一种暗网电子数据提取固定方法

文献发布时间:2023-06-19 11:35:49

技术领域

本发明属于电子数据取证技术领域,涉及一种暗网电子数据提取固定方法。

背景技术

暗网的匿名性使得用户个人信息不易查明;通信内容难以监管,暗网因此成为了犯罪人员从事危害社会和国家安全活动的集聚地,其中的非法交易数量巨大且内容涉及众多领域,常见的交易内容包含公民个人信息、毒品毒物等等,对社会治安造成严重危害,打击暗网犯罪刻不容缓。

随着暗网的发展,暗网中涉及非法网站类案件数量也将直线上升,犯罪事实不限于公民信息交易,案情复杂难以分析,而且面对页面较多的非法网站时,繁琐的截屏录像取证成为公安机关办案民警的一大难题。办案人员针对暗网取证,存在的难点主要有以下几点:(1)暗网的大量违法网站生命周期很短;(2)犯罪分子在实施犯罪后,会快速删除网络犯罪痕迹;(3)如何保存和管理繁杂、海量的暗网网站数据;(4)在打击境内暗网犯罪刚刚起步的当下,缺乏专门针对暗网的市场化取证产品。

发明内容

为解决上述技术问题,本发明提供一种暗网网站爬取及交易信息文本固定方法,通过网络爬虫技术对暗网网页数据和交易数据进行提取固定,并计算电子数据的完整性校验值,最终将结果以可视化的形式呈现在暗网在线取证系统前端。

本发明提供一种暗网电子数据提取固定方法,包括:

步骤1、编写暗网网站爬虫,利用浏览器测试框架进行暗网网站爬取;

步骤2、暗网网站交易文本信息固定;

步骤3、取证结果的可视化呈现。

在本发明的暗网电子数据提取固定方法中,所述暗网网站的域名地址的获取包括以下方法:

(1)Google语法搜索:利用Google语法进行搜索,获取与暗网域名相关的百度结果链接,并保存在本地txt文档中;

(2)正则表达式:根据Tor网络域名的形式,通过正则表达式收集域名地址,并使用以下URL的正则表达式进行匹配:

^https?:\/\/(([a-z0-9_-]{1,64}\.){0,4}[a-z0-9=]{16}\.onion)(:|\/|$)

从而获得相应的Tor网址,存储在本地txt文档并持续更新.将上述方法所收集的Tor域名地址,保存至urls.txt中。

在本发明的暗网电子数据提取固定方法中,所述步骤1中利用浏览器测试框架进行暗网网站爬取具体为:针对暗网的网站结构,暗网爬虫利用Selenium自动化测试框架进行爬取,Selenium测试直接运行在浏览器中,支持自动录制动作和自动生成.Net、Java、Perl不同语言的测试脚本。

在本发明的暗网电子数据提取固定方法中,所述步骤1中暗网网页爬取具体为:

步骤1.1:网页搜索:先利用Selenium访问用户输入的目标网址,随后根据用户提供的地址进行网页搜索,网页搜索步骤采用广度优先算法进行遍历,先将输入的主网站的域名作为入口,以主网站为第一层节点,然后爬取位于第二层的所有节点,层层爬行,直至未爬取队列为空或者达到设定的层次提取出未访问过的待爬取的URL列表;

步骤1.2:网页解析:对网页中内容进行数据分析,把下载的网页文档字符串作为输入,提取出该网页中需要的数据和未访问过的待爬取的URL列表,然后将这些数据保存到MySQL数据库中;

步骤1.3:网页下载:采用Python的Selenium自动化测试框架的网络爬虫对暗网网站进行截屏固定,利用Selenium中save_screenshot()函数对网页数据进行全屏截图;

步骤1.4:电子数据保全:对所提取到的截图进行电子数据完整性校验,计算电子数据完整性校验值;

步骤1.5:数据保存:将已经下载好的截图与完整性校验值一同根据用户的需求,保存到本地或者保存到服务器;

步骤1.6:从数据库被提取固定网站表中提取新的URL。

在本发明的暗网电子数据提取固定方法中,所述步骤1.4中使用哈希算法计算电子数据完整性校验值,具体为:

(1)电子数据文件的打开方式是二进制方式,即打开文件时使用b模式;

(2)用SHA-1作为哈希值的计算方式,SHA-1的结果是20字节长度,通常用一个40位的16进制字符串表示。

在本发明的暗网电子数据提取固定方法中,所述步骤2具体为:

步骤2.1:暗网网站自动注册:根据网站注册账号的规则进行配置,注册多账号发送Cookie请求,防止针对Cookie的请求频率限制;

步骤2.2:暗网网站自动登录:利用Python的Requests模块进行模拟登陆,通过Requests库创建一个Session()自动管理Cookies,用户在提交验证码的时候把Cookie同时提交至服务器即可,通过post session()函数,发送登陆请求并完成自动登陆;

步骤2.3:IP防封禁:目标站点是否存在若干的访问限制防护措施,比如UA防护、访问频率限制等,因此需要利用Python编写Tor自动切换脚本,当判断IP被Ban时实现Tor自动切换;

步骤2.4:爬取交易数据:通过Tor浏览器查看该网站主页分类以及每个分类下面的子分类,获取并迭代分类的全部类型,并将其 qeaid、页码page及其他参数代入模板URL,以抓取栏目最大页数及详细列表,在获取箭头指示最大页数后,不断翻页迭代上面的过程以爬取全部页码及类型。

在本发明的暗网电子数据提取固定方法中,所述步骤3具体为:将提取的暗网网页截图、电子数据校验值以及暗网网页地址在Django 后台进行可视化展示,对Django REST后台进行安装部署,其中部署的关键步骤如下所示:

(1)创建screen_shots项目,并且安装Pymysql数据库驱动,更改数据库参数,在配置完后,在MySQL中创建screenshots_db数据库,执行数据库迁移命令后,即可在MySQL下查看创建的表。

(2)创建worker APP。在models.py中定义模型,修改模型文件,并执行迁移命令。

(3)配置完URL后,启动本地服务器。

本发明的一种暗网网站爬取及交易信息文本固定方法,至少具有以下有益效果:

1)暗网网站可能随时更改域名,服务器可能随时会转移或关闭,电子数据存储状态复杂、表现形式多样,暗网网站的处理与传统证据的处理手段存在较大差异,本暗网电子数据提取固定方法的发明,能够对暗网违法网站进行提取固定。

2)公安机关在使用传统的网页截屏固定方式获取违法交易案值、作案团伙层级结构等线索或证据时,往往需要人工筛选出与违法交易相关的语句信息,严重影响案件侦办的时效性。本暗网电子数据提取固定方法的发明可根据公安机关的需求,对暗网案件中的交易数据信息进行提取固定,并以可视化的形式呈现出来,提高暗网侦查办案的效率。

附图说明

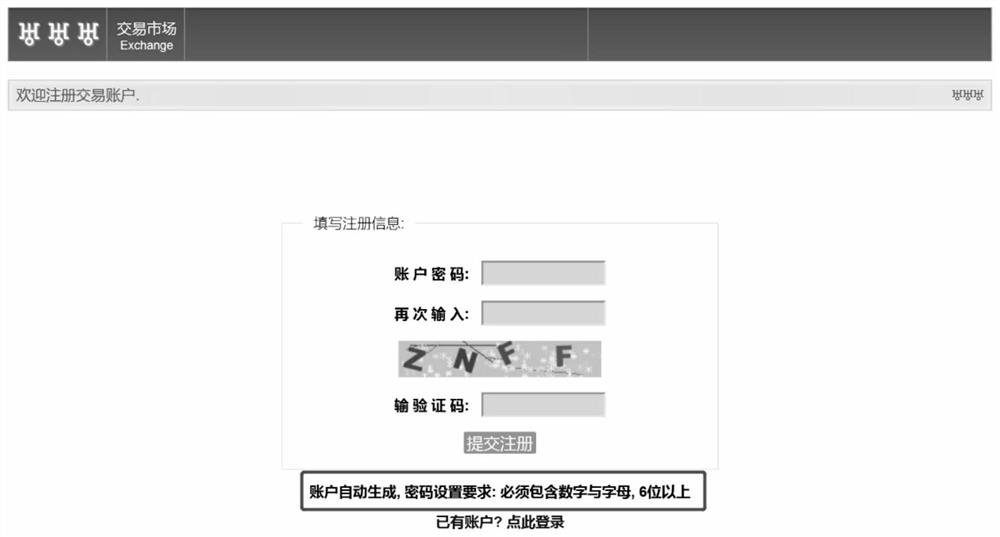

图1是暗网中文论坛的注册界面;

图2是获取暗网中文论坛的注册验证码结果;

图3是暗网中文论坛自动注册结果;

图4是注册账户测试结果保存表;

图5是实际注册账户测试结果;

图6是获取暗网中文论坛的注册验证码结果;

图7是暗网中文论坛自动登陆结果;

图8是Tor自动切换脚本测试结果;

图9是暗网网页数据提取固定展示结果;

图10是配置MySQL数据源;

图11是暗网中文论坛卖家出售商品的价格。

具体实施方式

为了更好的说明本发明的技术方案,先对相关现有技术和存在的缺陷进行简要的介绍。

1)Tor匿名通信系统:Tor匿名通信系统(The Second Generation OnionRouter),即第二代洋葱路由系统,由一组洋葱路由器组成(也称之为Tor节点),不仅能够提供客户端匿名通信,还可以帮助用户匿名上网和保护用户隐私。Tor具有隐匿服务,具体流程是当用户进行即时通信等活动时,Tor可以帮助隐藏用户的物理地址。在服务提供者仅知域名信息的情况下,其他用户通过“集合结点”(Rendezvous Point,RP),可顺利访问其隐匿服务。

2)网络爬虫技术:网络爬虫(Web Crawler)是一种按照一定的规则自动地爬取网络信息的程序或者脚本。网络爬虫可以根据用户需求,从指定的URL进行爬取,并且爬取与其相关联的所有URL,最终从URL的页面提取所需的数据。其中网络爬虫系统主要包括网页访问、网页信息爬取以及对获取到的数据进行存储三个部分。

3)网页搜索算法

对网络爬虫而言,在巨大的互联网中爬行有多种方式,如何高速无重复地遍历完所有节点取决于它爬行的方式。网络爬虫下一个爬取的URL由爬虫算法决定,因此采用何种算法进行节点爬行是网络爬虫的重要研究内容之一。目前主要的搜索策略包括:深度优先搜索和广度优先搜索。

深度优先的爬行方式优先考虑深度。由于网站的分层设计,可以将网站比作二叉树,它的子链接就是二叉树上的节点,起始URL就是二叉树上的根节点。深度优先算法的原理是将输入的主网站的域名作为入口,然后判断是否为同一站点链接,防止爬出站外而导致无限尝试爬取,接着去爬取匹配的所有子域名(例如:子域名_1、子域 _2……),再将爬取的子域名_1作为新的入口,继续爬取子域名_1所匹配的所有子域名,直到抓到尽头。假设某网站的链接结构如图所示。深度优先的爬行方式优先考虑深度。从根节点开始,沿着它指向的一条路径一直往下爬行,只要节点下还有子节点且该子节点未被访问过,该爬虫就会一直往下爬直到该路径下的所有节点都被遍历,然后返回起始URL沿着另一条路径继续爬行,重复上述爬行过程直至未爬取队列为空。以上图所示的二叉树结构为例,深度优先的爬行路线为:A—B—D—G—E—H—C—F—I。深度优先的优点是爬行方式简单,能够深入网站页面内部进行分析。但如果这种方式不断进行递归没有跳出或者递归太深,就会越爬越深最终陷入爬虫陷阱,且未考虑网站结构的广度范围而导致爬取的内容过于狭窄。

广度优先算法是以广度为优先考虑原则,简单地说就是分层次爬行,也可以称为宽度优先算法。广度优先算法的实质是通过队列的方式实现,以根节点为第一层节点,然后爬取位于第二层的所有节点,层层爬行,直至未爬取队列为空或者达到设定的层次数。以上图所示的结构为例,假设每次都先爬取最左边的节点,那么广度优先的爬行路线为:A—B—C—D—E—F—G—H—I。广度优先算法相较于深度优先算法更为简单,只需理清网站结构,就可以分层次爬取,因此这种方式非常适合层次结构较为简单的网站。若网站规模较大,层次较深结构较为复杂,则该爬行方式很难爬行到较为深层的网页同时也会爬取到大量无关的网页,从而导致爬行的效率降低。

在暗网网站爬虫设计中,广度优先算法相比深度优先算法具有如下特点:

第一,网站的结构都是把越重要的网页放在离起始URL比较近的地方,位于网站层次越深的地方,网页的重要性越低。

第二,网站设计不会将网页深度设置的很高,因此为了达到某个页面总是存在一条很短的路径,广度优先可以保证以最快的速度爬行到这个网页所在节点。

第三,为了提高爬虫效率,一般采用多线程或者多进程的方式抓取,而广度优先有利于多线程间爬虫的合作。

本发明提供一种暗网电子数据提取固定方法,该方法适用于如下计算机系统环境:

逻辑架构是采用B/S架构。系统管理员通过浏览器登陆,审查暗网网页数据的提取固定结果、电子数据完整性校验值,以及暗网交易数据的提取固定结果。

前端主要采用Grafana前端架构可视化实现,后端采用基于 Django RESTFramework框架进行开发。暗网在线系统的数据在提取固定后存储在MySQL数据库中,为业务逻辑的实现提供数据支持。 Grafana进行界面的布局和样式设计,采用Webpack进行文件的打包工作,将前端中涉及的多个css文件、js文件进行压缩打包,通过模块化的方式简化开发难度。采用Vue通过操作数据来实现页面的更新与展示。

后端采用Django REST Framework框架,其优点可以直接在Django程序中运行Python代码,为网络数据的采集提供便利。其中能够保证前后端之间的数据传送、管理对象间的依赖。项目开发完成后,打包成war包部署到服务器,并且通过Caddy进行负载均衡、反向代理、静态文件的处理等服务。

数据存储主要使用MySQL数据库对用户信息、暗网网页数据、暗网交易数据以及电子数据完整性校验值等信息进行持久化存储。

本发明提供一种暗网电子数据提取固定方法,首先为了实现爬虫程序对暗网的有效爬取要部署Tor环境。将Tor部署在系统中,Tor 匿名通信系统(the second generationOn—ion router)实现了客户端的匿名通信服务,当用户进行即时通信等活动时,Tor可以隐藏用户的物理地址。其中Tor使用的协议是Socks5,Python的Requests和 Selenium两个模块进行GET和POST请求,由于Requests模块通过常规DNS服务器不能解析*.onion地址,而通过Tor网络可以解析 *.onion地址。在程序中conf.py文件中配置代理。

安装命令行代理Proxychains。因为Tor与Proxychanins能构建 Socks代理链IP跳板,在进行爬虫测试时实现匿名。由于该软件第3 版本不支持指定地址放行,所以需要安装Proxychain 4.0版本。安装完后编辑/etc/proxychains.conf,将socks5地址修改为socks5127.0.0.1 9150,并添加localnet代理ip/255.255.255.255。

在暗网网页数据的提取采用主动获取模式,根据用户的需求输入命令开始数据采集,从而降低资源占用的同时具有灵活性;在暗网交易数据的提取固定采用被动获取模式,在添加暗网网站后,根据用户所需的数据进行数据采集,并以指定的时间间隔发送给服务器。

本发明的一种暗网电子数据提取固定方法包括如下几个步骤:

步骤1、暗网网站的爬取:为采集暗网数据,编写暗网网站爬虫,利用浏览器测试框架进行爬取,从而实现对暗网违法交易网站网页下载、网页解析功能;

本发明中暗网网站的域名地址的获取方法,主要有以下2种方案:

(1)Google语法搜索

为了持续获取并监测公开网络中网站上发布的数据,本文开发了一套针对百度结果链接的获取程序,即利用Google语法进行搜索,获取与暗网域名相关的百度结果链接,并保存在本地txt文档中。

(2)正则表达式

设计正则表达式.根据Tor网络域名的形式,可以通过正则表达式收集域名地址,并使用以下URL的正则表达式进行匹配:

^https?:\/\/(([a-z0-9_-]{1,64}\.){0,4}[a-z0-9=]{16}\.onion)(:|\/|$)

从而获得相应的Tor网址,存储在本地txt文档并持续更新.将上述方法所收集的Tor域名地址,保存至urls.txt中。

所述步骤1中利用浏览器测试框架进行暗网网站爬取具体为:针对暗网的网站结构,暗网爬虫利用Selenium浏览器自动化测试框架进行爬取,Selenium测试直接运行在浏览器中,支持自动录制动作和自动生成.Net、Java、Perl不同语言的测试脚本。

本发明步骤1中爬取单个暗网网页与批量爬取暗网网页的方法具体为:

步骤1.1:网页搜索。先利用Selenium访问用户输入的目标网址,随后根据用户提供的地址进行网页搜索。为了提取暗网网站下所有的子网站及网页,网页搜索步骤采用广度优先算法进行遍历,先将输入的主网站的域名作为入口,以主网站为第一层节点,然后爬取位于第二层的所有节点,层层爬行,直至未爬取队列为空或者达到设定的层次提取出未访问过的待爬取的URL列表。此步骤使用Python中的 PyQuery库,根据HTML网页创建成一个DOM树,以树的形式进行各种节点的搜索遍历。DOM是一种处理HTML和XML文件的标准 API。DOM提供了对整个文档的访问模型,将文档作为一个树形结构,树的每个结点表示了一个HTML标签或标签内的文本项。DOM 树结构精确地描述了HTML文档中标签间的相互关联性。DOM树形结构根据上下级关系,可以很方便地定位到各个元素。

将所生成的URL信息存入被提取固定网站表。

然后进行ULR去重,将URL保存到数据库进行去重:把页面上爬取到的每个存储到数据库,为了避免重复,每次存储前都要遍历查询数据库中是否已经存在当前(即是否已经爬取过了),若存在,则不保存,否则,保存当前,继续保存下一条,直至结束。

步骤1.2、网页解析。对网页内容中进行数据分析,把网页下载模块下载的网页文档字符串作为输入,提取出需要的内容和未访问过的待爬取的URL列表。网页存储模块主要的方法是实现写入文件功能。网页存储模块实际是网页处理的一部分,爬取到网页的数据后,利用网页解析模块提取出该网页中需要的数据,然后将这些数据保存到MySQL数据库中。网页解析模块是对网页内容进行数据分析的工具。使用Python中的PyQuery库,它的语法使用上严格遵循jQuery 规范,基于HTML页面创建DOM树,通过各个节点的搜索遍历,最后定位到每个元素。

步骤1.3、网页下载。针对暗网网页数据的提取固定,采用Python 的Selenium自动化测试框架的网络爬虫对暗网违法网站进行截屏固定,利用Selenium中save_screenshot()函数对网页数据进行全屏截图。

将暗网违法网页下载到本地计算机中,是暗网电子数据取证的核心方法。在本发明中,选用的是PhantomJS模拟浏览器,它没有图形界面,不能实现图片和CSS等静态资源的下载.但是可以使用Python 中的Requests库对CSS和图片等静态资源进行爬取。

步骤1.4、电子数据保全。对所提取到的截图进行电子数据完整性校验,计算电子数据完整性校验值。为防止电子数据被篡改或者破坏,使用散列算法等特定算法对电子数据进行计算,得出的用于校验数据完整性的数据值。

电子数据保全是本发明非常重要的一个功能步骤。该步骤针对电子数据易被篡改、存储存在安全风险的问题,对提取固定的暗网网页数据计算完整性校验值,其不仅能够保证证据的完整性,也能够辅助侦查人员填写《电子数据提取固定清单》。

本发明选择采用SHA-1作为哈希值的计算方式,SHA-1的结果是20字节长度,通常用一个40位的16进制字符串表示。哈希算法是一种单向算法,用户可以通过哈希算法对目标信息生成一段特定长度的唯一的哈希值,但无法通过这个哈希值反向获得目标信息,即为单向映射算法。哈希算法运用到的函数计算方式是哈希函数,哈希函数可以将任意大小的数据映射到固定大小的数据,也可称为散列函数。

本发明所采用的哈希函数具有以下特点:

(1)易压缩:对于任意大小的输入M,Hash值的长度很小,在实际应用中,函数H产生的Hash值其长度是固定的。

(2)易计算:对于任意给定的消息,计算其Hash值比较容易。

(3)单向性:在给定某个哈希函数H和哈希值H(M)的情况下,得出M在计算上是很难的,即使目前市面上有很多哈希算法已被破解,但破解耗费的时间也是相当长的。因此,哈希函数还是具有相对安全性的。

(4)高灵敏性:这是从比特位角度出发的,指的是1比特位的输入变化会造成1/2的比特位发生变化。消息M的任何改变都会导致哈希值H(M)发生改变。即如果输入有微小不同,哈希运算后的输出一定不同。

在使用本方法对暗网网页截屏计算完整性校验值需注意以下几点:

(1)电子数据文件的打开方式一定要是二进制方式,即打开文件时使用b模式,否则在使用Python计算电子数据完整性校验值将会以文本的形式打开,最终会得到错误的电子数据完整性校验值。

(2)对于SHA-1如果需要16位(Bit)的值,则调用对象的digest()和hexdigest()分别产生20位(Bit)和40位(Bit)的哈希值。

最后将计算好的完整性校验值与网页截屏一一对应。

步骤1.5、数据保存。将已经下载好的截图与完整性校验值一同根据用户的需求,保存到本地或者保存到服务器。

如果用户选择保存在服务器,则将截图信息以及完整性校验值保存在所设置的服务器端MySQL数据库中。

如果选择保存到本地,则创建本地文件夹,将截图与完整性校验值保存在用户计算机中。

同时为了记录网页度定时间,使用datetime库获得当前系统本地时间并保存在数据库当中。

步骤1.6、从数据库被提取固定网站表中提取新的URL。首先判断是否重复爬取,爬虫将重复抓取的URL去除,避免多次抓取同一网页,既影响爬虫效率,又产生冗余数据。爬虫一般会将待抓取的 URL放在一个队列中,从抓取后的网页中提取到新的URL,在他们被放入队列之前,首先要确定这些新的URL没有被抓取过,如果之前已经抓取过了,就不再放入队列。如被重复爬取过,则继续判断下一个URL;若未被爬取过则回到第四部循环进行对网页的爬取工作。

步骤2、暗网网站交易文本信息固定:针对需要登陆的暗网违法交易网站,根据取证人员的需求进行定制化爬虫,实现对暗网违法交易网站的自动注册、自动登陆、IP防封禁、爬取交易数据文本、将交易数据文本固定至数据库;

所述文本信息具体为:

(1)网页数据提取固定信息

网页数据提取固定信息表主要包括Hash值、暗网网页地址、暗网网页截图、数据采集时间等字段,各个字段的详细信息如表1所示。

表1

(2)交易数据提取固定信息

交易数据提取固定信息表主要包括被提取固定网站ID、发布商品序号、卖家ID、发布商品标题、交易单价、商品出售量、暗网网站状态商品图片、暗网网站地址等字段,各个字段的详细信息如表2所示。

表2

(3)交易数据提取固定任务信息

交易数据提取固定任务表是暗网交易数据提取固定功能实现过程中存储被提取网站而创建的提取任务的表结构,其中主要包括被提取网站的创建的任务的ID,被提取网站的地址、网站名称、开始扫描和结束扫描的时间等字段,具体字段的详细信息如表3所示。

表3

(4)网页数据提取固定任务信息

网页数据提取固定任务表示暗网网页数据提取固定时间过程中存储被提取网站而创建的提取任务的表结构,其中主要包括被提取的网站名、提取固定状态、Proxy最后工作时间、报错信息等字段,具体字段的详细信息如表4所示。

表4

步骤2.1:暗网网站自动注册:根据网站注册账号的规则进行配置,比如用户名密码是否需要大小写和字符及数字规定等。同时,注册多账号发送Cookie请求,防止针对Cookie的请求频率限制。

由于在进入该网站后网站以一个PHPSESSIDCookie作为用户整个生命周期的身份ID,过期时间为1小时,且不会自动延长。因此,需要设定一个Session会话来自动处理这个cookie,又由于Tor网络结合了P2P技术和Socks5技术,所以还需要配置socks5代理。在注册界面,这里要注意的是用户的账号是由暗网中文论坛随机生成的用户编号,而密码需要同时包含大小写字符及数字,范围6-20,具体如图1所示。

这一功能利用Python随机密码生成脚本来实现,然后通过 imgcat命令行图片浏览器获取注册验证码并输出到本地命名 code.png中,查看后输入进控制端。具体如图2、图3所示。

注册结果保存至MySQL数据库User表,如图4所示。

步骤2.2:暗网网站自动登录:利用Python的Requests模块进行模拟登陆,通过Requests库创建一个Session()自动管理Cookies,用户在提交验证码的时候把Cookie同时提交至服务器即可,通过post session()函数,发送登陆请求并完成自动登陆。利用Python编写一个随机密码生成脚本,暗网中文论坛登录界面如图5所示。

通过Python的imgcat命令行图片浏览器获取登陆验证码并输出到本地命名code.png,查看后输入进控制端。最后,封装用户注册数据的payload,通过post session()函数,发送登陆请求并完成自动登陆。具体如图6、图7所示。

当用浏览器登录网站后,服务器会自动创建一个Session对象,在Session的有效期内,Session对象中的变量在整个用户会话中会一直保存。因此,通过Requests库创建一个Session()自动管理 Cookies。如果遇到登陆界面有验证码,当向服务器请求完之后,服务器只会将图片的识别码作为一个Cookie发送给客户端,只需在提交验证码的时候把Cookie同时提交即可。根据所注册的账户进行登陆具体测试结果如图8所示。

步骤2.3:IP防封禁:目标站点是否存在若干的访问限制防护措施,比如UA防护、访问频率限制等,因此需要利用Python编写Tor 自动切换脚本,当判断IP被Ban时实现Tor自动切换;

步骤2.4:爬取交易数据:首先通过Tor浏览器查看该网站主页分类以及每个分类下面的子分类。获取并迭代分类的全部类型,并将其 qeaid、页码page及其他参数代入模板URL,以抓取栏目最大页数及详细列表,在获取箭头指示最大页数后,不断翻页迭代上面的过程以爬取全部页码及类型。

主页分类主要为:数据资源、服务业务、虚拟物品、实体物品、技术技能、影视色情、其他类别、基础知识、私人专拍。

步骤3、取证结果的可视化呈现。使用现有的Django集成式框架实现可视化。为了帮助公安机关办案人员及时审查暗网违法数据,将结果进行可视化展示。具体为:将提取的暗网网页截图、电子数据校验值以及暗网网页地址在Django后台进行可视化展示。对Django REST后台进行安装部署。其中部署的关键步骤如下所示:

(1)创建screen_shots项目,并且安装Pymysql数据库驱动,更改数据库参数,在配置完后,在MySQL中创建screenshots_db数据库,执行数据库迁移命令后,即可在MySQL下查看创建的表。

(2)创建worker APP。在models.py中定义模型,修改模型文件,并执行迁移命令。

(3)配置完URL后,启动本地服务器。暗网网页数据提取固定展示结果如图9所示。

可视化呈现具体操作为:

1)添加数据源。

创建Dashboard,并添加MySQL数据源。具体数据源配置如图10所示。

2)配置仪表盘

第一步,创建表格(Table)。根据MySQL的details表项,编写具体的SQL查询语句。具体代码实现如下所示:

SELECT uptime,title,sold,price_btc FROM details ORDER BY uptime desc;

第二步,第二,创建饼图(Pie Chart)。根据details表中的 uptime字段,编写具体的SQL查询语句。

3)展示暗网中文论坛卖家出售商品的价格,根据details表中的price_usdt字段,编写具体的SQL查询语句。结果如图11所示。

以上所述仅为本发明的较佳实施例,并不用以限制本发明的思想,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

- 一种暗网电子数据提取固定方法

- 一种数据提取方法、装置、电子设备及存储介质