约束型智能汽车自主决策系统在线训练方法及装置

文献发布时间:2023-06-19 11:49:09

技术领域

本发明涉及智能汽车应用技术领域,特别涉及一种约束型智能汽车自主决策系统在线训练方法及装置。

背景技术

汽车智能化技术具有提升道路车辆行驶经济性,舒适性和安全性的巨大潜力,是汽车行业未来发展的必经之路。规则型的决策与控制方法已被验证无法满足智能汽车高智能化发展的需求,必须发展学习型的智能汽车决策控制技术。然而,智能汽车的决策控制任务是一个复杂的序列决策问题,现有的使用传统模仿学习或者监督学习的方法,一方面需要大量有标签的人工驾驶数据,决策模型难以超越人类水平,另一方面单纯依靠离线数据集学习,难以覆盖实际问题中所有可能的真实状态的分布特性。基于强化学习的自进化型决策方法以性能为优化指标,具有超越人类驾驶员水平的潜力,是解决复杂决策问题的有效方法,成为实现智能汽车高度智能化的唯一路径。

但是,智能汽车高度关注安全,强化学习型决策的探索学习与应用安全存在矛盾,即如果要学习到安全的策略,就无法避免要经历危险的情况,因此需要构建约束来确保学习过程中的安全性。其中,约束型优化控制问题的处理难点不仅包括如何在动态规划体系结构中实现约束优化技术,而且还包括策略可行性的考量。一方面,策略的可行性要求安全区域内的所有状态都安全,另一方面,一个可行的策略更新方向需要满足所有约束的更新方向限制。

基于以上自进化性和安全性的要求,本实施例拟通过利用先验模型的信息,对学习过程中的试错探索过程进行安全性约束,克服现有的强化学习型决策控制方法训练时的危险性问题,以实现智能车辆安全在线训练的可能性。

发明内容

本发明旨在至少在一定程度上解决相关技术中的技术问题之一。

为此,本发明的一个目的在于提出一种,、约束型智能汽车自主决策系统在线训练方法,该方法通过利用先验模型的信息,对学习过程中的试错探索过程进行安全性约束,克服现有的强化学习型决策控制方法训练时的危险性问题,以实现智能车辆安全在线训练的可能性。

本发明的另一个目的在于提出一种约束型智能汽车自主决策系统在线训练装置。

为达到上述目的,本发明一方面实施例提出了一种约束型智能汽车自主决策系统在线训练方法,包括:

S1,对策略网络和策略评估网络的参数进行初始化,分别选择所述策略网络和所述策略评估网络的学习率,开始马尔科夫决策进程;

S2,通过所述策略网络输出动作分布,并执行满足所述动作分布的动作,获取智能汽车与环境交互产生的数据组,将所述数据组进行存储,判断存储量是否达到预设阈值,在所述数据组的存储量达到预设阈值时,执行S3;

S3,随机在所述数据组中选取多组数据组,通过所述策略评估网络对选取数据组的状态-动作值进行估计;

S4,根据估计值计算所述策略评估网络的梯度,以及计算当前所述策略网络的目标梯度;

S5,根据先验模型和约束计算选取数据组的未来有限步状态,根据约束函数计算所述策略网络的约束梯度和对应的约束投影矩阵;

S6,通过所述目标梯度、所述约束投影矩阵以及所述策略网络和所述策略评估网络的学习率,更新所述策略网络和所述策略评估网络的参数;

S7,根据所述马尔科夫决策进程的标志量判断该进程是否结束,若是,则转S1,若不是,智能汽车根据更新后的所述策略网络的输出动作分布及满足该动作分布的动作,与环境进行交互,将交互得到的数据组进行存储,转S3。

为达到上述目的,本发明另一方面实施例提出了一种约束型智能汽车自主决策系统在线训练装置,包括:

数据存储模块,用于存储从智能汽车传感器上收集的向量级状态信息并为策略评估模块随机提供数据组;

策略评估模块,用于利用获得的数据组来评估当前策略的价值,计算当前状态-动作的价值;

目标梯度模块,用于计算得到的状态-动作价值的策略梯度,确定初始策略优化方向;

模型预测模块,用于根据先验的车辆动力学模型以及周车行为模型进行有限时域预测,计算未来时刻的约束函数值和策略梯度,以保证未来策略优化方向的安全性;

安全约束投影模块,用于根据确定的投影规则,将策略梯度更新方向投影至可行且安全的梯度方向,并进行策略网络与值网络的参数更新;

安全护盾模块,用于对优化过的策略产生的动作信息进行检验。

本发明实施例的约束型智能汽车自主决策系统在线训练方法及装置,具有以下优势:

1)通过将先验模型预测步内的约束计算出合理的投影矩阵,并将目标函数的“目标梯度”投影到可行且安全的方向上,能够保证智能汽车在线训练过程的安全性。

2)能够根据不同场景(或者任务的需求)对目标函数做出修改,例如跟踪性、经济性等,多维度综合优化智能汽车的在线训练过程。

本发明附加的方面和优点将在下面的描述中部分给出,部分将从下面的描述中变得明显,或通过本发明的实践了解到。

附图说明

本发明上述的和/或附加的方面和优点从下面结合附图对实施例的描述中将变得明显和容易理解,其中:

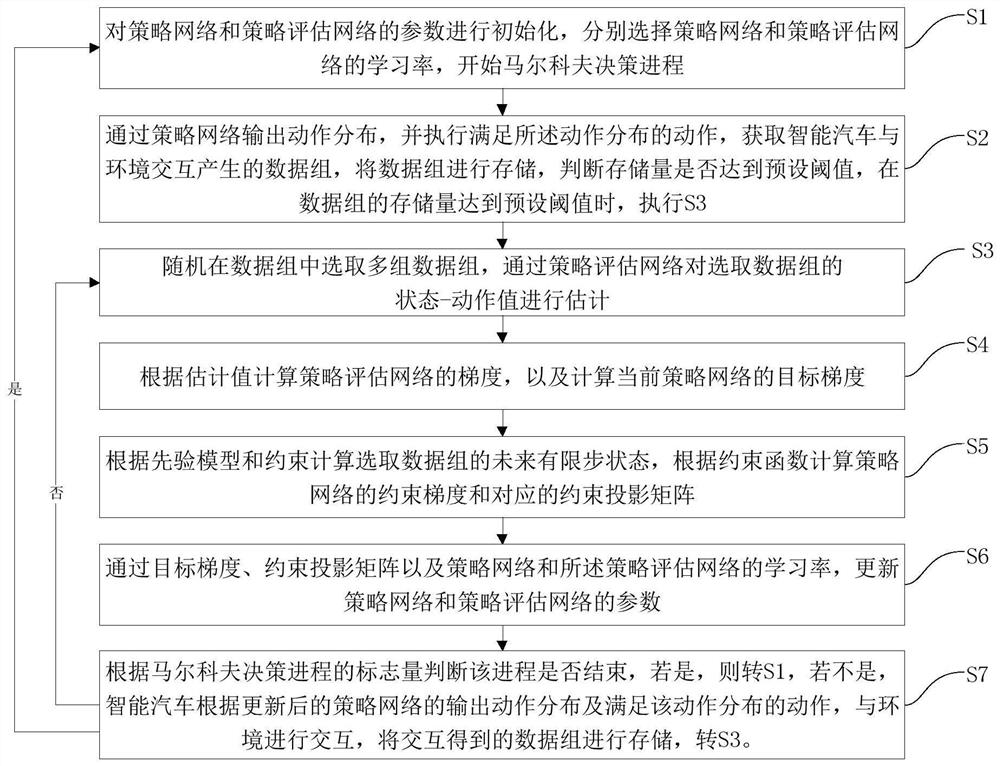

图1为根据本发明一个实施例的约束型智能汽车自主决策系统在线训练方法流程图;

图2为根据本发明一个实施例的约束型智能汽车自主决策系统在线训练方法框图;

图3为根据本发明一个实施例的车间碰撞约束示意图;

图4为根据本发明一个实施例的约束函数梯度求导示意图;

图5为根据本发明一个实施例的安全约束投影逻辑示意图;

图6为根据本发明一个实施例的约束型智能汽车自主决策系统在线训练装置结构示意图。

具体实施方式

下面详细描述本发明的实施例,所述实施例的示例在附图中示出,其中自始至终相同或类似的标号表示相同或类似的元件或具有相同或类似功能的元件。下面通过参考附图描述的实施例是示例性的,旨在用于解释本发明,而不能理解为对本发明的限制。

下面参照附图描述根据本发明实施例提出的约束型智能汽车自主决策系统在线训练方法及装置。

首先将参照附图描述根据本发明实施例提出的约束型智能汽车自主决策系统在线训练方法。

图1为根据本发明一个实施例的约束型智能汽车自主决策系统在线训练方法流程图。

如图1所示,该约束型智能汽车自主决策系统在线训练方法包括以下步骤:

步骤S1,对策略网络和策略评估网络的参数进行初始化,分别选择策略网络和策略评估网络的学习率,开始马尔科夫决策进程。

具体地,初始化策略网络和策略评估网络(又称Q网络)的参数θ和ω,选择合适的学习率β

步骤S2,通过策略网络输出动作分布,并执行满足动作分布的动作,获取智能汽车与环境交互产生的数据组,将数据组进行存储,判断存储量是否达到预设阈值,在数据组的存储量达到预设阈值时,执行S3。

具体地,根据策略网络输出动作分布,π(·|s;θ),并执行满足该分布的动作,a~π(·|s;θ),令该动作通过安全护盾模块的检查,并通过智能汽车不断与环境交互获得数据组,(s

步骤S3,随机在数据组中选取多组数据组,通过策略评估网络对选取数据组的状态-动作值进行估计。

从数据存储模块

在步骤S1中,采用下式(1)确定目标函数及约束:

服从于,

h(s

其中,收益函数r(s,a)代表任务的目标,包括智能汽车的跟踪性能、燃油经济性能以及驾驶舒适性能等,γ为折扣因子,π

进一步地,为了计算式(1)中的无穷时域收益函数累积和函数,步骤S3中,策略评估网络计算批数据的值函数,作为收益函数的估计值,得到策略网络π(·|s;θ)的更新目标,即式(1)可以写作:

其中,Q(s

y

其中,r

进一步地,获得更新Q网络参数ω的目标函数:

其中,

步骤S4,根据估计值计算策略评估网络的梯度,以及计算当前策略网络的目标梯度。

进一步地,步骤S4中计算的Q网络Q

计算当前策略π

其中,∝表明log的底数不唯一,可根据计算要求而定。

根据步骤S3得到的值估计结果,计算策略评估模块的梯度

步骤S5,根据先验模型和约束计算选取数据组的未来有限步状态,根据约束函数计算策略网络的约束梯度和对应的约束投影矩阵。

根据先验模型和约束,策略提升模块中的模型预测模块预测步骤S2中返回的批数据的未来有限步状态,安全约束模块根据约束函数计算策略的“约束梯度”

进一步地,步骤S5中计算“约束梯度”

其中,

进一步地,计算投影矩阵P

P

其中,M为约束梯度矩阵,I为单位矩阵。

步骤S6,通过目标梯度、约束投影矩阵以及策略网络和策略评估网络的学习率,更新策略网络和策略评估网络的参数。

根据步骤S4和步骤S5中的策略评估模块的梯度和策略提模块的“目标梯度”、“约束投影矩阵”,以及对应网络的学习率,更新策略网络和Q网络的参数θ和ω。

进一步地,步骤S6中参数ω和θ的更新规则为:

其中,β

步骤S7,根据马尔科夫决策进程的标志量判断该进程是否结束,若是,则转S1,若不是,智能汽车根据更新后的策略网络的输出动作分布及满足该动作分布的动作,与环境进行交互,将交互得到的数据组进行存储,转S3。

根据智能汽车MDP过程的标志量done判断该进程是否结束,如果是,进入步骤S1;如果否,根据更新后的策略网络输出动作分布,π(·|s;θ),及满足该分布的动作,a~π(·|s;θ),令该动作通过安全护盾模块的检查,智能车辆再执行相应的安全动作,与环境进行交互,并将交互得到的数据组,(s

进一步地,还包括:

对策略网络的输出动作分布以及满足动作分布的动作进行安全检验。

进一步地,策略网络输出的动作值,通过步骤S7中的安全护盾模块,得到绝对安全动作,由智能汽车执行:

其中,a

下面对本发明实施例的约束型智能汽车自主决策系统在线训练方法进行详细说明。

如图2所示,步骤1,本实施例中的智能汽车自主决策系统在线学习过程至少包含四个功能性模块,即数据存储模块、策略评估模块、策略提升模块及安全护盾模块,每个模块在实际的在线训练过程中并行启动。其中,策略提升模块是本实施例的核心,包含三个功能子模块,分别为目标梯度模块、模型预测模块以及安全约束投影模块。其特征在于,计算约束函数的梯度投影矩阵,将目标梯度投影至可行且安全的目标函数更新方向内,保证智能汽车策略探索时的安全性,并利用安全护盾保证策略执行阶段的绝对安全,达到安全在线训练的目标。

在智能汽车行驶的过程中,在线学习算法依次经过每一个模块,迭代更新求解。首先,从智能汽车传感器上收集的向量级状态信息不断输入并存放在数据存储模块中,同时,数据存储模块为策略评估模块随机提供一批数据。策略评估模块使用获得的批数据来评估当前策略的价值,即计算当前“状态-动作”,(s

步骤2,假定智能汽车在与交通环境(或系统)的交互过程中系统是完全可观的,则智能汽车的最优决策通常只与当前观测信息有关,此时可以用马尔科夫决策(MarkovDecision Process,MDP)过程对智能汽车决策过程进行建模。对于每轮MDP过程,若当前时刻为t,智能汽车根据当前的环境状态

本实施例中,定义策略函数π(·|s)是以状态s为输入,Q函数Q(s,a)是关于“状态-动作”对(s,a)的函数。对于自动驾驶决策问题而言,状态空间

π(·|s)≈π(·|s;θ)

Q(s,a)≈Q(s,a;ω) (14)

式(14)中的θ和ω分别代表策略网络和Q网络的网络参数,具体而言,策略网络π(·|s;θ)以s为输入并输出动作a的概率密度函数,简记作π

本实施例中,输入策略网络与Q网络的状态s主要包括三部分:自车状态、跟踪状态以及周车状态,如表1所示。

表1

其中,跟踪状态为自车状态相对于目标参考轨迹的偏差。

步骤3,根据强化学习相关定义,本实施例中的目标函数为无穷时域累积衰减收益信号的期望,任务的目标是找到一个最优策略最大化目标函数:

服从于,

h(s

式(15)和(16)中,

则式(15)中的目标函数可以写作

此时,最优策略可以表示为:

式(19)中的J

智能汽车在线训练过程中的安全约束目标包括不与其他交通参与者(如周围车辆、行人、非机动车等道路参与者)以及静态障碍物(如道路边界、护栏等)发生碰撞。即约束函数h(·)的个数取决于约束目标的个数,每个约束目标有不同的阈值,如图3所示,以车间安全距离约束为例。

式(20)中,#,■∈{front,rear},分别表示智能汽车前部和后部的碰撞圆圆心点,这里采用双圆法描述车辆的形状。x,y∈s,分别表示自车的横纵向位置的状态坐标,x

式(21)的d

步骤4,数据存储模块的功能主要包含两个:

其一是用于储存探索得到的状态信息,具体指智能汽车使用当前策略驾驶时采集到的所有车辆数据,以数据对的形式存入数据缓存中。其基本存储单位为五元组(s

其二是随机返回一批数据供后续模块学习。在数据缓存模块收集到指定量的数据后,随机返回一批数据给策略提升模块进行学习。数据存储模块有预先设置的存储数量上限,当储存数据对的数量达到了数据存储模块的上限时,采用“先进先出”的方式丢弃旧数据,以保证数据存储模块保存的是较新的数据。

步骤5,基于函数近似的强化学习方法通过对策略网络参数θ和策略评估网络Q网络的网络参数ω交替更新,逐步逼近最优策略。

在策略评估模块中,为了对Q网络Q

y

进一步得到更新参数ω的目标函数:

进一步得到Q网络Q

在策略提升模块中,目标梯度模块计算π(·|s;θ)的更新目标为:

其中,策略π(·|s

式(26)中的∝表明log的底数不唯一,可根据计算要求而定。同时得到相应的近似“状态-动作”价值函数的策略梯度,用于确定策略优化的方向,并称式(26)为策略的“目标梯度”。

此时,策略提升模块中的模型预测模块,根据先验的车辆动力学模型以及周车行为模型对此批数据进行有限时域预测,计算未来时刻对应的约束函数值h(s)及约束函数的策略梯度,称该梯度为“约束梯度”,

其中g包括自车和周车的预测模型,其形式包括但不限于解析函数、神经网络等,只要可以进行求导,即

定义如下等式:

可以得到:

即根据式(27)-(30),可以递推得到“约束梯度”

接着,该实施例策略提升模块中的安全约束投影模块,如图5所示,采用Rosen梯度投影法,将“目标梯度”投影到满足约束的可行区域的切面上,即“约束梯度”的零空间,并计算求得约束梯度的投影矩阵P

定义投影矩阵P

P

式(32)中,

在训练策略网络π

步骤6:利用步骤4和步骤5中的策略评估模块和策略提升模块对策略网络θ和Q网络参数ω进行交替迭代更新,从而得到近似最优策略

迭代过程主要包含如下两步:首先给定策略网络

其中,β

其中,β

步骤7:由于训练过程中的扰动等因素存在,基于策略π(s)产生的动作a=π(s)不一定能够完全近似该问题约束下的最优解,故而为确保绝对的安全,需要通过安全护盾模块的检验,输出最后的绝对安全动作,用于智能车辆执行:

其中,a

根据本发明实施例提出的约束型智能汽车自主决策系统在线训练方法,通过将先验模型预测步内的约束计算出合理的投影矩阵,并将目标函数的“目标梯度”投影到可行且安全的方向上,能够保证智能汽车在线训练过程的安全性。能够根据不同场景(或者任务的需求)对目标函数做出修改,例如跟踪性、经济性等,多维度综合优化智能汽车的在线训练过程。

其次参照附图描述根据本发明实施例提出的约束型智能汽车自主决策系统在线训练装置。

图6为根据本发明一个实施例的约束型智能汽车自主决策系统在线训练装置结构示意图。

如图6所示,该约束型智能汽车自主决策系统在线训练装置包括:数据存储模块601、策略评估模块602、目标梯度模块603、模型预测模块604、安全约束投影模块605和安全护盾模块606。

数据存储模块601,用于存储从智能汽车传感器上收集的向量级状态信息并为策略评估模块随机提供数据组。

策略评估模块602,用于利用获得的数据组来评估当前策略的价值,计算当前状态-动作的价值。

目标梯度模块603,用于计算得到的状态-动作价值的策略梯度,确定初始策略优化方向。

模型预测模块604,用于根据先验的车辆动力学模型以及周车行为模型进行有限时域预测,计算未来时刻的约束函数值和策略梯度,以保证未来策略优化方向的安全性。

安全约束投影模块605,用于根据确定的投影规则,将策略梯度更新方向投影至可行且安全的梯度方向,并进行策略网络与值网络的参数更新。

安全护盾模块606,用于对优化过的策略产生的动作信息进行检验。

需要说明的是,前述对方法实施例的解释说明也适用于该实施例的装置,此处不再赘述。

根据本发明实施例提出的约束型智能汽车自主决策系统在线训练装置,通过将先验模型预测步内的约束计算出合理的投影矩阵,并将目标函数的“目标梯度”投影到可行且安全的方向上,能够保证智能汽车在线训练过程的安全性。能够根据不同场景(或者任务的需求)对目标函数做出修改,例如跟踪性、经济性等,多维度综合优化智能汽车的在线训练过程。

此外,术语“第一”、“第二”仅用于描述目的,而不能理解为指示或暗示相对重要性或者隐含指明所指示的技术特征的数量。由此,限定有“第一”、“第二”的特征可以明示或者隐含地包括至少一个该特征。在本发明的描述中,“多个”的含义是至少两个,例如两个,三个等,除非另有明确具体的限定。

在本说明书的描述中,参考术语“一个实施例”、“一些实施例”、“示例”、“具体示例”、或“一些示例”等的描述意指结合该实施例或示例描述的具体特征、结构、材料或者特点包含于本发明的至少一个实施例或示例中。在本说明书中,对上述术语的示意性表述不必须针对的是相同的实施例或示例。而且,描述的具体特征、结构、材料或者特点可以在任一个或多个实施例或示例中以合适的方式结合。此外,在不相互矛盾的情况下,本领域的技术人员可以将本说明书中描述的不同实施例或示例以及不同实施例或示例的特征进行结合和组合。

尽管上面已经示出和描述了本发明的实施例,可以理解的是,上述实施例是示例性的,不能理解为对本发明的限制,本领域的普通技术人员在本发明的范围内可以对上述实施例进行变化、修改、替换和变型。

- 约束型智能汽车自主决策系统在线训练方法及装置

- 一种人工智能模型在线训练方法及系统