一种面向信息碰撞避免的无人机数据收集的强化学习方法

文献发布时间:2024-01-17 01:26:37

技术领域

本发明涉及无线通信技术领域,尤其涉及一种面向信息碰撞避免的无人机数据收集的强化学习方法。

背景技术

近些年,网络用户数量和需求的爆炸式增长,对未来通信系统中用户数据的有效传输和成功收集提出了更高的要求。无人机因其具有部署速度快、机动性强、灵活度高等特性,特别适用于通信空地环境的数据传输和收集。它能够通过灵活调整位置、优化轨迹快速从用户处收集到有效数据,提高复杂环境下通信网络的传输性能。

对于无人机的轨迹优化问题,传统的解决方法很多,其中动态规划算法是常见的优化算法之一,它要求模型相对简单,受状态空间限制较大,一旦空间过大容易出现组合爆炸的问题;最优控制法也是常见的方法,该方法需要避免模型及其参数相对复杂的通信环境。这些传统方法中未考虑启发因素,无法实现智能搜索,一旦状态空间较大或环境变化后容易陷入局部最优且耗时过长。而在智能规划算法中,启发式寻优搜索算法应用较多,在论文《两种启发式优化算法的研究及其应用》(2015年)中提及,启发式搜索是在状态空间中的搜索,对每一个搜索的位置进行评估,得到最好的位置,再从这个位置进行搜索直到目标,其中A*算法是最常用的启发式算法,该方法一般应用于静态规划中,随着搜索空间增大,搜索时间过长,其实时性无法保证,为了解决该问题,后续提出了一系列A*算法的衍生算法,如三维稀疏A*算法,该方法针对环境的变化可以调整权系数,对动态环境有较高的适应性。以及稀疏A*算法,现有论文《基于遗传算法和稀疏A*算法的无人机三维航迹规划研究》(2018年)中提及,该算法目的是通过分区搜索并结合飞行约束削减搜索节点,提高搜索效率。但是,A*算法依然受限于空间复杂度,无法兼顾搜索速率和目标性能。除此之外,还有遗传算法、蚁群算法等多种智能优化算法,各算法各有优劣,但一般都存在搜索速度慢、耗内存空间大以及算法实时性无法保证等缺陷。

在基于物联网的无人机辅助数据收集场景中,无人机作为一种移动数据收集器,一方面它不受地面运输移动性的限制,可以实现对节点用户的自动搜索和访问、实时路径规划、避障等;另一方面,在数据收集过程中,它对节点用户的覆盖率较高,可以减少数据采集的延迟。对于无人机多目标数据收集问题,优化求解的方法很多,例如,现有论文《物联网数据收集中无人机路径智能规划》(2021年)中提出,通过一种无人机收集数据的全局路径规划方法,以实现在最小化无人机收集节点数据花费时间的同时,最大化数据收集收益;论文《无人机辅助的物联网信息年龄优化方法研究》(2022年)中,利用动态规划方法寻找无人机的最优飞行轨迹,使得无人机沿该轨迹收集得到的节点数据信息年龄最小,其中涉及到无人机最佳数据收集位置的搜索和分组问题;论文《信息年龄受限下最小化无人机辅助无线供能网络的能耗:一种基于DQN的方法》(2021年)中提出,在深度强化学习的框架下重点研究了基于能量收割技术的无人机辅助数据收集问题,通过对地面节点传输机会和无人机的飞行轨迹进行联合优化,最小化节点的信息年龄,使得无人机能有效利用收割能量进行数据收集的同时避免由于缺乏能量而坠毁。目前大多数的研究旨在优化无人机系统数据收集场景的方法,即尽可能简化或特征化无人机与用户之间的数据收集过程,以便在一定时间内或有限的无人机飞行能量内获得最大用户信息吞吐量或最小信息传输时延。而规避了一个时隙内多个用户发送数据时存在一定概率会产生信息碰撞的可能性的问题。

综上:现有技术具有搜索速度慢、耗内存空间大以及算法实时性无法保证问题,且未考虑到一个时隙内与UAV距离相近的发送信息用户信息碰撞的问题。

发明内容

本发明的目的在于提供一种面向信息碰撞避免的无人机数据收集的强化学习方法。

为了实现上述发明目的,本发明采用技术方案具体为:

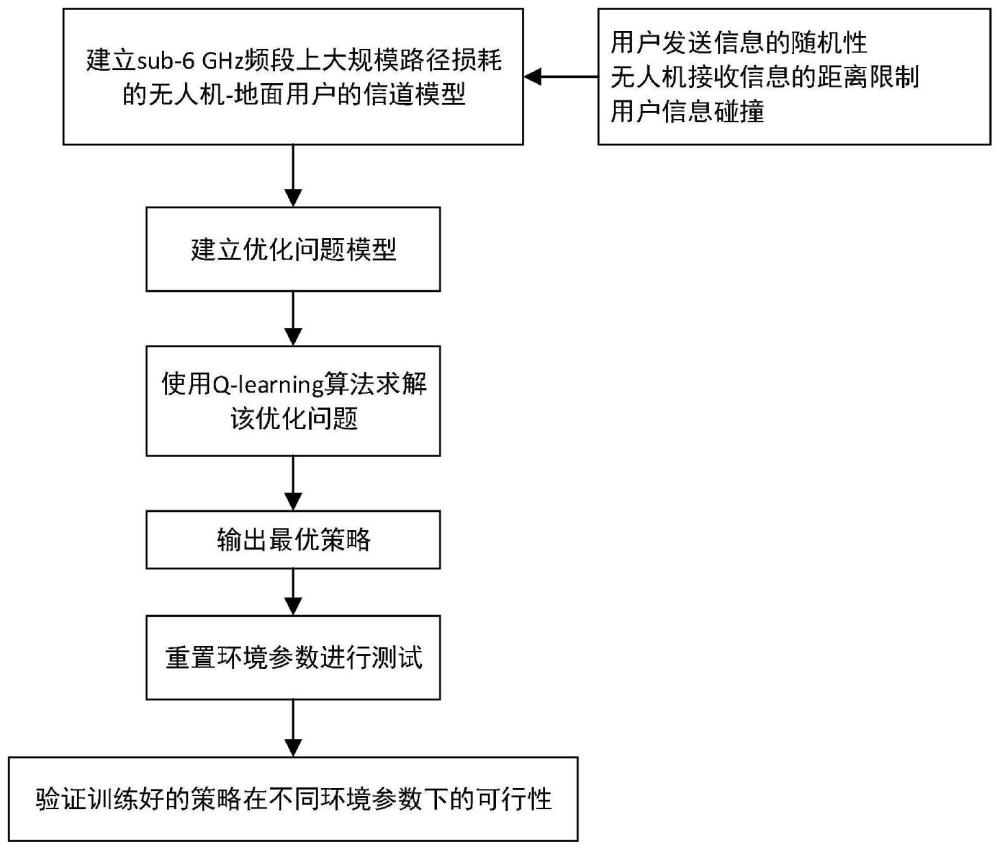

一种面向信息碰撞避免的无人机数据收集的强化学习方法,包括以下步骤:

S1:建立无人机-地面用户的信道模型;

S2:优化问题模型的建立;

S3:利用强化学习:Q-learning方法训练代理并更新状态-动作值函数,即Q值函数:Q

S4:在自定义环境中训练代理;

S5:重置环境参数进行测试工作;在原训练环境中,重置用户信息发送状态,即用户以概率p按泊松过程发送信息,进行测试工作。

步骤S1具体包括:

无人机在有限时间T内以恒定的速度V和高度H从初始位置

无人机的有效飞行域为[x

其中:(x

此基础上建立sub-6GHz频段上大规模路径损耗的无人机-地面用户的信道模型;

其中,对用户发送信息的随机性、用户和无人机有效通信范围以及用户信息碰撞进行约束:

用户发送信息的随机性:考虑用户每隔10时隙按泊松过程(一种累计随机事件发生次数的最基本的独立增量过程)发送信息,每时隙产生一个5个用户发送信息的0-1数组;0意味着该用户在当前时隙发送信息;反之表示该用户在当前时隙不发送信息;

用户和无人机的有效通信范围限制:分别提供用户和无人机的有效通信阈值(0.95),即便当前时隙有多个用户发送信息,但若无人机距用户太远(其用户的传输和速率低于通信阈值时),用户信息仍然无法成功传输给无人机。

用户信息碰撞:当前时隙有多用户发送信息,且满足无人机接收信息距离限制的情况下考虑用户发送信息碰撞的问题;设定一个碰撞阈值范围(1,1.01),取发送信息强度最大两个用户进行信息的碰撞判断,其它用户均视为噪声;判断依据是两个信息强度之比是否在设定的碰撞阈值范围内,如果在范围内则说明两个用户信息发生碰撞,该时隙无人机没有接收到信息,反之,该时隙无人机接收到信息强度更大(如果两个信息强度之比超过阈值范围即超过1.01了,因为在做这个判断之前,信息强度先进行了大小排序操作,被除数比除数更大,即此时选择信息强度之比的被除数对应的用户的信息接收)的用户信息。

步骤S2具体包括:

通过找到无人机的最优轨迹(满足目标的轨迹,即UAV由初始位置开始飞行,在T到达终点且飞行过程中最大化用户信息传输时延),最大限度缩短(最后得到的结果是训练期间得到的最小值)在有限飞行时间内无人机成功接收到用户信号的时延;将每时隙累计的所有用户的平均传输信号时延表示为t

min t

r

r

d

其中:

(a)式表示无人机在有限时间T内飞行;

(b)式表示无人机T时必须停在有效飞行域的最大位置处;

€表示用户的有效通信范围有限,用和速率表示距离限制;

其中和速率r

(d)表示用户信息碰撞的判断,其中r

€表示无人机的有效通信范围有限,若无人机到用户的距离超过阈值d

步骤S3具体包括:

设定状态中各元素初始值,并保证每次训练:episode结束后都从该初始状态开始;利用Q-learning算法,包括以下步骤:

S3.1.无人机状态空间设计:无人机的状态设计为obs=[x

A

t表示当前时隙;t

S3.2.无人机动作空间设计:无人机动作空间包含“上”、“下”、“左”、“右”四个离散动作,并用1、2、3、4数字表示,即[1,2,3,4]。

S3.3.动作选择:若当前训练没有达到最大训练次数,则实行动作选择步骤;

无人机在当前状态s下利用ε-greedy动作选择策略(每时隙,生成一随机数,判断该随机数与ε的大小,大于ε时,探索:此时在当前状态下随机选取一个动作。反之,利用:在当前状态下选择能产生最大Q值函数(Q

S3.4.奖励R的设计:为了在规定时间内避免更多不符合目标的轨迹出现以及规避稀疏奖励的局限性,将除了到达目标奖励和目标处额外惩罚奖励外的奖励设置为连续负奖励的形式,具体形式如下:

R=c

其中,r

r

当UAV在规定时间恰好到达终点,给予一个较大的正向奖励,反之,若UAV在规定时间并没有到达终点,即获得一个较大的负向奖励;

S3.5.得到并更新Q值函数;利用瓦片编码的状态线性映射方法(此时近似的Q值函数不再表示成一个表格,而是一个具有权值向量

设定的状态空间维度过大,导致其状态数过大,如果选取经典的表格检索方法来获得Q值,在训练的过程中无法遍历所有状态。因此,

利用函数线性近似技术,通过将状态映射为元素数小于现有状态数的0-1特征向量上,使得状态数减少,提高状态全部遍历的可行性;将状态近似映射到覆盖的8个瓦片(Tilings)中有重叠部分的8个小瓦片(Tiles)中,进而得到0-1状态向量:称为基向量F

更新状态s下的Q值;其Q-learning算法的Q值更新规则为:

Q(s,a)←(s,a)+α[R+γmaxQ(s′,a′)-Q(s,a)]

其中α为学习率,γ为折扣因子,maxQ(s′,a′)表示代理在下一时隙状态s′处最大动作值,a为动作值。

步骤S4具体包括:

重复S3,利用Q值更新规则不断更新Q值,优化无人机的动作选取策略,得到在飞行时间内最小化(在所有训练的过程中基于UAV能够从初始位置经过T到达终点位置的情况下,最后计算出来的用户传输时延收敛到最小值)无人机成功接收一个用户的发送信号所用平均时间;达到每次训练的最大步数时一次训练结束,达到总训练迭代次数时表示训练完成;训练成功后得到无人机动作选取的最优策略。

本发明在实际使用时:

与现有技术相比,本发明的有益效果为:

1、本发明利用Q-learning方法代替传统优化算法对无人机进行轨迹优化并实现其高效数据收集。针对随机多变的通信环境,Q-learning能够使得无人机在该环境中不断调整轨迹,适应其随机多变的特性,得到能实现平均完成一个用户有效数据收集的时间最短的最优策略。

2、本发明中利用函数近似的方法来解决状态空间过大的问题,用线性近似得到映射后的动作值函数Q(s,a,w)来取代表格型式下实际动作值函数Q

3、针对用户信息碰撞规避问题,本发明在无人机状态空间设计中增加一个对无人机轨迹方向引导的数组A

附图说明

附图用来提供对本发明的进一步理解,并且构成说明书的一部分,与本发明的实施例一起用于解释本发明,并不构成对本发明的限制。

图1为本发明整体流程示意图。

图2为本发明强化学习Q-learning流程图。

图3为本发明系统模型示意图。

具体实施方式

为了使本发明的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本发明进行进一步详细说明。当然,此处所描述的具体实施例仅用以解释本发明,并不用于限定本发明。

实施例1

参见图1与图3,如图3展示了,在一个无人机上行传输场景中,K个地面用户(Gus)固定分布在无人机规定的有效可行域Φ内,其中每一个地面用户都有一个有效通信域。无人机在恒定高度上以恒定速度飞行,并且无人机作为移动基站从地面用户中收集信息。需要注意的是,无人机在通过一些地面用户的公共通信范围时,考虑此时存在这些地面用户信息碰撞问题,无人机不能同时与多个地面用户进行通信。在当前时隙t,无人机从初始位置

一种面向信息碰撞避免的无人机数据收集的强化学习方法,包括以下步骤:

S1:建立无人机-地面用户的信道模型;

S2:优化问题模型的建立;

S3:利用强化学习:Q-learning方法训练代理并更新状态-动作值函数,即Q值函数:Q

S4:在自定义环境中训练代理;

S5:重置环境参数进行测试工作;在原训练环境中,重置用户信息发送状态,即用户以概率p按泊松过程发送信息,进行测试工作。

步骤S1具体包括:

无人机在有限时间T内(本实施例设置为51s)以恒定的速度V,单位:m/s和高度H,单位:m从初始位置

无人机的有效飞行域为[x

其中:(x

此基础上建立sub-6GHz频段上大规模路径损耗的无人机-地面用户的信道模型;

其中,对用户发送信息的随机性、用户和无人机有效通信范围以及用户信息碰撞进行约束:

用户发送信息的随机性:考虑用户每隔10时隙按泊松过程(一种累计随机事件发生次数的最基本的独立增量过程)发送信息,每时隙产生一个5个用户发送信息的0-1数组;0意味着该用户在当前时隙发送信息;反之表示该用户在当前时隙不发送信息;

用户和无人机的有效通信范围限制:分别提供用户和无人机的有效通信阈值(0.95),即便当前时隙有多个用户发送信息,但若无人机距用户太远(其用户的传输和速率低于通信阈值时),用户信息仍然无法成功传输给无人机。

用户信息碰撞:当前时隙有多用户发送信息,且满足无人机接收信息距离限制的情况下考虑用户发送信息碰撞的问题;设定一个碰撞阈值范围(1,1.01),取发送信息强度最大两个用户进行信息的碰撞判断,其它用户均视为噪声;判断依据是两个信息强度之比是否在设定的碰撞阈值范围内,如果在范围内则说明两个用户信息发生碰撞,该时隙无人机没有接收到信息,反之,该时隙无人机接收到信息强度更大(如果两个信息强度之比超过阈值范围即超过1.01了,因为在做这个判断之前,信息强度先进行了大小排序操作,被除数比除数更大,即此时选择信息强度之比的被除数对应的用户的信息接收)的用户信息。

步骤S2具体包括:

通过找到无人机的最优轨迹(满足目标的轨迹,即UAV由初始位置开始飞行,在T(即51s)到达终点且飞行过程中最大化用户信息传输时延),最大限度缩短(最后得到的结果是训练期间得到的最小值)在有限飞行时间(51s)内无人机成功接收到用户信号的时延;将每时隙累计的所有用户的平均传输信号时延表示为t

min t

r

r

d

其中:

(a)式表示无人机在有限时间T内飞行;

(b)式表示无人机T时必须停在有效飞行域的最大位置处;

(c)表示用户的有效通信范围有限,用和速率表示距离限制;

其中和速率r

(d)表示用户信息碰撞的判断,其中r

(e)表示无人机的有效通信范围有限,若无人机到用户的距离超过阈值d

步骤S3具体包括:

设定状态中各元素初始值,并保证每次训练:episode结束后都从该初始状态开始;利用Q-learning算法,包括以下步骤:

S3.1.无人机状态空间设计:无人机的状态设计为obs=[x

A

t表示当前时隙;t

S3.2.无人机动作空间设计:无人机动作空间包含“上”、“下”、“左”、“右”四个离散动作,并用1、2、3、4数字表示,即[1,2,3,4]。

S3.3.动作选择:若当前训练没有达到最大训练次数(自定义设置,本实施例设定为50000次),则实行动作选择步骤;

无人机在当前状态s下利用ε-greedy动作选择策略(每时隙,生成一随机数,判断该随机数与ε的大小,大于ε时,探索:此时在当前状态下随机选取一个动作。反之,利用:在当前状态下选择能产生最大Q值函数(Q

S3.4.奖励R的设计:为了在规定时间内避免更多不符合目标的轨迹出现以及规避稀疏奖励的局限性,将除了到达目标奖励和目标处额外惩罚奖励外的奖励设置为连续负奖励的形式,具体形式如下:

R=c

其中,r

r

当UAV在规定时间恰好到达终点,给予一个较大的正向奖励,反之,若UAV在规定时间并没有到达终点,即获得一个较大的负向奖励;

S3.5.得到并更新Q值函数;利用瓦片编码的状态线性映射方法(此时近似的Q值函数不再表示成一个表格,而是一个具有权值向量

设定的状态空间维度过大,导致其状态数过大,如果选取经典的表格检索方法来获得Q值,在训练的过程中无法遍历所有状态。因此,

利用函数线性近似技术,通过将状态映射为元素数小于现有状态数的0-1特征向量上,使得状态数减少,提高状态全部遍历的可行性;将状态近似映射到覆盖的8个瓦片(Tilings)中有重叠部分的8个小瓦片(Tiles)中,进而得到0-1状态向量:称为基向量F

更新状态s下的Q值;其Q-learning算法的Q值更新规则为:

Q(s,a)←(s,a)+α[R+γmaxQ(s′,a′)-Q(s,a)]

其中α为学习率,γ为折扣因子,maxQ(s′,a′)表示代理在下一时隙状态s′处最大动作值,a为动作值。

步骤S4具体包括:

重复S3,利用Q值更新规则不断更新Q值,优化无人机的动作选取策略,得到在飞行时间内最小化(在所有训练的过程中基于UAV能够从初始位置经过51s到达终点位置的情况下,最后计算出来的用户传输时延收敛到最小值)无人机成功接收一个用户的发送信号所用平均时间;达到每次训练的最大(51步,即一秒一步)步数时一次训练结束,达到总训练迭代次数时(50000次)表示训练完成;训练成功后得到无人机动作选取的最优策略。

以上所述仅为本发明的较佳实施例,并不用以限制本发明,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。