一种基于物联网的医疗陪护机器人系统

文献发布时间:2023-06-19 11:06:50

技术领域

本发明涉及一种机器人系统,具体涉及一种基于物联网的医疗陪护机器人系统。

背景技术

护理学是以自然科学和社会科学理论为基础的研究维护、促进、恢复人类健康的护理理论、知识、技能及其发展规律的综合性应用科学。在医疗体系逐渐完善和发展的社会,护理人员每天还需要重复做一些简单的、技术含量较低的操作,如逐一给本科室的每一位陪护对象发药,往返于病房间进行病情观察并记录护理记录单等工作,在这种趋势下,医疗陪护机器人的应用将会日益广泛,现有技术中也存在智能医疗机器人,但是大多数的机器人并不能完全满足陪护的需求,比如有些机器人虽然存在预警,但是预警收集的信息不足,预警内容过于单一,无法满足对于使用者快速高效率的诊断要求,从而导致延缓救治的情况发生。

发明内容

针对以上现有技术中存在的技术问题,本发明提出了一种基于物联网的医疗陪护机器人系统。包括机器人系统和医疗机构系统;

所述机器人系统包括机器人、路由器、局域网以及机器人服务器;

所述机器人服务器包括AI系统、语音识别/对话数据库、存储模块和健康测试模块;所述机器人与陪护对象进行对话,经由路由器和局域网被发送到机器人服务器,陪护对象的声音通过AI系统被数字化,经过语音识别/对话数据库转换为文本格式;

所述医疗机构系统包括管理服务器、电子病历服务器和终端;管理服务器包括AI服务器、医学词典数据库和分析数据库;所述AI服务器连接机器人服务器中的AI系统,AI服务器通过深度学习功能针对所述文本格式的关键词进行分析,从而更新和下载分析数据库,同时识别电子病历服务器的数据库的内容,输出关于陪护对象与机器人之间的对话状况的分析数据;

所述机器人包括显示系统和视频系统,显示系统具有识别陪护对象的识别装置和显示图像的图像显示装置,识别装置和图像显示装置均与控制装置连接,图像显示装置包括图像显示器和投影仪,图像显示装置被配置为跟随机器人移动,投影仪以病人活动区域作为投影位置。

进一步地,所述识别装置中包括第一识别装置和第二识别装置,第一识别装置用于识别被陪护对象遮挡后的阴影区域,第二识别装置用于感测与陪护对象关节相对应的特征点,并且识别人体的朝向;当图像显示装置被移动多个位置,第一识别装置和第二识别装置的识别位置均相重合时,判断陪护对象卧床或发生异常情况,则唤醒视频系统,对陪护对象活动区域情况进行监控。

进一步地,所述第二识别装置将陪护对象的人体骨骼抽象成火柴人的图像,检测人体的每个关节的特征点和连接这些特征点的线,从而判断头部或身体的倾斜方向。

进一步地,健康测试模块包含应用程序、用户数据映射单元和分析单元,陪护对象通过与健康测试模块中的应用程序进行交互训练,获得训练情况的数据。

进一步地,用户数据映射单元包括反应测试功能集、手指测试功能集、心理测试功能集和神经测试功能集;反应测试功能集用于通过小游戏测试陪护对象的反应能力,手指测试功能集用于测试陪护对象手指操控能力,心理测试功能集用于测试陪护对象戒备或注意力;心理测试功能集结合反应测试功能集或手指测试功能集的测试结果,进行多对一映射,映射到分析单元,分析单元根据陪护对象的病例及多项测试数据给出分析结果。

进一步地,神经测试功能集用于测试陪护对象眼球运动数据和用户面部运动数据,测得的眼球运动数据和面部运动数据通过用户数据映射单元映射到分析单元,分析单元根据陪护对象的病例及眼球运动数据和面部运动数据给出分析结果。

进一步地,当为陪护对象分配机器人后,机器人根据预先输入的陪护对象的个人资料,确定是否为首次陪护的陪护对象,如果不是首次陪护的陪护对象,则通知机器人服务器调取历次陪护的数据资料,如果是首次陪护的陪护对象,则通知机器人服务器建立新的输入数据。

附图说明

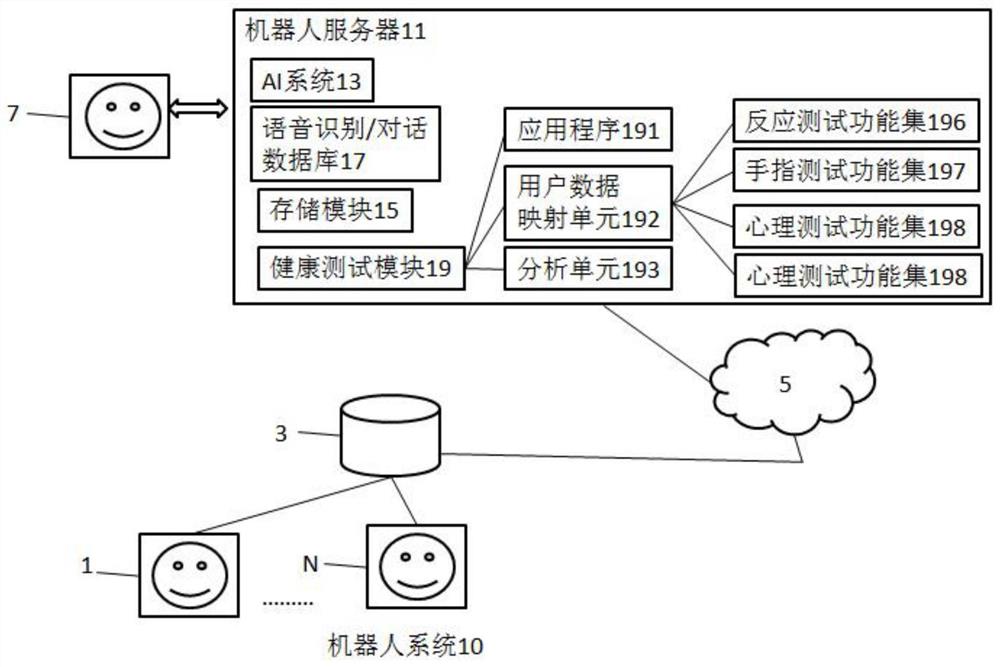

附图1为本发明的医疗陪护机器人系统中的机器人系统的示意图;

附图2为本发明的医疗陪护机器人系统中的医疗机构系统的示意图;

附图3为本发明的医疗陪护机器人系统中的优选实施例中的机器人系统的示意图;

附图4为本发明中的机器人的显示系统和视频系统的示意图;

具体实施方式

本发明的基于物联网的医疗陪护机器人系统,包括机器人系统10和医疗机构系统20。参考图1,机器人系统10包括机器人1、路由器3、局域网5以及机器人服务器11。机器人1具有AI功能并且能够与陪护对象7进行对话,机器人1包括可以听到陪护对象7的声音的麦克风和可以与陪护对象7说话的扬声器。机器人服务器11包括AI系统13和语音识别/对话数据库17,机器人1可以使用AI系统13和语音识别/对话数据库17与陪护对象7进行通信,具体地机器人与陪护对象进行对话,经由路由器和局域网被发送到机器人服务器,陪护对象的声音通过AI系统被数字化,经过语音识别/对话数据库转换为文本格式。

可以为医院中的每个陪护对象安装机器人1,还可以经由在医院中安装多个机器人N,并且通过路由器3和局域网5将多个机器人N连接到机器人服务器11。

参考图2,医疗机构系统20包括管理服务器22、电子病历服务器21和操作员使用的终端23;管理服务器22包括AI服务器221、医学词典数据库222和分析数据库223,电子病历服务器21包括能够存储和读取陪护对象诊断、治疗状态,用药信息等的数据库211。

AI服务器221连接机器人服务器11中的AI系统13,实现陪护对象7和医生和护士进行交流,AI服务器221通过深度学习功能针对上述文本格式的关键词进行分析,从而更新和下载分析数据库223,同时识别电子病历服务器21的数据库211的内容,输出关于陪护对象与机器人之间的对话状况的分析数据。

当为陪护对象分配机器人后,机器人根据预先输入的陪护对象的个人资料,确定是否为首次陪护的陪护对象,如果不是首次陪护的陪护对象,则通知机器人服务器11调取历次陪护的数据资料,如果是首次陪护的陪护对象,则通知机器人服务器11建立新的输入数据。

之后,机器人服务器11需要向机器人1输入与陪护对象有关的人员,操作员可以从终端23手动输入并保存这些简档,将与陪护对象有关的医学信息输入到机器人服务器11的语音识别/对话数据库17。

在优选实施例中,参考图3,机器人服务器11还包括存储模块15和健康测试模块19,医疗信息通过管理服务器22被存储在机器人服务器11的存储模块15中。管理服务器22的AI服务器221识别电子病历服务器21的数据库211的内容,例如,数据库211中关于陪护对象7的诊断或治疗状态的配置文件。此外,由于管理服务器22的AI服务器221具有深度学习功能,因此可以预先进行机器人服务器11的语音识别/对话训练,以便即时回答多个陪护对象经常询问的项目。例如,陪护对象7对机器人1作了一些询问,陪护对象7的声音在机器人1中被数字化,经过SSL处理,经由路由器3和局域网5被发送到机器人服务器11。机器人服务器11的AI系统13将陪护对象7的问题内容的数字化语音转换为文本。然后,AI系统13提取语音关键字,并通过管理服务器22的AI服务器221在管理服务器22的医学词典数据库222和分析数据库223中进行检索。当检索到陪护对象7的问题内容的答案时,机器人服务器11向陪护机器人的语音识别/对话模块17输出结果,当检索不到陪护对象7的问题内容的答案时,则语音识别/对话模块17输出诸如“我试图检查它,但我不理解它”、“抱歉”等消息。

健康测试模块19可以包含例如应用程序191、用户数据映射单元192和分析单元193。陪护对象通过与健康测试模块19的应用程序191的交互,健康测试模块19可以生成能够获取的陪护对象训练情况的数据。

用户数据映射单元192可以包括一个或多个用户健康测试功能集,例如,反应测试功能集196,手指测试功能集197、心理测试功能集198和神经测试功能集199。

反应测试功能集196用于通过小游戏测试陪护对象的反应能力,测得的反应时间数据通过用户数据映射单元192映射到分析单元193,分析单元193根据陪护对象的病例及反应时间数据给出分析结果。

手指测试功能集197,使陪护对象通过鼠标,轨迹球,指示笔移动或类似控制器件,进行游戏任务,测得的手指操控数据通过用户数据映射单元192映射到分析单元193,分析单元193根据陪护对象的病例及手指操控数据给出分析结果。

心理测试功能集198,测试陪护对象戒备或注意力等,心理测试功能集198需要结合反应测试功能集196或手指测试功能集197的测试结果,进行多对一映射,映射到分析单元193,分析单元193根据陪护对象的病例及多项测试数据给出分析结果。

神经测试功能集199,用于测试陪护对象眼球运动数据和用户面部运动数据,测得的眼球运动数据和面部运动数据通过用户数据映射单元192映射到分析单元193,分析单元193根据陪护对象的病例及眼球运动数据和面部运动数据给出分析结果。

参考图4,在优选实施例中,机器人1包括显示系统14和视频系统12,显示系统14具有识别目标陪护对象的识别装置141和显示图像的图像显示装置142,并且它们均与控制装置连接。图像显示装置142包括图像显示器32和投影仪34。投影仪34以陪护对象活动区域作为显示位置。图像显示装置142可以被配置为跟随机器人可移动的。

投影仪发出投影光线到陪护对象活动区域,识别装置141中包括与其无线连接的第一识别装置和第二识别装置,第一识别装置和第二识别装置分开设置在陪护对象活动区域的墙壁上,可以设置多个,第一识别装置用于识别被陪护对象遮挡后的阴影区域,第二识别装置用于感测与关节等相对应的特征点,并且识别人体等的朝向。当图像显示装置142移动多个位置对目标陪护对象进行投影,均得到第一识别装置和第二识别装置的识别位置相重合的信息时,判断陪护对象卧床或发生异常情况,则需唤醒视频系统12,对陪护对象活动区域情况进行监控。

具体地,第二识别装置的识别方法为:将人体骨骼抽象成火柴人的图像,检测人体的每个关节的特征点和连接这些特征点的线。通过将人体骨骼当作火柴人,可以容易地识别出对象的手和脚的位置,关节的位置等。

参照图4,分别检测头顶特征点A和下颌特征点B的坐标。然后,通过计算连接两个特征点的连线与参考平面之间的角度来识别头部的倾斜方向。

分别检测右肩特征点C和左肩特征点D的坐标,并根据特征点C和特征点D之间连线的位置确定身体的倾斜方向。

以上所述,仅为本发明较佳的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,根据本发明的技术方案及其发明构思加以等同替换或改变,都应涵盖在本发明的保护范围之内。

- 一种基于物联网的医疗陪护机器人系统

- 一种基于物联网的智能陪护床柜系统及使用方法