一种基于外观的视线估计方法

文献发布时间:2023-06-19 13:45:04

技术领域

本发明涉及计算机视觉领域,具体涉及一种基于外观的视线估计方法。

背景技术

视线是人类情感分析的重要非语言线索。该领域的研究根据不同的场景与应用大致可分为三类:注视点估计、注视目标估计以及三维视线估计。注视点估计即估算人双目视线聚焦的落点,其一般场景是估计人在一个二维平面上的注视点,二维平面可以是手机屏幕、pad屏幕和电视屏幕等,目前落点误差在3厘米,对手机屏幕、平板电脑屏幕和电视屏幕等来说已经是相当大的误差;注视目标估计即检测给定人物所注视的目标,这类方法较为局限,其要求人与其注视的目标必须同时出现在同一张图片中,这大大限制了其应用范围;三维视线估计是从眼睛图片或人脸图片中推导出人的视线方向,仅使用人脸图片即可,且应用场景广泛。

三维视线估计一般可以分为基于几何的方法和基于外观的方法两大类。基于几何的方法往往需要高分辨率的图像和额外的检测眼睛的模块,而基于外观的方法则是直接学习一个将外观映射到视线方向的模型。在现有技术中大多是基于几何的方法进行视线估计,其实时性和鲁棒性较差。随着现有硬件和神经网络技术飞速发展,基于外观的视线估计方法视线估计精度越来越高,且只需一个普通的摄像头获得人脸图像即可,使得它成为无束缚的视线估计方式,且完全能够满足实际需求也更人性化。

发明内容

本发明针对上述的不足,提供了一种基于外观的视线估计方法,解决视线估计实时性较差和准确性较低的问题。

为了达到本发明的目的,本发明采用的技术方案为:一种基于外观的视线估计方法,包括以下步骤:

步骤1:对公开数据集MPIIFaceGaze进行预处理;

步骤2:搭建轻量级的融合CBAM注意力机制的ResNet网络;

步骤3:将预处理后的数据集送入神经网络进行训练,并保存网络参数;

步骤4:载入神经网络和训练好的神经网络参数,结合dlib人脸检测和OpenCV进行实时的视线估计,得到视线俯仰角、偏航角和翻滚角。

进一步的:对公开数据集MPIIFaceGaze进行预处理,包括以下步骤;

步骤1-1:对公开数据集MPIIFaceGaze通过读取其注解文件获得人脸部关键点,在其注解文件中第4维数据开始到第15维数据每相邻两个维度为脸部关键点的一个坐标(x,y),其中包括左眼的内眼角点和外眼角点、右眼的内眼角点和外眼角点和嘴部两个角点,取左眼两个眼角点的中点为左眼瞳孔中心、右眼两个眼角点的中点为右眼瞳孔中心和嘴部两个角点的中点,所述三个中点为人脸关键点;

步骤1-2:通过头部姿态坐标系S

归一化坐标系S

X

归一化坐标系中眼睛中心的坐标若为(e

S=diag(1,1,λ) (1-2)

步骤1-3:转换矩阵M将输入到原始相机坐标系中的点旋转并缩放到归一化坐标系中,输入图像I使用图像转换矩阵

公式(1-3)中f

步骤1-4:在训练阶段,所有具有真实注释向量g的训练图像I都被归一化或直接由d

进一步的:所述轻量级的融合CBAM注意力机制的ResNet网络结构为:在特征提取网络中输入图像连接conv1(7,7,64)层,conv1(7,7,64)层连接conv2_x1(3,3,64)*2层,conv2_x1与conv2_x2(3,3,64)*2层连接,conv2_x2(3,3,64)*2层连接conv3_x1(3,3,128)*2层,conv3_x1(3,3,128)*2层连接conv3_x2(3,3,128)*2层,conv3_x2(3,3,128)*2层连接conv4_x1(3,3,256)*2层,conv4_x1(3,3,256)*2层连接conv4_x2(3,3,256)*2层,conv4_x2(3,3,256)*2层经过flatten操作再与FC层连接,在每一个残差块中,上一个残差块的输出经过卷积操作得到特征1,特征1经过通道注意力机制CAM后的输出与特征1相乘得到特征2,特征2经过空间注意力机制SAM后的输出与特征2相乘得到特征3,特征3与上一个残差块的输入相加得到本残差块的输出,在网络中每个卷积层后的激活函数使用Relu激活函数。

进一步的:所述网络参数学习方法具体为:将预处理后的图片数据集和标签文件送入搭建好的视线估计网络进行参数学习,并保存训练好的网络参数。

进一步的:使用OpenCV调用摄像头,进行视频数据拍摄并将其拆解为帧图片的数据,然后通过dlib库中的人脸检测算法,检测图片中是否出现人脸出现,若出现人脸且为睁眼状态则将图片数据归一化处理后送入网络,同时调用ResNet网络并载入其网络模型参数,进行在归一化的相机坐标系中的视线向量预测,然后经过逆归一化处理得到视线的角度。

本发明有益效果为:

本发明可直接通过人脸图像求得人的视线角度,采用轻量级的残差网络,检测速度快,融合注意力机制以增大人脸中与视线估计有关的区域的权重,抑制与视线估计无关区域权重,同时具有只需普通的摄像头,无需使用者穿戴任何设备,且可以部署在多种设备上的优点。

附图说明

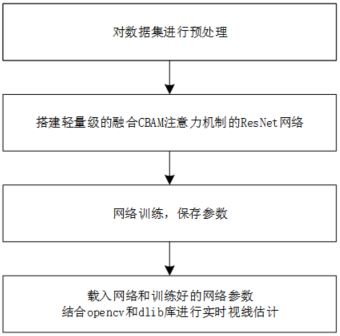

图1为本发明涉及的一种基于外观的视线估计方法整体流程图;

图2为本发明涉及的一种基于外观的视线估计方法的人脸关键点示意图;

图3为本发明涉及的一种基于外观的视线估计方法的注意力机制融合方法图;

图4为本发明涉及的一种基于外观的视线估计方法的网络结构图;

图5为本发明涉及的一种基于外观的视线估计方法的测试流程图;

具体实施方式

在下文中将结合附图对本发明的示范性实施例进行描述。为了清楚和简明起见,在说明书中并未描述实际实施方式的所有特征。然而,应该了解,在开发任何这种实际实施例的过程中必须做出很多特定于实施方式的决定,以便实现开发人员的具体目标,例如,符合与系统及业务相关的那些限制条件,并且这些限制条件可能会随着实施方式的不同而有所改变。

在此,还需要说明的一点是,为了避免因不必要的细节而模糊了本发明,在附图中仅仅示出了与根据本发明的方案密切相关的部分,而省略了与本发明关系不大的其他细节。

具体实施方式一:

本实施方式的一种基于外观的视线估计方法,结合图1所示,包括以下步骤:

步骤1:对公开数据集MPIIFaceGaze进行预处理;

步骤2:搭建轻量级的融合CBAM注意力机制的ResNet网络;

步骤3:将预处理后的数据集送入神经网络进行训练,并保存网络参数;

步骤4:载入神经网络和训练好的神经网络参数,结合dlib人脸检测和OpenCV进行实时的视线估计,得到视线俯仰角、偏航角和翻滚角。

具体实施方式二:

本实施方式的一种基于外观的视线估计方法,结合图2所示,数据预处理包括以下步骤:

步骤1-1:对公开数据集MPIIFaceGaze通过读取其注解文件获得人脸部关键点,在其注解文件中第4维数据开始到第15维数据每相邻两个维度为脸部关键点的一个坐标(x,y),其中包括左眼的内眼角点和外眼角点、右眼的内眼角点和外眼角点和嘴部两个角点,取左眼两个眼角点的中点为左眼瞳孔中心、右眼两个眼角点的中点为右眼瞳孔中心和嘴部两个角点的中点,所述三个中点为人脸关键点;

步骤1-2:通过头部姿态坐标系S

归一化坐标系S

X

归一化坐标系中眼睛中心的坐标若为(e

S=diag(1,1,λ) (1-2)

步骤1-3:转换矩阵M将输入到原始相机坐标系中的点旋转并缩放到归一化的相机坐标系中,输入图像I使用图像转换矩阵

公式(1-3)中f

步骤1-4:在训练阶段,所有具有真实注释向量g的训练图像I都被归一化或直接由d

具体实施方法三:

本实施方式的一种基于外观的视线估计方法,结合图3和图4所示,网络具体结构为:

在特征提取网络中输入图像连接conv1(7,7,64)层,conv1(7,7,64)层连接conv2_x1(3,3,64)*2层,conv2_x1与conv2_x2(3,3,64)*2层连接,conv2_x2(3,3,64)*2层连接conv3_x1(3,3,128)*2层,conv3_x1(3,3,128)*2层连接conv3_x2(3,3,128)*2层,conv3_x2(3,3,128)*2层连接conv4_x1(3,3,256)*2层,conv4_x1(3,3,256)*2层连接conv4_x2(3,3,256)*2层,conv4_x2(3,3,256)*2层经过flatten操作再与FC层连接,在每一个残差块中,上一个残差块的输出经过卷积操作得到特征1,特征1经过通道注意力机制CAM后的输出与特征1相乘得到特征2,特征2经过空间注意力机制SAM后的输出与特征2相乘得到特征3,特征3与上一个残差块的输入相加得到本残差块的输出,在网络中每个卷积层后的激活函数使用Relu激活函数。

具体实施方法四:

本实施方式的一种基于外观的视线估计方法,结合图1和图5所示,训练及测试具体流程为:

将预处理后的图片数据集和标签文件送入搭建好的视线估计网络进行参数学习,并保存训练好的网络参数。使用OpenCV调用摄像头,进行视频数据拍摄并将其拆解为帧图片,然后通过dlib库中的人脸检测算法,检测图片中是否出现人脸出现,若出现人脸且为睁眼状态则将图片数据归一化处理后送入网络,同时调用ResNet网络并载入其网络模型参数,进行在归一化的相机坐标系中视线向量预测,然后经过逆归一化处理得到视线的角度。

尽管根据上述实施例描述了本发明,但是受益于上面的描述,本技术领域内的技术人员明白,在由此描述的本发明的范围内,可以设想其它实施例。此外,应当注意,本说明书中使用的语言主要是为了可读性和教导的目的而选择的,而不是为了解释或者限定本发明的主题而选择的。因此,在不偏离所附权利要求书的范围和精神的情况下,对于本技术领域的普通技术人员来说许多修改和变更都是显而易见的。对于本发明的范围,对本发明所做的公开是说明性的,而非限制性的,本发明的范围由所附权利要求书限定。