多视角遥感图像配准方法及系统

文献发布时间:2023-06-19 11:32:36

技术领域

本发明涉及图像配准技术,具体地,涉及一种端到端的融合多尺度邻域一致性网络与图神经网络的多视角遥感图像配准方法。

背景技术

遥感图像是指由航空器或卫星上成像系统获得的具有地面目标特征的图像。多视角遥感图像指两幅图像(分别称作参考图像和待配准图像)由同一传感器采集,但采集视角有水平或(和)垂直方向上的改变。多视角遥感图像配准是实现图像辅助导航,导弹制导等应用的核心技术。

基于稀疏图像特征(sparse image feature)的配准是目前多视角遥感图像配准中的主要技术,可大致分为特征点提取和特征点匹配两步。首先从待配准的两幅图像中提取特征点,再通过最近邻匹配与RANSAC算法对两个点集进行特征点匹配和外点剔除,最后通过应用某种变换得到配准后图像。Lowe博士于04年完善了尺度不变特征变换(ScaleInvariant Feature Transform,SIFT)算法,具有很高的精度及鲁棒性,对图像旋转、缩放、尺度都具有不变性。后续有很多学者在该方法的基础上进行质量上的改进,但是,基于点特征的自动检测算法的健壮性依然不如人工标注的特征点,尤其是在多视角遥感图像配准中,同一物体在多视角下产生的特征点可能无法匹配甚至错误匹配,原因在于,基于特征点的算法往往更关注图像底层像素级的信息,而忽略图像本身表达的高级特征,因此有很多研究尝试在点特征基础上使用线特征或更复杂的特征进行检测,但提升有限。另外,稀疏图像特征在处理图像非刚性变换时也存在不足。

近年,遥感图像配准领域尝试使用基于深度学习的方法改进特征提取的性能,如Wang博士等通过有监督学习预测两幅图像是否来自同一区域,以此来分辨特征点是否匹配正确;Yang博士等使用VGG-16网络的多层特征图融合结果生成特征点,对多时相遥感图像进行特征提取,再使用改进的CPD算法进行特征匹配。通过在特征提取阶段引入深度学习,遥感图像配准任务得到了较好反馈,但只将深度神经网络当作特征提取器并不能充分利用深度学习的能力,此类方法对深度学习的利用不足,在匹配阶段依然需要传统算法介入,面对复杂的多视角遥感图像时依然会出现较多错误,同时,深度学习需要大量数据作为训练依据,传统遥感图像配准领域缺少公开的数据集,因此,如何获取大量数据也是训练多视角遥感图像配准模型所面临的主要困难。

最近有研究使用深度神经网络代替特征提取及特征匹配两步,即使用端到端的方式对图像进行配准。Detone博士等使用深度学习对两幅图像的单应性变换进行估计,其使用人工合成的数据集进行训练,达到了比传统算法更高的精确度。Rocco 等更进一步设计了一种端到端的框架,进行实例级、类级的图像配准,测试表明该模型在真实场景中也能达到较准确的配准结果。Kim博士等提出一种两阶段配准模型,第一阶段预测旋转变换,第二阶段预测仿射变换,在多时相遥感图像中取得了更好的表现。Park等对待配准图像进行预处理,使网络接受参考、待配准和增强三幅图像,并利用图像全局变换的同构性对模型进行训练,经过测试,该算法在地表变化较大的遥感图像配准中有更高的准确度。该类方法对特征提取和特征匹配两个任务同时训练,在复杂的非刚性图像配准场景中能得到更好的结果,但此类方法也有缺陷:其使用密集图像特征(dense image feature)提取技术,导致最终图像配准精度暂时达不到亚像素要求。

发明内容

针对现有技术中的缺陷,本发明的目的是提供一种多视角遥感图像配准方法及系统,解决复杂场景下多视角遥感图像配准精度低的问题。

根据本发明提供的多视角遥感图像配准方法,包括如下步骤:

步骤S1:根据原始遥感图像生成模拟多视角遥感图像配准的数据集;所述数据集的每一数据包括一参考图像,一待配准图像、由待配准图像向参考图像变换的参数、待配准图像的采样点坐标以及配准后图像的采样点坐标;

步骤S2:通过所述数据集和基于所述采样点的损失函数对深度神经网络模型进行训练和测试生成深度学习模型,所述深度学习模型包括密集配准网络和稀疏配准网络;

步骤S3:通过所述密集配准网络提取参考图像和待配准图像的多尺度特征,对所述多尺度特征进行匹配生成多尺度特征匹配图,根据将所述多尺度特征匹配图生成密集图像配准参数;

步骤S4:通所述稀疏配准网络进行稀疏特征提取,并进行特征匹配生成稀疏匹配参数;

步骤S5:参数融合,将所述密集图像配准参数和所述稀疏图像配准参数进行融合生成目标配准参数;

步骤S6:重采样,根据所述目标配准参数对待配准图像进行重采样,生成配准后图像。

优选地,所述步骤S1包括如下步骤:

步骤S101:在原始遥感图像I中随机选定一个大小为256像素×256像素且中心坐标为p的像素区域PA1;

步骤S102:对像素区域PA1的四个顶点进行幅度为[-x,x]随机扰动,得到新的像素区域PB且计算由像素区域PA1的四个顶点到像素区域PB的四个顶点的单应性变换矩阵HAB;

步骤S103:将单应性变换矩阵HAB的逆矩阵HBA应用于一原始遥感图像I上得到图像I’,再在图像I’上的p点选定一个大小为256像素×256像素的像素区域PA2;

步骤S104:将所述像素区域PA1作为参考图像,所述像素区域PA2作为待配准图像,HAB作为由待配准图像向参考图像变换的参数;

步骤S105:在待配准图像中随机均匀的选择15组采样点坐标S,将变换矩阵HAB 应用于采样点坐标S上得到一组新的采样点坐标S’,S作为配准图像的采样点坐标,S’作为配准后图像的采样点坐标。

优选地,所述密集配准网络包括多尺度密集特征提取网络、邻域一致性网络以及参数预测网络;

所述步骤S3包括如下步骤:

步骤S301:采用多尺度密集特征提取网络分别对参考图像和待配准图像进行特征提取,得到两组多尺度特征图;

步骤S302:采用双向相关运算对相同尺度的两幅特征图进行特征匹配生成一组多尺度特征匹配图;

步骤S303:采用邻域一致性网络对多尺度特征匹配图进行外点剔除,得到一组特征匹配图;

步骤S304:将融合后的特征匹配图输入参数预测网络,得到密集图像配准参数。

所述稀疏配准网络包括稀疏特征提取网络、图神经网络以及参数预测层;

所述步骤S4包括如下步骤:

步骤S401:采用稀疏特征提取网络分别对参考图像和待配准图像进行特征提取,得到两组特征点;

步骤S402:采用图神经网络对两组特征点进行特征匹配,得到匹配参数;

步骤S403:所述参数预测层根据所述匹配参数计算得到稀疏图像配准参数。

优选地,所述采样点的离损失函数L(θ,θ

其中,N取15,为采样点的数量,d为计算两组采样点距离的函数,S为采样点,θ‘为模型预测的参数,θ

优选地,所述密集配准参数和所述稀疏配准参数的融合权值比例为0.5比0.5。

优选地,原始遥感图像的大小范围为640×480像素至2560×1600像素;所述参考图像和所述待配准图像的大小范围为256像素×256像素。

优选地,在步骤S2中随机选择80%的数据集样本作为训练集,20%的样本作为测试集对深度神经网络模型进行训练和测试生成深度学习模型。

优选地,在步骤S302中采用双向相关运算对相同尺度的两幅特征图进行特征匹配时的,其中单向相关运算定义如下式所示:

C

其中,

本发明提供的多视角遥感图像配准系统,包括如下模块:

数据集生成模块:根据原始遥感图像生成模拟多视角遥感图像配准的数据集;所述数据集的每一数据包括一参考图像,一待配准图像、由待配准图像向参考图像变换的参数、待配准图像的采样点坐标以及配准后图像的采样点坐标;

模型训练模块,用于通过所述数据集和基于所述采样点的损失函数对深度神经网络模型进行训练和测试生成深度学习模型,所述深度学习模型包括密集配准网络和稀疏配准网络;

密集图像配准参数生成模块,用于通过所述密集配准网络提取参考图像和待配准图像的多尺度特征,对所述多尺度特征进行匹配生成多尺度特征匹配图,根据将所述多尺度特征匹配图生成密集图像配准参数;

稀疏匹配参数模块,用于通过所述稀疏配准网络进行稀疏特征提取,并进行特征匹配生成稀疏匹配参数;

参数融合模块,用于将所述密集图像配准参数和所述稀疏图像配准参数进行融合生成目标配准参数;

重采样模块,用于根据所述目标配准参数对待配准图像进行重采样,生成配准后图像。

与现有技术相比,本发明具有如下的有益效果:

1、本发明中深度学习模型采用端到端的配准框架,对特征检测和特征匹配两个任务同时进行训练,在复杂的多视角遥感图像配准中能得到更好的配准结果;

2、本发明中深度学习模型结合密集特征点及稀疏特征点配准的框架,能够同时对两幅图像进行基于密集和稀疏特征点的配准,保证了配准结果准确度及对非刚性变换的鲁棒性;

3、本发明通过基于图像采样点的损失函数进行模型训练,能够更好的衡量训练时模型的损失。

4、本发明采用生成多视角遥感图像配准有监督数据集的方法,能够很好的缓解了配准数据集制作困难的问题。

附图说明

通过阅读参照以下附图对非限制性实施例所作的详细描述,本发明的其它特征、目的和优点将会变得更明显:

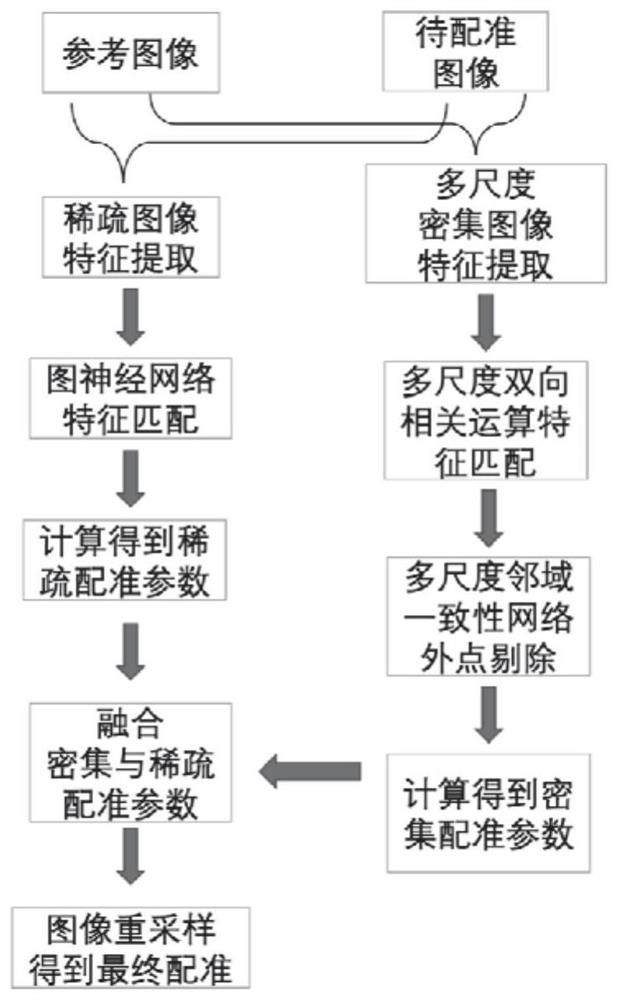

图1为本发明实施例中多视角遥感图像配准方法的流程图;

图2为本发明实施例中多尺度密集特征提取层的结构图;

图3为本发明实施例中是双向相关运算的示意图;

图4为本发明实施例中邻域一致性网络的结构图;

图5为本发明实施例中密集配准参数预测网络的结构图;

图6为本发明实施例中稀疏特征提取网络的机构图;

图7为本发明实施例中在真实数据上的配准结果;

图8为本发明实施例中配准方法与SIFT算法在真实数据上的定性对比;

图9为本发明实施例中配准方法与SIFT算法在真实数据上的定量对比。

具体实施方式

下面结合具体实施例对本发明进行详细说明。以下实施例将有助于本领域的技术人员进一步理解本发明,但不以任何形式限制本发明。应当指出的是,对本领域的普通技术人员来说,在不脱离本发明构思的前提下,还可以做出若干变形和改进。这些都属于本发明的保护范围。

本发明中多视角遥感图像配准方法的使用基于一假设,即:

(1)航空和航天遥感成像的距离非常远,成像目标区域相对于成像元件近似为一个平面;

(2)在不同视角对成像目标进行观察的运动可以近似为成像元件绕成像目标的单纯旋转运动。

满足上述假设的透视变换,可由单应性矩阵解决,如下式所示,该公式将原始遥感图像中坐标(x,y)的像素映射至配准后图像中的(x′,y′)处,具体定义如下式(1):

为了方便神经网络对输出参数进行优化,本发明实施例中采用4点参数模型公式(2) 描述上式。4点参数模型如下式所示,该模型使用两幅图像的对应四个点的坐标(x

图1为本发明实施例中多视角遥感图像配准方法的流程图,如图1所示,本发明提供的多视角遥感图像配准方法,包括如下步骤:

步骤S1:根据原始遥感图像生成模拟多视角遥感图像配准的数据集;所述数据集的每一数据包括一参考图像,一待配准图像、由待配准图像向参考图像变换的参数、待配准图像的采样点坐标以及配准后图像的采样点坐标;

在本发明实施例中,所述步骤S1包括如下步骤:

步骤S101:在原始遥感图像I中随机选定一个大小为256像素×256像素且中心坐标为p的像素区域PA1;

步骤S102:对像素区域PA1的四个顶点进行幅度为[-x,x]随机扰动,得到新的像素区域PB且计算由像素区域PA1的四个顶点到像素区域PB的四个顶点的单应性变换矩阵HAB;

步骤S103:将单应性变换矩阵HAB的逆矩阵HBA应用于一原始遥感图像I上得到图像I’,再在图像I’上的p点选定一个大小为256像素×256像素的像素区域PA2;

步骤S104:将所述像素区域PA1作为参考图像,所述像素区域PA2作为待配准图像,HAB作为由待配准图像向参考图像变换的参数;

步骤S105:在待配准图像中随机均匀的选择15组采样点坐标S,将变换矩阵HAB 应用于采样点坐标S上得到一组新的采样点坐标S’,S作为配准图像的采样点坐标,S’作为配准后图像的采样点坐标。

在本发明实施例中,所述数据集为有监督数据集。原始遥感图像的大小范围为640×480像素至2560×1600像素。所述参考图像和所述待配准图像的大小范围为256 像素×256像素。

步骤S2:通过所述数据集和基于所述采样点的损失函数对深度神经网络模型进行训练和测试生成深度学习模型,所述深度学习模型包括密集配准网络和稀疏配准网络;

在本发明实施例中,随机选择80%的数据集样本作为训练集,20%的样本作为测试集。

在本发明实施例中,所述采样点的离损失函数L(θ,θ

其中,N取15,为采样点的数量,d为计算两组采样点距离的函数,S为采样点,θ‘为模型预测的参数,θ

步骤S3:通过所述密集配准网络提取参考图像和待配准图像的多尺度特征,对所述多尺度特征进行匹配生成多尺度特征匹配图,根据将所述多尺度特征匹配图生成密集图像配准参数;

在本发明实施例中,所述步骤S3包括如下步骤:

步骤S301:采用多尺度密集特征提取网络分别对参考图像和待配准图像进行特征提取,得到两组多尺度特征图;

步骤S302:采用双向相关运算对相同尺度的两幅特征图进行特征匹配生成一组多尺度特征匹配图;

步骤S303:采用邻域一致性网络对多尺度特征匹配图进行外点剔除,得到一组特征匹配图;

步骤S304:将融合后的特征匹配图输入参数预测网络,得到密集图像配准参数。

在本发明实施例中,如图2所示,在图像输入阶段,将输入的默认大小调整为 256*256,如果需要提高输入图像的质量,可以堆叠更深的特征提取网络结构,并保证特征提取的输出与后面网络的输入匹配即可,综合网络运行效率与特征提取质量的考虑。所述多尺度密集特征提取网络的输入为一幅RGB图像,输出为4个尺度的特征图。多尺度密集特征提取网络共有5层卷积层,通过4次池化操作将输入图像大小缩减一半,在第五层卷积层之后,得到中间层M5,之后再通过3次参数为2的反卷积操作与分别来自第4、3、2层的跨层1*1连接的相加操作,依次得到中间层M4,M3,M2,最终再通过对 M2、M3和M4的3*3卷积操作得到4个不同尺度的特征。其中,通过跨层连接,顶层的特征图与底层的特征图得以融合得到更加丰富的语义信息,1*1卷积可以降低通道维度, 3*3卷积可以消除混叠效应。

如图3所示,在本发明实施例中采用多尺度双向相关运算特征匹配层进行特征匹配。设输入的两张特征图为A和B,相关运算可以计算出A中某一特征与B中所有特征的相似性,本发明使用双向的相关运算进行特征匹配,比起单向的相关运算,双向的方式计算特征图A所有特征与特征图B所有特征的相似性,可以更好的避免误匹配现象,提升准确率。

单向相关运算定义如下式所示:

C

其中,

在默认图像输入大小下,所述双向相关运算特征匹配层输入为2个192*16*16大小的特征图,输出大小为256*16*16的3维特征图,再经过调整得到16*16*16*16的4维特征图。输出特征图C

为进一步剔除误匹配特征,对特征图进行ReLU激活函数处理及归一化。归一化操作定义如下式所示:

其中,features为相关运算输出的匹配特征图,n为特征图的第一维大小,ξ取0.000001,F为归一化后输出特征图。得到两个归一化的特征匹配信息后,将C

在本发明实施例中,所述邻域一致性(neighbourhood consensus)是指:

a、正确的匹配特征点具有一定的一致性;

b、正确匹配点周围的匹配特征点相互支持。

双向相关运算特征匹配层输出的4维匹配特征图包含了所有图像所有密集特征点之间的匹配分数,其中包含了大量的错误匹配,如何在其中找到正确匹配的特征是比较困难的,因此,本发明实施例中采用4维卷积操作来剔除不匹配特征。4维卷积操作h定义如下所示,其中i、j、k、l分别代表四个维度,d

如图4所示,在邻域一致性网络中,每个4维卷积后都接一个ReLU运算,增加非线性处理能力。4维卷积共有三层,每一层4维卷积基于邻域一致性处理并提取输入匹配图中的所有邻域的匹配关系,第一层4维卷积的卷积核为5,可以学习到不同的局部几何变换,输出通道为16,第二层4维卷积的卷积核为5,类似2维卷积那样进一步处理邻域中的匹配关系,输出通道为16,第三层4维卷积的卷积核为5,输出通道为1,更深的4维卷积层可以像普通卷积神经网络一样,提取更加复杂的模式及关系,并合并本层及上层的输出,最终得到处理后的匹配图。

如图5所示,在本发明实施例中,所述参数预测网络根据多尺度邻域一致性网络输出的多个匹配图生成预测参数。该网络基本块包括两个卷积层和3层全连接层,除最后一层全连接层以外,每一层网络后都连接一个批归一化层和ReLU激活函数。

默认图像输入大小下,参数预测网络的基本块输入为256维大小16*16的特征图,第一层卷积核大小为5,输入通道256维,输出通道128维,后两层卷积核大小为1,通道数分别减少至64和32。全连接层输入大小为1152,经过一个隐含层后减少至最终 8个,输出密集配准参数。

步骤S4:通稀疏配准网络进行稀疏特征提取,并进行特征匹配生成稀疏匹配参数;在本发明实施例中,所述稀疏配准网络包括稀疏特征提取网络、图神经网络以及参数预测层;

所述步骤S4包括如下步骤:

步骤S401:采用稀疏特征提取网络分别对参考图像和待配准图像进行特征提取,得到两组特征点;

步骤S402:采用图神经网络对两组特征点进行特征匹配,得到匹配参数;

步骤S403:所述参数预测层根据所述匹配参数计算得到稀疏图像配准参数。

如图6所示,在本发明实施例中,所述稀疏特征提取网络采用预训练的VGG网络作为特征提取网络的骨干网结构,VGG网络由5个卷积层和每个卷积层之后的最大池化层组成,稀疏特征点选取来自第3个最大池化层pool3、第4个最大池化层pool4及第5 个最大池化层pool5_1合成所得。在输入图像上划分一个32*32的网格,每个网格的分辨率为8*8,在每个网格的中心生成对应的特征描述符,pool3层的输出为32*32*256 维的特征图,pool4层输出为16*16*512维的特征图,pool5_1层输出为8*8*512维特征图。Pool4和pool5_1生成的特征图还需进行克罗内克积以调整大小,具体操作定义如下式所示,其中

得到3组归一化的特征描述符D1、D2和D3后进行特征预匹配,删除不匹配的描述符,两个特征点x和y的预匹配公式如下式所示,其中,d

距离函数d

d

该阶段输出为预匹配后的稀疏特征点集,其中包含特征点的坐标和对应特征描述符。

在本发明实施例中,所述图神经网络匹配特征采用预训练的图卷积神经网络做稀疏特征匹配,其中,图的每一个节点代表图像中的每一个特征点,图中的边包含两种类型:一种边E

经过1层操作后,即可得到本层输出,即图像A的匹配描述符f

得到图像A和图像B的匹配描述符后,计算二者的内积得到两幅图像的匹配得分图,得分图S

在本发明实施例中,在计算密集配准参数时,根据两幅图像的匹配得分图预测稀疏配准参数。

步骤S5:参数融合,将所述密集图像配准参数和所述稀疏图像配准参数进行融合生成目标配准参数;

在本发明实施例中,所述密集配准参数和所述稀疏配准参数的融合权值比例为0.5 比0.5。

步骤S6:重采样,根据所述目标配准参数对待配准图像进行重采样,生成配准后图像。

实验分析与对比

为保证训练及测试图片的质量及多样性,本发明实施例中训练及测试所使用的遥感图像取自谷歌地球软件(Google Erath Pro,开启3D地形模式)、UCMerced_LandUse 数据集和NWPU VHR-10数据集。

实验训练软件环境为Ubuntu 16.04,Pytorch版本1.0.1,CUDA版本9,cuDNN版本7,Python版本3.6;硬件环境为GTX 1070显卡,Ryzen 5 2600处理器及16G内存。实验测试环境为Intel Core i5-7360U处理器,8G内存。

网络使用Pytorch的随机梯度下降(Stochastic Gradient Descent,SGD)优化器优化,学习率设置为0.0001,动量值设置为0.9,损失函数为输出参数的均方误差(MeanSquare Error,MSE)。模型Batch Size设置为16,训练总epochs为35,总迭代次数为20000,每100次迭代记录一次损失和精度。

图7为本发明实施例中在真实数据上的配准结果。三幅图均为从不同视角对同一地面物体进行拍摄得到,参考与待配准图像差别较大,存在明显高度起伏,河道弯曲等非刚性变化,比起普通的平面旋转、平移和缩放更加复杂,从3组配准结果看,配准后图像在空间特征和几何相似性上与参考图像非常接近,在细节处理上,主要特征没有出现明显的错位,颜色过渡自然,整体上,各个特征都较精确配准,几乎没有出现未对齐区域。

为进一步验证本发明实施例中对于多视角遥感配准的性能提升,图8为本发明与SIFT的定性对比,使用11*11的棋盘格进行参考图像与配准后图像的交替融合。棋盘格融合图可以方便地对配准性能定性对比,本实验中,出现棋盘格的为未配准区域(指示此区域配准性能较差)或因视角变化产生的非重叠区域(与配准性能无关)。红色方框标出的区域可以展示各试验结果中衡量配准精度的细节。

a、b、c、d图像配准的定量分析如图9所示。在所有测试数据上(真实遥感图像) 均匀、随机的选择15组采样点用作配准误差测试,使用平均绝对误差(MAD)、均方根误差(RMSD)、误差中值(MD)和误差标准差(STD)作为定量分析标准,所有数值结果均是越小越好,单位为像素。本发明在大部分情况下都可以取得最好精度。

本发明实施例中深度学习模型采用端到端的配准框架,对特征检测和特征匹配两个任务同时进行训练,在复杂的多视角遥感图像配准中能得到更好的配准结果;本发明中深度学习模型结合密集特征点及稀疏特征点配准的框架,能够同时对两幅图像进行基于密集和稀疏特征点的配准,保证了配准结果准确度及对非刚性变换的鲁棒性。

以上对本发明的具体实施例进行了描述。需要理解的是,本发明并不局限于上述特定实施方式,本领域技术人员可以在权利要求的范围内做出各种变形或修改,这并不影响本发明的实质内容。

- 多视角遥感图像配准方法及系统

- 一种结合SIFT点和控制线对的光学遥感图像配准方法及系统