移动体控制装置、移动体控制方法及存储介质

文献发布时间:2023-06-19 11:47:31

技术领域

本公开涉及移动体控制装置、移动体控制方法及存储介质。

背景技术

已知有通过身体动作来操作车辆的技术(例如,参照专利文献1)。在专利文献1所记载的技术中,在使加速器踏板、方向盘等驾驶操作件成为无法操作的状态的基础上执行车辆的自动驾驶的情况下,当向控制部输入拍摄装置等拍摄到的用户的手势等时,控制车辆的加速减速、操舵,变更行驶路径。

现有技术文献

专利文献

专利文献1:日本特开2018-172028号公报

发明内容

发明所要解决的课题

在专利文献1所记载的技术中,不是由用户操作驾驶操作件来进行驾驶,而是作为替代基于用户的身体动作来控制车辆的加速减速、操舵。因此,车辆等移动体的驾驶员能够获得驾驶的乐趣,但搭乘于该移动体的其他搭乘者难以享受搭乘移动体的乐趣。另外,对于驾驶员而言,例如在交通拥堵期间等那样需要断断续续地停止移动体的操作的情况下,难以享受搭乘移动体的乐趣。从这些方面出发,需要能够使搭乘于移动体的用户享受搭乘带来的乐趣的技术。

本公开是鉴于上述内容而做出,其目的在于,提供一种能够使搭乘于移动体的用户享受搭乘带来的乐趣的移动体控制装置、移动体控制方法及程序。

用于解决课题的技术方案

为了解决上述的课题而达成上述目的,本公开涉及的移动体控制装置具备具有硬件的处理器,所述处理器,取得移动体的外部和内部中的至少一方的空间信息,基于所述空间信息生成包含所述移动体的外部和内部中的至少一方的信息的假想图像并向搭乘于所述移动体的用户能够视觉识别的显示部输出,在所述用户进行了预定的动作的情况下,取得所述用户的所述动作的检测结果,基于所述检测结果中的所述用户的所述动作来更新并输出所述假想图像,输出基于所述检测结果的对所述移动体的控制信号。

根据该构成,搭乘的用户能够一边观察假想图像一边进行与假想图像对应的动作,并且能够与该用户的动作对应地控制移动体,所以搭乘于移动体的用户能够享受搭乘带来的乐趣。

在本公开的一技术方案涉及的移动体控制装置中,可以是,所述处理器,算出所述移动体的安全度,在所述安全度满足预定的基准的情况下,将所述控制信号向所述移动体输出。

根据该构成,能够在确保移动体的行驶上的安全性的基础上执行移动体的控制,所以能够给予搭乘的用户安心感。

在本公开的一技术方案涉及的移动体控制装置中,可以是,所述处理器,取得所述移动体的位置信息和基于所述位置信息的交通信息,在基于所述交通信息判定为所述移动体卷入交通拥堵的情况下,将所述控制信号向所述移动体输出。

根据该构成,能够在移动体卷入交通拥堵的期间执行移动体的控制,所以即使在交通拥堵时搭乘于移动体的用户也能够享受乐趣,能够缓解在卷入了交通拥堵的状况下用户容易感觉到无聊、有压力的情况。

在本公开的一技术方案涉及的移动体控制装置中,可以是,所述处理器,取得所述移动体的位置信息和基于所述位置信息的交通信息,在所述用户进行了预先设定的动作的情况下,基于所述交通信息生成从所述移动体的上方的视点观察所述移动体的外部的状态的假想图像,并向所述显示部输出。

根据该构成,用户能够在视觉上识别外部的状况,所以例如在移动体卷入了交通拥堵的情况下等,能够俯瞰地识别交通拥堵的状态,所以能够缓解用户因交通拥堵而容易感觉到有压力、不安的情况。

在本公开的一技术方案涉及的移动体控制装置中,可以是,所述显示部设置于所述用户穿戴的可穿戴设备。

根据该构成,即使用户进行各种动作,用户也能够始终视觉识别显示于显示部的假想图像,所以能够维持用户感受到的临场感。

在本公开的一技术方案涉及的移动体控制方法中,具有硬件的处理器,从第1传感器取得移动体的外部和内部中的至少一方的空间信息,基于所述空间信息生成包含所述移动体的外部和内部中的至少一方的信息的假想图像并向搭乘于所述移动体的用户能够视觉识别的显示部输出,在搭乘于所述移动体的用户进行了预定的动作的情况下,取得第2传感器检测出的所述用户的所述动作的检测结果,基于所述检测结果中的所述用户的所述动作来更新并输出所述假想图像,输出基于所述检测结果的对所述移动体的控制信号来控制所述移动体。

根据该移动体控制方法,搭乘的用户能够一边观察假想图像一边进行与假想图像对应的动作,并且能够与该用户的动作对应地控制移动体,所以搭乘于移动体的用户能够享受搭乘带来的乐趣。

本公开的一技术方案涉及的程序使具有硬件的处理器执行如下处理,所述处理包括:取得移动体的外部和内部中的至少一方的空间信息,基于所述空间信息生成包含所述移动体的外部和内部中的至少一方的信息的假想图像并向显示部输出,在搭乘于所述移动体的用户进行了预定的动作的情况下,取得所述用户的所述动作的检测结果,基于所述检测结果中的所述用户的所述动作来更新并输出所述假想图像,输出基于所述检测结果的对所述移动体的控制信号。

根据该程序,搭乘的用户能够一边观察假想图像一边进行与假想图像对应的动作,并且能够与该用户的动作对应地控制移动体,所以能够使处理器执行能够使搭乘于移动体的用户享受搭乘带来的乐趣的处理。

发明的效果

根据本公开涉及的移动体控制装置、移动体控制方法及程序,搭乘的用户能够一边观察假想图像一边进行与假想图像对应的动作,并且能够与该用户的动作对应地控制移动体,所以搭乘于移动体的用户能够享受搭乘带来的乐趣。

附图说明

图1是示出一实施方式的移动体控制系统的大致构成的示意图。

图2是示出穿戴有具备一实施方式的移动体控制装置的可穿戴设备的乘员所搭乘的移动体的例子的立体透视图。

图3是示出一实施方式的车辆终端装置的功能构成的框图。

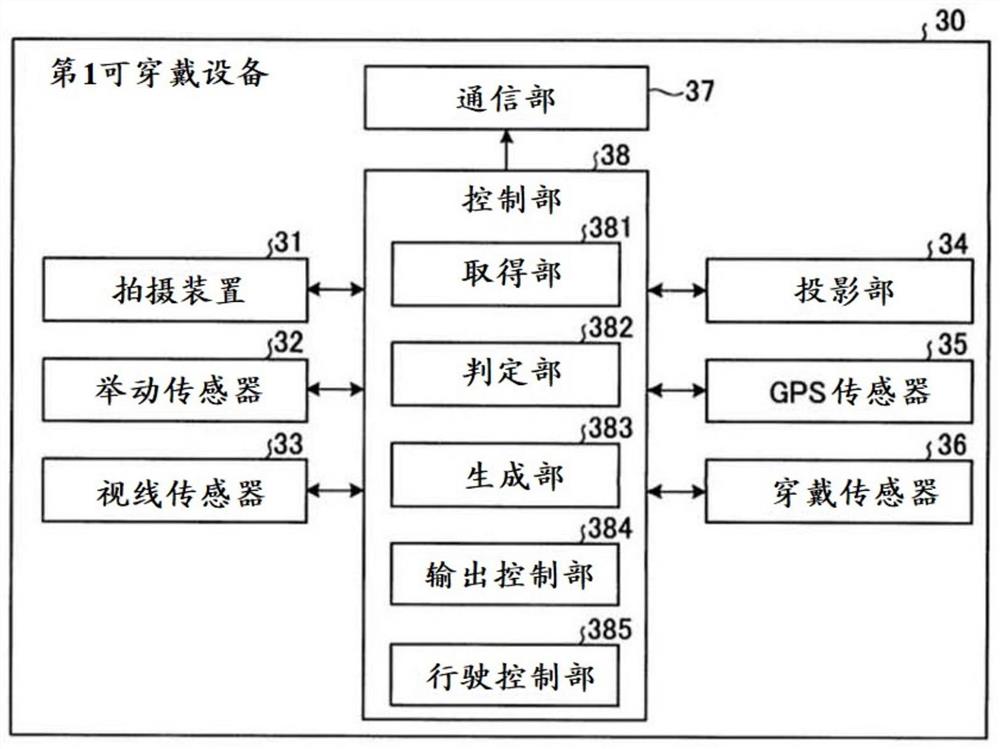

图4是示出一实施方式的第1可穿戴设备的大致构成的图。

图5是示出一实施方式的第1可穿戴设备的功能构成的框图。

图6是示出一实施方式的可穿戴设备所执行的处理的概要的流程图。

图7是示意性地示出一实施方式的生成部所生成的假想图像的例子的图。

图8是示意性地示出一实施方式的生成部所生成的俯瞰的假想图像的例子的图。

图9是示出一实施方式的第1变形例的移动体终端装置的功能构成的框图。

图10是示出一实施方式的第2变形例的第2可穿戴设备的大致构成的图。

图11是示出一实施方式的第2变形例的第2可穿戴设备的功能构成的框图。

图12A是用于说明一实施方式的第3变形例的用户的动作的例子、用户视觉识别的假想图像的例子的图。

图12B是用于说明一实施方式的第4变形例的用户的动作的例子、用户视觉识别的假想图像的例子的图。

图12C是用于说明一实施方式的第5变形例的用户的动作的例子、用户视觉识别的假想图像的例子的图。

图12D是用于说明一实施方式的第6变形例的用户的动作的例子、用户视觉识别的假想图像的例子的图。

图12E是用于说明一实施方式的第7变形例的用户的动作的例子、用户视觉识别的假想图像的例子的图。

图13是示出另一实施方式的可穿戴设备的大致构成的图。

图14是示出另一实施方式的可穿戴设备的大致构成的图。

图15是示出另一实施方式的可穿戴设备的大致构成的图。

图16是示出另一实施方式的可穿戴设备的大致构成的图。

标号说明

1:移动体;

2:网络;

10、10A:移动体终端装置;

11、11A、21、38、49:控制部;

12:拍摄部;

13:传感器组;

13a、33、45:视线传感器;

13b:车速传感器;

13c:开闭传感器;

13d:座椅传感器;

13e:动作传感器;

15:车辆导航系统;

16、22、37、48:通信部;

17、23:存储部;

17a:地图数据库;

18:行驶部;

19:室内设备;

20:交通信息服务器;

23a:交通信息数据库;

24:交通信息收集部;

30:第1可穿戴设备;

31、41:拍摄装置;

32、42:举动传感器;

34:投影部;

35:GPS传感器;

36、46:穿戴传感器;

39:透镜;

40:第2可穿戴设备;

43:声音输入装置;

44、152a:显示部;

47:操作部;

100A、100B、100C、100D:可穿戴设备;

111、381、491:取得部;

112、382、492:判定部;

113、383、493:生成部;

114、384、494:输出控制部;

151:定位部;

152:报知部;

152b:声音输出部;

385、495:行驶控制部。

具体实施方式

以下,参照附图对本公开的一实施方式进行说明。此外,在以下的一实施方式的所有附图中,对同一或对应的部分标注相同的标号。另外,本公开不被以下所说明的一实施方式限定。

首先,对本公开的一实施方式的移动体控制装置进行说明。图1是示出包括该一实施方式的移动体控制装置的移动体控制系统的大致构成的示意图。

(移动体控制系统的构成)

如图1所示,移动体控制系统例如具备搭载于移动体1的移动体终端装置10。在移动体1搭乘有穿戴有第1可穿戴设备30的用户U1、搭乘有穿戴有第2可穿戴设备40的用户U2。移动体控制系统也可以还具备经由网络2连接的交通信息服务器20。在该情况下,移动体终端装置10能够经由网络2与交通信息服务器20进行通信。此外,在本说明书中,可穿戴设备是指用户能够穿戴的设备,可以具备显示图像的显示部,也可以不具备显示图像的显示部。

交通信息服务器20收集道路上的交通信息,取得道路上的交通状况等信息。交通信息服务器20具备控制部21、通信部22、存储部23以及交通信息收集部24。

具体而言,控制部21具备CPU(Central Processing Unit:中央处理单元)、DSP(Digital Signal Processor:数字信号处理器)、FPGA(Field-Programmable Gate Array:现场可编程门阵列)等处理器、和RAM(Random Access Memory:随机存取存储器)、ROM(ReadOnly Memory:只读存储器)等主存储部。

通信部22例如是LAN(Local Area Network:局域网)接口板、用于无线通信的无线通信电路等,使用能够进行有线通信或无线通信的通信模块构成。LAN接口板、无线通信电路能够与作为公共通信网的因特网等网络2连接。另外,也可以是,通信部22能够按照预定的通信标准,例如4G、5G、Wi-Fi(Wireless Fidelity:无线保真)(注册商标)以及Bluetooth(蓝牙)(注册商标)等与外部进行通信。通信部22也可以连接于网络2,与移动体终端装置10等进行通信。通信部22也可以连接于网络2,在其与取得交通信息的信标台(beacon)等之间进行通信。通信部22根据需要向移动体终端装置10发送交通信息。此外,由通信部22发送的信息不限定于上述的信息。

存储部23由从EPROM(Erasable Programmable ROM:可擦除可编程只读存储器)、硬盘驱动器(HDD:Hard Disk Drive)、SSD(Solid State Drive:固态驱动器)、以及可移动介质(Removable Media)等中选择的存储介质构成。此外,可移动介质例如是USB(Universal Serial Bus:通用串行总线)存储器、或CD(Compact Disc:光盘)、DVD(DigitalVersatile Disc:数字多功能光盘)、或BD(Blu-ray(注册商标)Disc:蓝光光盘)这样的光盘记录介质。在存储部23能够存储操作系统(Operating System:OS)、各种程序、各种表、各种数据库等。

控制部21将存储于存储部23的程序加载到主存储部的工作区域并执行,通过执行程序来控制各构成部等。由此,控制部21能够实现与预定的目的相符的功能。在存储部23存储有交通信息数据库23a。

交通信息收集部24经由通信部22从例如设置于道路等的信标台等无线电波发送台收集交通信息。交通信息收集部24收集到的交通信息以能够检索的方式存储于存储部23的交通信息数据库23a。此外,交通信息收集部24也可以还具备存储部。另外,也可以使交通信息收集部24与控制部21、通信部22以及存储部23分体地构成。

在移动体控制系统中,也可以经由网络2使第1可穿戴设备30和第2可穿戴设备40各自能够相互通信。另外,也可以具备能够经由网络2与移动体终端装置10、第1可穿戴设备30以及第2可穿戴设备40进行通信的其他服务器。在以下的说明中,作为移动体1,以车辆,尤其是能够自主行驶的自动驾驶车辆为例进行说明,但不限定于此,也可以是通过驾驶员的驾驶而进行行驶的车辆、摩托车、无人机、飞机、船舶以及电车等。

(移动体)

图2是示出一实施方式的移动体的例子的立体透视图。在图2中,穿戴有具备移动体控制装置的第1可穿戴设备30的用户U1搭乘于移动体1。

如图2所示,在移动体1中,在室内设置有用户U1搭乘时就座的座椅、显示预定的信息的显示部152a。在图2中用户U1穿戴着第1可穿戴设备30,但不一定需要穿戴。此外,在移动体1是通过驾驶员的驾驶而进行行驶的车辆的情况下,具备方向盘、加速器踏板、制动器踏板等驾驶操作件。

图3是示出一实施方式的移动体1的功能构成的框图。如图3所示,例如车辆等移动体1具备移动体终端装置10、行驶部18以及室内设备19。移动体终端装置10一边与移动体1中的具备其他ECU(Electronic Control Unit:电子控制单元)等的行驶部18协作,一边控制移动体1的行驶。在移动体终端装置10具备自动驾驶的控制程序的情况下,能够通过控制行驶部18来持续进行自动驾驶。移动体终端装置10构成为能够控制室内设备19的各部。

移动体终端装置10具备控制部11、拍摄部12、传感器组13、输入部14、车辆导航系统15、通信部16以及存储部17。传感器组13具备视线传感器13a、车速传感器13b、开闭传感器13c以及座椅传感器13d。

控制部11和存储部17分别具有在物理上与上述的控制部21和存储部23同样的构成。控制部11除了统括地控制移动体终端装置10的各构成要素以外,还通过控制行驶部18而统括地控制搭载于移动体1的各种构成要素的动作。在存储部17存储有由各种地图数据构成的地图数据库17a。

作为移动体1的通信终端的通信部16也可以由通过经由网络2的无线通信与外部的服务器例如交通信息服务器20等进行通信的、例如DCM(Data Communication Module:数据通信模块)等构成。通信部16能够进行与设置于道路的天线等进行通信的路车间通信。即,通信部16也可以在通信部16与取得交通信息的信标台等之间进行路车间通信等。通信部16能够进行在通信部16与其他移动体1的通信部16之间进行通信的车车间通信。路车间通信、车车间通信也可以经由网络2进行。通信部16构成为能够按照预定的通信标准,例如4G、5G、Wi-Fi(Wireless Fidelity)(注册商标)以及Bluetooth(注册商标)等与外部的装置进行通信。通信部16根据需要经由网络2从交通信息服务器20接收交通信息。此外,由通信部16收发的信息不限定于上述的信息。

通信部16通过控制部11的控制,按照上述的预定的通信标准与各种设备进行通信。具体而言,通信部16在控制部11的控制下,能够与搭乘于移动体1的用户U1所穿戴的第1可穿戴设备30进行各种信息的发送/接收。另外,通信部16能够在通信部16与其他移动体1、用户U2所穿戴的第2可穿戴设备40之间进行各种信息的发送/接收。此外,预定的通信标准不限定于上述的标准。

拍摄部12在移动体1的外部设置有多个。拍摄部12例如可以以拍摄视角为360°的方式设置于移动体1的前方、后方以及两侧方这4个部位。进而,拍摄部12也可以在移动体1的内部设置有多个。拍摄部12在控制部11的控制下,通过对移动体1的外部空间和内部空间中的各空间进行拍摄而生成映出外部空间和内部空间的图像数据,并将所生成的图像数据向控制部11输出。拍摄部12使用光学系统和图像(image)传感器来构成。光学系统使用1个或多个透镜来构成。图像传感器由通过接收光学系统成像的被摄体图像而生成图像数据的CCD(Charge Coupled Device:电荷耦合器件)或CMOS(Complementary Metal OxideSemiconductor:互补金属氧化物半导体)等构成。

传感器组13构成为具备各种传感器。例如,视线传感器13a检测包含搭乘于移动体1的用户U1的视线和视网膜的视线信息,并将检测出的视线信息向控制部11输出。视线传感器13a使用光学系统、CCD或CMOS、存储器、以及CPU或GPU(Graphics Processing Unit:图形处理器)等具有硬件的处理器来构成。视线传感器13a例如使用周知的模版匹配(templatematching),将用户U1的例如眼角等眼睛的不动的部分检测为基准点,并且将例如虹膜等眼睛的活动的部分检测为动点。视线传感器13a基于基准点与动点的位置关系来检测用户U1的视线,并将检测结果向控制部11输出。视线传感器13a也可以检测用户U1的视网膜·脉络膜(日语:網脈)并将检测结果向控制部11输出。

此外,在一实施方式中,视线传感器13a通过可视相机来检测用户U1的视线,但不限定于此,也可以通过红外相机来检测用户U1的视线。在由红外相机构成视线传感器13a的情况下,通过红外LED(Light Emitting Diode:发光二极管)等向用户U1照射红外光,从通过利用红外相机对用户U1进行拍摄而生成的图像数据中检测基准点(例如角膜反射)和动点(例如瞳孔),并基于该基准点与动点的位置关系来检测用户U1的视线。

车速传感器13b检测移动体1行驶时的车速,并将检测结果向控制部11输出。开闭传感器13c检测用户出入的门的开闭,并将检测结果向控制部11输出。开闭传感器13c例如使用按压开关等构成。座椅传感器13d检测各座椅的就座状态,并将检测结果向控制部11输出。座椅传感器13d使用在设置于移动体1的各座椅的座面的下方设置的载荷检测装置或压力传感器等来构成。

输入部14例如由键盘或组装于显示部152a而检测显示面板的触摸操作的触摸面板式键盘、或能够与外部之间进行通话的声音输入设备等构成。在此,与外部之间的通话不仅包括与其他移动体终端装置10的通话,还包括例如与操作外部的服务器的操作员、人工智能系统的通话等。在输入部14由声音输入设备构成的情况下,输入部14受理用户U1的声音的输入,并将与所受理的声音相应的声音数据向控制部11输出。声音输入设备使用麦克风、将麦克风所受理的声音转换为声音数据的A/D转换电路、以及放大声音数据的放大电路等来构成。此外,也可以替代麦克风,由能够输出声音的扬声器麦克风(speakermicrophone)构成。

车辆导航系统15具有定位部151和报知部152。定位部151例如接收来自多个GPS(Global Positioning System:全球定位系统)卫星、发送天线的信号,并基于接收到的信号算出移动体1的位置。定位部151使用GPS接收传感器等来构成。也可以通过搭载多个构成定位部151的GPS接收传感器等来提高移动体1的方向精度。此外,作为检测移动体1的位置的方法,可以采用将LiDAR(Light Detection and Ranging、Laser Imaging Detectionand Ranging:光检测与测距、激光成像检测与测距)与三维数字地图组合的方法。报知部152具有显示图像、影像以及文字信息的显示部152a、和发出语音、警报音等声音的声音输出部152b。显示部152a使用液晶、有机EL等的显示器来构成。声音输出部152b使用扬声器等来构成。

车辆导航系统15将由定位部151取得的当前的移动体1的位置与存储于存储部17的地图数据库17a的地图数据重叠。由此,车辆导航系统15能够通过显示部152a和声音输出部152b中的至少一方向用户U1报知包含移动体1当前正在行驶的道路和到目的地的路径等的信息。显示部152a根据控制部11的控制而在触摸面板显示器的画面上显示文字、图形等。此外,车辆导航系统15也可以具备输入部14。在该情况下,也可以由触摸面板显示器、扬声器麦克风等构成显示部152a、声音输出部152b以及输入部14,也可以使显示部152a包括输入部14的功能而发挥作用。声音输出部152b根据控制部11的控制,从扬声器麦克风输出声音、向外部通知预定的信息。

此外,移动体1也可以具备钥匙单元,所述钥匙单元在与用户所拥有的用户终端装置之间,例如进行作为近距离无线通信技术的基于BLE认证信息的认证,执行移动体1的加锁、解锁。

行驶部18具备驱动部181和操舵部182。驱动部181包括移动体1的行驶所需要的驱动装置、将驱动向车轮等传递的驱动传递装置。具体而言,移动体1具备马达、发动机作为驱动源。马达由来自电池的电力驱动。发动机构成为能够利用燃料的燃烧产生的驱动,使用电机等进行发电。所发出的电力被充入能够充电的电池中。移动体1具备传递驱动源的驱动力的驱动传递机构、和用于进行行驶的驱动轮等。操舵部182变更成为操舵轮的车轮的舵角(转向角)来决定移动体1的行驶方向、朝向。

室内设备19例如具备具有倾斜功能的座椅部191。此外,室内设备19也可以还具备空气调节器、车内灯以及桌子等。

(第1可穿戴设备)

接着,对第1可穿戴设备30的构成进行说明。图4是示出第1可穿戴设备30的大致构成的图。图5是示出第1可穿戴设备30的功能构成的框图。

图4和图5所示的具备移动体控制装置的第1可穿戴设备30是用于进行所谓的AR(Augmented Reality:增强现实)的AR眼镜。第1可穿戴设备30在用户U1的视野区域内假想地显示图像、影像以及文字信息等。此外,在本说明书中,有时将假想的图像、影像以及文字信息等统称为假想图像。第1可穿戴设备30具备拍摄装置31、举动传感器32、视线传感器33、投影部34、GPS传感器35、穿戴传感器36、通信部37以及控制部38。

如图4所示,在第1可穿戴设备30设置有多个作为第1传感器的拍摄装置31。拍摄装置31在控制部38的控制下,通过对用户U1的视线的前方进行拍摄而生成图像数据,并将该图像数据向控制部38输出。拍摄装置31使用由1个或多个透镜构成的光学系统、和CCD、CMOS等图像传感器来构成。

如图5所示,作为第2传感器的举动传感器32检测与穿戴有第1可穿戴设备30的用户U1的举动相关的举动信息,并将检测结果向控制部38输出。具体而言,举动传感器32检测在第1可穿戴设备30产生的角速度和加速度作为举动信息,并将检测结果向控制部38输出。进而,举动传感器32通过检测地磁来检测绝对方向作为举动信息,并将检测结果向控制部38输出。举动传感器32可以使用三轴陀螺仪传感器、三轴加速度传感器以及三轴地磁传感器(电子罗盘)等来构成。

视线传感器33检测穿戴有第1可穿戴设备30的用户U1的视线的朝向,并将检测结果向控制部38输出。视线传感器33使用光学系统、CCD、CMOS等图像传感器、存储器、以及CPU等具有硬件的处理器来构成。视线传感器33例如使用周知的模版匹配,将用户U1的例如眼角等眼睛的不动的部分检测为基准点,并且将例如虹膜等眼睛的活动的部分检测为动点。视线传感器33基于这些基准点与动点的位置关系来检测用户U1的视线的朝向。

作为显示部的投影部34在控制部38的控制下,朝向穿戴有第1可穿戴设备30的用户U1的视网膜进行图像、影像以及文字信息等假想图像的投影。投影部34使用RGB激光器、MEMS镜以及反射镜等来构成。RGB激光器射出RGB中的每一个的激光。MEMS镜反射激光。反射镜将从MEMS镜反射的激光投影到用户U1的视网膜上。此外,投影部34也可以在控制部38的控制下,通过将假想图像投影到第1可穿戴设备30的透镜39来进行显示。

GPS传感器35基于从多个GPS卫星接收到的信号算出与第1可穿戴设备30的位置相关的位置信息,并将所算出的位置信息向控制部38输出。GPS传感器35使用GPS接收传感器等来构成。

穿戴传感器36检测用户U1的穿戴状态,并将检测结果向控制部38输出。穿戴传感器36使用检测用户U1穿戴了第1可穿戴设备30时的压力的压力传感器、检测用户U1的体温、脉搏、脑电波、血压以及出汗状态等生命体征信息的生命体征传感器等来构成。

通信部37使用能够进行无线通信的通信模块来构成。通信部37在控制部38的控制下,按照上述的预定的通信标准与移动体终端装置10之间进行各种信息的发送/接收。

控制部38具有在物理上与上述的控制部11、21等同样的构成,使用存储器、和CPU、GPU、FPGA、DSP及ASIC等具有任意硬件的处理器来构成。控制部38控制构成第1可穿戴设备30的各部的动作。控制部38具备取得部381、判定部382、生成部383、输出控制部384以及行驶控制部385。在一实施方式中,控制部38作为移动体控制装置的处理器发挥作用。

取得部381经由通信部37从移动体终端装置10取得各种信息。取得部381例如能够从移动体终端装置10取得交通信息、经由网络2和移动体终端装置10从交通信息服务器20取得交通信息。取得部381能够取得用户U1的举动信息、生命体征信息以及用户识别信息。此外,取得部381也能够经由通信部37和网络2从外部的服务器取得各种信息。

判定部382基于取得部381所取得的各种信息来进行判定。具体而言,判定部382例如能够判定可否进行行驶部18的控制、有无用户U1向移动体1的搭乘、可否开始动作控制、有无基于用户U1的身体信息的动作数据的输入等。此外,用户U1的身体信息包括表示举动的举动信息、生命体征信息、用户识别信息以及视线信息等。另外,判定部382也可以判定是否从移动体终端装置10的输入部14输入了预定的信息。另外,判定部382也可以具有完成了学习的模型,该完成了学习的模型通过使用包括进行判定的输入参数和表示判定结果的输出参数的预定的输入/输出数据组进行了的机器学习而生成。在该情况下,判定部382能够基于将所输入的输入参数输入到完成了学习的模型中而获得的输出参数来进行判定。

控制部38基于视线传感器33检测出的用户U1的视线信息和举动信息,将用户U1的视野区域内的预定的假想图像向投影部34输出。即,生成部383使用取得部381所取得的移动体1的空间信息生成从用户U1的视点观察的假想图像。输出控制部384控制由生成部383生成的假想图像向投影部34的输出。此外,在后面对生成部383所生成的假想图像的详情进行叙述。行驶控制部385基于取得部381所取得的与用户U1的动作相关的动作数据,输出能够经由移动体终端装置10控制移动体1的行驶部18的与动作数据对应的控制信号。

(移动体控制处理)

接着,对第1可穿戴设备30所执行的移动体控制处理进行说明。图6是示出第1可穿戴设备30所执行的处理的概要的流程图。在以下的说明中,各种信息的发送/接收在移动体终端装置10的通信部16与第1可穿戴设备30的通信部37之间直接进行或经由网络2进行,但省略对这一点的每次的说明。此外,虽然在一实施方式中,移动体1是由移动体终端装置10的控制部11控制为能够进行自动驾驶的车辆,但不一定限定于此。

如图6所示,取得部381首先取得第1可穿戴设备30的位置信息和移动体1的位置信息(步骤ST1)。继而,判定部382基于取得部381所取得的第1可穿戴设备30的位置信息和移动体1的位置信息来判定用户U1是否搭乘于移动体1(步骤ST2)。此外,除了第1可穿戴设备30的位置信息和移动体1的位置信息以外,判定部382还可以基于移动体终端装置10的开闭传感器13c的检测结果和座椅传感器13d的检测结果来判定用户U1是否搭乘于移动体1。

在判定部382判定为用户U1没有搭乘于移动体1的情况下(步骤ST2:否),结束移动体控制处理。与此相对,在判定部382判定为用户U1搭乘于移动体1的情况下(步骤ST2:是),处理移至步骤ST3。

在步骤ST3中,取得部381基于所取得的位置信息开始基于路车间通信、车车间通信等的交通信息的取得、来自交通信息服务器20等的交通信息的取得。此外,由取得部381进行的位置信息和交通信息的取得在移动体控制处理的执行期间持续执行。

接着,在步骤ST4中,判定部382判定由举动传感器32检测出的用户U1的动作是否为要求动作控制的开始的要求信号的输入动作。在用户U1的动作是要求信号的输入动作的情况下,伴随着动作而向判定部382输入要求信号。此外,要求动作控制的开始的要求信号也可以基于用户U1对移动体终端装置10的输入部14的操作,从通信部16经由通信部37向取得部381输入。在本说明书中,动作控制是与用户U1的动作、发声等对应地,控制行驶部18来控制移动体1的行驶、控制第1可穿戴设备30中的假想图像内的化身图像等的动作的控制。

在判定部382判定为没有输入要求信号的情况下(步骤ST4:否),反复执行步骤ST4直到输入了要求信号为止。与此相对,在判定部382判定为输入了要求信号的阶段(步骤ST4:是),处理移至步骤ST5。

取得部381取得与移动体1的内部空间和外部空间中的至少一方相关的空间信息(步骤ST5)。具体而言,取得部381经由通信部37取得通过移动体1的拍摄部12对移动体1的内部进行拍摄而生成的图像数据作为与内部空间相关的空间信息。取得部381取得通过移动体1的拍摄部12对移动体1的外部空间进行拍摄而生成的图像数据作为与外部空间相关的空间信息。进而,取得部381取得通过拍摄装置31进行拍摄而生成的图像数据作为空间信息。此外,虽然取得部381取得移动体1的拍摄部12所生成的图像数据作为与外部空间相关的空间信息,但不限定于此,例如也可以基于移动体1的位置信息,从地图数据库17a记录的地图数据中取得移动体1的当前位置的周边的图像数据作为与外部空间相关的空间信息。

接着,在步骤ST6中,生成部383生成假想图像,输出控制部384将所生成的假想图像向投影部34输出。具体而言,生成部383首先使用取得部381所取得的空间信息生成从用户U1的视点观察的假想图像。输出控制部384将生成部383所生成的假想图像向投影部34输出。投影部34将所输入的假想图像朝向用户U1的视网膜投影。由此,用户U1能够识别假想图像。

在此,对生成部383所生成的假想图像进行说明。图7是示意性地示出生成部383所生成的假想图像的一例的图。如图7所示,生成部383基于由取得部381取得的空间信息和交通信息生成假想图像P1。具体而言,生成部383生成与移动体1的内部空间的图像对应的驾驶席等的假想图像。进而,生成部383取得从用户U1的视点观察的手、手臂等的图像、或者生成假想图像。生成部383取得移动体1正在行驶的外部空间的图像、或者生成假想图像。生成部383将所取得的图像、所生成的假想图像进行组合,生成从用户U1的视点观察的假想图像P1。

继而,如图6所示,取得部381取得用户U1的举动信息和生命体征信息等所谓的身体信息(步骤ST7)。此外,也可以还取得用于识别用户U1的用户识别信息。具体而言,取得部381取得举动传感器32检测出的举动信息、穿戴传感器36检测出的生命体征信息。另外,取得部381也可以取得视线传感器33检测出的用户U1的虹膜作为识别用户U1的用户识别信息。取得部381也可以按时序取得移动体1的拍摄部12生成的映出用户U1的图像数据。在该情况下,控制部38也可以通过使用了周知的光流法(optical flow)的物体检测处理、图像处理等,针对时序的图像数据来检测或取得用户U1的举动信息。另外,控制部38也可以针对与图像数据对应的图像,使用周知的模版匹配来检测用户U1的面部,并取得检测出的面部作为用户识别信息。

之后,判定部382基于由取得部381取得的空间信息和举动信息来判定用户U1的身体动作是否发生了变化,即是否向取得部381输入了表示用户U1的动作的动作数据(步骤ST8)。在判定部382判定为没有输入作为预定的动作数据的动作数据的情况下(步骤ST8:否),返回到步骤ST5。与此相对,在判定部382判定为输入了动作数据的情况下(步骤ST8:是),处理移至步骤ST9。

之后,生成部383生成与动作数据对应的假想图像,输出控制部384输出假想图像。具体而言,生成部383使用取得部381所取得的空间信息,与用户U1的动作对应地生成从用户U1的视点或俯瞰的视点观察的假想图像。输出控制部384将生成部383所生成的假想图像P1、假想图像P2向投影部34输出,并朝向用户U1的视网膜投影。

例如,在用户U1进行了转动图7所示的方向盘的动作的情况下,生成部383所生成的假想图像P1成为由用户U1的手来转动方向盘的假想影像。另外,伴随着时间的经过,外部空间的情景也发生变化。由此,用户U1能够识别出假想图像对自身所进行的动作做出了响应。由此,用户U1能够获得驾驶着移动体1那样的感觉,能够享受操作移动体1的乐趣。

另外,例如,在用户U1进行了作为预先设定的动作的、例如类似于鸟的动作等的情况下,生成部383所生成的假想图像P2例如成为如图8所示那样的将视点从移动体1向铅垂上方移动的假想影像。此外,预先设定的动作不一定限定于类似于鸟的动作,可以设定任意的动作。图8是示意性地示出生成部383生成的俯瞰道路等的假想图像的例子的图。图8是特别地示出交通拥堵时的状况的假想图像P2。

如图8所示,生成部383基于取得部381所取得的空间信息和交通信息,生成在从用户U1搭乘的移动体1向铅垂上方移动的视点观察的、道路上的车队等的假想图像。在该情况下,假想图像P2所包含的道路、前方的其他移动体等例如能够使用插图图像等。插图图像能够基于取得部381所取得的空间信息和交通信息而生成。在此,在图8所示的假想图像P2中,描绘了在移动体1正在行驶的道路上出现交通拥堵的状态。即,基于交通拥堵信息等交通信息算出处于交通拥堵状态的移动体的台数,假想地描绘出所算出的移动体的台数的移动体。另外,根据用户U1搭乘的移动体1的信息,既可以生成在地图上显示交通拥堵状态这样的假想图像,也可以生成描绘了交通拥堵的开头的状态的假想图像。进而,也可以在图8所示的假想图像P2上重叠文字信息。在该情况下,在交通拥堵的开头是交通事故现场这样的情况下等,也可以基于包含事故信息的交通信息内容在视觉上描绘事故的状况、通过文字、声音输出事故的状况。

由此,用户U1能够识别当前的移动体1的周围的状况。例如,在移动体1卷入交通拥堵的情况下,用户U1能够通过假想图像P2来识别交通拥堵的开头的状态等。因此,对于用户U1而言,能够在视觉上识别卷入的交通拥堵是何种程度的交通拥堵,所以能够期待缓解因交通拥堵引起的压力、不安感的效果。

接着,在图6所示的步骤ST10中,判定部382判定是否能够通过动作控制来控制行驶部18。例如,判定部382基于取得部381从移动体终端装置10的拍摄部12取得的图像数据、移动体1的位置信息以及当前位置处的交通信息算出移动体1的安全度。在判定部382判定为移动体1的安全度满足预定的基准的情况下(步骤ST10:是),处理移至步骤ST12。在此,例如在用数值导出安全度并且数值越高则越安全的情况下,当导出的安全度的数值为预定值以上时,判定部382设为安全度满足预定的基准。相反地,在用数值导出安全度并且数值越低则越安全的情况下,当导出的安全度的数值为预定值以下等的情况下,设为安全度满足预定的基准。

与此相对,在判定部382判定为移动体1的安全度不满足基准的情况下(步骤ST10:否),移至步骤ST11。控制部38的行驶控制部385断开行驶部18的控制(步骤ST11)。具体而言,控制部38切断或停止从行驶控制部385向移动体终端装置10的用于控制行驶部18的控制信号的发送。在该情况下,移动体终端装置10继续进行基于自动驾驶的控制程序的控制信号下的行驶部18的控制。由此,即使构成为能够与用户U1的动作、发声对应地控制行驶部18,在无法确保安全性的情况下也能够使行驶部18无法被控制,所以能够确保移动体1的安全性。

在此,能够基于各种参数算出安全度。具体而言,能够基于将用户U1搭乘的移动体1的、与前后的移动体1的距离、行驶路径、速度、加速度、周围的紧急车辆等的有无等数值化而得到的值等来算出安全度。另外,能够基于将正在行驶的道路的红绿灯或人行横道的数量、周边的行人的人数、天气状态、道路状态等数值化而得到的值等来算出安全度。此外,也可以使用通过机器学习生成的完成了学习的模型进行移动体1的安全度的算出。

另外,作为判定部382判定是否能够进行基于动作控制的行驶部18的控制的方法,也可以采用使用了安全度的判定以外的方法。例如,判定部382也可以通过判定移动体1是否卷入交通拥堵来判定是否能够进行基于动作控制的行驶部18的控制。在该情况下,在移动体1中车速成为预定速度以下的低速状态持续了预定时间以上的情况下,判定部382能够判定为卷入了交通拥堵。预定速度例如可以任意地设定为10km/h等,预定时间例如也可以任意地设定为10分钟等。另外,判定部382能够基于取得部381所取得的交通信息来判定移动体1在当前位置是否卷入交通拥堵。例如,基于交通信息,在反复进行停止和起步的状态为15分钟以上且车队为1km以上的情况下,判定部382能够判定为移动体1卷入了交通拥堵。此外,可以采用各种方法来判定是否卷入交通拥堵。判定部382在判定为移动体1卷入了交通拥堵的情况下,能够判定为能够进行基于动作控制的行驶部18的控制,但也可以在判定为卷入了交通拥堵的情况下,判定为无法进行基于动作控制的行驶部18的控制。

作为判定部382判定是否能够进行基于动作控制的行驶部18的控制的方法,也可以将上述的使用了安全度的判定和有无交通拥堵的判定进行组合。例如,判定部382也可以在判定为移动体1卷入了交通拥堵、或者判定为移动体1的安全度为预定值以上的情况下,判定为能够进行基于动作控制的行驶部18的控制。

接着,在步骤ST12中,行驶控制部385基于取得部381所取得的用户U1的动作数据输出与动作数据对应的控制信号,并经由移动体终端装置10控制移动体1的行驶部18。以下,对使用了第1可穿戴设备30的移动体1的控制的具体例进行说明。

具体而言,例如,在图7所示的假想图像P1等中,示出从用户U1的视线观察的假想图像。例如,当用户U1进行使转向装置旋转这样的动作时,对行驶部18发送进行行驶路的变更之类的控制信号。接收到控制信号的行驶部18控制操舵部182来变更移动体1的车轮的舵角。由此,移动体1的行驶方向与用户U1的转向装置的旋转对应地进行变更。

另外,也可以显示与移动体1自动驾驶的行驶路对应的文字信息。具体而言,例如,在移动体1此后要在左转弯这样的行驶路上行进的情况下,通过在假想图像P1中显示“请向左转动操控装置”等文字信息来向用户U1报知动作。当与此对应地,用户U1进行向左转动操控装置的动作时,可以在伴随动作的定时下控制行驶部18的操舵部182,以使移动体1向左转弯的方式进行操作。

另外,例如,在显示手摇操控装置等的假想图像,并且用户U1针对假想图像进行了使手摇操控装置旋转这样的动作的情况下,也可以算出用户U1的动作的运动量,根据运动量在电池蓄电。具体而言,也可以基于所算出的用户U1的运动量来进行行驶部18的驱动部181中的发动机的转速的变更等,进行向电池的蓄电。此外,也可以构成为,在移动体1具备实际旋转的手摇操控装置等操作件和发电机,与假想图像一起实际操作手摇操控装置等操作件而进行发电,并将电储存于电池。进而,也可以设定基于由穿戴传感器36检测出的用户U1的生命体征信息而得到的预定的系数,对所算出的运动量乘以预定的系数,从而变更用户U1的动作对驱动部181的控制。例如,关于为了使发动机的转速增加100rpm所需要的运动量的设定,在运动员模式等情况下可以增大该运动量,在通常模式等情况下可以减小该运动量。

另外,例如,在显示制动器、加速器等的假想图像,并且用户U1进行了踩踏加速器的动作的情况下,可以控制行驶部18的驱动部181,使发动机的转速增加、使移动体1加速。同样地,在用户U1进行了踩踏制动器的动作的情况下,可以控制行驶部18的驱动部181,使移动体1的速度减小。

另外,在用户U1正在进行动作的期间,有时在图6所示的步骤ST10、ST11中断开对行驶部18的控制。在该情况下,来自行驶控制部385的控制信号没有被输入到行驶部18,基于动作控制的控制被中断。即使在该情况下,也可以继续进行假想图像P1、P2的生成、投影。在此基础上,也可以将断开了对行驶部18的控制的期间的用户U1的动作预先存储于控制部38,在成为能够进行对行驶部18的控制的阶段反映在行驶部18的控制上。进而,行驶控制部385也可以与生成部383所生成的假想图像、用户U1的动作等对应地控制座椅部191的倾斜功能等,从而变更移动体1的室内的座椅的状态。

继而,如图6所示,在向控制部38输入了指示结束的指示信号的情况下(步骤ST13:是),结束处理。作为向控制部38输入指示结束的指示信号的方法,能够采用各种方法。例如,指示结束的指示信号例如能够通过进行踩踏制动器等的动作、向移动体1的输入部14等输入预定的信息来输入。与此相对,在没有向控制部38输入指示结束的指示信号的情况下(步骤ST13:否),处理返回到步骤ST5。通过以上内容,基于第1可穿戴设备30的移动体1的行驶控制结束。

在移动体是能够自主行驶的移动体的情况下,在用户搭乘于移动体进行移动的期间,不需要由用户进行的驾驶操作。另外,即使在用户搭乘于移动体并伴随着由用户进行的驾驶的情况下,有时也会遇到交通拥堵等。即使在这样的情况下,根据以上所说明的本公开的一实施方式,搭乘于移动体1的用户U1也能够一边观察投影到第1可穿戴设备30的投影部34的假想图像,一边进行与假想图像对应的动作来操作移动体1。由此,用户U1能够享受搭乘移动体1的乐趣、操作移动体1的乐趣。

(第1变形例)

图9是示出一实施方式的变形例的移动体终端装置的功能构成的框图。图9所示的移动体终端装置10A具备控制部11A来替代上述的一实施方式的移动体终端装置10的控制部11,并且传感器组13具备动作传感器13e。控制部11A在物理上具有与控制部11同样的构成。控制部11A具备取得部111、判定部112、生成部113以及输出控制部114。取得部111、判定部112、生成部113以及输出控制部114分别与上述的取得部381、判定部382、生成部383以及输出控制部384同样。作为第2传感器的动作传感器13e检测移动体1内的用户U1的动作。在第1变形例中,控制部11A作为移动体控制装置的处理器发挥作用。

在第1变形例中,生成部113所生成的假想图像显示于显示部152a。用户U1的动作由拍摄部12拍摄、或者由动作传感器13e检测。由此,控制部11的取得部111能够取得用户U1的举动信息。另外,用户U1也可以穿戴能够取得用户U1的生命体征信息等,并且能够与通信部16进行通信的手表型可穿戴设备。在此基础上,也可以经由通信部16从用户U1穿戴的可穿戴设备向移动体终端装置10A的取得部111发送用户U1的生命体征信息。由此,判定部112能够进行基于用户U1的生命体征信息的判定。通过以上的构成,在第1变形例中,也能够获得与上述的一实施方式同样的效果。

(第2变形例)

接着,对一实施方式的第2变形例的第2可穿戴设备40的构成进行说明。图10是示出第2可穿戴设备40的大致构成的图。图11是示出第2可穿戴设备40的功能构成的框图。

图10和图11所示的作为移动体控制装置的第2可穿戴设备40是所谓的用于MR(Mixed Reality:混合现实)或VR(Virtual Reality:虚拟现实)的HMD(Head MountedDisplay:头戴式显示器)。第2可穿戴设备40向用户U2显示将现实世界与假想世界(数字空间)重叠而得到的能够立体观看的图像、影像以及文字信息等。第2可穿戴设备40具备拍摄装置41、举动传感器42、声音输入装置43、显示部44、视线传感器45、穿戴传感器46、操作部47、通信部48以及控制部49。拍摄装置41、举动传感器42、视线传感器45、穿戴传感器46、通信部48以及控制部49分别具有与第1可穿戴设备30的拍摄装置31、举动传感器32、视线传感器33、穿戴传感器36、通信部37以及控制部38同样的构成。在第2变形例中,控制部49作为移动体控制装置的处理器发挥作用。

如图10所示,在第2可穿戴设备40设置有多个作为第1传感器的拍摄装置41。拍摄装置41在控制部49的控制下,通过对用户U2的视线的前方进行拍摄而生成具有视差的两个图像数据,并将这些图像数据向控制部49输出。

如图11所示,作为第2传感器的举动传感器42检测与穿戴有第2可穿戴设备40的用户U2的举动相关的举动信息,并将检测结果向控制部49输出。声音输入装置43受理用户U2的声音的输入,并将与所受理的声音相应的声音数据向控制部49输出。声音输入装置43使用麦克风、将输入到麦克风的声音转换为声音数据的A/D转换电路、以及放大声音数据的放大电路来构成。

显示部44在控制部49的控制下显示能够立体观看的图像、影像以及文字信息等。显示部44使用具有预定的视差的左右一对的显示面板等来构成。作为显示面板,使用液晶或有机EL(Electro Luminescence:电致发光)面板等来构成。操作部47受理用户U2的操作的输入,并将与所受理的操作相应的信号向控制部49输出。操作部47使用按钮、开关、拨动盘(jog dial)、或触摸面板等来构成。

控制部49控制构成第2可穿戴设备40的各部的动作。控制部49具备取得部491、判定部492、生成部493、输出控制部494以及行驶控制部495。取得部491、判定部492、生成部493、输出控制部494以及行驶控制部495分别与上述的取得部381、判定部382、生成部383、输出控制部384以及行驶控制部385同样。

在第2变形例中,生成部493所生成的假想图像显示于显示部44。用户U2的动作由拍摄装置41拍摄、或者由举动传感器42检测。由此,控制部49的取得部491能够取得用户U2的动作信息。通过以上的构成,在第2变形例中,也能够获得与上述的一实施方式同样的效果。

(第3~第7变形例)

接着,对由一实施方式的第3变形例的可穿戴设备30、40显示的假想图像的例子和与假想图像对应的用户的动作进行说明。图12A~图12E分别是用于说明第3变形例~第7变形例的用户的动作的例子、用户视觉识别的假想图像的例子的图。

(第3变形例)

在第3变形例中,如图12A所示,穿戴有可穿戴设备30、40的用户U3例如能够视觉识别手摇辊等的假想图像P3。此外,通常,通过可穿戴设备30、40,仅用户U3处于视觉识别出假想图像P3的手摇辊的状态,但用户U3也可以实际使用手摇辊,与假想图像P3等影像对应地实际转动手摇辊。可穿戴设备30、40也可以与基于用户U3的使假想图像P3的手摇辊旋转的动作、动作量对应地向移动体1的移动体终端装置10发送控制信号而控制发动机的转速等,并将与动作量相应的电力量充入电池。另外,也可以通过可穿戴设备30、40向用户U3报知充电量。

(第4变形例)

在第4变形例中,如图12B所示,穿戴有可穿戴设备30、40的用户U4例如能够视觉识别脚蹬辊等的假想图像P4。此外,通常,通过可穿戴设备30、40,仅用户U4处于视觉识别出假想图像P4的脚蹬辊的状态,但用户U4也可以实际使用脚蹬辊,用户U4与假想图像P4等影像对应地实际脚蹬踏板。可穿戴设备30、40也可以将与基于用户U4的脚蹬假想图像P4的踏板的动作、所蹬的动作量对应的控制信号向移动体终端装置10发送。在该情况下,也可以与用户U4所蹬的动作量对应地控制发动机的转速等而对电池进行充电、与用户U4所蹬的动作量对应地移动移动体1。另外,也可以通过可穿戴设备30、40向用户U4报知对电池的充电量、移动体1的移动量。

(第5变形例)

在第5变形例中,如图12C所示,在穿戴有可穿戴设备30、40的用户U5进行了例如踏脚、抬腿等的情况下,也可以从可穿戴设备30、40向移动体终端装置10发送与踏脚、抬腿的动作、动作量对应的控制信号。此外,也可以从可穿戴设备30、40向用户U5输出催促踏脚、抬腿的动作的显示、声音等。在该情况下,用户U5与来自可穿戴设备30、40的输出对应地进行踏脚、抬腿等动作。移动体终端装置10也可以与用户U5所进行的踏脚或抬腿、或它们的次数等对应地控制发动机的转速、齿轮档位等,对电池进行充电、使移动体1移动。另外,也可以通过可穿戴设备30、40向用户U5报知对电池的充电量、移动体1的移动量。

(第6变形例)

在第6变形例中,如图12D所示,穿戴有可穿戴设备30、40的用户U6例如能够视觉识别哑铃(dumbbell)等的假想图像P5。此外,通常,通过可穿戴设备30、40,仅用户U6处于视觉识别出假想图像P5的哑铃的状态,但用户U6也可以实际使用哑铃、棒等,与假想图像P5的哑铃等影像对应地实际上下移动哑铃、棒等。可穿戴设备30、40也可以与基于用户U6的使假想图像P5的哑铃上下的动作、动作量对应地向移动体终端装置10发送控制信号而控制发动机的转速等,将与动作量相应的电力量充入电池。另外,也可以通过可穿戴设备30、40向用户U6报知充电量。

(第7变形例)

在第7变形例中,如图12E所示,在穿戴有可穿戴设备30、40的用户U7进行了例如左右挥动手臂的运动等的情况下,也可以从可穿戴设备30、40向移动体终端装置10发送与手臂的动作、动作量对应的控制信号。此外,也可以从可穿戴设备30、40向用户U7输出催促踏脚的动作的显示、声音等。在该情况下,用户U7与来自可穿戴设备30、40的输出对应地进行踏脚等动作。移动体终端装置10与用户U7所进行的踏脚、踏脚的次数等对应地控制发动机的转速、齿轮档位等,对电池进行充电、使移动体1移动。另外,也可以通过可穿戴设备30、40向用户U7报知对电池的充电量、移动体1的移动量。

上述的用户U1主要是司机,用户U2~U7既可以是司机,也可以是搭乘于移动体1的同乘者。由此,司机以外的其他搭乘者也能够通过与假想图像对应的自身的动作来识别移动体1的周边区域、控制移动体1,所以能够享受搭乘移动体1的乐趣。另外,在上述的第3~第7变形例中,对与用户的动作对应地对电池进行充电、使移动体1移动的例子进行了说明,但不一定限定于电池的充电、移动体1的移动。即,与用户的动作对应的对移动体1的各种控制能够任意地进行设定。

(记录介质)

在上述的一实施方式中,能够将使移动体终端装置、第1可穿戴设备或第2可穿戴设备执行的程序记录于计算机或其他机器、可穿戴设备等装置(以下,称为计算机等)能够读取的记录介质。通过使计算机等读入并执行该记录介质的程序,该计算机等作为移动体控制装置发挥作用。在此,计算机等能够读取的记录介质是能够通过电、磁、光学、机械、或化学的作用来储存数据、程序等信息,并且能够从计算机等读取的非瞬时性的记录介质。作为这样的记录介质中的能够从计算机等卸下的记录介质,例如有软盘、光磁盘、CD-ROM、CD-R/W、DVD、BD、DAT、磁带、闪存等存储卡等。另外,作为固定于计算机等的记录介质,有硬盘、ROM等。进而,SSD既可以用作能够从计算机等卸下的记录介质,也可以用作固定于计算机等的记录介质。

另外,也可以构成为,使一实施方式的车辆终端装置、第1可穿戴设备及第2可穿戴设备以及服务器执行的程序存储于与因特网等网络连接的计算机上,并通过经由网络下载来提供。

以上,对本公开的一实施方式具体地进行了说明,但本公开不限定于上述的一实施方式,能够基于本公开的技术思想进行各种变形。例如,在上述的一实施方式中列举的假想图像、动作只不过是例子,也可以是与上述不同的假想图像、动作。

(其他实施方式)

在上述的一实施方式中,对使用了用户能够穿戴的眼镜型可穿戴设备、手表型可穿戴设备的例子进行了说明,但不限定于这些,上述的一实施方式能够应用于各种可穿戴设备。例如,能够应用于如图13所示具有拍摄功能的隐形眼镜(contact lenses)型可穿戴设备100A。进而,也能够应用于如图14所示的可穿戴设备100B或图15所示的脑内芯片型可穿戴设备100C那样向用户U100的大脑直接传递的装置。进而,也可以如图16所示的可穿戴设备100D那样构成为具备面罩(visor)的头盔(helmet)形状。在该情况下,可穿戴设备100D也可以将图像投影到面罩上进行显示。

另外,在上述的一实施方式中,第1可穿戴设备通过将图像投影到用户U1的视网膜而使图像可视觉识别,但例如也可以将图像投影到眼镜等的透镜39上进行显示。

另外,在一实施方式中,能够将上述的“部”另称为“电路”等。例如,控制部能够另称为控制电路。

此外,在本说明书中的流程图的说明中,使用“首先”、“之后”、“继而”等表达来明示步骤间的处理的前后关系,但为了实施本实施方式所需的处理的顺序并不是由这些表达唯一地确定的。即,在本说明书中所记载的流程图中的处理的顺序能够在不矛盾的范围内进行变更。

能够由本领域技术人员容易地导出进一步的效果、变形例。本公开的更广泛的技术方案不限定于以上所表示并记述的特定的详细和代表性的实施方式。因此,能够在不脱离由所附权利要求及其等同物定义的总括性的发明的概念的精神或范围的情况下进行各种变更。

- 移动体控制装置、移动体、移动体控制方法及存储介质

- 移动体控制装置、移动体控制方法及存储介质