车载环视方法、装置、系统及车辆

文献发布时间:2023-06-19 09:36:59

技术领域

本申请涉及车载环视技术领域,特别涉及车载环视方法、装置、系统及车辆。

背景技术

车辆智能化的发展,车载图像系统在车辆中应用越来越广泛。在一些应用方案中,车载图像系统可以通过车辆中不同位置的图像采集设备获取车辆多个角度的图像。然后,车载图像系统可以将多个角度的图像投影到一个预设的场景模型中,以生成车身周围的场景图像。车载图像系统可以将图像在显示界面中显示,以便驾驶员了解车辆周围的场景。

然而,车载图像系统中预设的场景模型是一个参考模型,无法真实反映车身周围场景的三维结构。因此,车载图像系统将不同角度的图像投影到预设的场景模型时,存在视角盲区和图像畸变。换言之,图像采集系统生成的图像存在不够真实的问题。

发明内容

本申请提出了一种车载环视方案,能够提高生成的场景图像的真实度,从而提高用户体验度。

根据本申请一个方面,提供一种车载环视方法,其特征在于,包括:

获取多个图像,所述多个图像由布置在车辆上不同位置的多个图像采集设备采集;

对于任一个图像采集设备,确定该图像采集设备采集的图像中每个像素点对应的物距,其中,每个像素点对应的物距表示每个像素点对应的物点与该图像采集设备的镜头之间的距离;

对于任一个图像采集设备,根据该图像采集设备在世界坐标系中位姿信息,和该图像采集设备采集的图像中每个像素点对应的物距,生成与该图像采集设备采集的图像对应的场景结构模型;

融合所述多个图像的场景结构模型,得到融合场景模型;

将所述多个图像中像素点投影到所述融合场景模型,得到所述融合场景模型中的像素点;

根据所述融合场景模型中的像素点,生成目标图像。

在一些实施例中,所述对于任一个图像采集设备,确定该图像采集设备采集的图像中每个像素点对应的物距,包括:基于经过训练的物距估计算法模型,确定该图像采集设备的图像中每个像素点对应的物距。

在一些实施例中,所述对于任一个图像采集设备,确定该图像采集设备采集的图像中每个像素点对应的物距,包括:根据该图像采集设备的畸变校正参数,对该图像采集设备的图像进行畸变校正,得到经过畸变校正的图像;

基于经过训练的物距估计算法模型,确定经过畸变校正的图像中每个像素点对应的物距。

在一些实施例中,所述根据该图像采集设备的畸变校正参数,对该图像采集设备的图像进行畸变校正,得到经过畸变校正的图像,包括:根据该图像采集设备的畸变校正参数,对该图像采集设备的图像进行畸变校正,生成至少两个视角的图像。

在一些实施例中,车载环视方法进一步包括:获取所述多个图像采集设备中每个图像采集设备的畸变校正参数和每个图像采集设备在所述世界坐标系中的位姿信息,其中,所述每个图像采集设备的位姿信息包括:每个图像采集设备在所述世界坐标系中的位置和镜头朝向。

在一些实施例中,所述对于任一个图像采集设备,根据该图像采集设备在世界坐标系中位姿信息,和该图像采集设备采集的图像中每个像素点对应的物距,生成与该图像采集设备采集的图像对应的场景结构模型,包括:根据该图像采集设备在所述世界坐标系中位姿信息,和该图像采集设备采集的图像中每个像素点对应的物距,确定每个像素点对应的物点在所述世界坐标系中的位置;根据每个像素点对应的物点在所述世界坐标系中的位置,生成该图像采集设备采集的图像对应的场景结构模型。

在一些实施例中,所述融合所述多个图像的场景结构模型,得到融合场景模型,包括:拼接所述多个图像的场景结构模型;确定拼接后的所述多个图像的场景结构模型之间的重合区域;对拼接后所述多个图像的场景结构模型中所述重合区域进行平滑处理,得到所述融合场景模型。

在一些实施例中,所述根据所述融合场景模型中的像素点,生成目标图像,包括:确定所述世界坐标系中一个虚拟视点;确定所述虚拟视点对应的视平面和视角范围;将所述融合场景模型中的像素点中处于所述视角范围的像素点,投影到所述视平面,生成所述目标图像。

在一些实施例中,所述多个图像采集设备包括布置在所述车辆前侧的第一图像采集设备、布置在所述车辆后侧的第二图像采集设备、布置在所述车辆左侧的第三图像采集设备和布置在所述车辆右侧的第四图像采集设备,所述多个图像包括第一图像采集设备采集的第一图像、第二图像采集设备采集的第二图像、第三图像采集设备采集的第三图像和第四图像采集设备采集的第四图像。

在一些实施例中,车载环视方法进一步包括:在显示界面中呈现所述目标图像。

在一些实施例中,车载环视方法进一步包括:对所述目标图像进行目标检测,以确定检测到的目标对象,并在所述显示界面中显示检测到的目标与车辆的距离。

根据本申请一个方面,提供一种车载环视装置,包括:

图像获取单元,获取多个图像,所述多个图像由布置在车辆上不同位置的多个图像采集设备采集;

物距确定单元,对于任一个图像采集设备,确定该图像采集设备采集的图像中每个像素点对应的物距,其中,每个像素点对应的物距表示每个像素点对应的物点与该图像采集设备的镜头之间的距离;

场景生成单元,对于任一个图像采集设备,根据该图像采集设备在世界坐标系中位姿信息,和该图像采集设备采集的图像中每个像素点对应的物距,生成与该图像采集设备采集的图像对应的场景结构模型;

场景融合单元,融合所述多个图像的场景结构模型,得到融合场景模型;

投影单元,将所述多个图像中像素点投影到所述融合场景模型,得到所述融合场景模型中的像素点;

图像生成单元,根据所述融合场景模型中的像素点,生成目标图像。

根据本申请一个方面,提供一种车载环视系统,包括:布置在车辆上不同位置的多个图像采集设备;图像处理设备,用于执行根据本申请的车载环视方法。

根据本申请一个方面,提供一种车辆,其特征在于,包括:根据本申请的车载环视系统。

综上,根据本申请的车载环视方案可以根据多个图像采集设备采集车辆周围的多个图像。基于多个图像,本申请的车载环视方案可以确定多个图像中像素点对应的物距。这样,本申请的车载环视方案可以根据像素点对应的物距建立车辆周围环境对应的融合场景模型。本申请的车载环视方案可以将多个图像中像素点投影到融合场景模型中,并生成目标图像。由于通过图像建立模拟真实场景的融合场景模型,本申请的车载环视方案可以避免需要额外安装雷达传感器的麻烦,而可以生成真实度较高的目标图像,并可以避免目标图像中图像畸变的问题和避免目标图像中出现盲区。

附图说明

图1示出了根据本申请一些实施例的应用场景的示意图;

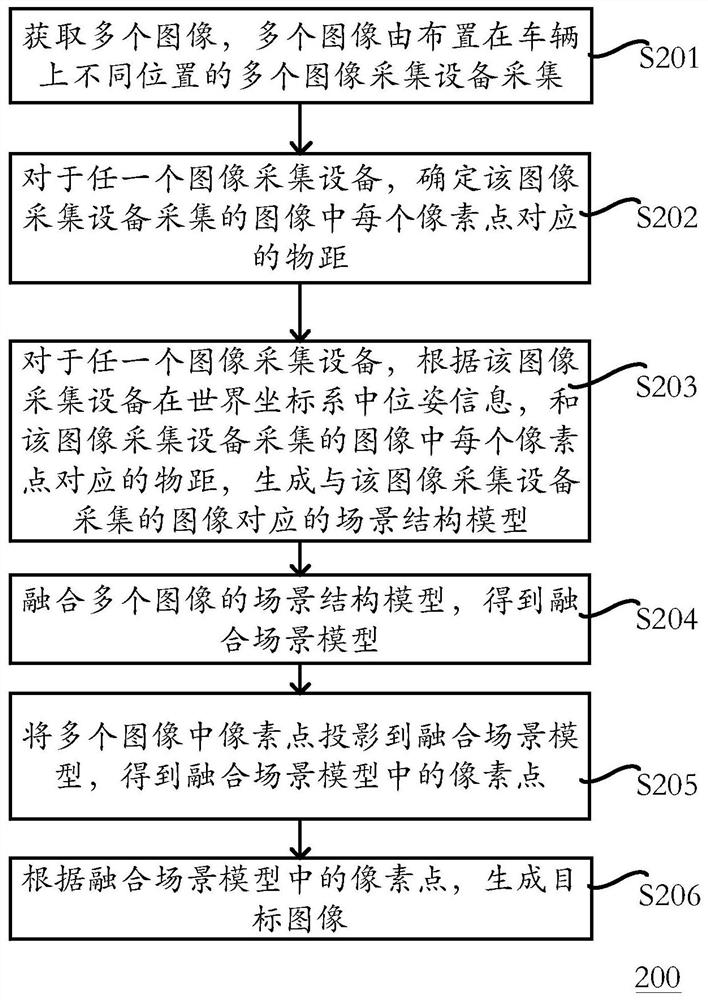

图2示出了根据本申请一些实施例的车载环视方法200的流程图;

图3示出了根据本申请一些实施例的车载环视方法300的流程图;

图4A示出了根据本申请一些实施例的确定像素点对应的物距的方法400的流程图;

图4B示出了根据本申请一些实施例的图像采集设备在水平面内的拍摄角度的示意图;

图4C示出了根据本申请一些实施例的经过畸变校正后的图像在水平面内的角度的示意图;

图5示出了根据本申请一些实施例的生成与图像对应的场景结构模型的方法500的流程图;

图6A示出了一个丁字路口的俯视图;

图6B示出了车辆10的第一图像采集设备30采集的图像的部分像素点的示意图;

图6C中示出了图像处理设备20根据图6B中像素点确定物距的结果示意图;

图7示出了部分像素点投影到融合场景模型的示意图;

图8示出了根据本申请一些实施例的生成目标图像的方法800的流程图;

图9示出了根据本申请一些实施例的车载环视装置900的示意图。

具体实施方式

为使本申请的目的、技术方案及优点更加清楚明白,以下参照附图并举实施例,对本申请进一步详细说明。

图1示出了根据本申请一些实施例的应用场景的示意图。如图1所示,应用场景包括车辆10和车载环视系统。这里,车载环视系统可以包括图像处理设备20和布置在车辆10中不同位置的多个图像采集设备。例如,多个图像采集设备包括在车辆前侧的第一图像采集设备30、在车辆后侧的第二图像采集设备40、在车辆左侧的第三图像采集设备50和在车辆右侧的第四图像采集设备60。这里,车辆可以是图像采集设备例如可以是相机、摄像机、摄像头等具有图像采集功能的设备。图像处理设备20可以属于车辆10的控制系统,或者可以独立安装到所述车辆10中。图像采集设备可以采用鱼眼镜头或者其他广角镜头,以便能够覆盖车辆10周围的区域。

图像处理设备20可以是能够进行图像处理的各种计算设备。图像处理设备20能够以有线通讯方式或者无线通讯方式获取图像采集设备采集的图像。在获取到多个图像采集设备采集的多个图像时,图像处理设备可以利用多个图像生成车辆周围环境的场景结构模型。这里,场景结构模型可以比预设的场景参考模型更接近于车辆周围环境的三维结构。在此基础上,图像处理设备20可以将多个图像投影到场景结构模型中,并生成目标图像。这样,本申请的图像处理设备20通过基于多个图像生成场景结构模型,可以避免使用预设的场景参考模型造成的图像畸变和视角盲区,从而可以提高目标图像的真实度。下面结合图2对图相处理设备20生成目标图像的过程进行说明。

图2示出了根据本申请一些实施例的车载环视方法200的流程图。方法200例如可以由图像处理设备20执行。

在步骤S201中,获取多个图像。多个图像由布置在车辆上不同位置的多个图像采集设备采集。例如,多个图像包括第一图像采集设备30采集的第一图像、第二图像采集设备40采集的第二图像、第三图像采集设备50采集的第三图像和第四图像采集设备60采集的第四图像。步骤S201获取的多个图像例如可以由第一、第二、第三和第四图像采集设备同时拍摄的。

在步骤S202中,对于任一个图像采集设备,确定该图像采集设备采集的图像中每个像素点对应的物距,其中,每个像素点对应的物距表示每个像素点对应的物点与该图像采集设备的镜头之间的距离。这里,每个像素点对应的物距也可以称为被拍摄物体上与像素点对应的物点的深度信息。在一些实施例中,图像采集设备拍摄的图像中每个像素点可以反映所拍摄的环境中物体表面的一个区域。该区域可以称为一个物点。

在步骤S203中,对于任一个图像采集设备,根据该图像采集设备在世界坐标系中位姿信息,和该图像采集设备采集的图像中每个像素点对应的物距,生成与该图像采集设备采集的图像对应的场景结构模型。

在步骤S204中,融合所述多个图像的场景结构模型,得到融合场景模型。这里,融合场景模型可以反映车辆周围360度范围内场景的三维结构。

在步骤S205中,将所述多个图像中像素点投影到所述融合场景模型,得到所述融合场景模型中的像素点。换言之,步骤S205可以将每个像素点投影到其对应的物点的位置处。

在步骤S206中,根据所述融合场景模型中的像素点,生成目标图像。

综上,根据本申请的方法200可以根据多个图像采集设备采集车辆周围的多个图像。基于多个图像,方法200可以确定多个图像中像素点对应的物距。这样,方法200可以根据像素点对应的物距建立车辆周围环境对应的融合场景模型。这样,方法200可以将多个图像中像素点投影到融合场景模型中,并生成目标图像。由于通过图像建立模拟真实场景的融合场景模型,方法200可以避免需要额外安装雷达传感器的麻烦,而可以生成真实度较高的目标图像,并可以避免目标图像中图像畸变的问题和避免目标图像中出现盲区。

图3示出了根据本申请一些实施例的车载环视方法300的流程图。方法300例如可以由图像处理设备20执行。

在步骤S301中,获取多个图像采集设备中每个图像采集设备的畸变校正参数和每个图像采集设备在世界坐标系中的位姿信息。其中,所述每个图像采集设备的位姿信息包括:每个图像采集设备在世界坐标系中的位置和镜头朝向。

另外说明的是,本申请的实施例可以在执行方法300之前,对每个图像采集设备的畸变校正参数和位姿信息进行标定。例如,车辆10的前后左右分别布置标定物。第一、第二、第三和第四图像采集设备分别拍摄处于各自视野内的标定物。根据标定物在图片中坐标和尺寸,以及标定物在世界坐标系中的真实坐标,本申请的实施例可以确定对镜头畸变的补偿参数(即畸变校正参数)、各图像采集设备在车辆10上的安装参数(即在世界坐标系中的位姿信息)、镜头焦距等设备参数。这里,标定物例如为水平布置在地面上的黑白相间的棋盘图案等等,本申请对此不做限制。步骤S301例如可以从本地存储器中查询畸变校正参数和位姿信息,也可以从远程服务器中下载畸变校正参数和位姿信息。

在步骤S302中,获取多个图像。多个图像由布置在车辆上不同位置的多个图像采集设备采集。例如,多个图像包括第一图像采集设备30采集的第一图像、第二图像采集设备40采集的第二图像、第三图像采集设备50采集的第三图像和第四图像采集设备60采集的第四图像。步骤S302获取的多个图像例如可以由第一、第二、第三和第四图像采集设备同时拍摄的。

在步骤S303中,对于任一个图像采集设备,确定该图像采集设备采集的图像中每个像素点对应的物距。其中,每个像素点对应的物距表示每个像素点对应的物点与该图像采集设备的镜头之间的距离。

在一些实施例中,图像集采集设备具有鱼眼镜头,鱼眼镜头的在水平面内的拍摄角度范围可以达到180度。对于任一个图像采集设备,步骤S303可以基于经过训练的物距估计算法模型确定图像采集设备采集的图像(即鱼眼图像)中每个像素点对应的物距。这里,物距估计算法模型例如为深度学习算法或者其他能够进行距离估计的算法模型。本申请的实施例可以获取关于鱼眼图像的训练样本,并利用训练样本训练物距估计算法模型。这里,每一个训练样本包括鱼眼图像和鱼眼图像中每个像素点对应的物距。一个样本中像素点对应的物距可以通过距离传感器或者其他方式进行测量,本申请对此不做限制。

在一些实施例中,对于任一个图像采集设备,步骤S303可以实施为方法400。

如图4A所示,在步骤S401中,根据该图像采集设备的畸变校正参数,对该图像采集设备的图像进行畸变校正,得到经过畸变校正的图像。在一些实施例中,对于任一个图像采集设备采集的一帧图像,步骤S401可以根据图像采集设备的畸变校正参数,对该帧图像进行畸变校正,生成至少两个视角的图像。例如,图4B示出了图像采集设备在水平面内的拍摄角度的示意图。图像采集设备的镜头例如为鱼眼镜头。每个图像采集设备的图像在水平面内的角度范围为180度。例如第三图像采集设备50的水平面内的角度范围为51。在经过畸变校正后,由第三图像采集设备50拍摄的图像生成的两个畸变校正图像在水平面内的拍摄角度范围为120度。例如图4C示出了经过畸变校正后的图像在水平面内的角度范围为52和53。角度范围52和53具有重合区域。综上,步骤301通过将每个图像采集设备采集的一帧图像生成经过畸变校正的至少两张图像,可以得到车辆周围场景的8张图像,从而使得经过畸变校正的图像能够覆盖车辆10周围360度的范围。

在步骤S402中,确定经过畸变校正的图像中每个像素点对应的物距。例如,步骤S402可以基于经过训练的物距估计算法模型,确定经过畸变校正的图像中每个像素点对应的物距。这里,物距估计算法模型可以关于正常图像(即不存在畸变的图像或者经过畸变校正的鱼眼图像)的训练样本进行训练。每个训练样本可以包括未畸变的图像或者经过畸变校正的鱼眼图像,以及图像中每个像素点对应的物距。

综上,本申请的实施例通过采用物距估计算法模型对图像中像素点对应的物距进行估计,可以避免采用车载雷达等传感器进行物距测量的麻烦,从而降低硬件复杂度。另外说明的是,不管是原始的鱼眼图像还是经过畸变校正的图像,本申请的实施例均可以确定图像中像素点对应的物距,从而极大提高了本申请的车载环视方法的场景适应性。

在步骤S304中,对于任一个图像采集设备,根据该图像采集设备在世界坐标系中位姿信息,和该图像采集设备采集的图像中每个像素点对应的物距,生成与该图像采集设备采集的图像对应的场景结构模型。

在一些实施例中,步骤S304可以实施为方法500,在步骤S501中,根据该图像采集设备在所述世界坐标系中位姿信息,和该图像采集设备采集的图像中每个像素点对应的物距,确定每个像素点对应的物点在世界坐标系中的位置。在一些实施例中,一个图像采集设备可以在该图像采集设备的坐标系(即相机坐标系)中采集图像。步骤S501可以首先根据每个像素点对应的物距,确定图像中像素点对应的物点在相机坐标系中位置。在此基础上,步骤S501可以根据图像采集设备在世界坐标系中位姿信息,将物点在相机坐标系中位置变换为物点在世界坐标系中位置。

在步骤S502中,根据每个像素点对应的物点在世界坐标系中的位置,生成该图像采集设备采集的图像对应的场景结构模型。这里,步骤S502中确定的大量物点(也可以称为点云)可以形成场景结构模型。即,步骤S502可以通过点云表示的图像采集设备的视角范围内的物体的表面模型。例如图6A示出了一个丁字路口的俯视图。如图6A所示,车辆10处于丁字路口处。车辆10的前方有一辆汽车80。车辆10的左前方具有建筑物70。车辆10的左侧具有建筑物90。车辆右侧为墙体100。图6B示出了车辆10的第一图像采集设备30采集的图像的部分像素点的示意图。图6C中示出了图像处理设备20根据图6B中图像确定物距的结果示意图。例如,虚线601和602表示建筑物70上两个物点与图像采集设备30的镜头之间的物距。类似的,虚线603和604表示汽车80上两个物点与图像采集设备30的镜头之间的物距。步骤S502生成的场景结构模型就是根据物距建立的环境场景的三维结构模型。例如场景结构模型可以包括图6B中建筑物70和汽车80的部分表面的三维结构。

在步骤S305中,融合所述多个图像的场景结构模型,得到融合场景模型。这里,融合场景模型可以反映车辆周围360度范围内场景的三维结构。在一些实施例中,步骤S305可以拼接多个图像的场景结构模型,和确定拼接后的多个图像的场景结构模型之间的重合区域。例如,场景结构模型A的区域a与场景结构模型B的区域b重合。区域a和区域b为相同物体表面C的模型。不同场景结构模型(例如A和B)是根据不同图像分别生成的。两个场景结构模型中A和B中同一个物点S在两张图像中像素点分别为p1和P2。由于确定的p1和P2的物距可能不同。因此,A和B中物点S对应的位置点(即在世界坐标系中坐标)可能存在偏差。区域a和b的位置可能存在偏差。换言之,区域a和区域b可以呈现为两层(如果a和b完全重合则呈现为一层)。

步骤S305可以对拼接后多个图像的场景结构模型中重合区域进行平滑处理,得到融合场景模型。步骤S305可以降低场景结构模型的颗粒度,从而降低模型复杂度。这里,步骤S305可以采用各种平滑处理方式,对重合区域进行平滑处理。例如,步骤S205可以将重合区域中的两层平滑为一层。

在步骤S306中,将多个图像中像素点投影到融合场景模型,得到融合场景模型中的像素点。换言之,步骤S306可以将每个像素点投影到其对应的物点的位置处。例如,图7示出了像素点投影到融合场景模型的示意图。例如,步骤S306可以基于视点701(空间位置与图像采集设备30的镜头一致),将图6B中图像600中像素点投影到融合场景模型。图像600中像素点702-705可以分别投影到融合场景模型的物点706-709。在一些实施例中,步骤S306可以对投影到融合场景模型的像素点进行图像平滑处理(例如对像素点颜色均衡处理等等),以便减少融合场景模型中像素点的突兀感,从而使得融合场景模型中像素点更加平滑。

在步骤S307中,根据所述融合场景模型中的像素点,生成目标图像。在一些实施例中,步骤S307可以实施为方法800。

如图8所示,在步骤S801中,确定世界坐标系中一个虚拟视点。例如,在车辆10右转时,步骤S801可以将靠近车辆10右侧后方的一个位置点确定为虚拟视点。在车辆10左转时,步骤S801可以将靠近车辆10左侧后方的一个位置点确定为虚拟视点。又例如,步骤S801可以根据在触屏界面中的触摸输入,选定虚拟视点。

在步骤S802中,确定虚拟视点对应的视平面和视角范围。这里,视平面是融合场景模型中像素点的成像平面。本申请的实施例可以根据需要设定视角范围。

在步骤S803中,将融合场景模型中的像素点中处于视角范围的像素点,投影到视平面,生成目标图像。

综上,方法800可以利用生成的融合场景模型来生成目标图像。由于融合场景模型可以比较真实反映车辆周围的是三维结构,方法800可以生成真实度高的目标图像。

在步骤S308中,在显示界面中呈现目标图像。

在步骤S309中,对目标图像进行目标检测,以确定检测到的目标对象,并在显示界面中显示检测到的目标与车辆10的距离。这里,目标对象例如为行人、车辆、建筑物等等。这样,步骤S309可以提示车辆与周围物体的距离,从而便于驾驶员进行后续的驾驶操作判断。

图9示出了根据本申请一些实施例的车载环视装置900的示意图。这里,车载环视装置900例如可以处在图像处理设备20中。

如图9所示,装置900可以包括:图像获取单元910、物距确定单元920、场景生成单元930、场景融合单元940、投影单元950和图像生成单元960。

图像获取单元910可以获取多个图像。这里,多个图像由布置在车辆上不同位置的多个图像采集设备采集。

对于任一个图像采集设备,物距确定单元920可以确定该图像采集设备采集的图像中每个像素点对应的物距。其中,每个像素点对应的物距表示每个像素点对应的物点与该图像采集设备的镜头之间的距离。

在一些实施例中,对于任一个图像采集设备,物距确定单元920可以基于经过训练的物距估计算法模型,确定该图像采集设备的图像中每个像素点对应的物距。

在一些实施例中,物距确定单元920还可以获取多个图像采集设备中每个图像采集设备的畸变校正参数和每个图像采集设备在所述世界坐标系中的位姿信息,其中,每个图像采集设备的位姿信息包括每个图像采集设备在世界坐标系中的位置和镜头朝向。对于任一个图像采集设备,物距确定单元920可以根据该图像采集设备的畸变校正参数,对该图像采集设备的图像进行畸变校正,得到经过畸变校正的图像。例如,根据该图像采集设备的畸变校正参数,物距确定单元920可以对该图像采集设备的图像进行畸变校正,生成至少两个视角的图像。基于经过训练的物距估计算法模型,物距确定单元920可以确定经过畸变校正的图像中每个像素点对应的物距。

对于任一个图像采集设备,场景生成单元930可以根据该图像采集设备在世界坐标系中位姿信息,和该图像采集设备采集的图像中每个像素点对应的物距,生成与该图像采集设备采集的图像对应的场景结构模型。

在一些实施例中,对于任一个图像采集设备,场景生成单元930可以根据该图像采集设备在世界坐标系中位姿信息,和该图像采集设备采集的图像中每个像素点对应的物距,确定每个像素点对应的物点在世界坐标系中的位置。根据每个像素点对应的物点在世界坐标系中的位置,场景生成单元930可以生成该图像采集设备采集的图像对应的场景结构模型。

场景融合单元940可以融合多个图像的场景结构模型,得到融合场景模型。在一些实施例中,场景融合单元940可以拼接多个图像的场景结构模型。另外,场景融合单元940可以确定拼接后的多个图像的场景结构模型之间的重合区域。这样,场景融合单元940可以对拼接后多个图像的场景结构模型中重合区域进行平滑处理,得到融合场景模型。

投影单元950可以将多个图像中像素点投影到融合场景模型,得到融合场景模型中的像素点。

图像生成单元960可以根据所述融合场景模型中的像素点,生成目标图像。在一些实施例中,图像生成单元960可以确定世界坐标系中一个虚拟视点。确定虚拟视点对应的视平面和视角范围。将融合场景模型中的像素点中处于视角范围的像素点,投影到视平面,生成目标图像。装置900更具体的实施方式与方法300一致,这里不再赘述。

综上,根据本申请的车载环视装置900可以根据多个图像采集设备采集车辆周围的多个图像。基于多个图像,车载环视装置900可以确定多个图像中像素点对应的物距。这样,车载环视装置900可以根据像素点对应的物距建立车辆周围环境对应的融合场景模型。车载环视装置900可以将多个图像中像素点投影到融合场景模型中,并生成目标图像。由于通过图像建立模拟真实场景的融合场景模型,车载环视装置900可以避免需要额外安装雷达传感器的麻烦,而可以生成真实度较高的目标图像,并可以避免目标图像中图像畸变的问题和避免目标图像中出现盲区。以上所述仅为本申请的较佳实施例而已,并不用以限制本申请,凡在申请的精神和原则之内,所做的任何修改、等同替换、改进等,均应包含在本申请保护的范围之内。

- 一种车载环视系统的在线标定方法及其车载环视系统

- 环视障碍物检测方法、装置、介质、车载系统以及车辆