360度多视口系统

文献发布时间:2023-06-19 09:36:59

相关申请的交叉引用

本申请是由2018年4月27日提交的名称为“360多视图故事讲述”的美国临时专利申请序列号62/663,915的非临时提交并且根据35 U.S.C.§119(e)要求所述临时专利申请的权益,所述临时专利申请通过引用整体结合于此。

背景技术

360度视频越来越受欢迎。内容变得更容易用消费者级记录设备来产生。许多由多相机设置组成的高端设备支持高清晰度视频流,实现新的用户体验。许多社交媒体和内容供应商提供360度媒体内容,用户能够利用增强现实设备或者通过在屏幕上滑动和旋转视图来消费该媒体内容。例如,存在虚拟旅行服务和具有同步耳机的基于VR的360度剧院,诸如在AltspaceVR中你可以做什么的网站上描述的那些,Altvr,www.altvr.com/what-can-you-do-in-altspacevr/(最后一次访问在2018年4月20日)。

360度内容可以作为若干相机视图和多麦克风空间音频流的合成而被下载或流传送到接收机。媒体播放器可以创建用于立体耳机或2D显示器的2D视图。用户可以与所设置的相机记录装置一起移动,并且交互地观察周围环境。

发明内容

根据一些实施例的示例方法可以包括:接收指示360度视频的哪个部分对应于在固定显示器上显示的360度视频的第一视口的元数据;跟踪移动设备相对于所述固定显示器的取向;基于所述元数据和所述移动设备相对于所述固定显示器的所述取向,确定在时间和取向上相对于在所述固定显示器上显示的所述360度视频同步的所述360度视频的第二视口;以及在所述移动设备上显示所述第二视口。

在示例方法的一些实施例中,确定第二视口可以包括:根据所述移动设备相对于所述固定显示器的所述取向确定第一角度;根据在所述固定显示器上显示的所述360度视频的所述第一视口的中心确定第二角度;以及针对第二角度,对在时间和空间上同步的360度视频进行定向以生成第二视口。

在示例方法的一些实施例中,确定360度视频的第二视口可以包括确定360度视频的虚拟镜像视口。

在示例方法的一些实施例中,确定360度视频的第二视口可以包括选择与固定显示器上显示的360度视频的部分相对应的虚拟镜像的位置。

在示例方法的一些实施例中,显示360度视频的第二视口可以包括渲染360度视频的与虚拟镜像的位置相对应的部分。

示例方法的一些实施例进一步可以包括:记录来自移动设备的前置相机的图像以生成记录的图像;以及将所述记录的图像覆盖在第二视口上以生成更新的第二视口,其中显示第二视口显示了更新的第二视口。

示例方法的一些实施例进一步可以包括:记录来自移动设备的前置相机的图像以生成记录的图像;以及在移动设备上将所记录的图像显示为第二视口上的覆盖图。

在示例方法的一些实施例中,第二视口是第一视口的虚拟镜像。

示例方法的一些实施例进一步可以包括:选择所述360度视频的所述第二视口内的对象作为虚拟镜像对象,其中显示所述第二视口可包括将所述虚拟镜像对象替换为所述360度视频的所述第一视口的部分。

示例方法的一些实施例进一步可以包括:选择360度视频内的对象作为虚拟镜像对象;以及将虚拟镜像对象替换为360度视频的第一视口的部分,其中显示第二视口可以包括显示替换为360度视频的第一视口的部分的虚拟镜像对象。

在示例方法的一些实施例中,第二视口是第一视口的虚拟镜像。

示例方法的一些实施例进一步可以包括:记录来自移动设备的前置相机的图像以生成记录的图像;确定记录的图像中的用户的边界以生成所述用户的形状;通过跟踪所述用户的形状来裁剪所述记录的图像以生成裁剪后的图像;以及在移动设备上将裁剪后的图像显示为第二视口上的覆盖图。

在示例方法的一些实施例中,确定360度视频的第二视口可以包括:捕获在固定显示器上显示的360度视频的图像以生成捕获的图像;确定所述捕获的图像被捕获的第一时刻;确定显示与捕获的图像相对应的360度视频的第一部分的第二时刻;将时间延迟确定为第一时刻和第二时刻之间的差;基于所述时间延迟来对所述第二视口进行时间调整以生成经时间调整的视口;以及在移动设备上显示经时间调整的视口。

在示例方法的一些实施例中,跟踪移动设备相对于固定显示器的取向可以包括:当所述固定显示器在第一时间平行于所述移动设备时,确定所述移动设备的第一方向;确定所述移动设备在第二时间的第二方向;确定所述第一方向与所述第二方向之间的航向差;以及将所述航向差存储为所述移动设备相对于所述固定显示器的所述取向。

在示例方法的一些实施例中,跟踪移动设备相对于固定显示器的取向可以包括:确定所述移动设备在第一时间相对于所述固定显示器的第一方向;确定所述移动设备在第二时间相对于所述固定显示器的第二方向;确定所述第一方向与所述第二方向之间的航向差;以及将所述航向差存储为所述移动设备相对于所述固定显示器的所述取向。

在示例方法的一些实施例中,元数据可以包括媒体呈现描述文件。

根据一些实施例的示例装置可以包括:处理器;以及存储指令的非暂时性计算机可读介质,所述指令在由处理器执行时可操作用于执行上文列出的方法中的任何方法。

根据一些实施例的另一示例方法可以包括:接收在第一显示器上利用第一视口显示的沉浸式视频;接收指示所述沉浸式视频的所述第一视口的元数据;跟踪所述第一显示器与第二显示器之间的相对取向;使所述沉浸式视频的第二视口的取向相对于所述第一视口同步,以生成用于所述第二视口的同步的沉浸式视频;基于所述第一视口和所述相对取向来确定所述同步的沉浸式视频的修改的视口;以及在第二显示器上显示修改的视口。

在示例方法的一些实施例中,跟踪第一显示器和第二显示器之间的相对取向可以包括:确定第二显示器在第一时间相对于第一显示器的第一方向;确定第二显示器在第二时间相对于第一显示器的第二方向;确定所述第一方向与所述第二方向之间的航向差;以及将航向差存储为第一显示器与第二显示器之间的相对取向。

在示例方法的一些实施例中,确定沉浸式视频的修改的视口可以包括选择与在第一显示器上显示的沉浸式视频的部分相对应的虚拟镜像的位置。

在示例方法的一些实施例中,显示沉浸式视频的修改的视口可以包括渲染沉浸式视频的与虚拟镜像的位置相对应的部分。

根据一些实施例的示例装置可以包括:处理器;以及存储指令的非暂时性计算机可读介质,所述指令在由处理器执行时可操作用于执行上文列出的方法中的任何方法。

根据一些实施例的另一示例方法可以包括:接收元数据,所述元数据指示沉浸式视频的哪个部分对应于在第一显示器上显示的沉浸式视频的第一视口;跟踪第二显示器相对于所述第一显示器的取向;基于所述元数据和所述第二显示器相对于所述第一显示器的取向,确定在时间和取向上相对于在所述第一显示器上显示的所述沉浸式视频同步的所述沉浸式视频的第二视口;以及在第二显示器上显示第二视口。

根据一些实施例的示例装置可以包括:处理器;以及存储指令的非暂时性计算机可读介质,所述指令在由处理器执行时可操作用于执行上文列出的方法中的任何方法。

附图说明

图1A是示出了根据一些实施例的示例通信系统的示例系统的系统图。

图1B是示出了根据一些实施例的可以在图1A所示的通信系统内部使用的示例的无线发射/接收单元(WTRU)的示例系统的系统图。

图2A是示出了根据一些实施例的用于记录沉浸式视频的示例视频相机的示意图。

图2B是示出了根据一些实施例的用于观看沉浸式视频的示例视口的示意图。

图3是示出了根据一些实施例的用于在多个移动设备上观看沉浸式视频的一组示例接口的系统图。

图4是示出了根据一些实施例的用于创建沉浸式视频流的视频和元数据内容的示例过程的流程图。

图5是示出了根据一些实施例的沉浸式视频的示例面板的示意性透视图,其中沉浸式视频具有关于导引器(director)的指定视点的指示。

图6是示出了根据一些实施例的沉浸式视频的示例分段的结构框图。

图7是示出根据一些实施例的两个显示器之间的示例内容同步的示意性透视图。

图8是示出根据一些实施例的TV显示器和两个移动设备的示例同步的示意性透视图。

图9A-9C是示出了根据一些实施例的用于确定相对于场景和其他几何形状的内容和移动设备视口取向的示例方法的示意性平面图。

图10是示出了根据一些实施例的用于利用虚拟镜像探索沉浸式视频内容的示例过程的消息序列图。

图11是示出了根据一些实施例的用于利用主显示器和沉浸式视频客户端之间的取向差异来探索沉浸式视频内容的示例过程的消息序列图。

图12是示出了根据一些实施例的用于利用诸如可穿戴AR头戴设备的显示设备来探索沉浸式视频内容的示例过程的消息序列图。

图13是示出了根据一些实施例的用于利用诸如可穿戴AR头戴设备的显示设备和AR环境中的人造镜像探索沉浸式视频内容的示例性过程的消息序列图。

图14A是示出了根据一些实施例的示例沉浸式视频内容流的示意性透视图。

图14B是示出了根据一些实施例的针对沉浸式视频的主显示视图的示例导引器的决定的示意性透视图。

图15A是示出了根据一些实施例的用于探索沉浸式视频环境的示例设备的示意性透视图。

图15B是示出了根据一些实施例的与沉浸式视频内容的虚拟镜像视图一起使用的示例设备的示意性透视图。

图16A是示出了根据一些实施例的显示位于用户后面的沉浸式视频内容的虚拟镜像的示例AR视图的示意性透视图。

图16B是示出了根据一些实施方式的显示覆盖有化身(avatar)的沉浸式视频内容的示例AR视图的示意性立体图。

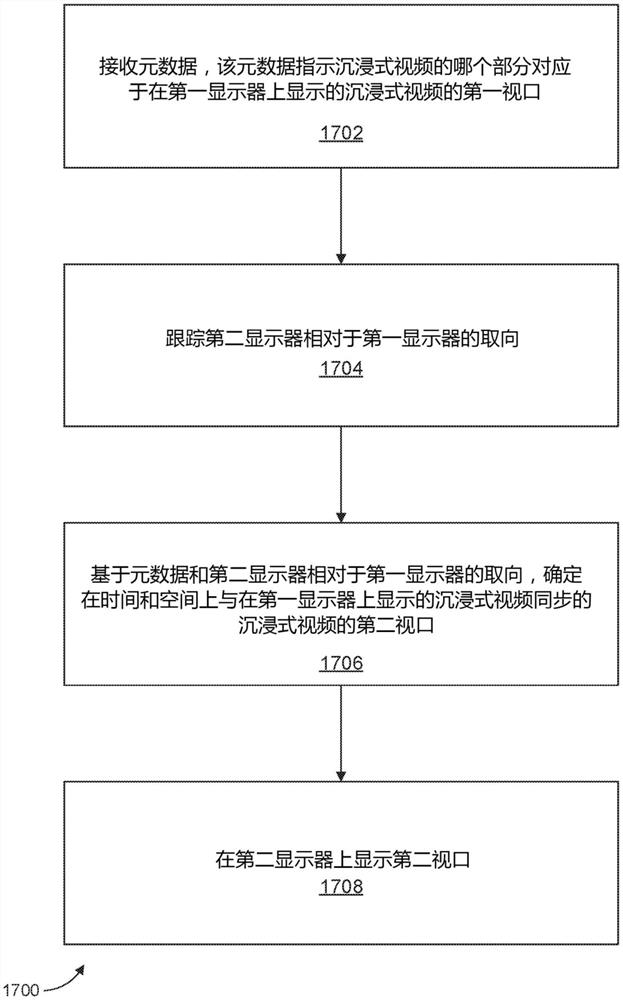

图17是示出根据一些实施例的示例过程的流程图。

图18是示出根据一些实施例的示例过程的流程图。

在各个附图中描绘并结合各个附图描述的实体、连接、布置等是作为示例而非作为限制来呈现的。因此,关于特定附图“描绘了”什么、特定附图中的特定元素或实体“是”或“具有”的任何和所有陈述或其他指示,以及任何和所有类似陈述——可以孤立且在上下文之外被解读为绝对的且因此是限制性的——可以仅被适当地解读为在其前面以建设性的方式加上诸如“在至少一个实施例中,……”的条款。为了简洁和清楚地呈现,在详细描述中并不重复这个隐含的主条款。

用于实施例的实现的示例网络

在本文所述的一些实施例中,无线发射/接收单元(WTRU)可以被用作例如移动设备或360度视频内容观看器/显示器。

图1A是示出了可以实施所公开的一个或多个实施例的示例通信系统100的图。该通信系统100可以是为多个无线用户提供诸如语音、数据、视频、消息传递、广播等内容的多址接入系统。该通信系统100可以通过共享包括无线带宽在内的系统资源而使多个无线用户能够访问此类内容。举例来说,通信系统100可以使用一种或多种信道接入方法,例如码分多址(CDMA)、时分多址(TDMA)、频分多址(FDMA)、正交FDMA(OFDMA)、单载波FDMA(SC-FDMA)、零尾唯一字DFT扩展OFDM(ZT UW DTS-s OFDM)、唯一字OFDM(UW-OFDM)、资源块滤波OFDM以及滤波器组多载波(FBMC)等等。

如图1A所示,通信系统100可以包括无线发射/接收单元(WTRU)102a、102b、102c、102d、RAN 104/113、CN 106/115、公共交换电话网络(PSTN)108、因特网110以及其他网络112,然而应该了解,所公开的实施例设想了任意数量的WTRU、基站、网络和/或网络元件。每一个WTRU 102a、102b、102c、102d可以是被配置成在无线环境中操作和/或通信的任何类型的设备。举例来说,任一WTRU 102a、102b、102c、102d都可被称为“站”和/或“STA”,其可以被配置成传送和/或接收无线信号,并且可以包括用户设备(UE)、移动站、固定或移动订阅者单元、基于订阅的单元、寻呼机、蜂窝电话、个人数字助理(PDA)、智能电话、膝上型计算机、上网本、个人计算机、无线传感器、热点或Mi-Fi设备、物联网(IoT)设备、手表或其他可穿戴设备、头戴显示器(HMD)、车辆、无人机、医疗设备和应用(例如远程手术)、工业设备和应用(例如机器人和/或在工业和/或自动处理链环境中操作的其他无线设备)、消费类电子设备、以及在商业和/或工业无线网络上操作的设备等等。WTRU 102a、102b、102c、102d的任一者可被可互换地称为UE。

通信系统100还可以包括基站114a和/或基站114b。每一个基站114a、基站114b可以是被配置成通过以无线方式与WTRU 102a、102b、102c、102d中的至少一者对接来促使其接入一个或多个通信网络(例如CN 106/115、因特网110、和/或其他网络112)的任何类型的设备。例如,基站114a、114b可以是基地收发信台(BTS)、节点B、e节点B、家庭节点B、家庭e节点B、gNB、NR节点B、站点控制器、接入点(AP)、以及无线路由器等等。虽然每一个基站114a、114b都被描述成了单个元件,然而应该了解,基站114a、114b可以包括任何数量的互连基站和/或网络元件。

基站114a可以是RAN 104/113的一部分,并且所述RAN还可以包括其他基站和/或网络元件(未显示),例如基站控制器(BSC)、无线电网络控制器(RNC)、中继节点等等。基站114a和/或基站114b可被配置成在名为小区(未显示)的一个或多个载波频率上发射和/或接收无线信号。这些频率可以处于许可频谱、未许可频谱或是许可与未许可频谱的组合之中。小区可以为相对固定或者有可能随时间变化的特定地理区域提供无线服务覆盖。小区可被进一步分成小区扇区。例如,与基站114a关联的小区可被分为三个扇区。由此,在一个实施例中,基站114a可以包括三个收发信机,也就是说,一个收发信机对应于小区的一个扇区。在实施例中,基站114a可以使用多输入多输出(MIMO)技术,并且可以为小区的每一个扇区使用多个收发信机。例如,通过使用波束成形,可以在期望的空间方向上发射和/或接收信号。

基站114a、114b可以通过空中接口116来与WTRU 102a、102b、102c、102d中的一者或多者进行通信,其中所述空中接口可以是任何合适的无线通信链路(例如射频(RF)、微波、厘米波、毫米波、红外线(IR)、紫外线(UV)、可见光等等)。空中接口116可以使用任何合适的无线电接入技术(RAT)来建立。

更具体地,如上所述,通信系统100可以是多址接入系统,并且可以使用一种或多种信道接入方案,例如CDMA、TDMA、FDMA、OFDMA以及SC-FDMA等等。例如,RAN 104/113中的基站114a与WTRU 102a、102b、102c可以实施某种无线电技术,例如通用移动电信系统(UMTS)陆地无线电接入(UTRA),其中所述技术可以使用宽带CDMA(WCDMA)来建立空中接口115/116/117。WCDMA可以包括如高速分组接入(HSPA)和/或演进型HSPA(HSPA+)之类的通信协议。HSPA可以包括高速下行链路(DL)分组接入(HSDPA)和/或高速UL分组接入(HSUPA)。

在实施例中,基站114a和WTRU 102a、102b、102c可以实施某种无线电技术,例如演进型UMTS陆地无线电接入(E-UTRA),其中所述技术可以使用长期演进(LTE)和/或先进LTE(LTE-A)和/或先进LTE Pro(LTE-A Pro)来建立空中接口116。

在实施例中,基站114a和WTRU 102a、102b、102c可以实施某种无线电技术,例如NR无线电接入,其中所述无线电技术可以使用新无线电(NR)来建立空中接口116。

在实施例中,基站114a和WTRU 102a、102b、102c可以实施多种无线电接入技术。例如,基站114a和WTRU 102a、102b、102c可以共同实施LTE无线电接入和NR无线电接入(例如使用双连接(DC)原理)。由此,WTRU 102a、102b、102c使用的空中接口可以通过多种类型的无线电接入技术和/或向/从多种类型的基站(例如eNB和gNB)发送的传输来表征。

在其他实施例中,基站114a和WTRU 102a、102b、102c可以实施以下的无线电技术,例如IEEE 802.11(即无线高保真(WiFi))、IEEE 802.16(即全球微波接入互操作性(WiMAX))、CDMA2000、CDMA2000 1X、CDMA2000 EV-DO、临时标准2000(IS-2000)、临时标准95(IS-95)、临时标准856(IS-856)、全球移动通信系统(GSM)、用于GSM演进的增强数据速率(EDGE)、以及GSM EDGE(GERAN)等等。

图1A中的基站114b例如可以是无线路由器、家庭节点B、家庭e节点B或接入点,并且可以使用任何合适的RAT来促成局部区域中的无线连接,所述局部区域例如营业场所、住宅、车辆、校园、工业设施、空中走廊(例如供无人机使用)以及道路等等。在一个实施例中,基站114b与WTRU 102c、102d可以通过实施诸如IEEE 802.11之类的无线电技术来建立无线局域网(WLAN)。在实施例中,基站114b与WTRU 102c、102d可以通过实施IEEE802.15之类的无线电技术来建立无线个人局域网(WPAN)。在再一个实施例中,基站114b和WTRU 102c、102d可通过使用基于蜂窝的RAT(例如WCDMA、CDMA2000、GSM、LTE、LTE-A、LTE-A Pro、NR等等)来建立微微小区或毫微微小区。如图1A所示,基站114b可以直连到因特网110。由此,基站114b不需要经由CN 106/115来接入因特网110。

RAN 104/113可以与CN 106/115进行通信,所述CN可以是被配置成向一个或多个WTRU 102a、102b、102c、102d提供语音、数据、应用和/或借助网际协议语音(VoIP)服务的任何类型的网络。该数据可以具有不同的服务质量(QoS)要求,例如不同的吞吐量要求、等待时间要求、容错要求、可靠性要求、数据吞吐量要求、以及移动性要求等等。CN 106/115可以提供呼叫控制、记账服务、基于移动位置的服务、预付费呼叫、因特网连接、视频分发等等,和/或可以执行用户验证之类的高级安全功能。虽然在图1A中没有显示,然而应该了解,RAN104/113和/或CN 106/115可以直接或间接地和其他那些与RAN 104/113使用相同RAT或不同RAT的RAN进行通信。例如,除了与可以使用NR无线电技术的RAN 104/113相连之外,CN106/115还可以与使用GSM、UMTS、CDMA 2000、WiMAX、E-UTRA或WiFi无线电技术的别的RAN(未显示)通信。

CN 106/115还可以充当供WTRU 102a、102b、102c、102d接入PSTN 108、因特网110和/或其他网络112的网关。PSTN 108可以包括提供简易老式电话服务(POTS)的电路交换电话网络。因特网110可以包括使用了公共通信协议(例如传输控制协议/网际协议(TCP/IP)网际协议族中的TCP、用户数据报协议(UDP)和/或IP)的全球性互联计算机网络设备系统。网络112可以包括由其他服务供应商拥有和/或运营的有线和/或无线通信网络。例如,网络112可以包括与一个或多个RAN相连的另一个CN,其中所述一个或多个RAN可以与RAN 104/113使用相同RAT或不同RAT。

通信系统100中一些或所有WTRU 102a、102b、102c、102d可以包括多模能力(例如WTRU 102a、102b、102c、102d可以包括在不同无线链路上与不同无线网络通信的多个收发信机)。例如,图1A所示的WTRU 102c可被配置成与使用基于蜂窝的无线电技术的基站114a通信,以及与可以使用IEEE 802无线电技术的基站114b通信。

图1B是示出了示例WTRU 102的系统图。如图1B所示,WTRU 102可以包括处理器118、收发信机120、发射/接收元件122、扬声器/麦克风124、数字键盘126、显示器/触摸板128、不可移除存储器130、可移除存储器132、电源134、全球定位系统(GPS)芯片组136和/或其他外围设备138等等。应该了解的是,在保持符合实施例的同时,WTRU 102还可以包括前述元件的任何子组合。

处理器118可以是通用处理器、专用处理器、常规处理器、数字信号处理器(DSP)、多个微处理器、与DSP核心关联的一个或多个微处理器、控制器、微控制器、专用集成电路(ASIC)、现场可编程门阵列(FPGA)电路、其他任何类型的集成电路(IC)以及状态机等等。处理器118可以执行信号译码、数据处理、功率控制、输入/输出处理、和/或其他任何能使WTRU102在无线环境中操作的功能。处理器118可以耦合至收发信机120,收发信机120可以耦合至发射/接收元件122。虽然图1B将处理器118和收发信机120描述成单独组件,然而应该了解,处理器118和收发信机120也可以一起集成在一电子封装或芯片中。

发射/接收元件122可被配置成经由空中接口116来发射或接收去往或来自基站(例如基站114a)的信号。举个例子,在一个实施例中,发射/接收元件122可以是被配置成发射和/或接收RF信号的天线。作为示例,在实施例中,发射/接收元件122可以是被配置成发射和/或接收IR、UV或可见光信号的放射器/检测器。在再一个实施例中,发射/接收元件122可被配置成发射和/或接收RF和光信号。应该了解的是,发射/接收元件122可以被配置成发射和/或接收无线信号的任何组合。

虽然在图1B中将发射/接收元件122描述成是单个元件,但是WTRU 102可以包括任何数量的发射/接收元件122。更具体地说,WTRU 102可以使用MIMO技术。由此,在一个实施例中,WTRU 102可以包括两个或更多个通过空中接口116来传送和接收无线信号的发射/接收元件122(例如多个天线)。

收发信机120可被配置成对发射/接收元件122所要传送的信号进行调制,以及对发射/接收元件122接收的信号进行解调。如上所述,WTRU 102可以具有多模能力。因此,收发信机120可以包括允许WTRU 102借助多种RAT(例如NR和IEEE 802.11)来进行通信的多个收发信机。

WTRU 102的处理器118可以耦合到扬声器/麦克风124、数字键盘126和/或显示器/触摸板128(例如液晶显示器(LCD)显示单元或有机发光二极管(OLED)显示单元),并且可以接收来自这些元件的用户输入数据。处理器118还可以向扬声器/麦克风124、数字键盘126和/或显示器/触摸板128输出用户数据。此外,处理器118可以从诸如不可移除存储器130和/或可移除存储器132之类的任何合适的存储器中存取信息,以及将数据存入这些存储器。不可移除存储器130可以包括随机存取存储器(RAM)、只读存储器(ROM)、硬盘或是其他任何类型的记忆存储设备。可移除存储器132可以包括订阅者标识模块(SIM)卡、记忆棒、和安全数字(SD)记忆卡等等。在其他实施例中,处理器118可以从那些并非实际位于WTRU 102的存储器存取信息,以及将数据存入这些存储器,作为示例,此类存储器可以位于服务器或家庭计算机(未显示)。

处理器118可以接收来自电源134的电力,并且可被配置成分发和/或控制用于WTRU 102中的其他组件的电力。电源134可以是为WTRU 102供电的任何适当设备。例如,电源134可以包括一个或多个干电池组(如镍镉(Ni-Cd)、镍锌(Ni-Zn)、镍氢(NiMH)、锂离子(Li-ion)等等)、太阳能电池以及燃料电池等等。

处理器118还可以耦合到GPS芯片组136,该芯片组可被配置成提供与WTRU 102的当前位置相关的位置信息(例如经度和纬度)。作为来自GPS芯片组136的信息的补充或替换,WTRU 102可以经由空中接口116接收来自基站(例如基站114a、114b)的位置信息,和/或根据从两个或多个附近基站接收的信号定时来确定其位置。应该了解的是,在保持符合实施例的同时,WTRU 102可以借助任何合适的位置确定方法来获取位置信息。

处理器118可以进一步耦合到其他外围设备138,其中所述外围设备可以包括提供附加特征、功能和/或有线或无线连接的一个或多个软件和/或硬件模块。例如,外围设备138可以包括加速度计、电子指南针、卫星收发信机、数码相机(用于照片和/或视频)、通用串行总线(USB)端口、振动设备、电视收发信机、免提耳机、

WTRU 102可以包括全双工无线电设备,其中对于该无线电设备来说,一些或所有信号(例如与用于UL(例如对传输而言)和下行链路(例如对接收而言)的特定子帧关联)的接收和传输可以是并发或同时的等。全双工无线电设备可以包括借助于硬件(例如扼流线圈)或是凭借处理器(例如单独的处理器(未显示)或是凭借处理器118)的信号处理来减小和/或基本消除自干扰的干扰管理单元。在实施例中,WTRU 102可以包括传送或接收一些或所有信号(例如与用于UL(例如对传输而言)或下行链路(例如对接收而言)的特定子帧关联)的半双工无线电设备。

有鉴于图1A-1B以及关于图1A-1B的对应描述,在这里对照以下的一项或多项描述的一个或多个或所有功能可以由一个或多个仿真设备(未显示)来执行:WTRU 102a-d、基站114a-b和/或这里描述的一个或多个其他任何设备。仿真设备可以是被配置成模拟这里描述的一个或多个或所有功能的一个或多个设备。举例来说,仿真设备可用于测试其他设备和/或模拟网络和/或WTRU功能。

仿真设备可被设计成在实验室环境和/或运营商网络环境中实施关于其他设备的一项或多项测试。例如,所述一个或多个仿真设备可以在被完全或部分作为有线和/或无线通信网络一部分实施和/或部署的同时执行一个或多个或所有功能,以便测试通信网络内部的其他设备。所述一个或多个仿真设备可以在被临时作为有线和/或无线通信网络的一部分实施或部署的同时执行一个或多个或所有功能。所述仿真设备可以直接耦合到别的设备以执行测试,和/或可以使用空中无线通信来执行测试。

一个或多个仿真设备可以在未被作为有线和/或无线通信网络一部分实施或部署的同时执行包括所有功能在内的一个或多个功能。例如,所述仿真设备可以在测试实验室和/或未被部署(例如测试)的有线和/或无线通信网络的测试场景中使用,以便实施关于一个或多个组件的测试。所述一个或多个仿真设备可以是测试设备。所述仿真设备可以使用直接的RF耦合和/或借助了RF电路(作为示例,该电路可以包括一个或多个天线)的无线通信来发射和/或接收数据。

具体实施方式

根据一些实施例的本文公开的一些方法和系统创建和促进沉浸式(例如,360度、3D、6D)视频流体验。在一些实施例中,沉浸式视频体验可以小于360度或3D观看,但是被配置和布置为使得可以为用户创建周围的3D视图(或者甚至6D视图)。通常,为了简单起见,在一些实施例中,沉浸式视频流体验将被称为360度沉浸式视频流体验。在一些实施例中,导引器或内容创建器能够利用灵活的工具来控制呈现以驱动故事讲述。包括在MPEG DASH协议流(在一些实施例中使用)中的附加上下文信息可由例如导引器或内容创建器使用以创建不同版本而无需内容修改。在一些实施例中,在多设备环境中流的空间同步或者例如空间和时间同步使得观看者能够自由和自然地探索360度内容。在一些实施例中,虚拟镜像模式创建了对于包括在呈现中的观看者而言自然的“自然”体验。

图2A是示出了根据一些实施例的用于记录沉浸式视频的示例视频相机的示意图。沉浸式视频可以包括例如360度、3D或6D视频。对于图2A中所示的示例相机200,镜头位于立方体的六个侧面中的每一个侧面上。

图2B是示出根据一些实施例的用于观看视频的示例视口的示意图。在3D内容的2D视口250中,时装表演的跑道看起来源于图的右中心点,并且在底部中心接近观看者,并且继续朝向图的左中心点。

360度内容生成变得更容易产生。甚至消费者级记录设备也是可用的。许多高端设备具有多相机设置。如果还包括过渡,则360度相机视图可以类似于6D内容。

360度视频流的一个问题涉及控制内容的渲染和呈现。内容制作器或内容呈现导引器可能缺乏对观看者如何体验(或“消费”)呈现的完全控制。360度视图可以同时包含许多不同的对象和事件。在一些实施例中,用户具有探索例如图像或呈现的一部分或者例如跟踪呈现上的对象的能力。在一些实施例中,可以用虚拟镜像工具来创建新的用户体验。因此,如果例如观看者没有跟上内容制作器所期望的目标,有意义的故事讲述(如由观看者评级的)可能是具有挑战性的。360度视图允许相同内容的几个视点。例如,对话可以从不同的方向跟随。因此,导引器可以控制故事,同时观看者能够探索内容。

多设备环境使得能够对360度内容进行单独探索,但是内容处理在一些情况下可能需要特别关注时间的(或时间)和/或空间同步。如果在相同空间中同时使用若干设备,那么根据一些实施例,那些设备可使用准确同步(例如,空间和/或时间)。

在VR环境中,用户和观看者本身可以被表示为化身,但是如果利用移动设备或AR头戴设备探察360度内容,则可以使用不同的配置。

对于本文公开的一些实施例,沉浸式(例如,360度)内容的渲染和呈现可以利用由内容制作器或导引器创建的定向元数据来控制。可以与一个或多个接收连接设备(例如,移动设备)共享内容,以用于多视图呈现。编辑和控制的内容(导引器的剪辑)可以在例如(例如,固定的)主2D屏幕上呈现,而观看者可以进一步利用例如连接到相同视频流的移动设备来探索360度环境。

在一些实施例中,使用MPEG DASH协议将内容流式传输到主媒体播放器,其中媒体呈现描述(MPD)文件可包含视听内容的适配集。此外,MPD可以携带关于视频相机取向和位置的元数据以及内容的“导引器的剪辑”视点。内容创建器、制作器或导引器可以包括“导引器的剪辑”视点和呈现的可用帧大小。可以通过将所接收的360度流裁剪到用于2D视点的区域来为2D显示器渲染流媒体。

可以通过与诸如移动电话和平板电脑的连接设备共享360度内容来扩展用户体验。连接设备可以使用本地连接从流媒体播放器接收内容,或者使用流协议直接从流服务接收内容。对于一些实施例,用户将在主显示器上查看导引器的剪辑,并且同时滑动或旋转连接的移动设备的屏幕,并且因此探索呈现的附加细节。

在一些实施例中,连接设备可以在虚拟镜像模式中使用,使得用户可以例如以类似于使用真实镜的方式来跟随事件。对于一些实施例,用户自身可以用背面相机来捕捉并且被包括在虚拟镜像中的呈现中。用户的面部可以从相机视图中裁剪并且被嵌入在镜像的视频流的顶部上。

多设备环境可以使用(例如,两者)时间和空间取向同步。连接设备的沉浸式(例如,360度)视图可以在相同方向上对齐。如果移动设备(或移动电话)的背面、主相机面对主2D屏幕,则在两个显示器上的内容是相同的。如果移动设备面向主屏幕的方向,则移动设备显示器上的视图可以对应于主屏幕。捕获主视图上的主呈现的移动设备的背面相机可以用于时间和空间取向同步两者。

多设备环境也可以在增强现实(AR)空间中使用。除了诸如可穿戴AR头戴设备(诸如,例如,谷歌眼镜或微软HoloLens)的可穿戴显示设备之外,用户可以使用附加的移动设备。对于一些实施例,移动设备的功能可以是类似的。AR内容可以呈现在移动设备屏幕上,并且用户可以通过例如头戴设备镜头看到内容。

对于一些实施例,现实世界对象可用作(或被替代为)虚拟显示器或虚拟镜像。如果用户利用AR头戴设备观看360度演示,则视图中的对象可以被分配为应用程序在其上投影360度演示的单独视图的显示。在AR环境中,可以基于视觉特性来检测真实的镜像面或反射表面。AR应用可以使用反射表面作为虚拟镜像面,在该虚拟镜像面上显示呈现的镜像图像。举例来说,如果真实的镜像面或反射表面具有X度的中心罗盘航向,那么真实的镜像面或反射表面可由在X小于180度时具有X+180度的中心罗盘航向且在X为180度或更大时具有X-180度的中心罗盘航向的呈现内容替换。中心罗盘航向是小于360的正数,其是针对对象的中点的罗盘航向。

如果360度内容流包括呈现控制信令,则内容创建器(或者例如导引器)可能能够定义体验。例如,演员之间的对话可以根据导引器的想法用不同的场景剪辑来表示。作为另一示例,视图可以表示来自交通工具(或汽车)窗口的视图,在这种情况下,沉浸式呈现的罗盘方向随着时间而改变。呈现导引器可自由地选择视点。然而,例如,内容可以在以后由导引器重新配置呈现而改变。这使得内容制作器能够基于反馈来适配内容,并且针对不同的观众来调谐呈现,而不改变实际的视听流。

从用户体验的角度来看,对于一些实施例,多设备环境通常可以提供最大的增益。在内容中具有附加视图可以使得能够例如自由探索360度和/或6D内容。在一些实施例中,导引器的剪辑可被呈现在主显示器(TV屏幕)中,而例如连接设备使得能够在不同的方向上进行探索并转换到呈现内的不同位置。主显示器上的呈现和关于视点坐标的对应元数据可用于与连接的移动设备一起渲染多设备呈现。

在一些实施例中,在连接的移动设备中具有虚拟镜像模式功能,其提供了一种观看者可以看起来更自然的环境的方式。对于一些实施例,应用前置相机来捕捉并将用户包括在连接设备中的360度呈现的顶部。因此,“镜像”效应在AR环境中也显得更自然。

如果检测到反射表面并且360度呈现的镜像视图被投影在其上,则AR服务可以更逼真。在一些实施例中,如果通过AR头戴设备观看内容,则现实世界对象可以用作虚拟镜像。示例AR应用可以将呈现的对应部分投影在虚拟镜像上。

图3是示出了根据一些实施例的用于在多个移动设备上观看沉浸式视频的一组示例接口的系统图。对于一些实施例,接收机显示器304可包括用于接收丰富内容并与一个或多个连接设备306、308(诸如一个或多个移动设备或例如其它显示设备)共享呈现的智能TV。内容制作器(诸如TV广播者)302准备(或者,例如,内容服务器(诸如ISP)传送)(例如)具有元数据330的视听内容以用于传输(其可以通过例如MPEG DASH流协议或使用另一广播系统来传输)。元数据可以包括视频捕获内容和内容导引器的呈现指令。在系统300的一些实施例中,ISP或TV广播者302可以从数据库服务器检索视频点播,或者可以实况流视频310。视频内容可以被发送到应用、模块或服务器功能312,以与上下文信息捆绑(bundle)。捆绑的内容和上下文信息可被发送(例如,经由实况流传输或广播330)到接收机设备304。

对于一些实施例,作为智能TV 304的一部分的接收机模块316可以将内容流330解除捆绑,并且使用导引器的渲染指令在主2D显示器320上呈现主视听内容。对于一些实施例,接收机模块可解码内容以用于显示。对于一些实施例,单独的解码器模块318可以解码内容以用于显示。智能TV(或接收设备或接收设备模块314)可以与其它连接的移动设备306、308共享360度内容。接收设备306、308可以(例如,经由解码器模块322、326)针对移动设备硬件对内容进行代码转换,移动设备硬件可以在本地显示器324、328上显示经代码转换的内容。

移动设备306、308(例如)上的应用可以建立到流应用(例如,智能TV 304上的)的连接(例如,经由蓝牙或Wi-Fi连接)332、334,并且接收智能TV 304正在共享的内容流332、334。如果建立了连接332、334,则移动设备306、308上的移动应用可以收集用户信息、本地上下文和传感器数据,以处理360度内容用于呈现。可以记录设备的取向,以便例如媒体播放器可以相应地呈现视听内容。在一些实施例中,移动设备用户可以通过物理地转动移动设备306、308来探索内容。对于一些实施例,两个或更多个移动设备306、308可以接收内容流332、334。例如,两个移动设备可以接收内容流,其中每个移动设备接收视频内容的单独视点或视口。

对于一些实施例,在本公开中,以下术语中的一个或多个可以用于替代另一术语:内容制作器、内容创建器、导引器、内容导引器、呈现导引器以及例如自动工具。为了便于描述,任何内容源或呈现方向源(例如,内容服务器)可以提供内容。

360度视频流内容可以利用具有专用360度相机和音频设置的实况记录来创建,或者内容可以通过将若干视频流和图像缝合在一起来离线创建。例如,360度视频内容可以使用在线工具来创建,诸如网站“终极沉浸(The Utimate Immersion)”上可用的内容创建工具:创建真棒全景、虚拟旅行、360度视频、Kolor、www.kolor.com(最后一次访问在2018年4月20日)。可以使所创建的360度视频内容在流传输服务中可用。

在一些实施例中,除了视听内容之外,流内容可以包含关于记录设备的即时位置和垂直/水平取向的连续上下文传感器信息流。位置/取向数据的采样速率可以被设置为足够高的速率以捕获记录设备的自然运动。

视频流可以包含关于导引器期望的360度呈现的视点的附加信息。该视频流可以具有关于呈现指令的元数据。2D呈现控件使用左边界和右边界位置(其可以在罗盘角度中)以及相对于地平线的上边界和下边界角度。该信息(例如,角度信息)可以应用于相对于接收用户的呈现的渲染中。

内容创建器可例如用含有一系列时间实例的坐标的数据库文件来创建渲染指令。这些渲染指令可以指示内容创建器对于观看者的视点。元数据可以在多设备配置中用于不同呈现的空间同步。接收设备可以流式传输360度视频内容,该视频内容具有相关的位置和取向数据以及具有关于如何在2D显示器上呈现内容的指令。

360度记录应用可以包括具有关于视频位置和取向的上下文信息的元数据。360度视频可以具有关于视图相对于地图的位置和对齐的细节。例如,可以使用来自记录的运动API的极坐标。设备的运动API可以提供来自例如GPS、加速度、陀螺仪或罗盘传感器的数据。

内容制作器、导引器或自动工具可控制360度内容的2D呈现视图。元数据可被添加到流渲染指令以供媒体播放器渲染呈现。渲染指令可以与相机取向相关。在一些实施例中,实际视频内容和对应的元数据可以被封装在例如媒体呈现描述(MPD)数据模型中,该MPD数据模型可以用于实况流服务器中的流客户端。

图4是示出了根据一些实施例的用于创建沉浸式视频流的视频和元数据内容的示例过程的流程图。AV产生过程400可包含产生360度视频412和导引器的指令414的视听内容创建402。360度视频上下文可被记录404为相机的坐标和位置。对于一些实施例,坐标可以极坐标格式记录。导引器的指令可被生成406以指示用于以2D格式呈现视频内容的指令,诸如顶部、底部、右部和左部边界位置。视频比特流可以与上下文参数组合408。组合数据可被转换410为例如具有视频内容和元数据的媒体呈现描述(MPD)数据模型。

图5是示出了根据一些实施例的沉浸式视频的示例面板的示意性透视图,其中沉浸式视频具有关于导引器的指定视点的指示。导引器可指定在给定时刻,主显示器可作为呈现的子集呈现的内容的视点。渲染指令可指示导引器的期望视点(例如,以极坐标)以及帧的水平和垂直大小(例如,以度为单位)。对于一些实施例,视口502是沉浸式(例如,360度)视频内容504的子集,诸如导引器对沉浸式视频内容的视点。对于图5所示的示例配置500,导引器的指定视点具有以大约105°为中心、左边界处于大约80°并且右边界处于大约130°的航向。垂直高度可以是以50°为中心、大约90°的垂直航向。

在一些实施例中,创建的内容流可以存储在例如媒体呈现描述(MPD)表现文件中,并且对应的编码比特流可以包括在媒体呈现数据模型中。接收应用可以请求实况视频流,并且可以在每个单独的视听流的短分段数据块中通过HTTP来发送媒体组成。MPD可包含例如内容和关于内容位置、取向、采样率和比特率的相关元数据。

图6是示出了根据一些实施例的沉浸式视频的示例分段的结构框图。图6示出了利用被指示为适配集合616、618、620的渲染指令的重新生成的MPD 600的一些实施例的示例。图6示出了如果导引器指令作为时间序列数据被包括在单独的适配集合616、618、620中,MPD 600的结构的示例。MPD 600可以具有多于一个的指令集合。在一些实施例中,接收机可以选择内容的视点。对于图6中所示的示例,适配集合616、618、620内的每个分段可以包含具有一个或多个媒体分段630、632、634、636的分段信息608,所述媒体分段包含用于HTTP流传输的访问细节。编辑器的内容指令可以作为元数据嵌入MPD 600中,类似于来自记录应用的实况流。

图6示出了在图的最左列中具有媒体呈现602的100秒(100s)时间段610、612、614的示例分层结构。图6的左中列示出了可在分量的选择604中使用的一系列适配集合616、618、620。媒体组件(诸如适配集合616、618、620)可包含多个流,包括导引器的用于2D呈现的指令的时间序列元数据。媒体呈现的每一时间段可与多个适配集合616、618、620相关联。例如,集合1(或组1)可以是音频设置的适配集合616。适配集合2(或组2)可以是视频设置的适配集合618。适配集合3(或组3)可以是呈现指令的适配集合620。图6的右中列示出了可以用于选择或切换带宽606的一系列表示分段622、624、626、628。例如,表示可以包含带宽设置。图6的最右列示出了一系列媒体分段630、632、634、636。例如,媒体分段可以包含关于如何访问一组2D渲染指令的分段信息。

表1示出MPD数据模型的示例。将图6与表1相关联,字段“MPD”指示MPD数据模型结构的开始。媒体呈现时间段可以用“Period”字段和时段标识符(例如,‘id=“1”’)来指示。适配集合可以用“AdaptationSet”字段和适配集合(或组)标识符(例如,‘group=“1”’)来指示。表示可以用“Representation”字段和表示标识符(例如,‘id=“128kps 240p”’)来指示。媒体分段可以用“SegmentTemplate”字段来指示。

MPD模型可以包含关于媒体内容的信息(或字段),诸如XML名字空间的XML模式实例(例如,

‘xmlns:xsi="www

媒体呈现时间段字段可包括时间段开始字段(‘start="PT0S"’)以及其它字段。

适配集合字段可以包括MIME类型(例如,‘mimeType="audio/mp4"’,和‘mimeType="video/mp4"’)、最小带宽(例如,‘minBandwidth="128000"’)、最大带宽(例如,‘maxBandwidth="128000"’)和段对齐(例如,‘segmentAlignment="true"’),以及其他字段。

表示字段可以包括表示带宽(例如,‘bandwidth="128000"’)、编解码器选择(例如,‘codecs=“mp4a.40.2”’)、音频采样率(例如,‘audioSamplingRate=“48000”‘)、帧速率(例如,‘frameRate=“25”’)、表示宽度(例如,‘width="320"’)、表示高度(例如,‘height="180"’)、视频采样率和比特率,以及其他字段。

分段字段可以包括分段持续时间(例如,‘duration="2"’)、分段媒体位置(例如,‘media="../dash/250k/bitcodin-$Number$.m4a"’和‘media="../dash/250k/bitcodin-$Number$.m4v"’)、分段初始化位置(例如,‘initialization="../dash/250k/bitcodin-init.m4a"’,和‘initialization="../dash/250k/bitcodin-init.m4v"’)、分段开始号(例如,'‘startNumber="92352"’)和分段实况边缘号(例如,‘liveEdgeNumber="92352"’),以及其他字段。

导引器的指令可以以类似的方式被包括。导引器的具有水平和垂直方向上的2D视图边界的期望视点可被嵌入为单独的时间序列数据。表1示出了由“StreamHighlight”和“StreamLimitHighlight”字段指示的相机位置/取向和导引器指令的示例数据条目。

此外,在一些实施例中,MPD模型可包含关于极坐标中的内容位置元数据的元数据(例如,‘ref=“polar”’)。流信息还可以指示该流是否处于固定位置,在这种情况下,坐标的信息可以表示为固定坐标(例如极坐标)。或者,所述流可为移动流,且坐标信息可指示初始坐标(例如,‘init-coord=“0,0,82,126”’)、最终坐标(例如,‘final-coord=“0,0,82,150”’)及轨迹信息(例如,‘trajectory=“straight”’)。

其它导引器指令(“StreamHighlight”和“StreamLimitHighlight”)字段可包含导引器指令的位置(例如,‘src="stream1.txt"’)、导引器指令的种类(例如,‘kind="highlight"’)和导引器指令标签(例如,‘label="marker"’),以及其它字段。

在MPD文件中将渲染指令作为单独的适配集合的情况下,可独立于内容而改变渲染。可以编辑内容的2D呈现而不改变实际的视听内容。接收媒体播放器可以使用流元信息来在屏幕上渲染2D呈现。

表1.MPD数据模型结构

根据一些实施例,如果用户正在探索360度呈现,则可以对齐每个单独显示器上的内容呈现。移动设备上的接收应用可以例如在空间上和(例如)在时间上与多设备环境中的主显示器上的呈现同步。如果具有背面相机的移动设备指向主显示器,则在每个显示器上以相同方向显示的内容可以是时间同步的。

在一些实施例中,可以通过确定目标内容传输时间以及不同设备之间的渲染和匹配延迟来执行时间同步。然而,在一些实施例中,主接收机可能不记录是否存在连接设备或这些连接设备的前置(lead)时间。对于一些实施例,连接设备的背面相机可以用于捕获内容。捕获的内容可以与接收的内容相关以补偿传输和渲染延迟。

在一些实施例中,可以以类似于时间同步的方式执行空间同步。如果背面相机指向主显示器,则连接设备的旋转上下文可以与主显示器的位置对齐。连接设备可以将流内容与捕获的视频进行匹配。将本地取向上下文与2D内容渲染指令(2D视图上的呈现方向的细节)进行比较,连接设备可以确定其自己相对于主显示器的相对取向。

图7是示出根据一些实施例的两个显示器之间的示例内容同步的示意性透视图。在一些实施例中,空间同步可以在环境700中在主(例如,固定的或例如静止的)显示器702(其在图7的背景中示出)上显示的内容和在移动设备704的显示器706上显示的内容之间同步取向。对于图7的示例,360度内容在移动设备704上的呈现与在主显示器702上的导引器的剪辑呈现对齐。在执行时间和空间对齐的情况下,指向主显示器702的连接的移动设备704可以显示与主显示器702上显示的视频流的一部分相同的视频流。

图8是示出根据一些实施例的TV显示器和两个移动设备的示例同步的示意性透视图。图8示出了导引器的剪辑的示例配置800,用于在主显示器804上渲染,其可以是TV屏幕上的固定视图。图8示出了具有同步视图的两个移动设备802、806。从上面看,图8左侧的移动设备802逆时针旋转(相对于主显示器804)。与示出了笔直向前视图810的主显示器804的视图相比,左侧的移动设备802的显示器具有同步的左视图808。从上面看,图8的右侧的移动设备806顺时针旋转(相对于主显示器804)。与主显示器的笔直向前视图810相比,右侧的移动设备806的显示器具有同步的右视图812。

图9A-9C是示出根据一些实施例的用于确定相对于场景和其他几何形状的内容和移动设备视口取向的示例方法的示意性平面图。例如,方法可以确定移动设备相对于沉浸式视频的导引器的视口的取向。

对于图9A,示出了场景几何环境900,移动设备可以跟踪相对于电视(TV)908的取向的取向。角度θ

对于图9B,示出了内容视口环境930,导引器的视口可作为元数据被传送(被用信号通知)。θ

对于图9C,示出了移动视口环境960,移动设备的视口970的方向可根据TV法向向量906、移动法向向量904、以及导引器的视口角度θ

θ

如果导引器的视口966在罗盘北向量964的左侧,则导致θ

对于一些实施例,跟踪主TV显示器和移动设备显示器之间的相对取向可以包括:针对在时刻t1主TV显示器平行于移动设备显示器的状况,确定(或测量)移动设备显示器的第一罗盘(或陀螺仪)方向(例如,航向);在时间t2,确定移动设备显示器的第二罗盘方向(例如,航向);确定所述第一罗盘方向(例如,航向)与所述第二罗盘方向(例如,航向)之间的航向差;以及存储所述航向差以跟踪所述主TV显示器与所述移动设备显示器之间的相对取向。

对于一些实施例,主TV显示器和移动设备可以各自具有陀螺仪。确定主TV显示器和移动设备之间的相对取向可以包括读取主TV显示器上和移动设备上的陀螺仪航向。主TV显示器和移动设备之间的相对方位可以是两个陀螺仪读数之间的差。

对于一些实施例,确定修改的或移动设备的视口(例如,移动设备视口970)可以包括:根据所述移动设备的显示器(例如,移动法线向量904)相对于第一显示器的取向确定第一角度(例如,θ

图10是示出了根据一些实施例的用于利用虚拟镜像探索沉浸式视频内容的示例过程的消息序列图。对于图10的示例过程1000,多设备环境1014可以包括从服务器和连接到提供流的服务的移动设备(诸如平板电脑)接收流的(例如,固定的)主2D显示器1006(例如,智能TV)。诸如移动电话或平板电脑的移动用户设备可以直接连接到主显示器(例如,使用蓝牙或Wi-Fi),或者移动设备可以独立地连接到服务(例如,通过蜂窝网络)。对于一些实施例,移动设备可以使用QR码、URL或超链接(其中的一个或多个可以在主显示器上运行的呈现上可用)与主显示器连接。或者,移动设备可以使用内容识别来识别主显示器上的呈现或搜索因特网上的流。

对于图10的示例,广播或流服务1012可以访问例如源自实况事件或源自视频点播数据库的内容。在一些实施例中,内容定向器1002可以将例如视听内容1016与用于相机设置和渲染指令的上下文信息组合以创建主呈现。在一些实施例中,导引器的指令元数据1018可与广播或流式传输的内容1016组合。音频/视频源内容1016和导引器的指令元数据1018都可以从内容服务器1002发送到视频服务器1004。MPD表现内容描述1020可以从视频服务器1004传送到主显示器接收机1006(例如智能TV)。用户1010经由移动设备1008(诸如平板电脑)可以向主显示器1006发送消息1022以开始主显示器上的呈现。主显示器1006接收开始消息1022,并且可以发送1024内容请求到视频服务器1004。对于一些实施例,主显示器1006可以从广播中选择流。视频服务器1004可以用具有元数据的内容流来响应1026主显示器1006。根据该示例,主显示器1006显示呈现。用户1010观看1028主显示器的呈现。在一些实施例中,如果连接设备1008建立1034到服务(图10中)的连接,则该设备连接到MPD。服务连接可以通过例如智能TV或者可以是直接连接(例如,通过蜂窝网络)。使用主显示的呈现的捕获的视图,用户1010经由连接设备1008选择1030内容流。用户1010可经由移动设备1008上的用户界面作出连接1032到内容的指示。移动设备1008可以建立1034到广播或流服务的连接。

2D内容可以基于元数据被编辑并且被立即渲染在本地显示器上。用户1010可能期望更多信息和呈现的附加视点。用户1010可以将连接设备1008(例如,移动设备、智能电话或平板电脑)连接到流。到广播或流服务1012的这种连接可以独立地(例如,经由蜂窝网络)进行或直接地进行到主显示器接收机1006(例如,使用蓝牙或Wi-Fi连接)。

接收机可以使用本地连接,以便共享360度内以及关于捕获相机位置和取向的上下文信息容。包含用于主显示器1006的渲染指令的元数据可由一个或多个连接设备1008用来执行1036空间同步。连接设备1008可以使用相机来跟踪1042主显示器并且在时间和空间上同步内容流。用户例如将相机朝向主显示器以实现同步。

诸如移动电话或平板电脑的连接设备1008可以接收内容流和元数据。在本地,连接设备1008可以捕获连接设备的取向和用户交互(这可以使用例如加速度传感器、指南针、触摸屏或键盘来完成)。用户1010还可放大内容(例如,使用触摸屏上的捏和滑动手势或键盘上的专用按钮)。对于一些实施例,跟踪第一显示器(例如固定显示器)与第二显示器(例如移动设备)之间的相对取向可包含确定第二显示器在第一时间相对于第一显示器的第一方向;确定第二显示器在第二时间相对于第一显示器的第二方向;确定所述第一方向与所述第二方向之间的航向差;以及将航向差存储为第一显示器与第二显示器之间的相对取向。对于一些实施例,陀螺仪传感器可用于确定相对取向,例如移动设备的第一方向和第二方向。对于一些实施例,如果主显示器1006在连接设备1008的相机视图中可见,则(主显示器1006与连接设备1008之间的)相对角度可以在视觉上确定。对于一些实施例,可比较多个相机图像以确定移动设备相对于固定显示器或相机图像中的其它静止对象的相对取向改变。

将设备取向与关于相机取向的流元数据组合,连接设备1008上的媒体播放器可以呈现360度内容的2D表示。该设备剪裁360度内容的相关部分,并将剪裁后的内容渲染在显示器上。连接设备可以显示裁剪后的内容,该裁剪后的内容被用户1010观看到1038。因此,在一些实施例中,用户1010能够通过转动(或旋转)移动设备来探索呈现。

对于一些实施例,可以通过切换到虚拟镜像模式并使用所连接设备作为镜子来探索360度呈现。用户可在连接设备1008的用户界面中作出选择以选择1040虚拟镜像模式。

在具有虚拟镜像模式的一些实施例中,连接设备1008的前置相机可以旨在跟踪用户自身并且捕获实况图像。连接设备上的应用可以裁剪1042来自相机流(或实况图像流)的用户图像,创建1044 360度内容的虚拟镜像视图,并且将用户图像覆盖在360度内容呈现之上。

对于一些实施例,确定沉浸式视频的视口可以包括确定沉浸式视频的虚拟镜像视口,诸如,例如,用户1010向连接设备1008指示1040所选择的虚拟镜像,并且连接设备1008显示1044沉浸式视频内容的虚拟镜像视图。对于一些实施例,图像可由移动设备的相机(例如,前置相机)记录以产生所记录图像。可以确定图像中的用户的边界以生成图像内的用户的形状。可通过在图像内跟踪用户的形状以生成裁剪后图像来裁剪图像以移除背景。可以将裁剪后的图像显示为沉浸式视频的视口上的覆盖图。

图11是示出了根据一些实施例的用于利用主显示器和沉浸式视频客户端之间的取向角差异来探索沉浸式视频内容的示例过程的消息序列图。对于图11的示例性过程1100,沉浸式视频客户端(或连接设备)1106可以直接与视频内容服务器1102(或广播/流服务)连接。主视频可以从服务器1102被传送1110到主显示器1104。沉浸式视频可以从服务器1102被传送1112到沉浸式视频客户端1106。根据该示例,沉浸式视频客户端1106上显示的内容可以与主显示器1104上显示的内容同步(例如,空间地和/或时间地)1114。沉浸式视频客户端(或连接设备)1106可以被旋转以在主显示器(其可以是电视机)1104和沉浸式视频客户端1106之间生成取向角。可以跟踪1116沉浸式视频客户端相对于主显示器1104的取向,并且可以计算1106相对于主显示器的取向角度。将具有导引器的视口的元数据从服务器1102发送1120到沉浸式视频客户端1106。对于一些实施例,沉浸式视频客户端1106可以从主显示器角度减去1122导引器的视口角度。沉浸式视频客户端1106可以使用例如上述的等式1,使用到主显示器的角度和到导引器的视口的角度来确定1124视口。沉浸式视频客户端1106可以基于角度来确定1124视口。沉浸式视频客户端1106可以渲染1126沉浸式视频的视口。在沉浸式视频客户端的显示器上显示1128渲染的视频。

对于一些实施例,用户能够在探索模式和虚拟镜像模式之间切换。对于一些实施例,用户可以利用在触摸屏上渲染的虚拟按钮在探索模式与虚拟镜像模式之间切换。对于一些实施例,移动设备(或连接设备)可以裁剪、渲染和显示针对设备所指向的方向的360度内容的视图。

对于一些实施例,移动设备可以在虚拟镜像模式中使用。在根据一些实施例的示例虚拟镜像模式中,移动设备可以以沉浸式(例如,360度)呈现来渲染和显示设备和用户后面(例如,正后面)的视图(例如,在设备指向的相反方向上)。对于一些实施例,虚拟镜像模式可以提供一种探索用户后面的360度内容的视图的方式。虚拟镜像模式可以使用户能够出现在镜像上。前置相机可以捕获设备和用户后面的环境。媒体播放器还可以捕获用户的视频图像。在一些实施例中,如果媒体播放器在用户后面渲染360度的内容视图,则媒体播放器可以从相机视图中裁剪(或跟踪)用户的视频图像,并且将视频图像嵌入在呈现之上。

对于一些实施例,在例如图4中创建的360度内容可以是增强现实(AR)内容。该流可以具有在相对于用户的预定位置处渲染的视听分量。对于一些实施例,不存在用于导引器的剪辑的2D呈现或渲染指令。AR对象可以由用户(例如,利用可穿戴AR型设备)显示和查看。用户能够通过转动她的头部来体验360度环境中的不同视点角度。

多个设备可以与AR体验一起使用。用户可以具有连接到与可穿戴设备相同的内容的连接设备(诸如移动电话或平板电脑)。连接的(或移动)设备可以基于位置和取向来渲染内容(类似于可穿戴设备)。可以使用类似的时间和空间同步过程。移动设备可以在与可穿戴设备中的内容相同的时间帧中在相同的方向上渲染相同的内容。可穿戴设备中的相机模块可以用于同步:可穿戴装置可记录在移动设备上设备的内容,且执行时间和空间同步。

在一些实施例中,多设备配置中的移动设备可以用作AR环境中的虚拟镜像。移动设备可以与可穿戴设备中的主内容同步并且用作虚拟镜像。移动设备可以渲染用户后面的内容。在虚拟镜像模式内,用户可以能够在没有导引器指令的情况下利用可穿戴头戴设备来探索360度内容。镜像可以帮助用户探索和体验环境。用户自己的镜像图像可以被投影在显示器上,这可以类似于VR环境。

图12是示出了根据一些实施例的用于利用可穿戴AR头戴设备探索沉浸式视频内容的示例过程的消息序列图。对于一些实施例,可穿戴AR头戴设备可以处于虚拟镜像模式。对于图12的示例过程1200,广播或流服务1212可以访问源自实况事件或源自视频点播数据库的内容。在这两种情况下,内容导引器1202可将视听内容与用于相机设置和渲染指令的上下文信息组合以创建主呈现。导引器的指令元数据可与广播或流传送的内容组合。音频/视频源内容1216和导引器的指令元数据1218可从内容服务器1202发送到视频服务器1204。对于一些实施例,增强现实(AR)体验1214中的多设备360度内容探索可以是用户1210用可穿戴AR头戴设备1206和移动设备1208探索AR环境。MPD表现内容描述可从视频服务器1204传送1220到可穿戴AR头戴设备1206。用户1210可以经由用于可穿戴头戴设备的用户界面来做出1222开始在可穿戴耳机上的呈现的指示。可穿戴AR头戴设备1206可以接收开始消息,并且可以向视频服务器1204发送1224内容请求。视频服务器1204可以用内容流和元数据来响应1226。用户1210可以经由可穿戴AR头戴设备1206观看1228 360度呈现。使用可穿戴AR头戴设备1206的用户界面,用户1210可以选择1230移动设备。用户可以经由移动设备上的用户界面做出连接1232到内容的指示。移动设备1208可以建立1234到广播或流服务1212的连接。移动设备1208可以执行1236与可穿戴AR头戴设备1206的时间和空间同步。移动设备1208可(例如)在用户的相机图像内跟踪1238用户的图像。跟踪的图像可以覆盖在移动设备的内容呈现上。根据该示例,用户1210看到1240移动设备上显示的360度内容的虚拟镜像视图。

对于一些实施方式,通过可穿戴AR设备可见的现实世界对象可以被分配为镜像。例如,用户通过可穿戴AR设备看到的对象可以在AR环境中被选择作为人造镜像。例如,使用手势和AR菜单,用户可以选择AR环境中的区域并且在所选择的区域上分配镜像面。应用可以将用户后面的AR风景的镜像图像投影在AR环境中的所选区域上。用户可以看到投影在所选区域上的AR视图的人造镜像图像。

在一些实施例中,确定沉浸式视频的视口可以包括:捕获在第一显示器上显示的沉浸式视频的图像以生成捕获的图像;确定所述捕获的图像被捕获的第一时刻;确定沉浸式视频的与所述捕获的图像相对应的第一部分被显示的第二时刻;确定时间延迟为第一时刻和第二时刻之间的差;基于所述时间延迟来时间调整所述第二视口以生成经时间调整的视口;以及在第二显示器上显示经时间调整的视口。图12所示的时间同步1236的示例可以如上文针对一些实施例所描述的那样来执行。

图12所示的空间同步1236的示例可如下面针对一些实施例描述的那样来执行。跟踪第一显示器相对于第二显示器的取向可以包括:当第二显示器在第一时间(例如,时间t1)平行于第一显示器时,确定第一显示器的第一罗盘航向;在第二时间(例如,时间t2)确定第一显示器的第二罗盘航向;确定所述第一罗盘航向与所述第二罗盘航向之间的航向差;以及将航向差存储为第一显示器相对于第二显示器的取向。

图13是示出了根据一些实施例的用于利用可穿戴AR头戴设备和AR环境中的人造镜像探索沉浸式视频内容的示例过程的消息序列图。对于一些实施例,利用人造镜像1314在增强现实(AR)体验中进行360度内容探索可以是用户1310使用可穿戴AR头戴设备1306和AR视图中充当镜像(例如,人造镜像)1308的人造对象探索AR环境。对于图13的示例,广播或流服务1312可以访问源自实况事件或源自视频点播数据库的内容。在这两种情况下,内容导引器1302可将视听内容与用于相机设置和渲染指令的上下文信息组合以创建主呈现。导引器的指令元数据可与广播或流传送的内容组合。音频/视频源内容1316和导引器的指令元数据1318两者都可以从内容服务器1302发送到视频服务器1304。MPD表现内容描述可从视频服务器1304传送1320到可佩戴AR头戴设备1306。用户1310可以经由用于可穿戴头戴设备1306的用户界面来作出1322在可穿戴头戴设备1306上开始呈现的指示。可穿戴AR头戴设备1306可以接收开始消息,并且可以向视频服务器1304发送1324内容请求。视频服务器1304可以用内容流和元数据来响应1326。用户1310可以经由可穿戴AR头戴设备1306观看1328 360度呈现。用户1310可以选择1330对象或区域作为AR视图中的镜像。可穿戴AR设备1306可以记录1332用户选择,并且可以确定所选表面的位置和几何形状。可穿戴AR设备1306可以将虚拟镜像图像投影1334在AR视图内的人造镜像对象(或选择的表面)上。根据该示例,用户1310使用1336人造镜像面视图来查看位于用户后面的360度内容。对于一些实施例,可穿戴AR设备1306可以在用户四处移动对象的同时将虚拟镜像图像投影到对象上。与可穿戴AR设备1306相比的对象的相对运动可以用于确定人造镜像1308的所选表面的位置几何形状。

360度内容可以包括来自不同位置的视听流。这些流可以是空间上不同的,但是可以彼此链接。例如,流可以覆盖相同的事件。在一些实施例中,连接设备可以具有探索事件的空间上不同的视点的选项。例如,环法自行车赛(Tour de France)的覆盖范围包括比赛的若干不同馈送。一个流可以覆盖比赛领先者,而另一个流跟随,例如领先者后面的一组骑自行车的人。主显示器上的导引器的剪辑可以示出领先者后面的一组骑自行车的人,并且用户可以使用连接设备来示出比赛领先者。作为另一示例,网球比赛、足球比赛、英式足球、曲棍球、棒球或其他体育赛事的覆盖范围可以包括若干馈送,并且可以在连接设备处通过另一同时的时间和空间同步的视角(例如,网球中的回攻手、足球中的接收者或其他角度和视图)来补充关注一个视角(例如,网球中的发球员、足球中的四分卫)的导引器的剪辑。

对于一些实施例,确定沉浸式视频的视口可以包括选择与所显示的沉浸式视频的一部分相对应的虚拟镜像的位置。这样的虚拟镜像位置可以基于用户指示对象作为沉浸式视频的AR视图中的镜像的选择来选择。在一些实施例中,显示沉浸式视频的视口可以包括渲染沉浸式视频的与虚拟镜像的位置对应的部分和/或用沉浸式视频的视口的部分替换虚拟镜像对象。

图14A是示出了根据一些实施例的示例沉浸式视频内容流的示意性透视图。在一些实施例中,360度内容分发可以包括内容的创建、元数据的插入、以及针对观看者的内容的流送。内容1400,诸如图14A中所示的示例,可以用3D或360度相机设置来记录。图14A示出了计算机房间的360度视图1402。

图14B是示出了根据一些实施例的导引器对沉浸式视频的主显示视图的示例性决定的示意性透视图。内容创建器(或导引器)可以选择用于呈现的内容的视图。在一些实施例中,导引器通过设置媒体播放器的渲染约束来创建2D呈现。例如,可以利用每个时间帧的坐标和图像大小信息来创建时间序列数据库。图14B是图14A中所示的360度视频内容的子集。图14B中所示的导引器的主显示视图是用图14A中的矩形1404勾勒出的视频内容的调整大小的图像1450。

对于一些实施例,可以向观看者呈现在多设备环境内更自由地探索内容的选项。通过将平板(或其他连接设备)连接到主显示器(例如,其可以是智能TV),观看者能够在不同的方向上观看内容。在一些实施例中,平板(或其他连接设备)将流与主显示器同步(这可以使用指向主显示器上的视频呈现的背面相机来完成)。该动作使得能够进行多设备环境的时间和空间同步。

图15A是示出了根据一些实施例的用于探索沉浸式视频环境的示例设备的示意性透视图。图15B是示出了根据一些实施例的与沉浸式视频内容的虚拟镜像视图一起使用的示例设备的示意性透视图。图15A和15B的示例连接设备是平板1502、1552,但是诸如智能电话的其他设备可以用于探索沉浸式视频。

前置相机可以捕获用户的图像并且可以将该图像覆盖在呈现的上面。观看者可以看到她自己1556,就像她在物理镜像中一样。背景可以取自360度流。用户可以如在呈现中一样体验环境。对于一些实施例,图15A可以具有指示用户后面的位置的中心罗盘航向,并且图15B可以具有指示用户前面的位置的中心罗盘航向。对于一些实施例,虚拟镜像视图可示出与用户后面的位置相关联的内容的反射。因此,图15B的背景内容1554是图15A中所示的内容1504的镜像反射。在图15B中,用户与图15A相比已经转过180度,使得图15B中的内容1554是图15A中的内容1504的镜像图像,并且图15B中的内容1554出现在用户1556之后。

对于一些实施例,来自移动设备的前置相机的图像可被记录以产生记录图像。记录的图像可以被覆盖在视口上以生成更新的视口。显示视口可以包括显示更新的视口。在一些实施例中,记录的图像可以被显示为视口上的覆盖图。对于一些实施例,沉浸式视频的视口可以包括沉浸式视频的另一视口的虚拟镜像。

图16A是示出了根据一些实施例的显示位于用户后面的沉浸式视频内容的虚拟镜像的示例AR视图的示意性透视图。图16B是示出了根据一些实施方式的显示覆盖有化身的沉浸式视频内容的示例AR视图的示意性透视图。

在一些实施例中,在AR环境中,可以利用显示虚拟镜像的移动设备来实现镜像视图模式。用户看到AR视图中的镜像并且可以跟随虚拟镜像上显示的呈现。在图16A和16B的虚拟镜像1604、1654上显示的呈现被呈现为看起来类似于在图15A和15B的平板1502、1552上显示的内容。对于一些实施例,用户的化身1656(例如,机器人的AR图像被示出为图16B中的示例)可以与可穿戴AR头戴设备一起使用。确定可穿戴AR头戴设备相对于人造对象(或人造镜像)的位置(并且由此确定用户的位置)。化身1656的渲染可使用该相对位置来更改。图16A示出了根据一些实施例的显示位于用户后面的具有沉浸式(例如,360度)视频内容的虚拟镜像1604的书1602的AR视图的示例。图16B示出了根据一些实施方式的显示具有虚拟镜像的书1652的AR视图的示例,该虚拟镜像显示覆盖有化身1656的沉浸式(例如,360度)视频内容。在根据一些实施例的图16B中所示的示例中,表示用户的化身1656反映用户的视角与图16A相比已经转动了180度,使得图16B中的内容1654是图16A中的内容1604的镜像图像,并且内容1654出现在表示用户的化身1656之后。

图17是示出根据一些实施例的示例过程的流程图。在一些实施例中,过程1700可以包括接收1702元数据,该元数据指示沉浸式视频的哪个部分对应于在第一显示器上显示的沉浸式视频的第一视口。过程1700进一步可包括跟踪1704第二显示器相对于第一显示器的取向。过程1700的一些实施例可以包括基于元数据和第二显示器相对于第一显示器的取向,确定1706在时间和空间上与在第一显示器上显示的沉浸式视频同步的沉浸式视频的第二视口。在一些实施例中,过程1700可包括在第二显示器上显示1708第二视口。在一些实施例中,装置可以包括处理器和存储指令的非暂时性计算机可读介质,当由处理器执行所述指令时,所述指令可操作用于执行本文公开的过程,诸如图17中所示的过程1700。

图18是示出根据一些实施例的示例过程的流程图。在一些实施例中,过程1800可以包括接收1802在第一显示器上利用第一视口显示的沉浸式视频。过程1800的一些实施例进一步可以包括接收1804指示沉浸式视频的第一视口的元数据。在一些实施例中,过程1800可包括跟踪1806第一显示器和第二显示器之间的相对取向。过程1800的一些实施例进一步可以包括使沉浸式视频的第二视口的取向相对于第一视口同步1808,以生成用于第二视口的同步的沉浸式视频。在一些实施例中,过程1800可以包括基于第一视口和相对取向来确定1810同步的沉浸式视频的修改的视口。过程1800的一些实施例进一步可以包括在第二显示器上显示1812修改的视口。在一些实施例中,装置可以包括处理器和存储指令的非暂时性计算机可读介质,当由处理器执行所述指令时,所述指令可操作以执行本文公开的过程,诸如图18中所示的过程1800。

对于一些实施例,由设备执行的示例过程可以包括接收指示360度视频内容的哪个部分对应于在固定显示器上显示的360度视频内容的第一视口的元数据。示例过程可以包括跟踪移动设备相对于固定显示器的取向。示例过程进一步可以包括基于元数据和移动设备相对于固定显示器的取向来确定在时间和空间上与固定显示器上显示的360度视频内容同步的360度视频内容的第二视口。示例过程还可以包括在移动设备上显示第二视口。

对于一些实施例,由设备执行的第二示例过程可以包括接收在第一显示器上利用第一视口显示的沉浸式视频。第二示例过程可以包括接收指示沉浸式视频的第一视口的元数据。第二示例过程进一步可以包括跟踪第一显示器和第二显示器之间的相对取向。第二示例过程可以包括将沉浸式视频的第二视口与第一视口同步以生成同步的沉浸式视频。第二示例过程可以包括基于第一视口和相对取向来确定同步的沉浸式视频的修改的视口。例如,可以使用相对取向来重新定向第一视口以生成经修改的视口。这种重新定向可以使用关于图9A-9C描述的等式1来执行。第二示例过程进一步可以包括在第二显示器上显示修改的视口。对于一些实施例,装置或设备可包含处理器和存储指令的非暂时性计算机可读媒体,所述指令在由所述处理器执行时操作用于执行上文所描述的方法中的任一者。

对于一些实施例,可以在虚拟现实(VR)、混合现实(MR)或增强现实(AR)的环境中执行方法和系统。对于一些实施例,头戴式显示器(HMD)可以用于显示VR、MR或AR环境,或者例如这些的任何组合。对于一些实施例,可穿戴设备(其可以附接到用户的头部或者可以不附接到用户的头部)可以用于显示360度视频或沉浸式视频的视口。

根据一些实施例的示例方法可以包括:接收指示360度视频的哪个部分对应于在固定显示器上显示的360度视频的第一视口的元数据;跟踪移动设备相对于所述固定显示器的取向;基于所述元数据和所述移动设备相对于所述固定显示器的所述取向,确定在时间和取向上相对于在所述固定显示器上显示的所述360度视频同步的所述360度视频的第二视口;以及在移动设备上显示第二视口。

在示例方法的一些实施例中,确定第二视口可以包括:根据所述移动设备相对于所述固定显示器的所述取向确定第一角度;根据在所述固定显示器上显示的所述360度视频的所述第一视口的中心确定第二角度;以及针对第二角度,对在时间和空间上同步的360度视频进行定向以生成第二视口。

在示例方法的一些实施例中,确定360度视频的第二视口可以包括确定360度视频的虚拟镜像视口。

在示例方法的一些实施例中,确定360度视频的第二视口可以包括选择与固定显示器上显示的360度视频的部分相对应的虚拟镜像的位置。

在示例方法的一些实施例中,显示360度视频的第二视口可以包括渲染360度视频的与虚拟镜像的位置相对应的部分。

示例方法的一些实施例进一步可以包括:记录来自移动设备的前置相机的图像以生成记录的图像;以及所记录的图像覆盖在第二视口上以生成更新的第二视口,其中显示第二视口包括显示更新的第二视口。

示例方法的一些实施例进一步可以包括:记录来自移动设备的前置相机的图像以生成记录的图像;以及在移动设备上将记录的图像显示为第二视口上的覆盖图。

在示例方法的一些实施例中,第二视口是第一视口的虚拟镜像。

示例方法的一些实施例进一步可以包括:选择所述360度视频的所述第二视口内的对象作为虚拟镜像对象,其中显示所述第二视口可包括将所述虚拟镜像对象替换为所述360度视频的所述第一视口的部分。

示例方法的一些实施例进一步可以包括:选择360度视频内的对象作为虚拟镜像对象;以及将虚拟镜像对象替换为360度视频的第一视口的部分,其中显示第二视口可以包括显示替换为360度视频的第一视口的部分的虚拟镜像对象。

在示例方法的一些实施例中,第二视口是第一视口的虚拟镜像。

示例方法的一些实施例进一步可以包括:记录来自移动设备的前置相机的图像以生成记录的图像;确定记录的图像中的用户的边界以生成所述用户的形状;通过跟踪所述用户的形状来裁剪所述记录的图像以生成裁剪后的图像;以及在移动设备上将裁剪后的图像显示为第二视口上的覆盖图。

在示例方法的一些实施例中,确定360度视频的第二视口可以包括:捕获在固定显示器上显示的360度视频的图像以生成捕获的图像;确定所述捕获的图像被捕获的第一时刻;确定显示与捕获的图像相对应的360度视频的第一部分的第二时刻;将时间延迟确定为第一时刻和第二时刻之间的差;基于所述时间延迟来对所述第二视口进行时间调整以生成经时间调整的视口;以及在移动设备上显示经时间调整的视口。

在示例方法的一些实施例中,跟踪移动设备相对于固定显示器的取向可以包括:当所述固定显示器在第一时间平行于所述移动设备时,确定所述移动设备的第一方向;确定所述移动设备在第二时间的第二方向;确定所述第一方向与所述第二方向之间的航向差;以及将所述航向差存储为所述移动设备相对于所述固定显示器的所述取向。

在示例方法的一些实施例中,跟踪移动设备相对于固定显示器的取向可以包括:确定所述移动设备在第一时间相对于所述固定显示器的第一方向;确定所述移动设备在第二时间相对于所述固定显示器的第二方向;确定所述第一方向与所述第二方向之间的航向差;以及将所述航向差存储为所述移动设备相对于所述固定显示器的所述取向。

在示例方法的一些实施例中,元数据可以包括媒体呈现描述文件。

根据一些实施例的示例装置可以包括:处理器;以及存储指令的非暂时性计算机可读介质,所述指令在由处理器执行时可操作用于执行上文列出的方法中的任何方法。

根据一些实施例的另一示例方法可以包括:接收在第一显示器上利用第一视口显示的沉浸式视频;接收指示所述沉浸式视频的所述第一视口的元数据;跟踪所述第一显示器与第二显示器之间的相对取向;使所述沉浸式视频的第二视口的取向相对于所述第一视口同步,以生成用于所述第二视口的同步的沉浸式视频;基于所述第一视口和所述相对取向来确定所述同步的沉浸式视频的修改的视口;以及在第二显示器上显示修改的视口。

在示例方法的一些实施例中,跟踪第一显示器和第二显示器之间的相对取向可以包括:确定第二显示器在第一时间相对于第一显示器的第一方向;确定第二显示器在第二时间相对于第一显示器的第二方向;确定所述第一方向与所述第二方向之间的航向差;以及将航向差存储为第一显示器与第二显示器之间的相对取向。

在示例方法的一些实施例中,确定沉浸式视频的修改的视口可以包括选择与在第一显示器上显示的沉浸式视频的部分相对应的虚拟镜像的位置。

在示例方法的一些实施例中,显示沉浸式视频的修改的视口可以包括渲染沉浸式视频的与虚拟镜像的位置相对应的部分。

根据一些实施例的示例装置可以包括:处理器;以及存储指令的非暂时性计算机可读介质,所述指令在由处理器执行时可操作用于执行上文列出的方法中的任何方法。

根据一些实施例的另一示例方法可以包括:接收元数据,所述元数据指示沉浸式视频的哪个部分对应于在第一显示器上显示的沉浸式视频的第一视口;跟踪第二显示器相对于所述第一显示器的取向;基于所述元数据和所述第二显示器相对于所述第一显示器的取向,确定在时间和取向上相对于在所述第一显示器上显示的所述沉浸式视频同步的所述沉浸式视频的第二视口;以及在第二显示器上显示第二视口。

根据一些实施例的示例装置可以包括:处理器;以及存储指令的非暂时性计算机可读介质,所述指令在由处理器执行时可操作用于执行上文列出的方法中的任何方法。

根据一些实施例的示例方法可以包括:接收与在第一显示器上示出的内容相关联的沉浸式视频;使在第二显示器上示出的沉浸式视频与在第一显示器上示出的内容时间同步以生成时间同步的沉浸式视频;跟踪所述第一显示器与所述第二显示器之间的相对取向;接收指示所述时间同步的沉浸式视频的第一视口的元数据;基于所述第一视口和所述相对取向来确定所述时间同步的沉浸式视频的修改的视口;以及在第二显示器上显示修改的视口。

对于示例方法的一些实施例,元数据可以指示作为时间的函数的第一视口在时间同步的沉浸式视频内的位置。

方法的一些实施例进一步可以包括使在第二显示器上示出的沉浸式视频与在第一显示器上示出的内容空间同步。

对于一些实施例,确定修改的视口可以包括:根据所述第一显示器与所述第二显示器之间的所述相对定向确定第一角度;确定从所述第一视口的中心到所述第一显示器上所示内容的北方向的第二角度;确定作为所述第一角度和所述第二角度的差的修改角度;以及通过针对修改的角度定向时间同步的沉浸式视频来确定修改的视口。

方法的一些实施例进一步可以包括:确定所述时间同步的沉浸式视频的虚拟镜像视口以生成反射的沉浸式视频,其中确定所述修改的视口包括确定所述反射的沉浸式视频的视口。

对于一些实施例,确定虚拟镜像视口可以包括:记录来自移动设备的前置相机的图像以生成记录的图像;将所记录的图像覆盖在所述修改的视口上以生成合成图像;以及在第二显示器上显示合成图像。

方法的一些实施例进一步可以包括:确定记录的图像中的用户的边界以生成所述用户的形状;以及通过跟踪用户的形状来裁剪记录的图像以生成裁剪后的图像,其中将记录的图像覆盖在修改的视口上包括将裁剪后的图像覆盖在修改的视口上。

对于一些实施例,时间同步沉浸式视频可以包括:捕获在所述第一显示器上示出的所述内容的图像以生成捕获的图像;确定捕获的图像被捕获的第一时刻;确定沉浸式视频的与捕获的图像相对应的第一部分被显示的第二时刻;将时间延迟确定为第一时刻和第二时刻之间的差;以及基于所述时间延迟来对在所述第二显示器上显示所述修改的视口进行时间调整。

对于一些实施例,跟踪第一显示器和第二显示器之间的相对取向可以包括:在第一显示器在时间t1平行于第二显示器的条件下,确定第二显示器的第一罗盘航向;确定第二显示器在时间t2的第二罗盘航向;确定所述第一罗盘航向与所述第二罗盘航向之间的航向差;以及存储航向差以跟踪第一显示器与第二显示器之间的相对取向。

方法的一些实施例可以包括:接收与在第一显示器上示出的内容相关联的沉浸式视频;使在第二显示器上示出的沉浸式视频与在第一显示器上示出的内容时间同步以生成时间同步的沉浸式视频;选择与在所述第二显示器上示出的所述时间同步的沉浸式视频的部分相对应的虚拟镜像的位置;渲染所述时间同步的沉浸式视频的修改的视口,所述修改的视口可以包括:渲染所述时间同步的沉浸式视频的虚拟镜像视口,并且渲染所述时间同步的沉浸式视频的修改的视口,其中所述时间同步的沉浸式视频的所述虚拟镜像视口用于渲染所述时间同步的沉浸式视频的与所述虚拟镜像的所述虚拟位置相对应的部分;以及在第二显示器上显示修改的视口。

方法的一些实施例进一步可以包括使在第二显示器上示出的沉浸式视频与在第一显示器上示出的内容空间同步。

方法的一些实施例进一步可以包括:跟踪所述第一显示器与所述第二显示器之间的相对定向;接收指示所述时间同步的沉浸式视频的第一视口的元数据;以及基于第一视口和相对取向来确定时间同步的沉浸式视频的修改的视口。

对于一些实施例,元数据可以指示作为时间的函数的第一视口在时间同步的沉浸式视频内的位置。

对于一些实施例,确定修改的视口可以包括:根据所述第一显示器与所述第二显示器之间的所述相对取向确定第一角度;确定从所述第一视口的中心到所述第一显示器上示出的内容的北方向的第二角度;将修改的角度确定为所述第一角度和所述第二角度的差;以及通过针对修改的角度定向时间同步的沉浸式视频来确定修改的视口。

对于一些实施例,渲染时间同步的沉浸式视频的虚拟镜像视口可以包括确定时间同步的沉浸式视频的虚拟镜像视口以生成反射的沉浸式视频,其中渲染修改的视口包括确定反射的沉浸式视频的视口。

对于一些实施例,确定虚拟镜像视口可以包括:记录来自移动设备的前置相机的图像以生成记录的图像;将记录的图像覆盖在所述修改的视口上以生成合成图像;以及在第二显示器上显示合成图像。

方法的一些实施例进一步可以包括:确定记录的图像中的用户的边界以生成所述用户的形状;以及通过跟踪用户的形状来裁剪记录的图像以生成裁剪后的图像,其中将记录的图像覆盖在修改的视口上包括将裁剪后的图像覆盖在修改的视口上。

对于一些实施例,时间同步沉浸式视频可以包括:捕获在所述第一显示器上示出的所述内容的图像以生成捕获的图像;确定捕获的图像被捕获的第一时刻;确定沉浸式视频的与捕获的图像相对应的第一部分被显示的第二时刻;将时间延迟确定为第一时刻和第二时刻之间的差;以及基于所述时间延迟来对在所述第二显示器上显示所述修改的视口进行时间调整。

对于一些实施例,跟踪第一显示器和第二显示器之间的相对取向可以包括:针对第一显示器在第一时间(例如,时间t1)平行于第二显示器的状况,确定第二显示器的第一罗盘航向;确定第二显示器在第二时间(例如,时间t2)的第二罗盘航向;确定所述第一罗盘航向与所述第二罗盘航向之间的航向差;以及存储航向差以跟踪第一显示器与第二显示器之间的相对取向。

设备的一些实施例可以包括:位置传感器;处理器;以及存储指令的非暂时性计算机可读介质,如果在处理器上执行,则所述指令可操作用于执行以下过程:接收与在第一显示器上示出的内容相关联的沉浸式视频;使在第二显示器上示出的沉浸式视频与在第一显示器上示出的内容时间同步以生成时间同步的沉浸式视频;跟踪所述第一显示器与所述第二显示器之间的相对取向;接收指示所述时间同步的沉浸式视频的第一视口的元数据;基于所述第一视口和所述相对取向来确定所述时间同步的沉浸式视频的修改的视口;以及在第二显示器上显示修改的视口。

注意,所描述的一个或多个实施例的各种硬件元件被称为“模块”,其实施(即,执行、施行等)在此结合相应模块描述的各种功能。如本文所使用的,模块包括相关领域的技术人员认为适合于给定实现的硬件(例如,一个或多个处理器、一个或多个微处理器、一个或多个微控制器、一个或多个微芯片、一个或多个专用集成电路(ASIC)、一个或多个现场可编程门阵列(FPGA)、一个或多个存储器设备)。每个所描述的模块还可以包括可执行用于实施被描述为由相应模块实施的一个或多个功能的指令,并且注意,这些指令可以采取硬件(即,硬连线的)指令、固件指令、软件指令等的形式或包括它们,并且可以存储在任何适当的非暂时性计算机可读介质或媒介中,诸如通常被称为RAM、ROM等。

尽管以上以特定的组合描述了特征和元素,但是本领域的普通技术人员将理解,每个特征或元素可以单独使用或与其它特征和元素任意组合使用。另外,本文描述的方法可以在计算机程序、软件或固件中实现,所述计算机程序、软件或固件并入计算机可读介质中以由计算机或处理器执行。计算机可读存储介质的示例包括但不限于,只读存储器(ROM)、随机存取存储器(RAM)、寄存器、高速缓冲存储器、半导体存储器设备、诸如内部硬盘和可移动盘的磁介质、磁光介质、以及诸如CD-ROM盘和数字多功能盘(DVD)的光介质。与软件相关联的处理器可以用于实现在WTRU、UE、终端、基站、RNC或任何主机计算机中使用的射频收发器。

- 360度多视口系统

- 协作系统中虚拟工作空间视口的跟随模式和位置标记