一种文本话题标签生成方法、终端设备及存储介质

文献发布时间:2023-06-19 09:57:26

技术领域

本发明涉及文本处理领域,尤其涉及一种文本话题标签生成方法、终端设备及存储介质。

背景技术

随着网络数据的高速膨胀增长,智能数据搜索的需求与日俱增。通过设置相关的搜索条件、关键字标签可以获取到所关注事物事件的新闻、评论等相关知识。而各个大数据中心的建立也需要对原始数据进行逻辑整理与标签化。基于语义信息的逻辑推理标签可以帮助人们在数据中心获取到逻辑语义上而非字符层面上更具关联的信息,在数据中心构建广范围的数据关联及数据推理中提供便利。

现有技术对数据库内容整理主要分为两个方向,一是基于线上信息的直接整理,主要利用网页链接的关联结构,或互联网文本本身检索时带有标签属性;当原始线上文本不带有类似标签分类信息时,数据整理的方法往往依靠人工整备标签内容及类别再利用机器学习方法进行标记训练。线上抓取方式依赖于原始内容标签及互联网链接关系,这会在数据整理过程中产生大量缺省值,导致数据关联稀疏;机器学习方法训练标签分类主要存在耗费人力大、标签覆盖面少,训练结果较为机械缺乏灵活性等缺点。

发明内容

为了解决上述问题,本发明提出了一种文本话题标签生成方法、终端设备及存储介质,在互联网文本缺乏自带话题标签的情形下,对长文本做多话题打标,实现文本内容的话题概括,为多文本内容构建话题关联。

具体方案如下:

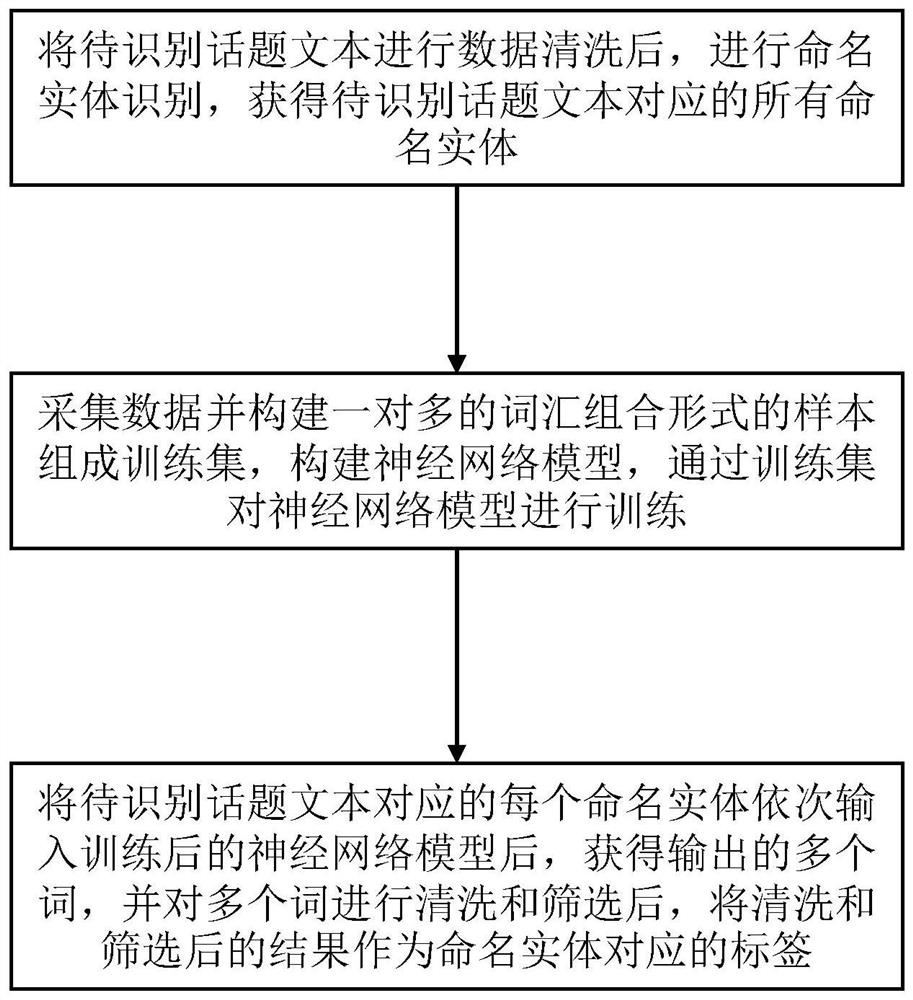

一种文本话题标签生成方法,包括以下步骤:

S1:将待识别话题文本进行数据清洗后,进行命名实体识别,获得待识别话题文本对应的所有命名实体;

S2:采集数据并构建一对多的词汇组合形式的样本组成训练集,一对多的词汇组合形式为一个词对应多个该词的语义关联词;构建神经网络模型,通过训练集对神经网络模型进行训练,其中训练集样本的一对多的词汇组合形式中,一个词作为神经网络模型的输入,该词对应的多个语义关联词作为神经网络模型的输出;

S3:将待识别话题文本对应的每个命名实体依次输入训练后的神经网络模型后,获得输出的多个词,并对多个词进行清洗和筛选后,将清洗和筛选后的结果作为命名实体对应的标签。

进一步的,步骤S1中数据清洗包括以下步骤:

S101:将待识别话题文本进行分句处理,划分为多个句子;

S102:去除所有句子中的格式化语段;

S103:对每个句子进行分词、词性识别、去除停用词和去除无意义符号的处理。

进一步的,步骤S1中将命名实体识别结果中的单字实体去除后,作为待识别话题文本对应的命名实体。

进一步的,步骤S2中每个词对应的语义关联词的抽取过程包括以下步骤:

S201:获取每个词对应的多条词汇解释词条;

S202:针对多条词条的被解释词部分,去除由二级汉字构成的词条,并且只保留名词、动词和形容词三种类别的词汇构成的词条;

S203:针对每条词条的解释语部分,去除发音和例句部分,去除无意义的符号,进行分词处理和词性识别;

S204:根据被解释词的词性,抽取解释语中的对应词性的词作为被解释词对应的语义关联词。

进一步的,神经网络模型的网络结构为多层感知机网络结构,其中前三层为全连接网络,后三层对应输出端为各自独立的全连接网络。

进一步的,神经网络模型的损失函数loss为:

其中,

进一步的,步骤S3中清洗和筛选包括:去除标点符号,去除5个字以上的长词汇、去除单字词汇和去除由二级汉字构成的词汇。

一种文本话题标签生成终端设备,包括处理器、存储器以及存储在所述存储器中并可在所述处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现本发明实施例上述的方法的步骤。

一种计算机可读存储介质,所述计算机可读存储介质存储有计算机程序,所述计算机程序被处理器执行时实现本发明实施例上述的方法的步骤。

本发明采用如上技术方案,通过逻辑语义标签训练生成,可对大范围文本进行话题语义的关联度量,将文本相似度范围进行可解释性归纳,为检索提供更优质的服务。

附图说明

图1所示为本发明实施例一方法的流程图。

图2所示为该实施例中数据清洗过程的流程图。

图3所示为该实施例中语义关联词的抽取过程的流程图。

具体实施方式

为进一步说明各实施例,本发明提供有附图。这些附图为本发明揭露内容的一部分,其主要用以说明实施例,并可配合说明书的相关描述来解释实施例的运作原理。配合参考这些内容,本领域普通技术人员应能理解其他可能的实施方式以及本发明的优点。

现结合附图和具体实施方式对本发明进一步说明。

实施例一:

本发明实施例提供了一种文本话题标签生成方法,如图1所示,其为本发明实施例所述的文本话题标签生成方法的流程图,所述方法包括以下步骤:

S1:将待识别话题文本进行数据清洗后,进行命名实体识别,获得待识别话题文本对应的所有命名实体。

由于待识别话题文本往往为长句子,且其内包含格式化语段、停用词、无意义符号等对命名实体识别造成影响的内容,因此,需要在命名实体识别前对齐进行数据清洗。

如图2所示,该实施例中,数据清洗包括以下步骤:

S101:将待识别话题文本进行分句处理,划分为多个句子。

分句处理可以按照文本中的逗号,句号,叹号,问号,以及空格等来进行句子的边界界定。每一篇长文本可界定出多条单句。

S102:去除所有句子中的格式化语段。

格式化语段具体可以为文段开头的账号名、转发标志语、系统提示语等。

S103:对每个句子进行分词、词性识别、去除停用词和去除无意义符号的处理。

该实施例中保留中文常用的句号,逗号,叹号,问号,省略号作为合法文本,其余标点统一进行删除。

去除停用词使用词性识别结果进行去除,去除文本句子中的助词、数词、连词、量词、介词和副词。

命名实体识别可以采用公知的常用方法进行即可,该实施例中采用开源模型BERT执行命名实体识别,训练集采用自有数据集进行采样标注,每一个命名实体标注选择BIESO标注法进行字符级别标注,分别表示B(begin)I(inside)E(end)S(single)O(other)用来标注多个字符构成的实体的“开始字符”“中间字符”“结束字符”“单一字符实体”“非实体”。

将命名实体识别结果中的单字实体去除后,作为待识别话题文本对应的命名实体。

S2:采集数据并构建一对多的词汇组合形式的样本组成训练集,一对多的词汇组合形式为一个词对应多个该词的语义关联词;构建神经网络模型,通过训练集对神经网络模型进行训练,其中训练集样本的一对多的词汇组合形式中,一个词作为神经网络模型的输入,该词对应的多个语义关联词作为神经网络模型的输出。

如图3所示,该实施例中每个词对应的语义关联词的抽取过程包括以下步骤:

S201:获取每个词对应的多条词汇解释词条。

该实施例中,以《现代汉语词典》中出现的词汇为基础,去除由二级汉字构成的词汇后,针对每个词,从互联网百科数据搜索结果中获取返回的多条词汇解释词条。

S202:针对多条词条的被解释词部分,去除由二级汉字构成的词条,并且只保留名词、动词和形容词三种类别的词汇构成的词条。

S203:针对每条词条的解释语部分,去除发音和例句部分,去除无意义的符号,进行分词处理和词性识别。

S204:根据每条被解释词的词性,抽取解释语中的对应词性的词作为被解释词对应的语义关联词。

当被解释词为名词时,抽取解释语中的名词;当被解释词为动词时,抽取解释语中的动词;被解释词为形容词时,抽取解释语中的形容词。

由于最终需要抽取出一对多的词汇组合,由于百科中的词条数据对一个汉语基础词汇的解释通常由多名相关领域专家反复推敲而定,并且在词汇的解释语句上通常会选用相同词性具有强语义关联的词汇来进行解释,以名词为例,词典通常会使用该词汇的上位词,下位词以及与之具有直接语义关系的名词进行刻画,如:“暗流:社会,地下水,思想,倾向,动态”,因此,按照本实施例中的被解释词与解释语中抽取的词相同词性的规则进行抽取后,将得到形如“霸道:猛烈,厉害”的数据形式。

为了能够更明确的体现映射关系,该实施例中构建的神经网络模型的网络结构为多层感知机网络结构。其中前三层为全连接网络,后三层对应输出端为各自独立的全连接网络。后三层网络连接输出端各自独立是为了避免这种补齐长度时的重复信息造成的干扰。

输出端采用余弦相似度作为损失loss,计算公式如下:

其中,

需要说明的是,由于词不能直接作为模型的输入和输出,因此,该实施例中通过相似词表将每个词转换为相似词表内对应的向量,通过向量来对模型进行训练。

S3:将待识别话题文本对应的每个命名实体依次输入训练后的神经网络模型后,获得输出的多个词,并对多个词进行清洗和筛选后,将清洗和筛选后的结果作为命名实体对应的标签。

该实施例中,将每个命名实体输入训练后的神经网络模型后,输入了n个相似向量,对每个相似向量在相似词表内进行相似词汇检索,获取前t个相似度最大的词汇,因此,每个命名实体对应输出了n*t个结果词汇。

由于这些结果词汇中可能包含近义词,因此还需要进行清洗和筛选。该实施例中清洗和筛选包括:去除标点符号,去除5个字以上的长词汇、去除单字词汇和去除由二级汉字构成的词汇。最终保留的结果为组成标签的词汇。这些词汇将作为该文段的逻辑标签与文段共同存储。若有其他文段具有相同标签,或标签向量相似度在0.8以上,则合并标签。

本发明实施例将互联网百科数据中的核心解释文本作为原始数据,进行数据清洗,构成不限定词性范围的词类比一对多关系,在静态词向量空间做映射训练使得神经网络模型对新词汇具有更广范围的逻辑推理能力。通过神经网络模型对进行命名实体识别后的语段进行话题标签生成。借用神经网络模型从互联网文本中抽取命名实体再进行话题标签生成,使得对互联网文本获得一个自动打标的标签结果,能够更好的在数据库中整合数据。

实施例二:

本发明还提供一种文本话题标签生成终端设备,包括存储器、处理器以及存储在所述存储器中并可在所述处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现本发明实施例一的上述方法实施例中的步骤。

进一步地,作为一个可执行方案,所述文本话题标签生成终端设备可以是桌上型计算机、笔记本、掌上电脑及云端服务器等计算设备。所述文本话题标签生成终端设备可包括,但不仅限于,处理器、存储器。本领域技术人员可以理解,上述文本话题标签生成终端设备的组成结构仅仅是文本话题标签生成终端设备的示例,并不构成对文本话题标签生成终端设备的限定,可以包括比上述更多或更少的部件,或者组合某些部件,或者不同的部件,例如所述文本话题标签生成终端设备还可以包括输入输出设备、网络接入设备、总线等,本发明实施例对此不做限定。

进一步地,作为一个可执行方案,所称处理器可以是中央处理单元(CentralProcessing Unit,CPU),还可以是其他通用处理器、数字信号处理器(Digital SignalProcessor,DSP)、专用集成电路(Application Specific Integrated Circuit,ASIC)、现场可编程门阵列(Field-Programmable Gate Array,FPGA)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件等。通用处理器可以是微处理器或者该处理器也可以是任何常规的处理器等,所述处理器是所述文本话题标签生成终端设备的控制中心,利用各种接口和线路连接整个文本话题标签生成终端设备的各个部分。

所述存储器可用于存储所述计算机程序和/或模块,所述处理器通过运行或执行存储在所述存储器内的计算机程序和/或模块,以及调用存储在存储器内的数据,实现所述文本话题标签生成终端设备的各种功能。所述存储器可主要包括存储程序区和存储数据区,其中,存储程序区可存储操作系统、至少一个功能所需的应用程序;存储数据区可存储根据手机的使用所创建的数据等。此外,存储器可以包括高速随机存取存储器,还可以包括非易失性存储器,例如硬盘、内存、插接式硬盘,智能存储卡(Smart Media Card,SMC),安全数字(Secure Digital,SD)卡,闪存卡(Flash Card)、至少一个磁盘存储器件、闪存器件、或其他易失性固态存储器件。

本发明还提供一种计算机可读存储介质,所述计算机可读存储介质存储有计算机程序,所述计算机程序被处理器执行时实现本发明实施例上述方法的步骤。

所述文本话题标签生成终端设备集成的模块/单元如果以软件功能单元的形式实现并作为独立的产品销售或使用时,可以存储在一个计算机可读取存储介质中。基于这样的理解,本发明实现上述实施例方法中的全部或部分流程,也可以通过计算机程序来指令相关的硬件来完成,所述的计算机程序可存储于一计算机可读存储介质中,该计算机程序在被处理器执行时,可实现上述各个方法实施例的步骤。其中,所述计算机程序包括计算机程序代码,所述计算机程序代码可以为源代码形式、对象代码形式、可执行文件或某些中间形式等。所述计算机可读介质可以包括:能够携带所述计算机程序代码的任何实体或装置、记录介质、U盘、移动硬盘、磁碟、光盘、计算机存储器、只读存储器(ROM,Read-OnlyMemory)、随机存取存储器(RAM,Random Access Memory)以及软件分发介质等。

尽管结合优选实施方案具体展示和介绍了本发明,但所属领域的技术人员应该明白,在不脱离所附权利要求书所限定的本发明的精神和范围内,在形式上和细节上可以对本发明做出各种变化,均为本发明的保护范围。

- 一种文本话题标签生成方法、终端设备及存储介质

- 一种医学文本标签生成系统、方法及计算机可读存储介质