混合图神经网络模型的训练、预测方法和装置

文献发布时间:2023-06-19 09:57:26

技术领域

本说明书涉及数据处理技术领域,尤其涉及一种混合图神经网络的训练方法和装置、和一种混合图神经网络的预测方法和装置。

背景技术

图具有强大的表达能力,能够用来作为数据结构,对在各个领域运行的社会网络进行建模。图通常用来描述某些事物之间的某种特定关系,用点代表事物,用连接两点的线表示相应两个事物间具有这种关系。图神经网络(GNN,Graph Neural Networks)是在图域上运行的基于深度学习的算法,具有令人信服的性能和高解释性,已成为一种广泛应用的图形分析方法。

在很多应用场景中,机器学习任务的输入数据不适合表示为图域中的信息,例如具有时序关系的一系列数据。混合图神经网络模型结合了图神经网络算法和其他机器学习算法,能够在这些应用场景中大大提升预测的效果。

在采用某个点的样本对混合图神经网络模型进行训练时,或者采用混合图神经网络模型对某个点进行预测时,需要计算该点的

发明内容

有鉴于此,本说明书提供一种混合图神经网络模型的训练方法,所述混合图神经网络模型包括编码函数和解码函数,所述编码函数为带有编码参数的图神经网络算法及其组合,所述解码函数为带有解码参数的机器学习算法及其组合,所述方法包括:

以训练样本中所有目标对应的实例以及所述实例的若干度邻居作为图中的点,基于所有实例的图数据,采用编码函数生成每个实例的图表示向量;

对解码参数进行

根据所述

重复上述所有步骤直至满足预定训练终止条件。

本说明书提供的一种混合图神经网络模型的预测方法,所述混合图神经网络模型包括编码函数和解码函数,所述编码函数为带有根据前述混合图神经网络模型的训练方法训练完毕的编码参数的图神经网络算法,所述解码函数为带有根据前述混合图神经网络模型的训练方法训练完毕的解码参数的机器学习算法,所述方法包括:

以所有待预测的目标对应的实例以及所述实例的若干度邻居作为图中的点,基于所有实例的图数据,采用编码函数生成每个实例的图表示向量;

基于与待预测的目标对应的实例的图表示向量、对应的非图数据,采用解码函数生成所述目标的预测量。

本说明书还提供了一种混合图神经网络模型的训练装置,所述混合图神经网络模型包括编码函数和解码函数,所述编码函数为带有编码参数的图神经网络算法及其组合,所述解码函数为带有解码参数的机器学习算法及其组合,所述装置包括:

训练图表示向量单元,用于以训练样本中所有目标对应的实例以及所述实例的若干度邻居作为图中的点,基于所有实例的图数据,采用编码函数生成每个实例的图表示向量;

解码参数训练单元,用于对解码参数进行

编码参数训练单元,用于根据所述

训练循环单元,用于重复采用上述所有单元直至满足预定训练终止条件。

本说明书提供的一种混合图神经网络模型的预测装置,所述混合图神经网络模型包括编码函数和解码函数,所述编码函数为带有根据前述混合图神经网络模型的训练方法训练完毕的编码参数的图神经网络算法,所述解码函数为带有根据前述混合图神经网络模型的训练方法训练完毕的解码参数的机器学习算法,所述装置包括:

预测图表示向量单元,用于以所有待预测的目标对应的实例以及所述实例的若干度邻居作为图中的点,基于所有实例的图数据,采用编码函数生成每个实例的图表示向量;

预测量生成单元,用于基于与待预测的目标对应的实例的图表示向量、对应的非图数据,采用解码函数生成所述目标的预测量。

本说明书提供的一种计算机设备,包括:存储器和处理器;所述存储器上存储有可由处理器运行的计算机程序;所述处理器运行所述计算机程序时,执行上述混合图神经网络的训练方法所述的方法。

本说明书提供的一种计算机设备,包括:存储器和处理器;所述存储器上存储有可由处理器运行的计算机程序;所述处理器运行所述计算机程序时,执行上述混合图神经网络模型的预测方法所述的方法。

本说明书提供的一种计算机可读存储介质,其上存储有计算机程序,所述计算机程序被处理器运行时,执行上述混合图神经网络的训练方法所述的方法。

本说明书还提供了一种计算机可读存储介质,其上存储有计算机程序,所述计算机程序被处理器运行时,执行上述混合图神经网络模型的预测方法所述的方法。

由以上技术方案可见,在本说明书混合图神经网络模型的训练方法和装置实施例中,由编码函数将实例的图数据转换为图表示向量,由解码函数基于图表示向量和对应于目标的非图数据生成训练目标的预测量,并根据预测量与标签量的差异来优化解码参数和编码参数,从而在编码参数未发生变化时一次性的将所有实例的图数据转换为图表示向量,避免了对图数据的冗余重复处理,提高了训练速度;同时,解码函数综合考虑了实例的图表示向量和非图数据,实现了混合图神经网络模型的高效训练。

在本说明书混合图神经网络模型的预测方法和装置实施例中,由编码函数一次性的将所有实例的图数据转换为图表示向量,由解码函数基于图表示向量和对应于目标的非图数据生成训练目标的预测量,从而避免了对图数据的冗余重复处理,提高了预测速度;同时,解码函数综合考虑了实例的图表示向量和非图数据,实现了混合图神经网络模型的高效预测。

附图说明

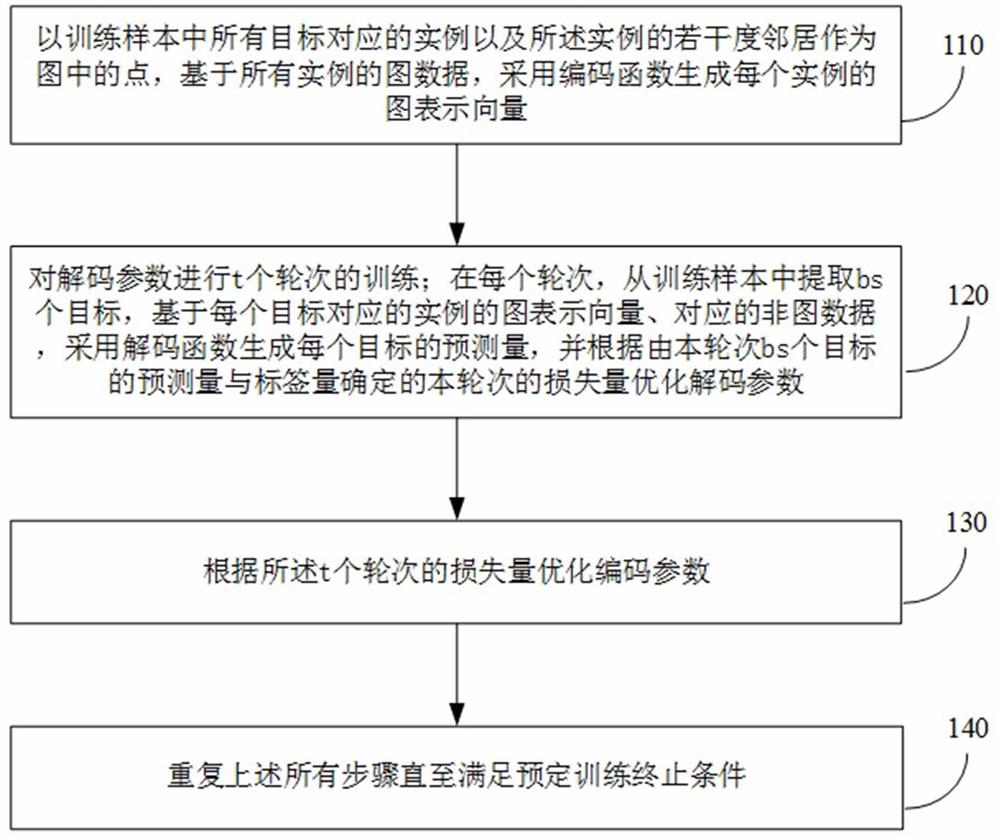

图1是本说明书实施例一中一种混合图神经网络模型的训练方法的流程图;

图2是本说明书实施例一的两种示例性实现方式中混合图神经网络模型训练系统的逻辑结构图;

图3是本说明书实施例二中一种混合图神经网络模型的预测方法的流程图;

图4是本说明书实施例二的两种示例性实现方式中混合图神经网络模型预测系统的逻辑结构图;

图5是运行本说明书实施例的设备的一种硬件结构图;

图6是本说明书实施例中一种混合图神经网络模型的训练装置的逻辑结构图;

图7是本说明书实施例中一种混合图神经网络模型的预测装置的逻辑结构图。

具体实施方式

本说明书的各个实施例中,混合图神经网络模型中的图以实例为点,以实例之间的关系作为边来构建。实例可以是实际应用场景中的任何主体,如用户、商品、店铺、供应商、站点、配送员、网页、用户终端、建筑物等。混合图神经网络模型用来预测与实例相关的状态、行为等。作为预测的目标,状态可以是该实例的类别、该实例的属性等能够描述该主体的信息;行为可以是由该实例实施的行为,也可以是以该实例为实施对象的行为。此外,还可以将第一种主体与第二种主体的匹配程度来作为预测的目标,在这种情形下,可以将其中的一种主体作为实例,另一种作为实例的关联对象。

需要说明的是,本说明书各个实施例中混合图神经网络模型预测的目标是与确定的实例相关的目标,根据预测的目标即可知道在预测该目标时会涉及到的所有图中的实例。混合图神经网络模型的目标对应于至少一个实例。

例如,某个混合图神经网络模型用来对某个用户未来若干天的消费金额进行预测,则这个混合图神经网络模型可以以用户为实例构图,其预测目标是某个用户未来若干天的消费金额,目标对应于一个确定的用户;第二个例子,某个混合图神经网络模型用来对某个网页被其他网页引用的次数进行预测,则这个混合图神经网络模型以网页为实例,其目标对应于一个确定的网页;第三个例子,某个混合图神经网络模型采用一个用户过去曾经点击过的若干个商品来对该用户对某个待推荐商品的感兴趣程度进行预测,则这个混合图神经网络模型以商品为实例,其预测目标是某个用户与目标商品的匹配程度,其目标对应的实例包括目标商品和该用户曾经点击过的若干个商品。

本说明书的各个实施例中,混合图神经网络模型包括编码函数和解码函数。其中,编码函数可以是各种图神经网络算法,也可以是一种到多种图神经网络算法的组合;解码函数可以是包括图神经网络在内的任意的机器学习算法,也可以是一种到多种上述各种机器学习算法的组合,例如可以是DNN(Deep Neural Networks,深度神经网络)、RNN(Recurrent Neural Network,循环神经网络)、LSTM(Long short-term memory,长短期记忆网络)、Wide&Deep(广度和深度)等算法以及这些算法的组合。

混合图神经网络模型的输入是与对应于目标的实例相关的各种数据,这些数据中,可以将适合以图的方式来表达、也适合也图神经网络算法来迭代或处理的数据作为实例的图数据,输入到编码函数,经编码函数处理或者说由编码函数对图数据进行编码后,输出实例的图表示向量;而输入图神经网络模型的数据中除图数据之外的其他数据,称为对应于目标的非图数据,可以与实例的图表示向量一并作为解码函数的输入,经解码函数处理后,输出目标的预测量。解码函数的输出即为混合图神经网络模型的输出,所输出的预测量可以是一个值,也可以是一个向量,不做限定。

本说明书的各个实施例中,将编码函数中使用的可学习参数称为编码参数,将解码函数中使用的可学习参数称为解码参数;模型的训练过程即是通过修改可学习参数,来使得模型的输出更加接近训练样本中模型目标的标签量的过程。

在很多应用场景中,采用混合图神经网络模型对目标进行预测时,要考虑目标对应的实例的属性信息和与实例相关的行为信息。从实例的属性信息可以得到实例自身的属性数据、与其他实例的关系数据;从与实例相关的行为信息可以得到与其他实例的关系数据、以及由与实例相关的历史行为记录得出的行为序列信息(即与实例相关的时序数据)。

在以实例作为图中的点时,实例与其他实例的关系数据可以方便的表达为图中的边,适合以图神经网络算法来处理,因此,与其他实例的关系数据通常可以以图中边的属性的形式,作为编码函数的输入。而与实例相关的时序数据则不适合以图的形式来表达,通常会作为解码函数的输入。

对实例自身的属性数据,虽然可以方便的表达为图中点的属性,但是并不是所有的属性数据都适合由图神经网络算法来处理时,例如,实例自身属性数据中的稀疏数据,就更适合作为解码函数的输入。此外,在某些应用场景中,有些实例自身的部分属性数据作为解码函数的输入时,对目标的预测有更好的效果。本说明书的实施例中,将实例自身的属性数据中输入编码函数的部分称为实例的自身点数据,将实例自身的属性数据中输入解码函数的部分称为实例的自身非点数据。实例的自身稠密数据通常会作为实例的自身点数据,而实例的自身稀疏数据则既可以作为实例的自身点数据,也可以作为实例的自身非点数据。在一些应用场景中,可以将实例的自身稠密数据作为实例的自身点数据,将实例的自身稀疏数据作为实例的自身非点数据;在另外一些应用场景中,也可以将一部分实例的自身稠密数据作为实例的自身点数据,将另一部分实例的自身稠密数据、和实例的自身稀疏数据作为实例的自身非点数据。

其中,稠密数据是可以用一个值或低维度向量表示的数据;而稀疏数据则是以维度很高、但只有少量元素有值的向量来表示的数据。例如,假设以用户为实例,用户的账户余额、账龄都可以表示为一个值,是稠密数据;用户所拥有的银行卡则是稀疏数据,在全世界几十万种银行卡中,一个用户通常只有几张银行卡,以一个维度为几十万但只有几个元素(即用户所拥有的银行卡对应的元素)的值为1的向量来表示。

本说明书的实施例一提出一种新的混合图神经网络模型的训练方法,在编码参数未发生变化时采用编码函数一次性计算所有实例的图表示向量,以实例的图表示向量和与实例相关的非图数据为输入采用解码函数计算训练目标的预测量,基于预测量和标签量优化编码参数及解码参数,避免了对实例图数据的冗余重复计算,降低运算量并加快了训练速度,同时解码函数综合考虑了图数据和非图数据对预测量的影响,实现了混合图神经网络模型的高效训练。

本说明书的实施例一可以运行在任何具有计算和存储能力的设备上,如手机、平板电脑、PC(Personal Computer,个人电脑)、笔记本、服务器等设备;还可以由运行在两个或两个以上设备的逻辑节点来实现本说明书实施例一中的各项功能。

本说明书的实施例一中,混合图神经网络模型的训练方法的流程如图1所示。实施例一中的训练为有监督学习,训练样本中包括混合图神经网络模型的输入数据和目标的标签量(期望的输出),输入数据包括输入编码函数的实例的图数据、和输入解码函数的对应于目标的非图数据。

在训练开始前,编码函数中的编码参数、解码函数中的解码参数被初始化为初始值。本说明书的实施例一中,可以采用任意的方式来设置编码参数和解码参数的初始值。

步骤110,以训练样本中所有目标对应的实例以及该些实例的若干度邻居作为图中的点,基于所有实例的图数据,采用编码函数生成每个实例的图表示向量。

对于编码函数所采用的图神经网络算法,训练样本中每个目标对应的每个实例是图中的一个点,图中点的集合不仅包括训练样本中所有目标对应的所有实例,还可以包括可能成为上述每个实例的若干度邻居的其他实例。例如,一个网络购物平台的商品有10亿个,假设以商品作为混合图神经网络模型的实例,训练样本中包括1亿个商品,而其他9亿个商品可能成为训练样本中1亿个商品的1度到

实例的图数据包括以下的一项到多项:实例自身属性数据中的自身点数据、与其他实例的关系数据。其中,实例的自身点数据用来表达图中点的特性,与其他实例的关系数据用来表达图中边的特性(不同点之间的关联)。与其他实例的关系数据可以是点与某阶邻居之间的关系数据,也可以是点与若干个各阶邻居之间的关系数据的组合,不做限定。

采用编码函数的图神经网络算法,可以将实例的图数据转换为实例的图表示向量。本说明书的实施例一中,对于既定的编码参数,一次性的根据所有实例的图数据,生成图中每个实例的图表示向量;在编码参数发生变化(被优化)后,再重复这一过程,采用变化后的编码参数一次性生成每个实例新的图表示向量;直到训练结束。

步骤120,对解码参数进行

本说明书的实施例一中,对于既定的编码参数,将对解码参数进行

在训练解码参数的每个轮次,从训练样本中提取

在得到本轮次

例如,可以采用预定的损失函数基于每个目标的预测量与标签量计算本轮次每个目标的损失量,再根据

在进行

步骤130:根据上述

可以根据实际应用场景的特点选择任意的优化函数来根据

例如,可以先基于每个轮次的损失量,计算该轮次损失量对该轮次

上述例子中,在采用

步骤140:重复上述所有步骤直至满足预定训练终止条件。

在完成对编码参数的优化后,判断是否满足预定训练终止条件。如果已经满足,则对混合图神经网络模型的训练完成,训练流程结束。如果尚未满足预定训练终止条件,则重复执行步骤110至130。

具体而言,在尚未满足预定终止条件时,转步骤110,按照更新后的编码参数计算所有实例的图表示向量,并采用新计算得出的图表示向量执行步骤120中

本说明书的实施例一中可以采用任意的预定训练终止条件。例如,可以将优化

以下给出本说明书实施例一的第一种示例性实现方式。本第一种示例性实现方式中,混合图神经网络模型用来对实例进行分类。训练样本中对应于所有目标的所有实例、以及可能成为这些实例的若干度邻居的其他实例组成点集合

每个训练样本的目标包括目标标识

第一种示例性实现方式中,混合图神经网络模型训练系统的逻辑结构如图2所示。训练系统包括训练编码器和训练解码器,训练编码器包括编码函数及编码参数模块、图表示向量计算模块、图表示向量存储模块、训练编码器梯度计算与参数优化模块、和梯度接收模块;训练解码器包括解码函数及解码参数模块、图表示向量查询模块、预测量与损失量计算模块、训练解码器梯度计算与参数优化模块、和梯度发送模块。其中,编码函数及编码参数模块中保存有编码函数

步骤S02:开始训练时,将编码函数及编码参数模块中的编码参数

步骤S04:在训练编码器中,基于当前的编码参数

步骤S06:在训练编码器中,由图表示向量存储模块以实例的标识为索引,保存每个实例的标识

步骤S08:在训练解码器中,从训练样本的目标集合中取出

步骤S10:在训练解码器中,预测量与损失量计算模块基于当前的解码参数

步骤S12:在训练解码器中,训练解码器梯度计算与参数优化模块根据本轮次的损失量

步骤S14:在训练解码器中,训练解码器梯度计算与参数优化模块采用式6计算得到本轮次的损失量

步骤S16:在训练解码器中,梯度发送模块将

步骤S18:将

步骤S20:在训练编码器中,训练编码器梯度计算与参数优化模块从梯度接收模块读取保存的

步骤S22:将

步骤S24:训练结束。此时,编码函数及编码参数模块中的编码参数

以下给出本说明书实施例一的第二种示例性实现方式。本第二种示例性实现方式中,混合图神经网络模型用来预测实例与对象的匹配程度。每个训练样本中包括对某个对象

训练样本中对应于所有目标的所有实例、以及可能成为这些实例的若干度邻居的其他实例组成点集合

第二种示例性实现方式中,混合图神经网络模型训练系统的逻辑结构如图2所示。训练系统以如下步骤运行:

步骤S32:开始训练时,将编码函数及编码参数模块中的编码参数

步骤S34:在训练编码器中,基于当前的编码参数

步骤S36:在训练编码器中,由图表示向量存储模块以实例的标识为索引,保存每个实例的标识

步骤S38:在训练解码器中,从训练样本的目标集合中取出

步骤S40:在训练解码器中,预测量与损失量计算模块基于当前的解码参数

步骤S42:在训练解码器中,训练解码器梯度计算与参数优化模块根据本轮次的损失量

步骤S44:在训练解码器中,训练解码器梯度计算与参数优化模块采用式6和式10计算得到本轮次的损失量

步骤S46:在训练解码器中,梯度发送模块将

步骤S48:将

步骤S50:在训练编码器中,训练编码器梯度计算与参数优化模块从梯度接收模块读取保存的

步骤S52:将

步骤S54:训练结束。此时,编码函数及编码参数模块中的编码参数

可见,本说明书的实施例一中,在编码参数未发生变化时采用编码函数一次性计算所有实例的图表示向量,由解码函数基于图表示向量和对应于目标的非图数据生成训练目标的预测量,依据预测量和标签量优化编码参数及解码参数,避免了对图数据的冗余重复处理,降低运算量并加快了训练速度,解码函数综合考虑了实例的图表示向量和非图数据,实现了混合图神经网络模型的高效训练。

本说明书的实施例二提出一种新的混合图神经网络模型的预测方法,采用编码函数一次性计算所有实例的图表示向量,以实例的图表示向量和对应于目标的非图数据为输入采用解码函数计算待预测目标的预测量,避免了对实例图数据的冗余重复计算,降低运算量并加快了预测速度,同时解码函数综合考虑了图数据和非图数据对预测量的影响,实现了混合图神经网络模型的高效预测。

本说明书的实施例二可以运行在任何具有计算和存储能力的设备上,如手机、平板电脑、PC、笔记本、服务器等设备;还可以由运行在两个或两个以上设备的逻辑节点来实现本说明书实施例一中的各项功能。

本说明书的实施例二中,混合图神经网络模型是采用本说明书实施例一的训练方法训练完毕的混合图神经网络模型,也就是说,实施例二的混合图神经网络模型中,编码函数是包括由本说明书实施例一的方法训练完毕的编码参数的图神经网络算法,解码函数是包括由本说明书实施例一的方法训练完毕的解码参数的机器学习算法。混合图神经网络模型的输入数据包括输入编码函数的实例的图数据和输入解码函数的对应于目标的非图数据。

本说明书的实施例二中,混合图神经网络模型的预测方法的流程如图3所示。如前所述,混合图神经网络模型的每个待预测的目标均对应于一个到多个实例。

步骤310:以所有待预测的目标对应的实例以及该些实例的若干度邻居作为图中的点,基于所有实例的图数据,采用编码函数生成每个实例的图表示向量。

对于编码函数所采用的图神经网络算法,训练样本中每个目标对应的每个实例是图中的一个点,图中点的集合不仅包括训练样本中所有目标对应的所有实例,还包括可能成为上述每个实例的若干度邻居的其他实例。

实例的图数据包括以下的一项到多项:实例自身属性数据中的自身点数据、与其他实例的关系数据。其中,实例的自身点数据用来表达图中点的特性,与其他实例的关系数据用来表达图中边的特性(不同点之间的关联)。与其他实例的关系数据可以是点与某阶邻居之间的关系数据,也可以是点与若干个各阶邻居之间的关系数据的组合,不做限定。

编码函数采用训练完毕的图神经网络算法,根据所有实例的图数据,一次性的为图中每个实例生成其图表示向量。

步骤320:基于与待预测的目标对应的实例的图表示向量、对应的非图数据,采用解码函数生成所述目标的预测量。

在生成所有实例的图表示向量后,对于某个或某些待预测的目标,可以将各个目标对应的实例的图表示向量、对应的非图数据输入训练完毕的解码函数,解码函数的输出即是各个目标的预测量。解码函数的输入中,对应于目标的非图数据可以是实例的自身非点数据、与对应于目标的实例相关的时序数据中的一项到多项。

在一些应用场景中,待预测目标的数量比较大。此时可以在每个轮次对

以下给出本说明书实施例二的第一种示例性实现方式。本第一种示例性实现方式中的图神经网络模型是经由本说明书实施例一的第一种示例性实现方式训练完成的图神经网络模型,因此,本第一种示例性实现方式中图神经网络模型用来对实例进行分类,其编码函数

本第一种示例性实现方式中,所有待预测目标对应的实例以及这些实例的若干度邻居组成点集合

本第一种示例性实现方式中,混合图网络神经网络模型预测系统的逻辑结构如图4所示。预测系统包括预测编码器和预测解码器,预测编码器包括编码函数及编码参数模块、图表示向量计算模块、和图表示向量存储模块;预测解码器包括解码函数及解码参数模块、图表示向量查询模块、和预测量计算模块。其中,编码函数及编码参数模块中保存有编码函数

步骤S62:在预测编码器中,采用编码参数

步骤S64:在预测编码器中,由图表示向量存储模块以实例的标识为索引,保存每个实例的标识

步骤S66:令变量

步骤S68:在预测解码器中,从待预测目标的集合中取出

步骤S70:在预测解码器中,预测量计算模块采用解码参数

步骤S72:从待预测的目标集合中删除本轮次取出的

以下给出本说明书实施例二的第二种示例性实现方式。本第二种示例性实现方式中的图神经网络模型是经由本说明书实施例一的第二种示例性实现方式训练完成的图神经网络模型,因此,本第二种示例性实现方式中图神经网络模型用来预测实例与对象的匹配程度,其编码函数

本第二种示例性实现方式中,每个待预测的目标包括目标标识,目标

本第二种示例性实现方式中,所有待预测目标对应的实例以及这些实例的若干度邻居组成点集合

本第二种示例性实现方式中,混合图网络神经网络模型预测系统的逻辑结构如图4所示。预测系统以如下步骤运行:

步骤S82:在预测编码器中,采用训练所得的编码参数

步骤S84:在预测编码器中,由图表示向量存储模块以实例的标识为索引,保存每个实例的标识

步骤S86:令变量

步骤S88:在预测解码器中,从待预测目标的集合中取出

步骤S90:在预测解码器中,预测量计算模块采用解码参数

步骤S92:从待预测的目标集合中删除本轮次取出的

可见,本说明书的实施例二中,采用编码函数一次性计算所有实例的图表示向量,由解码函数基于图表示向量和对应于目标的非图数据生成训练目标的预测量,避免了对图数据的冗余重复处理,降低运算量并加快了预测速度,解码函数综合考虑了实例的图表示向量和非图数据,实现了混合图神经网络模型的高效预测。

上述对本说明书特定实施例进行了描述。其它实施例在所附权利要求书的范围内。在一些情况下,在权利要求书中记载的动作或步骤可以按照不同于实施例中的顺序来执行并且仍然可以实现期望的结果。另外,在附图中描绘的过程不一定要求示出的特定顺序或者连续顺序才能实现期望的结果。在某些实施方式中,多任务处理和并行处理也是可以的或者可能是有利的。

在本说明书的第一个应用示例中,某互联网服务提供商采用混合图神经网络模型来评估用户所属的类别,并依据用户所属的类别,对来自用户的请求进行与其类别相对应的业务处理,从而能够为用户提供更加有针对性的服务,提升业务处理的效率。其中,可以根据具体的业务需求来确定类别的形式、以及相对应的业务处理,不做限定。例如,类别可以是消费级别、信用级别、活跃等级、安全级别等;对应的业务处理可以是对不同类别的用户适用不同的业务流程、采用不同的业务处理参数等。

该互联网服务提供商以用户为实例来构建混合图神经网络模型,模型的训练或预测目标为某个用户所属的类别。混合图神经网络模型中,实例的图数据为用户数据中表达为图中点的属性和边的属性的部分(如用户属性数据中的稠密数据、用户之间的关系数据等),而将用户数据中的其余部分(如用户属性数据中的稀疏数据)、根据用户的历史行为记录生成的历史行为时序数据来作为对应于目标的非图数据。

该互联网服务提供商采用本说明书实施例一的第一种示例性实现方式来进行混合图神经网络模型的训练。在训练完毕后,采用本说明书实施例二的第一种示例性实现方式,来基于训练完毕的混合图神经网络模型预测用户所属的类别,并根据所预测的类别来对用户进行对应于其所属类别的业务处理。

在本说明书的第二个应用示例中,某互联网服务提供商采用混合图神经网络模型来评估用户与对象的匹配程度,并依据用户与对象的匹配程度,向用户推荐对象,以便加快用户获取信息的效率,提升用户的满意度。其中,对象的具体形式不做限定,例如可以是商品、促销活动、广告、对用户搜索请求的搜索结果等。

该互联网服务提供商以对象为实例来构建混合图神经网络模型,模型的训练或预测目标为某个用户与某个对象的匹配程度。混合图神经网络模型中,实例的图数据为对象数据中表达为图中点的属性和边的属性的部分,而将用户的表示向量作为对应于目标的非图数据。根据用户的历史行为记录,将用户曾经有过行为(如浏览、收藏、关注等)的

该互联网服务提供商采用本说明书实施例一的第二种示例性实现方式来进行混合图神经网络模型的训练。在训练完毕后,采用本说明书实施例二的第二种示例性实现方式,来基于训练完毕的混合图神经网络模型预测用户与待推荐对象的匹配程度,并将预测的与该用户匹配程度较高的若干个待推荐对象推荐给用户。

与上述流程实现对应,本说明书的实施例还提供了一种混合图神经网络的训练装置,和一种混合图神经网络的预测装置。这两种装置均可以通过软件实现,也可以通过硬件或者软硬件结合的方式实现。以软件实现为例,作为逻辑意义上的装置,是所在设备的CPU(Central Process Unit,中央处理器)将对应的计算机程序指令读取到内存中运行形成的。从硬件层面而言,除了图5所示的CPU、内存以及存储器之外,混合图神经网络的训练装置或预测装置所在的设备通常还包括用于进行无线信号收发的芯片等其他硬件,和/或用于实现网络通信功能的板卡等其他硬件。

图6所示为本说明书实施例提供的一种混合图神经网络模型的训练装置,所述混合图神经网络模型包括编码函数和解码函数,所述编码函数为带有编码参数的图神经网络算法及其组合,所述解码函数为带有解码参数的机器学习算法及其组合,所述装置包括训练图表示向量单元、解码参数训练单元、编码参数训练单元和训练循环单元,其中:训练图表示向量单元用于以训练样本中所有目标对应的实例以及所述实例的若干度邻居作为图中的点,基于所有实例的图数据,采用编码函数生成每个实例的图表示向量;解码参数训练单元用于对解码参数进行

一个例子中,所述编码参数训练单元具体用于:计算每个轮次的损失量对该轮次

上述例子中,所述编码参数训练单元根据

可选的,所述解码参数训练单元根据由本轮次

可选的,所述预定训练终止条件包括:优化

一种实现方式中,所述实例的图数据包括实例的自身点数据、与其他实例的关系数据中的至少一项;所述对应的非图数据包括对应于目标的实例的自身非点数据、与对应于目标的实例相关的时序数据中的至少一项。

上述实现方式中,所述实例的自身点数据包括:实例的自身稠密数据;所述实例的自身非点数据包括:实例的自身稀疏数据。

可选的,所述混合图神经网络模型用于评估用户所属的类别;所述实例为用户;所述训练目标为某个用户所属的类别;所述实例的图数据包括:用户数据中表达为图中点和边的属性的部分;所述对应的非图数据包括以下至少一项:用户数据中除表达为图中点和边的属性之外的其余部分、根据用户的历史行为记录生成的历史行为时序数据;所述装置还包括类别预测及业务处理单元,用于采用训练完毕的混合图神经网络模型预测用户所属的类别,并根据所述用户所属的类别来对用户进行对应于所述类别的业务处理。

可选的,所述混合图神经网络模型用于评估用户与对象的匹配程度;所述实例为对象,所述训练目标为某个用户与某个待推荐对象的匹配程度;所述实例的图数据包括:对象数据中表达为图中点和边的属性的部分;所述目标对应的实例的图表示向量包括:待推荐对象的图表示向量、和所述用户有过历史行为的

图7所示为本说明书实施例提供的一种混合图神经网络模型的预测装置,所述混合图神经网络模型包括编码函数和解码函数,所述编码函数为带有根据前述混合图神经网络模型训练方法训练完毕的编码参数的图神经网络算法,所述解码函数为带有根据前述混合图神经网络模型训练方法训练完毕的解码参数的机器学习算法,所述装置包括预测图表示向量单元和预测量生成单元其中:预测图表示向量单元用于以所有待预测的目标对应的实例以及所述实例的若干度邻居作为图中的点,基于所有实例的图数据,采用编码函数生成每个实例的图表示向量;预测量生成单元用于基于与待预测的目标对应的实例的图表示向量、对应的非图数据,采用解码函数生成所述目标的预测量。

可选的,所述装置还包括目标提取单元,用于从待预测的目标集合中提取

一个例子中,所述实例的图数据包括实例的自身点数据、与其他实例的关系数据中的至少一项;所述对应的非图数据包括对应于目标的实例的自身非点数据、与对应于目标的实例相关的时序数据中的至少一项。

上述例子中,所述实例的自身点数据包括:实例的自身稠密数据;所述实例的自身非点数据包括:实例的自身稀疏数据。

可选的,所述混合图神经网络模型用于评估用户所属的类别;所述实例为用户;所述待预测的目标为某个用户所属的类别;所述实例的图数据包括:用户数据中表达为图中点和边的属性的部分;所述对应的非图数据包括以下至少一项:用户数据中除表达为图中点和边的属性之外的其余部分、根据用户的历史行为记录生成的历史行为时序数据;所述装置还包括类别业务处理单元,用于根据预测的某个用户所属的类别,来对所述用户进行对应于所述类别的业务处理。

可选的,所述混合图神经网络模型用于评估用户与对象的匹配程度;所述实例为对象,所述训练目标为某个用户与某个待推荐对象的匹配程度;所述实例的图数据包括:对象数据中表达为图中点和边的属性的部分;所述目标对应的实例的图表示向量包括:待推荐对象的图表示向量、和所述用户有过历史行为的

本说明书的实施例提供了一种计算机设备,该计算机设备包括存储器和处理器。其中,存储器上存储有能够由处理器运行的计算机程序;处理器在运行存储的计算机程序时,执行本说明书实施例中混合图神经网络的训练方法的各个步骤。对混合图神经网络的训练方法的各个步骤的详细描述请参见之前的内容,不再重复。

本说明书的实施例提供了一种计算机设备,该计算机设备包括存储器和处理器。其中,存储器上存储有能够由处理器运行的计算机程序;处理器在运行存储的计算机程序时,执行本说明书实施例中混合图神经网络的预测方法的各个步骤。对混合图神经网络的预测方法的各个步骤的详细描述请参见之前的内容,不再重复。

本说明书的实施例提供了一种计算机可读存储介质,该存储介质上存储有计算机程序,这些计算机程序在被处理器运行时,执行本说明书实施例中混合图神经网络的训练方法的各个步骤。对混合图神经网络的训练方法的各个步骤的详细描述请参见之前的内容,不再重复。

本说明书的实施例提供了一种计算机可读存储介质,该存储介质上存储有计算机程序,这些计算机程序在被处理器运行时,执行本说明书实施例中混合图神经网络的预测方法的各个步骤。对混合图神经网络的预测方法的各个步骤的详细描述请参见之前的内容,不再重复。

以上所述仅为本说明书的较佳实施例而已,并不用以限制请求保护的其他实施例,凡在本说明书的精神和原则之内,所做的任何修改、等同替换、改进等,均应包含在请求保护的范围之内。

在一个典型的配置中,计算设备包括一个或多个处理器(CPU)、输入/输出接口、网络接口和内存。

内存可能包括计算机可读介质中的非永久性存储器,随机存取存储器 (RAM)和/或非易失性内存等形式,如只读存储器(ROM)或闪存(flash RAM)。内存是计算机可读介质的示例。

计算机可读介质包括永久性和非永久性、可移动和非可移动媒体可以由任何方法或技术来实现信息存储。信息可以是计算机可读指令、数据结构、程序的模块或其他数据。计算机的存储介质的例子包括,但不限于相变内存(PRAM)、静态随机存取存储器(SRAM)、动态随机存取存储器(DRAM)、其他类型的随机存取存储器(RAM)、只读存储器(ROM)、电可擦除可编程只读存储器 (EEPROM)、快闪记忆体或其他内存技术、只读光盘只读存储器(CD-ROM)、数字多功能光盘(DVD)或其他光学存储、磁盒式磁带,磁带磁磁盘存储或其他磁性存储设备或任何其他非传输介质,可用于存储可以被计算设备访问的信息。按照本文中的界定,计算机可读介质不包括暂存电脑可读媒体(transitory media),如调制的数据信号和载波。

还需要说明的是,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、商品或者设备不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、商品或者设备所固有的要素。在没有更多限制的情况下,由语句“包括一个……”限定的要素,并不排除在包括所述要素的过程、方法、商品或者设备中还存在另外的相同要素。

本领域技术人员应明白,本说明书的实施例可提供为方法、系统或计算机程序产品。因此,本说明书的实施例可采用完全硬件实施例、完全软件实施例或结合软件和硬件方面的实施例的形式。而且,本说明书的实施例可采用在一个或多个其中包含有计算机可用程序代码的计算机可用存储介质(包括但不限于磁盘存储器、CD-ROM、光学存储器等)上实施的计算机程序产品的形式。

- 混合图神经网络模型的训练、预测方法和装置

- 基于图检索引擎的图神经网络模型训练方法和装置