一种多渠道、快速的知识点收集系统

文献发布时间:2023-06-19 10:05:17

技术领域

本发明涉及知识管控技术领域,更具体地,涉及一种多渠道、快速的知识点收集系统。

背景技术

随着经济的发展以及用电量的高速增长,电网的稳定运行工作越来越重要,电力调度工作人员在日常工作中始终处于一个紧张的工作节奏中,需要根据电网的运行做出果断的处置措施,同时需要熟练的操作各个专业系统,熟知相关领域的知识,熟练运用各种情况下的处置策略。但目前专业知识点都分布在各自的领域中,还存在部分离线的知识点存储在个人的电脑中,同时还有各分省公司或者地市发布在网上的一些好的知识点,这些都是调度人员日常工作可能会用到的,分散的知识点较大的制约了大家的工作开展。

往常调度人员在工作过程中只能依靠自己知道的渠道所能够获取的知识进行业务操作,对于其他渠道很难进行知识应用,造成对于专业知识的全面性不够。

目前电网的调度方向的系统比较多,同时随着专业系统的不断开展,系统形成的知识点越来越多,同时还有其他电网单位发布的调度专业方面的知识点,以及个人总结的知识点,分布范围广。同时随着工作要求的不断提高,调度人员在工作的时候如果需要多个知识领域的知识点,往往需要到以上提到的多个地方去查找,同时对于某些知识所在的系统缺少查看的权限可能还需要电话咨询其他人员,有时需要花费大量的精力才能得到自己所需的知识点,严重影响工作人员的工作效率,也对工作人员的日常工作带来较大的工作负担。

发明内容

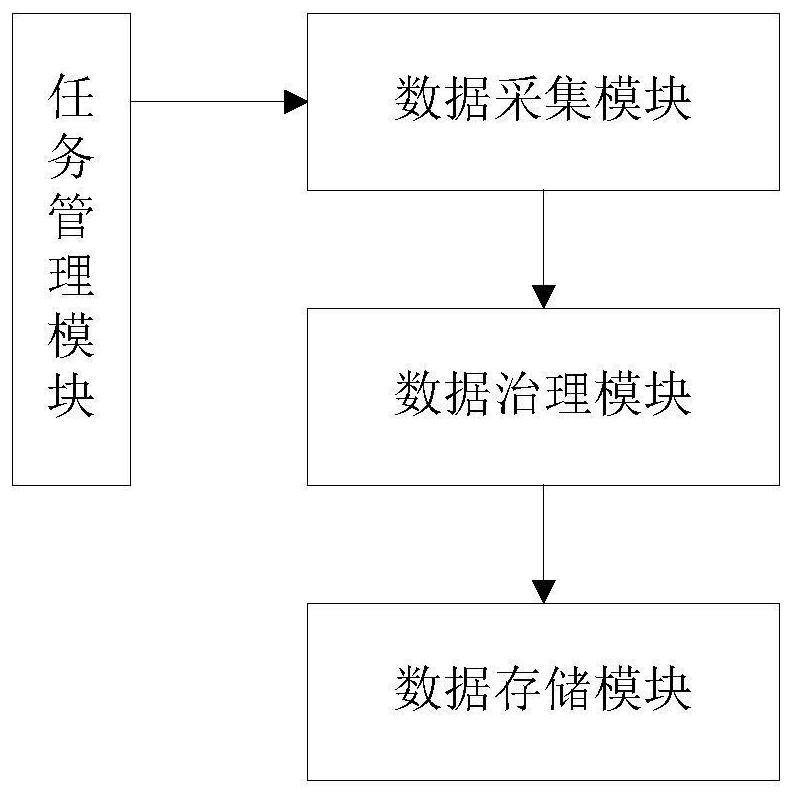

本发明为克服上述现有技术所述的知识点收集效率不够高的缺陷,提供一种多渠道、快速的知识点收集系统,其特征在于,所述系统包括数据采集模块、数据治理模块、数据存储模块、任务管理模块;

数据采集模块负责网络知识点数据的采集,并将采集的数据发送给数据治理模块进行治理,数据治理模块对数据进行治理之后发送给数据存储模块进行存储;其中数据采集模块可实现多线程数据采集;

任务管理模块对实时数据和非实时数据,根据数据生成的时间进行数据采集任务的调度配置,以及指定采集各种任务或定时执行。

2.根据权利要求1所述多渠道、快速的知识点收集系统,其特征在于,数据采集模块可实现以下数据采集步骤:

S1.1:判断数据采集模块接入的数据是网络数据还是其他业务系统数据,若是其他业务系统数据,则执行S1.2,若是网络数据,则执行S1.4;

S1.2:判断该业务系统是否提供数据接口,若提供,则进行接口解析,并采集数据;若不提供接口,则执行S1.3;

S1.3:输入用户账号,并对用户账号进行验证,若验证不通过,则结束数据采集,若通过,则执行S1.4;

S1.4:读取URL(统一资源定位系统,uniform resource locator);

S1.5:下载并解析页面,进行数据采集,直至解析至最后一个页面。

3.根据权利要求2所述多渠道、快速的知识点收集系统,其特征在于,当解析页面为HTML格式时执行正则表达式匹配或JSOUP解析匹配;

当解析页面为JSON格式时,执行JSON路径分析;

当解析界面为JS动态网页时,执行Phantom JS后端解析。

4.根据权利要求3所述多渠道、快速的知识点收集系统,其特征在于,数据治理模块可执行数据清洗、数据解析、分组分析的操作。

5.根据权利要求4所述多渠道、快速的知识点收集系统,其特征在于,数据清洗用来针对现有数据质量问题,对脏数据进行剔除或用估算值替代;对数据缺失进行自动化补全;细化指标计算范围。

6.根据权利要求5所述多渠道、快速的知识点收集系统,其特征在于,

数据解析用来实现数据标准化功能,通过用户定义的规则或者字典将原始数据中的特定属性的数据转变为统一的标准形式,使得数据规范化。

7.根据权利要求6所述多渠道、快速的知识点收集系统,其特征在于,分组分析具体为:针对不同类型的数据采取不同的存储格式,对于文件类型的数据,将文件存储在服务器指定位置,然后对文件进行解析;网页类型的数据直接解析后存储到服务器中。

8.根据权利要求7所述多渠道、快速的知识点收集系统,其特征在于,数据治理模块可实现以下数据治理步骤:

S2.1:爬取数据,并判断是否存在数据缺失、是否重复、是否离群;

S2.2:若存在数据缺失,则对缺失的数据进行数据填充,若不存在数据缺失,则进行多源数据匹配;

若存在数据重复,则对重复的数据进行数据删减,若不存在数据重复,则进行多源数据匹配;

若存在数据离群,则对离群的数据进行数据修正,若不存在数据离群,进行多源数据匹配;

S2.3:判断是否存在多源数据重复,若不存在,则结束数据治理;若存在,则进行关键字匹配,并进行数据去重,完成数据治理。

9.根据权利要求8所述多渠道、快速的知识点收集系统,其特征在于,数据存储模块可实现以下数据存储步骤:

S3.1:对数据库进行库表设计;

S3.2:对外部数据和内部其他系统数据进行元数据存储;

S3.3:判断外部数据结构和内部其他系统数据结构是否发生变动;

S3.4:若内部其他系统数据结构发生变动,则重新进行库表设计;若没发生变动,则将数据存储于内网服务器;

若外部数据结构发生变动,则重新进行库表设计;若没发生变动,则将外部数据存储于外网数据库;

S3.5:对外网数据库进行同步以及数据抽取,最后将数据存储于内网服务器。

其中,S3.5中的数据抽取包括增量抽取和全量抽取。

10.根据权利要求9所述多渠道、快速的知识点收集系统,其特征在于,任务管理模块可实现以下任务管理步骤:

S4.1:设置至少一个线程进行数据采集;

S4.2:设定采集网页数和暂停的时间;

S4.3:启动线程;任意一个线程任务失败,则进行问题查找;并确认问题是否网站存在问题;若存在问题,则更换网址,并返回S4.2;若不存在问题,则重新启动该线程;直至数据采集结束。

与现有技术相比,本发明技术方案的有益效果是:本发明通过任务管理模块对知识点数据采集进行管理,通过多线程采集数据采集,有效的提供了知识点数据采集的效率。

附图说明

图1为实施例1所述多渠道、快速的知识点收集系统示意图。

图2为数据采集流程图。

图3为数据治理流程图。

图4为数据存储流程图。

图5为任务管理流程图。

具体实施方式

附图仅用于示例性说明,不能理解为对本专利的限制;

为了更好说明本实施例,附图某些部件会有省略、放大或缩小,并不代表实际产品的尺寸;

对于本领域技术人员来说,附图中某些公知结构及其说明可能省略是可以理解的。

下面结合附图和实施例对本发明的技术方案做进一步的说明。

实施例1

本实施例提供一种多渠道、快速的知识点收集系统,如图1所示,所述系统包括数据采集模块、数据治理模块、数据存储模块、任务管理模块;

数据采集模块负责网络知识点数据的采集,并将采集的数据发送给数据治理模块进行治理,数据治理模块对数据进行治理之后发送给数据存储模块进行存储;其中数据采集模块可实现多线程数据采集;

任务管理模块对实时数据和非实时数据,根据数据生成的时间进行数据采集任务的调度配置,以及指定采集各种任务或定时执行。

针对满足爬虫网络数据采集程序或者允许系统通过接口接入数据的业务系统,提供以下获取结构化数据定制解决方案;

本实施例所述数据采集模块通过定制网络数据采集程序,采取业务系统的特定功能页面中的工单、表格数据;

对于无法通过网络数据采集程序采集的数据,通过与业务系统定义接口的方式进行数据获取,本实施例只提供业务系统中可以在知识库系统中查询到的接口;

对于需要登陆系统进行权限认证的系统,需要提供相关账号密码来爬取数据,但在爬虫获得认证之后爬取时间超过系统最大登陆时长时可以自动获取认证不需要重新提供帐密。

如图2所示,数据采集模块可实现以下数据采集步骤:

S1.1:判断数据采集模块接入的数据是网络数据还是其他业务系统数据,若是其他业务系统数据,则执行S1.2,若是网络数据,则执行S1.4;

S1.2:判断该业务系统是否提供数据接口,若提供,则进行接口解析,并采集数据;若不提供接口,则执行S1.3;

S1.3:输入用户账号,并对用户账号进行验证,若验证不通过,则结束数据采集,若通过,则执行S1.4;

S1.4:读取URL(统一资源定位系统,uniform resource locator);

S1.5:下载并解析页面,进行数据采集,直至解析至最后一个页面。

当解析页面为HTML格式时执行正则表达式匹配或JSOUP解析匹配;

当解析页面为JSON格式时,执行JSON路径分析;

当解析界面为JS动态网页时,执行Phantom JS后端解析。

所述数据治理模块可执行数据清洗、数据解析、分组分析的操作。

数据清洗(Data Cleaning)的目的是检测数据中存在的错误和不一致,剔除或者改正它们,以提高数据质量。

数据清洗用来针对现有数据质量问题,对脏数据进行剔除或用估算值替代;对数据缺失进行自动化补全;细化指标计算范围。

数据解析用来实现数据标准化功能,通过用户定义的规则或者字典将原始数据中的特定属性的数据转变为统一的标准形式,使得数据规范化。根据指定资源格式(字段)的定义,进行数据库字段级别的采集。字段:各种资源的最小单位,譬如要采集某个网站的多个帖子,那么每个帖子可能包含以下字段:作者、标题、日期、内容等。

分组分析具体为:针对不同类型的数据采取不同的存储格式,对于文件类型的数据,将文件存储在服务器指定位置,然后对文件进行解析;网页类型的数据直接解析后存储到服务器中。

如图3所示,数据治理模块可实现以下数据治理步骤:

S2.1:爬取数据,并判断是否存在数据缺失、是否重复、是否离群;

S2.2:若存在数据缺失,则对缺失的数据进行数据填充,若不存在数据缺失,则进行多源数据匹配;

若存在数据重复,则对重复的数据进行数据删减,若不存在数据重复,则进行多源数据匹配;

若存在数据离群,则对离群的数据进行数据修正,若不存在数据离群,进行多源数据匹配;

S2.3:判断是否存在多源数据重复,若不存在,则结束数据治理;若存在,则进行关键字匹配,并进行数据去重,完成数据治理。

如图4所示,数据存储模块可实现以下数据存储步骤:

S3.1:对数据库进行库表设计;

S3.2:对外部数据和内部其他系统数据进行元数据存储;

S3.3:判断外部数据结构和内部其他系统数据结构是否发生变动;

S3.4:若内部其他系统数据结构发生变动,则重新进行库表设计;若没发生变动,则将数据存储于内网服务器;

若外部数据结构发生变动,则重新进行库表设计;若没发生变动,则将外部数据存储于外网数据库;

S3.5:对外网数据库进行同步以及数据抽取,最后将数据存储于内网服务器。

其中,S3.5中的数据抽取包括增量抽取和全量抽取。

本实施例所述任务管理模块主要针对实时数据和非实时数据,根据数据生成的时间进行数据采集任务的调度配置,可以指定采集等各种任务定时执行。

(1)可启用多个线程来完成同一个采集任务。

(2)可自由设定采集网页数和暂停的时间,此功能主要解决采集过快而被屏闭或禁止访问等问题。

(3)可以在采集当中随身暂停、启动或停止任务。

(4)针对抽取失败的网站进行日志记录,并进行原因分析,查找是由于网络问题或者是网站自身更改问题或者是其他原因导致。

(5)网络问题导致抽取失败,则需要查找网络原因,问题排查后第二天重新进行任务的启动抽取。

(6)网站失效原因导致抽取失败,则需要更换类似网站进行抽取地址重新配置。

(7)抽取工具原因抽取失败,重新启动抽取工具或设置第二天自动重新抽取。

如图5所示,任务管理模块可实现以下任务管理步骤:

S4.1:设置至少一个线程进行数据采集;

S4.2:设定采集网页数和暂停的时间;

S4.3:启动线程;任意一个线程任务失败,则进行问题查找,并保存日志记录;并确认问题是否网站存在问题;若存在问题,则更换网址,并返回S4.2;若不存在问题,则重新启动该线程;直至数据采集结束,并进行日志记录。

本实施例所述装置对外部网站采用更多的数据获取手段,包括某些网站的数据是动态生成的,也可以准确的获取到,同时对于内网网站也采用多种方式进行数据采集,大大提高了数据采集的多样性和全面性。

本实施例通过建立数据清洗流程,针对采集到的数据进行数据修正,尽量减少脏数据的存储空间,提高存储利用率,同时提高数据的准确性。

此外,针对电网调度特殊的服务器管理要求,按照其规定进行了数据的存储流程设置,确保数据能够正确存储和访问。

附图中描述位置关系的用语仅用于示例性说明,不能理解为对本专利的限制;

显然,本发明的上述实施例仅仅是为清楚地说明本发明所作的举例,而并非是对本发明的实施方式的限定。对于所属领域的普通技术人员来说,在上述说明的基础上还可以做出其它不同形式的变化或变动。这里无需也无法对所有的实施方式予以穷举。凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明权利要求的保护范围之内。

- 一种多渠道、快速的知识点收集系统

- 一种多渠道来料饰面人造板不良品快速溯源方法及其系统