一种基于记忆单元的孪生网络视觉跟踪方法

文献发布时间:2023-06-19 10:11:51

技术领域

本发明属于目标跟踪技术领域,具体涉及一种基于记忆单元的孪生网络视觉跟踪方法。

背景技术

在计算机视觉技术中目标跟踪技术扮演着举足轻重的角色,广泛的应用在智慧交通、安防、体育、医疗、机器人导航和人机交互等领域,具有巨大的商业价值。视觉跟踪要完成的任务是在一个图像序列中选择一个感兴趣的区域作为跟踪目标,在接下来的连续若干图像帧中获得准确的目标位置、具体形态和目标的运动轨迹等信息。从技术发展角度来说,视觉跟踪技术的研究可以分为三个阶段,在第一阶段,以卡尔曼滤波、均值滤波、粒子滤波及光流法为代表的经典跟踪方法;在第二阶段,以TLD模型为代表的基于检测的视觉跟踪方法,以CSK算法为代表的相关滤波类视觉跟踪方法;在第三个阶段,基于深度学习的视觉跟踪方法。但是在视觉跟踪任务中,只能使用第一张图像的目标标注信息,因而在训练的过程中缺乏足够的先验知识来保证跟踪模型的精度。此外视觉跟踪问题还面临着光照的变化、跟踪目标的严重遮挡、背景的混杂、目标的形态剧烈变化以及运动模糊等挑战。

基于孪生网络的视觉跟踪模型将跟踪问题转化成了图片块相似度匹配问题。孪生网络跟踪模型将目标模板图像和视频中当前帧对应的搜索图像作为网络的输入向量,通常搜索图像的面积较大些。两个张量经过骨干网络得到各自的特征,将目标模板对应的特征当作卷积核与搜索图片对应的特征进行交叉相关运算,最终得到一个相似性得分图,相似性得分图中最大值点所在位置就是视频当前帧中目标所在的位置。

然而在传统的孪生网络跟踪模型中,仅仅使用初始帧作为目标模板,模型在离线训练完成后就不再对模型的网络参数和目标模板进行更新。网络参数不更新意味着模型在遇到未见过的场景或目标时的跟踪性能会出现巨大滑坡,目标模板不更新将会在视频序列中的目标发生剧烈的外观变化或受到严重遮挡等情况时产生跟踪漂移问题,这些都会导致模型鲁棒性和跟踪精度的下降。

发明内容

针对传统的孪生网络跟踪模型中存在的问题,本发明从目标模板的更新角度入手,利用DWConv-LSTM记忆单元从时间和空间两个角度去解决目标模板的更新问题,能够在提高模型的鲁棒性的同时获得较好的跟踪准确率,具有相当的使用价值。

本发明的技术方案是,在跟踪模型中骨干网络采用基于残差的孪生网络,模型有两个分支,上边支路为目标模板分支,下边支路为搜索图像分支。在目标模板分支中,目标模板通过骨干网络和记忆单元两个模块获得目标的鲁棒特征;在搜索图像分支中,为适应跟踪过程中目标尺度变化,对搜索图像做多尺度处理得到三种不同尺度的搜索图像,这些搜索图像经过骨干网络提取特征。三种不同尺度的搜索图像对应的特征分别与目标模板对应的特征进行交叉相关运算,最终得到三个相似性得分图,找到三者中最优的特征图,目标的预测位置由该特征图上值最大的K个响应值的平均值决定。根据检出的目标位置获取新的目标模板,将获取的目标模板输入跟踪模型的目标模板分支,利用DWConv-LSTM记忆单元学习目标模板在时间和空间上的变化。

本发明的一种基于记忆单元的孪生网络视觉跟踪方法,具体步骤如下:

步骤1:搭建跟踪模型;

跟踪模型分为两个分支:分别是目标模板分支和搜索图像分支,目标模板分支由骨干网络和DWConv-LSTM记忆单元两个模块组成,搜索图像分支由骨干网络组成,两个分支的骨干网络是共享权值的基于残差模块搭建的孪生网络;

DWConv-LSTM记忆单元实质上为融合了深度可分离卷积操作的长短期记忆网络LSTM,传统的LSTM可以很好的描述时序信息,但内部采用全连接结构,这样使得LSTM学习到大量对描述时序无用的信息,并且不能像卷积操作那样刻画目标的空间特征信息;本发明采用深度可分离卷积代替LSTM中的全连接结构,使得记忆单元输出的目标模板特征既包含时序上的变化信息又包含空间上的特征信息;

步骤2:获取初始的目标模板特征F;

步骤2.1:初始的目标模板图像经过目标模板分支的骨干网络提取出特征e

步骤2.2:将c

步骤3:获取跟踪目标在视频当前帧中的对应位置;

步骤3.1:从视频当前帧中裁剪出搜索图像,获取多尺度的搜索图像对应的特征;

假设当前帧是视频的第t帧(t=1,2,3,…,n),从视频中的当前帧中裁剪出搜索图像S

步骤3.2:获取相似性得分图;

当前时刻的目标模板特征F与步骤3.1中得到的多尺度搜索图像对应的特征

步骤3.3:根据相似性得分图获取跟踪目标对应位置;

对集合r中的每一个相似性得分图进行上采样,得到上采样后的相似性得分图集合

步骤4:根据步骤3中找出的当前帧中跟踪目标所在位置裁剪出目标所在区域作为目标模板,将该目标模板输入跟踪模型的目标模板分支获取新的目标模板特征F;读取视频的下一帧作为当前帧,转入步骤3进行下一轮迭代,直至读取完视频中的所有帧结束迭代。

上述一种基于记忆单元的孪生网络视觉跟踪方法,其中:

所述步骤3中,初始时视频的第1帧作为当前帧,即第一轮迭代时t=1,之后在由步骤4转入步骤3进行下一轮迭代时,视频的下一帧作为当前帧,即此时t=t+1。

所述步骤4中,在更新目标模板特征F的过程中,DWConv-LSTM记忆单元会以上一次更新过程中DWConv-LSTM记忆单元输出的细胞单元c

本发明的收益为:

本发明在跟踪模型的目标模板分支添加的基于DWConv-LSTM的记忆单元可以学习目标在时间序列上的外观变化趋势,同时利用卷积网络也保证了目标在空间上的稳定性,能够有效应对视觉跟踪过程中的遮挡、背景的混杂和目标的形态剧烈变化等问题,提升了跟踪模型面对复杂环境时的跟踪鲁棒性,同时在记忆单元中使用深度可分离卷积进一步的加速了记忆单元,使得跟踪模型能够保证实时性,有重要应用价值。

附图说明

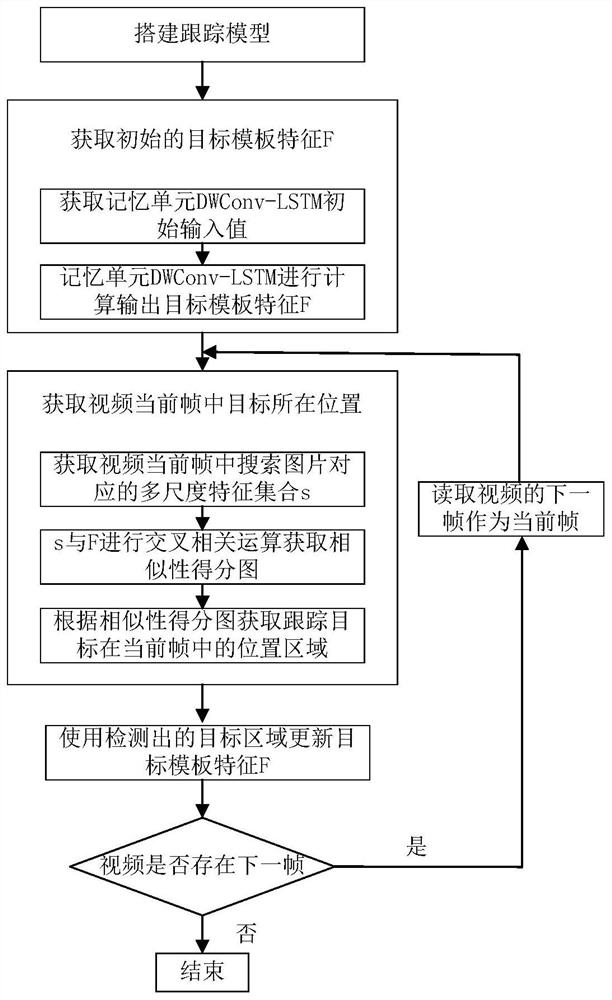

图1本发明的基于记忆单元的孪生网络视觉跟踪方法流程图。

图2本发明的跟踪模型整体架构图

图3本发明的DWConv-LSTM记忆单元的基本网络结构图。

图4本发明的目标模板图像的裁剪示例图。

图5本发明获取记忆单元初始的细胞单元和隐层状态过程示意图。

图6本发明在视频帧中裁剪多尺度的搜索图像示例图。

图7、8本发明具体实施例效果图。

具体实施方式

下面结合附图对本发明的具体实施方式做详细说明。

本实施方式的方法,算法实现采用TensorFlow深度学习框架,操作系统为Ubuntu16.04LTS。

如图1所示,一种基于记忆单元的孪生网络视觉跟踪方法,具体步骤如下:

步骤1:搭建跟踪模型;

如图2所示,跟踪模型分为目标模板分支和搜索图像分支两个分支,目标模板分支由骨干网络和DWConv-LSTM记忆单元两个模块组成,搜索图像分支由骨干网络组成,两个分支的骨干网络是共享权值的基于残差模块搭建的孪生网络;

DWConv-LSTM记忆单元的网络结构如图3所示,DWConv-LSTM记忆单元内部主要包含遗忘门f

细胞单元c

h

F=W

各个门的卷积运算都是使用深度可分离卷积实现,有助于捕获特征之间的空间关系并减少网络参数量从而加快前向推理的速度。

步骤2:获取初始的目标模板特征向量F;

步骤2.1:根据给定的待检测跟踪目标的宽w和高h,按照公式(8)计算出跟踪目标所在区域大小Z,其中,p表示扩充长度,按照公式(9)计算得到。如图4所示,在原图中以给定的待检测跟踪目标中心位置(cx,cy)为中心裁剪出边长为

Z=(w+2p)*(h+2p) (8)

p=(w+h)/4 (9)

步骤2.2:将c

步骤3:获取跟踪目标在视频当前帧中的对应位置;

步骤3.1:从视频当前帧中裁剪出搜索图像,获取多尺度搜索图像对应的特征;

假设当前帧是视频的第t帧(t=1,2,3,…,n),按照公式(10),计算出要裁剪的区域面积A={A

A

p′=(w+h)/4 (11)

步骤3.2:获取相似性得分图;

当前时刻的目标模板特征F与步骤3.1中得到的多尺度搜索图像对应的特征

步骤3.3:根据相似性得分图获取跟踪目标对应位置;

对集合r中的每一个相似性得分图进行上采样,得到上采样后的相似性得分图集合

步骤4:根据步骤3中找出的当前帧中跟踪目标所在位置裁剪出目标所在区域作为目标模板,将该目标模板输入跟踪模型的目标模板分支获取新的目标模板特征F,读取视频的下一帧作为当前帧,转入步骤3进行下一轮迭代,直至读取完视频中的所有帧结束迭代。

为检测本发明的有效性,这里挑选OTB100数据集中的Bird2视频序列进行测试,结果如图7所示,从示例中可以看出本发明能有效应对视频跟踪过程中的遮挡和形态变化等问题,具有很好的鲁棒性。这里又挑选一现实中的场景对本发明方法进行测试,采用与上述实施步骤相同的方法来跟踪目标,结果如图8所示,从示例中可以看出本发明能够很好的跟踪目标,具有一定的使用价值。

综上所述,基于记忆单元的孪生网络视觉跟踪方法在学习目标在时间序列上的外观变化趋势的同时又保证了目标在空间上稳定性,能够保证跟踪过程的实时性,提升了跟踪模型面对复杂环境时的跟踪鲁棒性。

- 一种基于记忆单元的孪生网络视觉跟踪方法

- 一种基于困难样本挖掘的孪生网络单目标视觉跟踪方法