一种保持分类一致性的预测方法及装置

文献发布时间:2023-06-19 10:16:30

技术领域

本发明属于互联网技术应用领域,特别涉及一种保持分类一致性的预测方法及装置。

背景技术

新闻分类中常常有多级分类,多级分类通常存在着层次依赖关系。 以两级分类为例。如果一级分类是游戏,二级分类可能会再次细分为网游、单机等等,如果一级分类是娱乐,二级分类可能是电影、八卦,明星等。然而,如果在对新闻进行分类时,如果第二级分类的预测和第一级分类的预测依赖关系错位,就导致了模型预测不一致问题,如一级分类预测是游戏,二级分类预测是电影。

现有技术一般是做一个级分类的模型,去预测一级分类。然后每个一级分类训练一个二级分类预测模型,以此类推。实际使用的时候,先做一级分类预测,然后再根据预测结果,使用相应的二级分类模型预测。这种方法需要训练很多模型,且模型数量随着分类层数和每层分类个数指数增长。训练和维护成本都很高。

例如在申请号为201910113211.9的分类模型的训练方法、装置、电子设备及存储介质中,提供了一种对于分类模型进行有效训练的方法,然而在这样的技术方案中,其核心点是把不分层的标签划分成分层依赖的的层次,然后逐层标签训练,其要解决的技术问题是利用上层标签输出的向量作为下层标签的输出,以提高下层标签的正确率,但是这样逐层训练的方式并不能解决一致性问题,而目前缺少一种能够实现一起训练,上层输出后查找依赖关系,来去对下层进行约束,输出是分了两层,但是训练是一次完成的控制方法,缺少一种能够解决上述技术问题的技术方案,具体地,缺少一种保持分类一致性的预测方法及装置。

发明内容

针对现有技术存在的技术缺陷,本发明的目的是提供一种保持分类一致性的预测方法及装置,根据本发明的一个方面,提供了一种保持分类一致性的预测方法,包括如下步骤:

a: 基于待预测样本的文本特征确定待预测样本文本特征的TOKEN编码向量,所述待预测样本的文本特征至少包括文本标题、文本内容以及文本来源;

b: 将所述待预测样本文本特征的TOKEN编码向量输入至预测模型Model以确定与待预测样本的文本特征相对应的一级分类以及与所述一级分类存在依赖关系的二级分类,所述依赖关系为上下位关系。

优选地,在所述步骤a中,所述待预测样本文本特征的TOKEN编码向量为对文本特征进行字级别的TOKEN编码所得到的向量。

优选地,所述预测模型Model通过如下方式建立:

i:基于Textcnn以及原始文本特征所对应的原始文本特征的TOKEN编码向量确定原始文本特征向量,所述原始文本特征至少包括文本标题、文本内容以及文本来源;

ii:基于MLP网络模型确定所述原始文本特征向量在一级分类中每个分类的评分ScoreVectorL1以及二级分类中每个分类的评分ScoreVectorL2;

iii:将基于所述ScoreVectorL1以及Softmax模型所确定的一级分类概率ProbVectorL1中概率最高的分类ClassL1作为一级分类的预测结果;

iv:在ClassMask依赖关系矩阵中确定所述ClassL1所在行的二级分类掩码MaskVector;

v:将所述MaskVector与所述ScoreVectorL2逐项相乘得到MaskedScoreVectorL2;

vi:将基于所述MaskedScoreVectorL2以及Softmax模型所确定的二级分类概率ProbVectorL2中概率最高的分类ClassL2作为二级分类的预测结果;

vii:将ProbVectorL1 和一级分类真实标签对比,ProbVectorL2 和二级标签真实值进行对比,一级分类交叉熵和二级分类交叉熵之和作为总Loss,利用梯度下降确定预测模型Model。

优选地,在所述步骤ii中,基于如下公式确定所述文本特征在一级分类中每个分类的评分ScoreVectorL1以及二级分类中每个分类的评分ScoreVectorL2:

其中,所述i的取值为0~m-1,m为一级分类或二级分类的个数。

优选地,所述步骤iii包括如下步骤:

iii1:将ScoreVectorL1输入至Softmax函数以确定每个一级分类的概率ProbVectorL1;

iii2:确定每个一级分类的概率ProbVectorL1中概率最高的分类ClassL1,并将其作为一级分类的预测结果。

优选地,所述Softmax函数为:

优选地,在所述步骤iv中,基于Embedding lookup函数确定所述ClassL1所在行的二级分类掩码MaskVector。

优选地,在所述步骤iv中,所述ClassMask依赖关系矩阵通过如下方式建立:

A:确定M-1个一级分类以及与所述一级分类存在依赖关系的N-1个二级分类;

B:基于所述M-1个一级分类以及所述N-1个二级分类生成一个M行N列的ClassMask依赖关系矩阵,其中,每一行为一个一级分类的Mask向量,每一列为所述一级分类是否包含二级分类的情况,其中,所述二级分类的情况至少包括0、1,1代表包含,0代表不包含。

优选地,在所述步骤v中,将所述MaskVector所对应的一级分类一致的二级分类保持原评分,而将不与所述MaskVector相对应的一级分类的二级分类清零。

优选地,所述步骤vi包括如下步骤:

vi1:将MaskedScoreVectorL2输入至Softmax模型以确定每个二级分类的概率ProbVectorL2;

vi2:确定每个二级分类的概率ProbVectorL2中概率最高的分类ClassL2,并将其作为二级分类的预测结果。

根据本发明的另一个方面,提供了一种保持分类一致性的预测装置,包括:

第一确定装置:基于待预测样本的文本特征确定待预测样本文本特征的TOKEN编码向量,所述待预测样本的文本特征至少包括文本标题、文本内容以及文本来源;

第二确定装置:将所述待预测样本文本特征的TOKEN编码向量输入至预测模型Model以确定与待预测样本的文本特征相对应的一级分类以及与所述一级分类存在依赖关系的二级分类,所述依赖关系为上下位关系。

优选地,还包括:

第三确定装置:基于Textcnn以及原始文本特征所对应的原始本文本特征的TOKEN编码向量确定原始文本特征向量,所述原始文本特征至少包括文本标题、文本内容以及文本来源;

第四确定装置:基于MLP网络模型确定所述原始文本特征向量在一级分类中每个分类的评分ScoreVectorL1以及二级分类中每个分类的评分ScoreVectorL2;

第一处理装置:将基于所述ScoreVectorL1以及Softmax模型所确定的一级分类概率ProbVectorL1中概率最高的分类ClassL1作为一级分类的预测结果;

第五确定装置:在ClassMask依赖关系矩阵中确定所述ClassL1所在行的二级分类掩码MaskVector;

第二处理装置:将所述MaskVector与所述ScoreVectorL2逐项相乘得到MaskedScoreVectorL2;

第三处理装置:将基于所述MaskedScoreVectorL2以及Softmax模型所确定的二级分类概率ProbVectorL2中概率最高的分类ClassL2作为二级分类的预测结果;

第四处理装置:将ProbVectorL1 和一级分类真实标签对比,ProbVectorL2 和二级标签真实值进行对比,一级分类交叉熵和二级分类交叉熵之和作为总Loss,利用梯度下降确定预测模型Model。

优选地,所述第一处理装置包括:

第五处理装置:将ScoreVectorL1输入至Softmax函数以确定每个一级分类的概率ProbVectorL1;

第六确定装置:确定每个一级分类的概率ProbVectorL1中概率最高的分类ClassL1,并将其作为一级分类的预测结果。

优选地,第五确定装置还包括:

第七确定装置:确定M-1个一级分类以及与所述一级分类存在依赖关系的N-1个二级分类;

第六处理装置:基于所述M-1个一级分类以及所述N-1个二级分类生成一个M行N列的ClassMask依赖关系矩阵,其中,每一行为一个一级分类的Mask向量,每一列为所述一级分类是否包含二级分类的情况,其中,所述二级分类的情况至少包括0、1,1代表包含,0代表不包含。

优选地,所述第三处理装置包括:

第七处理装置:将MaskedScoreVectorL2输入至Softmax模型以确定每个二级分类的概率ProbVectorL2;

第八确定装置:确定每个二级分类的概率ProbVectorL2中概率最高的分类ClassL2,并将其作为二级分类的预测结果。

本发明公开了一种保持分类一致性的预测方法,基于待预测样本的文本特征确定待预测样本文本特征的TOKEN编码向量,所述待预测样本的文本特征至少包括文本标题、文本内容以及文本来源;将所述待预测样本文本特征的TOKEN编码向量输入至预测模型Model以确定与待预测样本的文本特征相对应的一级分类以及与所述一级分类存在依赖关系的二级分类,所述依赖关系为上下位关系,本发明将一级分类以及二级分类一起训练,上层输出后查找依赖关系,进而去对下层进行约束,输出分两层,本发明在确定一级分类的预测结果的基础上,基于ClassMask依赖关系矩阵实现对于二级分类的预测,从而实现了训练的一次完成。本发明方法简单、流程便捷、预测精准、节约训练时间,具有极高的商业价值。

附图说明

通过阅读参照以下附图对非限制性实施例所作的详细描述,本发明的其它特征、目的和优点将会变得更明显:

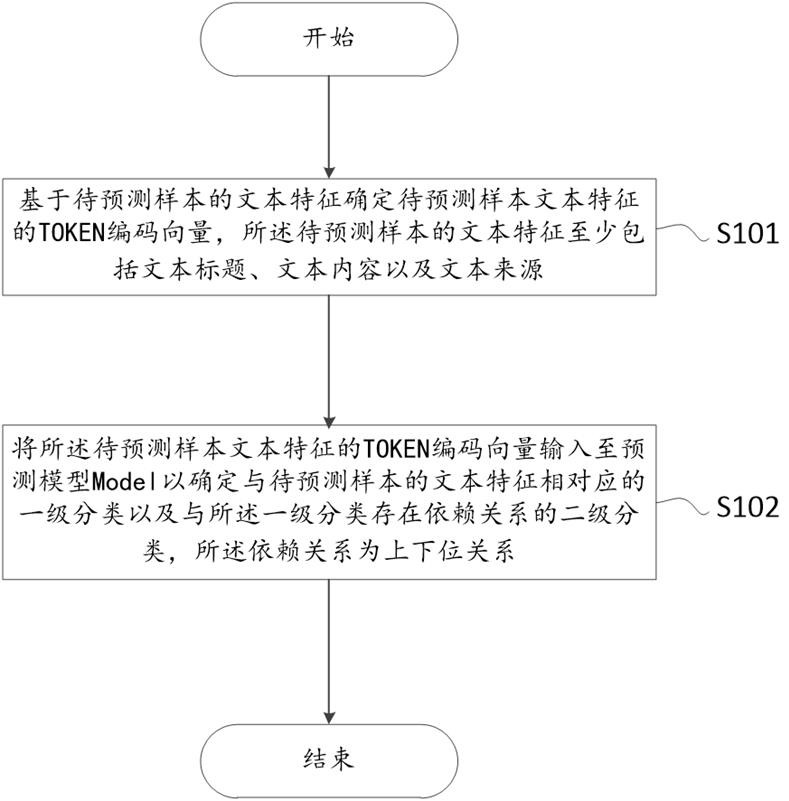

图1示出了本发明的具体实施方式的,一种保持分类一致性的预测方法的具体流程示意图;

图2示出了本发明的第一实施例的,一种预测模型Model建立的具体流程示意图;

图3示出了本发明的第二实施例的,将基于所述ScoreVectorL1以及Softmax模型所确定的一级分类概率ProbVectorL1中概率最高的分类ClassL1作为一级分类的预测结果的具体流程示意图;

图4示出了本发明的第三实施例的,所述ClassMask依赖关系矩阵建立的具体流程示意图;

图5示出了本发明的第四实施例的,将基于所述MaskedScoreVectorL2以及Softmax模型所确定的二级分类概率ProbVectorL2中概率最高的分类ClassL2作为二级分类的预测结果的具体流程示意图;

图6示出了本发明的本发明的另一具体实施方式的,一种保持分类一致性的预测装置的模块连接示意图;以及

图7示出了本发明的第五实施例的,一种保持分类一致性的预测方法的具体流程示意图。

具体实施方式

为了更好的使本发明的技术方案清晰的表示出来,下面结合附图对本发明作进一步说明。

图1示出了本发明的具体实施方式的,一种保持分类一致性的预测方法的具体流程示意图,进一步地,图1示出的一种保持分类一致性的预测方法其通过预测模型实现新闻内容上下位分类关系的一致性,包括如下步骤:

首先,进入步骤S101,基于待预测样本的文本特征确定待预测样本文本特征的TOKEN编码向量,所述待预测样本的文本特征至少包括文本标题、文本内容以及文本来源,本领域技术人员理解,基于所述待预测样本确定所述待预测样本的文本特征,所述待预测样本可以是任意新闻信息,但这样的新闻信息至少需要包括文本标题、文本内容以及文本来源,所述待预测样本文本特征的TOKEN编码向量为对文本特征进行字级别的TOKEN编码所得到的向量。

在这样的实施例中,所述待预测样本的文本特征的输入模型的是文本编号,即存在一个字典,将文本中的每个字编码成其在字典中的位置序号,所述文本标题、所述文本内容以及所述文本来源分别组成一个数字编号代表的向量,总共三个向量输入到文本中。进一步地,其中所述文本标题和所述文本来源最大为32位,不足的补0,多余的截断;而所述文本内容最大512位,不足的补0,多余的截断。

然后,进入步骤S102,将所述待预测样本文本特征的TOKEN编码向量输入至预测模型Model以确定与待预测样本的文本特征相对应的一级分类以及与所述一级分类存在依赖关系的二级分类,所述依赖关系为上下位关系,本领域技术人员理解,所述预测模型Model是本发明的核心技术实现,通过所述预测模型Model可以实现依赖关系为上下位关系的一级分类以及二级分类,进一步地,本发明将在后述的技术方案中具体介绍所述预测模型Model的建立,在此不予赘述。

需要理解的是,本发明旨在保护的是一种保持分类一致性的预测方法,虽然在权利要求及说明书中仅采用两级分类的上下位关系来进行预测,但本发明所需要保护的技术方案并不仅仅局限于此,具体地,可以用于预测三层级关系、四层级关系甚至更多,而在这样的实施例中,我们可以通过预测两两之间的上下位分类关系,从而得到多层级之间的分类关系,故通过本发明所记载的技术方案包括但不限于解决两层级上下位关系的分类预测,在此不予赘述。

图2示出了本发明的第一实施例的,一种预测模型Model建立的具体流程示意图,进一步地,所述预测模型Model通过如下方式建立:

首先,进入步骤S201,基于Textcnn以及原始文本特征所对应的原始本文本特征的TOKEN编码向量确定原始文本特征向量,所述原始文本特征至少包括文本标题、文本内容以及文本来源,本领域技术人员理解,参考步骤S101的相应做法,基于原始文本特征确定原始本文本特征的TOKEN编码向量,进一步地,基于Textcnn以及原始文本特征所对应的原始本文本特征的TOKEN编码向量确定原始文本特征向量,在步骤S101中,所述待预测样本的文本特征至少包括文本标题、文本内容以及文本来源,作为与之相对应的训练模型,同样需要训练这样的原始文本特征,即文本标题、文本内容以及文本来源,而在以后的技术实现中,可能会存在其他的训练参数,但这并不影响本发明的具体实施方案,在此不予赘述。Textcnn模型是由Yoon Kim提出的Convolutional Naural Networks for SentenceClassification一文中提出的使用卷积神经网络来处理NLP问题的模型,相比较nlp中传统的rnn/lstm等模型,cnn能更加高效的提取重要特征,这些特征在分类中占据着重要位置,其是一种利用卷积神经网络对文本进行分类的算法。

然后,进入步骤S202,基于MLP网络模型确定所述原始文本特征向量在一级分类中每个分类的评分ScoreVectorL1以及二级分类中每个分类的评分ScoreVectorL2,在所述步骤S202中,将Textcnn提取出的高维向量,转换到与一级分类一致的向量,具体地,基于如下公式确定所述文本特征在一级分类中每个分类的评分ScoreVectorL1以及二级分类中每个分类的评分ScoreVectorL2:

其中,所述i的取值为0~m-1,m为一级分类或二级分类的个数。

紧接着,进入步骤S203,将基于所述ScoreVectorL1以及Softmax模型所确定的一级分类概率ProbVectorL1中概率最高的分类ClassL1作为一级分类的预测结果,具体地,将ScoreVectorL1输入至Softmax函数以确定每个一级分类的概率ProbVectorL1,然后确定每个一级分类的概率ProbVectorL1中概率最高的分类ClassL1,并将其作为一级分类的预测结果,这些将在后述的具体实施方式中作进一步的描述。

再然后,进入步骤S204,在ClassMask依赖关系矩阵中确定所述ClassL1所在行的二级分类掩码MaskVector,所述ClassMask依赖关系矩阵为基于大数据建立的矩阵模型,本步骤的深度学习利有现成的Embedding lookup函数,即根据输入的数字,取矩阵中对应行的向量,即在所述步骤S204中,基于Embedding lookup函数确定所述ClassL1所在行的二级分类掩码MaskVector。

在执行完步骤S204后,执行步骤S205,将所述MaskVector与所述ScoreVectorL2逐项相乘得到MaskedScoreVectorL2,在这样的实施例中,所述MaskVector基于步骤S204得到,而所述ScoreVectorL2则可以根据步骤S202得到,在所述步骤S205中,将所述MaskVector所对应的一级分类一致的二级分类保持原评分,将不与所述MaskVector相对应的一级分类的二级分类清零。本步骤的目的是为了确定二级分类的预测结果而执行的中间运算。

紧接着,执行步骤S206,将基于所述MaskedScoreVectorL2以及Softmax模型所确定的二级分类概率ProbVectorL2中概率最高的分类ClassL2作为二级分类的预测结果,在这样的实施例中,将MaskedScoreVectorL2输入至Softmax模型以确定每个二级分类的概率ProbVectorL2;然后确定每个二级分类的概率ProbVectorL2中概率最高的分类ClassL2,并将其作为二级分类的预测结果,而这些也将在后述的具体实施方式中作进一步的描述,而结合步骤S201至步骤S206可以发现,本发明虽然进行了两次输出,但都是基于同一训练模型而生成一级分类的预测结果以及二级分类的预测结果,而这样的实现方式将大大提高并保证分类的一致性。

最后,执行步骤S207,所述步骤S207将用到步骤S203中确定的一级分类的预测结果以及步骤S206中确定的二级分类的预测结果,具体地,将ProbVectorL1 和一级分类真实标签对比,ProbVectorL2 和二级标签真实值进行对比,一级分类交叉熵和二级分类交叉熵之和作为总Loss,利用梯度下降确定预测模型Model。

图3示出了本发明的第二实施例的,将基于所述ScoreVectorL1以及Softmax模型所确定的一级分类概率ProbVectorL1中概率最高的分类ClassL1作为一级分类的预测结果的具体流程示意图,在这样的实施例中,所述图3即为步骤S203的详细描述,具体地,包括:

首先,进入步骤S2031,将ScoreVectorL1输入至Softmax函数以确定每个一级分类的概率ProbVectorL1,在这样的实施例中,所述ScoreVectorL1为一级分类中每个分类的评分,将一级分类中每个分类的评分依次输入到Softmax函数中,进而确定每个一级分类的概率ProbVectorL1,这里的ProbVectorL1为多个一级分类的概率。

最后,进入步骤S2032,确定每个一级分类的概率ProbVectorL1中概率最高的分类ClassL1,并将其作为一级分类的预测结果,在这样的实施例中,ProbVectorL1中多个一级分类的概率有很多,例如,娱乐、体育、人文等等,而选取的是这些概率中最高的一个一级分类,并将其作为ClassL1。

进一步地,所述Softmax函数为:

图4示出了本发明的第三实施例的,所述ClassMask依赖关系矩阵建立的具体流程示意图,在这样的实施例中,所述图4即为步骤S204的详细描述,具体地,在所述步骤S204中,所述ClassMask依赖关系矩阵通过如下方式建立:

首先,进入步骤S2041:确定M-1个一级分类以及与所述一级分类存在依赖关系的N-1个二级分类,在这样的实施例中,彼此间存在依赖关系的一级分类与二级分类可以是基于训练模型长期训练而得出的训练结果,也可以是人为进行划分的常识性上下位关系,例如,娱乐包括音乐、电影、电台等等。

最后,进入步骤S2042,基于所述M-1个一级分类以及所述N-1个二级分类生成一个M行N列的ClassMask依赖关系矩阵,其中,每一行为一个一级分类的Mask向量,每一列为所述一级分类是否包含二级分类的情况,其中,所述二级分类的情况至少包括0、1,1代表包含,0代表不包含,在本申请所采用的ClassMask依赖关系矩阵中,若存在一个Mask向量为第i行,第j列,则带编号为i的一级分类和编号为j的二级分类可以确定是否为上下位关系,值为1代表一致,值为0代表不一致,一个二级分类和一个一级分类上下位关系是根据训练样本确定的,或者认为指定的,即如果训练样本中的分类标签本来就存在一致的上下位关系,直接从样本中提取就可以了,如果不存在,就要人为分级,然后指定上下位依赖关系。

图5示出了本发明的第四实施例的,将基于所述MaskedScoreVectorL2以及Softmax模型所确定的二级分类概率ProbVectorL2中概率最高的分类ClassL2作为二级分类的预测结果的具体流程示意图,进一步地,所述步骤S206包括如下步骤:

首先,进入步骤S2061,将MaskedScoreVectorL2输入至Softmax模型以确定每个二级分类的概率ProbVectorL2,本步骤的具体实现可以参考前述步骤S2031至步骤S2032中ProbVectorL1的确定。

最后,进入步骤S2062,确定每个二级分类的概率ProbVectorL2中概率最高的分类ClassL2,并将其作为二级分类的预测结果,结合步骤S2032中的实施例中的一级分类为娱乐、体育、人文等等,而对于体育而言,又分为篮球、足球、羽毛球、乒乓球等等,本步骤的目的在于确定在ProbVectorL2中概率最高的分类ClassL2。

图6示出了本发明的本发明的另一具体实施方式的,一种保持分类一致性的预测装置的模块连接示意图,本发明所提供的保持分类一致性的预测装置包括第一确定装置1:基于待预测样本的文本特征确定待预测样本文本特征的TOKEN编码向量,所述待预测样本的文本特征至少包括文本标题、文本内容以及文本来源,所述第一确定装置1的工作原理可以参考前述步骤S101,在此不予赘述。

所述预测装置还包括第二确定装置2:将所述待预测样本文本特征的TOKEN编码向量输入至预测模型Model以确定与待预测样本的文本特征相对应的一级分类以及与所述一级分类存在依赖关系的二级分类,所述依赖关系为上下位关系,所述第二确定装置2的工作原理可以参考前述步骤S102,在此不予赘述。

进一步地,还包括第三确定装置21:基于Textcnn以及原始文本特征所对应的原始本文本特征的TOKEN编码向量确定原始文本特征向量,所述原始文本特征至少包括文本标题、文本内容以及文本来源,所述第三确定装置21的工作原理可以参考前述步骤S201,在此不予赘述。

进一步地,还包括第四确定装置22:基于MLP网络模型确定所述原始文本特征向量在一级分类中每个分类的评分ScoreVectorL1以及二级分类中每个分类的评分ScoreVectorL2,所述第四确定装置22的工作原理可以参考前述步骤S202,在此不予赘述。

进一步地,还包括第一处理装置23:将基于所述ScoreVectorL1以及Softmax模型所确定的一级分类概率ProbVectorL1中概率最高的分类ClassL1作为一级分类的预测结果,所述第一处理装置23的工作原理可以参考前述步骤S203,在此不予赘述。

进一步地,还包括第五确定装置24:在ClassMask依赖关系矩阵中确定所述ClassL1所在行的二级分类掩码MaskVector,所述第五确定装置24的工作原理可以参考前述步骤S204,在此不予赘述。

进一步地,还包括第二处理装置25:将所述MaskVector与所述ScoreVectorL2逐项相乘得到MaskedScoreVectorL2,所述第二处理装置25的工作原理可以参考前述步骤S205,在此不予赘述。

进一步地,还包括第三处理装置26:将基于所述MaskedScoreVectorL2以及Softmax模型所确定的二级分类概率ProbVectorL2中概率最高的分类ClassL2作为二级分类的预测结果,所述第三处理装置26的工作原理可以参考前述步骤S206,在此不予赘述。

进一步地,还包括第四处理装置27:将ProbVectorL1 和一级分类真实标签对比,ProbVectorL2 和二级标签真实值进行对比,一级分类交叉熵和二级分类交叉熵之和作为总Loss,利用梯度下降确定预测模型Model,所述第四处理装置27的工作原理可以参考前述步骤S207,在此不予赘述。

进一步地,所述第一处理装置23包括第五处理装置231:将ScoreVectorL1输入至Softmax函数以确定每个一级分类的概率ProbVectorL1,所述第五处理装置231的工作原理可以参考前述步骤S2031,在此不予赘述。

进一步地,所述第一处理装置23包括第六确定装置232:确定每个一级分类的概率ProbVectorL1中概率最高的分类ClassL1,并将其作为一级分类的预测结果,所述第六确定装置232的工作原理可以参考前述步骤S2032,在此不予赘述。

进一步地,第五确定装置24还包括第七确定装置241:确定M-1个一级分类以及与所述一级分类存在依赖关系的N-1个二级分类,所述第七确定装置241的工作原理可以参考前述步骤S2041,在此不予赘述。

进一步地,第五确定装置24还包括第六处理装置242:基于所述M-1个一级分类以及所述N-1个二级分类生成一个M行N列的ClassMask依赖关系矩阵,其中,每一行为一个一级分类的Mask向量,每一列为所述一级分类是否包含二级分类的情况,其中,所述二级分类的情况至少包括0、1,1代表包含,0代表不包含,所述第六处理装置242的工作原理可以参考前述步骤S2042,在此不予赘述。

进一步地,所述第三处理装置26包括第七处理装置261:将MaskedScoreVectorL2输入至Softmax模型以确定每个二级分类的概率ProbVectorL2,所述第七处理装置261的工作原理可以参考前述步骤S2061,在此不予赘述。

进一步地,所述第三处理装置26包括第八确定装置262:确定每个二级分类的概率ProbVectorL2中概率最高的分类ClassL2,并将其作为二级分类的预测结果,所述第八确定装置262的工作原理可以参考前述步骤S2062,在此不予赘述。

图7示出了本发明的第五实施例的,一种保持分类一致性的预测方法的具体流程示意图,结合图7本发明提出一种一致性预测方法,可以一个模型同时完成多级标签的预测,并且确保多级标签的一致。

如图7所示,在图7中存在数值与字符相对应的编码字典,例如,数值“1”对应字符“二”,数值“2”对应字符“三”,数值“3”对应字符“四”,数值“4”对应字符“种”,数值“5”对应字符“,”,数值“6”对应字符“新”,数值“7”对应字符“一”,数值“8”对应字符“最”,数值“9”对应字符“近”,以此类推,此为目前较为常见的现有技术,在此不予赘述。

作为本发明的另一个技术实现,以二级标签为例:1、对一级标签和二级标签进行顺序编码,将一级标签映射到0 ~ M-1, 二级标签映射到 0 ~ N-1,M为一级标签个数,N为二级标签个数。2、根据训练样本中标签的依赖关系以及标签的编码,生成一个M行N列的标签依赖关系矩阵,记为ClassMask。每一行代表一个一级标签的mask向量,每一列代表一级标签包含的二级标签情况, 1代表包含,0代表不包含,向量仅包含0,1两个值。3、使用深度神经网络对分类问题进行建模,模型设计如下:

(1)用textcnn 提取新闻的文本特征,生成新闻的特征向量;

(2) 将特征向量通过一层MLP生成一级分类每个分类的评分,记为ScoreVectorL1(向量),同时也将特征向量通过一层MLP生成二级分类每个分类的评分,记为ScoreVectorL2(向量);

(3) 将ScoreVectorL1 进行softmax, 得到每个一级分类的概率, 记为probVectorL1;

(4) 将probVectorL1中最大的分类对应的编号输出, 记为classL1, 即为一级分类的预测结果;

(5) 取 ClassMask,的classL1 行得到目前classL1的二级分类掩码MaskVector, 代表当前输出的一级分类允许输出的二级分类;

这一步,根据ClassMask和classL1 生成MaskVector 是利用深度学习的,embedding的机制实现的。将ClassMask作为embedding层权重的初始化权重,并将embedding设置为不可训练;

(6)将mask_vecto 和ScoreVectorL2逐项相乘得到MaskedScoreVectorL2 , 其中仅和一级分类一致的二级分类保持原评分,其余二级分类评分被清0;

(7)MaskedScoreVectorL2 进行softmax,得到每个二级分类的概率,记为probVectorL2;

(8)将probVectorL2中最大的分类对应的编号输出, 记为classL2, 即为二级分类的预测结果;

(9)将probVectorL1 和一级分类真实标签对比, probVectorL2 和二级标签真实值进行对比,一级分类交叉熵和二级分类交叉熵之和作为总loss,利用梯度下降,训练模型得到一个训练好的模型模型结尾Model;

(10)将新的文本特征输入Model1, 获取其classL1和classL2 的输出记为预测的一级分类编号和二级分类编号。此时,一级分类和二级分类编号完全一致。

需要说明的是,上述各装置实施例的具体实施方式与前述对应方法实施例的具体实施方式相同,在此不再赘述。综上所述,本发明的技术方案为用户提供了一种保持分类一致性的预测方法,本发明将一级分类以及二级分类一起训练,上层输出后查找依赖关系,进而去对下层进行约束,输出分两层,节约了资源并提高了效率。

在此提供的算法和显示不与任何特定计算机、虚拟装置或者其它设备固有相关。各种通用装置也可以与基于在此的示教一起使用。根据上面的描述,构造这类装置所要求的结构是显而易见的。此外,本发明也不针对任何特定编程语言。应当明白,可以利用各种编程语言实现在此描述的本发明的内容,并且上面对特定语言所做的描述是为了披露本发明的最佳实施方式。

在此处所提供的说明书中,说明了大量具体细节。然而,能够理解,本发明的实施例可以在没有这些具体细节的情况下实践。在一些实施例中,并未详细示出公知的方法、结构和技术,以便不模糊对本说明书的理解。

类似地,应当理解,为了精简本发明并帮助理解各个发明方面中的一个或多个,在上面对本发明的示例性实施例的描述中,本发明的各个特征有时被一起分组到单个实施例、图、或者对其的描述中。然而,并不应将该公开的方法解释成反映如下意图:即所要求保护的本发明要求比在每个权利要求中所明确记载的特征更多的特征。更确切地说,如下面的权利要求书所反映的那样,发明方面在于少于前面公开的单个实施例的所有特征。因此,遵循具体实施方式的权利要求书由此明确地并入该具体实施方式,其中每个权利要求本身都作为本发明的单独实施例。

此外,本领域技术人员理解,尽管在此所述的一些实施例包括其它实施例中所包括的某些特征而不是其它特征,但是不同实施例的特征的组合意味着处于本发明的范围之内并且形成不同的实施例。例如,在权利要求书中,所要求保护的实施例的任意之一都可以以任意的组合方式来使用。

本发明的各个部件实施例可以以硬件实现,或者以在一个或者多个处理器上运行的软件模块实现,或者以它们的组合实现。本领域技术人员理解,可以在实践中使用微处理器或者数字信号处理器(DSP)来实现装置中的一些或者全部部件的一些或者全部功能。本发明还可以实现为用于执行这里所描述的方法的一部分或者全部的设备或者装置程序(例如,计算机程序和计算机程序产品)。这样的实现本发明的程序可以存储在计算机可读介质上,或者可以具有一个或者多个信号的形式。这样的信号可以从因特网网站上下载得到,或者在载体信号上提供,或者以任何其他形式提供。

应该注意的是上述实施例对本发明进行说明而不是对本发明进行限制,并且本领域技术人员在不脱离所附权利要求的范围的情况下可设计出替换实施例。在权利要求中,不应将位于括号之间的任何参考符号构造成对权利要求的限制。词语“包含”不排除存在未列在权利要求中的元件或步骤。位于元件之前的单词“一”或“一个”不排除存在多个这样的元件。本发明可以借助于包括有若干不同元件的硬件以及借助于适当编程的计算机来实现。在列举了若干装置的单元权利要求中,这些装置中的若干个可以是通过同一个硬件项来具体体现。单词第一、第二、以及第三等的使用不表示任何顺序。可将这些单词解释为名称。

以上对本发明的具体实施例进行了描述。需要理解的是,本发明并不局限于上述特定实施方式,本领域技术人员可以在权利要求的范围内做出各种变形或修改,这并不影响本发明的实质内容。

- 一种保持分类一致性的预测方法及装置

- 一种图像分类方法、训练方法、分类预测方法及相关装置