一种基于3D卷积的深度补全方法

文献发布时间:2023-06-19 11:14:36

技术领域

本发明涉及基于深度学习的深度补全方法,尤其涉及一种基于3D卷积的深度补全方法。

背景技术

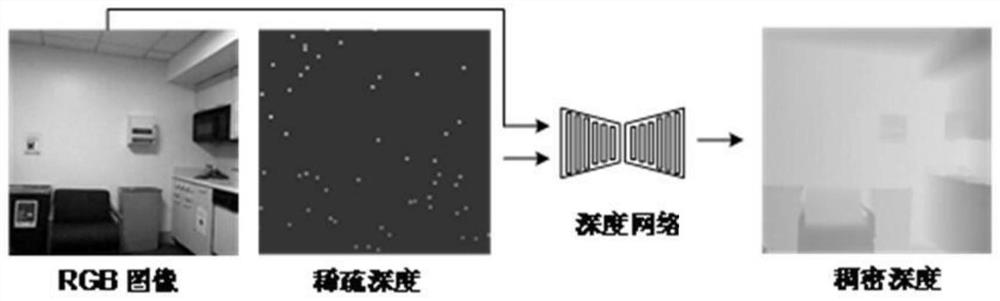

近年来,随着计算机视觉在自主驾驶、机器人、运动规划和增强现实等领域的迅速发展,深度估计已成为一个研究热点。然而,各种传感器主要包括RGB相机、基于结构光的传感器(如RGB-D相机)和激光雷达,都有其自身的局限性,影响了深度图的可靠性。例如,激光雷达只为远距离目标提供稀疏的点云数据。商用的RGB-D相机,当表面透明、有光泽、太远或太近时会产生大量丢失的像素。为了克服这些局限性,已有许多研究利用给定的稀疏深度测量来获得一个密集的深度图,称为深度补全。

早期的深度补全工作一般只基于稀疏测量,其估计结果容易产生不必要的模糊和混合深度问题。由于RGB图像包含了丰富的纹理和颜色信息,近年来许多研究都以RGB 图像为指导来预测精确的密集深度图。在近些年的深度补全研究中,稀疏深度图被视为一个附加通道,并与RGB图像一起送入网络。一些研究通过有效的卷积空间传播网络学习用于深度预测的稀疏亲和矩阵。在之前的一些研究中还有使用双流式网络处理RGB 和稀疏深度图像,以进一步挖掘输入的潜力。这些工作表明,附加模态数据可以提高预测性能。然而,这些多模态数据融合和特征提取只是在空间层面上进行的。与视频数据处理类似,3D卷积用于学习时空特征,而在2D卷积中,它们仅在空间上进行,在输入信号包含RGB图像和稀疏深度信息时,2D卷积无法保留其模态信息。虽然已有研究者将三维卷积应用于雷达点云数据处理,但在多模数据融合阶段仍采用2D卷积。

发明内容

发明目的:针对以上问题,本发明提出一种基于3D卷积的深度补全方法,利用3D卷积的方法进行模态特征的学习,在以往的二维卷积方法中模态特征的学习是缺失的,而通过3D卷积的方法能够充分挖掘数据信息,有效提高深度补全的精度。

技术方案:为实现本发明的目的,本发明所采用的技术方案是:一种基于3D卷积的深度补全方法,包括以下步骤:

(1)对RGB图像进行特征提取;

所述对RGB图像进行特征提取方法表示为:

选取像素点并设置阈值,之后找到一该点为圆心的半径为3的圆上的16个像素点,选择FAST-12方式完成特征点的判定,再对每个点进行以上的判定,完成特征的提取;

(2)生成稀疏深度测量S,对于多源多模态数据进行数据融合,作为深度学习的先验信息,对个网络进行训练;

所述的对多源多模态数据进行数据融合,生成多模态融合数据,具体方法是:

对于多源多模态数据,首先完成坐标系的统一,将不同传感器的测量结果通过下述公式进行统一:

X

公式中的X

同时还需要完成通过针孔相机模型将X

u=Kx

其中K表示相机内参矩阵,f

而生成稀疏深度测量S,则通过在深度图像D

其中temp是区间[0,1]中的随机数,对于每个像素应用此操作,生成稀疏深度测量S,最后将RGB 图像与稀疏深度测量S,组成多模态融合数据RGBS,同时作为深度学习的先验信息,对神经网络进行训练;

(3)通过随机变换以在线方式增加训练数据;

(4)模态特征提取;

针对输入信号包含RGB图像和稀疏深度的多模态信息,且2D卷积操作无法保留其模态信息的问题,本发明李颖3D卷积对RGB图像和稀疏深度进行特征融合,在网络对输入数据进行特征提取的同时保留其模态特征,以充分挖掘数据信息提高深度补全的精度。其中标准的三维卷积计算公式如下:

其中

作为本发明进一步改进,步骤(3)通过随机变换以在线方式增加训练数据:

e)尺度变换:对彩色图像和稀疏深度按随机数s∈[1,1.15],利用双线性插值进行放大;

f)随机裁剪:将尺度变换后的RGB图像和深度随机裁剪,使其与输入大小一致;

g)颜色调整:对彩色图像的亮度,对比度和饱和度均按k

h)颜色标准化:彩色图像通过平均减法和除以标准偏差进行归一化。

本发明的有益效果是:

本发明针对输入信号包含RGB图像和稀疏深度的多模态信息时,2D卷积神经网络无法保留其模态信息的问题,提出了一种基于3D卷积的神经网络,该网络能够充分利用输入信息中的RGB图像信息与稀疏深度信息,在对输入信息进行特征提取的同时,能够保留其模态特征,将稀疏深度信息与RGB图像信息进行充分的特征融合,从而充分的挖掘数据信息,提高了深度估计的精度。

附图说明

图1是基于卷积神经网络的深度补全方法技术方案流程图;

图2是2D卷积神经网络与3D卷积神经网络的模态特征提取图;

图3是使用Unet架构将原有的ConvBlock推广到了ResBlock示意图;

图4是Unet2D和Unet3D在KITTI深度补全数据集上的预测效果对比图。其中(a)RGB图像;(b)稀疏深度图;(c)真值;(d)Unet2D预测效果图;(e)Unet3D-LwBLwC预测效果图;(f)Unet3D预测效果图。

具体实施方式

下面结合附图和实施例对本发明的技术方案作进一步的说明,应理解下述具体实施方式仅用于说明本发明而不用于限制本发明的范围。

本发明使用室内数据集NYUv2和室外数据集KITTI作为我们的实验数据,对本发明提出的基于3D卷积的深度补全方法进行了实验验证。实验平台包括Pytorch0.4.1,Python3.6,Ubuntu16.04和12GB内存的GPUNVIDIA TiTanV,NYUv2数据集,是由 Kinect采集的高质量480×640RGB和深度数据组成。根据官方对数据的拆分,有249 个场景包含26331张图片用于训练,215个场景包含654张图片用于测试。KITTI测绘数据集由22个序列组成,包括相机和激光雷达测量。双目RGB相机共46000张训练序列图像用于训练阶段,3200张测试序列图像用于测试阶段。原有的NYUv2图像被下采样成224*224的大小,而KITTI测绘图像由于GPU内存的限制被裁剪成224*336。

对于实验的评估指标,我们采用了以下几个常用指标:

本次实验按照数据集的不同分为两个部分,第一部分的实验中,在NYUv2数据集上,采用了相同的稀疏采样策略,采取了200个稀疏样本进行实验,为验证3D卷积的深度补全方法的性能,这里使用了著名的Unet架构,并进一步将原有的ConvBlock推广到了ResBlock如图3所示,同时设计了一个与本发明提出的方法具有相似参数大小的Unet-Wide体系结构。这旨在确保3D卷积相关的性能改进不仅仅是由于参数的增加而导致的。实验中包含三组:具有标准2D卷积架构的Unet架构(Unet2D)、具有标准2D 卷积的Unet宽架构(UnetWide2D)和具有标准3D卷积的Unet架构(Unet3D)。所有卷积层使用尺寸为3*3的二维核或尺寸为3*3*3的三维核。实验结果如表1所示。

第二部分实验中将模态特征学习扩展到室外RGB-LiDAR数据集上,在接下来的实验中使用了与Resblock相同的网络。使用了KITTI深度补全基准的官方误差指标,包括MAE、RMSE、iMAE和iRMSE。结果列于表2。

表1:NYUV2数据集上使用CONVBLOCK和RESBLOCK完成UNET2D,UNETWIDE2D和UNET3D的深度估计精度对比

表2:在KITTI深度补全数据集上使用RESBLOCK完成UNET2D和UNET3D的深度完成

由表1可见,UnetWide2D始终优于Unet2D。这一改进归因于UnetWide2D中参数数目较多,对于两个最常用的块,Unet3D比Unet2D和UnetWide2D都获得了显著的性能增益。这个实验也验证了三维卷积在多模态特征提取和学习中的有效性,并且证明了 3D卷积相关的性能改进不仅仅是由于参数的增加而导致的。

由表2可见,在室外RGB激光雷达数据集的情况下,3D卷积仍然表现良好。与相同参数大小的Unet2D相比,可以看出,3D卷积可以提取和学习2D卷积中通常忽略的模态特征。图4显示了Unet2D和Unet3D在KITTI深度补全数据集上的预测效果,突出显示了具有挑战性的区域,与Unet2D相比,Unet3D借助3D卷积在这些区域实现了更清晰的边界。

以上所述,仅是本发明的较佳实施例而已,并非是对本发明作任何其他形式的限制,而依据本发明的技术实质所作的任何修改或等同变化,仍属于本发明所要求保护的范围。

- 一种基于3D卷积的深度补全方法

- 基于深度卷积特征和语义近邻的多标签图像补全方法