一种基于对抗网络和多尺度密集特征融合图像去雾方法

文献发布时间:2023-06-19 11:22:42

技术领域

本发明涉及图像处理技术领域,尤其涉及一种基于对抗网络和多尺度密集特征融合图像去雾方法。

背景技术

经检索,中国专利号CN102930514A公开了基于大气物理散射模型的快速图像去雾方法,该发明虽然能够通过大气物理散射模型进行图像去雾,但去雾不自然且存在噪声;近几年,我国城市中的雾霾天气逐渐增多,景物发出的光经过雾霾到达相机的感光元件时强度会被衰减,加上雾霾对光的散射作用,相机成像的效果受到了极大的影响,基于图像分析的计算机视觉技术已经在军事国防、人工智能和自动控制等领域有了广泛的应用,因此需要有效的图像去雾技术作为计算机视觉应用的前处理过程,以减少或消除雾霾的影响,在广泛采用的雾霾图像成像模型中,大气光照强度,景物的透射率,以及要复原的图像皆为未知量,而唯一已知为相机获取的雾霾图像,因此单幅图像去雾问题在数学上是一个不适定问题,图像去雾的关键问题是得到雾霾图像的透射率图像,而透射率又是图像深度的函数,为了解决这个不适定问题,图像去雾终于方法主要分为基于先验知识的去雾方法和基于深度学习的去雾方法,这些方法都基本采用通用的网络结构,但这些结构存在着一些局限性;因此,发明出一种基于对抗网络和多尺度密集特征融合图像去雾方法变得尤为重要;

现有的图像去雾方法,大多采用通用的网络结构,这些结构往往仅利用相对较浅网络的低级局部特征,然而在有限的感受野下高级语义信息很难被低级特征进行编码,进而容易导致图像去雾不自然且存在噪声;为此,我们提出一种基于对抗网络和多尺度密集特征融合图像去雾方法。

发明内容

本发明的目的是为了解决现有技术中存在的缺陷,而提出的一种基于对抗网络和多尺度密集特征融合图像去雾方法。

为了实现上述目的,本发明采用了如下技术方案:

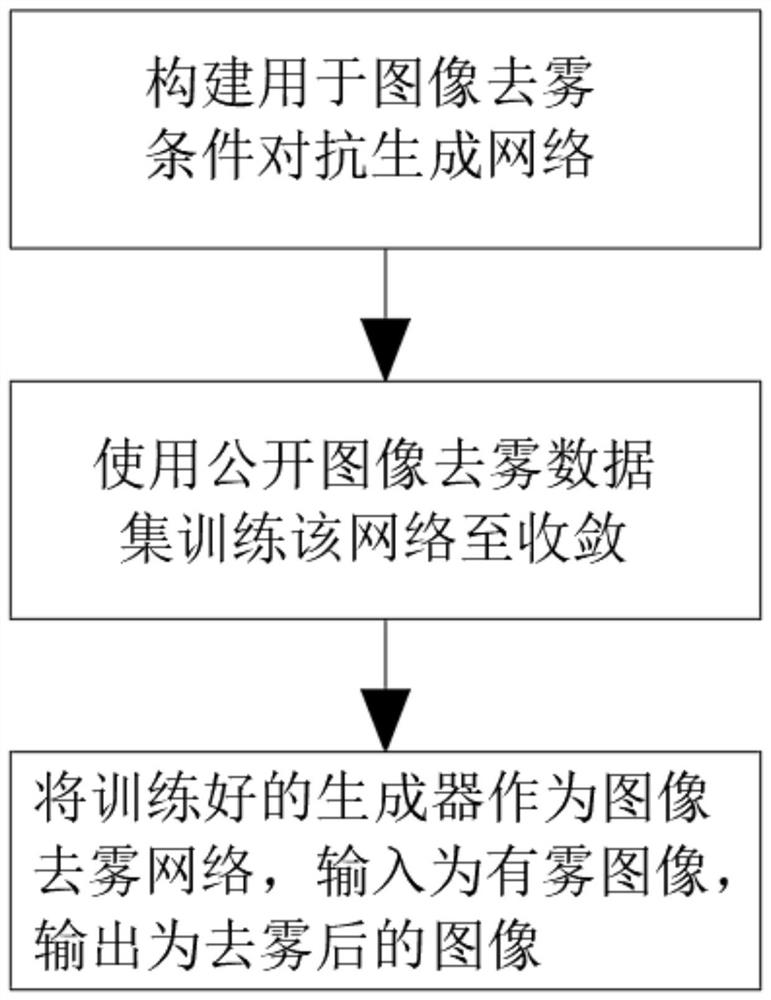

一种基于对抗网络和多尺度密集特征融合图像去雾方法,该去雾方法具体步骤如下:

(1)构建用于图像去雾条件对抗生成网络;

(2)使用公开图像去雾数据集训练该网络至收敛;

(3)将训练好的生成器网络作为图像去雾网络,输入为有雾图像,输出为去雾后的图像。

进一步地,步骤(1)所述条件对抗生成网络包括生成器网络、判别器网络和总体目标函数。

进一步地,所述生成器网络的结构设计基于U-Net结构,其包括编码模块、解码模块和特征恢复模块三部分组成,所述括编码模块设置有编码器,且集成有残差密集块RDB模块和基于反投影技术的DFF模块,所述解码模块设置有解码器;所述生成器网络具体运行过程如下:

S1:将网络的输入设置为;

S2:将有雾图像送入编码器部分,经过卷积操作,将图像下采样作为特征图;

S3:在每个下采样阶段均将特征图送入1个残差密集块RDB模块进行局部密集特征提取与局部特征融合,再把融合后的特征图通过一个步长为2的卷积层进行下采样操作,然后将下采样后的特征图送入到DFF模块,弥补缺失的空间信息;

S4:每一个阶段特征图的数量增加一倍,经过4次降采样后将的特征图送入特征恢复模块;

S5:将特征恢复模块增强过的特征图经4次反卷积上采样到原始输入大小;

S6:每次上采样后将输出与来自编码器对应层的潜在特征相连接,然后一起输入到残差密集块RDB模块进行特征细化;

S7:再将细化后的特征输入DFF模块进行自适应特征融合。

进一步地,所述判别器网络的结构采用PatchGAN,其输出的是一个N*N的矩阵。

进一步地,所述总体目标函数采用WGAN-GP损失并修改为条件设定作为对抗训练损失,如下所示:

将L

L

L

结合上述损失,得到最终总体目标函数:

式中:G是生成器网络结构,D是判别器网络结构,I是有雾图像,J是真实图像,

进一步地,所述特征融合采用反投影技术的DFF模块,所述反投影技术用于通过最小化估计出的高分辨率结果和多个观测到的低分辨率输入之间的重构误差来生成高分辨率内容。

进一步地,所述特征恢复模块包含8个残差密集块RDB模块,且每个残差密集块RDB模块包括密集的连接层、局部特征融合和局部残差学习,其具体运行过程如下:

SS1:通过连续内存机制读取前一个RDB模块的状态然后传递到当前RDB模块的每一层,同时通过局部密集连接充分利用其中的所有层;

SS2:通过一个1*1的卷积层进行局部特征融合,以自适应的保留积累特征;

SS3:通过局部残差学习进一步改善信息流,提高网络的表示能力。

进一步地,所述编码器在第n级的DFF模块

式中:i

所述解码器在第n级的DFF模块

式中:j

进一步地,所述增强特征采用渐进的方式进行更新,具体更新步骤如下:

SSS1:通过公式一计算DDF模块在第t次特征融合时的潜在特征和增强特征之间的反馈误差;

SSS2:再与增强特征相减得到反馈误差;

SSS3:再通过公式二将反馈误差下采样到与增强特征同等尺度大小;然后与潜在特征相加得到融合后的增强特征;

步骤SSS1所述公式一具体如下:

步骤SSS3所述公式二具体如下:

式中:

相比于现有技术,本发明的有益效果在于:

1、该基于条件生成对抗网络和多尺度密集特征融合图像去雾方法,在生成器网络中引入残差密集块和基于反投影技术的密集特征融合模块,并利用其分别进行局部特征融合和多尺度密集特征融合,通过有效的融合不同层次的特征来逐步得到更清晰的图像;并且在编解码部分的每一级别都应用一个RDB模块,在通过密集连接的卷积层提取丰富的局部特征的同时,还可以通过局部特征融合自适应的从以前和现在的局部特征中学习更有效的特征,从而有利于使图像去雾更加自然,并且有利于消除噪声;

2、该基于条件生成对抗网络和多尺度密集特征融合图像去雾方法中生成器网络的结构设计基于U-Net结构,由于使用U-Net结构处理图像去雾时存在一些固有的问题,例如,编码器中存在下采样而丢失空间信息,在非相邻层特征之间缺乏足够的连接;因此本发明在生成器网络的每一级别都引入基于反投影技术的DFF模块,并进行多尺度密集特征融合,充分利用不同尺度的特征;从而有利于避免充分提取的局部密集特征存在丢失空间信息的问题。

附图说明

附图用来提供对本发明的进一步理解,并且构成说明书的一部分,与本发明的实施例一起用于解释本发明,并不构成对本发明的限制。

图1为本发明提出的一种基于对抗网络和多尺度密集特征融合图像去雾方法的整体流程图;

图2为本发明生成器网络结构和判别器网络结构的示意图;

图3为本发明残差密集块RDB模块的示意图;

图4为本发明DFF模块在编码器第n级的网络架构的示意图。

具体实施方式

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。

在本发明的描述中,需要理解的是,术语“上”、“下”、“前”、“后”、“左”、“右”、“顶”、“底”、“内”、“外”等指示的方位或位置关系为基于附图所示的方位或位置关系,仅是为了便于描述本发明和简化描述,而不是指示或暗示所指的装置或元件必须具有特定的方位、以特定的方位构造和操作,因此不能理解为对本发明的限制。

参照图1-4,一种基于对抗网络和多尺度密集特征融合图像去雾方法,该去雾方法具体步骤如下:

(1)构建用于图像去雾条件对抗生成网络;

(2)使用公开图像去雾数据集训练该网络至收敛;

(3)将训练好的生成器网络作为图像去雾网络,输入为有雾图像,输出为去雾后的图像。

步骤(1)条件对抗生成网络包括生成器网络、判别器网络和总体目标函数。

生成器网络的结构设计基于U-Net结构,其包括编码模块、解码模块和特征恢复模块三部分组成,括编码模块设置有编码器,且集成有残差密集块RDB模块和基于反投影技术的DFF模块,解码模块设置有解码器;生成器网络具体运行过程如下:

S1:将网络的输入设置为;

S2:将有雾图像送入编码器部分,经过卷积操作,将图像下采样作为特征图;

S3:在每个下采样阶段均将特征图送入1个残差密集块RDB模块进行局部密集特征提取与局部特征融合,再把融合后的特征图通过一个步长为2的卷积层进行下采样操作,然后将下采样后的特征图送入到DFF模块,弥补缺失的空间信息;

S4:每一个阶段特征图的数量增加一倍,经过4次降采样后将的特征图送入特征恢复模块;

S5:将特征恢复模块增强过的特征图经4次反卷积上采样到原始输入大小;

S6:每次上采样后将输出与来自编码器对应层的潜在特征相连接,然后一起输入到残差密集块RDB模块进行特征细化;

S7:再将细化后的特征输入DFF模块进行自适应特征融合。

判别器网络的结构采用PatchGAN,其输出的是一个N*N的矩阵。

总体目标函数采用WGAN-GP损失并修改为条件设定作为对抗训练损失,如下所示:

将L

L

L

结合上述损失,得到最终总体目标函数:

式中:G是生成器网络结构,D是判别器网络结构,I是有雾图像,J是真实图像,

特征融合采用反投影技术的DFF模块,反投影技术用于通过最小化估计出的高分辨率结果和多个观测到的低分辨率输入之间的重构误差来生成高分辨率内容。

特征恢复模块包含8个残差密集块RDB模块,且每个残差密集块RDB模块包括密集的连接层、局部特征融合和局部残差学习,其具体运行过程如下:

SS1:通过连续内存机制读取前一个RDB模块的状态然后传递到当前RDB模块的每一层,同时通过局部密集连接充分利用其中的所有层;

SS2:通过一个1*1的卷积层进行局部特征融合,以自适应的保留积累特征;

SS3:通过局部残差学习进一步改善信息流,提高网络的表示能力。

编码器在第n级的DFF模块

式中:i

解码器在第n级的DFF模块

式中:j

增强特征采用渐进的方式进行更新,具体更新步骤如下:

SSS1:通过公式一计算DDF模块在第t次特征融合时的潜在特征和增强特征之间的反馈误差;

SSS2:再与增强特征相减得到反馈误差;

SSS3:再通过公式二将反馈误差下采样到与增强特征同等尺度大小;然后与潜在特征相加得到融合后的增强特征;

步骤SSS1公式一具体如下:

步骤SSS3公式二具体如下:

式中:

本发明的工作原理及使用流程:该基于条件生成对抗网络和多尺度密集特征融合图像去雾方法,首先需要构建用于图像去雾条件对抗生成网络;然后使用公开图像去雾数据集训练该网络至收敛;最后将训练好的生成器网络作为图像去雾网络,输入为有雾图像,输出为去雾后的图像;其生成器网络具体运行过程如下:首先将网络的输入设置为;然后将有雾图像送入编码器部分,经过卷积操作,将图像下采样作为特征图;之后在每个下采样阶段均将特征图送入1个残差密集块RDB模块进行局部密集特征提取与局部特征融合,再把融合后的特征图通过一个步长为2的卷积层进行下采样操作,然后将下采样后的特征图送入到DFF模块,弥补缺失的空间信息;然后每一个阶段特征图的数量增加一倍,经过4次降采样后将的特征图送入特征恢复模块;之后将特征恢复模块增强过的特征图经4次反卷积上采样到原始输入大小;然后每次上采样后将输出与来自编码器对应层的潜在特征相连接,然后一起输入到残差密集块RDB模块进行特征细化;最后再将细化后的特征输入DFF模块进行自适应特征融合;本发明在生成器网络中引入残差密集块和基于反投影技术的密集特征融合模块,并利用其分别进行局部特征融合和多尺度密集特征融合,通过有效的融合不同层次的特征来逐步得到更清晰的图像;从而有利于使图像去雾更加自然,并且有利于消除噪声。

以上所述,仅为本发明较佳的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,根据本发明的技术方案及其发明构思加以等同替换或改变,都应涵盖在本发明的保护范围之内。

- 一种基于对抗网络和多尺度密集特征融合图像去雾方法

- 一种基于全尺度特征融合和轻量级生成式对抗网络的行人重识别方法