一种分类模型的训练方法、装置、电子设备及存储介质

文献发布时间:2023-06-19 11:26:00

技术领域

本申请涉及信息技术领域,特别是涉及一种分类模型的训练方法、装置、电子设备及存储介质。

背景技术

异质图是指含有多种不同类型节点和关系的图,在现实中通过异质图往往更能体现待分类目标之间的关系。例如,在对电影和演员进行分类时,同一演员可能参演多部电影,同一电影也可能包括多个演员。

然而,当前在对待分类目标的异质图的分类模型进行训练时,通过直接对异质图进行识别和待分类目标进行分类,由于异质图中各节点之间的关系往往比较复杂,而观测到的异质图结构常常不能很好地反映此种复杂关系,使得识别得到的待分类目标之间的特征往往有限,导致异质图分类模型在训练过程中,训练效率不高。

发明内容

本申请实施例的目的在于提供一种分类模型的训练方法、装置、电子设备及存储介质,用以解决异质图分类模型训练效率不高的问题。具体技术方案如下:

本申请实施例的第一方面,首先提供了一种分类模型的训练方法,应用于待训练的分类模型,待训练的分类模型包括待训练的异质图结构学习网络和待训练的图神经网络,上述方法包括:

获取样本异质图中各节点的特征和各元路径的特征,其中,样本异质图为用于表征待分类目标之间关系的图;

通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图;

通过待训练的异质图结构学习网络,根据各元路径的特征,生成样本异质图的语义图;

将特征图、语义图和样本异质图进行融合,得到关系子图;

将关系子图输入待训练的图神经网络中,得到待分类目标的分类结果,并通过预设损失函数,计算当前损失;

根据当前损失对待训练的异质图结构学习网络和待训练的图神经网络的参数进行调整;

返回通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图的步骤继续执行,直至满足预设条件,得到训练好的异质图结构学习网络和图神经网络。

可选的,通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图,包括:

通过待训练的异质图结构学习网络,对各节点的特征和各元路径的特征,进行异质特征提取和度量学习生成特征相似度图;

根据各节点的特征和各元路径的特征,通过拓扑结构传播特征相似度矩阵生成特征传播图;

对特征相似度图和特征传播图进行聚合得到特征图。

可选的,通过待训练的异质图结构学习网络,根据各元路径的特征,生成样本异质图的语义图,包括:

通过待训练的异质图结构学习网络,根据各元路径的特征,生成对应各元路径的语义子图邻接矩阵;

对各语义子图邻接矩阵进行聚合得到语义图。

可选的,将关系子图输入待训练的图神经网络中,得到待分类目标的分类结果,并通过预设损失函数,计算当前损失,包括:

将关系子图输入待训练的图神经网络中,得到待分类目标的分类结果;

根据分类结果并通过第一预设损失函数,计算待训练的异质图结构学习网络的损失;

根据分类结果并通过第二预设损失函数,计算待训练的图神经网络的损失;

对待训练的异质图结构学习网络的损失和待训练的图神经网络的损失进行求和,得到当前损失。

本申请实施例的第二方面,还提供了一种分类模型的训练装置,应用于待训练的分类模型,待训练的分类模型包括待训练的异质图结构学习网络和待训练的图神经网络,上述装置包括:

特征获取模块,用于获取样本异质图中各节点的特征和各元路径的特征,其中,样本异质图为用于表征待分类目标之间关系的图;

特征聚合模块,用于通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图;

语义图生成模块,用于通过待训练的异质图结构学习网络,根据各元路径的特征,生成样本异质图的语义图;

关系子图生成模块,用于将特征图、语义图和样本异质图进行融合,得到关系子图;

损失计算模块,用于将关系子图输入待训练的图神经网络中,得到待分类目标的分类结果,并通过预设损失函数,计算当前损失;

参数调整模块,用于根据当前损失对待训练的异质图结构学习网络和待训练的图神经网络的参数进行调整;

神经网络获取模块,用于返回通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图的步骤继续执行,直至满足预设条件,得到训练好的异质图结构学习网络和图神经网络。

可选的,特征聚合模块,包括:

特征相似度图生成子模块,用于通过待训练的异质图结构学习网络,对各节点的特征和各元路径的特征,进行异质特征提取和度量学习生成特征相似度图;

特征传播图生成子模块,用于根据各节点的特征和各元路径的特征,通过拓扑结构传播特征相似度矩阵生成特征传播图;

特征图聚合子模块,用于对特征相似度图和特征传播图进行聚合得到特征图。

可选的,语义图生成模块,包括:

邻接矩阵生成子模块,用于通过待训练的异质图结构学习网络,根据各元路径的特征,生成对应各元路径的语义子图邻接矩阵;

邻接矩阵聚合子模块,用于对各语义子图邻接矩阵进行聚合得到语义图。

可选的,损失计算模块,包括:

分类结果获取子模块,用于将关系子图输入待训练的图神经网络中,得到待分类目标的分类结果;

第一损失计算子模块,用于根据分类结果并通过第一预设损失函数,计算待训练的异质图结构学习网络的损失;

第二损失计算子模块,用于根据分类结果并通过第二预设损失函数,计算待训练的图神经网络的损失;

当前损失计算子模块,用于对待训练的异质图结构学习网络的损失和待训练的图神经网络的损失进行求和,得到当前损失。

本申请实施例还提供了一种电子设备,包括处理器、通信接口、存储器和通信总线,其中,处理器,通信接口,存储器通过通信总线完成相互间的通信;

存储器,用于存放计算机程序;

处理器,用于执行存储器上所存放的程序时,实现上述任一分类模型的训练方法。

本申请实施例还提供了一种计算机可读存储介质,计算机可读存储介质内存储有计算机程序,计算机程序被处理器执行时实现上述任一分类模型的训练方法。

本申请实施例还提供了一种包含指令的计算机程序产品,当其在计算机上运行时,使得计算机执行上述任一分类模型的训练方法。

本申请实施例有益效果:

本申请实施例提供的一种分类模型的训练方法、装置、电子设备及存储介质,可以获取样本异质图中各节点的特征和各元路径的特征,其中,样本异质图为用于表征待分类目标之间关系的图;通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图;通过待训练的异质图结构学习网络,根据各元路径的特征,生成样本异质图的语义图;将特征图、语义图和样本异质图进行融合,得到关系子图;将关系子图输入待训练的图神经网络中,得到待分类目标的分类结果,并通过预设损失函数,计算当前损失;根据当前损失对待训练的异质图结构学习网络和待训练的图神经网络的参数进行调整;返回通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图的步骤继续执行,直至满足预设条件,得到训练好的异质图结构学习网络和图神经网络。通过根据样本异质图生成样本异质图提取语义图并生成关系子图,根据关系子图得到待分类目标的分类结果,并计算当前损失,根据当前损失对待训练的异质图结构学习网络和待训练的图神经网络的参数同时进行调整,从而可以提高模型训练的效率。

当然,实施本申请的任一产品或方法并不一定需要同时达到以上所述的所有优点。

附图说明

为了更清楚地说明本申请实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本申请的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的实施例。

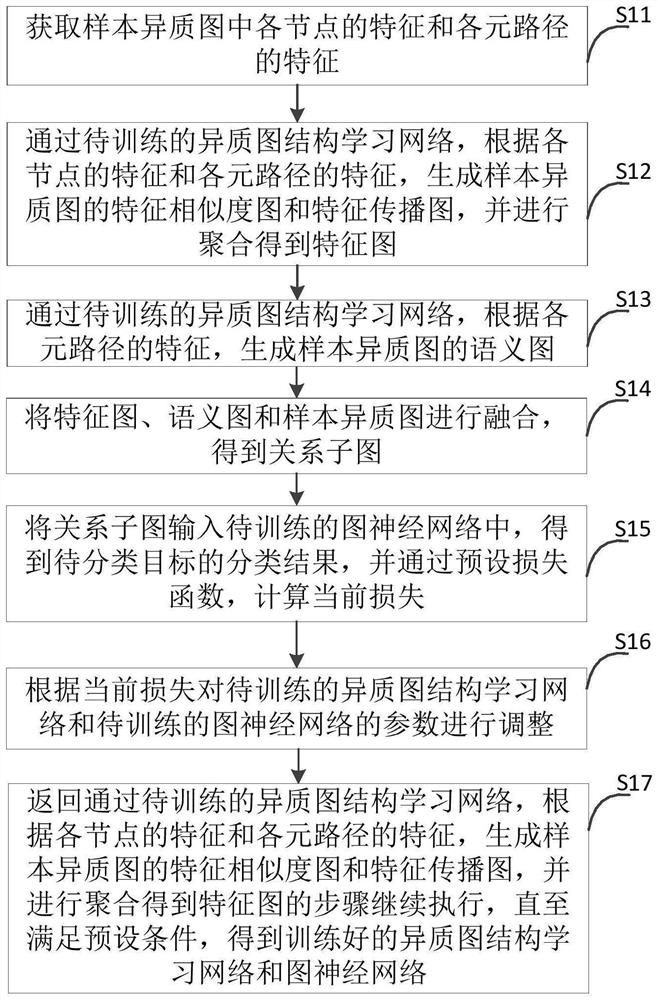

图1为本申请实施例提供的分类模型的训练方法的一种流程示意图;

图2a为本申请实施例提供的图神经网络的一种结构示意图;

图2b为本申请实施例提供的特征图生成器的一种结构示意图;

图2c为本申请实施例提供的语义图生成器的一种结构示意图;

图3为本申请实施例提供的聚合得到特征图的一种流程示意图;

图4为本申请实施例提供的生成语义图的一种流程示意图;

图5为本申请实施例提供的计算当前损失的一种流程示意图;

图6为本申请实施例提供的分类模型的训练装置的一种结构示意图;

图7为本申请实施例提供的电子设备的一种结构示意图。

具体实施方式

下面将结合本申请实施例中的附图,对本申请实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本申请一部分实施例,而不是全部的实施例。基于本申请中的实施例,本领域普通技术人员基于本申请所获得的所有其他实施例,都属于本申请保护的范围。

本申请实施例的第一方面,首先提供了一种分类模型的训练方法,应用于待训练的分类模型,待训练的分类模型包括待训练的异质图结构学习网络和待训练的图神经网络,上述方法包括:

获取样本异质图中各节点的特征和各元路径的特征,其中,样本异质图为用于表征待分类目标之间关系的图;

通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图;

通过待训练的异质图结构学习网络,根据各元路径的特征,生成样本异质图的语义图;

将特征图、语义图和样本异质图进行融合,得到关系子图;

将关系子图输入待训练的图神经网络中,得到待分类目标的分类结果,并通过预设损失函数,计算当前损失;

根据当前损失对待训练的异质图结构学习网络和待训练的图神经网络的参数进行调整;

返回通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图的步骤继续执行,直至满足预设条件,得到训练好的异质图结构学习网络和图神经网络。

可见,通过本申请实施例的分类模型的训练方法,可以根据样本异质图生成样本异质图提取语义图并生成关系子图,根据关系子图得到待分类目标的分类结果,并计算当前损失,根据当前损失对待训练的异质图结构学习网络和待训练的图神经网络的参数同时进行调整,从而可以提高模型训练的效率。

本申请中,为了解决现有技术中模型训练的效率低的问题,通过构建HGSL(异质图结构学习)的框架,HGSL共同优化图结构和GNN(图神经网络)参数。HGSL首先基于M条元路径的节点嵌入来构造语义嵌入矩阵Z,然后,对异质图结构和GNN参数进行联合训练。对于图学习部分,HGSL将原始关系子图、节点特征和语义嵌入作为输入,并分别生成关系子图。具体地,以关系r

具体的,参见图1,图1为本申请实施例提供的分类模型的训练方法的一种流程示意图,包括:

步骤S11,获取样本异质图中各节点的特征和各元路径的特征。

其中,样本异质图为用于表征待分类目标之间关系的图。例如,异质图中各节点可以分别表示不同的演员、电影、导演,其中,同一演员可能参演多部电影,同一导演也可能对应多部电影,同一电影也可能对应多名演员。

本申请实施例提供的分类模型的训练方法应用于待训练的分类模型,待训练的分类模型包括待训练的异质图结构学习网络和待训练的图神经网络。本申请实施例提供的分类模型的训练方法应用于智能终端,具体的,该智能终端可以是用于对模型进行训练的电脑或服务器等。

步骤S12,通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图。

其中,生成特征图,可以通过特征图生成器生成。通过首先生成一个特征相似度图,该特征相似度图通过异质特征投影和度量学习捕获由节点特征生成的潜在关系。然后,通过拓扑结构传播特征相似度矩阵来生成特征传播图。最后,将生成的特征相似度图和特征传播图通过通道注意力层聚合为最终特征图。

例如,异质图G=(V,E,F)由节点集V、边集E和特征集F组成,同时还具有节点类型映射函数

步骤S13,通过待训练的异质图结构学习网络,根据各元路径的特征,生成样本异质图的语义图。

其中,生成样本异质图的语义图,可以通过语义图生成器。语义图是根据HIN中的高阶拓扑结构生成的,描述了两个节点间的多跳结构交互。

步骤S14,将特征图、语义图和样本异质图进行融合,得到关系子图。

节点关系三元组(v

关系子图为当给定一个异质图G=(V,E,F),关系子图G

步骤S15,将关系子图输入待训练的图神经网络中,得到待分类目标的分类结果,并通过预设损失函数,计算当前损失。

根据预设损失函数,计算当前损失,可以通过分别计算HGSL的损失和GNN损失,并求和的方式,计算当前损失。具体的,计算当前损失可以参见图2a,图2a为本申请实施例提供的图神经网络的一种结构示意图。其中,特征集F由

步骤S16,根据当前损失对待训练的异质图结构学习网络和待训练的图神经网络的参数进行调整。

步骤S17,返回通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图的步骤继续执行,直至满足预设条件,得到训练好的异质图结构学习网络和图神经网络。

可见,通过本申请实施例的分类模型的训练方法,可以根据样本异质图生成样本异质图提取语义图并生成关系子图,根据关系子图得到待分类目标的分类结果,并计算当前损失,根据当前损失对待训练的异质图结构学习网络和待训练的图神经网络的参数同时进行调整,从而可以提高模型训练的效率。

可选的,参见图3,步骤S12通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图,包括:

步骤S121,通过待训练的异质图结构学习网络,对各节点的特征和各元路径的特征,进行异质特征提取和度量学习生成特征相似度图;

步骤S122,根据各节点的特征和各元路径的特征,通过拓扑结构传播特征相似度矩阵生成特征传播图;

步骤S123,对特征相似度图和特征传播图进行聚合得到特征图。

特征相似度图

其中,σ(·)表示非线性激活函数,

其中,∈

其中,⊙表示哈达玛乘积,

可选的,参见图4,步骤S13通过待训练的异质图结构学习网络,根据各元路径的特征,生成样本异质图的语义图,包括:

步骤S131,通过待训练的异质图结构学习网络,根据各元路径的特征,生成对应各元路径的语义子图邻接矩阵;

步骤S132,对各语义子图邻接矩阵进行聚合得到语义图。

例如,给定具有关系

其中生成语义图可以通过语义图生成器生成,语义图生成器通过对得到的基于元路径的节点嵌入进行度量学习来生成潜在的语义图结构。具体地,对于具有M条元路径的元路径集合

在获得语义嵌入Z后,对于每条元路径P

其中,

其中,

可选的,参见图5,步骤S15将关系子图输入待训练的图神经网络中,得到待分类目标的分类结果,并通过预设损失函数,计算当前损失,包括:

步骤S151,将关系子图输入待训练的图神经网络中,得到待分类目标的分类结果;

步骤S152,根据分类结果并通过第一预设损失函数,计算待训练的异质图结构学习网络的损失;

步骤S153,根据分类结果并通过第二预设损失函数,计算待训练的图神经网络的损失;

步骤S154,对待训练的异质图结构学习网络的损失和待训练的图神经网络的损失进行求和,得到当前损失。

本申请中,图结构

其中,X是原始节点特征矩阵,如果所有特征的维度都相同,

其中,f

由于图结构学习方法使原始GNN具有更强的适应下游任务的能力,因此将更容易过拟合。因此,将正则化项

本申请中,当前损失可以通过公式:

本申请中,可以通过最小化

进一步的,为了说明本申请的有益效果,下边结合具体对比试验进行说明。

试验中通过使用真实世界数据集来评估我们所提出的模型,具体的,数据集的统计信息如表1所示:

表1数据集统计信息

DBLP(DataBase systems and Logic Programming,集成数据库系统),DBLP的子集,包含4323篇论文(P)、2957名作者(A)和20个会议(C)。作者分为四个领域:数据库、数据挖掘、机器学习和信息检索。节点特征是分别与论文、作者和会议有关的术语。

ACM(Association for Computing Machinery,国际计算机学会),通过使用和GTN相同的数据集和实验设置,该数据集包含3025篇论文(P)、5912名作者(A)和57个会议主题(S)。论文根据其会议进行标记。节点特征由关键字构成。

Yelp(一点评网站),Yelp数据集包含2614个商家(B)、1286个用户(U)、4个服务(S)和9个等级(L)。商家节点按其类别标记。节点特征由相关关键字的词袋表示构成。

基线,本申请中将HGSL与11种最先进的嵌入方法进行了比较,其中包括4种同质图嵌入方法,即DeepWalk(深度游走算法)、GCN(图卷积网络)、GAT(图注意力网络)和GraphSAGE(Graph SAmple and aggreGatE),四种异质图嵌入方法,即MP2Vec(metapath2vec)、HAN(异质图注意力网络)、HeGAN(HIN embedding with GAN-basedadversarial learning,基于生成对抗网络的异质图嵌入算法)和GTN(图变换网络),以及三种图结构学习方法,即LDS(Learning Discrete Structures for GNN)、Pro-GNN(Property GNN)和Geom-GCN(几何图卷积网络)。

实验设置,本申请中,对于所有与GNN相关的模型,将层数设置为2,公共空间中的特征维度d

表2节点分类的性能评估(平均值(百分比)±标准差)

本申请中评估HGSL在节点分类任务上的性能。选择Macro-F1和Micro-F1作为评估指标。表2中显示了百分比下的平均值和标准差,从中我们可以观察到以下几点:HGSL具有自适应学习异质图结构的能力,始终优于所有基线;图结构学习方法通常优于原始GCN,因为它使GCN可以从学习的结构中聚合特征;与同质GNN相比,由于考虑了异质性,HAN、GTN和HGSL等HGNN方法具有更好的性能;由于使用了节点特征,因此基于GNN的方法大多优于基于随机游走的图嵌入方法。Yelp数据集上,这种现象更明显,因为节点特征(即关键字)有助于对商家类别进行分类。

消融实验,为验证HGSL不同部分的有效性,本申请通过从HGSL中分别删除每种类型的图来设计三个变体,分别表示为HGSL-w/o-FSG、HGSL-w/o-FPG和HGSL-w/o-SG。可以观察到,HGSL优于这些变体,表明有必要考虑所有这些候选图。此外,与HGSL相比,这三个变量的性能下降程度在不同的数据集上是不同的,这表明这些候选图的重要性在不同情况下也有所不同,应仔细权衡。

权重学习的有效性,为评估HGSL是否可以有效地学习不同图的重要性,本申请将HGSL中的每个通道注意力层替换为平均聚合层,即通过对所有候选图取平均来获得图,表示为HGSL-avg(HGSL的平均值)。很明显,HGSL的表现明显优于HGSL-avg,这表明通过通道注意力层进行权重学习的有效性。值得注意的是,与HGSL相比,HGSL-avg在Yelp上的性能明显下降。这是因为Yelp的节点特征非常重要,但是HGSL-avg同等融合了三个候选图,其中两个图(语义图和原始图)都是从拓扑生成的。因此,Yelp中节点特征的影响会大大减弱,从而影响性能。

候选图的重要性分析,为了研究HGSL是否可以区分候选图的重要性,本申请分析了在三个数据集上融合每个关系子图的通道注意力层的权重分布,即公式(6)中ψ

通过本申请的HGSL的框架,可共同学习异质图结构和GNN参数,以实现分类目标。特别地,通过利用异质图内部的复杂相互作用,生成特征相似图、特征传播图和语义图并融合,从而学习用于分类的最佳异质图结构。

本申请实施例的第二方面,还提供了一种分类模型的训练装置,应用于待训练的分类模型,待训练的分类模型包括待训练的异质图结构学习网络和待训练的图神经网络,参见图6,图6为本申请实施例提供的分类模型的训练装置的一种结构示意图,上述装置包括:

特征获取模块601,用于获取样本异质图中各节点的特征和各元路径的特征,其中,样本异质图为用于表征待分类目标之间关系的图;

特征聚合模块602,用于通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图;

语义图生成模块603,用于通过待训练的异质图结构学习网络,根据各元路径的特征,生成样本异质图的语义图;

关系子图生成模块604,用于将特征图、语义图和样本异质图进行融合,得到关系子图;

损失计算模块605,用于将关系子图输入待训练的图神经网络中,得到待分类目标的分类结果,并通过预设损失函数,计算当前损失;

参数调整模块606,用于根据当前损失对待训练的异质图结构学习网络和待训练的图神经网络的参数进行调整;

神经网络获取模块607,用于返回通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图的步骤继续执行,直至满足预设条件,得到训练好的异质图结构学习网络和图神经网络。

可选的,特征聚合模块602,包括:

特征相似度图生成子模块,用于通过待训练的异质图结构学习网络,对各节点的特征和各元路径的特征,进行异质特征提取和度量学习生成特征相似度图;

特征传播图生成子模块,用于根据各节点的特征和各元路径的特征,通过拓扑结构传播特征相似度矩阵生成特征传播图;

特征图聚合子模块,用于对特征相似度图和特征传播图进行聚合得到特征图。

可选的,语义图生成模块603,包括:

邻接矩阵生成子模块,用于通过待训练的异质图结构学习网络,根据各元路径的特征,生成对应各元路径的语义子图邻接矩阵;

邻接矩阵聚合子模块,用于对各语义子图邻接矩阵进行聚合得到语义图。

可选的,损失计算模块605,包括:

分类结果获取子模块,用于将关系子图输入待训练的图神经网络中,得到待分类目标的分类结果;

第一损失计算子模块,用于根据分类结果并通过第一预设损失函数,计算待训练的异质图结构学习网络的损失;

第二损失计算子模块,用于根据分类结果并通过第二预设损失函数,计算待训练的图神经网络的损失;

当前损失计算子模块,用于对待训练的异质图结构学习网络的损失和待训练的图神经网络的损失进行求和,得到当前损失。

可见,通过本申请实施例的分类模型的训练装置,可以根据样本异质图生成样本异质图提取语义图并生成关系子图,根据关系子图得到待分类目标的分类结果,并计算当前损失,根据当前损失对待训练的异质图结构学习网络和待训练的图神经网络的参数同时进行调整,从而可以提高模型训练的效率。

本申请实施例还提供了一种电子设备,如图7所示,包括处理器701、通信接口702、存储器703和通信总线704,其中,处理器701,通信接口702,存储器703通过通信总线704完成相互间的通信,

存储器703,用于存放计算机程序;

处理器701,用于执行存储器703上所存放的程序时,实现如下步骤:

获取样本异质图中各节点的特征和各元路径的特征,其中,样本异质图为用于表征待分类目标之间关系的图;

通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图;

通过待训练的异质图结构学习网络,根据各元路径的特征,生成样本异质图的语义图;

将特征图、语义图和样本异质图进行融合,得到关系子图;

将关系子图输入待训练的图神经网络中,得到待分类目标的分类结果,并通过预设损失函数,计算当前损失;

根据当前损失对待训练的异质图结构学习网络和待训练的图神经网络的参数进行调整;

返回通过待训练的异质图结构学习网络,根据各节点的特征和各元路径的特征,生成样本异质图的特征相似度图和特征传播图,并进行聚合得到特征图的步骤继续执行,直至满足预设条件,得到训练好的异质图结构学习网络和图神经网络。

上述电子设备提到的通信总线可以是外设部件互连标准(Peripheral ComponentInterconnect,PCI)总线或扩展工业标准结构(Extended Industry StandardArchitecture,EISA)总线等。该通信总线可以分为地址总线、数据总线、控制总线等。为便于表示,图中仅用一条粗线表示,但并不表示仅有一根总线或一种类型的总线。

通信接口用于上述电子设备与其他设备之间的通信。

存储器可以包括随机存取存储器(Random Access Memory,RAM),也可以包括非易失性存储器(Non-Volatile Memory,NVM),例如至少一个磁盘存储器。可选的,存储器还可以是至少一个位于远离前述处理器的存储装置。

上述的处理器可以是通用处理器,包括中央处理器(Central Processing Unit,CPU)、网络处理器(Network Processor,NP)等;还可以是数字信号处理器(Digital SignalProcessor,DSP)、专用集成电路(Application Specific Integrated Circuit,ASIC)、现场可编程门阵列(Field-Programmable Gate Array,FPGA)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件。

在本申请提供的又一实施例中,还提供了一种计算机可读存储介质,该计算机可读存储介质内存储有计算机程序,所述计算机程序被处理器执行时实现上述任一分类模型的训练方法的步骤。

在本申请提供的又一实施例中,还提供了一种包含指令的计算机程序产品,当其在计算机上运行时,使得计算机执行上述实施例中任一分类模型的训练方法。

在上述实施例中,可以全部或部分地通过软件、硬件、固件或者其任意组合来实现。当使用软件实现时,可以全部或部分地以计算机程序产品的形式实现。所述计算机程序产品包括一个或多个计算机指令。在计算机上加载和执行所述计算机程序指令时,全部或部分地产生按照本申请实施例所述的流程或功能。所述计算机可以是通用计算机、专用计算机、计算机网络、或者其他可编程装置。所述计算机指令可以存储在计算机可读存储介质中,或者从一个计算机可读存储介质向另一个计算机可读存储介质传输,例如,所述计算机指令可以从一个网站站点、计算机、服务器或数据中心通过有线(例如同轴电缆、光纤、数字用户线(DSL))或无线(例如红外、无线、微波等)方式向另一个网站站点、计算机、服务器或数据中心进行传输。所述计算机可读存储介质可以是计算机能够存取的任何可用介质或者是包含一个或多个可用介质集成的服务器、数据中心等数据存储设备。所述可用介质可以是磁性介质,(例如,软盘、硬盘、磁带)、光介质(例如,DVD)、或者半导体介质(例如固态硬盘Solid State Disk(SSD))等。

需要说明的是,在本文中,诸如第一和第二等之类的关系术语仅仅用来将一个实体或者操作与另一个实体或操作区分开来,而不一定要求或者暗示这些实体或操作之间存在任何这种实际的关系或者顺序。而且,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者设备不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者设备所固有的要素。在没有更多限制的情况下,由语句“包括一个……”限定的要素,并不排除在包括所述要素的过程、方法、物品或者设备中还存在另外的相同要素。

本说明书中的各个实施例均采用相关的方式描述,各个实施例之间相同相似的部分互相参见即可,每个实施例重点说明的都是与其他实施例的不同之处。尤其,对于装置、电子设备、存储介质、计算机程序产品实施例而言,由于其基本相似于方法实施例,所以描述的比较简单,相关之处参见方法实施例的部分说明即可。

以上所述仅为本申请的较佳实施例,并非用于限定本申请的保护范围。凡在本申请的精神和原则之内所作的任何修改、等同替换、改进等,均包含在本申请的保护范围内。

- 一种分类模型的训练方法、装置、电子设备及存储介质

- 证件分类模型训练方法、装置、电子设备及存储介质