表情重定向方法、装置、设备和介质

文献发布时间:2023-06-19 11:42:32

技术领域

本发明实施例涉及计算机视觉技术领域,尤其涉及一种表情重定向方法、装置、设备和介质。

背景技术

随着直播行业的流行,越来越多的人作为主播进入了直播行业。但是往往会面临一些问题,比如主播对自己的形象可能不够自信,担心直接将真实容貌暴露在直播环境之中会对直播效果产生影响,又比如主播总是以单一的自我形象进行直播,缺少多样性,限制了许多有趣的直播模式和玩法。因此,虚拟直播应运而生,让主播可以在背后驱动虚拟形象进行个性化直播。

当主播驱动虚拟形象进行个性化直播时,通过自己的表情变化来驱动虚拟形象的表情变化。然而,由于驱动模型的表情基组和虚拟形象表情基组之间通常会存在语义差异,导致将使用驱动模型的表情基组学习到的表情系数迁移到虚拟形象表情基组上时会出现虚拟形象表情不自然问题。

发明内容

本发明实施例提供一种表情重定向方法、装置、设备和介质,以解决主播驱动虚拟形象时虚拟形象表情不自然的问题。

第一方面,本发明实施例提供了一种表情重定向方法,包括:

实时获取直播视频帧中的人脸图像,并根据标准表情基组确定与所述人脸图像对应的标准表情系数;

确定与所述标准表情系数对应的个性化表情系数,其中,所述个性化表情系数与预先生成的目标个性化虚拟形象表情基组是匹配的;

将所述个性化表情系数使用到所述目标个性化虚拟形象表情基组上,以驱动与所述目标个性化虚拟形象表情基组对应的个性化虚拟形象的表情。

第二方面,本发明实施例还提供了一种表情重定向装置,包括:

标准表情系数确定模块,用于实时获取直播视频帧中的人脸图像,并根据标准表情基组确定与所述人脸图像对应的标准表情系数;

个性化表情系数确定模块,用于确定与所述标准表情系数对应的个性化表情系数,其中,所述个性化表情系数与预先生成的目标个性化虚拟形象表情基组是匹配的;

表情重定向模块,用于将所述个性化表情系数使用到所述目标个性化虚拟形象表情基组上,以驱动与所述目标个性化虚拟形象表情基组对应的个性化虚拟形象的表情。

第三方面,本发明实施例还提供了一种计算机设备,所述计算机设备包括:

一个或多个处理器;

存储器,用于存储一个或多个程序,

当所述一个或多个程序被所述一个或多个处理器执行,使得所述一个或多个处理器实现任意实施例所述的表情重定向方法。

第四方面,本发明实施例还提供了一种计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时实现任意实施例所述的表情重定向方法。

在本发明实施例提供的技术方案中,在预先生成的目标个性化虚拟形象表情之后,实时获取直播视频帧中的人脸图像,并根据标准表情基组确定与人脸图像对应的标准表情系数,然后将与标准表情系数对应的个性化表情系数使用到目标个性化虚拟形象表情基组上,以驱动与目标个性化虚拟形象表情基组对应的个性化虚拟形象的表情。由于与标准表情系数对应的个性化表情系数是与目标个性化虚拟形象表情基组匹配的,故将该个性化表情系数使用到目标个性化虚拟形象表情基组而得到的虚拟形象表情不会存在不自然的问题,使重定向到虚拟形象上的表情更加生动自然。

附图说明

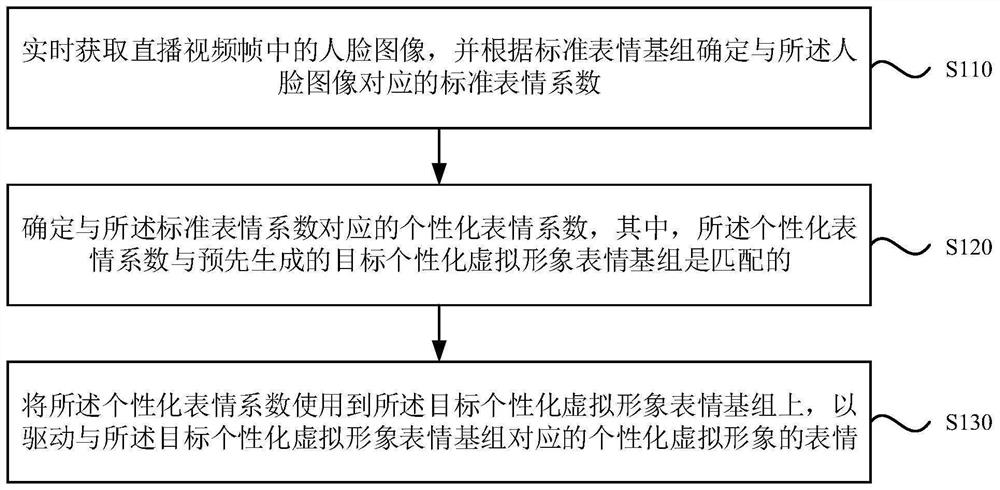

图1是本发明实施例一提供的一种表情重定向方法的流程图;

图2是本发明实施例一提供的表情基组的示意图;

图3是本发明实施例一提供的三维形变模型库的示意图;

图4是本发明实施例二提供的一种表情重定向方法的流程图;

图5是本发明实施例二提供的一种个性化虚拟形象表情基组的拆解示意图;

图6是本发明实施例二提供的一种主播驱动虚拟形象表情的示意图;

图7是本发明实施例三提供的一种表情重定向方法的流程图;

图8是本发明实施例三提供的一种目标神经网络的训练示意图;

图9是本发明实施例三提供的一种主播驱动虚拟形象表情的示意图;

图10是本发明实施例四提供的一种表情重定向装置的模块结构示意图;

图11是本发明实施例五提供的一种计算机设备的结构示意图。

具体实施方式

下面结合附图和实施例对本发明作进一步的详细说明。可以理解的是,此处所描述的具体实施例仅仅用于解释本发明,而非对本发明的限定。另外还需要说明的是,为了便于述,附图中仅示出了与本发明相关的部分而非全部结构。

在更加详细地讨论示例性实施例之前应当提到的是,一些示例性实施例被描述成作为流程图描绘的处理或方法。虽然流程图将各项操作(或步骤)描述成顺序的处理,但是其中的许多操作可以被并行地、并发地或者同时实施。此外,各项操作的顺序可以被重新安排。当其操作完成时所述处理可以被终止,但是还可以具有未包括在附图中的附加步骤。所述处理可以对应于方法、函数、规程、子例程、子程序等等。

实施例一

图1是本发明实施例一提供的一种表情重定向方法的流程图,本实施例可适用于主播在直播间中驱动虚拟形象表情的情况,该方法可以由本发明任意实施例提供的表情重定向装置来执行,该装置可由硬件和/或软件组成,并一般可集成在计算机设备。

如图1所示,本实施例提供的表情重定向方法,包括以下步骤:

S110、实时获取直播视频帧中的人脸图像,并根据标准表情基组确定与所述人脸图像对应的标准表情系数。

直播视频帧,指的是在直播间中获取的视频数据中的视频帧。可选的,直播视频帧可以是利用单个摄像头获取的单视角直播视频帧。直播视频帧中的人脸图像,指的是直播间主播的人脸图像。

其中,表情基组是有多个表情基构成的,不同的表情基代表不同的表情。如图2所示的表情基组中包括15个表情基,每个表情基代表不同的表情。可选的,每个表情基是一个可变形网络。

标准表情基组,指的是标准模型库中的表情驱动模块所使用的通用表情基组,包括多个用于代表不同表情的标准表情基(或者称通用表情基)。标准模型库例如可以是3DMM(3d Morphable Model,三维形变模型),如图3所示。

针对实时获取到的一个直播视频帧中的人脸图像,表情驱动模块根据标准表情基组学习与所述人脸图像对应的标准表情系数。根据标准表情系数组合标准表情基组中的各个标准表情基,即可组合出与人脸图像对应的网络数据(如3D网格数据),其中,网格数据所代表的表情与人脸图像所代表的表情是一致的。需要指出是,由于标准表情基组包含的通用表情基的数量为多个,则标准表情系数也是由分别与各个通用表情基对应的多个系数构成的。

S120、确定与所述标准表情系数对应的个性化表情系数,其中,所述个性化表情系数与预先生成的目标个性化虚拟形象表情基组是匹配的。

个性化虚拟形象表情基组,指的与虚拟形象对应的具有个性化人脸表情特征的表情基组,用于生成虚拟形象的个性化表情。不同个性化虚拟形象表情基组对应的个性化人脸表情特征是不同的。

目标个性化虚拟形象表情基组,可以是指任意一个预先生成的个性化虚拟形象表情基组。在本实施例中,与目标个性化虚拟形象表情基组对应的个性化虚拟形象即为主播希望驱动的个性化虚拟形象,也即代替主播自身形象进行虚拟直播的形象。

其中,可以为每个个性化虚拟形象表情基组设置人脸身份标识,用于唯一标识个性化虚拟形象表情基组。

可选的,个性化虚拟形象表情基组是在个性化模特的多视角视频数据中拆解得到的。其中,在通过多个摄像头在多个角度录制个性化模特的多视角视频数据的过程中,可以让个性化模特做出大量的个性化表情,例如可以让个性化模特通过朗读一段特定的文字而做出大量的个性化表情,以此尽可能地捕捉到个性化模特丰富的面部表情动作。不同的个性化虚拟形象表情基组可以在不同的个性化模特的多视角视频数据中拆解得到。

作为一种可选的实施方式,在实时获取直播视频帧中的人脸图像之前,还可以包括:响应于个性化虚拟形象选择请求,确定与所述个性化虚拟形象选择请求匹配的预先生成的所述目标个性化虚拟形象表情基组。

个性化虚拟形象选择请求,指的是直播间主播发起的用于选择个性化虚拟形象的请求。在接收到个性化虚拟形象选择请求之后,在多个预先生成的多个个性化虚拟形象表情基组中选取与个性化虚拟形象选择请求中携带信息匹配的一个个性化虚拟形象表情基组作为目标个性化虚拟形象表情基组。

可选的,个性化虚拟形象选择请求中可以携带个性化虚拟形象表情基组的人脸身份标识。进而,在接收到个性化虚拟形象选择请求之后,解析个性化虚拟形象选择请求,确定个性化虚拟形象选择请求中携带的目标人脸身份标识,并根据目标人脸身份标识获取对应的个性化虚拟形象表情基组作为目标个性化虚拟形象表情基组。

在生成与所述人脸图像对应的标准表情系数之后,确定与该标准表情系数对应的个性化表情系数,该个性化表情系数与目标个性化虚拟形象表情基组是匹配的,将个性化表情系数使用到目标个性化虚拟形象表情基组上,不会出现虚拟形象不自然的问题。

其中,根据标准表情系数确定对应个性化表情系数的方式,与目标个性化虚拟形象表情基组的生成方式有关。目标个性化虚拟形象表情基组的生成方式不同,根据标准表情系数确定对应个性化表情系数的方式也就不同。

例如,若目标个性化虚拟形象表情基组与标准表情基组的语义是一致的,则可以将标准表情系数直接作为对应的个性化表情系数;若目标个性化虚拟形象表情基组与标准表情基组的语义是不一致的,则需要在标准表情系数进行调整以得到对应的个性化表情系数。

S130、将所述个性化表情系数使用到所述目标个性化虚拟形象表情基组上,以驱动与所述目标个性化虚拟形象表情基组对应的个性化虚拟形象的表情。

在得到与目标个性化虚拟形象表情基组匹配的个性化表情系数之后,将个性化表情系数使用到目标个性化虚拟形象表情基组,也即根据个性化表情系数对目标个性化虚拟形象表情基组中各个虚拟形象表情基进行组合,即可生成与人脸图像一致表情的虚拟形象。

针对实时获取的连续多个直播视频帧中的人脸图像,分别执行生成标准表情系数、确定与标准表情系数对应的个性化表情系数,并将个性化表情系数使用到所述目标个性化虚拟形象表情基组上的操作,即可实现直播间主播对与目标个性化虚拟形象表情基组对应的个性化虚拟形象表情的驱动。

在本发明实施例提供的技术方案中,在预先生成的目标个性化虚拟形象表情之后,实时获取直播视频帧中的人脸图像,并根据标准表情基组确定与人脸图像对应的标准表情系数,然后将与标准表情系数对应的个性化表情系数使用到目标个性化虚拟形象表情基组上,以驱动与目标个性化虚拟形象表情基组对应的个性化虚拟形象的表情。由于与标准表情系数对应的个性化表情系数是与目标个性化虚拟形象表情基组匹配的,故将该个性化表情系数使用到目标个性化虚拟形象表情基组而得到的虚拟形象表情不会存在不自然的问题,使重定向到虚拟形象上的表情更加生动自然。

实施例二

图4是本发明实施例二提供的一种表情重定向方法的流程图,本实施例在上述实施例的基础上提供了一种可选的实施方式,其中,在实时获取直播视频帧中的人脸图像之前,还可以包括:

获取包括多种面部表情动作的多视角视频数据,并确定所述多视角视频数据中的主视角视频数据;

根据所述标准表情基组确定与所述主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数;

根据与所述多视角视频数据对应的三维网格流数据、与所述每个视频帧中的人脸图像分别对应的标准表情系数,以及表情基组模板,拆解得到所述目标个性化虚拟形象表情基组。

如图4所示,本实施例提供的表情重定向方法,包括以下步骤:

S210、获取包括多种面部表情动作的多视角视频数据,并确定所述多视角视频数据中的主视角视频数据。

其中,多视角视频数据是通过多个摄像头在多个角度拍摄个性化模特而生成的。主视角视频数据是指通过个性化模特正面的摄像头拍摄得到的视频数据。

例如,可以让个性化模特做出大量的个性化表情,如通过朗读一段特定的文字而做出大量的个性化表情,以使多视角视频数据尽可能地捕捉到个性化模特丰富的面部表情动作。

S220、根据标准表情基组确定与主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数。

对与主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数进行确定,例如可以通过3DMM库的表情驱动模块根据标准表情基组学习与主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数。

可选的,通过3DMM库的表情驱动模块根据标准表情基组根据主视角视频数据中的第一个视频帧学习与主视角视频数据的对应人脸身份,并将与该人脸身份对应的人脸身份标识作为与其对应的个性化虚拟形象表情基组的人脸身份标识。

S230、根据与多视角视频数据对应的三维网格流数据、与每个视频帧中的人脸图像分别对应的标准表情系数,以及表情基组模板,拆解得到所述目标个性化虚拟形象表情基组。

对多视角视频数据进行三维重建,将三维重建后的网格数据进行后处理后得到与多视角视频数据对应的3D网格流数据。其中,在对三维重建后的网格数据进行后处理时,可以对与每个视频帧对应的网格点数适量减少(例如从100万个左右网格点减少到4万左右个网格点),并保持不同视频帧对应的所有网格点的语义是一致的,由此可以得到与多视角视频数据对应的拓扑一致低面数的3D网格流数据。

表情基组模板,指的是用于进行表情基拆解的模板。在本实施例中,表情基组模板例如可以是与标准表情基组对应的表情基组模板。

在表情基组模板的基础上,将与多视角视频数据对应的三维网格流数据,以及与主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数作为训练样本进行目标个性化虚拟形象表情基组的拆解。

可选的,利用EBFR(Example-Based Facial Rigging)算法在表情基组模板的基础上,将与多视角视频数据对应的三维网格流数据,以及与主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数作为训练样本进行目标个性化虚拟形象表情基组的拆解。如图5所示,将多视角视频序列中主视角视频序列输入基于3DMM库的表情驱动模块,学习到与主视角视频序列对应的标准表情系数;将多视角视频序列输入到三维重建模块,得到拓扑一致低面数的3D网格流数据;通过EBFR算法拆解模块在表情基组模板的基础上,将3D网格流数据与标准表情系数作为训练样本进行拆解,得到目标个性化虚拟形象表情基组。

其中,在执行EBFR算法的过程中,每次迭代更新时保持表情系数固定不变,也即与主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数不变,只优化个性化虚拟形象表情基的网格顶点位置,当算法收敛时即可得到目标个性化虚拟形象表情基组。

基于EBFR算法拆解得到的目标个性化虚拟形象表情基组,根据与主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数,就可以完美地组合出与主视角视频数据的每个视频帧对应的拓扑一致的3D网格数据。

S240、实时获取直播视频帧中的人脸图像,并根据标准表情基组确定与所述人脸图像对应的标准表情系数。

S250、确定与标准表情系数对应的个性化表情系数。

针对预先拆解得到的目标个性化虚拟形象表情基组,确定与标准表情系数对应的个性化表情系数,也即确定与目标个性化虚拟形象表情基组匹配的个性化表情系数,将个性化表情系数使用到目标个性化虚拟形象表情基组上,不会出现虚拟形象不自然的问题。

可选的,确定与所述标准表情系数对应的个性化表情系数,可以具体为:将所述标准表情系数作为所述个性化表情系数。

在本实施例中,由于目标个性化虚拟形象表情基组是在与多视角视频数据对应的三维网格流数据的基础上,结合根据标准表情基组确定的标准表情系数拆解来的,则目标个性化虚拟形象表情基组与根据标准表情基组确定的标准表情系数是匹配的,因此可以将根据标准表情基组确定的标准表情系数直接迁移到目标个性化虚拟形象表情基组,实现对与目标个性化虚拟形象表情基组对应的个性化虚拟形象的表情驱动,不会出现虚拟形象不自然的问题。

进一步的,还可以对所述标准表情系数进行细微调整后,并将细微调整后的表情系数作为对应的个性化表情系数,以进一步突出虚拟形象表情的个性化程度。

S260、将所述个性化表情系数使用到所述目标个性化虚拟形象表情基组上,以驱动与所述目标个性化虚拟形象表情基组对应的个性化虚拟形象的表情。

参照图6,在得到与标准表情基组语义一致的目标个性化虚拟形象表情基组之后,在直播端使用时可以利用单个摄像头获取单视角主播图像,并输入到基于3DMM库的表情驱动模块中得到标准表情系数,然后将该标准表情系数直接用到拆解好的目标个性化虚拟形象表情基组上,即可达到主播驱动与目标个性化虚拟形象表情基组对应的虚拟形象的目的。

本实施例未尽详细解释之处请参见前述实施例,在此不再赘述。

本实施例提供的技术方案,从表情基拆解的角度入手能够更加有效地实现表情重定向,且拆解得到的个性化虚拟形象表情基与表情驱动模块使用的标准表情基的语义是一致的。因为表情基拆解过程中有大量训练数据,每一帧重组的拓扑一致网格数据都由使用标准表情基组的表情驱动模块直接给出,保证了将表情驱动模块使用标准表情基组得到标准表情系数迁移到个性化虚拟形象表情基组上会使虚拟形象表情更加生动自然。

同时,在生成个性化虚拟形象表情基时,无需手工设计,只需要基于真人模特提前录制一段表情丰富的视频数据,通过算法拆解自动生成,制作成本低且个性化特点多。上述技术方案摆脱了繁杂的人工介入成本,提高了虚拟形象的重定向效率,降低了虚拟直播的技术门槛。直播间主播仅需一个摄像头,就可以实时驱动任意虚拟形象做出对应的表情,提升了虚拟主播和观众的交互。基于上述技术方案,千人千面将会成为现实,每个主播都可以根据自己的喜好来把自己的喜怒哀乐表情在不同的虚拟形象主播上真实呈现,极大地丰富直播的娱乐性和趣味性。

实施例三

图7是本发明实施例三提供的一种表情重定向方法的流程图,本实施例在上述实施例的基础上提供了另一种可选的实施方式,其中,在实时获取直播视频帧中的人脸图像之前,还包括:

获取包括多种面部表情动作的多视角视频数据中的多个图像帧;

根据与所述多个图像帧对应的三维网格流数据,以及表情基组模板,拆解得到所述目标个性化虚拟形象表情基组。

如图7所示,本实施例提供的表情重定向方法,包括以下步骤:

S310、获取包括多种面部表情动作的多视角视频数据中的多个图像帧。

其中,多视角视频数据是通过多个摄像头在不同角度拍摄个性化模特而生成的。

例如,可以让个性化模特做出大量的个性化表情,如通过朗读一段特定的文字而做出大量的个性化表情,以使多视角视频数据尽可能地捕捉到个性化模特丰富的面部表情动作。

可选的,多个图像帧指的是在多视角视频数据中的不同视角视频数据中时序相同的多个图像序列。

S320、根据与多个图像帧对应的三维网格流数据,以及表情基组模板,拆解得到所述目标个性化虚拟形象表情基组。

在本实施例中,拆解得到所述目标个性化虚拟形象表情基组,只需要几个图像帧即可,无需拍摄得到的多视角视频数据中的所有视频帧。

对多个图像帧进行三维重建,将三维重建后的网格数据进行后处理后得到与多个图像帧对应的3D网格流数据。

表情基组模板,指的是用于进行表情基拆解的模板。在本实施例中,表情基组模板例如可以是与标准表情基组对应的表情基组模板。

在表情基组模板的基础上,将与多个图像帧对应的三维网格流数据作为训练样本进行目标个性化虚拟形象表情基组的拆解。可选的,利用EBFR算法在表情基组模板的基础上,根据与多个图像帧对应的三维网格流数据进行目标个性化虚拟形象表情基组的拆解。

S330、实时获取直播视频帧中的人脸图像,并根据标准表情基组确定与所述人脸图像对应的标准表情系数。

S340、确定与标准表情系数对应的个性化表情系数。

在本实施例中,拆解目标个性化虚拟形象表情基组时只依据了表情基模板和多视角视频数据中的多个图像帧,得到目标个性化虚拟形象表情基组与标准表情系数并不匹配,因此,需要对标准表情系数进行一定的处理,得到与目标个性化虚拟形象表情基组匹配的个性化表情系数。

可选的,所述确定与所述标准表情系数对应的个性化表情系数,可以具体为:将所述标准表情系数映射成所述个性化表情系数。

在根据标准表情基组学习到与所述人脸图像对应的标准表情系数之后,将该标准表情系数映射成与目标个性化虚拟形象表情基组匹配的个性化表情系数,再将个性化表情系数使用到目标个性化虚拟形象表情基组上,不再会出现虚拟形象不自然的问题。

示例性的,如果能够建立标准表情基组与目标个性化虚拟形象表情基组之间的映射关系,则可以根据该映射关系以及所述标准表情系数得到对应的个性化表情系数。

作为一种可选的实施方式,所述将所述标准表情系数映射成所述个性化表情系数,可以具体为:

将所述标准表情系数输入目标神经网络中,通过所述目标神经网络输出所述个性化表情系数;其中,所述目标神经网络是基于表情系数训练数据预先训练而生成的;所述表情系数训练数据包括:根据所述标准表情基组确定与所述多视角视频数据中主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数,以及根据所述目标个性化虚拟形象表情基组确定的与所述多视角视频数据的每个视频帧中的人脸图像分别对应的个性化表情系数。

参照图8,对与多视角视频数据中主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数进行确定,例如可以通过3DMM库的表情驱动模块根据标准表情基组学习与主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数。

可选的,通过3DMM库的表情驱动模块根据标准表情基组根据主视角视频数据中的第一个视频帧学习与主视角视频数据的对应人脸身份,并将与该人脸身份对应的人脸身份标识作为与其对应的个性化虚拟形象表情基组的人脸身份标识。

对与多视角视频数据中主视角视频数据的每个视频帧中的人脸图像分别对应的个性化表情系数进行确定,例如可以通过表情驱动模块根据通过S320拆解得到的目标个性化虚拟形象表情基组学习与多视角视频数据的每个视频帧中的人脸图像分别对应的个性化表情系数。

在对目标神经网络进行训练时,可以将与主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数作为输入,将与主视角视频数据的每个视频帧中的人脸图像分别对应的个性化表情系数作为标签。当目标神经网络输入与主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数,输出的表情系数和与主视角视频数据的每个视频帧中的人脸图像分别对应的个性化表情系数之间的误差小于预设误差阈值时,目标神经网络训练完成。可选的,目标神经网络可以任意一种人工神经网络模型。

当将根据标准表情基组确定的与实时获取直播视频帧中的人脸图像对应的标准表情系数输入到训练完成的目标神经网络中后,通过目标神经网络的表情系数映射,即可输出对该标准表情系数对应的个性化表情系数。

可选的,在根据目标个性化虚拟形象表情基组学习个性化表情系数时,除了依据主视角视频数据的每个视频帧,还可以依据与多视角视频数据对应的三维点云数据,以此提高学习到的个性化表情系数的精准度。进而,使用个性化表情系数作为标签对目标神经网络进行训练时,也能提高目标神经网络将标准表情系数映射成个性化表情系数的精准度。

由于在实际应用中,输入目标神经网络中的标准表情系数是仅根据通过单个摄像头采集的直播视频帧确定的表情系数,故为了保持目标神经网络的精准性,训练目标神经网络时,也是采用与主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数作为输入。

S350、将所述个性化表情系数使用到所述目标个性化虚拟形象表情基组上,以驱动与所述目标个性化虚拟形象表情基组对应的个性化虚拟形象的表情。

参照图9,在得到目标个性化虚拟形象表情基组之后,在直播端使用时可以利用单个摄像头获取单视角主播图像,并输入到基于3DMM库的表情驱动模块中得到标准表情系数,然后将该标准表情系数输入到目标神经网络中得到对应的个性化表情系数,再将该个性化表情系数用到拆解好的目标个性化虚拟形象表情基组上,即可达到主播驱动与目标个性化虚拟形象表情基组对应的虚拟形象的目的。

本实施例未尽详细解释之处请参见前述实施例,在此不再赘述。

本实施例提供的技术方案,在学习到标准表情系数之后,通过目标神经网络自动生成成对的个性化表情系数,以此保证了语义幅度的一致性,当再将个性化表情系数使用到目标个性化虚拟形象表情基上时不会出现虚拟形象表情不自然的问题。具体的,用户只需要借助一个基于3DMM库的表情驱动模型获得标准表情系数,通过重定向技术转换接口,就可以将表情重定向到不同的虚拟形象上面,在保证表情语义一致的情况下可以让不同的虚拟形象呈现出各自独特的表情风格,极大地丰富了表情驱动的娱乐性和功能性。

同时,在生成个性化虚拟形象表情基时,无需手工设计,只需要基于真人模特提前录制一段表情丰富的视频数据,通过算法拆解自动生成,制作成本低且个性化特点多。上述技术方案摆脱了繁杂的人工介入成本,提高了虚拟形象的重定向效率,降低了虚拟直播的技术门槛。直播间主播仅需一个摄像头,就可以实时驱动任意虚拟形象做出对应的表情,提升了虚拟主播和观众的交互。

实施例四

图10是本发明实施例四提供的一种表情重定向装置的模块结构示意图,本实施例可适用于主播在直播间中驱动虚拟形象表情的情况,该装置可以采用软件和/或硬件的方式实现,并一般可集成在计算机设备中。

如图10所示,该装置具体包括:标准表情系数确定模块410、个性化表情系数确定模块420和表情重定向模块430。其中,

标准表情系数确定模块410,用于实时获取直播视频帧中的人脸图像,并根据标准表情基组确定与所述人脸图像对应的标准表情系数;

个性化表情系数确定模块420,用于确定与所述标准表情系数对应的个性化表情系数,其中,所述个性化表情系数与预先生成的目标个性化虚拟形象表情基组是匹配的;

表情重定向模块430,用于将所述个性化表情系数使用到所述目标个性化虚拟形象表情基组上,以驱动与所述目标个性化虚拟形象表情基组对应的个性化虚拟形象的表情。

在本发明实施例提供的技术方案中,在预先生成的目标个性化虚拟形象表情之后,实时获取直播视频帧中的人脸图像,并根据标准表情基组确定与人脸图像对应的标准表情系数,然后将与标准表情系数对应的个性化表情系数使用到目标个性化虚拟形象表情基组上,以驱动与目标个性化虚拟形象表情基组对应的个性化虚拟形象的表情。由于与标准表情系数对应的个性化表情系数是与目标个性化虚拟形象表情基组匹配的,故将该个性化表情系数使用到目标个性化虚拟形象表情基组而得到的虚拟形象表情不会存在不自然的问题,使重定向到虚拟形象上的表情更加生动自然。

作为一种可选的实施方式,上述装置还包括:第一个性化虚拟形象表情基组拆解模块,用于在实时获取直播视频帧中的人脸图像之前,获取包括多种面部表情动作的多视角视频数据,并确定所述多视角视频数据中的主视角视频数据;根据所述标准表情基组确定与所述主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数;根据与所述多视角视频数据对应的三维网格流数据、与所述每个视频帧中的人脸图像分别对应的标准表情系数,以及表情基组模板,拆解得到所述目标个性化虚拟形象表情基组。

进一步的,个性化表情系数确定模块420,具体用于将所述标准表情系数作为所述个性化表情系数。

作为另一种可选的实施方式,上述装置还包括:第二个性化虚拟形象表情基组拆解模块,用于在实时获取直播视频帧中的人脸图像之前,获取包括多种面部表情动作的多视角视频数据中的多个图像帧;根据与所述多个图像帧对应的三维网格流数据,以及表情基组模板,拆解得到所述目标个性化虚拟形象表情基组。

进一步的,个性化表情系数确定模块420,具体用于将所述标准表情系数映射成所述个性化表情系数。

可选的,个性化表情系数确定模块420,具体用于将所述标准表情系数输入目标神经网络中,通过所述目标神经网络输出所述个性化表情系数;其中,所述目标神经网络是基于表情系数训练数据预先训练而生成的;所述表情系数训练数据包括:根据所述标准表情基组确定与所述多视角视频数据中主视角视频数据的每个视频帧中的人脸图像分别对应的标准表情系数,以及根据所述目标个性化虚拟形象表情基组确定的与所述多视角视频数据的每个视频帧中的人脸图像分别对应的个性化表情系数。

可选的,上述装置还包括:个性化虚拟形象选择模块,用于在实时获取直播视频帧中的人脸图像之前,响应于个性化虚拟形象选择请求,确定与所述个性化虚拟形象选择请求匹配的预先生成的所述目标个性化虚拟形象表情基组。

本发明实施例所提供的表情重定向装置可执行本发明任意实施例所提供的表情重定向方法,具备执行方法相应的功能模块和有益效果。

实施例五

图11是本发明实施例五提供的一种计算机设备的结构示意图,如图11所示,该计算机设备包括处理器50、存储器51、输入装置52和输出装置53;计算机设备中处理器50的数量可以是一个或多个,图11中以一个处理器50为例;计算机设备中的处理器50、存储器51、输入装置52和输出装置53可以通过总线或其他方式连接,图11中以通过总线连接为例。

存储器51作为一种计算机可读存储介质,可用于存储软件程序、计算机可执行程序以及模块,如本发明实施例中的表情重定向方法对应的程序指令/模块(例如,图10中表情重定向装置中的标准表情系数确定模块410、个性化表情系数确定模块420和表情重定向模块430)。处理器50通过运行存储在存储器51中的软件程序、指令以及模块,从而执行计算机设备的各种功能应用以及数据处理,即实现上述的表情重定向方法。

存储器51可主要包括存储程序区和存储数据表区,其中,存储程序区可存储操作系统、至少一个功能所需的应用程序;存储数据表区可存储根据计算机设备的使用所创建的数据等。此外,存储器51可以包括高速随机存取存储器,还可以包括非易失性存储器,例如至少一个磁盘存储器件、闪存器件、或其他非易失性固态存储器件。在一些实例中,存储器51可进一步包括相对于处理器50远程设置的存储器,这些远程存储器可以通过网络连接至计算机设备。上述网络的实例包括但不限于互联网、企业内部网、局域网、移动通信网及其组合。

输入装置52可用于接收输入的数字或字符信息,以及产生与计算机设备的用户设置以及功能控制有关的键信号输入。输出装置53可包括显示屏等显示设备。

实施例六

本发明实施例六还提供一种存储有计算机程序的计算机可读存储介质,计算机程序在由计算机处理器执行时用于执行一种表情重定向方法,该方法包括:

实时获取直播视频帧中的人脸图像,并根据标准表情基组确定与所述人脸图像对应的标准表情系数;

确定与所述标准表情系数对应的个性化表情系数,其中,所述个性化表情系数与预先生成的目标个性化虚拟形象表情基组是匹配的;

将所述个性化表情系数使用到所述目标个性化虚拟形象表情基组上,以驱动与所述目标个性化虚拟形象表情基组对应的个性化虚拟形象的表情。

当然,本发明实施例所提供的存储有计算机程序的计算机可读存储介质,其计算机程序不限于如上的方法操作,还可以执行本发明任意实施例所提供的表情重定向方法中的相关操作。

通过以上关于实施方式的描述,所属领域的技术人员可以清楚地了解到,本发明可借助软件及必需的通用硬件来实现,当然也可以通过硬件实现,但很多情况下前者是更佳的实施方式。基于这样的理解,本发明的技术方案本质上或者说对现有技术做出贡献的部分可以以软件产品的形式体现出来,该计算机软件产品可以存储在计算机可读存储介质中,如计算机的软盘、只读存储器(Read-Only Memory,ROM)、随机存取存储器(RandomAccess Memory,RAM)、闪存(FLASH)、硬盘或光盘等,包括若干指令用以使得一台计算机设备(可以是个人计算机,服务器,或者网络设备等)执行本发明各个实施例的方法。

值得注意的是,上述表情重定向装置的实施例中,所包括的各个单元和模块只是按照功能逻辑进行划分的,但并不局限于上述的划分,只要能够实现相应的功能即可;另外,各功能单元的具体名称也只是为了便于相互区分,并不用于限制本发明的保护范围。

注意,上述仅为本发明的较佳实施例及所运用技术原理。本领域技术人员会理解,本发明不限于这里的特定实施例,对本领域技术人员来说能够进行各种明显的变化、重新调整和替代而不会脱离本发明的保护范围。因此,虽然通过以上实施例对本发明进行了较为详细的说明,但是本发明不仅仅限于以上实施例,在不脱离本发明构思的情况下,还可以包括更多其他等效实施例,而本发明的范围由所附的权利要求范围决定。

- 表情重定向方法、装置、设备和介质

- 表情推荐模型的训练、表情推荐方法、装置、设备及介质