一种基于深度学习的多模态扩散光学层析成像重建方法

文献发布时间:2023-06-19 11:42:32

技术领域

本发明属于医学图像处理领域,涉及一种基于深度学习的多模态扩散光学层析成像重建方法。

背景技术

扩散光学层析成像(Diffusion optical tomography,DOT)是一种新兴的非侵入性光学成像技术,该技术的主要依据是生物体内不同的组织内血氧、血红蛋白及水等物质含量有所差异,从而导致不同组织对近红外光的吸收系数μ

相比其他医学成像模态,扩散光学层析成像具有成像时间短、非侵入、无损伤、成像深度深、特异性强、能获得待测组织的功能信息和结构等优点[2-4]。但在DOT图像重建中,由于光在生物组织中的传播受到介质的强散射特性的影响,加之测量值数量有限,导致DOT图像重建具有严重的病态性和不适定性。以X射线、超声以及核磁共振成像(MagneticResonance Imaging,MRI)等高分辨率成像技术提供结构信息引导的DOT图像重建[5-7],具有较高的计算效率和重建图像精度;但此过程需要精准分割其他成像模态所提供的结构图像,导致重建结果很大程度依赖于分割精度,例如目前乳腺图像大多数是由人工分割的,这十分耗费人力和资源。

得益于神经网络和深度学习技术快速发展,为生物医学成像领域带来了新的研究思路。[8]中的U-net神经网络实现了医学图像的自动分割,但仍需将分割结果结合到后续的重建工作中,并未实现光学信号到图像域的端到端直接重建。[9]将两层的神经网络应用到DOT图像重建中,但该方法的重建结果只能粗略定位异常区位置,且需要分别训练两个神经网络;[10]提出了基于卷积神经网络的DOT图像重建方法,该方法的网络输出仅为仿体吸收系数和散射系数的单个数值,而非整个待重建区域的光学参数分布,同样没有实现直接从探测器采集的光学信号到图像域的端到端重建。因此,如何将其他模态与光学信号进行融合实现端到端的光学特征参数直接重建变得十分有意义。

参考文献:

[1]郭伟.生物自发荧光断层成像的稀疏重建方法研究[D].北京工业大学,2013.

[2]Alex H.Barnett,Joseph P.Culver,A,Gregory Sorensen,Anders Dale,David A.Boas.Robust inference ofbaseline optical properties ofthe human headwith three-dimensional segmentation frommagneticresonanceimaging.AppliedOptics,2003,42(16):3095~3108.

[3]汪立宏,吴新一.生物医学光学原理和成像[M].安徽:中国科学技术大学出版社,2017:229.

[4]David,A,Boas.,et al.,Diffuse optical imaging ofbrain activation:approaches to optimizing image sensitivity,resolution,andaccuracy[J].Neuroimage,2004.

[5]Althobaiti M.,et al.,Diffuse optical tomography reconstructionmethod using ultrasound images as prior for regularization matrix[J].Journalof biomedical optics,2017,22(2):026002.1-026002.9.

[6]Zhang L.,et al.,Direct regularization from co-registeredcontrastMRI improves image quality of MRI-guided near-infrared spectraltomography of breast lesions.[J].IEEE Transactions on Medical Imaging,2018.37(5):1247-1252.

[7]Carpenter C M.,et al.,Methodology development for three-dimensional MR-guided near infrared spectroscopy ofbreasttumors[J].OpticsExpress,2008,16(22):17903-17914.

[8]Hu X,Yang H.,DRU-net:a novel U-net for biomedical imagesegmentation.[C].IEEE Transactions onMedical Imaging,2020.

[9]LI,T.,W.LI and Z.QIAN,Near-infrared optical tomography imagereconstruction approach based on two-layered BP neural network[J].JournalofInnovative Optical Health Sciences,2009.2(2):p.143-147.

[10]Sabir,S.,et al.,Convolutional neural network-based approach toestimate bulk optical properties in diffuse opticaltomography[J].AppliedOptics,2020.59(5):1461.

发明内容

·发明目的

本发明立足现有研究的不足,提出了一种将核磁共振成像与光学信号进行深度融合的多模态扩散光学层析成像重建方法。本发明利用核磁共振成像可为DOT图像重建提供结构信息的优点,以及神经网络强大的非线性映射能力,构建Z-Net神经网络将核磁共振成像与光学信号进行融合,避免对核磁共振成像提供的结构图像进行分割,直接实现端到端的光学特性参数重建。

·发明方案

本发明要解决的技术问题是如何将光学信号与核磁共振成像进行融合实现端到端的光学特征参数直接重建。

为解决上述技术问题本发明采取了如下技术方案:首先分析并构建本发明的模型结构Z-Net,再通过PyTorch框架对模型进行实现,然后设计仿真实验模拟肿瘤情况,在训练过程中选择合适的网络参数,并测试本发明的模型性能,验证本发明对DOT重建的表现。

扩散光学层析成像的前向过程为在光学参数分布已知的情况下,根据扩散近似方程求解出边界测量值Φ。本发明将光学信号以及对应的核磁共振图像作为Z-Net神经网络的两个输入,网络最终输出光学特征参数分布图。

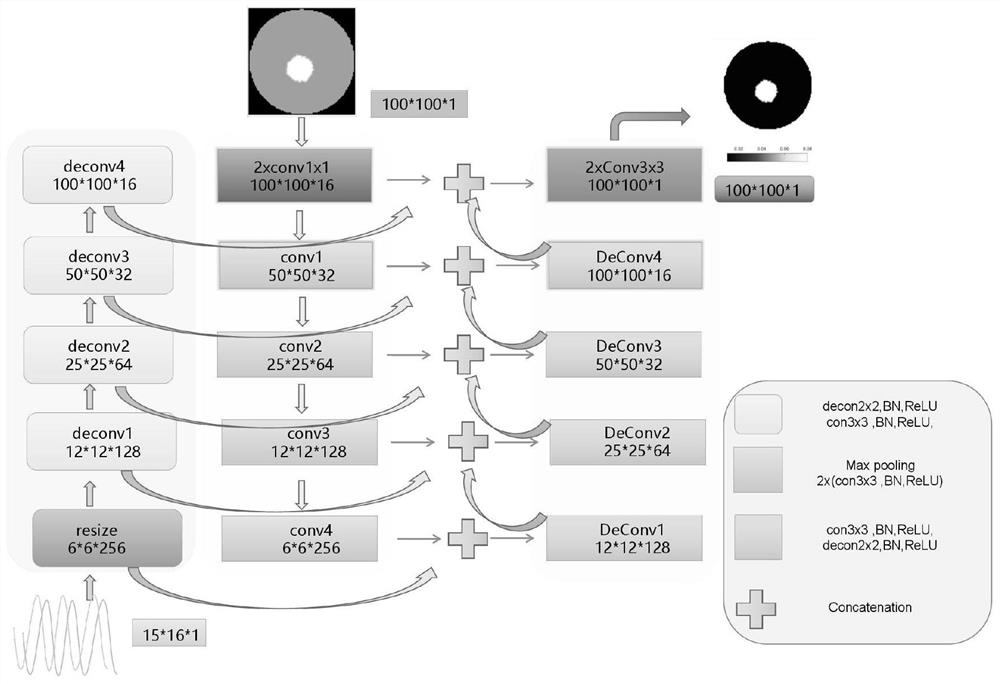

本发明所构建的Z-Net网络结构如图1所示,包括以下操作:

步骤1、光学信号

首先下采样的实现过程为:

其中

每层上采样操作包括反卷积操作和卷积操作,以及BN和ReLU处理,其中,每层上采样的输出为:

其中

步骤2、核磁共振图像m作为网络的第二个输入,先通过卷积操作改变通道数,然后进行四层下采样,最终获取核磁共振图像的结构信息;

首先卷积操作实现过程为:

ψ

其中ψ

每层下采样包括两步卷积操作以及最大池化操作,以及BN和ReLU处理,其中,每层下采样的输出为:

ψ

其中ψ

步骤3、经步骤1得到的光学信号的特征与步骤2得到的结构特征用跳连接结合进行融合后,进行上采样操作,最终输出光学特性参数图像,并且要保证融合的特征之间具有相同结构;其中

其中φ

最终经过四层融合后将输出φ

本发明为了验证所提方法的可行性和有效性,进行了一系列仿真实验。实验使用直径为80mm的二维圆形仿体用来生成数据集,沿模型的圆周均匀地放置了共16个光源和16个检测器,在每个光源进行照射时,在其余15个位置上的检测器收集数据,每次得到240个(16×15)测量值,光源探测器位置如图2所示;本发明所用的MRI图像通过计算机仿真产生,每张MRI图像具有与对应近红外光图像相同的结构、仿体大小以及异常区大小,如图3所示。最后将数据集中单异常区样本和双异常区样本混合,共7000个样本,其中5000个样本进行网络训练,1000个用于验证,1000个用于测试,在训练过程中设置迭代次数epoch=150,学习率η=0.005,batch_size=128,采用Adam优化器以及MSE损失函数。

本发明构建Z-Net神经网络将光学信号与核磁共振图像同时作为网络输入,通过网络训练直接建立光学信号与光学特性参数之间的非线性关系,实现光学信号到光学特性参数的端到端重建,而无需构建描述光子在生物组织内传输规律的数学模型,也不需要对核磁共振图像进行图像分割处理。

·发明效果

本发明的两组重建结果如图4和图5所示。其中图4为单异常区情况下的重建结果,包括不同异常区位置、不同的异常区尺寸和不同的吸收系数,第一行为吸收系数的真实分布,第二行为本发明重建结果,对比可知本发明较为准确的重建出异常区形状和位置,并且具有较高的重建精度。图5展示了具有不同吸收系数值的双异常区重建结果,本发明同样表现出较高的重建精度。

附图说明

图1为Z-Net网络结构。

图2为光源及探测器的位置。

图3为仿真MRI灰度值设置示意图。

图4为具有不同大小和不同吸收系数值的单异常区重建图像。

图5为具有不同吸收系数值的双异常区重建图像。

- 一种基于深度学习的多模态扩散光学层析成像重建方法

- 一种基于模型的深度学习扩散光学层析成像方法