一种智能舌面象数据采集系统及方法

文献发布时间:2023-06-19 12:00:51

技术领域

本申请涉及舌诊仪的技术领域,具体而言,涉及一种智能舌面象数据采集系统及一种智能舌面象数据采集方法。

背景技术

随着现代城市生活的不断发展,人们的工作生活节奏逐渐加快,压力以及其引起的健康问题也随之而来。于此同时,社会也面临人口老龄化带来的居家空巢老人健康管理的问题。因此,对日常生活中的健康数据追踪、疾病的管理和预测变得尤为重要。而中医中的“望诊”诊断方法,能够很好的实现日常家庭健康管理。

而现有的家庭健康管理相关设备成本高昂,且均处于实验室研究阶段,未能够得到实际应用。比如:上海中医药大学许家佗教授针对中医望诊图像的采集条件进行了实验探究,得出参与望诊的图像可以通过光源的干预调整来提高图像成像,但其自主研发的TDA-1型舌诊仪多用于高校研究,暂未投入市场。

又如:上海道生医疗科技有限公司研发生产的DS01-B型舌诊仪,使用1500M像素的图像传感器与OSRAM全光谱L18/72965BIOLUX标准光源,可运用深度学习方法分析50多种舌面部特征。但这种舌诊仪不仅价格昂贵,而且对外界环境中光照条件的要求较严格,并不适合全民普及。

发明内容

本申请的目的在于:解决现有舌诊仪的成本昂贵、不够便捷智能的问题,利用人工智能和云计算技术,实现便捷的个人数据划分、以及基于深度学习的舌象检测,建立适用于日常家庭健康管理的、低成本的舌面象信息数据库。

本申请第一方面的技术方案是:提供了一种智能舌面象数据采集系统,系统包括:智能终端和服务器;智能终端内设置有图像传感器,智能终端用于获取用户的人脸图像,并将人脸图像发送至服务器;服务器用于根据人脸图像和存储的用户基本信息,对当前用户进行验证,当验证通过后向智能终端发送舌象图像采集指令,并确定人脸图像的舌部位置,并根据舌部位置对应的像素信息,计算直方图特征,并对直方图特征进行降维处理,生成用户特征向量,根据用户特征向量与样本特征向量之间的欧几里得向量距离,确定色彩校正矩阵;智能终端还用于根据舌象图像采集指令,采集用户的舌象图像,并将舌象图像发送至服务器;服务器还用于根据色彩校正矩阵,对舌象图像进行色彩校正,并存储校正后的舌象图像。

上述任一项技术方案中,进一步地,服务器生成用户特征向量的过程,具体包括:

步骤B,根据舌象图像中的像素信息,计算舌象图像的亮度信息;

步骤C,根据舌象图像在RGB通道上的通道分量,计算通道分量在色度度量上的通道张量;

步骤D,根据亮度信息和通道张量,计算舌象图像的直方图特征;

步骤E,利用线性转换函数,从直方图特征中提取舌象图像的用户特征向量,对应的公式为:

v(h(I)

式中,vec(·)线性转换函数,v(h(I)

上述任一项技术方案中,进一步地,根据用户特征向量与样本特征向量之间的欧几里得向量距离,确定色彩校正矩阵,具体包括:当判定全部欧几里得向量距离大于距离阈值时,将预设校正矩阵作为色彩校正矩阵。

上述任一项技术方案中,进一步地,还包括:

当存在小于距离阈值的计算出的欧几里得向量距离时,选取欧几里得向量距离小于距离阈值的样本特征向量

其中,α

上述任一项技术方案中,进一步地,装置还包括:环境光强传感器和补光灯;环境光强传感器用于采集环境光照度,并将光照度发送至智能终端;智能终端用于对接收到的光照度进行数值转换,并将数值与预设阈值进行比较,当判定数值小于或等于预设阈值时,向补光灯发送补光指令;补光灯用于根据补光指令由关闭状态转换至开启状态。

上述任一项技术方案中,进一步地,根据人脸图像和存储的用户基本信息,对当前用户进行验证,具体包括:验证人脸图像是否为人脸,当验证通过后,提取人脸图像中的第一人脸,并将第一人脸映射到欧氏空间,将映射结果记作第一向量;确定人脸图像对应的智能终端的唯一设备编号id,根据唯一设备编号id在存储的用户基本信息进行查找,将查找出的用户基本信息中的第二人脸映射到欧氏空间,将映射结果记作第二向量;计算第一向量和第二向量之间的欧氏距离,当判定欧氏距离小于验证阈值时,判定当前用户通过验证。

上述任一项技术方案中,进一步地,智能终端在上传人脸图像至服务器之前,将人脸图像的命名格式设置为时间戳序号与智能终端的唯一设备编号id的组合,用户基本信息与唯一设备编号id一一绑定。

上述任一项技术方案中,进一步地,用户基本信息至少包括用户姓名、用户身高、用户体重、用户年龄、用户免冠面部图像。

上述任一项技术方案中,进一步地,样本特征向量由训练数据集中的色彩错误图像确定。

本申请第二方面的技术方案是:提供了一种智能舌面象数据采集方法,该方法包括:步骤10,获取用户的人脸图像,并根据所述人脸图像和存储的用户基本信息,对当前用户进行验证;

步骤20,当验证通过后,确定所述人脸图像的舌部位置,并根据所述舌部位置对应的像素信息,计算直方图特征,并对所述直方图特征进行降维处理,生成用户特征向量;

步骤30,根据所述用户特征向量与样本特征向量之间的欧几里得向量距离,确定色彩校正矩阵;

步骤40,根据所述色彩校正矩阵,对采集到的所述用户的舌象图像进行色彩校正,并存储所述校正后的舌象图像。

本申请的有益效果是:

本申请中的技术方案,我们利用了现有的低成本开发板,利用云计算以及人工智能的技术,实现了基于人脸识别和色彩校正技术的方便、快捷舌诊数据的采集校正设备和后端的收集。通过大量光源对舌色的影响关系的实验,我们认为6500K的光源色温对还原舌色有最好的效果,所以我们选用可调节亮度的6500K色温光源对环境光的影响进行削弱,并得到了良好的效果。

在当前用户的身份验证过程中,我们基于人脸识别算法,用户可以无感知的进入采集步骤,由服务器根据智能终端的唯一设备编号id自动获得当前用户的匹配信息进行用户身份验证,缩短了身份验证的耗时、提高了验证精度,有助于实现方便快速的舌象采集,并且将用户信息和用户采集的舌象图像,结合智能终端的唯一设备编号id进行存储归档,相较于市面上的舌诊仪,具有优秀的用户数据归类和用户数据跟踪的特色。

其次,因为开放式的采集方式补光并不能够完全避免不同的环境条件而导致色彩的真实度偏差。因此我们设计了一种色彩校正的步骤,通过前期采集的训练数据集,将训练集中色彩错误图像与采集到的舌象图像进行映射,得到特征向量,以便搜索出色彩错误图像对应的色彩转换矩阵,进而得出色彩校正矩阵对产生色彩偏差的舌象数据进行校正,并通过实验验证,证明色彩校正过程能够达到了理想的效果,保证舌象图像采集的准确性。

特别的,在色彩校正部分我们利用CIE Lab色彩空间平均色度D和色度中心距离M的比值作为偏色因子K来衡量图像的偏色程度,一般我们认为小于2的图像通常不存在偏色,偏色越严重则偏色因子越大。我们采集了20张不同环境下的舌象图像,并计算了其偏色因子用作评价我们的最后结果,其偏色因子均值K为1.8504,达到了偏色校正的目的,并能供充分满足我们的项目要求。

附图说明

本申请的上述和/或附加方面的优点在结合下面附图对实施例的描述中将变得明显和容易理解,其中:

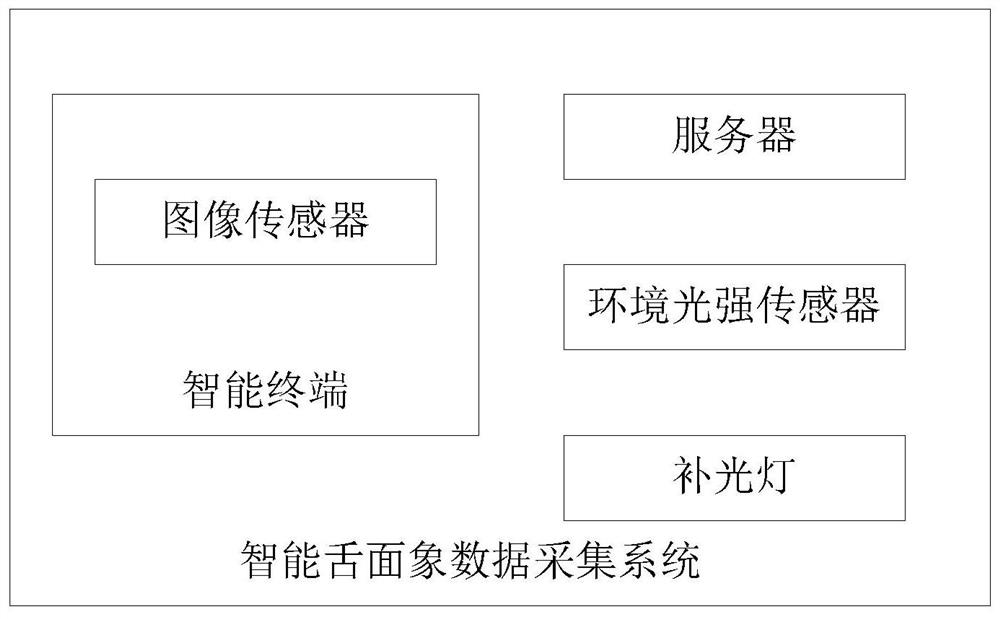

图1是根据本申请的一个实施例的智能舌面象数据采集系统的示意框图;

图2是根据本申请的一个实施例的人脸检测模型的示意图;

图3是根据本申请的一个实施例的检测出的人脸图像以及提取出的舌象图像的示意图;

图4是根据本申请的一个实施例的所采集的数据统计信息。

具体实施方式

为了能够更清楚地理解本申请的上述目的、特征和优点,下面结合附图和具体实施方式对本申请进行进一步的详细描述。需要说明的是,在不冲突的情况下,本申请的实施例及实施例中的特征可以相互结合。

在下面的描述中,阐述了很多具体细节以便于充分理解本申请,但是,本申请还可以采用其他不同于在此描述的其他方式来实施,因此,本申请的保护范围并不受下面公开的具体实施例的限制。

实施例一:

如图1所示,本实施例提供了一种智能舌面象数据采集系统,该系统包括:智能终端和服务器;智能终端内设置有处理器和图像传感器,智能终端用于获取用户的人脸图像,并将人脸图像发送至服务器;服务器用于根据人脸图像和存储的用户基本信息,对当前用户进行验证,当验证通过后向智能终端发送舌象图像采集指令,并确定人脸图像的舌部位置,并根据舌部位置对应的像素信息,计算直方图特征,并对直方图特征进行降维处理,生成用户特征向量,根据用户特征向量与样本特征向量之间的欧几里得向量距离,确定色彩校正矩阵;智能终端还用于根据舌象图像采集指令,采集用户的舌象图像,并将舌象图像发送至服务器;服务器还用于根据色彩校正矩阵,对舌象图像进行色彩校正,并存储校正后的舌象图像。

本实施例中,智能终端由Raspberry(微型电脑)实现,每一个智能终端对应一个唯一设备编号id,通过智能终端可以实现用户基本信息采集,如用户姓名、用户身高、用户体重、用户年龄、用户免冠面部图像等。智能终端在上传用户基本信息时,将用户基本信息与智能终端的唯一设备编号id进行绑定,以便基于这种绑定,服务器通过查询智能设备的唯一设备编号id,将该智能设备的所有用户提取出来进行人脸识别,找出当前使用智能设备的用户。

比如在采集过程中,可以在智能终端上嵌入一张表单,用于提交用户基本信息数据至Django服务端,在提交过程中,还将表单中的数据转换为json格式,写入数据库中。

进一步的,装置还包括:环境光强传感器和补光灯;环境光强传感器用于采集环境光照度,并将光照度发送至智能终端;智能终端用于对接收到的光照度进行数值转换,并将数值与预设阈值进行比较,当判定数值小于或等于预设阈值时,向补光灯发送补光指令;补光灯用于根据补光指令由关闭状态转换至开启状态。

本实施例中的光源装置包括MAX44009环境光强传感器和补光灯,其中,补光灯为直径26cm、色温为6500K的光圈。

每次进行数据采集前,通过MAX44009环境光强传感器获得当前环境的光照度,其通过CSI接口与智能终端连接并传输。由智能终端对接收到的光照度进行数值转换,转换为以光照度(lux)为单位的数值,将该数值于预设阈值进行比较,该预设阈值可以为2000lux,若该数值小于或等于2000lux,则由智能终端向补光灯发送补光指令,由补光灯进行补光,从而保证图像质量尽可能的接近自然光。

智能终端内设置有处理器和图像传感器,智能终端用于获取用户的人脸图像,其中,人脸图像的命名格式为“时间戳序号+唯一设备编号id”,服务器以此来进行唯一设备编号id的获取,在进行人脸识别的过程中,服务器会加载当前唯一设备编号id下的已注册用户的用户信息,进行人脸匹配,找出当前使用智能设备的用户;

本实施例中的图像传感器为IMX219 800W像素图像传感器,通过Picamera模块与智能终端实现电连接,以便进行用户的人脸数据采集,设定图像的最高分辨率为3280×2464。智能终端收到图像传感器采集到的图像后,使用jpeg格式对图像进行压缩,之后,上传至基于Django Web框架的服务器。

优选的,智能终端在上传人脸图像至服务器之前,将人脸图像的命名格式设置为时间戳序号与智能终端的唯一设备编号id的组合,用户基本信息与唯一设备编号id一一绑定,其中,以时间戳序号为主键区别。

服务器获取到智能终端上传的人脸图像后,对人脸图像的尺寸进行修改,将图像尺寸更改为224×224×3,利用基于深度学习的方法,从人脸图像中检测人脸。首先使用VGG16进行原始人脸图像的特征提取,得到特征图,将获得的特征图输入Region ProposalNetwork(RPN网络),生成相应的带有人脸的推荐区域,再将特征图和推荐区域进行综合提取推荐的特征图后,进行最后确定人脸的最终位置。

本实施例示出一种判断/验证人脸图像是否为人脸的过程,具体包括:

步骤1,基于VGG16模型和设定的卷积层参数,构建卷积层,并提取智能终端上传的人脸图像中的初始特征图feature maps,其中,卷积层参数包括卷积共有13层、卷积核为3、步长为1,层间采用ReLU激活函数,卷积层的像素填充为1,即围绕图像边填充一层0,使得卷积层不改变图像的大小。

本实施例中,ReLU激活函数对应的计算公式为:

式中,x为在神经网络传播过程中的输入值。作为优选,卷积层参数还包括最大池化层的核为2,以及步长为2。通过设定最大池化层的核以及步长,使得每个经过池化层的图像,长和宽都会变为原来的1/2,这样共4次最大池化后,若输入图像为N×M,则经过上述卷积层的特征提取后转换为N/16×M/16的固定尺寸。

步骤2,基于推荐候选区域网络,遍历初始特征图feature maps,选取最优的锚anchor,以确定人脸图像的候选区域(G′

具体的,利用Region Proposal Network(RPN)网络作为推荐候选区域网络,采用遍历的方式,遍历卷积层输出的初始特征图feature maps,为每个像素点都生成9个锚anchor,每个锚anchor用坐标(x

在确定候选区域的过程中,先对卷积层输出的初始特征图feature maps进行1×1的卷积,并设置卷积核的个数为18,以对应9个锚anchor的正样本和负样本的状态,通过softmax函数的一个二分类任务,将负样本去除,只留下正样本的锚anchor。得到正样本的锚anchor后,对窗口进行微调,窗口一般使用四维向量(x,y,w,h)表示窗口的中心点坐标还有宽和高。

在确定最优锚的过程中,假设给定锚A以及地面真值GT为:

A=(A

GT=[G

式中,(A

通过如下映射函数F,根据给定锚A进行映射,以确定候选区域(G′

(G′

s.t.(G′

其中,映射函数F对应的变换如下:

G′

G′

G′

G′

其中,d

步骤3,基于ROI pooling池化层,根据初始特征图feature maps和候选区域(G′

具体的,基于ROI pooling池化层,将卷积层输出的初始特征图feature maps均转换为固定的大小,即做一次尺寸的变换。并将候选区域对应的最优的锚anchor,映射回(N/16)×(M/16)相对应的特征图的尺度,再将每个最优的锚anchor的对应的特征图的区域水平分为w×h的网格对网格每份都进行max pooling池化层处理,最后得到7×7的特征图,将该特征图作为人脸特征图。

之后,通过全连接网络以及softmax函数,对人脸特征图(δ

B=(b

式中,矩阵W为权重矩阵,矩阵B为偏置矩阵,都是通过训练得到的参数,用于进行人脸特征图的判别分类,得到的y

本实施例中,当判定智能终端通过图像传感器采集到的当前用户的人脸图像为人脸后,服务器通过卷积神经网络学习将图像映射到欧几里得空间,并通过计算数据库中的人脸与当前用户的人脸的欧氏距离来辨别是否是同一个人。

由服务器通过上述过程验证人脸图像是否为人脸,当验证通过后,提取人脸图像中的第一人脸,并将第一人脸映射到欧氏空间,将映射结果记作第一向量;

确定人脸图像对应的智能终端的唯一设备编号id,根据唯一设备编号id在存储的用户基本信息进行查找,将查找出的用户基本信息中的第二人脸映射到欧氏空间,将映射结果记作第二向量;

计算第一向量和第二向量之间的欧氏距离,当判定欧氏距离小于验证阈值时,判定当前用户通过验证。

如图2所示,先根据步骤2计算出的人脸图像的候选区域进行步骤3中的人脸验证,验证通过后,根据确定出的人脸图像的候选区域,将相应的人脸区域从上传的人脸图像中提取出来,然后通过训练好的深度学习中的ZF网络,将提取出的人脸映射到欧氏空间,得到一个128维的第一向量。

同样,首先服务器根据人脸图像的命名进行分析,确定对应智能终端的唯一设备编号id,之后,根据该唯一设备编号id在其数据库中进行查询,得到与该唯一设备编号id对应的相应设备下所有的用户基本信息,提取查找出的所有用户基本信息中的用户免冠面部图像,进行计算得到128维的第二向量。

最后,分别计算第一向量与多个第二向量之间的欧氏距离,并将计算出的欧氏距离与设定阈值进行比较,其中,设定阈值为0.4,若欧氏距离小于0.4,则判定当前用户与该欧氏距离对应的、查找出的用户基本信息对应的用户为同一个人,完成对当前用户的验证。

具体的,在当前用户的人脸验证过程中,设定卷积层采用12次的卷积操作、4次最大池化操作、以及两次Batch Normalization操作,其中,卷积操作有5次为1×1的卷积核,其余6次卷积为为3×3的卷积核,最后输出为1×1×128的向量。

这样就完成了将人脸图像映射到欧几里得空间,在该空间中,图像间的空间距离直接和图像相似度相关:同一个人的不同的图像在空间距离上很小,但是不同人的图像在空间中有较大的距离。依据此理论,我们可以方便的计算和匹配人脸,实现依据当前用户的人脸图像,对用户身份信息的验证。

设定当前用户的人脸图像X(第一向量)为:X=[x

当验证通过后,服务器向所述智能终端发送舌象图像采集指令,由智能终端通过图像传感器采集用户的舌象图像,并将所述舌象图像发送至所述服务器,

服务器首先确定所述人脸图像的舌部位置,并根据所述舌部位置对应的像素信息,计算直方图特征,并对所述直方图特征进行降维处理,生成用户特征向量,根据所述用户特征向量与训练数据集中的样本特征向量之间的欧几里得距离,确定色彩校正矩阵,之后根据所述色彩校正矩阵对所述舌象图像进行色彩校正,并存储所述校正后的舌象图像。

具体的,如图3所示,当智能终端检测到的人脸通过验证,即当前用户已经在当前设备(智能终端)注册(登录)后,后端(服务器)返回验证通过的消息,由智能终端对当前用户进行舌象图像采集,包括舌面、舌底的图像。

当服务器对当前用户进行人脸验证后,向智能终端发送舌象图像采集指令,智能终端收到该指令后,向当前用户发送语音提示,开始采集伸舌(舌面)以及翘舌(舌底)动作图像,采集到的图像的分辨率同样为3280×2464,并使用jpeg格式进行压缩,之后上传至基于Django Web框架的服务器,并以当前采集过程的时间戳,即采集过程的id以及图片序号作为后缀,来命名图像文件,并将图像所在位置写入数据库。

本实施例中,服务器还基于人脸图像中的人脸区域,根据相对位置经验计算舌部位置,对应的关系式为:

t=(top-(top-bottom)×2/3)

b=bottom×1.1

l=(left+(right-left)×1/4)

r=(right-(right-left)×1/4)

式中,人脸区域(top,bottom,left,right)代表了人脸在人脸图像中的相对位置,(top,left)代表左上顶点坐标,(bottom,right)右下顶点坐标,通过上述计算可以计算出舌部位置(t,b,l,r)。

根据计算出的舌部位置,对当前采集到的舌象图像进行图像提取、剪裁,确定舌部位置对应的像素信息,并选取色彩校正矩阵,对舌象图像进行色彩校正,该过程具体包括:

步骤A,基于训练数据集中的色彩错误图像

式中,argmin||·||

需要说明的是,上述计算出的色彩转换矩阵M

步骤B,根据舌象图像中的像素信息,计算舌象图像的亮度信息,对应的计算公式为:

式中,I为图像的张量值,R,G,B表示张量值I中的颜色通道,其中i={1,…,N,I

步骤C,定义两个色度度量分别记作为u、v,根据舌象图像在RGB通道上的通道分量I

I

I

I

I

需要说明的是,两个色度度量u、v的定义过程并不限定,采用常规的定义方式即可。

步骤D,根据计算出的舌象图像的亮度信息I

式中,C∈{1,2,3}表示直方图中的每个颜色通道,ε为直方图的宽度,最后得到h(I)

步骤E,为了进行高效的检索,利用线性转换函数,从直方图特征中提取舌象图像的维度更低的用户特征向量,对应的公式为:

v(h(I)

式中,vec(·)线性转换函数,

同样的,计算训练数据集中的色彩错误图像

步骤F,计算采集到的每张舌象图像的降维后的用户特征向量v(h(I)

当计算出的欧几里得向量距离都大于给定的距离阈值时,即在我们前期采集的训练数据集中不存在与其相对应的图像,对于此类舌象图像给定一个预设校正矩阵,并基于给定的预设校正矩阵,对当前采集的舌象图像进行校正,对应的计算公式为:

I=M1*(I)

式中,M1为预设校正矩阵,I为校正后的舌象图像。

通过测试实验,该矩阵在对于舌象类数据的还原在视觉效果上拥有相对的优势,并且大多数场景下对色彩的还原表现更加优秀;

当存在小于距离阈值的计算出的欧几里得向量距离时,在步骤A中计算出的色彩转换矩阵M

其中,α

最后,得到的色彩校正矩阵M2用于对舌象图像进行色彩转换(校正):

I=M2*(I)

步骤G,进行校正后的舌象图像的存储,存储时,同样以当前采集过程的时间戳序号和该智能终端的唯一设备编号id作为舌象图像的命名元素进行命名,同时保留原舌象图像,并将图像所在的位置的绝对路径分别写入数据库。

优选的,智能终端在采集到舌象图像后,还利用语音提示,采集伸舌和翘舌动作视频,并上传至后端,再利用MP4Box由h264转换为mp4格式存储,并将存储地址写入数据库。

如图4所示,本实施例中,设计了Web页面进行显示收集数据,并对收集到的数据进行简单的统计分析,计算7天内每天采集到的数据量,数据库内总共的数据量、用户数量、以及设备数量。

具体的,可以共设计三个数据表,分别为用户表、设备表、采集数据表,其中,用户表用于存储从微信小城程序端收集到的用户的年龄、身高、体重、设备id的信息;

设备表存储设备所生产时间、设备id;

采集数据表用于存储采集的数据的时间戳、人脸数据的地址、舌象数据的地址、所归属的用户、所使用的设备id。

实施例二:

在上述实施例的基础上,本实施例还提供了一种智能舌面象数据采集方法,该方法适用于上述实施例中的采集系统,该方法包括:方法包括:

步骤10,获取用户的人脸图像,并根据人脸图像和存储的用户基本信息,对当前用户进行验证;

步骤20,当验证通过后,确定人脸图像的舌部位置,并根据舌部位置对应的像素信息,计算直方图特征,并对直方图特征进行降维处理,生成用户特征向量;

步骤30,根据用户特征向量与样本特征向量之间的欧几里得向量距离,确定色彩校正矩阵;

步骤40,根据色彩校正矩阵,对采集到的用户的舌象图像进行色彩校正,并存储校正后的舌象图像。

以上结合附图详细说明了本申请的技术方案,本申请提出了一种智能舌面象数据采集系统及方法,该系统包括:智能终端和服务器;智能终端内设置有图像传感器,智能终端用于获取用户的人脸图像,并将人脸图像发送至服务器;服务器用于根据人脸图像和存储的用户基本信息,对当前用户进行验证,当验证通过后向智能终端发送舌象图像采集指令,并确定人脸图像的舌部位置,并根据舌部位置对应的像素信息,计算直方图特征,并对直方图特征进行降维处理,生成用户特征向量,根据用户特征向量与样本特征向量之间的欧几里得向量距离,确定色彩校正矩阵;智能终端还用于根据舌象图像采集指令,采集用户的舌象图像,并将舌象图像发送至服务器;服务器还用于根据色彩校正矩阵,对舌象图像进行色彩校正,并存储校正后的舌象图像。通过本申请中的技术方案,解决现有舌诊仪的成本昂贵、不够便捷智能的问题。

本申请中的步骤可根据实际需求进行顺序调整、合并和删减。

本申请装置中的单元可根据实际需求进行合并、划分和删减。

尽管参考附图详地公开了本申请,但应理解的是,这些描述仅仅是示例性的,并非用来限制本申请的应用。本申请的保护范围由附加权利要求限定,并可包括在不脱离本申请保护范围和精神的情况下针对发明所作的各种变型、改型及等效方案。

- 一种智能舌面象数据采集系统及方法

- 一种智能痧象采集分析系统及痧象采集分析方法