一种不确定网络环境中的任务卸载和资源分配方法

文献发布时间:2023-06-19 12:10:19

技术领域

本发明涉及无线通信技术领域,尤其涉及一种不确定网络环境中的任务卸载和资源分配方法。

背景技术

随着物联网技术的快速发展和5G/6G新型应用的普及,时延敏感性应用已经被广泛设想,如虚拟现实、无人驾驶和人脸识别等正以前所未有的速度发展。移动边缘计算(Mobile Edge Computing,MEC)通过将任务卸载网络边缘节点,如基站和无线接入点,为时延敏感型应用提供了固有的低时延优势。

移动边缘计算中任务卸载和资源分配策略往往是影响用户卸载时延和能耗的关键因素,为提高用户的服务质量(Quality of Experience,QoE),同时最小化计算卸载能耗,需要根据任务的计算能耗预算、计算时延,以及MEC服务器的可用资源等性能约束条件来制定任务卸载和资源分配策略。国内外研究人员针对此问题进行了大量深入研究,一些主要的成果有:

(1)移动边缘计算中的任务分配和计算频率任务算法(参考文献:Dinh T Q,TangJ,La Q D,et al.Offloading in Mobile Edge Computing:Task Allocation andComputational Frequency Scaling[J].IEEE Transactions on Communications,2017,65(8):3571-3584.):该算法考虑了单个用户将任务卸载到多个MEC服务器的场景,通过优化任务的卸载决策和用户的中央处理单元(Central Process Unit,CPU)频率值来实现任务计算时延和用户能耗的最小化。

(2)联合任务卸载和无线资源分配算法(参考文献:Chen H,D Zhao,Chen Q,etal.Joint Computation Offloading and Radio Resource Allocations in Small-CellWireless Cellular Networks[J].IEEE Transactions on Green Communications andNetworking,2020,4(3):745-758.):该算法考虑在多用户多MEC服务器场景下,对任务卸载决策、传输功率和信道分配进行了联合优化,目的是在满足任务计算时延约束条件下,最小化所有用户的能耗。

任务计算时延是保证用户QoE的重要指标之一,上述研究工作均考虑了任务的计算时延,然而都忽略了MEC服务器任务队列的排队等待时延。在实际的MEC网络环境中,由于MEC服务器的计算、存储等资源非常有限,通常无法快速响应海量突发的计算请求,因此,任务在MEC服务器端的排队等待时间是不可忽略的。由于任务到达的随机性,以及MEC服务器任务队列的时变性,欲得到任务排队等待时间的准确预测值是不现实的,这种不确定性因素对传统任务卸载和资源分配造成了严峻挑战。此外,大部分研究工作都只针对用户端能耗,而计算资源有限的MEC服务器端将面临着大量计算密集型和时延敏感型用户的访问,随之而来的是计算资源匮乏,以及高能耗等问题。因此,如何在任务计算时延不确定的MEC网络环境中制定高效、绿色的任务卸载和资源分配策略具有重要研究价值。

发明内容

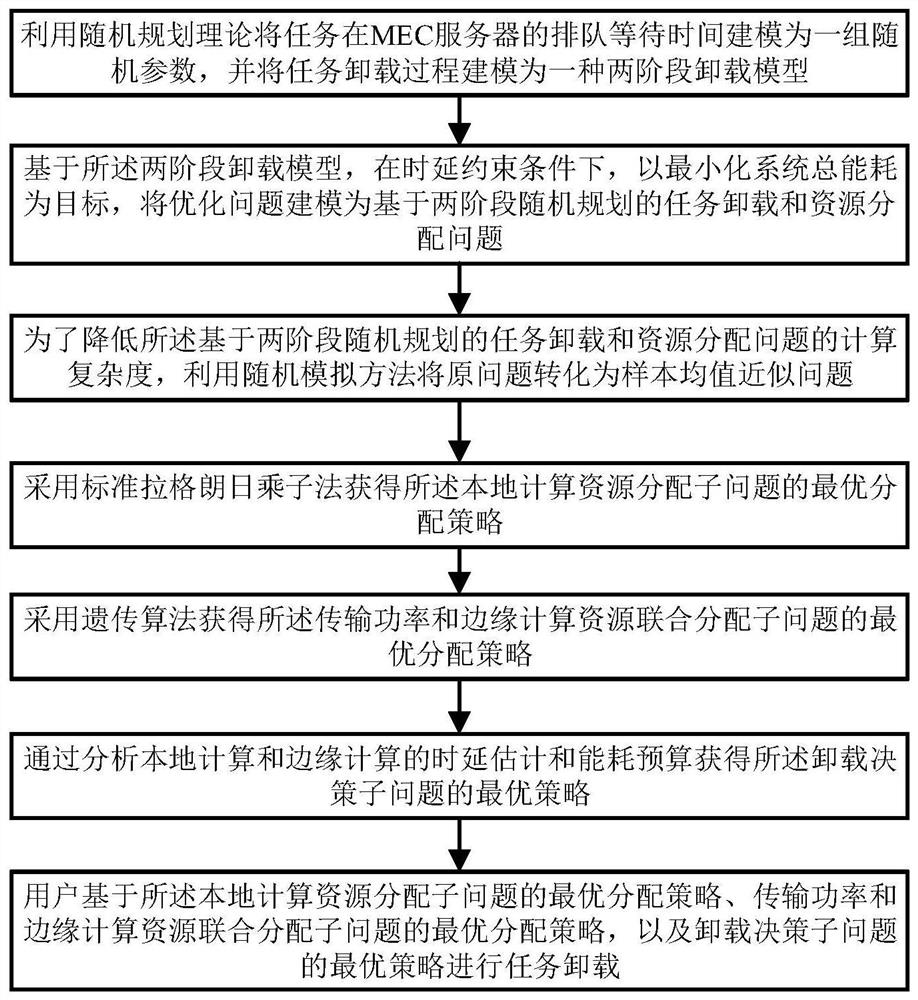

为解上述问题,本发明考虑任务在MEC服务器的随机排队等待时间导致的计算时延不确定问题,提出了一种不确定网络环境中的任务卸载和资源分配方法,具体包括以下步骤:

利用随机规划理论将任务在MEC服务器的排队等待时间建模为一组随机参数,并将任务卸载过程建模为两阶段卸载模型;

基于两阶段卸载模型,在时延约束条件下,以最小化系统总能耗为目标,将优化问题建模为基于两阶段随机规划的任务卸载和资源分配问题;

利用随机模拟方法将基于两阶段随机规划的任务卸载和资源分配问题转化为样本均值近似问题;

将样本均值近似问题解耦为本地计算资源分配子问题、传输功率和边缘计算资源联合分配子问题,以及卸载决策子问题;

采用标准拉格朗日乘子法获得所述本地计算资源分配子问题的最优分配策略;

采用遗传算法获得所述传输功率和边缘计算资源联合分配子问题的最优分配策略;

通过分析本地计算和边缘计算的时延估计和能耗预算获得所述卸载决策子问题的最优策略;

用户基于所述本地计算资源分配子问题的最优分配策略、传输功率和边缘计算资源联合分配子问题的最优分配策略,以及卸载决策子问题的最优策略进行任务卸载。

进一步的,在两阶段卸载模型中,将卸载决策过程分为两个阶段,包括:

第一阶段的决策变量为任务的传输功率,即用户在没有观察到不确定性MEC服务器排队等待时间的情况下,考虑未来所有可能排队时间的影响,做出第一阶段的传输功率分配策略p

第二阶段的决策变量为MEC服务器的CPU频率资源,即当任务上传至MEC服务器,排队等待时间实现已知,在获得排队等待时间和第一阶段的传输功率分配策略p

进一步的,若第i个用户的任务卸载决策为1,即第i个用户将任务卸载到服务器计算,则通过遗传算法计算最优的卸载策略,具体包括:

将每一个可行的传输功率进行浮点向量编码,每一个浮点向量表示一个染色体,浮点向量维数与解向量维数一致;

从用户i传输功率的可行域中随机产生一个点,检验其是否满足用户传输时延小于最大传输时延要求,即

对于每个染色体p

对于染色体p

定义P

定义P

经过选择、交叉和变异操作,可以得到一个新的种群,并准备进行下一代进化,如果上述步骤达到了给定的循环次数,则遗传算法终止;算法终止后,从最后一代选择一个适应度最高的染色体,即得到优化问题的全局最优解。

本发明针对移动边缘计算中任务在边缘服务器的随机排队等待时间导致的计算时延不确定问题,提出了一种不确定网络环境中的任务卸载和资源分配算法。首先,在计算时延约束条件下,以最小化系统总能耗为目标,将优化问题建模为两阶段随机规划问题。其次,为了降低两阶段随机规划问题的计算复杂度,利用随机模拟方法将原问题转化为基于样本均值近似的混合整数非线性规划问题,并将该问题解耦为本地计算资源分配、传输功率和边缘计算资源联合分配,以及卸载决策3个子问题。接着,采用拉格朗日乘子法获得本地计算资源最优分配策略,同时采用遗传算法获得传输功率和边缘计算资源最优联合分配策略。最后,通过分析本地和边缘计算的时延估计和能耗预算获得最优任务卸载决策。通过仿真实验,与传统算法相比,所提算法能够在时延不确定的网络中满足任务计算时延的要求,同时保证系统能耗最小化。

附图说明

图1为本发明中一种不确定网络环境中的任务卸载和资源分配算法流程图;

图2为本发明两阶段卸载模型图;

图3为不同算法下系统总能耗随着任务量的变化过程图;

图4为不同算法下系统总能耗随着时延约束的变化过程图。

具体实施方式

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

本发明提出一种不确定网络环境中的任务卸载和资源分配方法,如图1,包括以下步骤:

利用随机规划理论将任务在MEC服务器的排队等待时间建模为一组随机参数,并将任务卸载过程建模为两阶段卸载模型;

基于两阶段卸载模型,在时延约束条件下,以最小化系统总能耗为目标,将优化问题建模为基于两阶段随机规划的任务卸载和资源分配问题;

利用随机模拟方法将基于两阶段随机规划的任务卸载和资源分配问题转化为样本均值近似问题;

将样本均值近似问题解耦为本地计算资源分配子问题、传输功率和边缘计算资源联合分配子问题,以及卸载决策子问题;

采用标准拉格朗日乘子法获得所述本地计算资源分配子问题的最优分配策略;

采用遗传算法获得所述传输功率和边缘计算资源联合分配子问题的最优分配策略;

通过分析本地计算和边缘计算的时延估计和能耗预算获得所述卸载决策子问题的最优策略;

用户基于所述本地计算资源分配子问题的最优分配策略、传输功率和边缘计算资源联合分配子问题的最优分配策略,以及卸载决策子问题的最优策略进行任务卸载。

在本实施例中,考虑一个MEC系统模型,该模型包含一个配置了服务器的基站,N个请求任务处理的用户,集合表示为

每个用户的处理器均支持动态电压频率调整(Dynamic Voltage FrequencyScaling,DVFS)技术,DVFS技术可以动态调整CPU频率值,从而达到节省功耗的目的本地计算的时延为:

本地计算时UEi产生的计算能耗为:

其中,f

用户选择将任务卸载到MEC服务器处理主要经历四个过程:任务上传、MEC服务器排队等待、MEC服务器计算,以及计算结果返回。由于返回结果时的任务量较小,为便于分析,本发明忽略计算结果返回的通信时延。UEi将任务卸载到MEC服务器可获得的传输速率为:

其中,B

当任务上传至MEC服务器后,由于MEC服务器计算资源的有限性,通常无法快速响应突发的计算请求,因此,MEC服务器排队等待时间是不可忽略的,定义T

进一步,边缘计算时MEC服务器为UEi提供计算服务所产生的计算能耗为:

其中,γ表示与MEC服务器芯片架构相关的有效能量系数。

实施例1

本实施例提供基于两阶段随机规划的任务卸载及资源分配问题建模的具体实施。

由于任务到达的随机性,以及MEC服务器任务队列的时变性,欲得到任务排队等待时间的准确预测值是不现实的。本实施例首先对排队等待时间进行不确定性分析,然后在满足用户计算时延要求的条件下,以最小化系统总能耗为目标,将优化问题建模为一种基于两阶段随机规划的任务卸载和资源分配问题,具体包括:

(一)、对排队等待时间进行不确定性分析

为了处理MEC服务器排队等待时间的不确定性问题,本发明利用随机规划理论将不确定的排队等待时间建模为一组由概率分布描述的随机参数。不失一般性,假设MEC服务器排队等待时间服从指数分布,定义Ω

(二)、构建基于两阶段随机规划的任务卸载和资源分配问题

本发明旨在满足用户处理时延要求的条件下,通过优化本地和MEC服务器的CPU频率资源、任务传输功率,以及任务卸载决策来最小化系统的总能耗。如图2所示,用户首先在没有观察到不确定性MEC服务器排队等待时间的情况下,考虑未来所有可能排队等待时间的影响,并通过衡量本地和边缘计算时的能耗预算和时延估计得到卸载决策π

1)第一阶段的决策变量为任务的传输功率。同样地,用户在没有观察到不确定性MEC服务器排队等待时间的情况下,考虑未来所有可能排队时间的影响,做出第一阶段的传输功率分配策略p

2)第二阶段的决策变量为MEC服务器的CPU频率资源。当任务上传至MEC服务器,排队等待时间实现已知,在获得排队等待时间的实现T

结合以上分析,可得到基于两阶段随机规划的任务卸载和资源分配问题的期望值模型,表示为:

P1:

目标函数:

f

f

T

π

其中,π={π

实施例2

本实施例为了降低实施例1提出的两阶段随机规划问题的计算复杂度,将问题P1中的期望值模型转化为基于样本均值近似的MINLP问题。接着,将MINLP问题解耦为本地计算资源分配、传输功率和边缘计算资源联合分配,以及卸载决策3个子问题进行求解,具体包括:

(一)、将问题P1中的期望值模型转化为基于样本均值近似的MINLP问题

本发明考虑了MEC服务器排队等待时间的不确定环境下的任务卸载和资源分配优化问题,并将优化问题建模为一个两阶段随机规划问题。然而,求解两阶段随机规划问题通常面临着“维数灾难”的挑战,这将导致较高的计算复杂度。例如,当用户的场景空间Ω

为了解决两阶段随机规划中的“维数灾难”问题,本发明首先采用随机模拟方法从场景空间Ω

P2:

目标条件:式(8-a)-式(8-f)

在优化问题P2中,π

(二)、本地计算资源分配

假设卸载决策变量π

P2-1:

约束条件:式(8-b)-式(8-d)

在优化问题P2-1中,目标函数是关于f

其中,μ

通过求解KKT条件,可得到任务在本地计算时最优CPU频率分配策略的闭合表达式为:

(三)、传输功率和边缘计算资源联合分配

假设卸载决策变量π

P2-2:

约束条件:式(8-a)、式(8-c)和式(8-e)

在优化问题(12)中,由于边缘计算第一阶段目标函数是关于p

实施例3

本实施例提出采用遗传算法求取P2-2问题的全局最优解的具体实施,具体包括以下步骤:

1)编码

在两阶段卸载模型中,主要目标是确定第一阶段任务传输功率,因此,本发明将每一个可行的传输功率进行浮点向量编码,每一个浮点向量表示一个染色体,浮点向量维数与解向量维数一致。

2)初始种群

定义M表示种群大小,初始化过程随机产生M个染色体。从用户传输功率的可行域中随机产生一个点,并检验其是否满足约束条件,如果满足则作为一个染色体,否则,重新产生一个随机点,直到满足约束条件。重复以上过程M次,产生M个染色体作为初始种群,记为p

3)评价函数

评价函数用来对种群中的每个染色体设定一个概率,以使该染色体被选择的可能性与种群中其他染色体的适应度成比例,适应度强的染色体被选择产生后代的几率较大。本发明利用优化问题P2-2的最优值作为染色体的适应度,利用适应度的大小决定一个序,并按照此序确定染色体被选择的概率。最优值越小,适应度越强,即作为父本繁殖下一代的概率越大。具体操作为对于每个染色体p

S.t.:式(8-c)和式(8-e)

在优化问题式(15)中,边缘计算第一阶段的目标值为常数,边缘计算第二阶段目标函数是关于

将所有场景下最优CPU频率值带入式(15),可求得每个染色体相应的适应度值,并按照适应度值从小到大对染色体进行排序,据此定义评价函数如下

eval(p

其中,a∈(0,1)。对于染色体p

4)选择

对于每一个染色体p

5)交叉

定义P

6)变异

定义P

7)终止条件

经过选择、交叉和变异操作,可以得到一个新的种群,并准备进行下一代进化。如果上述步骤达到了给定的循环次数,则遗传算法终止。算法终止后,从最后一代选择一个适应度最高的染色体,即得到优化问题的全局最优解,该解即为用户i最优发射功率。

实施例4

本实施例给出卸载决策的求解方法。

用户通过对本地计算和边缘计算的能耗预算和时延估计得到卸载决策,在获得本地计算资源、传输功率和边缘计算资源最优分配策略的情况下,优化问题P2可写为任务卸载决策子问题:

P2-3:

约束条件:式(8-f)

在优化问题P2-3中,唯一的变量是卸载决策π

实施例5

本实施例为了验证本发明的有效性,进行了相关仿真实验。

本发明利用MATLAB工具对本发明提出的一种不确定网络环境下任务卸载和资源分配算法(SS_2SSP)进行仿真验证,为了验证所提算法的性能,对比算法包括:

(1)基于最大排队等待时间的静态卸载策略(Maximum Waiting Time basedStatic Offloading,MWT_SO):用户基于任务在MEC服务器最大排队时间的静态网络中,对传输功率和边缘计算资源进行优化;

(2)贪婪式卸载策略(Greedy):用户基于任务在MEC服务器最大排队时间的静态网络中,以及采用MEC服务器最大CPU频率的贪婪式卸载策略对传输功率进优化;

(3)本地计算策略(OnlyLocal):用户将任务只在本地处理。

本发明考虑单个MEC服务器场景,MEC服务器排队等待时间服从指数分布,平均排队等待时间为0.1~4s;若无特别说明,排队等待时间样本数量K均为100个;计算密度L

图3所示为不同算法下系统总能耗随着任务量的变化过程图,其中,每个任务计算时延要求为1s/Mbit,MEC服务器最大排队等待时间为5s,平均排队等待时间为2s。从图3中可以看出,随着任务量的增加,所有算法的系统总能耗随之增加,而本发明所提SS_2SSP算法具有最低的系统总能耗,这是由于SS_2SSP算法在第一阶段制定传输功率策略时考虑了未来所有可能排队等待时间的影响,待任务上传至MEC服务器后,获得了排队等待时间的实现,并结合第一阶段传输功率分配策略,MEC服务器根据用户的计算时延约束条件采取第二阶段的追索策略,即CPU频率分配策略,这将弥补第一阶段策略的不准确预测。而MWT_SO算法是基于MEC服务器最大排队等待时间且没有追索动作的静态卸载策略,当MEC服务器平均排队等待时间较小时,MWT_SO算法将会以更高的能耗去满足时延需求。Greedy算法基于最大的排队等待时间,且贪婪式地使用MEC服务器最大CPU频率资源,相比MWT_SO算法和SS_2SSP算法具有更高的系统能耗。OnlyLocal算法由于将任务全在本地处理,较其他算法具有最高的系统能耗。

图4所示为不同算法下系统总能耗随着时延约束的变化过程图,其中,用户数1个,任务量大小为20Mbit,MEC服务器最大排队等待时间为2.5s,平均排队等待时间为1s。从图4可以看出,随着时延约束的增加,系统总能耗随之减小,本发明所提SS_2SSP算法具有最低的系统总能耗,而MWT_SO算法基于最大排队等待时间具有较高的系统总能耗,与MWT_SO算法对比,Greedy算法没有对MEC服务器CPU频率进行优化,因此,具有更高的系统能耗,OnlyLocal算法将任务只在本地处理,由于本地计算性能和计算资源的限制,与其他算法相比,具有最高的系统总能耗。

尽管已经示出和描述了本发明的实施例,对于本领域的普通技术人员而言,可以理解在不脱离本发明的原理和精神的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由所附权利要求及其等同物限定。

- 一种不确定网络环境中的任务卸载和资源分配方法

- 一种计算资源有限MEC中任务卸载与资源分配方法