一种基于小波分析的超高维数据重建深度学习方法

文献发布时间:2023-06-19 12:13:22

技术领域

本发明涉及图像处理、神经网络技术领域,尤其是涉及一种基于小波分析的超高维数据重建深度学习方法。

背景技术

传统的小波变换是为了解决傅里叶变换丢失时域信息而提出的,在图像处理领域,快速离散小波变换应用一系列的滤波器,将图像信息扩展到不同的独立的频域子带中,并用小波系数所表示。

CNN是处理图像领域的神经网络的基础,卷积层是CNN的核心,通过一系列的滤波器提取图像的细节信息,生成一张特征向量图。池化层为CNN引入不变性,同时降采样,扩大下一层卷积核的感受野,网络将很好地学习到不同尺度下图像的特征信息。激活层通常为非线性函数,使网络更好地拟合任意函数,也会缓解过深层网络的过拟合现象。

U-net是一种常用的图像语义分割、重建模型,由编码器和解码器构成。

GAN架构由生成器和判别器级联构成,被广泛应用在图像生成任务中。核心思想是使两个网络互相竞争,从生成器角度而言,它趋向于降低判别器的判别准确度,即努力生成与真值(Ground Truth)相似的图像,以期以假乱真;从判别器角度而言,它趋向于降低生成器的输出图像相似度,即不断提高审核标准。完全训练后,判别器的输出将收敛于某一个值,达到动态平衡。

现有技术中,DTI(Diffusion Tensor Imaging,弥散张量成像)是通过多方向MRI扫描数据描述大脑结构的方法,通常一个被试个体的扫描数据有若干吉字节(GB)之大,而深度学习常常需要极大的样本量,直接参与训练的数据约100GB-200GB,但目前的深度学习芯片显存容量有限,如英伟达特斯拉V100也仅支持32GB的显存容量,因此通常无法直接将大量DTI数据存入深度学习芯片的显存用于深度学习训练。

发明内容

为解决现有技术的不足,克服现有硬件条件难以支撑深度学习网络训练超高维数据的问题,实现利用有限的计算资源训练大体积超高维数据的目的,本发明采用如下的技术方案:

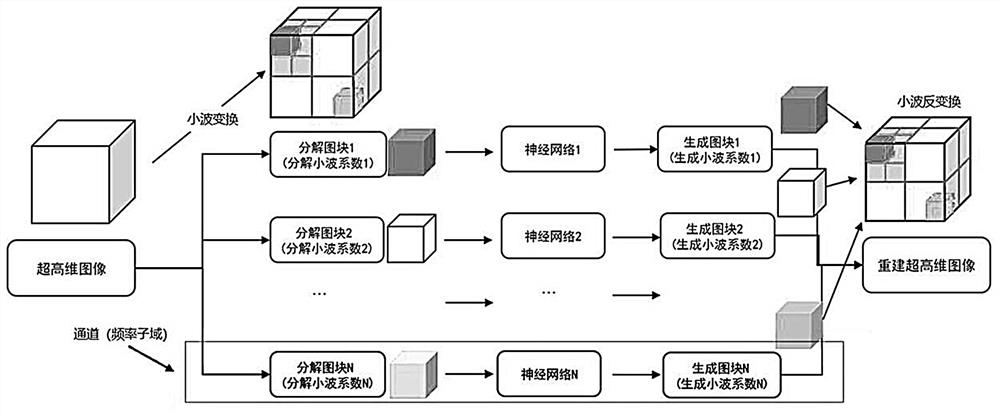

如图1所示,一种基于小波变换的平行深度网络模型,其具体步骤如下;

S1,数据预处理;

S11,数据标签:对个人采集的数据标签化;

S12,数据增强:使用平移、旋转、缩放等方式扩充数据库;

S13,数据清洗:填补缺失值,检查异常对象;

S14,数据规范化:使用统一的图片编码方式。

S2,数据频域扩展;

S21,根据任务与数据不同,选择合适的小波基函数;

S22,利用多阶高维小波包变换,提取图像数据各个维度的低频与高频信息,置于不同频域子带,分解层数根据图形处理器内存和数据规模而定;

在本发明中,采用的是高维N阶的小波包变换,经小波变换的数值,即为拟合原图像空间信息的小波基系数,可以认为是图像信息在各小波基上的投影值。原始图像经一组正交的小波基分解后,实际上通过了一组滤波器,将其分为高频分量和低频分量,在此基础上,小波包变换对每一级的高频和低频子带做进一步的分解,通过最大化逐级分解信号的信息熵,计算出最优分解路径,因此小波包分解又被称为最优子带树结构。以三维图像输入为例,一阶小波包分解得到的子图块(小波包分解系数)最小为原图像尺寸的1/8,根据最大信息熵优化分解路径原则,还会留存未完全分解的子图块,尺寸为原图像尺寸的1/4,分解方式如图2所示。小波包反变换可以无失真重建原高维图像。

S3,网络搭建;

S31,根据不同任务,为各频域通道分别搭建独立的神经网络,对于分割、重建任务,搭建基于U-net的神经网络,对于生成任务,搭建GAN网络模型,让神经网络在S4中平行训练;

S32,U-net搭建:U-net由相同数量的若干编码器和解码器构成,每个编码器包含卷积层和下采样层,其中每个卷积层包括批归一化层、激活层和卷积核,下采样层包括批归一化层、激活层和池化层,池化层用于下采样图像特征,每个解码器包含卷积层和上采样层,其中每个卷积层包含批归一化层、激活层和卷积核,上采样层包括批归一化层、激活层和采样器,采样器通过反卷积算法或插值算法恢复像素,批归一化层用于标准化数据和校准,激活函数用于引入非线性因子,使神经网络拟合数据分布。同级编解码器间使用跳层连接(Skip Connection),拼接多尺度的特征图,保证多尺度的特征图相融合,从而提高重建、分割精度;

U-net独特设计了跳层连接,将降采样前的特征拼接到恢复同等像素的特征图中,帮助解码器在恢复像素的过程中尽可能少的丢失细节信息,编码器包含若干卷积核,负责提取此感受野下的细节特征,组成特征向量图,池化层引入不变性并降采样图像;解码器同样包含若干卷积核,得到特征向量图后通过跳层连接拼接了从同级解码器裁剪的部分特征向量图,保证上采样器在恢复像素的时候,尽可能少的丢失细节信息,同时利用了编码器和解码器学习到的图像特征,对应编码器的池化层,解码器用上采样器恢复像素,通常采用反卷积算法或插值算法。在每个卷积器和池化层前,U-net使用批归一化层来标准化数据,并校准可能产生偏移的数据分布;激活函数通常使用修正线性单元(ReLU),目的是为了引入非线性因子,使网络更好地拟合数据分布。U-net网络结构如图3所示。

S33,生成式对抗网络GAN搭建:GAN架构由生成器和判别器级联构成,均为卷积神经网络网络(CNN)架构,生成器是一个上采样的卷积网络,类似于U-net的解码器,输入为随机信号分布,输出为与目标图像同尺寸的图像数据,主要由卷积层和上采样层构成,卷积层同样包含批归一化层、激活层和卷积器,上采样层包含上采样器,输出为高维图像;判别器是下采样的卷积网络,包含卷积层和池化层,卷积层包含卷积器、批归一化层和激活层,输入为图像数据,输出为一维概率∈[0,1]。

训练GAN网络前需初始化生成器和判别器的网络权值。首先,通过迁移学习或随机化初始生成器的网络参数,再用随机种子生成虚假图像数据,混入真实图像数据训练判别器并更新网络权值。通常使数据库真假数据数量相等,判别器输出为0.5左右时完成初始化。之后用随机噪声为生成器的输入,串接生成器和判别器,利用反向传播误差更新生成器网络权值,生成器和判别器在反复的迭代训练中表现交替上升,继续训练直至稳定。GAN的训练过程如图4所示。

S4,网络训练;

S41,初始化网络参数;

S42,利用标注后的数据(真值)与训练中的网络预测值计算损失函数,再利用随机梯度下降、势能法(Momentum)或自适应梯度(AdaGrad)、自适应动量估计(Adam)等残差反向传播算法更新网络权值,具体地,根据真值和预测值,通过相似损失函数和交叉熵损失函数的加和,对每个网络参数求偏微分,在各网络层间,由预测端向输入端反向传播残差,各网络参数带入前一层的残差值,更新各权值处的偏微分值(梯度)与残差值,通过偏微分值(梯度),采用梯度下降法更新各个网络权值,降低预测误差。完整的一次前向传播和反向传播为一次迭代,通过多次迭代优化模型,训练流程如图5所示;

S43,超参数调节:通过调节批大小(Batch Size)、学习率、动量(Momentum)、权值衰减(Weight Decay)、正则化系数、随机失活(Dropout)等方式避免过拟合问题。

S5,数据重建;

S51,待同级频域通道的神经网络训练完毕后,对各通道网络输出(预测值)进行小波包反变换,重建上级频域信息;

S6,模型评估;

S61,对各频域通道对应的网络,利用交叉验证(Cross Validation)比较预测值与真值之间差异,针对性地调整表现欠佳的频域通道的神经网络结构及参数;

S62,模型的评价与衡量方法:相似系数(Dice Coefficient)、重叠度(IoU)、混淆矩阵(Confusion Matrix)及其参数精度(Precision)、敏感度(Sensitivity)、准确度(Accuracy)、接收者操作特征曲线(ROC)和曲线下面积等(AUC)。

本发明的优势和有益效果在于:

本发明利用高维图像经小波变换后各频域独立的性质,提供了一套针对大体积高维数据的深度学习方法,高效的利用GPU内存,显著加速了神经网络的训练进程,使原受限于硬件计算资源的深度学习人工任务变为可能。该方法亦推广到分割及生成任务。对于分割任务,U-net网络输出结果经反卷积上采样为原始图像分辨率分割标签。对于图像生成任务,各通道的神经网络改为对抗神经网络GAN。

附图说明

图1是本发明中超高维神经网络重建模型流程示意图。

图2是本发明中小波包变换示意图。

图3是本发明中U-net网络结构示意图。

图4是本发明中GAN网络训练步骤示意图。

图5是本发明中单通道神经网络训练示意图。

图6是本发明中重建DTI数据实例系统流程框图。

图7是本发明中小波包分解流程示意图。

图8是本发明中一阶图块输入U-net最上层编解码器示意图

图9是本发明中二阶图块输入U-net最上层编解码器示意图。

具体实施方式

以下结合附图对本发明的具体实施方式进行详细说明。应当理解的是,此处所描述的具体实施方式仅用于说明和解释本发明,并不用于限制本发明。

本发明提供了多频域平行的神经网络,创造性的提出利用小波包变换,将超高维数据(如视频数据、弥散加权磁共振数据、功能磁共振数据等)分解到不同的频率子带(subband),并为各子域搭建独立的神经网络,完成高维图像数据的分割、生成和重构等任务。该方法可应用于医学影像分析、视频分析等大体积超高维数据输入的深度学习任务。注:每个(小波变换——神经网络——小波反变换)称为一个频域通道或通道(channel)。

由于经变换后的不同频域通道存在一定的独立性,我们通过神经网络后,可以完美恢复原始图像,误差只来源于各神经网络的预测误差。简言之,本发明提供了在深度学习中,无损压缩大体积数据平行学习的一种方法,在这个过程中,超高维大体积数据被分解到多个通道,各通道内的神经网络模型能够独立训练,大大减少数据训练所需要的图形处理器的计算和内存资源,各网络的输出最后通过小波包反变换重构上级频域信息,还原超高维数据信息。

一种无信息损失的分解原始数据并在子频域独立训练的深度学习框架,在一定程度上,解决了深度学习不适用于超高维大体积数据的问题。如图6所示,描述了在本发明提供的技术框架下,重建DTI的步骤流程。

步骤1、数据预处理:

1-1)数据增强:将DTI数据延x、y、z轴循环平移2-10个体素点(voxel),得到新数据扩充数据库;

1-2)数据规范化:使用最近邻法对齐弥散敏感场方向(b-vector),提取相对应的扫描图像。

步骤2、数据频域扩展:

2-1)选择多贝西(Daubechies)小波基;

2-2)数据库为290个DTI数据,一个DTI数据包括长、宽、高、方向四个维度,尺寸为148×176×148×288。小波包变换根据最大信息熵原则,选择最优分解路径,一个DTI对象经二阶小波包变换后被分解为1个尺寸为74×88×74×288的一阶子图块(一阶小波包系数)和56个37×44×37×288的二阶子图块(二阶小波包系数)。分解阶数由小波包分解算法自动决定。特别的,单个数据样本所占用空间从3.92GB对应地缩小为0.49GB和61.2MB,可以在24GB的图形处理器显存下,保证同时加载约64或128个数据样本对象训练约400万参数的深度神经网络模型。一个DTI对象的小波包分解流程如图7所示。

步骤3、网络搭建:

3-1)搭建基于U-net的8个独立网络,在步骤4中平行训练;

3-2)U-net搭建:U-net由6个编码器和解码器构成,每个编码器卷积层和池化层,卷积层包含两次卷积计算,卷积核为3×3×3×3,零填充(Padding)值1,步长(Stride)为1,除此之外使用批归一层、修正线性单元,池化层使用2×2×2×2最大池化算法(MaxPooling),输入为1个37×44×37×288的数据经卷积层后得到尺寸为64个37×44×37×288的特征图(Feature Map)输出,经池化层得到尺寸为64个19×22×19×144的特征图;每个解码器包含卷积核的卷积层和上采样层,卷积层的卷积参数同编码器,上采样层使用双线性插值算法,最上层解码器的输入为64个19×22×19×144特征图,经上采样器得到的64个37×44×37×288的输出,同级编码器和解码器之间使用跳层连接,将编码器卷积层输出的特征图部分融合到解码器卷积层的输入部分,随机选取最上层编码器的32个输出特征图拼接到最上层解码器卷积层的输入端,解码器卷积层输入则为96个37×44×37×288特征图,经最后解码器的卷积层后得到原尺寸为37×44×37×288的重构DTI二阶子图块(二阶小波包系数);如图8、9所示,描述了最上层编解码器的组成,以及输入分别为一阶子图块(一阶小波包系数)和二阶子图块(二阶小波包系数)时,各层的输入输出。

步骤4、网络训练:

4-1)本步骤说明为单独一个通道的训练方法,8个独立网络相同,可分别独立训练;

4-2)使用标准正态分布随机初始化网络参数;

4-3)标签数据前向传播通过网络,利用真值和网络预测值得到两个损失函数:相似损失函数(Dice Loss)和交叉熵损失函数(Cross-entropy Loss)的加和,再利用反向传播算法得到梯度,使用自适应动量估计(Adam)优化器更新网络权值,通过多次迭代优化模型直到模型收敛;

4-3) 超参数调节:学习率在前50个迭代中设置为0.0005,后30个迭代中设置为0.0001,权值衰减为0.01,随机失活率0.5。

步骤5、数据重建:

5-1)待同级频域通道的神经网络训练完毕后,将各频域通道的神经网络输出(各通道预测值)进行小波包反变换,重建上级频域信息,得到重建高维数据。

步骤6、模型评估:

6-1)对各频域通道对应的网络,(即相同频域通道),利用交叉验证(CrossValidation)比较预测值与真值之间差异,针对性地调整表现欠佳的频域通道的神经网络结构及参数;

6-2)模型的评价与衡量方法:相似系数、重叠度。

以上实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述实施例所记载的技术方案进行修改,或者对其中部分或者全部技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本发明实施例技术方案的范围。

- 一种基于小波分析的超高维数据重建深度学习方法

- 一种基于小波分析的超高维数据重建深度学习方法