一种红外与可见光图像文本描述生成方法

文献发布时间:2023-06-19 12:25:57

技术领域

本发明属于计算机视觉领域,具体涉及一种红外与可见光图像文本描述生成方法。

背景技术

随着近年来人工智能领域中机器学习特别是深度学习技术的迅猛发展,计算机视觉作为一门研究如何更好地理解和分析图像的科学,在数据及算力的推动下也呈现出飞跃式的进步。例如在图像分类任务中,运行深度学习算法的机器的对物体种类识别的准确率已经超过人类;在目标检测与定位任务中,基于深度学习的算法已广泛应用于智能视频监控,机器人导航和基于内容的图像检索等领域。

图像描述生成任务的本质是完成场景信息从图像域到文本域的转换。目前图像描述生成领域中的研究都是围绕可见光图像展开的,然而单一光学谱段的成像设备可能在一些环境下无法完整的获取场景信息。例如,当关注的目标或场景缺乏良好的光线照射或者被遮挡时,普通的可见光相机将无法捕获到目标或相关场景的有用信息。尤其是在军事战场环境中,重要设施目标常常需要通过伪装式遮挡以躲避侦察,以及军事计划可能借助夜晚黑暗的保护开展行动。如果使用普通的可见光成像设备进行场景信息的采集,图像描述生成算法后续就无法生成正确的描述语句。为了在极端成像条件下也能够获取全面的场景信息,有必要结合使用工作在不同谱段的成像设备。例如在上述情景中,可以使用红外相机与可见光相机同时对场景成像。其中红外相机通过捕捉物体发出的热辐射信息并根据其强度大小进行成像,这样的特点使其具备全天候的工作能力而不受遮挡和光照条件变化的影响。因此研究多源传感器在图像描述生成任务中的应用也具有非常重要的意义。

发明内容

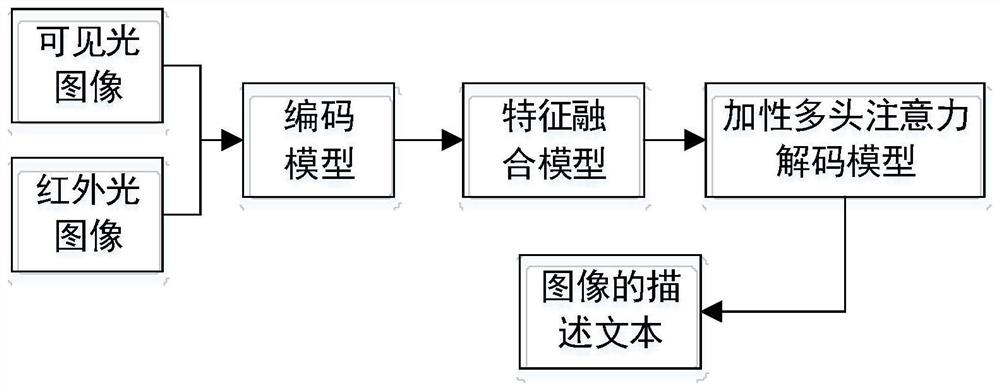

针对现有技术的不足,本发明提出一种红外与可见光图像文本描述生成方法。本方法建立了了一种联合红外可见光特征的双输入图像描述网络,能够有效地结合红外和可见光两个谱段的视觉特征信息。

本发明的技术方案包括以下步骤:

步骤1,建立数据集,采集n对分辨率大小为H×W、场景相同的红外与可见光图像,构建成数据集,对数据集中的每个样本进行人工文本描述,生成多条不同的描述文本,所述描述文本由多个词组成,将所有描述文本中的词组成一个集合,这个集合称为“字典”;

步骤2,构建红外与可见光图像文本描述生成网络,包括以下子步骤:

步骤2.1,多源图像场景特征提取:建立红外与可见光图像特征提取的编码模型,用于提取数据集中每一对红外与可见光图像样本的深层语义特征v

步骤2.2,场景特征信息融合:建立前馈神经网络构成的特征融合模型,用以融合红外与可见光图像包含的多源场景信息,获得融合语义特征v

步骤2.3,建立加性多头注意力机制的图像特征解码模型,对融合语义特征v

步骤3,利用步骤1中的数据集及对应的描述文本训练步骤2中构建的文本描述生成网络;

步骤4,将测试图像对输入到训练好的文本描述生成网络,输出其对应的描述文本。

进一步的,步骤1的具体实现包括如下子步骤:

步骤1.1,采集n对分辨率大小为H×W、场景相同的红外与可见光图像,构建成数据集S

步骤1.2:对所述数据集中的每个样本对

进一步的,步骤2.1的具体实现包括如下子步骤:

步骤2.1.1,建立红外与可见光图像描述生成网络的编码模型,用于提取图像特征映射,编码模型可表示为如下计算公式:

其中I

步骤2.1.2,为了使编码模型能够适应不同尺寸的图像输入,添加自适应均值池化层对所述红外与可见光图像特征映射进行处理,得到图像的深层语义特征,其计算公式为:

其中,Pool表示自适应均值池化层,v

进一步的,步骤2.2的具体实现包括如下子步骤:

步骤2.2.1,建立连接层,对红外与可见光图像深层语义特征v

步骤2.2.2,建立线性层对所述联合深层语义特征进行处理,得到线性深层语义特征v

v

其中,W

步骤2.2.3,建立激活层,对所述线性深层语义特征进行非线性化,使得v

v

其中,v

步骤2.2.4,建立线性层对所述非线性深层语义特征进行处理,得到融合语义特征v

v

其中,W

进一步的,步骤2.3的具体实现包含如下子步骤:

步骤2.3.1,对融合语义特征v

步骤2.3.2,加性多头注意力机制解码模型通过迭代的方式完成,记h和c为解码模型在迭代过程中的隐状态,h∈R

当迭代时间步t=0时,解码模型的初始隐状态为h

h

c

其中,W

步骤2.3.3,通过解码模型在迭代时间步t的隐状态h

步骤2.3.3.1:加性多头注意力机制中第i个头的权重α

α

其中

步骤2.3.3.2:加性多头注意力机制中的第i个头head

其中

步骤2.3.3.3:将多头head

v

其中

步骤2.3.4,解码模型采用融合加性多头注意力机制的LSTM进行迭代计算,其迭代计算公式如下:

h

其中,W

步骤2.3.5,通过全连接层FC和softmax归一化后,解码模型输出字典中候选概率值最大的单词

判断

本发明与现有技术相比具有以下优点和有益效果:

(1)本发明设计了一种加性多头注意力机制,通过划分多个抽头的方式在不同特征子空间计算注意力权重,能够使网络模型学习通道维度下的不同的注意力权重分布模式,弥补了传统算法遗漏关键目标实体和场景描述不充分的不足。

(2)本发明设计了一种联合红外可见光特征的双输入图像描述网络,网络中设计的特征融合模型能够有效地结合红外和可见光两个谱段的视觉特征信息,在极端不利成像条件下单一谱段成像手段无法获取完整场景信息时,可以有效利用红外图像和可见光图像提供的互补视觉特征,生成符合场景语义的描述语句。

附图说明

图1为本发明的总体流程图;

图2为解码模型结构;

图3为特征融合模型结构;

图4为加性多头注意力机制网络流程图;

图5为目标图像1和生成文本;

图6为目标图像2和生成文本。

具体实施方式

下面结合附图和实施例对本发明的技术方案作进一步说明。

为了更清楚的阐述本发明的目的、技术方案和有益效果,下面结合附图和实施例进一步说明。应当理解,本发明不应限于实施例公开的内容,本发明要求保护的范围以权利要求书界定的范围为准。

技术问题:本发明设计了一种红外与可见光图像文本描述生成方法,可有效利用红外图像和可见光图像提供的互补视觉特征,弥补了传统单光算法遗漏关键目标实体和场景描述不充分的不足。

本发明的技术方案包括以下步骤:

步骤1:建立数据集:采集n对分辨率大小为H×W、场景相同的红外与可见光图像,构建成数据集,对数据集中的每个样本进行人工文本描述,生成多条不同的描述文本,所述描述文本由多个词组成,将所有描述文本中的词组成一个集合,这个集合我们称为“字典”。

进一步的,步骤1的具体实现包括如下子步骤:

步骤1.1:采集n对分辨率大小为H×W、场景相同的红外与可见光图像,构建成数据集S

步骤1.2:对所述数据集中的每个样本对

步骤2,构建红外与可见光图像文本描述生成网络,包括以下子步骤:

步骤2.1:多源图像场景特征提取:建立红外与可见光图像特征提取的编码模型,用于提取数据集中每一对红外与可见光图像样本的特征信息;

进一步的,步骤2.1的具体实现包括如下子步骤:

步骤2.1.1:建立红外与可见光图像描述生成网络的编码模型,用于提取图像特征映射,模型可表示为如下计算公式:

其中I

步骤2.1.2:为了使编码模型能够适应不同尺寸的图像输入,添加自适应均值池化层对所述红外与可见光图像特征映射进行处理,得到图像的深层语义特征,其计算公式为:

其中,Pool表示自适应均值池化层,v

步骤2.2:场景特征信息融合:建立前馈神经网络构成的特征融合模型,用以融合红外与可见光图像包含的多源场景信息;

进一步的,步骤2.2的具体实现包括如下子步骤:

步骤2.2.1:建立连接层,对所述红外与可见光图像深层语义特征v

步骤2.2.2:建立线性层对所述联合深层语义特征进行处理,得到线性深层语义特征v

v

其中,W

步骤2.2.3:建立激活层,对所述线性深层语义特征进行非线性化,使得v

v

其中,v

步骤2.2.4:建立线性层对所述非线性深层语义特征进行处理,得到融合语义特征v

v

其中,W

步骤2.3:建立加性多头注意力机制的图像特征解码模型,用于输出描述文本;

进一步的,步骤2.3的具体实现包含如下子步骤:

步骤2.3.1:对所述融合语义特征v

步骤2.3.2:加性多头注意力机制解码模型通过迭代的方式完成,记h和c为解码模型在迭代过程中的隐状态,h∈R

当迭代时间步t=0时,解码模型的初始隐状态为h

h

c

其中,W

步骤2.3.3:通过解码模型在迭代时间步t的隐状态h

步骤2.3.3.1:加性多头注意力机制中第i个头的权重α

α

其中

步骤2.3.3.2:加性多头注意力机制中的第i个头head

其中

步骤2.3.3.3:将多头head

v

其中

步骤2.3.4:解码模型采用融合加性多头注意力机制的LSTM进行迭代计算,其迭代计算公式如下:

h

其中,W

步骤2.3.5:通过全连接层FC和softmax归一化后,解码模型输出字典中候选概率值最大的单词

判断

步骤3,利用步骤1中的数据集及对应的描述文本训练步骤2中构建的文本描述生成网络;

步骤4,将测试图像对输入到训练好的文本描述生成网络,输出其对应的描述文本。

以上所述,仅是本发明较佳实施例而已,并非对本发明的技术范围作任何限制,故凡是依据本发明的技术实质对以上实施例所作的任何细微修改、等同变化与修饰,均仍属于本发明技术方案的范围的。

- 一种红外与可见光图像文本描述生成方法

- 一种基于生成对抗网络的图像描述文本生成方法