一种基于深度卷积神经网络的水库钓鱼人检测方法

文献发布时间:2023-06-19 13:49:36

技术领域

本发明属于目标检测领域,具体涉及一种基于深度卷积神经网络的水库钓鱼人检测方法。

背景技术

水库钓鱼人检测大多基于计算机视觉的算法,使用目标的形状等底层特征进行目标检测,或者基于不同范围的阈值灰度图像区别目标和背景等算法。这些算法的共性是需要人为设计特征进行目标判断,由于人为设计所以存在主观性,并不能适用于所有的目标检测场景。

近年来发展起来的深度检测算法,例如区域卷积神经网络(Regions withConvolutional Network,RCNN)生成候选区域,再利用分类器识别候选区域,最后去除冗余候选框得到目标。快速区域卷积神经网络(Fast Regions with Convolutional Network,Fast RCNN)

发明内容

发明目的:为了解决现有技术的不足,本发明提供了一种基于深度卷积神经网络的水库钓鱼人检测方法。

技术方案:一种基于深度卷积神经网络的水库钓鱼人检测方法,图像作为全卷积神经网络的输入,利用网络对图像进行特征提取,不同的卷积作为滤波器提取图像的不同特征;将得到的特征图像作为检测模块的输入,提取候选边框,最终得到候选框的类别概率和目标预测位置;再对候选框采用NMS(非极大值抑制)的方法进行过滤,最终得到检测结果。

作为优化:采用深度神经网络对图像进行目标检测,首先在图像上划分S×S个网格,如果待测目标的中心落入该网格,该网格就负责检测出这个目标;

每一个网格都会预测B个候选框,每个候选框会附带一个置信度,这个置信度代表这个候选框检测到目标的置信度以及这个候选框预测的准确度;置信度如公式(1)所示:

式(1)中,

如果网格中不存在目标,则置信度为0,否则为1;每个候选框都会包含5个预测值:x,y,w,h和置信度;(x,y)坐标表示边界框的中心相对于网格单元边界的值,而宽度(w)和高度(h)则是相对于整张图像来预测的;每个网格还要预测类别概率Pr(Object),存在类别概率的前提是存在目标,即置信度不为0的情况,

非极大值抑制(NMS)指抑制不是极大值的元素,在某个局部邻域内存在两个可变参数:邻域的维数和邻域的大小;以目标检测为例,图像上有无数个候选框,每个框可能代表某种目标;但是这些框会有重叠的部分,所以需要NMS去除概率较低的框,保留最优的结果;假设有N个框,每个框被分类器计算并得到分数为S

作为优化:目标检测模型的损失函数定义如下:

Loss=C+S+P (2)

式(2)中,公式主要分为三个部分:C为类别预测的概率、S为目标的预测位置概率、P为置信度的损失;

损失函数通过BP算法不断更新模型,使loss值不断地减少;其中,类别预测的概率公式如下所示:

式(3)中,P

每个网格只对一个目标进行预测,需要计算该类别预测的损失,采用概率分布平方差计算方式;首先需要验证网格i内是否包含目标,其次计算预测值和真实值的平方差;

计算预测目标位置的损失函数:

式(4)中,x

预测目标位置的损失函数有两个部分:计算坐标中心的平方差和高度、宽度的平方差之和。预测置信度的损失函数如下计算:

式(5)中,C

最后,每个网格会得到5个预测值和1个类别信息,所以输入网格的尺度如式(6)所示:

S*S*(5*B+1) (6)。

对于长时间(30分钟以上)出现在同一位置的同一个人,作为疑似钓鱼人,给出预警。

有益效果:本发明主要使用深度神经网络进行水库钓鱼人检测,首先介绍了水库钓鱼人检测的算法、检测框架和训练方法,然后介绍了水库钓鱼人检测相关实验的参数和结果。该发明使用一个端到端的模型,主要通过深度神经网络进行特征提取,使用网络提取候选边框,最后通过NMS进行过滤。实验证明,该发明在不同场景(光照)下能准确的检测出水库钓鱼人。

附图说明

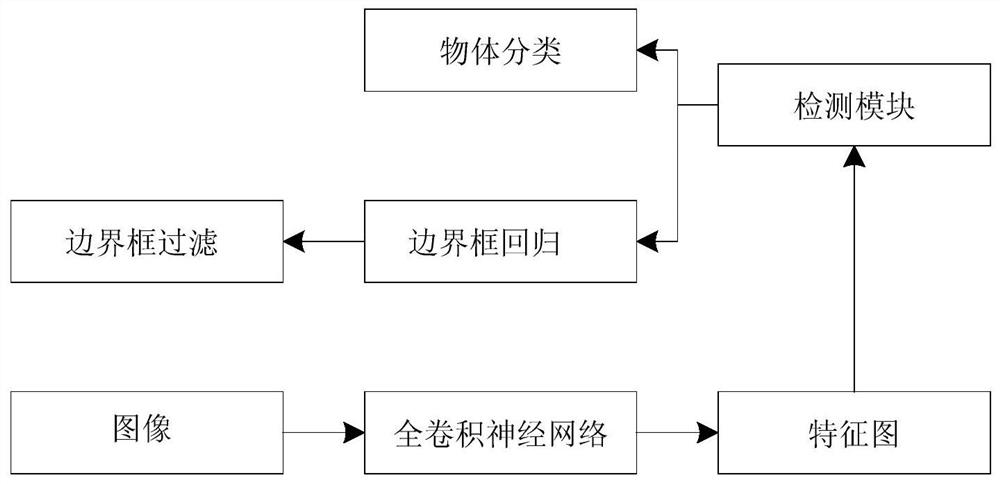

图1是本发明的算法检测流程图;

图2是本发明的算法原理图;

图3是本发明的水库钓鱼人检测结果示意图。

具体实施方式

下面将对本发明实施例中的技术方案进行清楚、完整地描述,以使本领域的技术人员能够更好的理解本发明的优点和特征,从而对本发明的保护范围做出更为清楚的界定。本发明所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例,基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动的前提下所获得的所有其他实施例,都属于本发明保护的范围。

实施例

本发明经过研究深度神经网络算法,提出一个端到端的网络结构,将目标检测作为回归问题。通过在图像上划分网格,在网格上设置多个候选框,并且输出每个候选框的类别概率和目标候选位置。算法通过设置阈值去除了概率较低的候选框,将最高概率候选框作为最后的目标位置和最终判定类别。

1.深度神经网络算法

图像作为全卷积神经网络的输入,利用网络对图像进行特征提取,不同的卷积作为滤波器提取图像的不同特征。将得到的特征图像作为检测模块的输入,提取候选边框,最终得到候选框的类别概率和预测目标位置。再对候选框采用NMS(非极大值抑制)的方法进行过滤,最终得到检测结果。图1是本发明基于深度神经网络的目标检测流程图。

采用深度神经网络算法对图像进行目标检测。首先在图像上划分S×S个网格,如果待测目标的中心落入该网格,该网格就负责检测出这个目标。图2是本发明的算法原理图。

每一个网格都会预测B个候选框,每个候选框会附带一个置信度,这个置信度代表这个候选框检测到目标的置信度以及这个候选框预测的准确度。置信度如公式(1)所示:

式(1)中,

如果网格中不存在目标,则置信度为0,否则为1。每个候选框都会包含5个预测值:x,y,w,h和置信度。(x,y)坐标表示边界框的中心相对于网格单元边界的值,而宽度(w)和高度(h)则是相对于整张图像来预测的。每个网格还要预测类别概率Pr(Object),存在类别概率的前提是存在目标,即置信度不为0的情况,

非极大值抑制(Non-Maximum Suppression,NMS)指抑制不是极大值的元素。在某个局部邻域内存在两个可变参数:邻域的维数和邻域的大小。以目标检测为例,图像上有无数个候选框,每个框可能代表某种目标。但是这些框会有重叠的部分,所以需要NMS去除概率较低的框,保留最优的结果。假设有N个框,每个框被分类器计算并得到分数为S

模型的训练和调整

目标检测模型的损失函数定义如下:

loss=C+S+P (2)

式(2)中,公式主要分为三个部分:C为类别预测的概率、S为目标的预测位置概率、P为置信度的损失。

损失函数通过BP算法不断更新模型,使loss值不断地减少。其中,类别预测的概率公式如下所示:

式(3)中,P

每个网格只对一个目标进行预测,需要计算该类别预测的损失,采用概率分布平方差计算方式。首先需要验证网格i内是否包含目标,其次计算预测值和真实值的平方差。

计算预测目标位置的损失函数:

式(4)中,x

预测目标位置的损失函数有两个部分:计算坐标中心的平方差和高度、宽度的平方差之和。预测置信度的损失函数如下计算:

式(5)中,C

最后,每个网格会得到5个预测值和1个类别信息,所以输入网格的尺度如式(6)所示:

S*S*(5*B+1) (6)

对于长时间(30分钟以上)出现在同一位置的同一个人,作为疑似钓鱼人,给出预警。

2.实验结果和分析

2.1实验数据

数据集采用不同场景(光照)下的水库钓鱼人图像,该数据集包含1000张图像。其中700张作为训练集训练模型,300张作为测试集进行验证,比例为7:3。训练时采用将60个样本作为处理单元,利用前向算法正则化更新参数。表1是模型的参数。

表1模型的参数

制作训练集时,选取不同场景下的水库钓鱼人,并用矩形框进行手工标注。标注信息采用PASCAL VOC数据集样式保存,其中包含水库钓鱼人目标的类别和边框信息。将数据进行归一化处理,设置在0~1之间的数值,以便快速处理不同尺度的图像。在模型的最后,是通过设定阈值得到最优结果,通过对阈值进行相关调整,最终阈值为0.5。

3.2实验结果

本实验使用深度神经网络完成了在自然状态下的水库钓鱼人检测任务。本发明对不同场景(光照)下的水库钓鱼人均能准确检测到。

本实验选取不同情况下的水库钓鱼人进行检测。在相同的数据集上,对图片亮度进行实验,分别设置为光照较亮(目标清晰可见)和光照较暗(目标模糊)。表2是水库钓鱼人检测的数据表示。

表2不同情况下的检测结果

由表2可知,光照较亮时的检测结果要比阴暗时的结果好,这是因为水库钓鱼人在光照较亮时的分辨率较高,网络可辨别的特征较多,而阴暗条件下的特征可辨率较低。实验表明,模型的精度较高、速度较快,在复杂的场景下鲁棒性更高。

本发明主要使用深度神经网络进行水库钓鱼人检测,首先介绍了水库钓鱼人检测的算法、检测框架和训练方法,然后介绍了水库钓鱼人检测相关实验的参数和结果。该发明使用一个端到端的模型,主要通过深度神经网络进行特征提取,使用网络提取候选边框,最后通过NMS进行过滤。经过实验证明,该发明在不同场景(光照)下能准确的检测出水库钓鱼人。

- 一种基于深度卷积神经网络的水库钓鱼人检测方法

- 一种基于深度卷积神经网络的水体变化检测方法和系统