输入方法及相关设备

文献发布时间:2023-06-19 19:37:02

技术领域

本公开涉及计算机技术领域,尤其涉及一种输入方法及相关设备。

背景技术

扩展现实(Extended Reality,简称XR),是指通过计算机将真实与虚拟相结合,打造一个可人机交互的虚拟环境。XR(扩展现实)技术可以进一步包含增强现实(AR)、虚拟现实(VR)、混合现实(MR),利用硬件设备结合多种技术手段,将虚拟的内容和真实场景融合。

在相关技术中,在扩展现实系统中实现输入的操作较为不便,用户体验欠佳。

发明内容

本公开提出一种输入方法及相关设备,以解决或部分解决上述问题。

本公开第一方面,提供了一种输入方法,包括:

响应于接收到输入请求,在目标画面中显示输入界面和辅助输入对象,所述辅助输入对象是根据所述输入界面与操作者的距离以及输入媒介中的至少其一而确定的;

接收所述输入媒介利用所述辅助输入对象操作所述输入界面而生成的输入指令;

输入所述输入指令对应的信息。

本公开第二方面,提供了一种输入装置,包括:

显示模块,被配置为:响应于接收到输入请求,在目标画面中显示输入界面和辅助输入对象,所述辅助输入对象是根据所述输入界面与操作者的距离以及输入媒介中的至少其一而确定的;

接收模块,被配置为:接收所述输入媒介利用所述辅助输入对象操作所述输入界面而生成的输入指令;

输入模块,被配置为:输入所述输入指令对应的信息。

本公开第三方面,提供了一种计算机设备,包括一个或者多个处理器、存储器;和一个或多个程序,其中所述一个或多个程序被存储在所述存储器中,并且被所述一个或多个处理器执行,所述程序包括用于执行根据第一方面所述的方法的指令。

本公开第四方面,提供了一种包含计算机程序的非易失性计算机可读存储介质,当所述计算机程序被一个或多个处理器执行时,使得所述处理器执行第一方面所述的方法。

本公开第五方面,提供了一种计算机程序产品,包括计算机程序指令,当所述计算机程序指令在计算机上运行时,使得计算机执行第一方面所述的方法。

本公开提供的输入方法及相关设备,根据输入媒介和/或模拟场景中输入界面与操作者的距离而显示相应的辅助输入对象,然后接收所述输入媒介操作所述辅助输入对象而生成的输入指令来输入对应的字符,使得当前的输入媒介和/或输入界面与操作者的距离不同时可以采用不同的输入模式来完成输入,方便了用户的操作。

附图说明

为了更清楚地说明本公开或相关技术中的技术方案,下面将对实施例或相关技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本公开的实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

图1示出了本公开实施例所提供的示例性系统的示意图。

图2示出了根据本公开实施例的示例性流程的示意图。

图3A示出了根据本公开实施例的示例性画面的示意图。

图3B示出了根据本公开实施例的示例性画面的示意图。

图3C示出了根据本公开实施例的示例性画面的示意图。

图3D示出了根据本公开实施例的示例性画面的示意图。

图3E示出了根据本公开实施例的一个示例性手势的示意图。

图3F示出了根据本公开实施例的示例性画面的示意图。

图3G示出了根据本公开实施例的一个示例性手势的示意图。

图4A示出了根据本公开实施例的示例性画面的示意图。

图4B示出了根据本公开实施例的示例性画面的示意图。

图4C示出了根据本公开实施例的示例性画面的示意图。

图4D示出了根据本公开实施例的示例性画面的示意图。

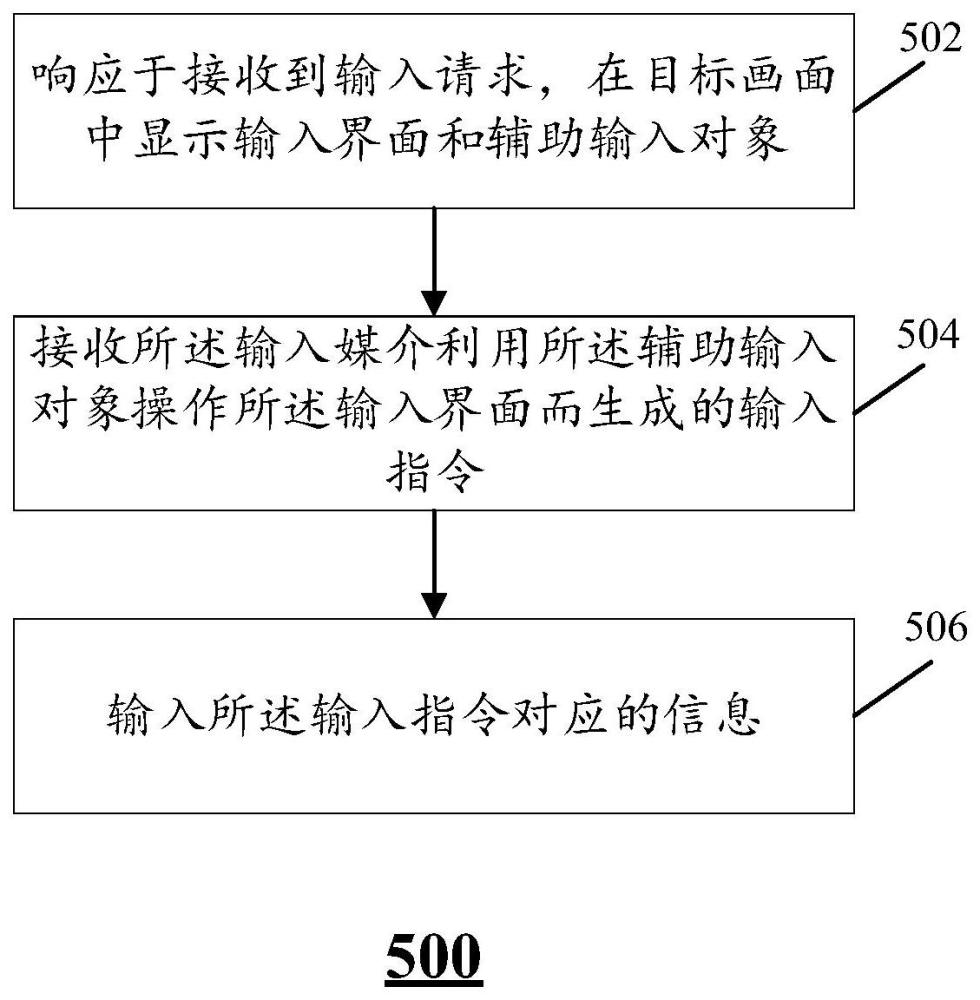

图5示出了本公开实施例所提供的一个示例性方法的示意图。

图6示出了本公开实施例所提供的示例性计算机设备的硬件结构示意图。

图7示出了本公开实施例所提供的一种示例性装置的示意图。

具体实施方式

为使本公开的目的、技术方案和优点更加清楚明白,以下结合具体实施例,并参照附图,对本公开进一步详细说明。

需要说明的是,除非另外定义,本公开实施例使用的技术术语或者科学术语应当为本公开所属领域内具有一般技能的人士所理解的通常意义。本公开实施例中使用的“第一”、“第二”以及类似的词语并不表示任何顺序、数量或者重要性,而只是用来区分不同的组成部分。“包括”或者“包含”等类似的词语意指出现该词前面的元件或者物件涵盖出现在该词后面列举的元件或者物件及其等同,而不排除其他元件或者物件。“连接”或者“相连”等类似的词语并非限定于物理的或者机械的连接,而是可以包括电性的连接,不管是直接的还是间接的。“上”、“下”、“左”、“右”等仅用于表示相对位置关系,当被描述对象的绝对位置改变后,则该相对位置关系也可能相应地改变。

图1示出了本公开实施例所提供的示例性扩展现实系统100的示意图。

如图1所示,该系统100可以包括头戴式可穿戴设备(例如,VR眼镜)104、穿戴手套106、操作手柄108。在一些场景中,还可以设置有用于拍摄操作者(用户)102的照片的相机/摄像头110。在一些实施例中,当前述的设备不具有处理功能时,系统100还可以包括外接的控制设备112,用于提供处理功能。该控制设备112,例如,可以是手机、电脑等计算机设备。在一些实施例中,前述的各设备中的任一设备作为控制设备或主控制设备时,可以与系统100中的其他设备通过有线或无线的通信方式来实现信息交互。

在系统100中,操作者102可以利用头戴式可穿戴设备(例如,VR眼镜)104、穿戴手套106、操作手柄108来实现与扩展现实系统100的交互。在一些场景中,系统100可以利用相机/摄像头110所采集的画面来识别操作者102的姿态、手势等,进而基于识别出的姿态、手势来完成与操作者102的交互。

在一些实施例中,头戴式可穿戴设备104、穿戴手套106和操作手柄108上均可以设置用于采集信息的采集单元。采集单元的类型可以有多个。例如,头戴式可穿戴设备104可以设置用于采集人眼画面的摄像头或电荷耦合器件(CCD)图像传感器、用于采集头戴式可穿戴设备104的速度信息或加速度信息的速度传感器、加速度传感器、角速度传感器(例如,陀螺仪)、用于采集脑电波信息的电极、用于采集神经肌肉反应信息的神经肌肉传感器(neuromuscular sensors)、用于采集体表温度的温度传感器,等等。又例如,穿戴手套106也可以设置用于采集穿戴手套106的速度信息或加速度信息的速度传感器、加速度传感器、角速度传感器(例如,陀螺仪)、用于采集神经肌肉反应信息的神经肌肉传感器(neuromuscular sensors)、用于采集体表温度的温度传感器,等等。需要说明的是,前述的采集单元除了可以设置在头戴式可穿戴设备104和穿戴手套106上之外,还可以设置在图1的操作手柄108,或者,不依托硬件设备而是直接通过贴附的方式设置在交互操作者102的身体部位上,从而采集该身体部位的相关信息,例如,速度或加速度或角速度信息,或者其他传感器或采集单元所采集的生物信息(例如,人眼图像(包含瞳孔图像)、神经肌肉反应信息、脑电波信息、体表温度,等等)。

在一些实施例中,系统100通过采集的信息可以对操作者102的姿态、手势等进行识别,进而可以进行相应的交互。

在一些实施例中,如图1所示,系统100还可以与服务器114进行通信,并可以从服务器114中获取数据,例如,图片、音频、视频等。在一些实施例中,如图1所示,服务器114可以从用于存储数据的数据库服务器116中调取所需的数据,例如,图片、音频、视频等。

扩展现实(XR)系统100可以允许操作者102与模拟场景中的数字世界进行交互。该模拟场景可以是虚拟场景或者虚实结合的场景。在一些情况下,可能需要操作者102在模拟场景中输入一些信息来完成交互。

在相关技术中,输入方法主要通过操作手柄108上的点击按钮对模拟场景中输入界面中的可触发对象进行键入。可以看出,采用这种输入方式,因为需要依赖操作手柄来实现输入,操作较为不便。

有鉴于此,本公开实施例提供了一种输入方法,根据输入媒介和/或模拟场景中输入界面与操作者的距离而显示相应的辅助输入对象,然后接收所述输入媒介操作所述辅助输入对象而生成的输入指令来输入对应的字符,使得当前的输入媒介和/或输入界面与操作者的距离不同时可以采用不同的输入模式来完成输入,方便了用户的操作。

图2示出了根据本公开实施例的示例性方法200的示意图。

如图2所示,该方法200可以用于供操作者102在模拟场景中输入信息,并可以由系统100中具有处理能力的设备来实施。作为一个可选实施例,可以由头戴式可穿戴设备104来实施。

如前所述,操作者102可以使用扩展现实系统100来与模拟场景中的数字世界进行交互,在这个过程中,可能存在操作者102需要输入信息的场景。例如,模拟场景中提供了一个模拟人类社会的数字世界,其中可以包括各种各样的可操作对象,例如,街边的商店。用户通过与这些可操作对象进行交互来获得一些服务,例如,用户可以在该商店购买一些虚拟产品。假设用户点击了该商店,从而可以进入商店提供的服务界面,在该服务界面中,用户可能需要输入一些信息。因此,可以理解认为,该点击操作生成了输入请求,该服务界面可以是一种输入界面。

图3A示出了根据本公开实施例的示例性画面300的示意图。

该画面300可以是操作者102通过头戴式可穿戴设备104观看到的画面,如图3A所示,在画面300中展示了一个模拟场景下的数字世界,其中,当接收到输入请求时(例如,点击了模拟场景中的某个商店),可以在画面300中显示一个输入界面302(该商店对应的服务界面)。

在一些实施例中,在输入界面302中可以显示多个可触发对象,例如,如图3A所示,在商店的服务界面中可以显示可供购买的商品的图标,这些图标被触发后可以生成相应的输入指令(例如,购买某个商品的指令),因此,这些图标可以被认为是所述可触发对象。在一些实施例中,如图3A所示,可触发对象还可以是输入栏,例如,供用户输入备注的输入栏。

在接收到输入请求之后,在一些实施例中,为了方便操作者102对可触发对象进行选择或触发,还可以显示辅助输入对象,用于辅助操作者来完成输入操作。

在相关技术中,一般是把输入界面302形成在距离操作者102较远的位置(可称为远场),这样从视觉效果上,输入界面302相对于页面300会比较小(参考图3C所示),会导致用户操作比较不方便。需要强调的是,目前本领域中比较常见的方案都是采用远场方式来显示输入界面302,没有近场的输入方式。并且,在相关技术中,一般是利用硬件输入设备(例如,操作手柄)来实现输入,而不支持徒手输入。

考虑到上述的情况,在一些实施例中,可以根据输入界面302处于较远位置(远场)或是处于较近位置(近场)以及操作者102所使用的输入媒介来分别设计所述辅助输入对象。这样,操作者102可以通过所述输入媒介(例如,操作手柄或者手)利用相应的辅助输入对象操作所述输入界面进而生成输入指令,从而在所述模拟场景中输入所述输入指令对应的信息。

在一些实施例中,若输入界面与操作者的距离小于第一距离,所述辅助输入对象可以包括用于操作所述输入界面的第一对象。若所述输入界面与操作者的距离大于第二距离,所述辅助输入对象可以包括用于操作所述输入界面的第二对象。这样,当输入界面与操作者的距离的远近不同时,可以采用不同的辅助输入对象来辅助实现输入指令,使得不同辅助输入对象可以在不同场景(远场或近场)下分别实现较好的操作体验,提升操作效率。可以理解的是,前述的第一距离和第二距离可以根据实际需要进行设置,具体数值可以不做限定。作为一个示例,第一距离可以是35cm,第二距离可以是50cm(或其他数值,以一手臂距离为主)。在计算输入界面与操作者的距离时,可以基于图像中所反映的三维世界的投影关系来进行确定,其中,操作者102的所在位置可以以最前端平面为基准,然后计算最前端平面和输入界面投影到三维空间中时,二者之间的距离。在一些实施例中,输入界面与操作者的距离也可以是以操作者的某个身体部位(例如,手或手指、脸或眼睛,等等)与输入界面之间的距离来计算,具体计算方式参考前面所述,在此不再赘述。

在一些实施例中,若输入界面与操作者的距离小于第一距离,根据输入媒介的不同,作为辅助输入对象的所述第一对象可以是不同的。

如图3A所示,若所述输入媒介为所述操作者的手,第一对象304可以包括手形图像3042和位于所述手形图像3042前端的指向点3044。所述手型图像3042可以用于反映操作者102的手在模拟场景中的所处位置,以使操作者102能够基于该手形图像3042来进行操作。手形图像3042前端的指向点3044可以作为该手型图像3042与模拟场景中的特定对象进行接触的点。这样,在确定操作者102是否触发输入界面302的某个可触发对象时,可以根据指向点3044的位置来进行判断。可以理解,由于手型图像3042占用面积较大,在确定操作者102的手势是否接触到了模拟场景中的某个对象时,可能会出现误判,增加设置指向点3044之后,可以使得操作更加精准。

在一些实施例中,该手形图像3042的形状可以不是固定的。例如,可以根据当前所识别到的操作者102在真实物理世界中的手势来生成相应的手形图像。作为一个可选实施例,识别操作者102在真实物理世界中的手势可以通过图1所示的相机/摄像头110来采集操作者102的图像或操作者102的手部的图像,或者,头戴式可穿戴设备104上可以设置拍摄环境画面的摄像头,然后可以利用该摄像头来采集操作者102的手部的图像,然后根据采集的图像来识别操作者102的手部当前的姿态,然后基于该姿态来生成相应的手形图像3042来显示在画面300中,从而增加操作者102在模拟场景中的真实感,提升用户体验。可以理解,由于手形图像3042的形态不固定,通过设置指向点3044,可以提高操作准确性。

接着,操作者102可以利用其手部来实现输入操作。例如,在图3A所示的状态下,可以先确定当前所述指向点和所述输入界面的位置来作为初始位置。然后,操作者102可以将手向前移动,相应地,系统100实时采集操作者102的图像或操作者102的手部的图像来进行识别,并根据识别结果确定操作者102的手在真实物理世界中的移动距离和移动方向,然后将该移动距离和移动方向映射到图3A所示的模拟场景中,进而确定手形图像3042的移动距离和移动方向,然后根据该移动距离和移动方向来确定指向点3044的当前位置,进而根据指向点3044的当前位置来确定指向点3044是否与所述输入界面302上的可触发对象相接触;若确定所述指向点3044与所述输入界面302上的可触发对象相接触,根据被接触的所述可触发对象生成相应的输入指令。

图3B示出了根据本公开实施例的示例性画面300的示意图。

如图3B所示,手形图像3042向前移动后,指向点3044与输入界面302上的一个可触发对象接触,则可以根据被接触的所述可触发对象生成相应的输入指令。如图3B所示,在一些实施例中,检测到指向点3044接触到某个可触发对象后,可以将该可触发对象进行高亮显示来起到提示作用。如图3B所示,在一些实施例中,手形图像3042在画面300中的位置可以根据真实物理世界中操作者102的手的位置的变化而实时变化,以帮助用户了解当前手部在模拟场景中的移动情况。

由此可见,前述实施例实现了操作者徒手输入的方案,扩展了应用范围,有利于提升用户体验。并且,当输入界面处于近场时,上述实施例可以实现徒手接触输入界面302来完成输入,能够提升真实感,用户体验更好。

作为一个可选实施例,在近场输入场景下,若输入媒介为硬件输入设备(例如,操作手柄),则作为辅助输入对象的第一对象可以与前述的第一对象有所不同,从而通过不同的第一对象来区分不同场景,增加系统丰富度,提升用户体验。

图3C示出了根据本公开实施例的示例性画面310的示意图。

如图3C所示,所述输入媒介为硬件输入设备(例如,操作手柄108),所述第一对象314包括所述硬件输入设备对应的图像3142和位于所述图像前端的指向点3144。所述图像3142可以用于反映硬件输入设备在模拟场景中的所处位置,以使操作者102能够基于该图像3142来进行操作。图像3142前端的指向点3144可以作为该图像3142与模拟场景中的特定对象进行接触的点。这样,在确定操作者102是否触发输入界面312的某个可触发对象时,可以根据指向点3144的位置来进行判断。可以理解,由于图像3142占用面积较大,在确定是否接触到了模拟场景中的某个对象时,可能会出现误判,增加设置指向点3144之后,可以使得操作更加精准。

在一些实施例中,该图像3142的姿态和位置可以是根据物理世界中硬件输入设备的变化而实时变化的。例如,可以根据当前所识别到的硬件输入设备在真实物理世界中的姿态和位置来生成相应的图像3142。作为一个可选实施例,识别硬件输入设备在真实物理世界中的姿态和位置可以通过图1所示的相机/摄像头110来采集操作者102的图像或操作者102所持有的硬件输入设备的图像,或者,头戴式可穿戴设备104上可以设置拍摄环境画面的摄像头,然后可以利用该摄像头来采集操作者102所持有的硬件输入设备的图像,然后根据采集的图像来识别硬件输入设备当前的姿态和位置,然后基于该姿态和位置来生成相应的图像3142来显示在画面310中,从而增加操作者102在模拟场景中的真实感,提升用户体验。可以理解,由于图像3142的姿态不固定,通过设置指向点3144,可以提高操作准确性。

接着,操作者102可以利用其硬件输入设备来实现输入操作。例如,在图3C所示的状态下,可以先确定当前所述指向点和所述输入界面的位置来作为初始位置。然后,操作者102可以将硬件输入设备向前移动,相应地,系统100实时采集操作者102的图像或硬件输入设备的图像来进行识别,并根据识别结果确定硬件输入设备在真实物理世界中的移动距离和移动方向,然后将该移动距离和移动方向映射到图3C所示的模拟场景中,进而确定图像3142的移动距离和移动方向,然后根据该移动距离和移动方向来确定指向点3144的当前位置,进而根据指向点3144的当前位置来确定指向点3144是否与所述输入界面312上的可触发对象相接触;若确定所述指向点3144与所述输入界面302上的可触发对象相接触,根据被接触的所述可触发对象生成相应的输入指令。

作为一个可选实施例,如前所述,硬件输入设备为操作手柄108时,其中可以设置用于采集速度信息或加速度信息的速度传感器、加速度传感器、角速度传感器(例如,陀螺仪),因此,在计算前述的移动距离和移动方向时,可以利用速度传感器、加速度传感器、角速度传感器(例如,陀螺仪)所采集的信息来进行计算,而无需通过图像识别来处理。

在一些实施例中,所述硬件输入设备还可以是穿戴手套106,可以理解,穿戴手套采集的信息可以模拟出操作者102的手的姿态,因此,当硬件输入设备是穿戴手套106时,在显示硬件输入设备的图像时,可以将该图像模拟成手形图像(而非穿戴手套的图像),进而可以提升真实感。

从上述实施例可以看出,本公开的一些实施例可以结合硬件、徒手两种不同的控制方式来设计不同的输入融合方案,扩展了产品的适用范围,提升了用户体验。

在一些实施例中,若输入界面与操作者的距离大于第二距离,根据输入媒介的不同,作为辅助输入对象的所述第二对象也可以是不同的。

图3D示出了根据本公开实施例的示例性画面320的示意图。

如图3D所示,若所述输入媒介为所述操作者的手,第二对象324可以包括手形图像3242和从所述手形图像指向所述输入界面的射线3244。所述手形图像3242可以用于反映操作者102的手在模拟场景中的所处位置,以使操作者102能够基于该手形图像3242来进行操作。射线3244的前端可以作为该手形图像3242与模拟场景中的特定对象进行接触的点。这样,在确定操作者102是否触发输入界面322的某个可触发对象时,可以根据射线3244的前端的位置来进行判断。可以理解,由于输入界面322距离操作者102的距离较远,使得操作者102无法通过点击的方式来操作输入界面322,通过射线3244能够瞄准相应可触发对象,起到指示作用。

可以理解,射线3244可以起到指示的作用,在一些实施例中,可以利用输入媒介来调整射线3244的指向,从而实现射线3244的前端在不同的可触发对象之间移动。

在一些实施例中,该手形图像3242的形状可以不是固定的。例如,可以根据当前所识别到的操作者102在真实物理世界中的手势来生成相应的手形图像。作为一个可选实施例,识别操作者102在真实物理世界中的手势可以通过图1所示的相机/摄像头110来采集操作者102的图像或操作者102的手部的图像,或者,头戴式可穿戴设备104上可以设置拍摄环境画面的摄像头,然后可以利用该摄像头来采集操作者102的手部的图像,然后根据采集的图像来识别操作者102的手部当前的姿态,然后基于该姿态来生成相应的手形图像3242来显示在画面300中,从而增加操作者102在模拟场景中的真实感,提升用户体验。

如前所述,当操作者102徒手实现输入操作时,可以通过图像识别的方式来识别操作者102的手势,进而实现相应的操作。作为一个可选实施例,可以通过识别操作者102的手部姿态来确定是否需要显示射线3244。例如,当识别到操作者102的手部姿态是食指向前而其他手指蜷缩,则认为操作者102当前需要进行输入操作,进而显示射线3244,并且射线3244的后端与手形图像3242的食指端部相接触,进而形成一条从食指端部延伸到输入界面322的射线,从辅助操作的角度,能够更好地帮助操作者102来进行可触发对象的选择。

在一些实施例中,手形图像3242的移动以及射线3244的移动都可以采用前述的图像识别方法来完成,并且,可以基于图像识别来确定移动距离和移动方向,在此不再赘述。

由于输入界面322距离较远且射线3244的前端在移动时存在不稳定性(指向不一定准确),因此,在一些实施例中,当射线3244指向某个可触发对象时,并不会直接触发该对象,而是需要等待操作者102发出选择指令,才能触发该对象。

因此,在实施输入操作时,当操作者102利用手部的移动选定一个可触发对象时(射线3244前端指向该可触发对象),可以采用特定手势来生成选择指令。在一些实施例中,可以获取至少两帧目标画面(例如,设备104所显示的画面),然后从这至少两帧目标画面中分别识别得到至少两帧手形图像,再根据所述至少两帧手形图像识别所述操作者的手势。若识别到的所述操作者的手势与第一预设手势(例如,捏合(Pinch)手势)相匹配,则可以确定接收到选择指令。

图3E示出了根据本公开实施例的一个示例性手势的示意图。

如图3E所示,通过两帧图像中的手形图像可以确定操作者当前的手势是捏合手势,从而确定操作者102发出了选择指令。然后,可以根据当前射线3244指向的可触发对象来生成输入指令,进而输入所述输入指令对应的信息。

可以理解的是,第一预设手势可以是任意的手势,并不局限在前述的捏合手势。但是,当采用捏合手势时,操作者102可以实现食指指向所选择的可触发对象而大拇指实现捏合操作,可以在单手情况下完成输入操作,使用较为方便。

作为一个可选实施例,在远场输入场景下,若输入媒介为硬件输入设备(例如,操作手柄),则作为辅助输入对象的第二对象可以与前述的第二对象有所不同,从而通过不同的第二对象来区分不同场景,增加系统丰富度,提升用户体验。

图3F示出了根据本公开实施例的示例性画面330的示意图。

如图3F所示,若所述输入媒介为硬件输入设备,所述第二对象334可以包括指向所述输入界面332的射线3344。可选地,如图3F所示,该射线3344可以是从画面底部延伸到输入界面332的射线。

作为可选实施例,射线3344的移动距离和移动方向可以采用前述的图像识别或者根据传感器采集的数据进行计算而处理得到,在此不再赘述。

可以理解,与前述实施例类似地,由于输入界面332距离较远且射线3344的前端在移动时存在不稳定性(指向不一定准确),因此,在一些实施例中,当射线3344指向某个可触发对象时,并不会直接触发该对象,而是需要等待操作者102发出选择指令,才能触发该对象。

作为一个可选实施例,若所述硬件输入设备为操作手柄108,可以按下该手柄108上的确认按键来发出选择指令。作为另一个可选实施例,若所述硬件输入设备为穿戴手套106,可以采用前述的捏合手势来发出选择指令。具体实施时,可根据需要进行设计。

对比远场和近场输入方式,可以理解,远场输入时,会射出一条射线,射线的顶端作为锚点,锚点选择在可触发对象上,点击确认按钮或采用捏合手势后选择。这样的方法,因为射线距离较长,可能存在远场操控因长力臂导致输入点晃动,操作者可能会产生输入的不安全感以及影响到输入的精度。因此,作为一个可选实施例,当在画面中显示输入界面时,默认状态下可以是近场输入模式,例如,图3A和图3C所示的模式(根据输入媒介的不同而不同)。

可以理解,有的操作者可能因为使用习惯的不同,需要调整输入界面的距离远近(以使输入界面显示在自己观察起来较为舒适的特定距离的位置),或者,想要采用远场模式来实现输入。因此,在一些实施例中,可以提供调整输入界面的距离远近的方式。

作为一个可选实施例,输入界面上可以设置一个用于调整界面距离远近的按钮,通过点击该按钮可以调整输入界面的距离远近。可选地,该按钮可以有两个,一个用于推远界面,一个用于拉近界面,点击对应的按钮可以将界面推远或者拉近。

可选地,当操作者102是徒手输入时,可以利用手势来实现输入界面的距离调整。当操作者102是利用硬件输入设备实现输入时,可以进一步分为两种情况,若硬件输入设备设置有按键(例如,操作手柄108),则可以利用特定按键来实现输入界面的距离调整;若硬件输入设备没有按键(例如,穿戴手套106),则可以利用手势来实现输入界面的距离调整。

作为一个可选实施例,操作手柄108上可以设置用于启动距离调整机制的按键(Trigger)和用于调整距离的摇杆(Joystick),操作者102可以通过按下该启动按键然后往前或往后拨动该摇杆来控制输入界面的距离。例如,当往前拨动摇杆可以将输入界面向远处推动,当往后拨动摇杆则可以将输入界面向近处拉动。

作为一个可选实施例,在徒手和穿戴手套的场景下均可以采用手势来实现输入界面的距离调整。可选地,头戴式可穿戴设备104可以获取至少两帧所述目标画面并从至少两帧所述目标画面中分别识别得到至少两帧手形图像,然后根据所述至少两帧手形图像识别所述操作者的手势。若确定所述操作者的手势与第二预设手势相匹配,根据所述操作者的手势在当前目标画面中移动所述输入界面。具体的识别方法可以参考前述实施例,在此不再赘述。

可以理解,在识别操作者的手势与第二预设手势是否相匹配时,该第二预设手势可以根据需要进行设定。作为一个可选实施例,可以使用将展开的手掌逐渐握拳或者握拳手势逐渐展开来实现将输入界面逐渐拉近或推远,如图3G所示。作为另一个可选实施例,可以利用捏合手势(如图3E所示)加上拖拽来实现将输入界面拉近,或者,利用手掌手势向前推动来实现将输入界面推远。

在一些实施例中,还可以根据识别的手势来确定输入界面的移动距离,例如,根据手掌的展开或握紧的程度来计算距离。又例如,根据捏合手势拉近的距离来计算输入界面被拉近的距离,根据手掌推动的距离来计算输入界面被推远的距离,等等。

这样,就可以实现将输入界面拉近或推远,操作也十分方便。

根据前面所述,本公开实施例提供了多种输入模式,并且,可以实现将输入界面推远或拉近,因此,在一些实施例中,当操作者与输入界面的距离变化到从近场进入远场(大于第二距离)或者从远场进入近场(小于第一距离),可以将显示的画面中的辅助输入对象进行切换。例如,当操作者使用的是徒手输入方式,则从近场进入远场时,可以从图3A切换为图3D所示的画面,反之,可以从图3D切换为图3A所示的画面。类似地,当操作者使用的是硬件输入设备来实现输入,则从近场进入远场时,可以从图3C切换为图3F所示的画面,反之,可以从图3F切换为图3C所示的画面。

作为一个可选实施例,实现前述的切换可以具体采用以下步骤:

确定移动前和移动后的所述输入界面与所述操作者的距离;

响应于确定移动前和移动后的所述输入界面与所述操作者的距离分别对应不同的辅助输入对象,在当前目标画面中切换显示与移动后的所述输入界面与所述操作者的距离对应的辅助输入对象。

这样,就实现了远近场模式的自动切换,方便了用户操作,提升用户体验。

在一些实施例中,除了前述实施例中点选输入的输入界面的实施例外,输入界面还可以显示键盘,以使操作者可以输入一些较为复杂的内容/字符。

作为一个可选实施例,如图3A所示,在输入界面302中有备注栏,操作者102点击该备注栏可以进一步发出新的输入请求,进而输入界面可以切换到包括键盘的界面402,如图4A所示。

在图4A中,画面400的输入界面402可以包括两个部分,一个部分是输入内容的显示界面4022,另一个部分可以是键盘界面4024,上面包括多个键盘按键作为可触发对象。如图4A所示,当操作者102采用徒手输入时,画面400中同样可以显示手形图像4042和指向点4044来作为第一对象404。操作者102在画面400的场景下实现输入的方式与图3A和图3B的输入方式类似,并可以具有类似的实施例,在此不再赘述。

图4B示出了根据本公开实施例的示例性画面410的示意图。

如图4B所示,若操作者102在图3C所示的输入界面312中点击了备注栏,可以进一步显示画面410。在图4B中,画面410的输入界面412也可以包括两个部分,一个部分是输入内容的显示界面4122,另一个部分可以是键盘界面4124,上面包括多个键盘按键作为可触发对象。如图4B所示,当操作者102采用硬件输入设备输入时,画面410中同样可以显示硬件输入设备的图像4142和指向点4144来作为第一对象414。操作者102在画面410的场景下实现输入的方式与图3C的输入方式类似,并可以具有类似的实施例,在此不再赘述。

图4C示出了根据本公开实施例的示例性画面420的示意图。

如图4C所示,若操作者102在图3D所示的输入界面322中点击了备注栏,可以进一步显示画面420。在图4C中,画面420的输入界面422也可以包括两个部分,一个部分是输入内容的显示界面4222,另一个部分可以是键盘界面4224,上面包括多个键盘按键作为可触发对象。如图4C所示,当操作者102采用徒手输入时,画面420中同样可以显示手形图像4242和指向输入界面422的射线4244来作为第二对象424。操作者102在画面420的场景下实现输入的方式与图3D的输入方式类似,并可以具有类似的实施例,在此不再赘述。

图4D示出了根据本公开实施例的示例性画面430的示意图。

如图4D所示,若操作者102在图3F所示的输入界面332中点击了备注栏,可以进一步显示画面430。在图4D中,画面430的输入界面432也可以包括两个部分,一个部分是输入内容的显示界面4322,另一个部分可以是键盘界面4324,上面包括多个键盘按键作为可触发对象。如图4D所示,当操作者102采用硬件输入设备输入时,画面430中同样可以显示指向输入界面432的射线4344来作为第二对象434。操作者102在画面430的场景下实现输入的方式与图3F的输入方式类似,并可以具有类似的实施例,在此不再赘述。

需要说明的是,除了输入界面存在差异外,图4A~图4D所示的实施例与图3A~3F所示的实施例具有对应关系,例如,在接收到新的输入请求(点击备注栏)时,可以再次实施对距离和输入媒介的判断步骤以及根据距离和/或输入媒介来显示输入界面和辅助输入对象,然后基于此来实现信息输入。因此,图4A~图4D所示的实施例可以具有图3A~3F所示的实施例相类似的具体实施方式以及相应的技术效果,此处不再赘述。

在一些实施例中,除了根据输入界面与操作者的距离以及输入媒介中的至少其一来确定输入界面和辅助输入对象外,还可以结合操作者的输入意图来确定输入界面和辅助输入对象。例如,若当前处于在备注栏中输入内容的场景(此时可以识别操作者的输入意图是键盘输入),为了方便操作者能够更快地输入字符,可以将输入界面显示在近场中(如图4A或图4B所示),使得操作者102可以通过点击输入方式快速输入信息。

从上述实施例可以看出,本公开实施例提供的输入方法,建立识别模型进行当前状态的判断,给出符合当前状态的键盘交互形态;并且,根据不同输入媒介提供了对应的远近场输入方案,方便用户使用;此外,还可以支持自动与手动的远近场输入方式的切换。本公开实施例提供的输入方法,同时兼容手柄、手势输入时远场与近场的交互操作,近场输入时根据距离与输入媒介模拟用户意图,支持点击或敲击的方式进行输入,方便用户使用,提升用户体验。

本公开实施例还提供了一种输入方法。图5示出了本公开实施例所提供的示例性方法500的流程示意图。该方法500可以应用于图1的头戴式可穿戴设备104,也可以应用于图1的外接设备112。在一些情况下,还可以应用于设备106、108和110。如图5所示,该方法500可以进一步包括以下步骤。

在步骤502,响应于接收到输入请求,在目标画面(例如,图3A的画面300、图3C的画面310、图3D的画面320、图3F的画面330、图4A~图4D的画面400~430)中显示输入界面(例如,图3A的界面302、图3C的界面312、图3D的界面322、图3F的界面332、图4A~图4D的界面402~432)和辅助输入对象(例如,图3A的辅助输入对象304、图3C的辅助输入对象314、图3D的辅助输入对象324、图3F的辅助输入对象334、图4A~图4D的辅助输入对象404~434)。其中,所述辅助输入对象是根据所述输入界面与操作者的距离以及输入媒介中的至少其一而确定的。

在步骤504,接收所述输入媒介利用所述辅助输入对象操作所述输入界面而生成的输入指令。

在步骤506,输入所述输入指令对应的信息。

本公开实施例提供的输入方法,根据输入媒介和/或模拟场景中输入界面与操作者的距离而显示相应的辅助输入对象,然后接收所述输入媒介操作所述辅助输入对象而生成的输入指令来输入对应的字符,使得当前的输入媒介和/或输入界面与操作者的距离不同时可以采用不同的输入模式来完成输入,方便了用户的操作。

在一些实施例中,所述输入界面与操作者的距离小于第一距离(例如,35cm),所述辅助输入对象包括用于操作所述输入界面的第一对象(例如,图3A的对象304、图3C的对象314、图4A~图4B的对象404~414)。在一些实施例中,所述输入界面与操作者的距离大于第二距离(例如,50cm),所述辅助输入对象包括用于操作所述输入界面的第二对象(例如,图3D的对象324、图3F的对象334、图4C~图4D的对象424~434)。这样,当输入界面与操作者的距离的远近不同时,可以采用不同的辅助输入对象来辅助实现输入指令,使得不同辅助输入对象可以在不同场景(远场或近场)下分别实现较好的操作体验,提升操作效率。可以理解的是,前述的第一距离和第二距离可以根据实际需要进行设置,具体数值可以不做限定。作为一个示例,第一距离可以是35cm,第二距离可以是50cm(或其他数值,以一手臂距离为主)。

在一些实施例中,所述输入媒介为硬件输入设备,所述第一对象包括所述硬件输入设备对应的图像(例如,图3C的图像3142、图4B的图像4142)和位于所述图像前端的指向点(例如,图3C的指向点3144、图4B的指向点4144);或者,所述输入媒介为所述操作者的手,所述第一对象包括手形图像(例如,图3A的手形图像3042、图4A的手形图像4042)和位于所述手形图像前端的指向点(例如,图3A的指向点3044、图4A的指向点4044)。在不同的场景中采用不同的辅助输入对象,有利于帮助操作者实现输入操作和提升用户体验。

在一些实施例中,接收所述输入媒介利用所述辅助输入对象操作所述输入界面而生成的输入指令之前,所述方法还包括:确定所述指向点和所述输入界面的初始位置;

接收所述输入媒介利用所述辅助输入对象操作所述输入界面而生成的输入指令,包括:

确定所述输入媒介的移动距离;

根据所述输入媒介的移动距离,确定所述指向点的移动距离;

根据所述指向点和所述输入界面的初始位置,结合所述指向点的移动距离,确定所述指向点是否与所述输入界面上的可触发对象相接触;

响应于确定所述指向点与所述输入界面上的可触发对象相接触,根据被接触的所述可触发对象生成所述输入指令,从而实现了近场的输入操作,用户的操作也十分方便。

在一些实施例中,所述输入媒介为硬件输入设备,所述第二对象包括指向所述输入界面的射线(例如,图3F的射线3344、图4D的射线4344);或者,所述输入媒介为所述操作者的手,所述第二对象包括手形图像和从所述手形图像指向所述输入界面的射线(例如,图3D的射线3244、图4C的射线4244)。在不同的场景中采用不同的辅助输入对象,有利于帮助操作者实现输入操作和提升用户体验。

在一些实施例中,接收所述输入媒介利用所述辅助输入对象操作所述输入界面而生成的输入指令,包括:响应于接收到基于所述输入媒介发送的选择指令,根据所述第二对象与所述输入界面上可触发对象的对应关系,生成所述输入指令。结合选择指令来实现输入,能够更加符合用户使用习惯和操作习惯。

在一些实施例中,接收所述输入媒介利用所述辅助输入对象操作所述输入界面而生成的输入指令,包括:响应于确定所述输入媒介为所述操作者的手,获取至少两帧所述目标画面;从至少两帧所述目标画面中分别识别得到至少两帧手形图像;根据所述至少两帧手形图像识别所述操作者的手势;响应于确定所述操作者的手势与第一预设手势相匹配,确定接收到选择指令。采用手势实现选择指令的发送,能够更加符合用户使用习惯和操作习惯,同时也能提升用户体验。

在一些实施例中,所述输入媒介为所述操作者的手,所述方法还包括:获取至少两帧所述目标画面;从至少两帧所述目标画面中分别识别得到至少两帧手形图像;根据所述至少两帧手形图像识别所述操作者的手势;响应于确定所述操作者的手势与第二预设手势相匹配,根据所述操作者的手势在当前目标画面中移动所述输入界面。采用手势实现输入界面的移动,能够更加符合用户使用习惯和操作习惯,同时也能提升用户体验。

在一些实施例中,根据所述操作者的手势在当前目标画面中移动所述输入界面之后,所述方法还包括:确定移动前和移动后的所述输入界面与所述操作者的距离;响应于确定移动前和移动后的所述输入界面与所述操作者的距离分别对应不同的辅助输入对象,在当前目标画面中切换显示与移动后的所述输入界面与所述操作者的距离对应的辅助输入对象,从而实现远近场的自动切换,提升用户体验。

在一些实施例中,所述方法还包括:根据所述输入请求确定所述操作者的输入意图;在目标画面中显示输入界面和辅助输入对象,包括:根据所述输入意图,在目标画面中显示输入界面和辅助输入对象,从而拓展了适用范围。

需要说明的是,本公开实施例的方法可以由单个设备执行,例如一台计算机或服务器等。本实施例的方法也可以应用于分布式场景下,由多台设备相互配合来完成。在这种分布式场景的情况下,这多台设备中的一台设备可以只执行本公开实施例的方法中的某一个或多个步骤,这多台设备相互之间会进行交互以完成所述的方法。

需要说明的是,上述对本公开的一些实施例进行了描述。其它实施例在所附权利要求书的范围内。在一些情况下,在权利要求书中记载的动作或步骤可以按照不同于上述实施例中的顺序来执行并且仍然可以实现期望的结果。另外,在附图中描绘的过程不一定要求示出的特定顺序或者连续顺序才能实现期望的结果。在某些实施方式中,多任务处理和并行处理也是可以的或者可能是有利的。

本公开实施例还提供了一种计算机设备,用于实现上述的方法500。图6示出了本公开实施例所提供的示例性计算机设备600的硬件结构示意图。计算机设备600可以用于实现图1的头戴式可穿戴设备104,也可以用于实现图1的外接设备112,也可以用于实现图1的服务器114。在一些场景中,该计算机设备600也可以用于实现图1的数据库服务器116。

如图6所示,计算机设备600可以包括:处理器602、存储器604、网络模块606、外围接口608和总线610。其中,处理器602、存储器604、网络模块606和外围接口608通过总线610实现彼此之间在计算机设备600的内部的通信连接。

处理器602可以是中央处理器(Central Processing Unit,CPU)、图像处理器、神经网络处理器(NPU)、微控制器(MCU)、可编程逻辑器件、数字信号处理器(DSP)、应用专用集成电路(Application Specific Integrated Circuit,ASIC)、或者一个或多个集成电路。处理器602可以用于执行与本公开描述的技术相关的功能。在一些实施例中,处理器602还可以包括集成为单一逻辑组件的多个处理器。例如,如图6所示,处理器602可以包括多个处理器602a、602b和602c。

存储器604可以配置为存储数据(例如,指令、计算机代码等)。如图6所示,存储器604存储的数据可以包括程序指令(例如,用于实现本公开实施例的方法500的程序指令)以及要处理的数据(例如,存储器可以存储其他模块的配置文件等)。处理器602也可以访问存储器604存储的程序指令和数据,并且执行程序指令以对要处理的数据进行操作。存储器604可以包括易失性存储装置或非易失性存储装置。在一些实施例中,存储器604可以包括随机访问存储器(RAM)、只读存储器(ROM)、光盘、磁盘、硬盘、固态硬盘(SSD)、闪存、存储棒等。

网络接口606可以配置为经由网络向计算机设备600提供与其他外部设备的通信。该网络可以是能够传输和接收数据的任何有线或无线的网络。例如,该网络可以是有线网络、本地无线网络(例如,蓝牙、WiFi、近场通信(NFC)等)、蜂窝网络、因特网、或上述的组合。可以理解的是,网络的类型不限于上述具体示例。

外围接口608可以配置为将计算机设备600与一个或多个外围装置连接,以实现信息输入及输出。例如,外围装置可以包括键盘、鼠标、触摸板、触摸屏、麦克风、各类传感器等输入设备以及显示器、扬声器、振动器、指示灯等输出设备。

总线610可以被配置为在计算机设备600的各个组件(例如处理器602、存储器604、网络接口606和外围接口608)之间传输信息,诸如内部总线(例如,处理器-存储器总线)、外部总线(USB端口、PCI-E总线)等。

需要说明的是,尽管上述计算机设备600的架构仅示出了处理器602、存储器604、网络接口606、外围接口608和总线610,但是在具体实施过程中,该计算机设备600的架构还可以包括实现正常运行所必需的其他组件。此外,本领域的技术人员可以理解的是,上述计算机设备600的架构中也可以仅包含实现本公开实施例方案所必需的组件,而不必包含图中所示的全部组件。

本公开实施例还提供了一种输入装置。图7示出了本公开实施例所提供的示例性装置700的示意图。如图7所示,该装置700可以用于实现方法500,并可以进一步包括以下模块。

显示模块702,被配置为:响应于接收到输入请求,在目标画面(例如,图3A的画面300、图3C的画面310、图3D的画面320、图3F的画面330、图4A~图4D的画面400~430)中显示输入界面(例如,图3A的界面302、图3C的界面312、图3D的界面322、图3F的界面332、图4A~图4D的界面402~432)和辅助输入对象(例如,图3A的辅助输入对象304、图3C的辅助输入对象314、图3D的辅助输入对象324、图3F的辅助输入对象334、图4A~图4D的辅助输入对象404~434)。其中,所述辅助输入对象是根据所述输入界面与操作者的距离以及输入媒介中的至少其一而确定的。

接收模块704,被配置为:接收所述输入媒介利用所述辅助输入对象操作所述输入界面而生成的输入指令。

输入模块706,被配置为:输入所述输入指令对应的信息。

本公开实施例提供的输入装置,根据输入媒介和/或模拟场景中输入界面与操作者的距离而显示相应的辅助输入对象,然后接收所述输入媒介操作所述辅助输入对象而生成的输入指令来输入对应的字符,使得当前的输入媒介和/或输入界面与操作者的距离不同时可以采用不同的输入模式来完成输入,方便了用户的操作。

在一些实施例中,所述输入界面与操作者的距离小于第一距离(例如,35cm),所述辅助输入对象包括用于操作所述输入界面的第一对象(例如,图3A的对象304、图3C的对象314、图4A~图4B的对象404~414)。在一些实施例中,所述输入界面与操作者的距离大于第二距离(例如,50cm),所述辅助输入对象包括用于操作所述输入界面的第二对象(例如,图3D的对象324、图3F的对象334、图4C~图4D的对象424~434)。这样,当输入界面与操作者的距离的远近不同时,可以采用不同的辅助输入对象来辅助实现输入指令,使得不同辅助输入对象可以在不同场景(远场或近场)下分别实现较好的操作体验,提升操作效率。可以理解的是,前述的第一距离和第二距离可以根据实际需要进行设置,具体数值可以不做限定。作为一个示例,第一距离可以是35cm,第二距离可以是50cm(或其他数值,以一手臂距离为主)。

在一些实施例中,所述输入媒介为硬件输入设备,所述第一对象包括所述硬件输入设备对应的图像(例如,图3C的图像3142、图4B的图像4142)和位于所述图像前端的指向点(例如,图3C的指向点3144、图4B的指向点4144);或者,所述输入媒介为所述操作者的手,所述第一对象包括手形图像(例如,图3A的手形图像3042、图4A的手形图像4042)和位于所述手形图像前端的指向点(例如,图3A的指向点3044、图4A的指向点4044)。在不同的场景中采用不同的辅助输入对象,有利于帮助操作者实现输入操作和提升用户体验。

在一些实施例中,接收模块704,被配置为:确定所述指向点和所述输入界面的初始位置;确定所述输入媒介的移动距离;根据所述输入媒介的移动距离,确定所述指向点的移动距离;根据所述指向点和所述输入界面的初始位置,结合所述指向点的移动距离,确定所述指向点是否与所述输入界面上的可触发对象相接触;响应于确定所述指向点与所述输入界面上的可触发对象相接触,根据被接触的所述可触发对象生成所述输入指令,从而实现了近场的输入操作,用户的操作也十分方便。

在一些实施例中,所述输入媒介为硬件输入设备,所述第二对象包括指向所述输入界面的射线(例如,图3F的射线3344、图4D的射线4344);或者,所述输入媒介为所述操作者的手,所述第二对象包括手形图像和从所述手形图像指向所述输入界面的射线(例如,图3D的射线3244、图4C的射线4244)。在不同的场景中采用不同的辅助输入对象,有利于帮助操作者实现输入操作和提升用户体验。

在一些实施例中,接收模块704,被配置为:响应于接收到基于所述输入媒介发送的选择指令,根据所述第二对象与所述输入界面上可触发对象的对应关系,生成所述输入指令。结合选择指令来实现输入,能够更加符合用户使用习惯和操作习惯。

在一些实施例中,接收模块704,被配置为:响应于确定所述输入媒介为所述操作者的手,获取至少两帧所述目标画面;从至少两帧所述目标画面中分别识别得到至少两帧手形图像;根据所述至少两帧手形图像识别所述操作者的手势;响应于确定所述操作者的手势与第一预设手势相匹配,确定接收到选择指令。采用手势实现选择指令的发送,能够更加符合用户使用习惯和操作习惯,同时也能提升用户体验。

在一些实施例中,所述输入媒介为所述操作者的手,显示模块702,被配置为:获取至少两帧所述目标画面;从至少两帧所述目标画面中分别识别得到至少两帧手形图像;根据所述至少两帧手形图像识别所述操作者的手势;响应于确定所述操作者的手势与第二预设手势相匹配,根据所述操作者的手势在当前目标画面中移动所述输入界面。采用手势实现输入界面的移动,能够更加符合用户使用习惯和操作习惯,同时也能提升用户体验。

在一些实施例中,显示模块702,被配置为:确定移动前和移动后的所述输入界面与所述操作者的距离;响应于确定移动前和移动后的所述输入界面与所述操作者的距离分别对应不同的辅助输入对象,在当前目标画面中切换显示与移动后的所述输入界面与所述操作者的距离对应的辅助输入对象,从而实现远近场的自动切换,提升用户体验。

在一些实施例中,显示模块702,被配置为:根据所述输入请求确定所述操作者的输入意图;根据所述输入意图,在目标画面中显示输入界面和辅助输入对象,从而拓展了适用范围。

为了描述的方便,描述以上装置时以功能分为各种模块分别描述。当然,在实施本公开时可以把各模块的功能在同一个或多个软件和/或硬件中实现。

上述实施例的装置用于实现前述任一实施例中相应的方法500,并且具有相应的方法实施例的有益效果,在此不再赘述。

基于同一发明构思,与上述任意实施例方法相对应的,本公开还提供了一种非暂态计算机可读存储介质,所述非暂态计算机可读存储介质存储计算机指令,所述计算机指令用于使所述计算机执行如上任一实施例所述的方法500。

本实施例的计算机可读介质包括永久性和非永久性、可移动和非可移动媒体可以由任何方法或技术来实现信息存储。信息可以是计算机可读指令、数据结构、程序的模块或其他数据。计算机的存储介质的例子包括,但不限于相变内存(PRAM)、静态随机存取存储器(SRAM)、动态随机存取存储器(DRAM)、其他类型的随机存取存储器(RAM)、只读存储器(ROM)、电可擦除可编程只读存储器(EEPROM)、快闪记忆体或其他内存技术、只读光盘只读存储器(CD-ROM)、数字多功能光盘(DVD)或其他光学存储、磁盒式磁带,磁带磁磁盘存储或其他磁性存储设备或任何其他非传输介质,可用于存储可以被计算设备访问的信息。

上述实施例的存储介质存储的计算机指令用于使所述计算机执行如上任一实施例所述的方法500,并且具有相应的方法实施例的有益效果,在此不再赘述。

基于同一发明构思,与上述任意实施例方法500相对应的,本公开还提供了一种计算机程序产品,其包括计算机程序。在一些实施例中,所述计算机程序由一个或多个处理器可执行以使得所述处理器执行所述的方法500。对应于方法500各实施例中各步骤对应的执行主体,执行相应步骤的处理器可以是属于相应执行主体的。

上述实施例的计算机程序产品用于使处理器执行如上任一实施例所述的方法500,并且具有相应的方法实施例的有益效果,在此不再赘述。

所属领域的普通技术人员应当理解:以上任何实施例的讨论仅为示例性的,并非旨在暗示本公开的范围(包括权利要求)被限于这些例子;在本公开的思路下,以上实施例或者不同实施例中的技术特征之间也可以进行组合,步骤可以以任意顺序实现,并存在如上所述的本公开实施例的不同方面的许多其它变化,为了简明它们没有在细节中提供。

另外,为简化说明和讨论,并且为了不会使本公开实施例难以理解,在所提供的附图中可以示出或可以不示出与集成电路(IC)芯片和其它部件的公知的电源/接地连接。此外,可以以框图的形式示出装置,以便避免使本公开实施例难以理解,并且这也考虑了以下事实,即关于这些框图装置的实施方式的细节是高度取决于将要实施本公开实施例的平台的(即,这些细节应当完全处于本领域技术人员的理解范围内)。在阐述了具体细节(例如,电路)以描述本公开的示例性实施例的情况下,对本领域技术人员来说显而易见的是,可以在没有这些具体细节的情况下或者这些具体细节有变化的情况下实施本公开实施例。因此,这些描述应被认为是说明性的而不是限制性的。

尽管已经结合了本公开的具体实施例对本公开进行了描述,但是根据前面的描述,这些实施例的很多替换、修改和变型对本领域普通技术人员来说将是显而易见的。例如,其它存储器架构(例如,动态RAM(DRAM))可以使用所讨论的实施例。

本公开实施例旨在涵盖落入所附权利要求的宽泛范围之内的所有这样的替换、修改和变型。因此,凡在本公开实施例的精神和原则之内,所做的任何省略、修改、等同替换、改进等,均应包含在本公开的保护范围之内。

- 一种电子设备的输入方法、输入装置及电子设备

- 汉字输入方法、存储设备及计算机设备

- 音频输入设备的调用检测方法、设备及计算机可读存储介质

- 电烹饪设备、电烹饪设备的输入装置和方法

- 可以作为多个目标/端点(设备)和的整合点的以人为中心的“设备的超UI”体系结构的方法和设备,以及面向“模块化”通用控制器平台以及输入设备虚拟化的具有动态上下文意识的手势输入的相关方法/系统

- 输入纠错方法及相关装置、输入设备和存储介质