一种基于事件相机的水下蛙人目标检测方法

文献发布时间:2024-01-17 01:27:33

技术领域

本发明属于水下机器视觉目标检测技术领域,具体涉及水下蛙人目标检测领域。

背景技术

近年来,安全防御浅海水域的问题受到越来越多的关注。作为水下的生力军,水下蛙人与搭载动力系统的水下无人航行器、水下潜艇等传统军事设备相比,具有更强的机动性和隐蔽性。特别是经过专业训练且携带先进军事装备的战斗蛙人,其水下破坏力更强,能够给舰船、潜艇和军事港口带来严重威胁。因此,能够对水下蛙人实现精准检测在保卫浅海水域安全上起着至关重要的作用。

目前,针对水下蛙人的目标检测技术正在不断发展和完善,尤其是随着人工智能技术的快速发展,目标检测算法也变得越来越高效和精确。基于深度学习的目标检测算法已经开始应用于水下环境中,取得了一些非常不错的成果。但目前基于深度学习的水下蛙人目标检测仍存在以下缺点:

目标模糊:由于蛙人在水下移动速度过快,传统相机容易拍摄到模糊的蛙人图像,这减少了图片的有效特征信息,不利于水下蛙人目标的检测。

环境阴暗:由于水下环境的极端性,传统相机拍摄的水下图像存在噪声和失真等问题,不利于检测器对目标进行精准检测。

检测性能不稳定:由于水下环境的复杂性,目标检测器的性能在不同场景和条件下表现不稳定。例如,在不同的水质、光照和目标尺寸等情况下,检测器的准确率和召回率可能会有很大差异。

因此,如何在复杂的水下环境中提高水下蛙人目标检测的准确性、减小识别误差以及提升泛化能力是当前研究的热点和难点。

事件相机,也称为脉冲相机或异步相机,是一种新型的传感器技术,用于捕捉和处理场景中快速变化的运动和事件。事件相机通过高时间分辨率、低延迟、高动态范围和低功耗等特点,为目标检测提供了优异的能力。它能够捕捉到快速变化的目标动作并提供准确的特征信息,具有在高速、高动态范围和实时性要求的场景中应用的潜力。然而,事件相机目前仍处于发展阶段,针对水下场景的视觉应用,事件相机的潜力还尚未完全挖掘,需要进一步研究以实现更广泛的应用。

发明内容

本发明为了解决以往的水下蛙人目标检测缺乏鲁棒性强的特征信息的问题,利用事件相机获取水下蛙人事件序列和RGB图像,将水下蛙人事件序列和RGB图像信息进行细粒度特征融合,为水下蛙人目标检测提供高效鲁棒性强的特征信息。

所述检测方法包括如下步骤:

S1、利用事件相机采集水下蛙人事件序列和水下蛙人RGB图像;

S2、对步骤S1采集的水下蛙人事件序列采用固定时间间隔法转化为水下蛙人事件图像,使用水下蛙人事件图像与水下蛙人RGB图像构建数据集,按照7:3的比例划分训练集与验证集,用于对模型进行训练;

S3、设计RGB残差学习模块,用于提取水下蛙人RGB图像特征;

S4、设计事件图像残差学习模块,用于提取水下蛙人事件图像特征;

S5、设计水下蛙人RGB图像与事件图像特征融合网络,将RGB残差学习模块与事件图像残差学习模块嵌入到网络中,实现对RGB图像特征与事件图像特征的提取与融合,获得融合RGB与事件图像的融合特征图;

S6、将水下蛙人RGB图像与事件图像特征融合网络嵌入到目标检测模型中;

S7、使用步骤S2构建的数据集训练步骤S6获得的目标检测模型,使用验证集验证网络训练效果,保存最优目标检测模型;

S8、使用步骤S7保存的最优目标检测模型对水下蛙人进行目标检测。

进一步,所述步骤S1中事件相机的主动像素传感器采集水下蛙人RGB图像,事件相机的动态视觉传感器采集水下蛙人事件序列。

进一步,所述步骤S2中,采用固定时间间隔法将水下蛙人事件序列转化为水下蛙人事件图像,具体为:将帧重建设置为10ms的固定帧长,使检测频率达到每秒100帧,在每个时间间隔内,根据水下蛙人事件序列中事件生成的像素位置,在有极性生成的对应像素点上,极性增加的事件被绘制成白色像素,极性减少的事件被绘制成黑色像素,图像的背景颜色为灰色,最后生成与水下蛙人RGB图像相同大小的水下蛙人事件图像。

进一步,所述步骤S3中,所述RGB残差学习模块包括三个分支,第一个分支由两个DBS模块以及一个全局平均池化串联而成;第二个分支由一个坐标注意力机制构成;第三个分支作为残差分支;最后三个分支的输出特征图通过逐元素相加得到对应每一级尺度下完整细粒度的融合特征图。

进一步,所述步骤S4中,所述事件图像残差学习模块包括三个分支,第一个分支由两个DBS模块以及一个全局最大池化串联而成;第二个分支由一个DBS模块组成;第三个分支作为残差分支;最后三个分支的输出特征图通过逐元素相加得到对应每一级尺度下完整细粒度的融合特征图。

进一步,所述DBS模块包括卷积层、批量归一化层和激活层。

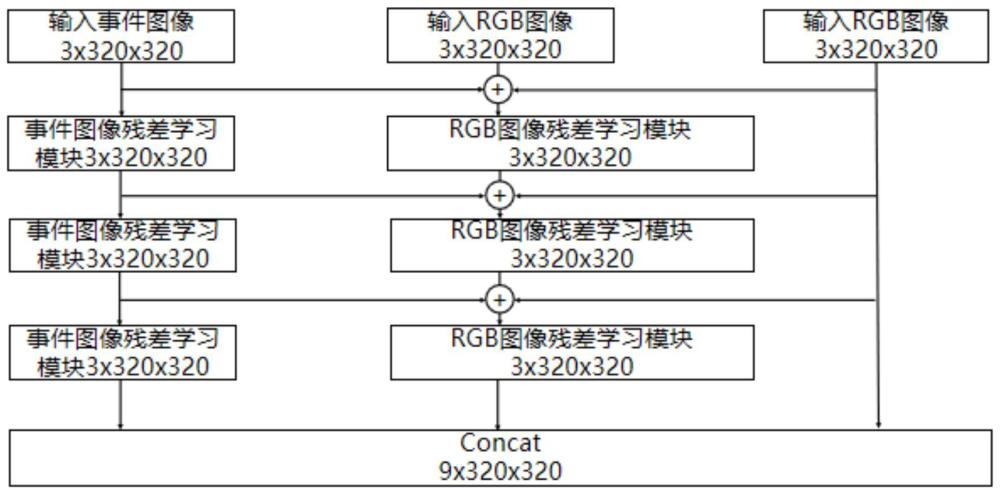

进一步,所述步骤S5中,所述水下蛙人RGB图像与事件图像特征融合网络由三个分支和一个总拼接层组成,第一个分支由三个事件图像残差学习模块串联构成,第二个分支由三个RGB残差学习模块串联构成,第三个分支为残差,三种分支每层输出的特征图进行逐元素相加融合,然后送入下一层RGB残差学习模块中,最后将三个分支输出的特征图在总拼接层进行按维度拼接。

进一步,步骤S6中,水下蛙人RGB图像与事件图像特征融合网络嵌入到目标检测模型的特征提取网络之前。

本发明所述方法的有益效果为:

利用事件相机获取水下蛙人事件序列和RGB图像,设计RGB残差学习模块,用于充分提取水下蛙人RGB图像空间特征信息,设计事件残差学习模块,用于充分提取水下蛙人事件图像纹理特征信息,设计特征融合网络,使水下蛙人RGB图像特征信息与水下蛙人事件图像特征信息进行细粒度特征融合。解决了因水下光照不均匀、水质模糊等一系列极端环境因素导致的目标特征信息不足等问题,为水下蛙人目标检测提供高效鲁棒性强的特征信息。能够对水下复杂环境条件下的蛙人目标进行准确高效的端到端的检测。

本发明所述方法可以应用在水下目标检测技术领域、水下航行安全检测领域以及水下目标识别设备制造领域。

附图说明

图1为本发明实施例中水下蛙人目标检测方法流程图;

图2为本发明实施例中RGB残差学习模块结构图;

图3为本发明实施例中事件图像残差学习模块结构图;

图4为本发明实施例中水下蛙人RGB图像与事件图像特征融合网络结构图。

具体实施方式

下面将结合附图对本发明的技术方案进行清楚、完整地描述,显然,所描述的实施例是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明的保护范围。

实施例1、

如图1所示,本实施例提供一种基于事件相机的水下蛙人目标检测方法,所述检测方法包括如下步骤:

S1、利用事件相机采集水下蛙人事件序列和水下蛙人RGB图像;

S2、对步骤S1采集的水下蛙人事件序列采用固定时间间隔法转化为水下蛙人事件图像,使用水下蛙人事件图像与水下蛙人RGB图像构建数据集,按照7:3的比例划分训练集与验证集,用于对模型进行训练;

S3、设计RGB残差学习模块,用于提取水下蛙人RGB图像特征;

S4、设计事件图像残差学习模块,用于提取水下蛙人事件图像特征;

S5、设计水下蛙人RGB图像与事件图像特征融合网络,将RGB残差学习模块与事件图像残差学习模块嵌入到网络中,实现对RGB图像特征与事件图像特征的提取与融合,获得融合RGB与事件图像的融合特征图;

S6、将水下蛙人RGB图像与事件图像特征融合网络嵌入到目标检测模型中;

S7、使用步骤S2构建的数据集训练步骤S6获得的目标检测模型,使用验证集验证网络训练效果,保存最优目标检测模型;

S8、使用步骤S7保存的最优目标检测模型对水下蛙人进行目标检测。

实施例2、

本实施例是对实施例1的进一步限定,所述步骤S1中,利用事件相机通过主动像素传感器(APS)和动态视觉传感器(DVS)分别输出3000张水下蛙人RGB图像和水下蛙人事件序列。 APS具有更高的速度和更低的噪声水平,同时也能够实现单独控制每个像素的曝光时间和增益等参数,提高了水下蛙人图片质量。DVS能够在高速移动和变化的环境下实时获取场景信息,并且具有低延迟、低功耗、易于集成等特点。

实施例3、

本实施例是对实施例1的进一步限定,步骤S2通过以下方式实现:将帧重建设置为10ms的固定帧长,使检测频率达到每秒100帧,在每个时间间隔内,根据水下蛙人事件序列中事件生成的像素位置,在有极性生成的对应像素点上,极性增加的事件被绘制成白色像素,极性减少的事件被绘制成黑色像素,图像的背景颜色为灰色,最后生成与水下蛙人RGB图像相同大小的水下蛙人事件图像,使用3000张水下蛙人事件图像与RGB图像构建数据集,按照7:3的比例划分训练集与验证集,用于对模型进行训练。

实施例4、

本实施例是对实施例1的进一步限定,步骤S3通过以下方式实现:

设计RGB残差学习模块,用于充分提取水下蛙人RGB图像特征。设计DBS模块,它由可形变卷积层、批量归一化层和SiLU激活函数层构成,其中“D”表示Deformable Conv,即为可变卷积层,“B”表示 Batch Normalization,即为批量归一化层,“S”表示Sigmoid LinearUnit,为一种激活函数,可以简写为SiLU;输入DBS模块的图像依次经过可形变卷积层、批量归一化层和SiLU激活函数层,最后输出,DBS模块用于适应水下蛙人目标物体的形变和旋转,提高检测精度,防止梯度消失和爆炸等问题,抑制模型过拟合。如图2所示,RGB残差学习模块共有三个分支组成,其中:第一个分支由两个DBS模块以及一个全局平均池化串联而成;第二个分支由一个坐标注意力机制构成;第三个分支作为残差分支,最后三个分支的输出特征图通过逐元素相加得到对应每一级尺度下完整细粒度的融合特征图。

实施例5、

本实施例是对实施例1的进一步限定,步骤S4通过以下方式实现:

设计事件图像残差学习模块,用于充分提取水下蛙人事件图像特征。如图3所示,它由三个分支组成,其中:第一个分支由两个DBS模块以及一个全局最大池化串联而成;第二个分支由一个DBS模块组成;第三个分支作为残差分支,最后三个分支的输出特征图通过逐元素相加得到对应每一级尺度下完整细粒度的融合特征图。

实施例6、

本实施例是对实施例1的进一步限定,步骤S5通过以下方式实现:

设计水下蛙人RGB图像与事件图像特征融合网络,将事件图像与RGB图像同时输入到网络中,如图4所示,所述水下蛙人RGB图像与事件图像特征融合网络由三个分支和一个总拼接层组成,其中:事件图像网络分支由三个事件图像残差学习模块串联构成,RGB图像网络分支由三个RGB残差学习模块串联构成,残差分支对于原始RGB图像不做任何处理。三种分支每层输出的特征图进行逐元素相加融合,然后送入下一层RGB残差学习模块中,实现事件图像与RGB图像的特征充分融合,同时残差分支的特征图保留了RGB图像的原始信息,最后将三个网络分支输出的3x320x320的特征图进行按维度拼接,获得9x320x320大小的特征图。

对于第1层特征融合操作,其计算公式为:

对于第k层特征融合操作(k>1),其计算公式为:

其中,当

其中,

实施例7、

本实施例是对实施例1的进一步限定,步骤S6通过以下方式实现:

将水下蛙人RGB图像与事件图像特征融合网络嵌入到目标检测模型中,目标检测模型可以选用任意一阶段目标检测模型,如Yolov5、YoloX、Yolov6、Yolov7等,将水下蛙人RGB图像与事件图像特征融合网络加在目标检测模型的特征提取网络之前,特征融合网络的嵌入使得目标检测模型可以获得信息更丰富的特征图,从而加强了模型的目标检测效果。

其中,Yolov5、YoloX、Yolov6、Yolov7都是已有的目标检测的算法模型,它们属于YoLo(You Only Look Once)系列,不同的尾字母代表不同的YoLo(You Only Look Once)系列,都是已知模型。

此处的目标监测模型就是任何设计好的水下蛙人目标检测模型,本发明所述方法就是设计所述特征融合网络,提高模型的检测能力。

实施例8、

本实施例是对实施例1的进一步限定,步骤S7通过以下方式实现:

使用步骤1构建的数据集训练所述目标检测模型,使用验证集验证网络训练效果,保存最优模型,使模型能够充分的提取水下蛙人特征,从而准确的对水下蛙人进行目标检测。

具体的,将划分好的图像数据集进行预处理,包括图像的缩放、旋转、归一化、通道顺序的变换等操作。使用训练集对目标检测模型进行训练,使用验证集验证模型的训练效果,同时保存训练中的最优模型。

实施例9、

本实施例是对实施例1的进一步限定,步骤S8通过以下方式实现:

使用事件相机获得水下蛙人RGB图像与水下蛙人事件序列,使用固定时间间隔法将水下蛙人事件序列转换成水下蛙人事件图像,使用步骤S7保存的最优模型对水下蛙人进行特征提取与目标检测,得到目标的位置和类别信息,对预测的结果进行后处理,包括去重、筛选、非极大值抑制等操作,最终得到水下蛙人目标检测结果。

- 一种基于Faster-RCNN的强负样本水下目标检测方法

- 一种基于事件相机的静态和动态目标检测方法及设备

- 一种基于事件相机的注意力机制目标检测的方法