自适应的人机语音对话装置和设备、交互系统和车辆

文献发布时间:2023-06-19 09:26:02

技术领域

本发明涉及一种自适应的人机语音对话装置、一种人机语音交互系统、一种自适应的人机语音对话设备和一种车辆。本发明的实施例涉及对话式交互技术,更具体而言,涉及用通过TTS技术将文本转换自适应地转换成流畅的语音的装置、系统和设备。

背景技术

当前语音交互的产品,我们称之为ChatBot(聊天机器人),基本分为两种,一种是开放域(Open Domain)聊天产品;另一种是任务导向(Task Oriented)聊天。以类似“订机票”,“询问天气”这样单一任务为导向的语音聊天互动已经相对比较成熟,并且使用也越来越广泛。

但是,现有技术中录制的真人声音模板较为有限,用户无法自行设置音色,更无法获得客制化声音的语音互动服务。

因此,如何利用现有语音聊天系统以及配套硬件设备按照用户意图来实现音色等调节功能,以提供更好的用户体验成为一个亟待解决的问题。

发明内容

为了解决现有技术的问题,本发明实施例提供了一种自适应的人机语音对话装置、一种人机语音交互系统、一种自适应的人机语音对话设备和一种车辆。所述技术方案如下:

按照第一方面,本发明涉及一种自适应的人机语音对话装置,包括:

-语音获取模块,用于获取语音信息;

-语音识别模块,用于生成语音信息对应的文本信息;

-语义理解模块,用于分析语音信息对应的语义信息;

-对话管理模块;用于根据语义信息决定对话过程;

-对话生成模块,用于基于对话过程生成对话文本;

其特征在于,所述人机语音对话装置进一步包括:

-语音片段形成模块,用于从由语音获取模块所获取的语音信息和由语音识别模块所生成的文本信息形成语音片段组;

-语音合成模块,用于基于所形成的语音片段组和所生成的对话文本合成语音对话。

本发明的人机语音对话装置包括一个语音片段形成模块和一个语音合成模块。语音片段形成模块可以从语音获取模块所获取的语音信息和由语音识别模块所生成的文本信息形成个性化的语音片段组。然后,语音合成模块用于基于所形成的语音片段组和所生成的对话文本合成语音对话。因此本发明可以提供定制的语音音色作为语音对话或者说播报语音,从而用户可以享用客制化的声音效果,丰富收听体验。

优选地,所述语音合成模块包括音色调整模块,所述音色调整模块在生成语音对话时控制语速、音调、音量和音频码率中至少一项。由此,进一步地精细化调整语音对话的效果。

优选地,所述语音片段形成模块通过如下方式形成语音片段组:

-在由语音识别模块所生成的文本信息中搜索与预设的模板中相同的信息片段;

-从由语音获取模块所获取的语音信息截取与所述信息片段对应的语音信息;

-将所截取的语音信息与信息片段对应地存储为语音片段组。

优选地,所获取的语音信息包括所述用户或他人的语音录音和/或现场谈话,并且特定于个人地形成语音片段组。由此,能够通过简单的方式为用户自身或者他人形成语音片段组,使得能够以用户自身或者他人的声音进行语音对话或语音播报。

优选地,语音识别模块用于:通过声学模型和语言模型,利用自动语音识别技术(ASR),将用户的语音识别为文本。

优选地,语义理解模块用于:

-确定对话中的领域;

-分析用户的意图;和

-获得对话中的语义信息。

优选地,对话管理模块用于:

-确定对话上下文;

-跟踪对话状态;和

-确定对话策略。

优选地,所述预设的模板包括语句、短语、单词、字和音素中的至少一项。由此,能够更为贴近于自然语音地形成语音片段组。

本发明的第二方面提供了一种人机语音交互系统,其特征在于,包括:

-一个如前所述的自适应的人机语音对话装置;

-至少一个麦克风,用于采集语音信息;和

-至少一个扬声器,用于播放语音对话。

本发明的第三方面提供了一种车辆,其特征在于,所述车辆包括前面所述的人机语音交互系统。

按照本发明的第四方面提供了一种自适应的人机语音对话设备,所述设备包括:

-存储器,存储有计算机可执行指令;以及

-处理器,被配置为执行计算机可执行指令,其中,所述计算机可执行指令被所述处理器执行时,使所述自适应的人机语音对话设备执行如下步骤:

-获取语音信息;

-生成语音信息对应的文本信息;

-分析语音信息对应的语义信息;

-根据语义信息决定对话过程;

-基于对话过程生成对话文本;

-从所获取的语音信息和所生成的文本信息形成语音片段组;并且

-基于所形成的第二语音片段组和所生成的对话文本合成语音对话。

如上所述,根据本发明的各个方面,所合成的语音对话可包含用户自己或他人的语音片段。因此通过本发明可以提供非预存储的语音音色作为播报语音,从而用户可以享用客制化的声音效果,丰富收听体验。

附图说明

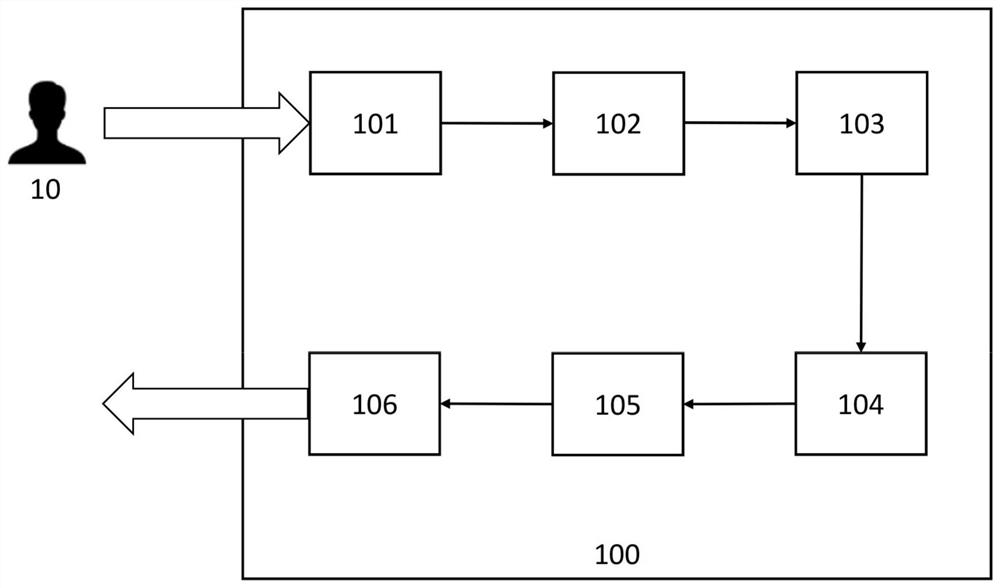

图1是现有技术中的人机语音对话装置的结构框图;

图2是本发明的一个实施例的自适应的人机语音对话装置的结构框图;

图3是本发明的一个实施例的自适应的人机语音对话装置的结构框图;和

图4是按照本发明的人机对话设备的结构框图。

具体实施方式

为使本发明的上述目的、特征和优点能够更为明显易懂,下面结合附图对本发明的具体实施方式做详细的说明。

在以下描述中阐述了具体细节以便于充分理解本发明。但是本发明能够以多种不同于在此描述的其它方式来实施,本领域技术人员可以在不违背本发明内涵的情况下做类似推广。因此本发明不受下面公开的具体实施方式的限制。

表述“和/或”在本文中使用的含义为,包括该表述之前和之后列出的组件中的至少一个。而且,表述“连接/联接”使用的含义为,包括与另一个组件的直接连接,或通过另一个组件而间接连接。本文中的单数形式也包括复数形式,除非在措辞中特别提及。而且,本文中使用的涉及“包括”或“包含”的组件、步骤、操作和元件的含义为,存在或添加至少一个其他的组件、步骤、操作和元件。

应理解的是,本文中所用的术语“车辆”或“车辆的”或其他类似术语通常包括机动车辆,如包括运动型多用途车辆(SUV)、大客车、大货车、各种商用车辆的乘用车辆,包括各种舟艇、船舶的船只,航空器等,并包括混合动力车辆、电动车辆、插电式混合动力电动车辆、氢动力车辆和其他替代性的燃料车辆(例如,源于除了石油之外的来源的燃料)。正如本文所提到的,混合动力车辆为具有两种或更多种动力源的车辆,例如汽油动力和电力动力两者的车辆。

如本文中所用的,短语“车辆(车载)系统”的含义为,具有无线通信能力的集成信息系统。这些系统有时称为车内信息系统,并且通常与远程信息通信服务、娱乐系统和/或导航系统整合为一体。此外,应当理解的是,术语“控制器”是指包括存储器和处理器的硬件设备。存储器配置为存储程序指令,而处理器配置为执行所述程序指令以执行下面进一步描述的一个或多个过程。

图1为现有技术的语音交互装置框图。模块101为语音信息获取功能模块。

模块102为语音识别模块。ASR(Automatic Speech Recognition)直译为自动语音识别,是一种通过声学模型和语言模型,将人的语音识别为文本的技术。近年来,随着深度学习在语音识别中的广泛使用,识别的准确率大大提高,让这项技术能被广泛地应用于语音输入、语音搜索、实时翻译、智能家居等领域,让人与机器的语音交互变为可能。

模块103为语义理解模块。语音识别只是知道说了什么,但真正要理解我们说的是什么,就需要依靠NLU这项技术。NLU(Natural Language Understand)直译为自然语言理解,是NLP(Natural Language Processing,自然语言处理)的一个子集,专注于“口语表达和对话”方向的自然语言处理。自然语言理解通过完成指代消解、否定判断、语句泛化、口语归一化、ASR纠错等工作,识别人机对话中的领域和意图,获得对话任务的语义信息。

模块104为对话管理模块(Dialog Management),是对话式交互系统的核心,负责控制整个对话过程。主要包括对话上下文(Dialog Context)、对话状态跟踪(Dialog StateTracking)和对话策略(Dialog Policy)几部分。

模块105为对话生成模块。NLG(Natural Language Generation)直译为自然语言生成,即对话生成的技术。对于任务导向的对话来说,NLG基本以回复模板或者说范例形式来实现。回复模板或者说范例中的回复信息可由词槽或通过内容服务得到的数据来替换。对话生成的原则是符合自然语言交互的习惯,易于用户理解,最快完成对话。此外,NLG还可以用于引导用户的交流习惯,比如NLG的内容为"已经为你开启导航",可以引导用户在希望导航时,说"开启导航"。

模块106为语音合成模块。TTS(Text To Speech)是语音合成播报技术,主要目标是处理好播报的“音韵”问题,这需要对符号、多音字,句型等等信息做判断,统一考虑,处理播报中的字音读法。另一方面,为适应不同人群喜好,也要关注“音色”。总的来说就是处理好“音韵”和“音色”。对于大多数任务导向型的语音交互系统,在NLG过程中使用了大量的模板,为提升TTS播报质量,会邀请真人录制标准的模板,然后在播报语音时使用模板中录制的真人声音。

该流程图常见信息流动方式为:首先是语音识别,产生语音识别结果也就是用户话语;语义模块NLU将用户话语映射成用户对话行为;对话管理模块选择需要执行的系统行为;如果这个系统行为需要和用户交互,那么语言生成模块NLG会被触发,生成自然语言或者说是系统话语,也就是说根据语义信息决定对话过程。最后,生成的语言由语音合成模块借助于预存储的语音片段朗读给用户听。

图2是本发明实施例的自适应的人机语音对话装置的结构框图,其中,模块201至205分别可以参照图1中对于模块101至105的描述。

语音获取模块201用于获取语音信息11。

语音识别模块202用于生成语音信息对应的文本信息12。ASR(Automatic SpeechRecognition)直译为自动语音识别,是一种通过声学模型和语言模型,将人的语音识别为文本的技术。近年来,随着深度学习在语音识别中的广泛使用,识别的准确率大大提高,让这项技术能被广泛地应用于语音输入、语音搜索、实时翻译、智能家居等领域,让人与机器的语音交互变为可能。

语义理解模块203用于分析语音信息对应的语义信息13。语音识别只是知道说了什么,但真正要理解我们说的是什么,就需要依靠NLU这项技术。NLU(Natural LanguageUnderstand)直译为自然语言理解,是NLP(Natural Language Processing,自然语言处理)的一个子集,专注于“口语表达和对话”方向的自然语言处理。自然语言理解通过完成指代消解、否定判断、语句泛化、口语归一化、ASR纠错等工作,识别人机对话中的领域和意图,获得对话任务的语义信息。

在整个语音交互流程中,对用户语义的理解(NLU)主要致力于解决以下几个问题:1意图识别:理解用户表达的意图,确定需求类型;2槽位解析:理解用户表达中关键信息,确定需求细节;3实现对话:设计对话逻辑,满足用户所需,让人机交互简单顺畅。

NLU模块主要做两件事,那就是对用户意图的理解,和对用户表达的语句中核心槽位(Slot)的解析。举例来说,用户表达:“帮我订一张明天上午10点从北京到上海的机票”。从这句话中,我们通过NLU模块解析出如下内容:

意图:

用户意图=“订机票”

槽位(Slot):

起飞时间=“明天早上10点”

起始地=“北京”

目的地=“上海”

上面的例子中提到了三个概念,分别是意图、槽位和槽位类型。

意图其实是一个分类器,确定用户表达的这句话是那个类型,进而由这个类型对应的程序做专门的解析。这里所说的“这个类型对应的程序”我们给他起了一个形象的名字,叫做Bot(机器人),比如用户说:“给我放一首快乐的歌吧”,这个时候我们判断用户的意图分类是音乐,因此召唤出音乐机器人(Bot)给用户推荐一首歌播放,用户听着觉得不对的时候,说:“换一首”,还是这个音乐机器人继续为用户服务,直到用户表达别的问题,意图已经不是音乐的时候,再切换成别的机器人为用户服务。

如果用户表达很模糊,可能判断出有多个意图,就需要有一个“中控”的模块做决策。

当用户意图被确定之后,就需要进一步理解对话中的内容,为简便起见,只选择最核心重要的部分进行理解,那些最重要的部分称之为槽位(Slot)。在“订机票”这个例子中,定义了三个核心槽位,分别是“起飞时间”,“起始地”,“目的地”,如果要全面考虑用户订机票需要输入的内容,我们肯定能想到更多,比如旅客人数、航空公司、起飞机场、降落机场等,对于语音交互的设计者来说,设计的起点就是定义槽位。

另一方面,系统需要依靠槽位类型(Slot-type)去理解这些槽位,例如针对时间(明天上午10点),系统是需要预先知道所有关于时间的表达方式,才能判断这句话里的是是指具体什么时间,这个预先知道关于所有时间的表达方式,可以称之为时间的槽位类型(Slot-type)。无论是目的地还是起始地,对应的槽位类型都是城市名称,那么就需要预先有一个关于所有城市名称的词表,这个词表可以称之为槽位类型(Slot-type)。槽位类型是可以预先定义好的。

对话管理模块204用于根据语义信息决定对话过程,其致力于对话管理(DialogManagement),是对话式交互系统的核心,负责控制整个对话过程。主要包括对话上下文(Dialog Context)、对话状态跟踪(Dialog State Tracking)和对话策略(Dialog Policy)几部分。

对话管理模块专门实施对话状态控制和管理。举例来说,如果用户表达了“订机票”的需求,但是什么信息都没说清楚,就需要对话系统询问用户必须获知的槽位信息,如下:

用户:我想订机票

BOT:请问目的地是哪里?

用户:上海

BOT:请问你想订什么时间起飞的航班?

对话管理模块204会发现这里关键槽位没有填补上,并选择预先定义好的设置询问。

对话生成模块205用于基于对话过程生成对话文本15。NLG(Natural LanguageGeneration)直译为自然语言生成,即对话生成的技术。对于任务导向的对话来说,NLG基本以模板形式来实现。模板中的回复信息可由词槽或通过内容服务得到的数据来替换。对话生成的原则是符合自然语言交互的习惯,易于用户理解,最快完成对话。此外,NLG还可以用于引导用户的交流习惯,比如NLG的内容为"已经为你开启导航",可以引导用户在希望导航时,说"开启导航"。

对话生成模块205实现自然语言生成。比如用户说:“我想订个明天傍晚差一刻10点的飞机”,聊天交互系统回复说:“明天傍晚差一刻10点从北京飞往上海的飞机已经订好了。”这个句子就可以由13个词语模板组成:1.(明天),2.(傍晚),3.(差一刻),4.(10点),5.(从),6.(北京),7.(飞往),8.(上海),9.(的),10(飞机),11.(已经),12.(订好),13(了)。其中关键回复信息可以由用户表达来替换,例如上述例子中的“差一刻10点”。

在TTS(Text To Speech)语音合成播报技术中,主要目标是处理好播报的“音韵”问题,这需要对符号、多音字,句型等等信息做判断,统一考虑,处理播报中的字音读法。另一方面,为适应不同人群喜好,也要关注“音色”。总的来说就是处理好“音韵”和“音色”。对于大多数任务导向型的语音交互系统,在NLG过程中使用了大量的模板,为提升TTS播报质量,有时会邀请真人按照标准的模板录制语音片段,然后在播报语音时使用模板中录制的真人声音。

人机语音对话装置200还包括一个语音片段形成模块207。该模块用于从由语音获取模块201所获取的语音信息和由语音识别模块202所生成的文本信息形成语音片段组。

所述语音片段形成模块207示例性地可以首先获取由语音获取模块201所获取的语音信息和由语音识别模块202所生成的文本信息;再在由语音识别模块202所生成的文本信息12中搜索与预设的模板中相同的信息片段;接着从由语音获取模块201所获取的语音信息截取与所述信息片段对应的语音信息;再将所截取的语音信息与信息片段对应地存储为语音片段组。

人机语音对话装置200还包括语音合成模块209,所述语音合成模块用于基于所形成的语音片段组和所生成的对话文本15合成语音对话。

所述语音合成模块209可以包括一个音色调整模块208。该音色调整模块用于在生成语音对话时控制语速、音调、音量和音频码率中至少一项。

特别是,所述语音片段形成模块207通过如下方式形成语音片段组:

-在由语音识别模块202所生成的文本信息12中搜索与预设的模板中相同的信息片段;

-从由语音获取模块201所获取的语音信息截取与所述信息片段对应的语音信息;

将所截取的语音信息与信息片段对应地存储为语音片段组。

由于在选择语音片段时,参考了预设的模板,因此带有个性化的语音音色特征的语音片段可以被截取并且一一对应于预设的模板中的各个信息片段地存储。从而能够生成个性化的语音音色特征语音。所述预设的模板包括语句、短语、单词、字和音素中的至少一项。在此,预设的模块可部分地相当于TTS技术中常用的码本。但这里所说的模板更广泛地包括语句、短语、单词、字和/或音素。示例性地,模板可以包括:常用语句、如“请问要去哪里?”;常用短语、如“已完成设定”;单词,如“好的”、“不是”;字、如“我”、“你”、“是”;和/或音素如“a”、“b”、“ch”。这样,可以依照所述模板从获取的语音信息中提取将要在语音片段组中形成的各个语音信息。

优选地所获取的语音信息11可以包括所述用户或他人的语音录音和/或现场谈话,并且特定于个人地形成语音片段组。这里,可以使用名人在电视、广播或网络中的音频录音,可以使用他人的现场谈话,例如特别是他人直接所说的话或甚至电话中的对话。这样可以方便地则对用户自己或他人形成独特的语音片段组,使得人机语音对话装置能够播放个性化的声音。例如,可以形成孩子母亲的语音片段组,使得可以在母亲不在时以母亲的声音来哄孩子。例如可以以发出文本信息的对象的声音来朗读其所发送的文本信息。还可能的是,为用户以其喜爱的主持人的声音来播报文字新闻。可以想到的是,用户还可以以自己声音来播报语音、朗读文章等,例如以便于用户准备讲演。

本发明提供的人机语音交互系统包括一个所述的自适应的人机语音对话装置200、至少一个用于采集语音信息的麦克风和至少一个用于播放语音对话的扬声器。

综上所述,当人机语音聊天互动开始时,本发明的自适应的人机语音对话装置200可以利用语音获取模块201、语音识别模块202、语义理解模块203、对话管理模块204、对话生成模块205、语音片段形成模块207和语音合成模块209这七个模块进行个性化的对话式交互。同时,人机语音对话装置200可以仅基于语音获取模块201输入的语音和语音识别模块202分析得到的文本信息将人机对话装置200的用户10或他人的语音特征(特别是音色特征、语速、音调、音量等)特种录制成一个客制化的语音片段组。并且该语音片段组可依照预设的模板来截取和存储的,因此可供人机语音对话装置200作为新的TTS语音合成播报使用。

用户10在刚开始使用本发明的自适应的人机语音交互系统时,语音交互系统可以按照现有技术的人机语音对话装置来使用预存储声音TTS语音合成声音。而在使用过程中,本发明的语音对话装置例如可以利用用户10输入的自己的语音信息建立一个针对用户10的客制化的新语音特征数据库、即形成的语音片段组,其中包含所录制的用户10的语音片段。该数据库被设置在语音片段形成模块207中。同样,还可以针对他人形成语音片段组,从而能够输出特别的互动语音30。语音片段形成模块207可以在运行中不断积累样本、即获取大量语音信息,从而形成的语音片段组能够不断优化地得到训练。

当语音合成模块209被系统启用时,对话生成模块205生成的对话文本15直接输入到语音合成模块209,语音合成模块209输出个性化的互动语音30。互动语音30可以模拟用户10本身和/或他人的声音音色特征。

图3同样示出本发明的一个实施例的自适应的人机语音对话装置的结构框图。在此,标记有相同附图标记的模块可以直接参照对图2的说明。

与图2不同地,所述语音合成模块209可以包括音色调整模块208,所述音色调整模块在生成语音对话时控制语速、音调、音量和音频码率中至少一项。由此,用户可以个性化地细微地调节人机对话装置的效果,使得满足其特别的需要。例如,可以提高播报新闻的语速、缓和朗读故事的声调、提高询问的音量等。

图4是按照本发明的人机对话设备1000的结构框图。所述人机对话设备1000包括存储器1001,存储有计算机可执行指令;以及处理器1002,被配置为执行计算机可执行指令,其中,所述计算机可执行指令被所述处理器执行时,使所述自适应的人机语音对话设备执行如下步骤:

-获取语音信息11;

-生成语音信息对应的文本信息12;

-分析语音信息对应的语义信息3;

-根据语义信息决定对话过程;

-基于对话过程生成对话文本15;

-从所获取的语音信息和所生成的文本信息形成语音片段组;并且

-基于所形成的第二语音片段组和所生成的对话文本15合成语音对话。

需要说明的是,上述计算机可执行指令可以作为计算机程序产品来存储、特别是存储在计算机可读存储介质中。