使用深度Q网络促进资源配对的方法和装置

文献发布时间:2023-06-19 09:29:07

技术领域

示例实施例总体上涉及用于确定动作序列的方法和装置,并且具体地涉及在通信网络资源分配中使用深度Q网络技术来促进资源指配。

背景技术

在5G多用户MIMO(MU-MIMO)中,每个小区具有多个子小区,每个子小区具有自己的天线阵列。小区中的调度器需要以每传输时间间隔(TTI)为单位将波束分配给活动UE。调度器的一个目的是以实现期望的或备选地最大总系统吞吐量的方式将UE分配给波束。

发明内容

根据至少一些示例实施例,一种确定动作序列的方法包括:训练第一深度Q网络(DQN);提供第一多维矩阵的多个条目作为对DQN的输入,第一矩阵表示第一状态,第一矩阵的每个条目表示在第一状态中能够被采取的动作;使用第一DQN,分别针对第一矩阵的多个条目确定多个Q值;执行第一动作,第一动作是由来自多个条目中的如下表示的动作,针对该条目第一DQN确定了所确定的多个Q值中的最高Q值;基于执行第一动作来累积奖励;以及根据第一组规则和所执行的第一动作来从第一状态转变到下一状态。

第一DQN的训练可以包括:初始化第一权重;从多个存储状态中随机地选择小批量的样本状态,每个存储状态包括与多个动作相对应的多个条目;以及针对随机地选择的小批量的样本状态中的每个样本状态S

样本状态S

初始化第一权重可以包括随机地选择第一权重。

确定动作序列的方法还可以包括:通过将第二权重设置为等于第一权重来初始化第二权重。

生成一个或多个目标值可以包括:针对A中的每个有效动作a,确定y

确定动作序列的方法还可以包括:针对每个连续状态迭代地执行提供、确定、执行、累积和转变步骤中的每项,直到达到最终状态为止,最终状态是如下状态:针对该状态不存在有效动作。

当前状态的有效动作可以是如下动作:该动作根据第一组规则被允许在当前状态中被执行。

执行第一动作可以包括在无线通信网络中分配资源。

针对第一矩阵的多个条目中的每个条目,条目的数值可以对应于与执行由条目表示的动作相关联的奖励。

根据至少一些示例实施例,一种在无线通信网络中操作调度器的方法包括:在调度器处获得多个度量值,每个度量值对应于来自多个UE波束对中的UE波束对,每个UE波束对包括来自多个UE中的UE和多个波束中的波束;执行UE波束对选择操作包括:由调度器的深度Q网络(DQN)基于多个度量值确定多个Q值,多个Q值分别对应于多个UE波束对,以及基于多个Q值从多个UE波束对中选择UE波束对;以及将所选择的UE波束对中包括的UE分配给所选择的UE波束对中包括的波束。

选择可以包括从多个Q值中选择最高Q值作为所选择的Q值。

多个度量值可以分别是多个比例公平(PF)度量值。

针对多个PF度量值中的每个PF度量值,PF度量值可以是第一UE相对于第一波束的瞬时频谱效率与第一UE的吞吐量的比率,第一UE是与PF度量值相对应的UE波束对中包括的UE,第一波束是与PR度量值相对应的UE波束对中包括的波束。

分配可以包括调度器针对当前传输时间间隔(TTI)将所选择的UE波束对中包括的UE分配给所选择的UE波束对中包括的波束。

所选择的UE波束对是多个所选择的UE波束对中的一个所选择的UE波束对。在无线通信网络中操作调度器的方法还可以包括:由调度器通过多次执行UE波束对选择操作来生成多个所选择的UE波束对。分配可以包括:针对当前TTI,分别将多个所选择的UE波束对中包括的UE分配给多个所选择的UE波束对中包括的波束。

根据至少一些示例实施例,一种训练调度器的方法,该调度器用以在无线通信网络中执行关于多个用户设备(UE)和多个波束的调度,该方法包括:从多个存储的UE波束状态中随机地选择小批量的样本UE波束状态,其中每个存储的UE波束状态包括多个UE波束对和分别与多个UE波束对相对应的多个度量值。根据至少一些示例实施例,每个UE波束对包括来自多个UE中的UE和来自多个波束中的波束。根据至少一些示例实施例,训练调度器以执行调度的方法还包括:针对随机地选择的小批量的样本UE波束状态中的每个样本UE波束状态S

训练调度器以执行调度的方法还可以包括:通过随机地选择第一权重来初始化第一权重;以及通过将第二权重设置为等于第一权重来初始化第二权重。

针对样本UE波束状态S

生成一个或多个目标值可以包括针对A中的每个有效动作a,确定y

根据至少一些示例实施例,一种调度器包括:存储器,该存储器存储计算机可执行指令;以及处理器,该处理器被配置为执行计算机可执行指令使得处理器被配置为获得多个度量值,每个度量值对应于来自多个UE波束对中的UE波束对,每个UE波束对包括来自多个UE中的UE和来自多个波束中的波束。根据至少一些示例实施例,处理器还被配置为执行计算机可执行指令使得处理器被配置为执行UE波束对选择操作,包括:使用深度Q网络(DQN)基于多个度量值确定多个Q值,以及基于多个Q值从多个UE波束对中选择UE波束对。根据至少一些示例实施例,多个Q值分别对应于多个UE波束对。根据至少一些示例实施例,处理器还被配置为执行计算机可执行指令,使得处理器被配置为将所选择的UE波束对中包括的UE分配给所选择的UE波束对中包括的波束。

处理器可以被配置为执行计算机可执行指令,使得选择包括从多个Q值中选择最高Q值作为所选择的Q值。

处理器可以被配置为执行计算机可执行指令,使得多个度量值分别是多个比例公平(PF)度量值。

处理器可以被配置为执行计算机可执行指令,使得针对多个PF度量值中的每个PF度量值,PF度量值是第一UE相对于第一波束的瞬时频谱效率与第一UE的吞吐量的比率,第一UE是与PF度量值相对应的UE波束对中包括的UE,第一波束是与PF度量值相对应的UE波束对中包括的波束。

处理器可以被配置为执行计算机可执行指令,使得分配包括针对当前传输时间间隔(TTI)将所选择的UE波束对中包括的UE分配给所选择的UE波束对中包括的波束。

处理器可以被配置为执行计算机可执行指令,使得所选择的UE波束对是多个所选择的UE波束对中的一个所选择的UE波束对。处理器可以被配置为执行计算机可执行指令使得处理器还被配置为由调度器通过多次执行UE波束对选择操作来生成多个所选择的UE波束对。另外,处理器可以被配置为执行计算机可执行指令,使得分配包括:针对当前TTI,分别将多个所选择的UE波束对中包括的UE分配给多个所选择的UE波束对中包括的波束。

根据至少一些示例实施例,一种调度器包括存储器,该存储器存储计算机可执行指令;以及处理器,该处理器被配置为执行计算机可执行指令,使得处理器被配置为从多个存储的UE波束状态中随机地选择小批量的样本UE波束状态。根据至少一些示例实施例,每个存储的UE波束状态包括多个UE波束对和分别与多个UE波束对相对应的多个度量值,并且每个UE波束对包括来自多个UE中的UE和来自多个波束中的波束。根据至少一些示例实施例,处理器还被配置为执行计算机可执行指令,使得处理器被配置为针对随机地选择的小批量的样本UE波束状态中的每个样本UE波束状态S

处理器可以被配置为执行计算机可执行指令,使得处理器还被配置为通过随机地选择第一权重来初始化第一权重;以及通过将第二权重设置为等于第一权重来初始化第二权重。

处理器被配置为执行计算机可执行指令,使得针对样本UE波束状态S

处理器可以被配置为执行计算机可执行指令,使得生成一个或多个目标值包括针对A中的每个有效动作a,确定y

附图说明

通过下面提供的详细描述和附图,至少一些示例实施例将变得更加充分地理解,其中相似的元素由相似的附图标记表示,附图标记仅以说明的方式给出,因此不限制示例实施例,并且在附图中:

图1A是用于说明确定将产生期望的或最大的累积奖励的动作序列的示例方法的图。

图1B是用于说明根据至少一些示例实施例的无线通信网络中的资源分配的示例的图。

图2是示出根据至少一些示例实施例的用于无线通信网络的调度器的示例结构的图。

图3和图4是用于说明根据至少一些示例实施例的强化学习的示例的图。

图5示出了根据至少一些示例实施例的调度器中包括的深度Q网络(DQN)的示例结构。

图6示出了根据至少一些示例实施例的在无线通信网络中操作调度器251以分配资源的示例方法。

具体实施方式

现在将参考在其中示出了一些示例实施例的附图来更全面地描述各种示例实施例。

本文中公开了详细的说明性实施例。然而,出于描述至少一些示例实施例的目的,本文中公开的特定结构和功能细节仅是代表性的。然而,示例实施例可以以很多替代形式来实施,而不应当被解释为仅限于本文中阐述的实施例。

因此,尽管示例实施例能够具有各种修改和备选形式,但是其实施例在附图中通过示例被示出并且将在本文中被详细描述。然而,应当理解,不旨在将示例实施例限制为所公开的特定形式,而是相反,示例实施例将涵盖落入示例实施例的范围内的所有修改、等同物和备选。在整个附图的描述中,相似的附图标记表示相似的元素。如本文中使用的,术语“和/或”包括一个或多个相关联的所列项的任何和所有组合。

将理解的是,当一个元件被称为“连接”或“耦合”到另一元件时,它可以直接连接或耦合到另一元件,或者可以存在中间元件。相反,当一个元件被称为“直接连接”或“直接耦合”到另一元件时,不存在中间元件。用于描述元件之间的关系的其他词语应当以类似的方式来解释(例如,“在……之间”与“直接在……之间”、“相邻”与“直接相邻”等)。

本文中使用的术语仅出于描述特定实施例的目的,而不旨在限制示例实施例。如本文中使用的,除非上下文另外明确指出,否则单数形式的“一”、“一个”和“该”也意图包括复数形式。还将理解,当在本文中使用时,术语“包括”、“包含”、“包括有”和/或“包含有)”指定所述特征、整数、步骤、操作、元素和/或组件的存在,但是不排除一个或多个其他特征、整数、步骤、操作、元素、组件和/或其组的存在或添加。

还应当注意,在一些备选实现中,所提到的功能/动作可以不按照图中提到的顺序发生。例如,取决于所涉及的功能性/动作,连续示出的两个图实际上可以基本上并发地执行,或者有时可以以相反的顺序执行。

如本文中使用的,术语“移动终端”可以被认为是与以下各项同义并且下文中可以偶尔称为以下各项:用户设备(UE)、终端、移动终端、移动单元、移动设备、移动台、移动用户、接入终端(AT)、订户、用户、远程站、接入终端、接收器等,并且可以描述无线通信网络中无线资源的远程用户。术语基站(BS)可以被视为与以下各项同义和/或称为以下各项:节点B、演进型节点B(eNB)、基站收发器(BTS)、归属eNB(HeNB)、接入点(AP)等,并且可以描述为网络与一个或多个用户之间的数据和/或语音连接性提供无线电基带功能的设备。

本文中将示例性实施例讨论为在合适的计算环境中实现。尽管不是必需的,但是将在由一个或多个计算机处理器或CPU执行的计算机可执行指令(诸如程序模块或功能过程)的一般上下文中描述示例性实施例。通常,程序模块或功能过程包括执行特定任务或实现特定抽象数据类型的例程、程序、对象、组件、数据结构等。

本文中讨论的程序模块和功能过程可以使用现有通信网络中的现有硬件来实现。例如,本文中讨论的程序模块和功能过程可以使用现有网络元件或控制节点(例如,e节点B(enB)或无线电网络控制器(RNC))处的现有硬件来实现。这样的现有硬件可以包括一个或多个数字信号处理器(DSP)、专用集成电路(ASIC)、现场可编程门阵列(FPGA)计算机等。

在以下描述中,除非另外指出,否则将参考由一个或多个处理器执行的操作的动作和符号表示(例如,以流程图的形式)来描述说明性实施例。这样,将理解的是,有时被称为计算机执行的这样的动作和操作包括处理器对以结构化形式来表示数据的电信号的操纵。该操纵变换数据或将其保存在计算机的存储器系统中的位置处,其以本领域技术人员熟知的方式重新配置或以其他方式改变计算机的操作。

一些真实世界任务可以用状态S和动作A表示,其中每个状态与一个或多个可用动作相关联,每个可用动作与以下各项相关联:(i)对应奖励值R,以及(ii)到下一状态的对应转变(例如,S

图1A示出了表示为矩阵105的示例状态S

算法1

O1:训练深度Q网络(DQN)(例如,通过执行算法2中概述的操作,以下将对其进行详细讨论)。

O2:将当前状态(例如,矩阵105表示的状态S

O3:从矩阵(例如,矩阵105)的N*M个条目中选择与动作A

O4:基于(S

O5:通过对于每个连续状态重复操作O2-O4直到到达最终状态S

下面参考图1B至图6和示例场景来更详细地解释算法1,在示例场景中,应用了算法1的任务是调度器将用户设备(UE)分配给5G无线通信网络中的波束的任务,并且每个状态S可以由矩阵表示,该矩阵的深度为1并且具有多个条目,每个条目对应于将由该条目的行标识的UE分配给由该条目的列标识的波束的动作。例如,将在下面更详细讨论的算法2表示算法1的步骤O1的示例实现;并且将在下面更详细讨论的图6的步骤S610、S615和S625分别表示算法1的步骤O2、O3和O4的示例实现。

然而,将UE分配给波束仅仅是由算法1表示的通用框架的一个示例应用,并且至少一些示例实施例不限于这一个示例。根据至少一些示例实施例,由算法1表示的通用框架可以被应用于任何资源分配任务或其他场景,其中该任务或场景可以被构架(frame)为遵循马尔可夫或半马尔可夫演进过程以顺序方式从多维矩阵(数值矩阵)中挑选条目之一,目的是增加或备选地最大化累积奖励。将矩阵单元视为图像像素的想法使得能够使用神经网络的强大的图像处理能力。现在将参考图1B和图2讨论无线通信网络中的资源分配的示例。

图1B是用于说明根据至少一些示例实施例的无线通信网络中的资源分配的示例的图。图2是示出根据至少一些示例实施例的调度器251的示例结构的图。例如,在实现5G多用户MIMO(MU-MIMO)的无线通信网络中,每个小区具有多个子小区,每个子小区具有自己的天线阵列。每个小区可以包括调度器。调度器251以每传输时间间隔(TTI)为单位波束分配给活动UE。根据至少一些示例实施例,每个TTI,调度器251创建矩阵D,矩阵D的第(i,j)项表示针对UE i在波束j上的比例公平(PF)度量。例如,图1B示出了矩阵D的第一、第二和第三状态110、120和130。调度器251的示例包括执行无线通信网络调度功能(例如,将UE分配给波束)的任何网络元件或设备。例如,调度器251可以由e节点B(eNB)或无线电网络控制器(RNC)来实施。在本公开中,术语PF度量有时也被称为“度量”、“度量值”和“PF度量值”中的任何一个。

例如,如图1B所示,调度器251可以生成矩阵D,使得第一状态110包括分别与多个UE波束对(UE 1,波束1)至(UE 6,波束4)相对应的多个条目(1,1)至(6,4)。如图1B所示,在第一状态110中的每个条目(i,j)包括对应UE波束对(UE i,波束j)的PF度量。例如,在第一状态110中的每个条目(i,j)包括与针对当前TTI被分配给波束j的UE i相对应的PF度量。

调度器可以根据已知方法确定矩阵D在第一状态110中的每个PF度量。例如,调度器251可以将针对第一状态110的每个条目(i,j)的PF度量确定为UE i针对波束j的瞬时频谱效率与由UE i实现的长期吞吐量的比率。调度器251使用所确定的PF度量来确定如下方式,UE(例如,UE 1-UE 6)以该方式针对当前TTI获取所分配的资源(例如,波束1-波束4)。例如,根据一个示例调度方案,调度器251尝试将资源给予具有最高PF度量的一组UE。

此外,当使用矩阵D分配资源时,调度器251可以遵循一组调度规则。在图1B所示的示例中,调度器251遵循第一调度规则和第二调度规则,第一调度规则要求任何两个调度波束被分离最小距离δ,第二调度规则要求可以被调度的UE的数目具有上限。

在图1B所示的示例中,由调度器251从第一状态110选择的用于在当前TTI中进行调度的第一UE波束对是(UE 3,波束3)。在第一状态110中与UE波束对(UE 3,波束3)相对应的条目是条目(3,3)。如图3所示,第一状态110的条目(3,3)中包括的PF度量是35。在从第一状态110选择UE波束对之后,调度器251基于到目前为止调度器针对当前TTI已经选择的所有UE波束对来计算累积奖励。由于此时调度器251仅选择了UE波束对(UE 3,波束3),因此调度器将累积奖励计算为35(即,与UE波束对(UE 3,波束3)相对应的条目(3,3)的PF值)。

根据上面讨论的第一调度规则和第二调度规则,UE波束对(UE3,波束3)的选择导致矩阵D从第一状态110转变到第二状态120。如图1B所示,在第二状态120中,由于调度器251遵循的第一调度规则和第二调度规则的要求,UE波束对(UE 1,波束1)至(UE 6,波束4)中的某些禁止被选择。在图1B中,由调度器251禁止针对当前TTI进行选择的UE波束对由与被设置为0的被禁止的UE波束对相对应的矩阵D中的条目的值来指示。如上所述,在图1B所示的示例中,调度器251遵循第一调度规则,第一调度规则要求任何两个调度波束被分离至少最小距离δ。在图1B所示的示例中,最小距离δ=2。因此,如图1B所示,在第二状态120中,由于在第一状态101中已经选择波束3,并且在波束3与波束2和波束4中的每个波束之间的距离为1(其小于最小距离δ=2),因此在当前TTI期间,与波束2-4相对应的UE波束对禁止被选择用于调度。

在图1B所示的示例中,由调度器251从第二状态120选择的用于在当前TTI中进行调度的第二UE波束对是(UE 5,波束1)。在第一状态110下与UE波束对(UE 5,波束1)相对应的条目是条目(5,1)。如图3所示,第二状态120的条目(5,1)中包括的PF度量为40。因此,在从第二状态120选择第二UE波束对之后,调度器251基于到目前为止调度器针对当前TTI已经选择的所有UE波束对来将累积奖励计算为75(即,与UE波束对(UE 3,波束3)相对应的条目(3,3)的PF值和与UE波束对(UE 5,波束1)相对应的条目(5,1)的PF值的和)。

根据上面讨论的第一调度规则和第二调度规则,UE波束对(UE3,波束3)的选择导致矩阵D从第二状态120转变到第三状态130。如图1B所示,在第三状态130中,由于调度器251遵循的第一调度规则和第二调度规则的要求,所有UE波束对(UE 1,波束1)至(UE6,波束4)禁止被选择。由于在第三状态130中调度器无法选择UE波束对,因此第三状态130被调度器251确定为最终状态,并且在当前TTI期间用于调度的UE波束对的选择结束。

因此,在图1B所示的示例中,针对当前TTI,调度器251调度两个选择的波束对(UE3,波束3)和(UE 5,波束1)。在本公开中,将UE i分配给波束j的动作可以简单地称为调度UE波束对(UE i,波束j)或分配UE波束对(UE i,波束j)。虽然图1B的示例示出了一种可能的动作序列(即,首先选择UE波束对(UE 3,波束3),然后选择UE波束对(UE 5,波束1)),但是还有其他几种可能的动作序列可能已经被调度器251选择并且可能导致更期望的结果。因此,可能是有利的是,确定一种方法以用于改进或备选地优化调度器251分配资源(例如,将UE分配给波束)的过程,以使得调度器251的小区的业务吞吐量增加或备选地最大化。

下面将参考图2更详细讨论调度器251的示例结构。下面将参考图3至图6更详细讨论用于改进使用调度器251在无线通信网络中分配资源的过程的示例方法。

如上所述,图2是示出调度器251的示例结构的图。

参考图2,调度器251可以包括例如数据总线259、发送单元252、接收单元254、存储器单元256和处理单元258。

发送单元252、接收单元254、存储器单元256和处理单元258可以使用数据总线259向彼此发送数据和/或从彼此接收数据。

发送单元252是包括硬件和任何必要的软件的设备,该硬件和任何必要的软件用于经由一个或多个有线和/或无线连接性向无线通信网络中的一个或多个其他网络元件发送信号,包括例如控制信号或数据信号。

接收单元254是包括硬件和任何必要的软件的设备,该硬件和任何必要的软件用于经由与无线通信网络中的一个或多个其他网络元件的一个或多个有线和/或无线连接性来接收无线信号,包括例如控制信号或数据信号。

存储器单元256可以是能够存储数据的任何设备,包括磁存储装置、闪存等。

处理单元258可以是能够处理数据的任何设备,包括例如处理器。

根据至少一个示例实施例,本文中例如参考图1至图6中的任何图描述为由调度器执行的任何操作可以由具有图2所示的调度器251的结构的电子设备来执行。例如,根据至少一个示例实施例,调度器251可以在软件和/或硬件方面进行编程,以执行本文中描述为由调度器执行的任何或所有功能。因此,调度器可以通过软件和/或硬件编程被实施为专用计算机。

现在将在下面讨论在软件方面进行编程以执行本文中描述为由本文中描述的任何调度器执行的任何或所有功能的调度器251的示例。例如,存储器单元256可以存储程序,该程序包括可执行指令,该可执行指令对应于本文中参考图1至图4描述为由调度器执行的任何或所有操作。根据至少一个示例实施例,除了或备选存储在存储器单元256中,可执行指令可以被存储在计算机可读介质中,包括例如光盘、闪存驱动器、SD卡等,并且调度器251可以包括用于读取存储在计算机可读介质上的数据的硬件。此外,处理单元258可以是如下处理器,该处理器被配置为执行本文中参考图1至图4描述为由调度器执行的任何或所有操作,例如通过读取并且执行存储在存储器单元256和计算机可读存储介质中的至少一个中的可执行指令,该可执行指令被加载到调度器251中包括的硬件中以用于读取计算机可读介质。

现在将在下面讨论在硬件方面进行编程以执行本文中描述为由调度器执行的任何或所有功能的调度器251的示例。作为对与参考图1至图6描述为由上述存储在存储器单元或计算机可读介质中的调度器执行的功能相对应的可执行指令的补充或备选,处理单元258可以包括具有专用于执行本文中参考图1至图6描述为由调度器执行的任何或所有操作的结构设计的电路(例如,集成电路)。例如,包括在处理单元258中的上述电路可以是FPGA或ASIC,该FPGA或ASIC通过特定电路设计而被物理编程为执行参考图1至图6描述为由调度器执行的任何或所有操作。

如将在下面参考图3至图6更详细讨论的,根据至少一些示例实施例,调度器251可以利用强化学习技术或从其受益以改进资源分配。

图3和图4是用于说明根据至少一些示例实施例的强化学习的示例的图。

图3示出了游戏的示例,其中游戏板310包括盒子的矩阵,每个盒子具有由盒子的对应灰度值指示的不同数值。图3中的游戏涉及动作At,动作At例如可以是玩家在板310投掷飞镖305。游戏具有规定奖励R

一种增加或备选地最大化诸如图3所示的游戏的最终或最后得分的方法将是找到期望的或备选地最优的策略(π*),该策略将状态映射到动作以增加或备选地最大化累积收益或回报。例如,图3所示的游戏可以被概念化为有限马尔可夫决策过程(MDP)(其中{S

例如,在时间t的累积收益G

其中0≤γ≤1是折扣参数,T表示最终时间点,k是整数索引值。

最优动作值函数(Q*)可以根据等式2来定义:

Q

使用已知的贝尔曼(Bellman)等式作为迭代更新,动作值函数Q

Q

其中s′和r是在状态s下采取动作a之后的状态和奖励。

根据至少一些示例实施例,通过概念化将网络资源分配为如图3中所示的游戏的过程,类似于上面参考等式1-3讨论的强化学习(例如,Q学习技术)可以被应用于分配网络资源(例如,将UE分配给小区中的波束)的任务。例如,如图4所示,通过根据矩阵D的空间上对应的框(即,条目或元素)中的PF度量的数值来设置游戏板310中的框的灰度值,上面参考图1B讨论的矩阵D可以被表示为以上参考图3讨论的游戏板310。

然而,即使矩阵D被重新解释为游戏板310,并且以上关于等式1-3讨论的Q学习技术被应用,试图针对游戏板310(即,矩阵D)的每个可能状态和动作来学习Q函数在时间、处理资源和/或存储器要求方面也可能是禁止的。因此,根据至少一些示例实施例,神经网络可以被用于促进确定与状态动作对相关联的Q函数的过程,该状态动作对与矩阵D相关联。

例如,神经网络可以被有利地应用于在结构化数据内找到特征,诸如图像的像素值的阵列或向量。此外,如doi:10.1038/nature14236的Nature的2015年第518卷第7540号第529-533页的Mnih、Volodymyr等人的“Human-level control through deepreinforcement learning”(其内容通过引用并入本文)中讨论的,Q学习技术可以被与卷积神经网络(CNN)技术相结合以创建深度Q网络(DQN)。

图5示出了根据至少一些示例实施例的调度器251中包括的DQN501的示例结构。如图5所示,DQN 501可以接收状态505并且输出与对应于状态505的每个有效动作相关联的Q值555。例如,每个有效动作是在给定矩阵D的状态505和调度器251遵循的调度规则的情况下调度器251被准许在当前TTI期间执行的与UE波束对的分配相对应的动作。状态505是指例如特定状态中的矩阵D。例如,图1B所示的矩阵D的第一状态110、第二状态120和第三状态130是可以被输入到DQN 501的状态505的每个示例。在本公开中,矩阵D的特定状态(例如,图1B所示的矩阵D的第一状态310)可以简称为“状态”(例如,“第一状态310”)。

如图5所示,DQN 501可以是卷积神经网络(CNN),该CNN可以包括例如第一卷积层510、第二卷积层520、第三卷积层530、第一全连接层540、以及作为输出层的第二全连接层550。在图5所示的示例中,第一卷积层510包括五个大小为6×6的过滤器,第二卷积层520包括十个大小为3×3的过滤器,并且第三卷积层530包括十个尺寸为2×2的过滤器。根据至少一些示例实施例,用于DQN 501的所有隐藏层的激活是ReLU函数,并且第二全连接层550(其输出是Q值555)具有线性激活函数。图5所示的DQN 501的结构是一个示例。根据至少一些示例实施例,调度器251中包括的DQN的参数(例如,每层中的过滤器的数目、过滤器的大小、以及第四隐藏层中的全连接的节点的数目)可以不同于图5所示的那些,并且可以根据调度器251的设计者或操作者的偏好来选择。例如,DQN 501的上述参数可以基于经验分析来选择。现在将在下面参考图6更详细讨论利用调度器251的DQN 501来促进将UE分配给波束的任务的方法。

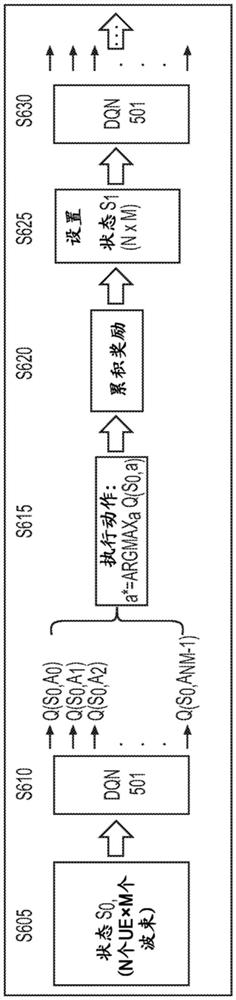

图6示出了根据至少一些示例实施例的操作调度器251以分配无线通信网络的资源的示例方法。

在操作S605中,调度器251获得多个PF度量值。例如,在操作S605中,调度器251可以以矩阵D的状态S

在操作S610中,调度器251确定与在操作S605中获得的状态S

在操作S615中,调度器251可以确定具有在操作S610中计算的Q值中的最高Q值的动作A,并且执行所确定的动作。例如,如果Q(S

在操作S620中,调度器251累积当前奖励。例如,调度器251可以将与在操作S620中执行的动作A相对应的UE波束对的PF度量值确定为用于执行动作A的奖励,并且将该奖励添加到与先前由调度器251针对当前TTI执行的动作相对应的奖励的累积总和(即,先前由调度器251针对当前TTI分配的UE波束对的PF度量的累积总和)。

在操作S625中,调度器251将状态S

在操作S630中,调度器251确定与在操作S625中获得的状态S

在操作S630之后,调度器251可以确定具有在操作S630中针对状态S

现在将在下面参考算法2讨论训练DQN 501的示例方法。算法2以伪代码表示,该伪代码表示可以例如由调度器251执行以训练DQN501的操作。另外,根据至少一些示例实施例,DQN 501可以由除调度器251之外的设备(例如,训练器、计算机或服务器)执行算法2中包括的操作来训练,并且在训练之后,经训练的DQN 501可以被包括在调度器251中。

算法2

P1:利用随机主权重θ初始化Q(即,DQN)。

P2:将冻结权重θ

P3:使用贪婪选择方法将DQN与样本拟合:Q

P3′:如果不使用贪婪选择方法(用于加快训练速度),则仅使用倒数第二状态样本和相关联的动作奖励作为Q值进行拟合。

P4:将以上样本和另外若干随机地生成的样本存储在重放缓冲区中(replaybuffer)。

P5:从重放缓冲区中选择随机小批量的样本。针对小批量中的每个样本S

P5-1:将S

P5-2:针对S

P5-3:对于S

针对非最终状态S

如果使用Q

如果不使用Q

针对最终状态S

y

针对具有零奖励的动作:

y

P5-4:通过将所有aεA的y

P6:通过使用小批量的样本在DQN中执行批量梯度下降步骤来更新θ,其中针对每个样本S

P7:经过若干小批次的采样和训练之后,设置θ

参考算法2,在步骤P1中,调度器251初始化作为DQN 501的权重的主权重θ。根据至少一些示例实施例,调度器251使用随机值作为主权重θ的初始值。

在步骤P2中,调度器251将冻结权重θ-设置为主权重θ。

在步骤P3中,调度器使用贪婪选择方法Q

备选地,在步骤P3′中,在调度器251未使用贪婪选择方法的情况下,调度器251可以仅使用倒数第二状态(即,最终状态之前的一个状态)样本和相关联的动作奖励作为Q值来拟合DQN 501。注意,在倒数第二状态中,Q(S,a)=R(a)。一旦倒数第二状态的Q值由DQN501获知,DQN 501就可以获知倒数第二状态之前的状态的Q值,以此类推。

在步骤P4中,调度器将在步骤P3或P3′中生成的样本状态存储在重放缓冲区中。根据至少一些示例实施例,重放缓冲区可以被包括在调度器251的存储器单元256中。例如,针对在步骤P3或P3′中发生的从状态S

在步骤P5中,调度器251从重放缓冲区中选择随机小批量的样本,并且针对随机小批量中包括的每个样本S

在步骤P5-1中,调度器251使用当前主权重θ将样本状态S

在步骤P5-2中,调度器251针对状态S

在步骤P5-3中,针对状态S

在步骤P5-3中,当下一状态S

y

y

当使用贪婪选择方法Q

在步骤P5-3中,当下一状态S

y

在步骤P5-3中,当动作a是具有0个奖励的动作时(例如,鉴于调度器251遵循的调度规则而不允许的动作,如分配距先前针对同一TTI分配的UE波束对小于最小距离δ的UE波束对;或者该波束中没有PF值),调度器251根据等式7计算该目标y

y

在等式4和5中,R(a)表示由于执行动作a而获得的奖励,γ表示值不小于0并且不大于1的折扣参数,并且表达式max

在步骤P5-4中,调度器251通过将所有aεA的y

在步骤P6中,调度器251通过使用小批量的样本S

L=[y

经过若干采样和训练后,设置θ

在步骤P7中,将冻结权重θ

这样描述了示例实施例,很清楚的是,可以以很多方式改变实施例。这样的变化不应当被认为偏离示例实施例,并且所有这样的修改旨在被包括在示例实施例的范围内。

- 使用深度Q网络促进资源配对的方法和装置

- 使用深度学习的多用户多输入多输出波束选择和用户配对的方法和装置