一种以节能为目标的计算卸载模型优化方法

文献发布时间:2023-06-19 11:22:42

技术领域

本发明涉及任务卸载领域,具体说是一种以节能为目标的计算卸载模型优化方法。

背景技术

长久以来,变电站等基础设施的人工巡检工作存在着巡检到位率低、设备巡视质量不高及巡视数据不准确等方面的问题。在建站时,就将传感器和设备一起来部署,这样后期就可以使用传感器来检测每个设备的各类运行状态,通过定期读取和分析传感器的数据,来实现定期自动巡检。但是,对于建设年代较早的许多电站,建站时未部署相应的传感设备。这就需要进行技术改造,将传感器嵌入到生产系统中,其施工难度很大。一种代替方案是巡检机器人携带红外热像仪、可见光摄像机、拾音器等较为先进的现场检测装置,执行预先设定时间的任务或根据操作人员在基站的操作指令,进行全天候的站点设备巡检,完成一次设备的可见光图像检测以及红外检测等,识别记录设备表计的信息,并对其进行相应的数据分析,及时对异常数据报警。

在这个过程中,对可见光图像检测以及红外检测等,识别记录设备表计的信息需要依托于计算机视觉(CV)方面的成果,提高检测的准确率。进年来,深度神经网络(DNN)在计算机视觉(CV)等方面,其识别精度和处理速度都取得了长足的进步。另一方面,巡检机器人等移动设备的计算能力也在不断增强,多核CPU和GPU集成在移动设备的Soc中。因此,越来越多的DNN应用开始尝试直接部署在这些移动设备上。但是由于其计算能力毕竟有限,在移动设备上运行DNN计算显得力不从心;而且DNN计算也会消耗大量电能,对一些仅依赖电池供电的巡检机器人等移动设备而言,会大大缩短其工作时间,随之其可用性也会降低。

在资源受限的设备上运行DNN,比较明智的做法是将DNN计算卸载到云中心。但受地理位置的限制,部分站点的移动网络覆盖不好,站点的某些地方存在盲区。在这种情况下,需要使用边缘计算技术,构建边缘计算网络,并部署边缘计算服务器,将DNN计算卸载到边缘服务器。在边缘计算中,一种方法是全部卸载到边缘服务器,即移动设备向边缘服务器发出请求(如请求识别一张图片中的物体),边缘服务器执行DNN计算,将计算后的结果传回移动设备。另一种方法是部分卸载,即一个DNN任务进行切分,一部分由移动设备执行,另一部分由边缘服务器执行,以实现性能的提升或节能。

在边缘计算过程中,将面临以下挑战。如何平衡通信能耗和计算能耗,在不同的无线接入条件下,选择一个最节能的DNN模型切分方案?如果移动设备执行部分DNN任务,需要将DNN任务执行的中间结果上传给服务器,并接收服务器处理后的数据。因此,移动设备在执行DNN任务的能耗包含计算能耗和通信能耗。不同DNN层的输入数据量、输出量不同,不同可用带宽下的通信能耗差异很大。

发明内容

针对上述问题,本发明提供一种以节能为目标、可感知接入带宽的计算卸载模型优化方法。

本发明解决上述技术问题所采用的技术方案为:一种以节能为目标的计算卸载模型优化方法,包括以下步骤:

(1)采用边缘设备构建一个边缘计算环境;

(2)对所述边缘设备的待机能耗、DNN执行功耗、数据传输功耗进行测量;

(3)使用G=(V,E)表示一个执行图,将所述执行图建模为一个有向无环图,每个层转化为有向无环图的3个节点,第k层转化为vk,1,vk,2和vk,33个节点;

(4)给定当前带宽B,预测边缘设备发送D字节的数据的能耗,记为f

(5)使用V={v1,v2,·,vm}表示所有节点(v1和vm分别表示Input和Output层对应的节点),E表示边的集合,其中的一条边(vi,vj)∈E;

(6)根据

计算各节点之间的边的权重,有向无环图的最短路径即为当前宽带条件下最节能的执行方式;其中,{L

作为优选,Client按如下方法计算各个边的权重:Client通过DNN执行profile文件计算出边缘设备上各层的执行能耗,作为client端节点之间的边的权重;使用预测函数预测各层在边缘服务器上的执行时间,使用公式“服务器端执行时间乘以client端的待机能耗”,得出server端节点之间的边的权重;另外,client与Server端的数据传输能耗,可以根据当前可用带宽通过回归模型来预测,作为client端和server端的节点之间的边的权重。

作为优选,使用求解最短路径算法的Dijkstra算法,计算从起始顶点v1(Input层对应的节点)和vm(Output层对应的节点)所经过的路径中,各边上权值之和最小的一条路径,该路径为最短路径,即为当前带宽条件下的最节能的执行方式。

作为优选,使用Moon库仑计对NVidia Jetson Nano的DNN执行功耗、数据传输功耗进行测量。

作为优选,使用回归模型进行拟合,得到相关的能耗模型。

作为优选,使用Matlab对DNN切分算法进行仿真。

与现有技术相比,本发明具有以下有益效果:本发明采用边缘计算的解决方案,解决了现有技术的巡检机器人进行检测所需的深度神经网络计算时能耗较大的技术问题。在边缘计算中,我们的方法可自适应当前可用带宽,选择最节能的执行方式(本地执行,全部或部分卸载到边缘服务器),并进行DNN推理任务的执行。经实验验证,我们的方法,与本地执行或全部卸载方案相比,在不用可用带宽条件下,均以可以选择已最节能的方式执行,这就大大节省了巡检机器人等移动设备的能耗,延长了工作时间。

附图说明

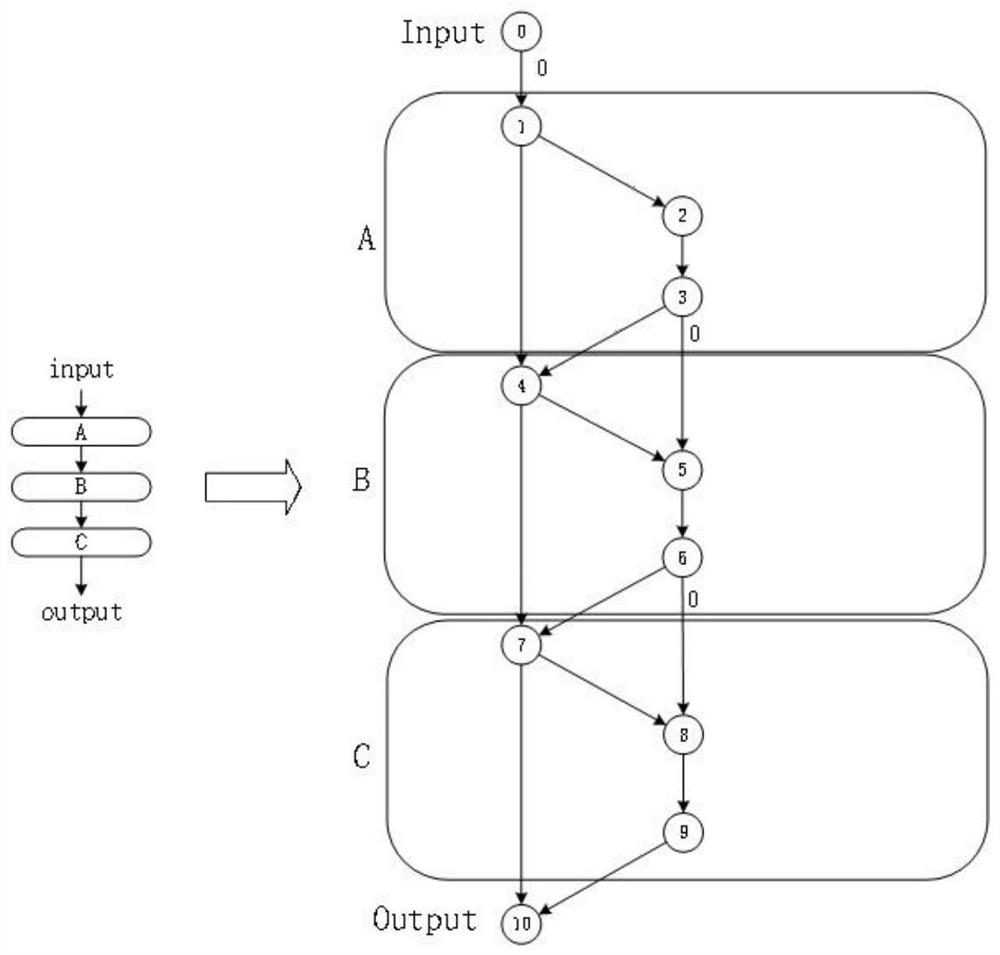

图1为本发明基于能耗的执行图;

图2为在不同带宽下不同执行方式下的移动设备的能耗情况;

图3表示Alex模型在不同带宽下的切分点选择;

图4显示了在优化能量的过程中,DNN的推理时间的变化情况。

具体实施方式

下面以一个经典的3层DNN模型为例,说明是其基于能耗的执行图的构造过程,在此本发明的示意性实施例以及说明用来解释本发明,但并不作为对本发明的限定。

执行图表示边缘设备和边缘服务器针对DNN计算过程中层粒度的协同执行路径。如图1箭头左边部分所示,一个DNN由3个神经网络层组成,箭头右边部分就是该DNN对应的执行图。每一层转化为3个节点(层A:1,2,3,层B:4,5,6,层C:7,8,9)。位于左侧的节点(如0,1,4,7,10)属于client端节点,位于右侧的节点(2,3,5,6,8,9)属于server端节点。client端节点之间的边(如1→4)代表层A在移动设备执行,而server端节点之间的边(如2→3代表层A在边缘服务器上执行。client端和server端的节点之间的边(如1→2或3→4)代表NN层的输入或输出数据在client端和server端之间进行传输。给每个边添加权重,每个权重表示相应的能耗(计算能耗或通信能耗)。一些边由于没有产生计算能耗或通讯能耗,因此它的权重为0(如0→1或3→5)。Client按如下方法计算各个边的权重:Client通过DNN执行profile文件计算出边缘设备上各层的执行能耗,作为client端节点之间的边的权重;使用预测函数预测各层在边缘服务器上的执行时间,使用公式“服务器端执行时间乘以client端的待机能耗”,得出server端节点之间的边的权重。另外,client与Server端的数据传输能耗,可以根据当前可用带宽通过回归模型来预测,作为client端和server端的节点之间的边的权重。

使用求解最短路径算法的Dijkstra算法,计算从起始顶点v1(Input层对应的节点)和vm(Output层对应的节点)从所经过的路径中,各边上权值之和最小的一条路径叫做最短路径。该路径代表了当前带宽条件下的最节能的执行方式。

采用实际测量+Matlab仿真的方式对上述算法进行评估。在实际测量中,边缘设备为一台NVidia Jetson Nano,通过2.4GHz Wifi连接TP-Link路由器,边缘服务器配置RTX2060GPU,联入TP-Link路由器,构成一个边缘计算环境。使用Moon库仑计对NVidia JetsonNano的DNN执行功耗、数据传输功耗进行测量,使用回归模型进行拟合,得到相关的能耗模型。使用Matlab对DNN切分算法进行仿真。可用带宽从0.1Mbps,每次增加0.1Mbps,增加到100Mbps,记录切分点、能耗和执行时间。

图2表示在不同带宽下不同执行方式下的移动设备的能耗情况。与移动设备本地执行(local execution)和全部卸载到边缘服务器(total offloading)这两种执行方式相比,我们提供的方案(our scheme)可自动适应各种带宽条件,在不同带宽条件下均最节能。当网络带宽<0.7Mbps,在本地执行最节能;当网络带宽大于0.7Mbps,移动设备将部分或全部DNN层的计算任务卸载到边缘服务器,可以节省能耗。所以,我们的算法可以平衡计算能耗和通信能耗,在不同带宽条件下都可以找到的最优切分。

图3表示Alex模型在不同带宽下的切分点选择(如实线所示)。我们发现切分算法将一个DNN模型被切分点p切分为2个部分。之前的部分被移动设备执行,后一部分被边缘服务器执行。如果p等于1表示所有DNN层都将卸载到边缘服务器执行,然后将执行结果返回给移动设备;如果p等于N+1(N表示为DNN模型的层数),表示所有DNN层都将移动设备本地执行。如图4-3所示,当网络带宽<0.7Mbps,在本地执行最节能;当网络带宽在0.7Mbps和3.4Mbps之间,最节能的执行方式是将第16到22层卸载到边缘服务器执行更节能;当网络带宽在3.4Mbps和17.8Mbps之间,最节能的执行方式是将第5到22层卸载到边缘服务器执行更节能;当网络带宽大于17.8Mbps,将全部DNN层卸载到边缘服务器最节能。随着可用网络带宽的增加,越来越多的DNN层将卸载到边缘服务器执行,以获得最节能的切分执行方式。

图4显示了在优化能量的过程中,DNN的推理时间的变化情况。我们的算法在优化能耗的同时,对DNN的推理时间也进行了优化。但是,在某些网络带宽变化的临界区域,其推理时间略有增加。所以,以优化能耗为目标的算法和优化推理时间为目录的算法无法相互替代。

以上对本发明实施例所提供的技术方案进行了详细介绍,本文中应用了具体个例对本发明实施例的原理以及实施方式进行了阐述,以上实施例的说明只适用于帮助理解本发明实施例的原理;同时,对于本领域的一般技术人员,依据本发明实施例,在具体实施方式以及应用范围上均会有改变之处,综上所述,本说明书内容不应理解为对本发明的限制。

- 一种以节能为目标的计算卸载模型优化方法

- 一种云机器人边缘计算卸载模型及其卸载方法