一种复杂网络拓扑图表示学习方法、预测方法及服务器

文献发布时间:2023-06-19 11:42:32

技术领域

本发明涉及一种基于无监督图自编码器的复杂网络拓扑图表示学习方法、预测方法及服务器,属于计算机软件技术领域。

背景技术

复杂网络拓扑图数据有着复杂的结构,比如在自治系统AS(Autonomous System)中,两两之间存在着密不可分的关联关系,顶点与顶点直接通过边相互衔接,使不同顶点具备多样化的属性类型,以及多层面的学习任务,要充分利用图数据顶点之间密切连接的优势,就需要一种高效的图数据表示方法,因此,基于复杂网络拓扑图的图表示学习已经成为图学习领域中十分热门的研究课题之一。

目前,基于复杂网络拓扑图的图表示学习主要有三类方法:1)基于分解的方法:通过描述复杂网络图数据结构信息的矩阵进行矩阵分解,将节点转化到低维向量空间中去,同时保留结构上的相似性。一般来说,这类方法均有解析解,但是由于结果依赖于相关矩阵的分解计算,因此,这类方法具有很高的时间复杂度和空间复杂度;2)基于随机游走的方法:通过将图转化为序列的方式从而实现了大规模图的表示学习,但将图转化成序列集合,复杂网络拓扑图本身的结构信息没有办法被充分利用,同时该学习框架很难融合图中的属性信息进行表示学习;3)基于深度学习的方法,其典型代表是基于图神经网络GNN的相关方法:通过聚合节点自身特征和邻居节点的特征获得节点的嵌入表示,能够非常自然地融合图的属性信息进行学习,在多个图数据相关任务上都取得了较好的成绩,充分显示出了其强大的表示学习能力,为图嵌入学习带来了新的建模方法。但在实际的应用场景中,大量的数据标签往往具有很高的获取门槛,研究如何对图数据进行高效地无监督表示学习将具有十分重要的价值。

发明内容

针对现有技术中存在的技术问题,本发明的目的在于提供一种基于无监督图自编码器的复杂网络拓扑图表示学习方法、预测方法及服务器。

本发明解决原始数据无标签或标签数据较少的问题,同时在无节点属性信息的情况下也能学习到较好的图节点表示结果,用于下游链路预测或图生成等任务。本发明通过基于PageRank算法的DropEdge策略,在训练图神经网络时对输入的原图数据加噪,迫使模型从基于图结构信息的加噪数据中提取有用的信息用于恢复原数据,从而增强模型的学习能力,提高学习到的图嵌入表示的鲁棒性,同时解决过平滑引起的模型参数难以调优的问题。

本发明在图自编码器训练优化阶段,基于高维而稀疏(只有有限的非零元素)的表示是更好的特征表达的启发式知识,引入一个稀疏性约束作为一个正则惩罚项加入到损失函数中,对整个自编码器网络的稀疏性进行正则化约束,使图自编码器学习到图数据的稀疏表征。即在同一时间只激活一小部分神经元,即使在隐藏神经元数量较多的情况下仍然可以发现输入数据中一些有价值的内部结构信息,并可以将大量冗余或噪声特征去除,提高模型的泛化能力,降低模型过拟合的风险。

本发明的技术方案为:

一种复杂网络拓扑图表示学习方法,其步骤包括:

1)从复杂网络拓扑图结构数据中提取邻接矩阵A和特征矩阵X;

2)将邻接矩阵A中设定位置的节点按一定概率p置0,抹去一部分边信息或边权重值,得到加噪后的邻接矩阵A′;

3)将所述邻接矩阵A′和特征矩阵X输入到图神经网络中;图神经网络的编码模块对输入的邻接矩阵A′和特征矩阵X进行深度学习和特征编码,得到复杂网络拓扑图中各节点的嵌入表示,然后将各节点的嵌入表示进行稀疏化处理并输入到图神经网络的解码模块;其中,图神经网络的损失函数中添加一个稀疏性约束;

4)解码模块根据输入的稀疏节点表示重构复杂网络拓扑图,然后利用添加稀疏性约束的损失函数计算重构复杂网络拓扑图与原始复杂网络拓扑图的损失值;

5)通过梯度下降方法不断计算损失函数的梯度值,梯度方向即损失值下降最快的方向,反复求取梯度即可得到损失函数的最小值,此时得到的参数矩阵就是图神经网络的最优参数,当参数矩阵达到最优时,将编码模块得到的各节点的嵌入表示,作为复杂网络拓扑图中各节点的嵌入表示。

进一步的,所述稀疏性约束为一个正则惩罚项。

进一步的,所述图神经网络的原损失函数为交叉熵损失函数,在所述交叉熵损失函数的基础上添加KL散度或L1正则化,作为训练优化所述图神经网络所用的损失函数。

进一步的,训练优化所述图神经网络所用的损失函数为

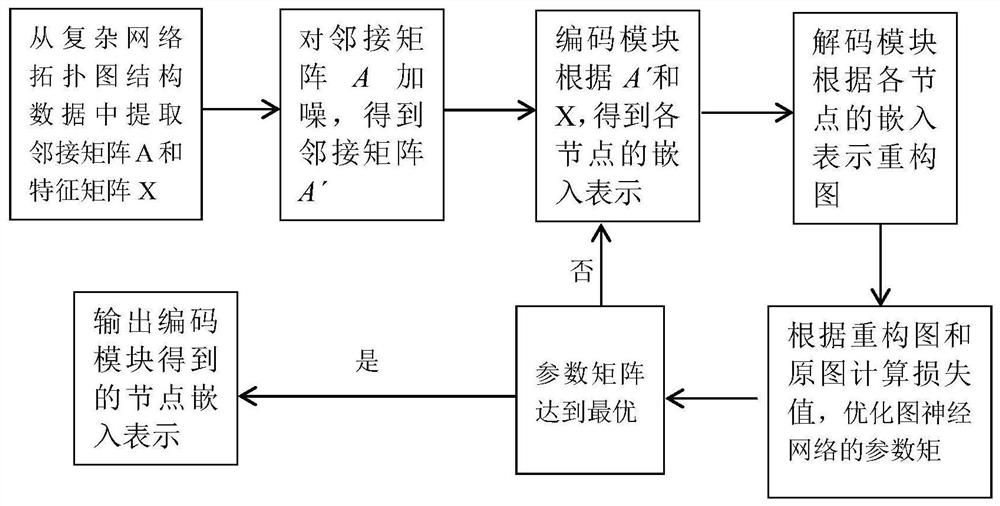

进一步的,得到邻接矩阵A′的方法为:对复杂网络拓扑图中的N个节点分别计算PageRank值,然后在邻接矩阵A中排名前M/2节点和排名后M/2节点对应的位置采用DropEdge策略按设定概率p进行删除,得到加噪后的邻接矩阵A′;其中M 进一步的,所述复杂网络拓扑图主要为自治系统的复杂网络拓扑图,但不限于自治系统的复杂网络拓扑图。 一种复杂网络链路预测方法,其特征在于,利用上述方法得到的复杂网络拓扑图中各节点的图嵌入表示,作为神经网络或分类器的输入特征,预测出相应边是否存在。 一种复杂网络图生成方法,其特征在于,利用上述方法得到的复杂网络拓扑图中的各节点的图嵌入表示结合链路预测任务,预测复杂网络拓扑图的新边,然后根据预测结果更新复杂网络拓扑图。 一种服务器,其特征在于,包括存储器和处理器,所述存储器存储计算机程序,所述计算机程序被配置为由所述处理器执行,所述计算机程序包括用于执行上述方法中各步骤的指令。 一种计算机可读存储介质,其上存储有计算机程序,其特征在于,所述计算机程序被处理器执行时实现所上述方法的步骤。 本发明的复杂网络拓扑图表示学习方法,其特征包括以下步骤: 1)数据加噪处理模块,负责从复杂网络拓扑图结构数据分析提取邻接矩阵A和特征矩阵X(若无节点属性信息,则X用one-hot矩阵表示;网络中节点特征构成的特征矩阵X),并进行加噪处理。加噪处理方法:通过PageRank算法对图数据(节点总数为N)各节点计算PageRank值,然后在邻接矩阵中对排名两端的共M个节点对应的位置采用DropEdge策略按概率p置0(M 2)编码模块,将上述邻接矩阵和特征矩阵输入到图神经网络中作为输入层数据,并通过图神经网络对其进行深度学习和特征编码,从而学习得到各节点的嵌入表示;然后将各节点的嵌入表示进行稀疏化操作处理为稀疏节点表示并输入到解码模块;通过在训练图神经网络模型的优化阶段,添加一个稀疏性约束,即设定一个正则惩罚项并将其加入到图神经网络模型的损失函数中(原损失函数为交叉熵损失函数,本发明在交叉熵损失函数的基础上添加KL散度或L1正则化),通过训练学习到图数据的稀疏节点表示,将其传递给解码模块作为其输入。或者将得到的各节点的嵌入表示不稀疏化处理直接输入到解码模块。 3)解码模块,负责利用解码器(内积形式)逐步重构复杂网络拓扑图,利用上述损失函数使重构的复杂网络拓扑图的邻接矩阵与原始复杂网络拓扑图的邻接矩阵尽可能相近,通过不断学习自编码器参数最终得到有效的图节点嵌入表示。 4)特征融合与建模模块,负责利用最终得到的有效的图嵌入表示结果作为下游任务的输入特征,结合图数据多种其他维度特征进行建模实现链路预测、图生成等任务。 本发明还提供了一种复杂网络链路预测方法,利用上述得到的复杂网络拓扑图中各节点有效的图嵌入表示,将其作为下游神经网络或分类器的输入特征,结合链路(即边)的预测任务,可在输出层预测出相应边是否会存在的结果。 本发明还提供了一种复杂网络图生成方法,利用上述得到的复杂网络拓扑图的各节点有效的图嵌入表示结合链路预测任务,可以给出现有图中未来会出现哪些新链接(新边)的预测结果,生成新图。 本发明还提供一种服务器,其特征在于,包括存储器和处理器,所述存储器存储计算机程序,所述计算机程序被配置为由所述处理器执行,所述计算机程序包括用于执行上述方法中各步骤的指令。 本发明还提供一种计算机可读存储介质,其上存储有计算机程序,其特征在于,所述计算机程序被处理器执行时实现所上述方法的步骤。 本发明的特点包括: 1)基于降噪和稀疏表示的图自编码器无监督图嵌入学习方法,在图自编码器训练时,将降噪处理和稀疏表示的思想融合:针对原始输入图数据,通过PageRank算法在保留图自身结构信息重要性的基础上引入DropEdge加噪策略,迫使基于图自编码器模型从加噪数据中提取有用的信息用于恢复原数据,增强模型的图表示学习能力;针对编码器训练图嵌入表示的优化阶段,通过设定一个稀疏性正则化约束作为惩罚项加入到损失函数中,实现的稀疏性表示,根据得到的邻接矩阵和特征矩阵中值为0的数量判定稀疏程度,0多表示稀疏性强;当不够稀疏或和期望的稀疏程度偏离较大时,惩罚增强,从而提高模型泛化能力,降低过拟合风险,由于在损失函数中加入了惩罚项,利用梯度下降算法进行参数优化过程中即可自动调整惩罚项的值。 2)基于降噪和稀疏表示的图自编码器无监督图嵌入学习方法装置的实现,将基于降噪和稀疏表示的图自编码器的图嵌入学习方法设计为有效的系统装置,能通过输入任意领域网络图数据(有无节点属性特征均可),通过图自编码器端到端训练得到图各节点的嵌入表示。此装置中涉及所有算法对用户均为黑盒模式,用户只需输入原始网络图即可得到期望的图嵌入表示结果,用户可将其作为下游任务的输入特征应用于链路预测、图生成等任务中,提升目标任务的准确率。 与现有技术相比,本发明的积极效果为: 1)通过一种基于图自编码器的方法,将降噪和稀疏表示的思想融合到图自编码器中,在图神经网络模型对图的属性信息和结构信息进行学习的过程中,对输入数据增加噪声干扰同时利用稀疏表示的数据更容易线性可分的启发式知识,引入稀疏性约束,解决过平滑和过拟合的问题,从而得到更准确的图嵌入表示。2)通过一种无监督学习的图嵌入表示方法,解决了原始数据无标签或标签数据较少的问题,无需针对监督学习的要求进行大量的人工标注,减少工作量,降低训练成本。3)通过基于PageRank算法的DropEdge策略对输入的原始图数据加噪,同时在此加噪的过程保留图自身结构信息的重要性,只对PageRank排名两端的节点添加干扰因素,迫使图自编码器模型从基于图结构信息的加噪数据中提取有用的信息用于恢复原数据,提高学习到的节点表示的鲁棒性和普适性,同时解决过平滑引起的模型参数难以有效优化的问题。4)在图自编码器训练学习节点表示的优化阶段,引入一个针对稀疏性的限制,将一个正则惩罚项加入到损失函数中,以此对整个图自编码器网络的稀疏性进行正则化约束,即使在隐藏神经元数量较多的情况下仍然可以发现输入数据中一些有价值的内部结构信息,提高模型的泛化能力,降低模型过拟合的风险。 附图说明 图1为本发明的复杂网络拓扑图表示学习方法生成流程图。 具体实施方式 下面结合附图对本发明进行进一步详细描述。 本实施例的整体流程的具体步骤描述如下: 1)搭建服务器集群(服务器分为1台主服务器和若干子服务器),包括数据加噪处理模块、编码模块、解码模块、特征融合与建模模块四部分; 2)数据加噪处理模块,从AS复杂网络拓扑图结构数据根据AS与AS之间的关联关系分析提取邻接矩阵A和特征矩阵X(若无节点属性信息,则X用one-hot矩阵表示),并基于PageRank排名利用DropEdge策略对原始图数据进行加噪处理,将加噪后的邻接矩阵A′和特征矩阵X传递至编码模块作为输入特征。 3)编码模块,利用图神经网络模型作为编码器学习节点嵌入表示,在训练图神经网络模型的优化过程中,添加一个稀疏性约束,即设定一个正则惩罚项将其加入到损失函数(在交叉熵的基础上添加KL散度或L1正则化),通过训练学习到节点表示,并将其传递给解码模块作为其输入。 4)解码模块,将编码器传递的节点表示结果输入到解码器进行图的重构(通过内积形式),得到重构图的邻接矩阵 5)特征融合与建模模块,利用训练得到的图嵌入表示结合节点其他属性特征作为下游任务的输入,构建图神经网络完成建模,实现链路预测、图生成等任务。 具体实现过程示例(仅以IPv6 AS级网络拓扑图举例说明过程,并非用以限定本发明),核心流程如图1所示: (1)选取RouteViews项目位于俄勒冈的IPv6专用采集点(route-views6)一年内的IPv6 BGP路由表原始数据,解析原始数据后提取AS_PATH字段的ASN相关数据,构建AS两两互联的网络拓扑图(节点总数为N)。 (2)数据预处理:将AS网络图数据按照边连接情况转换为邻接矩阵A,AS节点特征矩阵X通过one-hot矩阵表示,若没有节点属性特征,则将X设置为N×1阶全1矩阵(即N维全1列向量)。 (3)图数据加噪处理:对图数据N个节点分别计算PageRank值,然后在邻接矩阵A中对排名两端的共M个节点(排名前M/2节点和排名后M/2节点)对应的位置采用DropEdge策略按p的概率删除(M (4)图自编码处理:对加噪后的邻接矩阵A′和特征矩阵X通过两层图卷积神经网络得到图节点嵌入表示Z,即图嵌入表示: Z=GCN(X,A′)-----公式(1) 其中,两层图卷积网络的定义如下:

其中, (5)解码:采用内积的形式作为解码器来重构原始的图:

(6)优化处理:在训练图自编码器模型得到图嵌入表示的优化阶段,添加一个正则惩罚项作为稀疏性约束,使图自编码器学习到图数据的稀疏表征:假设激活函数采用的是sigmoid,那么输出为1代表这个节点很“活跃”,输出为0代表这个节点“不活跃”。 基于此可以引入KL离散度或L1正则化来作为优化阶段中损失函数的惩罚项ρ(Z),损失函数L为在交叉熵的基础上添加惩罚项,表示为:

其中,y表示邻接矩阵A′中的某个元素的值(0或1), (7)基于学习到的图嵌入表示,结合其他维度特征应用于下游任务中构建图神经网络建模,实现链路预测、图生成等任务。 本发明还提供一种服务器,其特征在于,包括存储器和处理器,所述存储器存储计算机程序,所述计算机程序被配置为由所述处理器执行,所述计算机程序包括用于执行上述方法中各步骤的指令。 本发明还提供一种计算机可读存储介质,其上存储有计算机程序,其特征在于,所述计算机程序被处理器执行时实现所上述方法的步骤。 以上所述仅为本发明的较佳实施例而已,并不用以限制本发明,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

- 一种复杂网络拓扑图表示学习方法、预测方法及服务器

- 一种基于对比学习的分子图表示学习方法