超分辨率网络模型压缩方法、系统、设备和介质

文献发布时间:2023-06-19 09:27:35

技术领域

本发明涉及图像处理和深度学习领域,特别涉及一种超分辨率网络模型压缩方法、系统、设备和介质。

背景技术

SR(Super-Resolution,超分辨率技术)是指在低分辨率图像的基础上构建出高分辨率图像的方法。目前,超分辨率技术在视频监控、医学诊断、遥感成像等领域都有重要的应用价值。超分辨率技术的传统方法一般是通过线性插值方式来将低分辨率图像放大至目标尺寸。传统方法的算法时间复杂度较低,但是带来的问题是图像失真严重。目前主流思路是利用基于CNN(Convolutional Neural Networks,卷积神经网络结构)的深度模型来实现超分辨率技术,通过训练网络模型的数十万个参数,模型可以很好的模拟出非线性插值效果,极大提升超分辨率的成像质量。不过目前为了提高超分辨率网络模型成像质量,网络结构不断加深,参数量持续增加,在前向推理计算和内存占用方面都给机器设备带来较高的负担。

面对以上的挑战,当下的解决方案有对网络模型进行蒸馏,结构剪枝,参数量化等方式,但是这些方法在一定程度上都存在很大缺陷,比如蒸馏和剪枝很大程度利用经验设置网络结构和参数,而参数量化往往带来精度损失较大。超分辨率网络模型对精度上要求较高,网络结构基本都是卷积算子,而且卷积核参数通常冗余度较高。

发明内容

本发明要解决的技术问题是为了克服现有技术中优化网络模型的方式模型运算精度损失大的缺陷,提供一种超分辨率网络模型压缩方法、系统、设备和介质。

本发明是通过下述技术方案来解决上述技术问题:

本发明提供一种超分辨率网络模型压缩方法,所述超分辨率网络模型压缩方法包括:

获取超分辨率网络模型的卷积层和全连接层;

采用张量分解算法对所述卷积层的卷积核参数进行张量分解并进行扩充,以获取三个四维卷积层矩阵,并且,对全连接层进行截断奇异值分解,以获取两个全连接层矩阵;

利用三个所述四维卷积层矩阵和两个所述全连接层矩阵分别替换所述卷积层和所述全连接层。

较佳地,所述采用张量分解算法对所述卷积层的卷积核参数进行张量分解并进行扩充,以获取三个四维卷积层矩阵的步骤包括:

提取卷积核的参数;

根据卷积层表达式,将卷积核的参数转换为四维的第一卷积层矩阵;

将所述四维的第一卷积层矩阵沿着输入通道和输出通道两个轴方向进行展开,以获取两个二维的第二卷积层矩阵;

获取两个二维的所述第二卷积层矩阵的秩;

判断两个所述第二卷积层矩阵的秩是否大于预设阈值,若是,则采用张量分解将两个二维的所述第二卷积层矩阵进行分解,以获取两个二维的第三卷积层矩阵和一个四维的卷积层矩阵,并对两个二维的所述第三卷积层矩阵进行扩充,以获取三个四维卷积层矩阵。

较佳地,所述对全连接层进行截断奇异值分解,以获取两个全连接层矩阵的步骤包括:

获取所述全连接层的参数矩阵;

对所述全连接层的参数矩阵进行奇异值分解,以获取第一对角矩阵、第一左奇异矩阵、第一右奇异矩阵;

将所述第一对角矩阵、第一左奇异矩阵、第一右奇异矩阵进行截断,以获取第二对角矩阵、第二左奇异矩阵、第二右奇异矩阵,并且,对所述第二对角矩阵和所述第二右奇异矩阵进行相乘运算,以获得两个全连接层矩阵。

较佳地,所述获取超分辨率网络模型的卷积层和全连接层的步骤包括:

获取经过训练后的所述超分辨率模型;

对所述超分辨率模型进行遍历,并获取超分辨率网络模型的全部卷积层和全连接层。

较佳地,在所述利用三个所述四维卷积层矩阵和两个所述全连接层矩阵分别替换所述卷积层和所述全连接层的步骤之后,所述超分辨率网络模型压缩方法还包括:对全连接层和卷积层替换后的超分辨率网络模型重新进行训练。

本发明还提供一种超分辨率网络模型压缩系统,所述超分辨率网络模型压缩系统包括:

获取模块,用于获取超分辨率网络模型的卷积层和全连接层;

分解模块,用于采用张量分解算法对所述卷积层的卷积核参数进行张量分解并进行扩充,以获取三个四维卷积层矩阵,并且,对全连接层进行截断奇异值分解,以获取两个全连接层矩阵;

替换模块,用于利用三个所述四维卷积层矩阵和三个所述全连接层矩阵分别替换所述卷积层和所述全连接层。

较佳地,所述分解模块包括:

提取单元,用于提取卷积核的参数;

转换单元,用于据卷积层表达式,将卷积核的参数转换为四维的第一卷积层矩阵;

展开单元,用于将所述四维的第一卷积层矩阵沿着输入通道和输出通道两个轴方向进行展开,以获取两个二维的第二卷积层矩阵;

第一获取单元,用于获取两个二维的所述第二卷积层矩阵的秩;

判断单元,用于判断两个所述第二卷积层矩阵的秩是否大于预设阈值,若是,则采用张量分解将两个二维的所述第二卷积层矩阵进行分解,以获取两个二维的第三卷积层矩阵和一个四维的卷积层矩阵,并对两个二维的所述第三卷积层矩阵进行扩充,以获取三个四维卷积层矩阵。

较佳地,所述分解模块还包括:

第二获取单元,用于获取所述全连接层的参数矩阵;

奇异值分解单元,用于对所述全连接层的参数矩阵进行奇异值分解,以获取第一对角矩阵、第一左奇异矩阵、第一右奇异矩阵;

截断单元,用于将所述第一对角矩阵、第一左奇异矩阵、第一右奇异矩阵进行截断,以获取第二对角矩阵、第二左奇异矩阵、第二右奇异矩阵,并且,对所述第二对角矩阵和所述第二右奇异矩阵进行相乘运算,以获得两个全连接层矩阵。

较佳地,所述获取模块包括:

第三获取单元,用于获取经过训练后的所述超分辨率模型;

第四获取单元,对所述超分辨率模型进行遍历,并获取超分辨率网络模型的全部卷积层和全连接层。

较佳地,所述超分辨率网络模型压缩系统还包括训练模块;

所述训练模块用于对全连接层和卷积层替换后的超分辨率网络模型重新进行训练。

本发明还提供一种电子设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现如前述的超分辨率网络模型压缩方法。

本发明还提供一种算机可读存储介质,其上存储有计算机程序,所述计算机程序被处理器执行时实现如前述的超分辨率网络模型压缩方法的步骤。

本发明的积极进步效果在于:

本发明能够在不损失超分辨率模型的成像质量情况下,对超分辨率网络模型的卷积层和全连接层进行压缩,减少了模型参数,对于设备来说内存需求下降,其次降低了浮点运算次数,前向推理延迟降低,改善了模型的综合性能。

附图说明

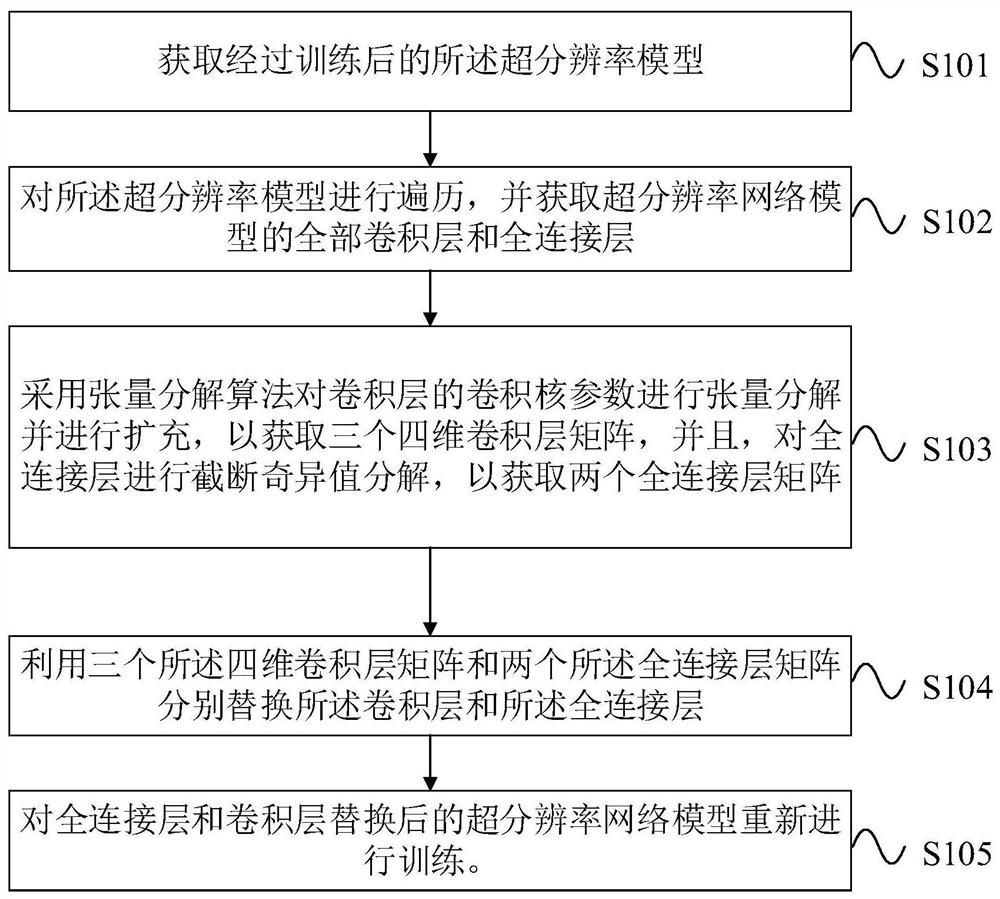

图1为本发明实施例1的超分辨率网络模型压缩方法的流程图;

图2为本发明实施例1中卷积层替换示意图;

图3为本发明实施例1中的步骤S103中对卷积层张量分解的流程图;

图4为本发明实施例1中三阶张量的张量分解示意图;

图5为本发明实施例1中的步骤S103中对全连接层截断奇异值分解的流程图;

图6为本发明实施例1中截断奇异值分解的示意图;

图7为本发明实施例2的超分辨率网络模型压缩系统的的模块示意图;

图8为本发明实施例2的分解模块的模块示意图;

图9为本发明实施例2的获取模块的模块示意图;

图10为本发明实施例3的电子设备的结构示意图。

具体实施方式

下面通过实施例的方式进一步说明本发明,但并不因此将本发明限制在所述的实施例范围之中。

实施例1

如图1,图2所示,本实施例公开了超分辨率网络模型压缩方法,包括以下步骤:

步骤S101、获取经过训练后的所述超分辨率模型;

本实施例中模型是指模型是指深度网络模型,在超分辨率模型中一般指是基于卷积结构的网络模型,本实例使用的模型是EDSR(enhanced deep super-resolution,增强深度超分辨率网络)。该网络模型中包含16个残差块,其中每个残差块中包含两个卷积层,使用的训练数据集和测试数据集是DIV2K,DIV2K数据集是一种用于图像复原任务的公开数据集。

步骤S102、对所述超分辨率模型进行遍历,并获取超分辨率网络模型的全部卷积层和全连接层。

步骤S103、采用张量分解算法对卷积层的卷积核参数进行张量分解并进行扩充,以获取三个四维卷积层矩阵,并且,对全连接层进行截断奇异值分解,以获取两个全连接层矩阵;

步骤S104、利用三个所述四维卷积层矩阵和三个所述全连接层矩阵分别替换所述卷积层和所述全连接层。

步骤S105、对全连接层和卷积层替换后的超分辨率网络模型重新进行训练。

本实施例中,待替换后的超分辨率网络模型重新训练好后训进行了测试。具体测试如下:输入模型的图片大小为(382,680),输出的图片尺寸为(764,1360),变换尺度为2,实验结果如下面表格所示,其中PSNR(Peak Signal to Noise Ratio,峰值信噪比)和SSIM(Structural Similarity,结构相似性)是两种对图片差异的评判指标,从实验结果可以得出以下结论,该发明的方法在模型精度损失几乎可以忽略不计,而原始模型参数降低了520%,运行时间加速比为116%,超分辨率模型的整体性能能得到了极大的提升,具体如下表:

如图3-图4所示,本实施例中,步骤S103中采用张量分解算法对所述卷积层的卷积核参数进行张量分解并进行扩充,以获取三个四维卷积层矩阵的步骤包括:

步骤S10311、提取卷积核的参数;

步骤S10312、根据卷积层表达式,将卷积核的参数转换为四维的第一卷积层矩阵;

本实施例中,卷积核W∈R

w={1,2,…,L}

其中(i,j,k),(u,v,w),(a,b,k,w)分别是输入,输出,卷积核中元素的位置坐标,S是步长,输入为X∈R

步骤S10313、将所述四维的第一卷积层矩阵沿着输入通道和输出通道两个轴方向进行展开,以获取两个二维的第二卷积层矩阵;

本步骤中,将四维的卷积核W沿着输入通道和输出通道两个轴方向进行展开,得到两个二维矩阵M∈R

步骤S10314、获取两个二维的所述第二卷积层矩阵的秩;其中,两个矩阵的秩分别表示为σ

步骤S10315、判断两个所述第二卷积层矩阵的秩是否大于预设阈值,若是,则执行步骤S1036;若否,则执行步骤S1037;本实施例中预设阈值为D/10,若σ

步骤S10316、采用张量分解将两个二维的所述第二卷积层矩阵进行分解,以获取两个二维的第三卷积层矩阵和一个四维的卷积层矩阵,并对两个二维的所述第三卷积层矩阵进行扩充,以获取三个四维卷积层矩阵。

本实施例中,利用张量分解将张量W进行分解为三个矩阵first,core,last,其中first=[D,σ

步骤S10317、直接将该层卷积网络删除。

如图5,图6所示,本实施例中,步骤S103中对全连接层进行截断奇异值分解,以获取两个全连接层矩阵的步骤包括:

步骤S10321、获取所述全连接层的参数矩阵;全连接层的表达式如下:

Y=AX+B

其中,A代表全连接层的参数矩阵,B是偏置,X代表该层的输入,Y代表该层的输出。

步骤S10322、对所述全连接层的参数矩阵进行奇异值分解,以获取第一对角矩阵、第一左奇异矩阵、第一右奇异矩阵;

本步骤中,对矩阵A进行SVD分解可以得到如下公式的结果:

S

步骤S10323、将第一对角矩阵、第一左奇异矩阵、第一右奇异矩阵进行截断,以获取第二对角矩阵、第二左奇异矩阵、第二右奇异矩阵,并且,对所述第二对角矩阵和所述第二右奇异矩阵进行相乘运算,以获得两个全连接层矩阵。

本步骤中,用矩阵U

Y′=HX

Y=U

本实施公开了一种超分辨率网络模型压缩方法,通过采用张量分解算法对超分辨率网络模型的卷积层的卷积核参数进行张量分解和扩充得到三个四维卷积层矩阵,并对对全连接层进行截断奇异值分解,以获取三个全连接层矩阵;利用三个四维卷积层矩阵和三个全连接层矩阵分别替换卷积层和全连接层。相较于现有技术,本发明能够在不损失超分辨率模型的成像质量情况下,对超分辨率网络模型的卷积层和全连接层进行压缩,减少了模型参数,对于设备来说内存需求下降,其次降低了浮点运算次数,前向推理延迟降低,改善了模型的综合性能。

实施例2

如图7所示,本实施例公开了一种超分辨率网络模型压缩系统,包括:

获取模块1,用于获取超分辨率网络模型的卷积层和全连接层;

分解模块2,用于采用张量分解算法对所述卷积层的卷积核参数进行张量分解并进行扩充,以获取三个四维卷积层矩阵,并且,对全连接层进行截断奇异值分解,以获取两个全连接层矩阵;

替换模块3,用于利用三个所述四维卷积层矩阵和三个所述全连接层矩阵分别替换所述卷积层和所述全连接层。

本实施例中,待替换后的超分辨率网络模型重新训练好后训进行了测试。具体测试如下:输入模型的图片大小为(382,680),输出的图片尺寸为(764,1360),变换尺度为2,实验结果如下面表格所示,其中PSNR(Peak Signal to Noise Ratio,峰值信噪比)和SSIM(Structural Similarity,结构相似性)是两种对图片差异的评判指标,从实验结果可以得出以下结论,该发明的方法在模型精度损失几乎可以忽略不计,而原始模型参数降低了520%,运行时间加速比为116%,超分辨率模型的整体性能能得到了极大的提升,具体如下表:

如图8所示,本实施例中分解模块2包括:

提取单元21,用于提取卷积核的参数;

转换单元22,用于据卷积层表达式,将卷积核的参数转换为四维的第一卷积层矩阵;

本实施例中,卷积核W∈R

w={1,2,…,L}

其中(i,j,k),(u,v,w),(a,b,k,w)分别是输入,输出,卷积核中元素的位置坐标,S是步长,输入为X∈R

展开单元23,用于将所述四维的第一卷积层矩阵沿着输入通道和输出通道两个轴方向进行展开,以获取两个二维的第二卷积层矩阵;

本步骤中,将四维的卷积核W沿着输入通道和输出通道两个轴方向进行展开,得到两个二维矩阵M∈R

第一获取单元24,用于获取两个二维的所述第二卷积层矩阵的秩;其中,两个矩阵的秩分别表示为σ

判断单元25,用于判断两个所述第二卷积层矩阵的秩是否大于预设阈值,若是,则采用张量分解将两个二维的所述第二卷积层矩阵进行分解,以获取两个二维的第三卷积层矩阵和一个四维的卷积层矩阵,并对两个二维的所述第三卷积层矩阵进行扩充,以获取三个四维卷积层矩阵。

本实施例中,利用张量分解将张量W进行分解为三个矩阵first,core,last,其中first=[D,σ

步骤S10317、直接将该层卷积网络删除。

第二获取单元26,用于获取所述全连接层的参数矩阵;

全连接层的表达式如下:

Y=AX+B

其中,A代表全连接层的参数矩阵,B是偏置,X代表该层的输入,Y代表该层的输出。

奇异值分解单元27,用于对所述全连接层的参数矩阵进行奇异值分解,以获取第一对角矩阵、第一左奇异矩阵、第一右奇异矩阵;

本步骤中,对矩阵A进行SVD分解可以得到如下公式的结果:

S

截断单元28,用于将第一对角矩阵、第一左奇异矩阵、第一右奇异矩阵进行截断,以获取第二对角矩阵、第二左奇异矩阵、第二右奇异矩阵,并且,对所述第二对角矩阵和所述第二右奇异矩阵进行相乘运算,以获得两个全连接层矩阵。本步骤中,用矩阵U

Y′=HX

Y=U

第三获取单元11,用于获取经过训练后的所述超分辨率模型;

本实施例中模型是指模型是指深度网络模型,在超分辨率模型中一般指是基于卷积结构的网络模型,本实例使用的模型是EDSR(enhanced deep super-resolution,增强深度超分辨率网络)。该网络模型中包含16个残差块,其中每个残差块中包含两个卷积层,使用的训练数据集和测试数据集是DIV2K,DIV2K数据集是一种用于图像复原任务的公开数据集。

第四获取单元12,对所述超分辨率模型进行遍历,并获取超分辨率网络模型的全部卷积层和全连接层。

本实施公开了一种超分辨率网络模型压缩系统,通过采用张量分解算法对超分辨率网络模型的卷积层的卷积核参数进行张量分解和扩充得到三个四维卷积层矩阵,并对对全连接层进行截断奇异值分解,以获取两个全连接层矩阵;利用三个四维卷积层矩阵和两个全连接层矩阵分别替换卷积层和全连接层。相较于现有技术,本发明能够在不损失超分辨率模型的成像质量情况下,对超分辨率网络模型的卷积层和全连接层进行压缩,减少了模型参数,对于设备来说内存需求下降,其次降低了浮点运算次数,前向推理延迟降低,改善了模型的综合性能。

实施例3

图10为本发明实施例3提供的一种电子设备的结构示意图。所述电子设备包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现实施例1所提供的超分辨率网络模型压缩方法。图10显示的电子设备30仅仅是一个示例,不应对本发明实施例的功能和使用范围带来任何限制。

如图10所示,电子设备30可以以通用计算设备的形式表现,例如其可以为服务器设备。电子设备30的组件可以包括但不限于:上述至少一个处理器31、上述至少一个存储器32、连接不同系统组件(包括存储器32和处理器31)的总线33。

总线33包括数据总线、地址总线和控制总线。

存储器32可以包括易失性存储器,例如随机存取存储器(RAM)321和/或高速缓存存储器322,还可以进一步包括只读存储器(ROM)323。

存储器32还可以包括具有一组(至少一个)程序模块324的程序/实用工具325,这样的程序模块324包括但不限于:操作系统、一个或者多个应用程序、其它程序模块以及程序数据,这些示例中的每一个或某种组合中可能包括网络环境的实现。

处理器31通过运行存储在存储器32中的计算机程序,从而执行各种功能应用以及数据处理,例如本发明实施例1所提供的超分辨率网络模型压缩方法。

电子设备30也可以与一个或多个外部设备34(例如键盘、指向设备等)通信。这种通信可以通过输入/输出(I/O)接口35进行。并且,模型生成的设备30还可以通过网络适配器36与一个或者多个网络(例如局域网(LAN),广域网(WAN)和/或公共网络,例如因特网)通信。如图所示,网络适配器36通过总线33与模型生成的设备30的其它模块通信。应当明白,尽管图中未示出,可以结合模型生成的设备30使用其它硬件和/或软件模块,包括但不限于:微代码、设备驱动器、冗余处理器、外部磁盘驱动阵列、RAID(磁盘阵列)系统、磁带驱动器以及数据备份存储系统等。

应当注意,尽管在上文详细描述中提及了电子设备的若干单元/模块或子单元/模块,但是这种划分仅仅是示例性的并非强制性的。实际上,根据本发明的实施方式,上文描述的两个或更多单元/模块的特征和功能可以在一个单元/模块中具体化。反之,上文描述的一个单元/模块的特征和功能可以进一步划分为由多个单元/模块来具体化。

实施例4

本实施例提供了一种计算机可读存储介质,其上存储有计算机程序,所述程序被处理器执行时实现实施例1所提供的超分辨率网络模型压缩方法的步骤。

其中,可读存储介质可以采用的更具体可以包括但不限于:便携式盘、硬盘、随机存取存储器、只读存储器、可擦拭可编程只读存储器、光存储器件、磁存储器件或上述的任意合适的组合。

在可能的实施方式中,本发明还可以实现为一种程序产品的形式,其包括程序代码,当所述程序产品在终端设备上运行时,所述程序代码用于使所述终端设备执行实现实施例1所提供的超分辨率网络模型压缩方法中的步骤。

其中,可以以一种或多种程序设计语言的任意组合来编写用于执行本发明的程序代码,所述程序代码可以完全地在用户设备上执行、部分地在用户设备上执行、作为一个独立的软件包执行、部分在用户设备上部分在远程设备上执行或完全在远程设备上执行。

虽然以上描述了本发明的具体实施方式,但是本领域的技术人员应当理解,这仅是举例说明,本发明的保护范围是由所附权利要求书限定的。本领域的技术人员在不背离本发明的原理和实质的前提下,可以对这些实施方式做出多种变更或修改,但这些变更和修改均落入本发明的保护范围。

- 超分辨率网络模型压缩方法、系统、设备和介质

- 神经网络模型压缩方法、系统、设备及介质