基于ERNIE模型和DCNN模型的还款预测方法

文献发布时间:2023-06-19 09:30:39

技术领域

本申请涉及自然语言处理技术领域,特别涉及一种基于ERNIE模型和DCNN模型的还款预测方法、装置、设备及可读存储介质。

背景技术

随着信用卡业务的规模的不断扩大和借贷人群的不断下沉,信用卡贷后催收业务面临着新的挑战。

传统催收预测模型采用的数据为用户的申请资料或当前贷后还款信息,基于这些数据预测过程包括:对当前申请资料信息进行预处理,得到当前资料信息的目标自变量特征信息;对此信息采用算法模型搭建,然后通过大量的数据训练得到催收预测模型,从而达到提高预测精度的目的。但是,该方案没有有效利用对用户电话沟通过程中产生的大量语音数据,在催收过程中用户的语音数据是真实且宝贵的,能够为催收预测提供诸多有价值的信息,而这些信息是申请资料和贷后还款信息无法提供的。

随着机器学习和深度学习的快速发展,从大规模的对话数据中学到有用信息成为可能。文本分类作为自然语言处理的一个重要分支,在近几年里得到了快速发展,目前一般通过深度学习进行文本分类,基于深度学习的文本分类效果的好坏取决于对如何更好地提取出数据的潜在语义信息特征。传统的机器学习通过one-hot编码、TFIDF、LDA、LSA等算法提取数据潜在信息,但是这些算法存在维度灾难的问题,而word2vec、glove、fasttext等词向量模型虽然有着各自的优点,但是却也存在依赖于输入数据的质量与数量大小,对于不同领域的知识仍然存在需要重新进行训练才能再次使用的尴尬处境。

使用大规模语料库训练出预训练模型,然后针对不同任务再来对预训练模型进行微调的方式有效解决了上述问题,其典型代表就是BERT(Bidirectional EncoderRepresentation from Transformers)模型及其泛化模型。而为了进一步提高分类任务的效果,使用BERT-CNN(Convolutional Neural Networks)模型是一种非常不错的解决方案。但是,该方案至少存在以下两个缺陷:

(1)BERT模型在进行掩码过程中仅仅从字层面进行掩码,没有考虑到词之间存在的相关性,对语言模型联合概率存在偏差估计,同时存在预训练过程和生成过程存在不一致的情况,从而会导致预测精度较差。

(2)CNN模型的卷积层的操作会使句子的长度变短,导致边缘信息丢失,且CNN模型池化层的操作会打乱句子的顺序。

综上,如何充分利用电话催收过程中生成的语音数据,提升催收预测精度,并克服前述方案的缺陷,是亟待本领域技术人员解决的问题。

发明内容

本申请的目的是提供一种基于ERNIE模型和DCNN模型的还款预测方法、装置、设备及可读存储介质,用以解决当前的催收预测方案没有充分利用电话催收过程中的语音数据,导致预测精度较低的问题。其具体方案如下:

第一方面,本申请提供了一种基于ERNIE模型和DCNN模型的还款预测方法,包括:

利用文本数据集对ERNIE模型进行预训练;

将预训练后的ERNIE模型与DCNN模型进行层级连接,得到还款预测模型;

获取电话催收过程中生成的语音数据,采用ASR技术将所述语音数据转换为文本数据,并添加标签,得到训练样本;

利用所述训练样本,对所述还款预测模型进行训练;

将待测语音数据对应的文本数据输入训练完成的还款预测模型,得到预测结果。

优选的,在所述采用ASR技术将所述语音数据转换为文本数据之后,还包括:

利用kenLM纠错模块或pycorrect纠错模块对所述文本数据进行纠错。

优选的,所述利用文本数据集对ERNIE模型进行预训练,包括:

根据文本数据集和多种掩码策略,构造训练集,所述多种掩码策略包括字掩码策略、词掩码策略、实体掩码策略、随机掩码策略;

利用所述训练集对所述ERNIE模型进行预训练。

优选的,所述多种掩码策略还包括句子掩码策略,所述句子掩码策略为:对于目标句子,随机选择起始位置进行掩码,掩码比例不超过所述目标句子句长的预设比例。

优选的,所述将待测语音数据对应的文本数据输入训练完成的还款预测模型,得到预测结果,包括:

将待测语音数据对应的文本数据输入训练完成的还款预测模型的ERNIE模型,得到语义表示;

将所述语义表示输入训练完成的还款预测模型的DCNN模型,得到预测结果。

优选的,所述DCNN模型包括宽卷积层、动态池化层、Folding层、全连接层,所述将所述语义表示输入训练完成的还款预测模型的DCNN模型,得到预测结果,包括:

利用宽卷积层对所述输入语义层表示进行卷积操作,提取完整句子信息,得到卷积结果,其中所述完整句子信息包括句首信息和句尾信息;

利用动态池化层对所述卷积结果进行池化操作,得到池化结果;

利用Folding层对所述池化结果进行降维,得到降维结果;

利用全连接层将所述降维结果确定预测结果。

优选的,所述ERNIE模型包括文本编码器和知识型编码器,所述将待测语音数据对应的文本数据输入训练完成的还款预测模型的ERNIE模型,得到语义表示,包括:

利用文本编码器根据所述文本数据生成文本信息,所述文本信息词法信息和句法信息;

利用知识型编码器将所述文本数据的知识信息整合到所述文本信息,得到语义表示。

第二方面,本申请提供了一种基于ERNIE模型和DCNN模型的还款预测装置,包括:

预训练模块:用于利用文本数据集对ERNIE模型进行预训练;

模型构建模块:用于将预训练后的ERNIE模型与DCNN模型进行层级连接,得到还款预测模型;

训练样本生成模块:用于获取电话催收过程中生成的语音数据,采用ASR技术将所述语音数据转换为文本数据,并添加标签,得到训练样本;

模型训练模块:用于利用所述训练样本,对所述还款预测模型进行训练;

预测模块:用于将待测语音数据对应的文本数据输入训练完成的还款预测模型,得到预测结果。

第三方面,本申请提供了一种基于ERNIE模型和DCNN模型的还款预测设备,包括:

存储器:用于存储计算机程序;

处理器:用于执行所述计算机程序,以实现如上所述的基于ERNIE模型和DCNN模型的还款预测方法。

第四方面,本申请提供了一种可读存储介质,所述可读存储介质上存储有计算机程序,所述计算机程序被处理器执行时用于实现如上所述的基于ERNIE模型和DCNN模型的还款预测方法。

本申请所提供的一种基于ERNIE模型和DCNN模型的还款预测方法,包括:利用文本数据集对ERNIE模型进行预训练;将预训练后的ERNIE模型与DCNN模型进行层级连接,得到还款预测模型;获取电话催收过程中生成的语音数据,采用ASR技术将语音数据转换为文本数据,并添加标签,得到训练样本;利用训练样本,对还款预测模型进行训练;将待测语音数据对应的文本数据输入训练完成的还款预测模型,得到预测结果。

可见,该方法充分利用电话催收过程中生成的语音数据,并利用预训练后的ERNIE模型生成语音数据的语义表示,最终利用DCNN模型根据该语义表示确定预测结果。由于ERNIE模型在预训练过程中采用字掩码、词掩码、实体掩码和随机掩码四种级别的掩码策略,因此能够学习到字层面、词层面、实体层面等知识信息,使得模型能够更好的捕捉到语义信息,输出高参考价值的语义表示。DCNN模型的宽卷积会使句子的长度增加,避免边缘信息丢失,且DCNN模型的动态池化层,能够保留原来序列的次序,从不同长度的句子中提取出相应数量的语义特征信息,显著提升还款预测的准确性和可靠性。

此外,本申请还提供了一种基于ERNIE模型和DCNN模型的还款预测装置、设备及可读存储介质,其技术效果与上述方法相对应,这里不再赘述。

附图说明

为了更清楚的说明本申请实施例或现有技术的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单的介绍,显而易见地,下面描述中的附图仅仅是本申请的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

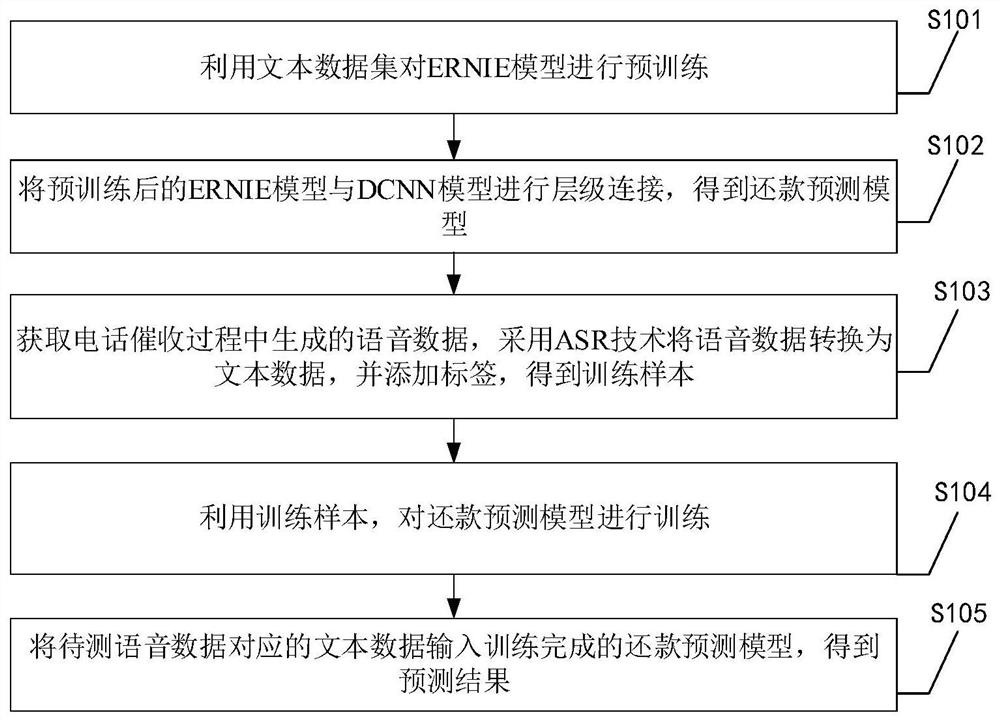

图1为本申请所提供的基于ERNIE模型和DCNN模型的还款预测方法实施例一的实现流程图;

图2为本申请所提供的基于ERNIE模型和DCNN模型的还款预测方法实施例一的S105的细化流程图;

图3为ERNIE模型的结构图;

图4为ERNIE+DCNN模型的内部结构图;

图5为本申请所提供的基于ERNIE模型和DCNN模型的还款预测装置实施例的功能框图。

具体实施方式

本申请的核心是提供一种基于ERNIE模型和DCNN模型的还款预测方法、装置、设备及可读存储介质,有效利用电话催收过程中生成的语音数据,并利用预训练后的ERNIE模型生成语音数据的语义表示,最终利用DCNN模型根据该语义表示确定预测结果,显著提升还款预测准确性。

为了使本技术领域的人员更好地理解本申请方案,下面结合附图和具体实施方式对本申请作进一步的详细说明。显然,所描述的实施例仅仅是本申请一部分实施例,而不是全部的实施例。基于本申请中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本申请保护的范围。

下面对本申请提供的一种基于ERNIE模型和DCNN模型的还款预测方法实施例一进行介绍,参见图1,实施例一包括:

S101、利用文本数据集对ERNIE模型进行预训练;

ERNIE是一种基于知识遮蔽策略的、增强型的语义表示模型。通过对字、词、实体等语义单元的掩码,使得模型学习完整概念的语义表示。ERNIE在结构上主要分为两个部分,Transformer编码和知识整合,前者使用Transformer作为模型的基本编码器,生成对应的词向量表示,以此保留词在文本中的上下文信息。后者则是通过多阶段的知识遮蔽策略,将短语和实体层次的知识整合到语言表示中。

本实施例通过过网上公开的中文文本数据和已有的文本数据对ERNIE模型进行预训练,得到预训练的ERNIE模型与其所有初始化参数。具体的,根据文本数据集和多种掩码策略,构造训练集,多种掩码策略包括字掩码策略、词掩码策略、实体掩码策略、随机掩码策略;然后利用训练集对ERNIE模型进行预训练。

预训练后的ERNIE模型能够有效捕捉文本数据的语音信息,方便后续进行还款预测。

S102、将预训练后的ERNIE模型与DCNN模型进行层级连接,得到还款预测模型;

将ERNIE模型与DCNN模型进行层级连接,得到全新的ERNIE+DCNN的组合模型,本实施例将其称为还款预测模型。实际预测过程中,数据首先进入ERNIE模型中,以ERNIE模型的输出作为输入进入至DCNN模型中,最终得到预测结果。

S103、获取电话催收过程中生成的语音数据,采用ASR技术将语音数据转换为文本数据,并添加标签,得到训练样本;

本申请的模型用于预测用户是否还款,因此,标签可以分为两类:是(还款)、否(不还款)。

由于ERNIE的词表中包括各种标点符号,所以不需要对上述文本数据进行去标点等操作。且由于模型从字层级进行分析,所有也不需要进行分词操作。此处主要是对数据进行划分,将数据按比例划分为训练集、验证集和测试集。为简化描述,本实施例仅对训练集进行介绍。

因为本次预测主要是对用户的行为预测,所以更关心用户的语音数据。但是,在实际应用中,客服的语音数据也具备一定参考价值,所以可以将客服的语音数据一并考虑进来。

S104、利用训练样本,对还款预测模型进行训练;

训练开始之前,对ERNIE模型与DCNN模型的参数分别进行初始化。其中,ERNIE的参数初始化为之前预训练得到的参数;DCNN模型的参数则进行随机初始化,且其数值符合标准正态分布。

此外,训练开始之前还需要设置训练终止条件,学习率等信息。

S105、将待测语音数据对应的文本数据输入训练完成的还款预测模型,得到预测结果。

作为一种优选的实施方式,为了提升文本数据的参考价值,在将语音数据转换为文本数据之后,还包括:利用kenLM纠错模块或pycorrect纠错模块对文本数据进行纠错。

在实际应用中,如图2所示,S105具体包括:

S201、将待测语音数据对应的文本数据输入训练完成的还款预测模型的ERNIE模型,得到语义表示;

S202、将语义表示输入训练完成的还款预测模型的DCNN模型,得到预测结果。

在具体实施例中,S202包括:利用宽卷积层对输入语义层表示进行卷积操作,提取完整句子信息,得到卷积结果,其中完整句子信息包括句首信息和句尾信息;利用动态池化层对卷积结果进行池化操作,得到池化结果;利用Folding层对池化结果进行降维,得到降维结果;利用全连接层将降维结果确定预测结果。

在具体实施例中,S201包括:利用文本编码器根据文本数据生成文本信息,文本信息词法信息和句法信息;利用知识型编码器将文本数据的知识信息整合到文本信息,得到语义表示。

本实施例所提供一种基于ERNIE模型和DCNN模型的还款预测方法,充分利用电话催收过程中生成的语音数据,并利用预训练后的ERNIE模型生成语音数据的语义表示,最终利用DCNN模型根据该语义表示确定预测结果。具备至少以下三个优点:

1、在ERNIE模型的预训练过程中,在进行掩码操作时,不仅从字层面进行掩码操作,也从词层面和实体层面进行掩码操作,从而避免训练的语言模型联合概率存在偏差的情况。

2、在构建模型的层面上,考虑引入知识图谱信息,结合知识图谱的多信息实体来作为外部知识改善模型的语言特征,进一步融合知识编码和异质信息。

3、不同于CNN模型的卷积层和池化层的操作方式,DCNN模型避免卷积操作边缘信息丢失和在池化操作打乱语句顺序的情况。

下面开始详细介绍本申请提供的一种基于ERNIE模型和DCNN模型的还款预测方法实施例二。

第一步,通过wiki百科、今日头条、THUCNews和自有的文本数据集,对ERNIE模型进行预训练。

在预训练ERNIE模型时,大致可分为两个部分:一是构造训练集;二是使用构造好的训练集训练ERNIE模型。

其中,构造训练集的具体实施步骤包括:将文本数据集按句子划分,对句子使用词法分析工具对数据进行字、词、实体等不同粒度的切分,然后对切分的数据进行token化处理,得到明文的token序列及切分边界,然后通过词表进行映射成id数据,其中序列化的token数据包括五个部分,每个部分以分号隔开:

(1)token_ids:输入句子对的表示。

(2)sentence_type_ids:0或1表示token属于哪一个句子。

(3)position_ids:绝对位置编码。

(4)seg_labels:表示分词边界信息,0表示词首,1表示非词首,-1表示占位符。

(5)next_sentence_label:表示该句子是否存在上下句的关系(0表示没有,1表示有)。

随机将句子的15%的词进行掩码,而其中这15%词中的80%词会用[mask]代替,10%随机用其他词代替,最后剩余的10%仍然使用原本的词,不进行替换。并且在其实位置拼接[cls],使用这种方式构造出全新的句子来训练ERNIE模型来预测这被遮住的15%的词。在预训练阶段引入先验知识,引入4种掩码策略预测:

(1)Basic-Level Masking:从单个字级别来说,对单字进行掩码,但无法获取高层次语义。即前文所述的字掩码策略。

(2)Phrase-Level Masking:输入仍然是单字级别的,掩码连续短语。即前文所述的词掩码策略。

(3)Entity-Level Masking:首先进行实体识别,然后将识别出的实体进行掩码。即前文所述的实体掩码策略。

(4)Span Masking:首先计算出句子的长度,然后随机选择span的起始位置进行掩码,掩码比例不超过句子长度的20%。即前文所述的句子掩码策略。

通过上述步骤进行ERNIE模型的预训练,将最后模型的参数保留下来,用于对还款预测模型中的ERNIE模型进行参数初始化。

第二步,使用ERNIE模型与DCNN模型进行层级连接,得到还款预测模型。

本实施例中,ERNIE模型包括但不仅限于12层transformer编码器、768个隐藏层和12个自注意力头(self-attention heads)。transformer的核心部件是多头的自注意力机制,8个自注意力头通过拼接的方式进行组合。DCNN模型的主要包括one-dim宽卷积层、dynamic k-max pooling(动态topK池化层)、Folding层和全连接层。

具体的,上述层级连接过程为:将ERNIE模型中的12层的每一层的最后一个位置的输出作为DCNN模型的输入,得到ERNIE-DCNN模型,其宽度为12的输入矩阵经过1x1矩阵和k-max-pooling(动态池化层)得到富含句子语义信息的特征向量,并在这个向量后加入全连接层(full connect layer),最后再经过分类器。

第三步,从Mysql数据库提取催收电话中生成的客服语音数据和用户语音数据,并将两者按次序进行合并。采用ASR技术将语音数据转换为文本数据,通过kenLM纠错模块完成纠错流程,得到正常流场的语音通话中的文本数据。

纠错模块分为错误检测、候选召回和打分排序。在错误检测方面使用未标注的无监督原始数据进行训练,同时利用字音混合特征缩小预测概率的分布。在候选召回方面,计算两者之间在同音、同型方面的编辑距离。并使用trie tree(字典树)来优化索引效率。在候选排序方面,加入基于kenLM的语言模型特预测语义特征,从而提高模型的判别能力。

第四步,初始化工作。

分别对ERNIE模型与DCNN模型进行参数初始化。

设置轮数(epoch)、学习率(learning rate)、批处理大小(batch size)等核心参数进行模型的训练,模型的评价指标主要为precision、call、f1值,并且当模型出现过拟合的情况则通过设置的early stopping提前终止训练任务。

第五步,训练还款预测模型。

具体的训练步骤为:通过输入句子+标签,本实施例的标签分为两种,0和1。利用random库打乱数据,sklearn库将数据按0.64:0.16:0.2比例分为训练集、验证集和测试集。将训练集的数据丢至模型中进行训练,并将其与验证集的模型效果进行比较,当模型轮数达到指定轮数或是两者之间的验证指标相差指定值时,模型便停止训练。并使用训练好的模型对验证集数据进行测试,与真实指标进行对比,得到模型的效果。

还款预测模型的主要的相关参数如下所示:

hidden_sizez:768

num_hidden_layers:12

num_attention_heads:12

hidden_act=’gelu’

hidden_dropout_prob:0.1

batch_size:128

pad_size:32

learning_rate:5e-5

第六步,利用训练完的还款预测模型进行真正的预测。

预测过程与训练过程类似,此部分不再展开介绍。

下面分别对ERNIE模型和DCNN模型的计算原理进行简要介绍。本实施例中,ERNIE模型的具体结构图如图3所示,ERNIE模型和DCNN模型拼接后的结构图如图4所示。

相较于BERT结构,ERNIE在结构上比BERT在提取文本特征上更加丰富。ERNIE模型的架构主要分为两个模块,一是底层的文本编码器(T-Encoder),负责获取输入token的词法和句法信息;二是上层的知识型编码器(K-Encoder),负责将额外的面向token的知识信息整合进来自底层的文本信息。

K-Encoder中的模型又称为aggregator,如图3的右边所示,其输入部分主要由两部分组成:底层T-Encoder的输出和transformer算法得到的文本中实体向量。

接着利用multi-head self-attention(MH-ATT)对文本和实体分别进行处理,将实体信息和文本信息进行融合。ERNIE模型会对文本进行提取特征,形成富含文本特征的矩阵向量,该矩阵向量会进入DCNN模型,作为其输入值。

DCNN模型能够捕捉长距离词语的语义信息。DCNN模型主要包括one-dim宽卷积层、dynamic k-max pooling(动态topK池化层)、Folding层和全连接层。下面分别对各个层进行介绍:

one-dim宽卷积层就是每一个维度,假设embedding的维度为300,那么就是300个dim,在图像任务中宽卷积层可以更有效地提取图边角信息,而在NLP任务中也是一样有效的,这样的方式可以更加有效地提取句首和句尾信息。

max pooling(最大池化)层就是对所有卷积求平均值,而dynamic k-max pooling就是选择最大的k个数。根据网络结构和预先设定的k值,通过公式动态地选择k值,通常来说可以预先设置在每层的最小k值(通常为3,4,5)。

Fold层通过数学计算将d维的矩阵映射到d/2维,减少计算量并加快计算速度。

全连接层即为普通CNN模型的一样,对当前层所有的节点相连计算,整合前面提取的各个特征空间上的文本特征计算各个分类标签下的概率值。

可见,本实施例提供的一种基于ERNIE模型和DCNN模型的还款预测方法,采用ERNIE与DCNN联合模型完成预测还款模型的分类任务,经过预训练过的ERNIE模型,将知识图谱的结构化信息融入至模型中,使其能够更好地对真实世界进行语义建模,不只是机械化地学习语言的合理性,而且还能够学习到语言之前的语义联系。而DCNN模型使用宽卷积层和动态的k-max pooling层能够进一步地进行特征融合,并且可以同时提取多个关键信息,确保能够充分提取句子信息。

综上,相较于基于BERT-CNN的还款预测方案,本实施例至少具有以下优势:

1、ERNIE模型相对于BERT模型具有明显优势。

(1)ERNIE采取的掩码机制结合了字、词与实体三者的信息,并采用随机掩码的方式增加模型的健壮性,捕捉更好的语义信息,而BERT仅在字层级进行掩码。

(2)ERNIE模型结合了知识图谱中的多信息实体来作为外部知识改善语言特征,模型通过采用TransE知识嵌入算法将编码后的知识信息整合到语义信息中,有利于结构化知识编码和异质信息融合。

(3)为了将抽取知识信息与训练语言模型,ERNIE在BERT结构的基础上加上了k-Encoder,实现了知识信息与token原始语义的融合设计出全新的预训练任务。

(4)从输入数据来说,ERNIE不仅考虑了纯文本信息,还提取了句子中的实体信息,并将其嵌入至向量中,且通过词法分析工具从字、词、实体不同角度进行切分。

2、DCNN模型相对于CNN模型具有明显优势。

不同于CNN模型中的普通卷积层与普通池化层,DCNN模型由宽卷积层与动态k-max池化层构成。

传统的卷积操作往往会使卷积后的句子长度变短(L–w+1,L为句子长度,w为卷积核尺寸),而DCNN的宽卷积会使句子的长度增加为(L+w+1),因为宽卷积的窗口并不需要覆盖输入值,没有值的部分用0值填充,这种卷积的好处在于边缘信息不会丢失。

传统的池化层一般为最大池化层或平均池化层。而DCNN模型采用动态的k-max池化层,即选择序列p中前k个最大值,并且保留原来序列的次序。k-max pooling的好处在于可以选取句子中不止一个的重要信息,并且保留了其相对的次序。

3、相对于BERT-CNN模型,从数据层面也是不同的。由于本模型的数据来源是语音数据,而得到的文本数据也是将语音数据由ASR技术翻译所得到的,而ASR技术在将语音转为文字的过程中不可避免的会存在一定的转换错误。所以需要将ASR模块之后,还款预测模型之前,加入一个纠错模块对文本数据进行纠错,以提高输入模型的文本质量。

下面对本申请实施例提供的一种基于ERNIE模型和DCNN模型的还款预测装置进行介绍,下文描述的基于ERNIE模型和DCNN模型的还款预测装置与上文描述的基于ERNIE模型和DCNN模型的还款预测方法可相互对应参照。

如图5所示,本实施例的基于ERNIE模型和DCNN模型的还款预测装置,包括:

预训练模块501:用于利用文本数据集对ERNIE模型进行预训练;

模型构建模块502:用于将预训练后的ERNIE模型与DCNN模型进行层级连接,得到还款预测模型;

训练样本生成模块503:用于获取电话催收过程中生成的语音数据,采用ASR技术将语音数据转换为文本数据,并添加标签,得到训练样本;

模型训练模块504:用于利用训练样本,对还款预测模型进行训练;

预测模块505:用于将待测语音数据对应的文本数据输入训练完成的还款预测模型,得到预测结果。

本实施例的基于ERNIE模型和DCNN模型的还款预测装置用于实现前述的基于ERNIE模型和DCNN模型的还款预测方法,因此该装置中的具体实施方式可见前文中的基于ERNIE模型和DCNN模型的还款预测方法的实施例部分,例如,预训练模块501,模型构建模块502,训练样本生成模块503,模型训练模块504,预测模块505,分别用于实现上述基于ERNIE模型和DCNN模型的还款预测方法中步骤S101,S102,S103,S104,S105。所以,其具体实施方式可以参照相应的各个部分实施例的描述,在此不再展开介绍。

另外,由于本实施例的基于ERNIE模型和DCNN模型的还款预测装置用于实现前述的基于ERNIE模型和DCNN模型的还款预测方法,因此其作用与上述方法的作用相对应,这里不再赘述。

此外,本申请还提供了一种基于ERNIE模型和DCNN模型的还款预测设备,包括:

存储器:用于存储计算机程序;

处理器:用于执行所述计算机程序,以实现如上文所述的基于ERNIE模型和DCNN模型的还款预测方法。

最后,本申请提供了一种可读存储介质,可读存储介质上存储有计算机程序,计算机程序被处理器执行时用于实现如上文所述的基于ERNIE模型和DCNN模型的还款预测方法。

本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其它实施例的不同之处,各个实施例之间相同或相似部分互相参见即可。对于实施例公开的装置而言,由于其与实施例公开的方法相对应,所以描述的比较简单,相关之处参见方法部分说明即可。

结合本文中所公开的实施例描述的方法或算法的步骤可以直接用硬件、处理器执行的软件模块,或者二者的结合来实施。软件模块可以置于随机存储器(RAM)、内存、只读存储器(ROM)、电可编程ROM、电可擦除可编程ROM、寄存器、硬盘、可移动磁盘、CD-ROM、或技术领域内所公知的任意其它形式的存储介质中。

以上对本申请所提供的方案进行了详细介绍,本文中应用了具体个例对本申请的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本申请的方法及其核心思想;同时,对于本领域的一般技术人员,依据本申请的思想,在具体实施方式及应用范围上均会有改变之处,综上所述,本说明书内容不应理解为对本申请的限制。

- 基于ERNIE模型和DCNN模型的还款预测方法

- 一种基于DCNN模型的矿井机械设备的剩余寿命预测方法