一种人脸特征码的跨模型转换系统及方法

文献发布时间:2023-06-19 10:16:30

技术领域

本发明属于人脸识别的技术领域,具体涉及一种人脸特征码的跨模型转换系统及方法。

背景技术

计算机机器视觉中的人脸识别技术被大量的应用于考勤,安防,视频监控,身份认证等众多领域,是计算机机器视觉技术应用最为广泛的技术之一。人脸识别技术的核心之一是提取人脸图像的特征码,作为核心技术,不同的算法公司一般都会训练独有的人脸识别模型来提取特征码。

然而,不同的算法模型之间由于训练数据,网络结构,优化方法之间的不同,导致即使同一张图像,如果由不同的算法模型来提取,得到的特征码也是不同的,无法通过常用的余弦相似度等方法来进行下游的人脸识别,对比等任务。

对于人脸识别系统使用者而言,如果需要替换或者更新人脸识别模型,就需要对系统底库中所有的注册人脸全部由新模型重新生成特征码,且历史记录中保存的特征码也无法再使用。这极大的限制了脸识别系统的灵活性和兼容性。因此,急需要提出一种高效,准确的方法,来对不同人脸识别模型生成的特征码进行相互转换。

发明内容

本发明的目的在于提供一种人脸特征码的跨模型转换系统,本发明同时利用了人脸图片和待转换特征码的信息,可以实现高精度的人脸特征码的跨模型转换,具有易于实施、计算精度高的特点。本发明的目的还在于提供一种人脸特征码的跨模型转换方法,旨在解决上述问题。

本发明主要通过以下技术方案实现:

一种人脸特征码的跨模型转换系统,包括图像训练模块、特征码训练模块、特征码提取模块、转换处理模块,所述图像训练模块用于将训练集中的人脸图像输入图像特征网络进行训练,并得到训练好的图像特征网络;所述特征码训练模块用于将训练集中的待转换特征码输入特征码转换网络进行训练,并得到训练好的特征码转换网络;

所述特征码提取模块用于将人脸图像、待转换码分别输入训练好的图像特征网络、特征码转换网络,并对应提取得到图像特征码、转换特征码;

所述转换处理模块用于将提取得到的图像特征码、转换特征码结合求平均值,然后进行正则化操作得到最终转换的特征码。

为了更好地实现本发明,进一步地,所述图像特征网络由从前至后依次设置的根部模块、若干个可重复模块以及特征提取模块构成;所述根部模块包括从前至后依次连接并封装的卷积层、批归一化层和激活层;所述可重复模块包括从前至后依次设置的卷积层、批归一化层、激活层、深度可分离卷积层、批归一化层、激活层、卷积层和批归一化层;所述特征提取模块包括从前至后依次连接并封装的全局平均池化层、全连接层、激活层和正则化层。

为了更好地实现本发明,进一步地,若可重复模块进行下采样,则可重复模块的尾端设置有空间注意力层;所述空间注意力层由从前至后依次连接并封装的第一卷积层、第二卷积层以及采用sigmoid激活函数的激活层生成。

为了更好地实现本发明,进一步地,所述空间注意力层的注意力映射函数的表达式如下:

其中:

sigmoid(·)为sigmoid激活函数,

为了更好地实现本发明,进一步地,所述空间注意力层的处理步骤如下:

步骤S100:输入特征张量并结合注意力映射函数求得一个与输入特征张量大小相同、且通道为1的注意力图;

步骤S200:将注意力图的结果与输入的特征张量进行元素乘,得到空间注意力层的输出结果,所述空间注意力层的输出结果的表达式如下:

其中,

步骤S300:将加权注意力特征张量沿通道方向上进行拼接,得到注意力层的输出张量,且表达式如下:

其中,

为了更好地实现本发明,进一步地,所述特征码转换网络由从前至后若干个顺序连接的可重复全连接单块以及正则化层构成;所述可重复全连接单块由若干个全连接基础模块顺序连接得到,所述全连接基础模块由从前至后依次连接并封装的全连接层、批归一化层、激活层构成。

为了更好地实现本发明,进一步地,所述可重复全连接单块采用残差连接的方式,将可重复全连接单块中最后一个全连接基础模块的输出与可重复全连接单块的输入按元素进行相加,以作为可重复全连接单块的输出。

为了更好地实现本发明,进一步地,所述可重复全连接单块中最后一个的全连接基础模块的输出作为可重复全连接单块的输出,以作为特征码转换网络的输出。

为了更好地实现本发明,进一步地,所述可重复全连接单块中设置有3个全连接基础模块;所述特征码转换网络中设置有6个可重复全连接单块。

为了更好地实现本发明,进一步地,所述转换处理模块将输出的图像特征码与转换特征码按元素进行求平均值,然后导入正则化模块进行L2正则化操作得到最终转换的特征码。

本发明主要通过以下技术方案实现:

一种人脸特征码的跨模型转换方法,采用上述的转换系统进行转换,包括以下步骤:

步骤S1:分别获取图像特征网络、特征码转换网络的训练集;

步骤S2:利用训练集并结合损失函数分别对图像特征网络、特征码转换网络进行训练;

步骤S3:然后将人脸图像输入训练后的图像特征网络得到图像特征码;将待转换特征码输入训练后的特征码转换网络得到转换特征码;

步骤S4:将步骤S3中处理得到的图像特征码与转换特征码结合求平均值,并进行正则化操作,得到最终转换的特征码。

为了更好地实现本发明,进一步地,所述图像特征网络的损失函数定义如下:

其中:

为了更好地实现本发明,进一步地,特征码转换网络的损失函数定义如下:

其中:

本发明构建两个神经网络模型,其中一个为图像特征网络,网络的输入为人脸图片,输出为图像特征码;另一个网络为特征码转换网络,输入为待转换特征码,输出为转换特征码。将两个网络的输出求均值,并进行正则化操作,得到最终的转换后的特征码。本发明同时利用了人脸图片和待转换特征码的信息,可以实现高精度的人脸特征码的跨模型转换,具有易于实施、计算精度高的特点。

本发明的有益效果:

(1)本发明同时利用了原始人脸图像和待转换特征码作为网络的输入,相比只利用待转换特征码,网络的输入信号更为丰富,有利于提升精度;

(2)本发明的图像特征网络,采用了的空间注意力结构,有利于使网络更关注于图像中对人脸特征贡献重要的区域,而不是背景等无关区域,有利于提升精度;

(3)本发明的特征码转换网络,采用了可重复堆叠的全连接层为主体构成的模块,计算量小,应用时耗时短,消耗的资源小;

(4)本发明利用了两个相互独立的网络分别处理原始人脸图像和待转换特征码,最后再将结果进行融合,相比较于单个网络,精度更高;

(5)本发明利用中的两个网络在训练时分别进行训练,模型更容易收敛,训练过程更加稳定。

附图说明

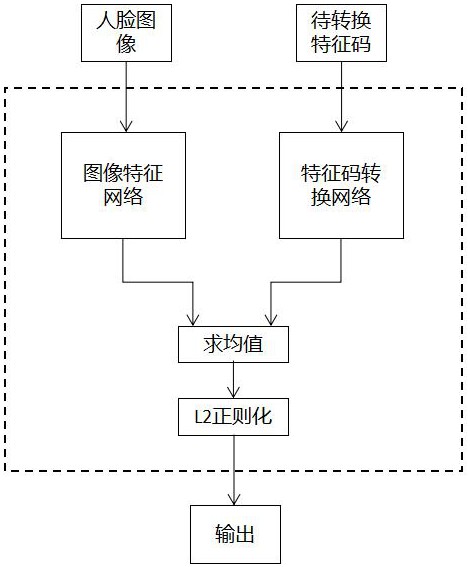

图1为本发明的原理示意图;

图2为图像特征网络的结构示意图;

图3为图像特征网络中根部模块的结构示意图;

图4为图像特征网络中不带空间注意力层的可重复模块的结构示意图;

图5为图像特征网络中带有空间注意力层的可重复模块的结构示意图;

图6为图像特征网络中空间注意力层的结构示意图;

图7为图像特征网络中特征提取模块的结构示意图;

图8为特征码转换网络的结构示意图;

图9为特征码转换网络中全连接基础模块的结构示意图;

图10为特征码转换网络中不使用残差连接的可重复全连接单块法结构示意图;

图11为特征码转换网络中使用残差连接的可重复全连接单块结构示意图。

具体实施方式

实施例1:

一种人脸特征码的跨模型转换系统,包括图像训练模块、特征码训练模块、特征码提取模块、转换处理模块,所述图像训练模块用于将训练集中的人脸图像输入图像特征网络进行训练,并得到训练好的图像特征网络;所述特征码训练模块用于将训练集中的待转换特征码输入特征码转换网络进行训练,并得到训练好的特征码转换网络。

如图1所示,所述特征码提取模块用于将人脸图像、待转换码分别输入训练好的图像特征网络、特征码转换网络,并对应提取得到图像特征码、转换特征码;

所述转换处理模块用于将提取得到的图像特征码、转换特征码结合求平均值,然后进行正则化操作得到最终转换的特征码。

进一步地,所述转换处理模块将输出的图像特征码与转换特征码按元素进行求平均值,然后导入正则化模块进行L2正则化操作得到最终转换的特征码。本发明同时利用了原始人脸图像和待转换特征码作为网络的输入,相比只利用待转换特征码,网络的输入信号更为丰富,有利于提升精度。本发明利用了两个相互独立的网络分别处理原始人脸图像和待转换特征码,最后再将结果进行融合,相比较于单个网络,精度更高。

本发明构建两个神经网络模型,其中一个为图像特征网络,网络的输入为人脸图片,输出为图像特征码;另一个网络为特征码转换网络,输入为待转换特征码,输出为转换特征码。将两个网络的输出求均值,并进行正则化操作,得到最终的转换后的特征码。本发明同时利用了人脸图片和待转换特征码的信息,可以实现高精度的人脸特征码的跨模型转换,具有易于实施、计算精度高的特点。

实施例2:

本实施例是在实施例1的基础上进行优化,如图2-图4所示,所述图像特征网络由从前至后依次设置的根部模块、若干个可重复模块以及特征提取模块构成;所述根部模块包括从前至后依次连接并封装的卷积层、批归一化层和激活层;所述可重复模块包括从前至后依次设置的卷积层、批归一化层、激活层、深度可分离卷积层、批归一化层、激活层、卷积层和批归一化层;如图7所示,所述特征提取模块包括从前至后依次连接并封装的全局平均池化层、全连接层、激活层和正则化层。

进一步地,如图5、图6所示,若可重复模块进行下采样,则可重复模块的尾端设置有空间注意力层;所述空间注意力层由从前至后依次连接并封装的第一卷积层、第二卷积层以及采用sigmoid激活函数的激活层生成。本发明的图像特征网络,采用了的空间注意力结构,有利于使网络更关注于图像中对人脸特征贡献重要的区域,而不是背景等无关区域,有利于提升精度。

进一步地,所述空间注意力层的注意力映射函数的表达式如下:

其中:

进一步地,所述空间注意力层的处理步骤如下:

步骤S100:输入特征张量并结合注意力映射函数求得一个与输入特征张量大小相同、且通道为1的注意力图;

步骤S200:将注意力图与输入的特征张量进行元素乘,将注意力图在通道方向上进行广播扩展,得到加权注意力特征张量,且表达式如下:

步骤S200:将注意力图的结果与输入的特征张量进行元素乘,得到空间注意力层的输出结果,所述空间注意力层的输出结果的表达式如下:

其中,

步骤S300:将加权注意力特征张量沿通道方向上进行拼接,得到注意力层的输出张量,且表达式如下:

其中,

本实施例的其他部分与实施例1相同,故不再赘述。

实施例3:

本实施例是在实施例1或2的基础上进行优化,如图8、图9所示,所述特征码转换网络由从前至后若干个顺序连接的可重复全连接单块以及正则化层构成;所述可重复全连接单块由若干个全连接基础模块顺序连接得到,所述全连接基础模块由从前至后依次连接并封装的全连接层、批归一化层、激活层构成。本发明的特征码转换网络,采用了可重复堆叠的全连接层为主体构成的模块,计算量小,应用时耗时短,消耗的资源小。

进一步地,如图11所示,所述可重复全连接单块采用残差连接的方式,将可重复全连接单块中最后一个全连接基础模块的输出与可重复全连接单块的输入按元素进行相加,以作为可重复全连接单块的输出。

进一步地,如图10所示,所述可重复全连接单块中最后一个的全连接基础模块的输出作为可重复全连接单块的输出,以作为特征码转换网络的输出。

进一步地,所述可重复全连接单块中设置有3个全连接基础模块;所述特征码转换网络中设置有6个可重复全连接单块。

本实施例的其他部分与上述实施例1或2相同,故不再赘述。

实施例4:

一种人脸特征码的跨模型转换方法,如图1所示,采用上述的转换系统进行转换,包括以下步骤:

步骤S1:分别获取图像特征网络、特征码转换网络的训练集;

步骤S2:利用训练集并结合损失函数分别对图像特征网络、特征码转换网络进行训练;

步骤S3:然后将人脸图像输入训练后的图像特征网络得到图像特征码;将待转换特征码输入训练后的特征码转换网络得到转换特征码;

步骤S4:将步骤S3中处理得到的图像特征码与转换特征码结合求平均值,并进行正则化操作,得到最终转换的特征码。

本发明构建两个神经网络模型,其中一个为图像特征网络,网络的输入为人脸图片,输出为图像特征码;另一个网络为特征码转换网络,输入为待转换特征码,输出为转换特征码。将两个网络的输出求均值,并进行正则化操作,得到最终的转换后的特征码。本发明同时利用了人脸图片和待转换特征码的信息,可以实现高精度的人脸特征码的跨模型转换,具有易于实施、计算精度高的特点。

实施例5:

一种人脸特征码的跨模型转换系统,如图1-图11所示,实现过程如下:

第一步,如图3所示,从前至后依次连接并封装的卷积层、批归一化层和激活层得到根部模块;

第二步,如图4所示,从前至后依次连接并封装的卷积层、批归一化层、激活层、深度可分离卷积层、批归一化层、激活层、卷积层和批归一化层得到可重复模块。如图5所示,若可重复模块进行下采样,则可重复模块的尾端还设置有一空间注意力层;

第三步,如图7所示,从前至后依次连接并封装的全局平均池化层、全连接层、激活层和正则化层得到特征提取模块;

第四步,如图2所示,从前至后依次连接根部模块、数个可重复模块、特征提取模块得到图像特征网络;

第五步,如图9所示,从前至后按全连接层,批归一化层,激活层顺序连接并封装得到全连接基础模块;

第六步,如图10所示,将数个全连接基础模块顺序连接得到可重复全连接单块;如图11所示,可重复全连接单块可使用残差连接的方式,即将单块中最后一个全连接模块的输出,与单块的输入按元素进行相加,作为单块的输出。可重复全连接单块也可不使用残差连接,即将直接将单块中最后一个全连接模块的输出,作为单块的输出;

第七步,如图8所示,从前至后由数个顺序连接的可重复全连接单块,和正则化层构成特征码转换网络。

第八步,图像特征网络和特征码转换网络在模型训练时,应当分别进行训练。

所述图像特征网络的损失函数定义如下:

其中:

特征码转换网络的损失函数定义如下:

其中:

第九步,将图像特征网络和特征码转换网络的输出求均值,并进行正则化操作,得到最终的转换后的特征码。

为了验证本方法的可行性和良好的性能,本实施例通过构建以下实验进行测试:

1)首先准备两个不同的人脸识别模型,模型A和模型B,以及人脸识别的验证集。

2)实验中,模型A输出的特征码为512维,模型B输出的特征码为256维。由于特征码维度不同,两个模型的输出无法兼容使用。

3)通过构建本实施例中的神经网络,进行训练。训练时,训练集包含25万张不同的人脸图像。训练完成后,使用人脸识别验证集进行测试,结果如表1所示。

表1

从表1中的结果可以看出,模型A的特征码,经过转换以后,能够达到非常接近模型B原本的精度。同时,人脸识别模型所需的训练图片数量一般都非常庞大,本实施中的模型A和模型B均使用了1200万张人脸图像进行训练,而转换模型的训练集仅为25万张。训练图像特征网络和特征码转换网络所需的资源和时间,均远小于人脸识别模型。因此,采用本发明所述的方法,在应用于不同人脸识别模型相互转换时,只需要较少的资源训练转换网络即可实现。通过上述实验,可以验证本发明所采用的结构的高效性,和高精度。

通过上述方法,本发明利用了两个相互独立的网络分别处理原始人脸图像和待转换特征码,最后再将结果进行融合,相比较于单个网络,精度更高。与相同技术相比,本发明具有突出的实质性特点和显著的进步,在人脸识别领域具有很高的实用价值和推广价值。

以上所述,仅是本发明的较佳实施例,并非对本发明做任何形式上的限制,凡是依据本发明的技术实质对以上实施例所作的任何简单修改、等同变化,均落入本发明的保护范围之内。

- 一种人脸特征码的跨模型转换系统及方法

- 不同人脸识别模型特征码的转换系统、方法及可读存储介质