生成时间序列数据的频率成分矢量的方法及装置

文献发布时间:2023-06-19 10:18:07

技术领域

本发明涉及利用了神经网络进行的数据的处理。

背景技术

能够使用神经网络而生成或者变换系列数据。例如在非专利文献1中公开了WaveNet。在WaveNet中能够将过去的音频样本系列的输入值或者输出值和与设为目标的输出音频样本系列的性质有关的辅助数据之中的至少一个作为输入,在每个单位时间得到针对新的音频样本的值的概率分布,从该概率分布对1个值进行采样,从而能够得到新的音频样本的值。每单位时间重复以上的处理,从而能够得到输出音频样本系列。在WaveNet中,必须针对每个音频样本进行大规模的神经网络的计算。通常音频样本每1秒需要几十万样本,因此存在计算量变得庞大这样的问题。

非专利文献1:Van Den Oord,Aaron,et al."Wavenet:A generative model forraw audio."CoRR abs/1609.03499(2016)

非专利文献2:Blaauw,Merlijn,and Jordi Bonada."A neural parametricsinging synthesizer."arXiv preprint arXiv:1704.03809(2017)

发明内容

WaveNet是专门用于音频样本系列的变换或者生成的技术。在将其直接应用于某种矢量系列数据的生成而作为声音合成器起作用的方式中,存在非专利文献2中公开的Neural Parametric Singing Synthesizer(NPSS)。在NPSS中由对声音的性质进行表现的几十维度的梅尔倒谱系数构成的矢量的各维度的概率分布是通过与WaveNet类似的方式的神经网络,全维度对应量一同输出的。但是,在这里输出的概率分布是基于针对各维度各自的独立性的概率分布,不是全维度的同时概率分布、基于维度间的依赖关系的带条件的概率分布。因此,该方法能够直接应用的情况被限定于下述情况,即,如声音中的梅尔倒谱系数那样,即使不那么严格地处理维度间的关系性,也能得到充分的品质的输出的情况。为了避免该限定,假设如果考虑通过相同方式的神经网络将全维度的同时概率分布、基于维度间的依赖关系的带条件的概率分布进行输出,则神经网络应该输出的概率分布、其参数的数量会变得庞大,学习、生成所花费的计算资源会变得庞大,而且由于与输出的维度数对应的学习数据的不足,因此有可能无法适当地进行学习。

为了解决以上的课题,本发明的一个方式所涉及的方法是生成时间序列数据的频率成分矢量的方法,该方法具有:第1处理,其使用被提供第1数据的第1神经网络,生成表示第1数据的替代表现的中间数据;以及第2处理,其基于所述中间数据而生成与多个频带相对应的多个成分值,所述第1处理及所述第2处理在多个单位步骤的各个单位步骤中被执行,所述第2处理包含与所述多个频带相对应的多个单位处理,所述多个单位处理的各个单位处理包含通过被提供所述中间数据的第2神经网络进行的推定,生成所述相对应的多个成分值,所述多个单位处理之中的与第1频带相对应的第1单位处理将通过与不同于所述第1频带的第2频带相对应的第2单位处理而生成的第2成分值或者所述第2单位处理的中间值、和所述中间数据,提供给所述第2神经网络,生成第1成分值。

另外,本发明的一个方式所涉及的装置是生成时间序列数据的频率成分矢量的装置,该装置具有:第1处理部,其执行第1处理,该第1处理使用被提供第1数据的第1神经网络,生成表示第1数据的替代表现的中间数据;以及第2处理部,其执行第2处理,该第2处理基于所述中间数据而生成与多个频带相对应的多个成分值,所述第1处理及所述第2处理在多个单位步骤的各个单位步骤中被执行,所述第2处理包含与所述多个频带相对应的多个单位处理,所述多个单位处理的各个单位处理包含通过被提供所述中间数据的第2神经网络进行的推定,生成所述相对应的多个成分值,在所述多个单位处理之中的与第1频带相对应的第1单位处理中,将通过与不同于所述第1频带的第2频带相对应的第2单位处理而生成的第2成分值或者所述第2单位处理的中间值、和所述中间数据,提供给所述第2神经网络,生成第1成分值。

附图说明

图1是例示本发明的一个方式所涉及的信息处理装置的结构的框图。

图2是例示信息处理装置的功能性结构的框图。

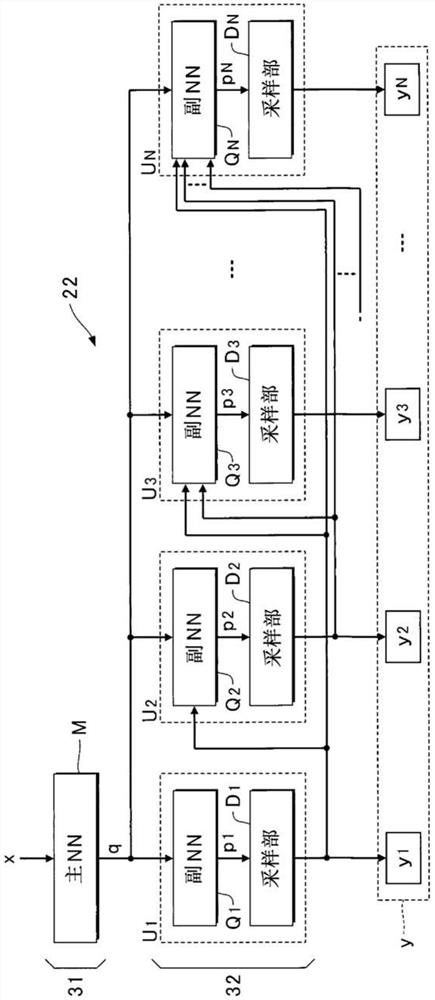

图3是例示信息处理部的具体结构的框图。

图4是例示信息处理装置的动作的具体顺序的流程图。

图5是例示学习的具体顺序的流程图。

具体实施方式

1.发明的主旨

1.1发明的方式

本发明的一个方式的神经网络构成为,具有:

主神经网络,其在每个单位时间输入1个以上的矢量,输出1个以上的矢量;以及

一个以上的副神经网络,其在每个所述单位时间,将主神经网络的输出作为输入的一部分或者全部,输出一般的系列数据的该时刻下的频率成分矢量的一个以上的要素值或者其要素值的概率分布或者对其概率分布进行表现的参数组,

这些副神经网络组之中的至少一个,依赖于该时刻下的通过副神经网络组之中的至少一个计算所得到的值而输出该时刻的值。

1.2特别有效的方式

(1)作为频率成分矢量,利用由离散余弦变换(DCT;Discrete Cosine Transform)的系数构成的矢量的方式。

(2)作为频率成分矢量,利用由离散正弦变换(DST;Discrete Sine Transform)的系数构成的矢量的方式。

(3)作为频率成分矢量,利用由修正离散余弦变换(MDCT;Modified DiscreteCosine Transform)的系数构成的矢量的方式。

(4)作为频率成分矢量,利用与比率变换滤波器组的一个时刻下的输出相当的矢量的方式。

(5)与高频带相对应的系数依赖于通过与低频带相对应的系数的计算所得到的值而输出的方式。

(6)是主神经网络为大规模,各副神经网络为小规模或者不具有能够学习的系数的函数的方式。

(7)设为各副神经网络的规模基于针对各自对应的频率成分所要求的精度而不同的方式。

(8)特别地,越是与高频率成分相对应的副神经网络而规模越减小的方式。

(9)将系数的概率分布进行输出的方式。

(10)特别地,设为基于各频率成分的统计性质而使其概率分布的表现方法不同的方式。

(11)特别地,设为基于各频率成分的性质而使根据其概率分布而得到系数值的方法不同的方式。

2.发明的一个方式

2.1硬件结构

图1是例示本发明的一个方式所涉及的信息处理装置100的结构的框图。如图1所例示那样,本实施方式的信息处理装置100是具有控制装置11、存储装置12和放音装置13的计算机系统。例如移动电话机、智能手机或者个人计算机等信息终端被利用为信息处理装置100。

控制装置11例如为CPU(Central Processing Unit)等处理电路,集中地对信息处理装置100的各要素进行控制。存储装置12例如是由磁记录介质或者半导体记录介质等公知的记录介质构成的存储器,对由控制装置11执行的程序和由控制装置11使用的各种数据进行存储。例如,对后面记述的神经网络进行规定的多个系数K存储于存储装置12。此外,也可以通过多种记录介质的组合而构成存储装置12。另外,也可以将相对于信息处理装置100能够装卸的移动型的记录介质、或者信息处理装置100经由通信网能够通信的外部记录介质(例如在线储存器)利用为存储装置12。放音装置13是控制装置11对与音响信号A相对应的声波进行播放。例如扬声器或者耳机是放音装置13的典型例。

图2是例示通过由控制装置11执行在存储装置12中存储的程序而实现的功能的框图。如图2所例示那样,本实施方式的控制装置11实现前处理部21、信息处理部22和波形生成部23。此外,也可以通过相互地分体构成的多个装置而实现控制装置11的功能。也可以将控制装置11的功能的一部分或者全部由专用的电子电路实现。

前处理部21关于时间轴上的多个单位步骤的各个单位步骤,生成表示声音的特征的输入数据Din的时间序列。输入数据Din例如为振幅谱等的特征量矢量。但是,也可以将梅尔倒谱的低次系数和基本频率的组合、或者振动谱图等的特征量矢量作为输入数据Din而生成。前处理部21利用包含声音合成的公知的变换技术,例如根据表示说话内容的文本信息而生成输入数据Din。单位步骤是成为通过信息处理装置100进行的处理的时间单位的期间。

信息处理部22在时间轴上的多个单位步骤的各个单位步骤中,基于包含输入数据Din的第1数据x而生成第2数据y。第2数据y是包含与N个频带各自对应的N个成分值y

如图2所例示那样,任意的1个单位步骤中的第1数据x是包含该单位步骤的输入数据Din和关于紧跟其前的单位步骤而生成的第2数据y在内的矢量。即,由信息处理部22生成的第2数据y作为第1数据x的一部分而反馈至信息处理部22的输入侧。

波形生成部23基于由信息处理部22生成的第2数据y的时间序列而生成时间区域的音响信号A。例如,波形生成部23通过针对第2数据y的时间序列的逆修正离散余弦变换(IMDCT;Inverse MDCT)而生成音响信号A。由波形生成部23生成的音响信号A供给至放音装置13而作为声波进行播放。

2.2网络结构

图3是例示通过由控制装置11执行在存储装置12中存储的程序而实现的信息处理部22的具体结构的框图。如图3所例示那样,本实施方式的信息处理部22是包含第1处理部31和第2处理部32而构成的。第1处理部31在时间轴上的多个单位步骤的各个单位步骤中执行第1处理。第1处理是生成中间数据q的处理,该中间数据q表示第1数据x的替代表现。在第1处理中,利用对第1数据x和中间数据q之间的关系进行了学习的1个主神经网络M(主NN)。中间数据q是表示第1数据x的特征量(特别是对第1数据x和第2数据y之间的关系做出贡献的特征量)的特征量矢量。主神经网络M是第1神经网络的例示。

第2处理部32在时间轴上的多个单位步骤的各个单位步骤中执行第2处理。第2处理是基于由第1处理部31生成的中间数据q而生成第2数据y的处理。如图3所例示那样,第2处理部32是包含与第2数据y的不同的频带的成分值y

各单位处理部U

单位处理部U

向第1个单位处理部U

由第1个副神经网络Q

此外,图3构成为相对于成为1≤n≤N的所有n,y

如根据以上的说明所理解那样,如果为了方便起见而关注于生成N个频带之中的第1频带的成分值y

主神经网络M的构造是任意的,例如可以是将全连接层层叠的单纯的前馈神经网络,也可以是卷积神经网络(CNN;Convolutional Neural Network)。另外,也可以使用如递归型神经网络(RNN;Recurrent Neural Network)或者长·短期存储(LSTM;Long Short-Term Memory)那样将计算的结果存储于内部状态而用于下一次计算的这种神经网络。此外,推断的准确性和学习及推断所需的计算效率良好的是CNN、RNN及LSTM这种神经网络。

副神经网络Q

此外,在作为副神经网络Q

在N个副神经网络Q

2.3推断

在推断中,主神经网络M针对每个单位步骤而输出中间数据q。各副神经网络Q

图4是例示由控制装置11执行的推断的具体顺序的流程图。针对时间轴上的每个单位步骤而执行图4的处理。如果开始图4的处理,则信息处理部22取得第1数据x(Sa1)。如前所述,第1数据x包含由前处理部21关于该单位步骤而生成的输入数据Din和通过紧跟其前的1个以上的单位步骤而生成的第2数据y。此外,在刚刚开始推断后的第1次单位步骤中,第2数据y设定为初始值。信息处理部22通过将第1数据x输入至主神经网络M,从而生成中间数据q(Sa2)。

信息处理部22执行第1次单位处理(Sb1)。具体地说,信息处理部22通过向单位处理部U

信息处理部22执行第2次单位处理(Sb2)。具体地说,信息处理部22通过向第2个单位处理部U

直至第N个成分值y

通过遍及N次而反复进行单位处理(即第2处理),从而生成由N个成分值y

2.4学习

图5是例示学习的顺序的流程图。能够使主神经网络M和N个副神经网络Q

2.5频率成分和变换

在本实施方式中,利用时间区域的一般的系列数据(即,与时间轴上的不同的时刻相对应的多个数据的时间序列)和频率区域的第2数据y能够相互地变换的情况。在如上所述的变换中大体区分而存在两个方法,一个是使用向与频率基底对应的系数的变换及其逆变换的方法,另一个是使用滤波器组的方法。

2.5.1使用向与频率基底对应的系数的变换的方法

与频率基底相对应的系数适合作为第2数据y的各成分值y

在可选择的各种频率基底及变换中,将余弦函数用作基底,将通过修正离散余弦变换(MDCT;Modified Discrete Cosine Transform)得到的系数矢量的系列数据用作本实施方式中的第2数据y是极优选的。此外,该变换仅针对实数系列进行了定义,因此无法利用于复数的系列数据。现实中处理的系列数据大多为实数,因此该方式的利用范围极大。

DCT是从实数系列向与余弦函数的基底对应的系数的变换及其逆变换的统称。DFT是将复正弦函数作为基底,针对实数系列都输出复数的系数,与此相对,由DCT输出的系数始终为实数。复数是由实数和虚数的组构成的,不容易通过神经网络对它们的相互的依赖关系进行处理,与此相对,由DCT输出的实数的系数能够容易地利用为神经网络的输出。另外,一般来说,已知针对现实的系列数据的DCT与DFT相比较,向低频率成分的能量集中性良好。根据该性质,如果在DCT的系数中将与低频率成分相对应的系数以充分高的精度进行表现,则即使将与高频率成分相对应的系数通过低精度表现,也不会大幅地丧失原来的系列数据的信息。此外,DST是从实数系列向与正弦函数的基底对应的系数的变换及其逆变换的统称。DST与DCT相比较,向低频率成分的能量集中性不好。但是,DST与DCT同样地是针对实数系列数据将实数系数进行输出的变换。因此,DCT、DST的各种在可选择的各种频率基底及变换中都是适合的。

MDCT是离散余弦变换的一种,是以通过将满足特定条件的窗函数以特定的比率进行重叠的帧而进行每单位时间的相互变换为前提的,与其他DCT的类别、DFT相比较,能够减少与频率基底相对应的系数的数量。在具体的例子中,在使用2N点的窗函数通过N点的时间步长(timestep)进行双重叠的变换时,各时间步长的变换结果成为与N个频率基底对应的系数的矢量。如果与在以该条件使用其他DCT的情况下成为与2N个频率基底对应的系数的矢量相比较,则在MDCT中能够通过其一半的系数而完全地表现原来的系列数据,尽管使用双重叠的窗函数,但也能够通过与原来的系列数据相同的个数对与全时间范围的全频率基底对应的系数进行表现。该性质在将针对频率基底的系数的矢量用作神经网络的输入或者输出时,有助于所要求的网络的规模削减。因此MDCT在DCT的各变种中也是适合的。

2.5.2使用比率变换滤波器组的方法

作为第2数据y的各成分值y

作为在本实施方式中能够适当地使用的比率变换滤波器组,存在正交镜像滤波器(QMF;Quadrature Mirror Filter)组、伪QMF(PQMF;Pseudo Quadrature Mirror Filter)组、共轭正交滤波器(Conjugate Quadrature Filter)组等,这些滤波器通过使用多相分解和其等价变换,从而能够高效地执行伴随拉开间隔、内插的计算。

3.效果

3.1计算量的削减

在本实施方式中输出系列数据是帧单位的矢量系列,主神经网络M针对该帧的每个单位步骤进行计算。因此,根据增大主神经网络M的规模、充分地减小副神经网络Q

在将最终得到的第2数据y变换为时间序列数据的情形中,执行该变换的计算量的增加相对于使用本实施方式所带来的计算量的削减而充分地小。特别地,在利用向与包含MDCT的频率基底对应的系数的变换的情况下,该变换能够返回极小规模的计算和逆离散傅立叶变换(IDFT;Inverse Discrete Fourier Transform)的组合,IDFT能够使用高速傅立叶变换(FFT;Fast Fourier Transform)的算法而高效地计算,因此由此引起的计算量的增加极小。

3.2感受野的扩大

在对有限长度的系列数据进行处理的神经网络中,将在每单位时间的输出值的推断中能够利用的输入系列的长度称为感受野(receptive field)。为了实现准确地反映出设为目标的时间序列数据的继时性的变动构造的推断,对该构造进行表示需要充分长度的感受野。

前馈神经网络、卷积神经网络具有由其结构决定的有限的感受野。在这些神经网络中,通过单纯地增加神经网络的输入节点数或者卷积内核的大小,从而能够使感受野变长。但是,输入节点数或者卷积内核的大小的增加与学习时及推断时的计算量的增加直接相关。RNN、LSTM将过去的推断的中间计算结果利用于推断,因此在理论上能够利用过去的全部输入值。但是,实际上过去的状态的影响针对每个单位步骤而逐渐地减小,因此实质上相当于具有有限的感受野,另外,不容易对该实质性的感受野的长度进行控制。

在本实施方式中针对与帧单位相当的每个单位步骤(单位时间)进行向主神经网络M的输入,因此在帧间隔为N样本时,例如与如WaveNet那样以样本单位输入系列数据的神经网络相比较,实质性的感受野以N倍变长。

3.3实质性的量化误差的减少

在神经网络中,有时作为输出而期待的值原本是连续性的值,但设为将量化而可取得的值的任意者进行输出的结构也能够实现误差小的推断。在WaveNet中,提出了将声音波形进行mu-law量化而处理。但是此时,在神经网络的推断的误差的基础上,会产生由量化引起的误差。一般与将时间序列数据直接量化相比,一度变换为频率区域的第2数据y而将其量化后再次变换为时间序列数据会使误差变小。例如在声音、图像等的信号中,通过该方法进行了量化的信号与直接被量化的信号相比不易觉察到误差。根据该倾向,为了最终地得到时间序列数据,如本实施方式那样利用针对将频率基底系数量化后的系数的神经网络的方式与如WaveNet那样利用针对将时间序列数据直接量化后的数据的神经网络相比,不易觉察到由量化而引起的误差。

3.4针对每个频带的特性的利用

系列数据有时具有针对每个频带而不同的特性。例如人类的声音的能量大部分集中于大致4kHz以下的频带,在与其相比更高的频带中能量急剧地变小。另外存在下述倾向,即,在4kHz以下时发生大致周期性的历时变动,与此相对,在与其相比更高的频带中发生非周期性的历时变动。另外,在高于4kHz的频带中,人类的听觉的灵敏度逐渐地降低。

可以利用与第2数据y的各成分值y

另外,如果使用频率区域的第2数据y,则也能够相对于在推断时输出的概率分布p

3.5广泛的应用范围

与仅将标量值即音频样本的时间序列设为对象的WaveNet、将矢量的时间序列设为对象的无法进行具有维度间的关系性的推断的NPSS不同,本实施方式能够进行将矢量的维度间的关系性和其矢量的时间序列构造或者空间系列构造这两者同时考虑在内的推断,因此能够立即应对更一般的矢量系列数据。

4.实施例

4.1作为神经声码器的实施例

4.1.1概要

主要将与振幅谱具有关系的低维度的声音的特征量作为输入,输出与其相对应的波形的神经网络被称为神经声码器。输入至神经声码器的声音的特征量,例如是梅尔倒谱的低次系数和基本频率信息的组合、梅尔频谱等。这些特征量是通过公知的变换技术,例如基于文本信息而生成的。如果将上述这样的变换技术和神经声码器进行组合,则信息处理装置100作为从文本信息得到声音波形的声音合成系统起作用。此外,振幅谱不具有相位的信息,因此将其压缩为低维度表现的特征量也无法通过逆傅立叶变换等简单的函数变换为波形。因此在神经声码器中,取代如上所述的函数,准备事先对在现实中产生的声音特征量和波形的组进行了学习的神经网络,使用该神经网络将与振幅谱相关的特征量变换为波形。

使用不是对波形而是对第2数据y进行推断的本实施方式,在将主神经网络M的规模充分地变大的基础上,如果减小各副神经网络Q

作为代替声音波形的第2数据y,使用系数矢量列是优选的,该系数矢量列是针对声音波形而应用2~64样本左右的帧间隔的MDCT而得到的。如果考虑在声音波形中包含大量噪音性的成分,则在大多情况下与该MDCT系数的值本身相比概率性的性质是重要的,因此各副神经网络Q

N个副神经网络Q

也能够将单一的RNN、LSTM设为副神经网络Q

以下,基于在本实施例中叙述为优选的上述的各条件进行说明。

4.1.2学习

将在学习中使用的声音的任意的时间范围中的第2数据y的正解值和与其相对应的输入数据Din(特征量矢量的系列数据)作为输入,将输入的时间范围的下一个单位步骤中的MDCT系数矢量作为最终输出的目标值而对神经网络整体进行学习。实际上由各副神经网络Q

在上述学习的顺序中,向各副神经网络Q

4.1.3推断

如果将本实施方式的神经网络用于自回归以使得将各时刻的紧跟其前的输出矢量设为最新的输入值,则能够得到与遍及期望的时间范围(以下称为“合成范围”)的设为目标的声音的输入数据Din(特征量矢量)相对应的第2数据y,与其相对,如果应用逆MDCT,则能够得到设为目标的声音的波形。更具体地说只要执行以下的顺序即可。

[顺序1]控制装置11关于合成范围内的最初的时间步长,将声音的第2数据y的初始值和设为目标的声音的特征量的矢量的系列数据之中的起始的输入数据Din输入至主神经网络M。第2数据y的初始值在与全MDCT系数的值为0相对应的矢量、或者与设为目标的声音的最初的信号相对应的MDCT系数预先已知的情况下,使用与其相对应的矢量。顺序1相当于图4的步骤Sa1及Sa2。

[顺序2]控制装置11将由主神经网络M输出的中间数据q输入至与最低频带(n=1)的MDCT系数相对应的副神经网络Q

[顺序3]通过生成按照在之前的顺序中得到的概率分布的近似随机数,从而得到该频带的MDCT系数y

[顺序4]控制装置11将由主神经网络M输出的中间数据q和直至之前的顺序为止推断出的低频带的MDCT系数y

[顺序5]针对该单位步骤的MDCT系数的全部而反复进行顺序4及顺序3,由此生成MDCT系数矢量y。

[顺序6]控制装置11将通过以上的顺序得到的MDCT系数矢量作为该单位步骤的最终的输出值而输出,并且将其作为第2数据y的最新的单位步骤的值进行记录。

[顺序7]控制装置11将成为处理对象的单位步骤前进1个,将包含关于紧跟其前的1个以上的单位步骤而输出的1个以上的第2数据y和表示设为目标的声音的特征的输入数据Din在内的第1数据x输入至主神经网络M。

[顺序8]控制装置11将顺序7、2~6在合成范围内的声音合成中以充分次数重复进行。

[顺序9]控制装置11通过针对第2数据y的时间序列而应用逆MDCT,从而得到合成范围内的声音波形。将在顺序9中得到的表示声音波形的音响信号A供给至放音装置13。与音响信号A相对应的音从放音装置13进行放音。顺序9相当于图4的步骤Sc。

4.2作为声音合成器的实施例

取代与在前述神经声码器中使用的声音相对应的特征量矢量,将离散化后的音素符号的系列数据用作输入数据Din,或者在更高级的例子中将字母或者汉字等一般的书写文字的系列数据用作输入数据Din,由此能够作为生成与音素符号或者书写文字相对应的声音的、更直接的声音合成器。

4.3作为音频效果的实施例

对与输入音频信号相对应的MDCT系数矢量系列数据实施任意的变换(例如音高变换器或者多频段压缩器等),得到与输出音频信号相对应的MDCT系数矢量系列数据。取代与在前述神经声码器中使用的声音相对应的特征量矢量,赋予与其变换的性质相关的信息而进行学习及推断。在本实施例的情况下,不将输出矢量作为输入回归,取而代之,将与输入音频信号相对应的MDCT系数矢量系列数据设为输入也能够实施。

5.其他

前述的方式所涉及的信息处理装置100的机能是通过计算机(例如控制装置11)和程序的协同动作而实现的。本发明的一个方式所涉及的程序以储存于计算机可读取的记录介质的方式被提供而安装于计算机。记录介质例如是非易失性(non-transitory)的记录介质,CD-ROM等光学式记录介质(光盘)是优选例,但也可包含半导体记录介质或者磁记录介质等公知的任意形式的记录介质。此外,非易失性的记录介质包含除了暂时性的传输信号(transitory,propagating signal)以外的任意的记录介质,并不是将易失性的记录介质排除在外。另外,也能够通过经由通信网的传送的方式将程序提供给计算机。

用于实现神经网络的人工智能软件的执行主体并不限定于CPU。例如,TensorProcessing Unit及Neural Engine等神经网络专用的处理电路、或者人工智能专用的DSP(Digital Signal Processor)也可以执行人工智能软件。另外,从以上的例示选择出的多种处理电路也可以协同动作而执行人工智能软件。

<附记>

从以上例示出的方式,例如掌握以下的结构。此外,为了使各方式的理解变得容易,在以下的记载中,为了方便起见将在前述的方式中使用过的标号用括号一并记载,但并不将本发明限定为前述的方式。

[第1方式]

本发明的第1方式所涉及的方法是生成时间序列数据的频率成分矢量的方法,该方法具有:第1处理,其使用被提供第1数据(x)的第1神经网络(主NN),生成表示第1数据(x)的替代表现的中间数据(q);以及第2处理,其基于所述中间数据而生成与多个频带相对应的多个成分值(y

根据以上的结构,在多个单位处理之中的生成与第1频带相对应的第1成分值的第1单位处理中,将通过第2单位处理关于第2频带而生成的第2成分值或者在该第2单位处理的过程中生成的中间值和中间数据输入至第2神经网络。因此,能够生成对第1成分值和第2成分值之间的依赖进行了反映的、包含与多个频带分别对应的多个成分值(y

在以上的方式中,为了方便起见仅关注了多个单位处理之中的任意的2个单位处理(第1单位处理、第2单位处理)。不考虑其他单位处理中的输入如何(输入的总数、范围等)。另外,在第1单位处理中,不考虑除了第2成分值(或者中间值)以外的成分值是否输入至第2神经网络。

第2处理例如是(1)通过与不同的频带相对应的N个副NN生成N个成分值的处理,或者(2)通过1个RNN遍及N次反复进行成分值的生成的处理。

在将RNN利用为副NN的情况下,并不是将成分值,而是将副NN中的中途的计算值(中间值)应用于下一次的推定。

单位处理例如是(1)通过第2神经网络进行的概率分布的推定及按照概率分布的成分值的决定,或者(2)通过第2神经网络进行的直接的成分值的推定。在(1)的结构中,所述多个单位处理的各个单位处理包含下述处理:通过被输入所述中间数据(q)的第2神经网络(副NN)对所述成分值的概率分布进行推定的处理,以及根据该概率分布而决定成分值的处理。

[第2方式]

在第1方式的一个例子(第2方式)中,所述第1单位处理将通过包含所述第2单位处理在内的2个以上的单位处理而生成的2个以上的成分值、或者该2个以上的中间值(q)输入至所述第2神经网络(副NN),生成第1成分值(y

[第3方式]

在第1方式的一个例子(第3方式)中,所述多个单位处理是N个单位处理,在第n个(n=2~N)单位处理中,通过从第1个至第(n-1)个单位处理生成的(n-1)个成分值、或者在该各单位处理的过程中生成的中间值与所述中间数据(q)一起输入至所述第2神经网络(副NN)。

另外,在所述多个单位步骤的各个单位步骤中,所述第2单位处理是在执行所述第1单位处理前被执行的。

另外,在所述多个单位步骤的各个单位步骤中,所述2个以上的单位处理是在执行所述第1单位处理前被执行的。

[第4方式]

在第1方式至第3方式的任意方式的一个例子(第4方式)中,所述频率成分矢量的所述多个成分值是离散余弦变换(DCT)或者离散正弦变换(DST)的系数。

[第5方式]

在第1方式至第3方式的任意方式的一个例子(第5方式)中,所述频率成分矢量的所述多个成分值是修正离散余弦变换(MDCT)的系数。

[第6方式]

在第1方式至第3方式的任意方式的一个例子(第6方式)中,所述频率成分矢量的所述多个成分值与所述多个成分值分别对应,是来自下采样的滤波器组的输出值。

[第7方式]

在第1方式至第6方式的任意方式的一个例子(第7方式)中,所述第2频带低于所述第1频带。

[第8方式]

在第7方式的一个例子(第8方式)中,所述第2神经网络具有与所述多个单位处理相对应的多个单独神经网络,所述多个单位步骤的各个单位步骤包含通过与所述多个单位处理的各个单位处理相对应的单独神经网络进行的推定。

另外,与所述第2单元处理相对应的单独神经网络,大于与所述第1单元处理相对应的单独神经网络。

所述第2神经网络是与所述多个单元处理共通的单一神经网络,所述多个单位处理的各个单位处理包含通过所述单一神经网络进行的推定。

此外,神经网络的规模例如是指层数、1层内的节点数或者通道数。另外,在卷积神经网络中,应用于卷积的内核的大小也视作该神经网络的规模。

[第9方式]

在第1方式至第8方式的任意方式的一个例子(第9方式)中,也可以是所述第2神经网络小于所述第1神经网络。

作为执行以上例示出的各方式的信息处理方法的信息处理装置,或者使计算机执行以上例示出的各方式的信息处理方法的程序,也能实现本发明的各方式。

本申请基于2018年8月10日申请的日本申请(特愿2018-151748)及2018年9月11日申请的日本申请(特愿2018-169304),在这里作为参照而引入其内容。

工业实用性

本发明的信息处理方法及信息处理装置能够削减运算量、并且实现神经网络的适当的学习及推断。

标号的说明

100…信息处理装置

11…控制装置

12…存储装置

13…放音装置

21…前处理部

22…信息处理部

23…波形生成部

31…第1处理部

32…第2处理部

M…主神经网络

U

Q

D

- 生成时间序列数据的频率成分矢量的方法及装置

- 针对矢量网络分析仪实现宽带频率快速锁定和生成的装置及方法