一种音频处理的方法、装置、可读存储介质和电子设备

文献发布时间:2023-06-19 11:49:09

技术领域

本发明涉及音频处理领域,具体涉及一种音频处理的方法、装置、可读存储介质和电子设备。

背景技术

随着互联网应用的发展,在线教学和网络直播改变了传统的教学方式以及人们的生活方式,在人们的日常生活使用越来越广泛,以在线教学为例,在线教学平台同时会有大量的学生用户,教师在教学过程中如果受到个人情绪或身体状态的影响,讲话时的音调一成不变,平淡无奇或者异常严厉,都会影响教师的亲和力,进而影响学生的学生效率和学习兴趣,造成用户的流失。

因此,如何通过技术手段对人物的音调进行控制,提高交流的效果,是目前需要解决的问题。

发明内容

有鉴于此,本发明实施例提供了一种音频处理的方法、装置、可读存储介质和电子设备,有效的对人物的音调进行控制,提高了交流的效果。

第一方面,本发明实施例提供了一种音频处理的方法,该方法包括:获取第一音频;确定所述第一音频的第一情感类别;响应于所述第一情感类别与所述第一音频对应的第二情感类别不同,根据所述第二情感类别修改所述第一音频的音调,生成第二音频。

优选地,所述第一音频对应的第二情感类别根据情感预测模型预先确定的。

优选地,所述第一音频对应的第二情感类别为预先设置的。

优选地,所述根据情感预测模型预先确定的所述第一音频对应的第二情感类别,具体包括:

将所述第一音频的起始时刻之前设定时长的历史音频输入到自动语音识别模型,输出所述历史音频对应的文本信息,其中,所述历史音频用于预测所述第一音频的第二情感类别;

将所述文本信息输入到语义分析模型,输出所述文本信息对应候选情感类别;

将所述候选情感类别与所述历史音频之前N段音频对应的历史情感类别输入到情感预测模型,输出所述第一音频对应的第二情感类别,其中,N为大于或等于1的正整数。

优选地,所述情感类别包括愉快、悲伤、平淡、厌烦、惊讶以及生气中的至少一项。

优选地,所述确定所述第一音频的第一情感类别,具体包括:

根据高斯混合模型GMM或者深度神经网络模型,确定所述第一音频的第一情感类别。

优选地,所述根据所述第二情感类别修改所述第一音频的音调,生成第二音频,具体包括:

通过预先训练的情感转换模型,将所述第一音频的音调从所述第一情感类别修改为所述第二情感类别,生成第二音频,其中,所述情感转换模型为高斯混合模型GMM或者深度神经网络模型,所述第二音频的音调为第二情感类别。

优选地,所述通过预先训练的情感转换模型,将所述第一音频的音调从所述第一情感类别修改为所述第二情感类别,生成第二音频,具体包括:

确定所述第一音频的至少一个第一情感特征;

根据所述预先训练的情感转换模型将所述至少一个第一情感特征转换为至少一个第二情感特征;

将所述至少一个第二情感特征按照设定方法进行合成,生成第二音频。

优选地,所述设定方法为波形拼接、以及使用长短期记忆网络LSTM、循环神经网络RNN、Wavenet、或者Fastpitch进行参数合成。

优选地,所述第一情感特征和所述第二情感特征为矩阵参数。

优选地,所述情感转换模型的训练过程包括:

获取历史源音频以及历史目标音频,其中,历史源音频的音调与所述历史目标音频的音调的情感类别不同;

根据所述历史源音频确定至少一个第一历史情感特征,以及根据所述历史目标音频确定至少一个第二历史情感特征;

根据所述第一历史情感特征与所述第二历史情感特征训练所述情感转换模型。

优选地,所述自动语音识别模型包括神经网络模型或者端到端模型。

优选地,所述语义分析模型包括XGBoost模型、聚类模型或者端到端模型。

优选地,所述情感预测模型为隐马尔可夫HMM模型。

第二方面,本发明实施例提供了一种音频处理的装置,该装置包括:获取单元,用于获取第一音频;确定单元,用于确定所述第一音频的第一情感类别;处理单元,响应于所述第一情感类别与所述第一音频对应的第二情感类别不同,用于根据所述第二情感类别修改所述第一音频的音调,生成第二音频。

优选地,所述第一音频对应的第二情感类别根据情感预测模型预先确定的。

优选地,所述第一音频对应的第二情感类别为预先设置的。

优选地,所述根据情感预测模型预先确定的所述第一音频对应的第二情感类别,具体包括:

将所述第一音频的起始时刻之前设定时长的历史音频输入到自动语音识别模型,输出所述历史音频对应的文本信息,其中,所述历史音频用于预测所述第一音频的第二情感类别;

将所述文本信息输入到语义分析模型,输出所述文本信息对应候选情感类别;

将所述候选情感类别与所述历史音频之前N段音频对应的历史情感类别输入到情感预测模型,输出所述第一音频对应的第二情感类别,其中,N为大于或等于1的正整数。

优选地,所述情感类别包括愉快、悲伤、平淡、厌烦、惊讶以及生气中的至少一项。

优选地,所述确定所述第一音频的第一情感类别,具体包括:

根据高斯混合模型GMM或者深度神经网络模型,确定所述第一音频的第一情感类别。

优选地,所述根据所述第二情感类别修改所述第一音频的音调,生成第二音频,具体包括:

通过预先训练的情感转换模型,将所述第一音频的音调从所述第一情感类别修改为所述第二情感类别,生成第二音频,其中,所述情感转换模型为高斯混合模型GMM或者深度神经网络模型,所述第二音频的音调为第二情感类别。

优选地,所述通过预先训练的情感转换模型,将所述第一音频的音调从所述第一情感类别修改为所述第二情感类别,生成第二音频,具体包括:

确定所述第一音频的至少一个第一情感特征;

根据所述预先训练的情感转换模型将所述至少一个第一情感特征转换为至少一个第二情感特征;

将所述至少一个第二情感特征按照设定方法进行合成,生成第二音频。

优选地,所述设定方法为波形拼接、以及使用长短期记忆网络LSTM、循环神经网络RNN、Wavenet、或者Fastpitch进行参数合成。

优选地,所述第一情感特征和所述第二情感特征为矩阵参数。

优选地,所述情感转换模型的训练过程包括:

获取历史源音频以及历史目标音频,其中,历史源音频的音调与所述历史目标音频的音调的情感类别不同;

根据所述历史源音频确定至少一个第一历史情感特征,以及根据所述历史目标音频确定至少一个第二历史情感特征;

根据所述第一历史情感特征与所述第二历史情感特征训练所述情感转换模型。

优选地,所述自动语音识别模型包括神经网络模型或者端到端模型。

优选地,所述语义分析模型包括XGBoost模型、聚类模型或者端到端模型。

优选地,所述情感预测模型为隐马尔可夫HMM模型。

第三方面,本发明实施例提供了一种计算机可读存储介质,其上存储计算机程序指令,所述计算机程序指令在被处理器执行时实现如第一方面或第一方面任一种可能中任一项所述的方法。

第四方面,本发明实施例提供了一种电子设备,包括存储器和处理器,所述存储器用于存储一条或多条计算机程序指令,其中,所述一条或多条计算机程序指令被所述处理器执行以实现如第一方面或第一方面任一种可能中任一项所述的方法。

本发明实施例通过获取第一音频,确定所述第一音频的第一情感类别;响应于所述第一情感类别与所述第一音频对应的第二情感类别不同,根据所述第二情感类别修改所述第一音频的音调,生成第二音频。通过上述方法当第一音频中的音调影响交流效果时,通过与第一情感类别不同的第二情感类别修改第一音频中的音调,得到需要的音调,即有效的对人物的音调进行控制,提高了交流的效果。

附图说明

通过以下参照附图对本发明实施例的描述,本发明的上述以及其它目的、特征和优点将更为清楚,在附图中:

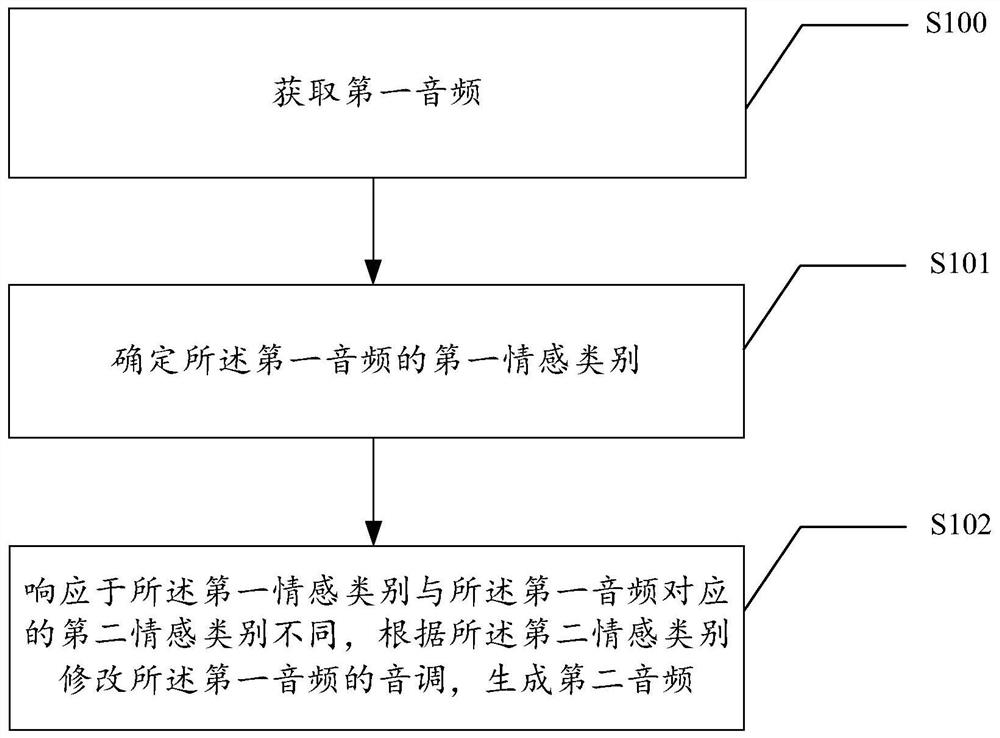

图1是本发明实施例的一种音频处理的方法流程图;

图2是本发明实施例的一种音频处理的方法流程图;

图3是本发明实施例的一种音频处理的方法流程图;

图4是本发明实施例的一种音频处理的方法流程图;

图5是本发明实施例的一种音频处理的方法流程图;

图6是本发明实施例的一种音频处理的方法流程图;

图7是本发明实施例的一种音频处理的方法流程图;

图8是本发明实施例的一种音频处理的装置示意图;

图9是本发明实施例的电子设备的示意图。

具体实施方式

以下基于实施例对本发明公开进行描述,但是本发明公开并不仅仅限于这些实施例。在下文对本发明公开的细节描述中,详尽描述了一些特定的细节部分。对本领域技术人员来说没有这些细节部分的描述也可以完全理解本发明公开。为了避免混淆本发明公开的实质,公知的方法、过程、流程、元件和电路并没有详细叙述。

此外,本领域普通技术人员应当理解,在此提供的附图都是为了说明的目的,并且附图不一定是按比例绘制的。

除非上下文明确要求,否则整个申请文件中的“包括”、“包含”等类似词语应当解释为包含的含义而不是排他或穷举的含义;也就是说,是“包括但不限于”的含义。

在本发明公开的描述中,需要理解的是,术语“第一”、“第二”等仅用于描述目的,而不能理解为指示或暗示相对重要性。此外,在本发明公开的描述中,除非另有说明,“多个”的含义是两个或两个以上。

在线教学平台会有大量的学生用户,假设教师在教学过程中如果受到个人情绪或身体状态的影响,例如,情绪不佳时,讲话时的音调一成不变,平淡无奇或者异常严厉,都会影响教师的亲和力,进而影响学生的学生效率和学习兴趣,造成用户的流失;或者,在网络直播行业,假设主播采用一成不变的音调与粉丝交流时,会影响粉丝的观看兴趣,取消对主播的关注,影响主播的粉丝数量;再者,在进行网络会议时,假设会议的主题比较悲伤,但是主讲人可能习惯性的使用欢快的音调,但欢快的音调不适合出现在该会议上,如果主讲人使用欢乐的音调会造成负面的舆论,对主讲人会造成负面的影响。

本发明实施例提出了一种音频处理的方法,通过该方法,可以结合语境,重新构建音频中音调,当讲述悲伤的话题时,即使音频中的实际发音是欢快的,也可以将其修改为悲伤的音调;或者,当需要教师通过欢快的音调授课时,即使教师的实际音调是厌烦,也可以将其修改为欢快的音调。通过本发明实施例,有效的对人物的音调进行控制,提高了交流的效果。

本发明实施例中,图1是本发明实施例的一种音频处理的方法流程图。如图1所示,具体包括如下步骤:

步骤S100、获取第一音频。

具体的,所述第一音频可以为视频流中提取的音频,也可以为直接录制为音频格式的音频,所述第一音频的时长可以为10ms,即每接收10ms的音频再进行处理,其中,所述10ms为示例性说明,具体的时长可以根据实际情况确定,本发明实施例对其不做限定。

步骤S101、确定所述第一音频的第一情感类别。

具体的,所述情感类别包括愉快、悲伤、平淡、厌烦、惊讶以及生气中的至少一项,在一种可能的实现方式中,所述情感类别还包括其它情感,本发明实施例对其不做限定。

在一种可能的实现方式中,可以基于Kaldi的高斯混合模型(Gaussian MixedModel,GMM)或者隐马尔可夫模型(Hidden Markov model,HMM)确定第一音频的第一情感类别,其中,所述Kaldi是当前最流行的开源语音识别工具,所述高斯模型是用高斯概率密度函数(正态分布曲线)精确地量化事物,将一个事物分解为若干的基于高斯概率密度函数(正态分布曲线)形成的模型,所述隐马尔可夫模型是一种结构最简单的动态贝叶斯网的生成模型,也是一种著名的有向图模型,它是典型的自然语言中处理标注问题的统计机器学模型;也可以使用深度神经网络(Deep Neural Networks,DNN)或者循环神经网络(Recurrent Neural Network,RNN)确定所述第一音频的第一情感类别。

假设,第一图像中包括一个人物的音频,则将所述一个人物的音调确定所述第一情感类别;假设所述第一图像中包括多个人物,确定所述多个人物中的主要人物,其中,所述主要人物可能是具有特殊声音标记(例如,音色特征)的人物、或者在第一音频中发音时间较长的人物,将所述主要人物的音调确定所述第一情感类别;或者,将专家判断的人物的音调确定为所述第一情感类别。

步骤S102、响应于所述第一情感类别与所述第一音频对应的第二情感类别不同,根据所述第二情感类别修改所述第一音频的音调,生成第二音频。

具体的,通过预先训练的情感转换模型,将所述第一音频的音调从所述第一情感类别修改为所述第二情感类别,生成第二音频,其中,所述情感转换模型为高斯混合模型GMM或者深度神经网络模型,所述第二音频的音调为第二情感类别。

在一种可能的实现方式中,假设所述第一音频对应的第一情感类别为悲伤,所述第一音频对应的第二情感类别为愉快,所述第一情感类别与所述第二情感类别不同,根据所述第二情感类别修改所述第一音频中的音调,将所述第一音频中的音调从悲伤修改为愉快,生成第二音频。

可选的,假设所述第一音频对应的第一情感类别与所述第一音频对应的第二情感类别相同,不对所述第一音频进行修改,将所述第一音频的原音作为第二音频。

通过上述方法当第一音频中的音调影响交流效果时,通过与第一情感类别不同的第二情感类别修改第一音频中的音调,得到需要的音调,即有效的对人物的音调进行控制,提高了交流的效果。

本发明实施例中,所述第一音频对应的第二情感类别根据情感预测模型预先确定,或者,所述第一音频对应的第二情感类别为预先设置的。

下面分别对上述两种第二情感类别的确定方法进行详细说明。

情况一、所述第一音频对应的第二情感类别为预先设置的。

具体的,在获取第一音频之前预先设置第一音频的第二情感类别,即预先设置第一音频中音调的情感类别。

假设,所述第一音频为教师授课音频,由于教师要保持愉快的授课音调,因此,将所述第一音频的第二情感类别预先设置为愉快,从获取第一音频开始,如果识别出的第一音频的第一情感类别与预先设置的第二情感类别不同,则根据第二情感类别修改第一音频的音调。具体的处理流程如图2所示。

图2为本发明实施例的一种音频处理的方法流程图,具体包括如下步骤:

步骤S200、获取预先设置的第一音频的第二情感类别。

步骤S201、获取第一音频。

步骤S202、确定所述第一音频的第一情感类别。

步骤S203、响应于所述第一情感类别与所述第一音频对应的第二情感类别不同,根据所述第二情感类别修改所述第一音频的音调,生成第二音频。

在一种可能的实现方式中,从数据流向的角度进行描述,所述第一音频的处理过程还可以如图3所示,由于第一音频的第二情感类别为预先设置的,因此,从获取第一音频开始就可以对第一音频中的音调进行修改,而不需要等待一段时间后才可以对第一音频中的音调进行修改;第一音频输入到语音情感处理模块301,通过语音情感处理模块301对第一音频的音调进行修改,然后所述语音情感处理模块301输出第二音频。

情况二、根据情感预测模型预先确定所述第一音频对应的第二情感类别。

具体的,假设没有在接收第一音频之前对第二情感类别进行预设,又需要在实时直播中即时的对第一音频中音调进行及时的修正,因此,需要提前对第一音频中的音调进行预测,然后当播放到某一段第一音频时,对该段第一音频中的音调进行判断,若第一音频中音调的第一情感类别与预测的第二情感类别不同,则及时的进行修改,由于提前对第一音频中的音调进行了预测,因此,只需要进行判断修改,所需要的时间较短,较短的延迟不会影响用户的使用体验。

本发明实施例中,通过情感预测模型预测某一端第一音频的第二情感类别时需要一段时间的历史数据,因此,不能像情况一从获取第一段第一音频开始就对所述第一音频进行处理,但是情况二比较适合不确定情感类别的音频,或者音频中包括多种情感类别的情况。

在一种可能的实现方式中,所述情况一和所述情况二可以同时存在,首先通过情况一从获取第一段第一音频开始就对所述第一音频进行处理,然后经过一定时间的积累之后,采用情况二对音频经常处理。

具体的,根据情感预测模型预先确定所述第一音频对应的第二情感类别,具体如图4所示。

图4为本发明实施例的一种音频处理的方法流程图,具体包括如下步骤:

步骤S400、将所述第一音频的起始时刻之前设定时长的历史音频输入到自动语音识别模型,输出所述历史音频对应的文本信息,其中,所述历史音频用于预测所述第一音频的第二情感类别。

在一种可能的实现方式中,所述自动语音识别(Automatic Speech Recognition,ASR)模型包括神经网络模型或者端到端模型。

具体的,所述神经网络模型可以为基于Kaldi开发的自动语音识别模型;其中,所述Kaldi是当前最流行的开源语音识别工具;所述神经网络模型包括具有深度结构的前馈神经网络的卷积神经网络(Convolutional Neural Networks,CNN)、长短期记忆网络(LongShort-Term Memory,LSTM)、Chain或者至少两种神经网络的融合网络;所述自动语音识别模型还可以为基于Espnet、Wav2letter++等端到端的开源框架,使用c2c、transformer等端到端网络训练的ASR模型。

在一种可能的实现方式中,所述自动语音识别模型只要是用于识别所述第一音频中的语音,得到所述语音对应的文本信息;具体的,所述自动语音识别目标是将人类的语音中的词汇内容转换为计算机可读的输入,例如,按键、二进制编码或者字符序列。

在一种可能的实现方式中,每段第一音频的时长可以为10ms,也可以为其它数值,由于自动语音识别模型的处理过程需要时间,例如,每次处理需要250ms;举例说明,每段10ms的第一音频中可能只包含一个字,则将第一音频和第一音频之前的音频同时输入到自动语音识别模型,输出所述第一音频对应的文本信息。

步骤S401、将所述文本信息输入到语义分析模型,输出所述文本信息对应候选情感类别。

具体的,所述语义分析模型包括XGBoost模型、聚类模型或者端到端模型。

本发明实施例中,由于需要一句话、几句话或者一段话才可以确定出所述一句话、几句话或者一段话所属的情感类别,根据一个字不能确定出情感类别,因此,无法简单的针对一段第一音频对应的文本信息确定情感类别,需要将所述一段第一音频对应的文本信息,和该第一音频之前多段音频对应的文本信息同时输入所述语义分析模型,然后确定出所述第一音频对应的候选情感类别。

在一种可能的实现方式中,由于语义分析模型的处理过程需要时间,例如,每次处理需要250ms;举例说明,每段10ms的音频中可能只包含一个字,获取该音频的情感类型,需要经过ASR模型和语义分析模型,假设共需要500ms,即在t0时刻获取的音频是用于预测t0+500ms时为起点的音频的情感类别。

步骤S402、将所述候选情感类别与所述历史音频之前N段音频对应的历史情感类别输入到情感预测模型,输出所述第一音频对应的第二情感类别,其中,N为大于或等于1的正整数。

具体的,所述情感预测模型为隐马尔可夫HMM模型。其中,所述隐马尔可夫HMM模型是统计模型,用来描述一个含有隐含未知参数的马尔可夫过程。

在一种可能的实现方式中,通过一段音频对应情感类别为无法准确的对第一音频的情感类别进行预测,因此需要将与所述第一音频之前N段音频对应的历史情感类别输入到情感预测模型,假设,情感预测模块里会存储[t0-20s,t0)时间段内的情感类别信息,则此段时间内包含2000个时间序列的情感类别,然后根据HMM模型预测当前时间段的情感类别,此处仅仅为示例性的说明,具体数据根据实际情况确定,本发明实施例对其不做限定。

本发明实施例中,上述处理过程中的输入数据根据时间的变化进行迭代更新。

在一种可能的实现方式中,从数据流向的角度进行描述,所述第一音频的处理过程还可以如图5所示,包括自动语音识别模块501、语义分析模块502、情感预测模块503以及语音情感处理模块301,其中,所述自动语音识别模块包括自动语音识别模型,所述语义分析模块包括语义分析模型,所述情感预测模块包括情感预测模型,通过自动语音识别模块501、语义分析模块502、情感预测模块503预测第一音频中音调的第二情感类别,当播放到第一音频时,首先通过语音情感处理模块对第一音频的第一情感类别与第二情感类别是否相同进行判断,若所述第一情感类别与第二情感类别不同,通过语音情感处理模块301对第二图像进行修改,然后所述语音情感处理模块301输出第二音频。

在一种可能的实现方式中,所述通过预先训练的情感转换模型,将所述第一音频的音调从所述第一情感类别修改为所述第二情感类别,生成第二音频,具体如图6所示,包括如下步骤:

步骤S600、确定所述第一音频的至少一个第一情感特征。

具体的,所述第一情感特征为矩阵参数。

步骤S601、根据所述预先训练的情感转换模型将所述至少一个第一情感特征转换为至少一个第二情感特征。

具体的,所述第二情感特征为所述第二情感特征。

步骤S602、将所述至少一个第二情感特征按照设定方法进行合成,生成第二音频。

具体的,所述设定方法为波形拼接、以及使用长短期记忆网络LSTM、循环神经网络RNN、Wavenet、或者Fastpitch进行参数合成。

在一种可能的实现方式中,所述情感转换模型的训练过程如图7所示,具体包括如下步骤:

步骤S700、获取历史源音频以及历史目标音频,其中,历史源音频的音调与所述历史目标音频的音调的情感类别不同。

步骤S701、根据所述历史源音频确定至少一个第一历史情感特征,以及根据所述历史目标音频确定至少一个第二历史情感特征。

具体的,对所述历史源音频进行特征提取,获取至少一个第一历史情感特征,所述第一历史情感特征为矩阵参数;同样的,对所述历史目标音频进行特征提取,获取至少一个第二历史情感特征,所述第二历史情感特征也为矩阵参数。

步骤S702、根据所述第一历史情感特征与所述第二历史情感特征训练所述情感转换模型。

具体的,将所述第一历史情感特征与所述第二历史情感特征进行对齐,然后进行训练,将所述第一历史情感特征作为输入,所述第二历史情感特征作为输出,训练所述情感转换模型的参数,获得训练后的情感转换模型。

图8是本发明实施例的一种音频处理的装置示意图。如图8所示,本实施例的装置包括获取单元801、确定单元802和处理单元803。

其中,获取单元801,用于获取第一音频;确定单元802,用于确定所述第一音频的第一情感类别;处理单元803,响应于所述第一情感类别与所述第一音频对应的第二情感类别不同,用于根据所述第二情感类别修改所述第一音频的音调,生成第二音频。

本发明实施例中,通过上述方法当第一音频中的音调影响交流效果时,通过与第一情感类别不同的第二情感类别修改第一音频中的音调,得到需要的音调,即有效的对人物的音调进行控制,提高了交流的效果。

图9是本发明实施例的电子设备的示意图。图9所示的电子设备为通用音频处理装置,其包括通用的计算机硬件结构,其至少包括处理器91和存储器92。处理器91和存储器92通过总线93连接。存储器92适于存储处理器91可执行的指令或程序。处理器91可以是独立的微处理器,也可以是一个或者多个微处理器集合。由此,处理器91通过执行存储器92所存储的指令,从而执行如上所述的本发明实施例的方法流程实现对于数据的处理和对于其它装置的控制。总线93将上述多个组件连接在一起,同时将上述组件连接到显示控制器94和显示装置以及输入/输出(I/O)装置95。输入/输出(I/O)装置95可以是鼠标、键盘、调制解调器、网络接口、触控输入装置、体感输入装置、打印机以及本领域公知的其他装置。典型地,输入/输出装置95通过输入/输出(I/O)控制器96与系统相连。

如本领域技术人员将意识到的,本发明实施例的各个方面可以被实现为系统、方法或计算机程序产品。因此,本发明实施例的各个方面可以采取如下形式:完全硬件实施方式、完全软件实施方式(包括固件、常驻软件、微代码等)或者在本文中通常可以都称为“电路”、“模块”或“系统”的将软件方面与硬件方面相结合的实施方式。此外,本发明实施例的各个方面可以采取如下形式:在一个或多个计算机可读介质中实现的计算机程序产品,计算机可读介质具有在其上实现的计算机可读程序代码。

可以利用一个或多个计算机可读介质的任意组合。计算机可读介质可以是计算机可读信号介质或计算机可读存储介质。计算机可读存储介质可以是如(但不限于)电子的、磁的、光学的、电磁的、红外的或半导体系统、设备或装置,或者前述的任意适当的组合。计算机可读存储介质的更具体的示例(非穷尽列举)将包括以下各项:具有一根或多根电线的电气连接、便携式计算机软盘、硬盘、随机存取存储器(RAM)、只读存储器(ROM)、可擦除可编程只读存储器(EPROM或闪速存储器)、光纤、便携式光盘只读存储器(CD-ROM)、光存储装置、磁存储装置或前述的任意适当的组合。在本发明实施例的上下文中,计算机可读存储介质可以为能够包含或存储由指令执行系统、设备或装置使用的程序或结合指令执行系统、设备或装置使用的程序的任意有形介质。

计算机可读信号介质可以包括传播的数据信号,所述传播的数据信号具有在其中如在基带中或作为载波的一部分实现的计算机可读程序代码。这样的传播的信号可以采用多种形式中的任何形式,包括但不限于:电磁的、光学的或其任何适当的组合。计算机可读信号介质可以是以下任意计算机可读介质:不是计算机可读存储介质,并且可以对由指令执行系统、设备或装置使用的或结合指令执行系统、设备或装置使用的程序进行通信、传播或传输。

可以使用包括但不限于无线、有线、光纤电缆、RF等或前述的任意适当组合的任意合适的介质来传送实现在计算机可读介质上的程序代码。

用于执行针对本发明实施例各方面的操作的计算机程序代码可以以一种或多种编程语言的任意组合来编写,所述编程语言包括:面向对象的编程语言如Java、Smalltalk、C++等;以及常规过程编程语言如“C”编程语言或类似的编程语言。程序代码可以作为独立软件包完全地在用户计算机上、部分地在用户计算机上执行;部分地在用户计算机上且部分地在远程计算机上执行;或者完全地在远程计算机或服务器上执行。在后一种情况下,可以将远程计算机通过包括局域网(LAN)或广域网(WAN)的任意类型的网络连接至用户计算机,或者可以与外部计算机进行连接(例如通过使用因特网服务供应商的因特网)。

上述根据本发明实施例的方法、设备(系统)和计算机程序产品的流程图图例和/或框图描述了本发明实施例的各个方面。将要理解的是,流程图图例和/或框图的每个块以及流程图图例和/或框图中的块的组合可以由计算机程序指令来实现。这些计算机程序指令可以被提供至通用计算机、专用计算机或其它可编程数据处理设备的处理器,以产生机器,使得(经由计算机或其它可编程数据处理设备的处理器执行的)指令创建用于实现流程图和/或框图块或块中指定的功能/动作的装置。

还可以将这些计算机程序指令存储在可以指导计算机、其它可编程数据处理设备或其它装置以特定方式运行的计算机可读介质中,使得在计算机可读介质中存储的指令产生包括实现在流程图和/或框图块或块中指定的功能/动作的指令的制品。

计算机程序指令还可以被加载至计算机、其它可编程数据处理设备或其它装置上,以使在计算机、其它可编程设备或其它装置上执行一系列可操作步骤来产生计算机实现的过程,使得在计算机或其它可编程设备上执行的指令提供用于实现在流程图和/或框图块或块中指定的功能/动作的过程。

以上所述仅为本发明的优选实施例,并不用于限制本发明,对于本领域技术人员而言,本发明可以有各种改动和变化。凡在本发明的精神和原理之内所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

- 终端支架及其控制方法、音频处理方法、音频处理系统、电子设备以及计算机可读存储介质

- 一种音频处理方法、装置、电子设备及可读存储介质