一种面向嵌入式平台的红外目标检测方法及系统

文献发布时间:2023-06-19 12:10:19

技术领域

本发明涉及计算机通信技术领域,特别是涉及一种面向嵌入式平台的红外目标检测方法及系统。

背景技术

目标检测是计算机视觉领域重要的研究内容,随着深度学习的快速发展,可见光环境下不断涌现出新的检测算法,其中主要分为Two-stage检测模型与One-stage检测模型。Two-stage检测模型主要包括R-CNN系列算法,通过生成建议区域,大大提高了检测精度;One-stage检测模型主要包括SSD(Single Shot MultiBox Detector)系列、YOLO(YouOnly Look Once)系列等,采用全局回归与分类的一步框架,在牺牲一定精度的同时,检测速度得到较大提升。上述两种检测模型都是基于预设锚点,虽然检测精度与速度得到很大提升,但是自身预设锚点的局限性也阻碍了检测模型的优化创新。为了解决这些问题,最近提出了Anchor-free检测模型,如CornerNet、Centernet等,不需预设锚点便能完成目标检测,带来了目标检测模型创新的新思路。

上述可见光环境下的目标检测算法十分依赖于光照充足的条件,无法满足光照不足场景下的目标检测要求。红外能够实现基于目标对红外光的反射和目标自身的热辐射进行成像,很好地突出目标,受光照强度条件的影响很小,可以覆盖大多数光照不足的场景。然而传统的红外图像检测算法是人工设计目标轮廓提取方法,需要设计精确的模板进行目标轮廓特征提取,对于复杂多变的背景会造成目标的漏检和定位不准情况,因此对设计人员的经验要求比较高,鲁棒性较差。基于深度学习的红外目标检测算法检测准确率高,但是需要高功耗GPU计算平台,无法满足嵌入式平台的实时性的要求。

发明内容

为了解决上述问题,本发明提出一种面向嵌入式平台的红外目标检测方法及系统,以YOLOv4模型为基础,利用深度可分离卷积替换原始网络中的普通卷积,利用YOLOv4的框架思路来提升网络的检测能力,从而提高检测算法的鲁棒性。

为实现上述目的,本发明的技术方案如下:

一种面向嵌入式平台的红外目标检测方法,所述方法包括:

获取待识别图像;

利用深度可分离卷积替换YOLOv4算法中标准卷积,对YOLOv4网络模型进行改进;

基于改进后的YOLOv4模型对所述待识别图像进行特征图提取;

基于预先定义的红外检测模型对多尺度的特征图进行检测,得到所述特征图对应的目标检测结果。

优选的,所述利用深度可分离卷积替换YOLOv4算法中标准卷积,对YOLOv4网络模型进行改进包括:

将YOLOv4网络模型中的标准卷积分解为深度可分离卷积中的深度卷积和逐点卷积;定义a为D

G

则深度可分离卷积的计算量为:

G

优选的,所述红外检测模型的预先定义包括:根据模型结构进行参数初始化得到初始红外模型,将可见光目标检测模型中各卷积层的参数传递给初始红外模型对应的卷积层;

从可见光目标检测模型中抽取红外物体检测的预训练模型,并在实际采集的红外数据集中进行微调,得到基于深度学习的红外检测模型。

优选的,所述基于预先定义的红外检测模型对特征图进行检测包括:将提取到的多尺寸特征图输入到红外检测模型的CSPDarknet53主干网络中;其中,所述CSPDarknet53是通过在YOLOv3的Darknet53主干网络的基础上添加CSP模块获得;

将浅层特征映射分为两部分,通过跨层次结构进行合并;通过PANet网络将高层特征的语义信息传播到低层网络并与浅层特征的高分辨率信息融合,将底层信息传播到高层网络中,将融合不同层的特征图进行预测,得到不同尺度的融合特征。

一种面向嵌入式平台的红外目标检测系统,所述系统包括:

获取模块,用于获取待识别图像;

改进模块,用于利用深度可分离卷积替换YOLOv4算法中标准卷积,对YOLOv4网络模型进行改进;

特征图提取模块,用于基于改进后的YOLOv4模型对所述待识别图像进行特征图提取;

目标检测模块,用于基于预先定义的红外检测模型对多尺度的特征图进行检测,得到所述特征图对应的目标检测结果。

优选的,所述改进模块包括:

分解模单元,用于将YOLOv4网络模型中的标准卷积分解为深度可分离卷积中的深度卷积和逐点卷积;

替换单元,用于定义a为D

G

则深度可分离卷积的计算量为:

G

优选的,所述目标检测模块包括:预定义单元,用于根据模型结构进行参数初始化得到初始红外模型,将可见光目标检测模型中各卷积层的参数传递给初始红外模型对应的卷积层;

从可见光目标检测模型中抽取红外物体检测的预训练模型,并在实际采集的红外数据集中进行微调,得到基于深度学习的红外检测模型。

进一步地,所述目标检测模块还包括:检测单元,用于将特征图提取模块提取到的多尺寸特征图输入到红外检测模型的CSPDarknet53主干网络中;其中,所述CSPDarknet53是通过在YOLOv3的Darknet53主干网络的基础上添加CSP模块获得;

融合单元,用于将浅层特征映射分为两部分,通过跨层次结构进行合并;通过PANet网络将高层特征的语义信息传播到低层网络并与浅层特征的高分辨率信息融合,将底层信息传播到高层网络中;

预测单元,用于将融合不同层的特征图进行预测,得到不同尺度的融合特征。

本发明的有益效果体现在:

本发明提供的一种面向嵌入式平台的红外目标检测方法及系统,通过获取待识别图像;利用深度可分离卷积替换YOLOv4算法中标准卷积,对YOLOv4网络模型进行改进;利用深度可分离卷积替换YOLOv4算法中标准卷积,在满足嵌入式平台计算能力的同时提高了检测速度。

基于改进后的YOLOv4模型对所述待识别图像进行特征图提取;基于预先定义的红外检测模型对多尺度的特征图进行检测,得到所述特征图对应的目标检测结果。实现了嵌入式平台对于多源图像的实时检测,保证决策级融合目标检测模型在嵌入式平台做到了精度与速度的良好平衡。无需人工设计精确的模板进行目标轮廓特征提取,解决了由于复杂多变的背景造成目标的漏检和定位不准情况,鲁棒性佳。

附图说明

为了更清楚地说明本发明具体实施方式或现有技术中的技术方案,下面将对具体实施方式或现有技术描述中所需要使用的附图作简单地介绍。在所有附图中,类似的元件或部分一般由类似的附图标记标识。附图中,各元件或部分并不一定按照实际的比例绘制。

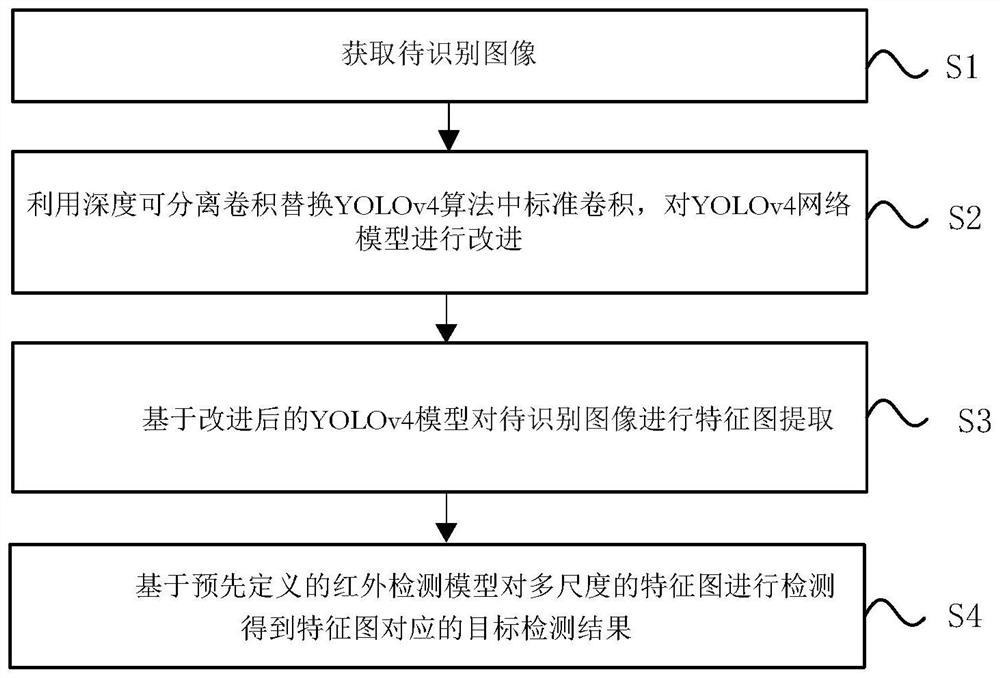

图1为本发明具体实施方式提供的一种面向嵌入式平台的红外目标检测方法流程图;

图2为本发明具体实施方式提供的深度可分离卷积示意图。

具体实施方式

下面将结合附图对本发明技术方案的实施例进行详细的描述。以下实施例仅用于更加清楚地说明本发明的技术方案,因此只作为示例,而不能以此来限制本发明的保护范围。

需要注意的是,除非另有说明,本申请使用的技术术语或者科学术语应当为本发明所属领域技术人员所理解的通常意义。

本发明具体实施方式提供如图1所示的一种面向嵌入式平台的红外目标检测方法,所述方法包括:

S1获取待识别图像;

S2利用深度可分离卷积替换YOLOv4算法中标准卷积,对YOLOv4网络模型进行改进;

S3基于改进后的YOLOv4模型对所述待识别图像进行特征图提取;

S4基于预先定义的红外检测模型对多尺度的特征图进行检测,得到所述特征图对应的目标检测结果。

步骤S2中,所述利用深度可分离卷积替换YOLOv4算法中标准卷积,对YOLOv4网络模型进行改进包括:

将YOLOv4网络模型中的标准卷积分解为深度可分离卷积中的深度卷积和逐点卷积;定义a为D

G

则深度可分离卷积的计算量为:

G

步骤S4中,所述红外检测模型的预先定义包括:根据模型结构进行参数初始化得到初始红外模型,将可见光目标检测模型中各卷积层的参数传递给初始红外模型对应的卷积层;

从可见光目标检测模型中抽取红外物体检测的预训练模型,并在实际采集的红外数据集中进行微调,得到基于深度学习的红外检测模型。

其中,红外检测模型检测原理包括:

红外检测模型继续沿用了YOLO目标的思想,将整张图像作为整个网络的输入,基于回归思想将目标识别与定位融合在一起。CSPDarkNet是YOLOv4使用的特征提取网络,吸收CSPNet的优势,在YOLOv3的主干网络DarkNet53中加入CSP模块,将浅层特征映射分为两部分,然后通过跨层次结构进行合并,在轻量化网络的同时保持检测准确性、降低计算瓶颈、降低内存成本。另外YOLOv4吸收PANet的优势,将高层特征的语义信息传播到低层网络并与浅层特征的高分辨率信息融合,提高小目标物体的检测效果;随后将底层信息传播到高层网络中,最后用融合不同层的特征图进行预测。

红外网络模型将标准卷积分解为深度可分离卷积中的深度卷积核逐点卷积,大幅度降低检测模型的参数量和计算量。运算分解如图2所示。

图2中,a为D

标准卷积计算量为:

G

深度可分离卷积计算量为:

G

将深度可分离卷积与标准卷积计算量做对比得:

当D

基于上述内容,对YOLOv4网络模型进行改进,采用深度可分离卷积替换标准卷积,减小模型的计算参数和大小。

由于检测目标的种类不同,可见光目标检测模型、红外目标检测模型的分类层必须重新设计,在网络的前向推理中,提取特征图进行预测,特征图尺寸分别为13*13*18,26*26*18。可见光目标检测模型的预训练模型一般建立在ImageNet、MS COCO训练过的模型,通过模型参数传递方式实现模型的快速收敛。

红外预训练模型的设计,首先根据模型结构进行参数初始化得到初始模型,同时为了充分利用可见光模型已具备的目标检测能力,将可见光模型中各卷积层的参数传递给红外模型对应的卷积层,实现参数共享。从上述的可见光检测模型抽取用于红外物体检测的预训练模型,并在红外数据集上进行微调,从而得到基于深度学习的红外检测模型。

步骤S4中,基于预先定义的红外检测模型对特征图进行检测包括:将提取到的多尺寸特征图输入到红外检测模型的CSPDarknet53主干网络中;其中,所述CSPDarknet53是通过在YOLOv3的Darknet53主干网络的基础上添加CSP模块获得;

将浅层特征映射分为两部分,通过跨层次结构进行合并;通过PANet网络将高层特征的语义信息传播到低层网络并与浅层特征的高分辨率信息融合,将底层信息传播到高层网络中,将融合不同层的特征图进行预测,得到不同尺度的融合特征。

实验结果分析:

实验硬件配置为NVIDIA的嵌入式平台Jetson TX2,实验数据采用FLIR公司车辆热红外数据集。针对红外检测模型的速度与精度进行实验,并与其他检测模型进行对比测试,实验结果如表1所示。

表1不同模型对比实验

实施例2:

基于同一技术构思,本发明还提供一种面向嵌入式平台的红外目标检测系统,包括:

获取模块,用于获取待识别图像;

改进模块,用于利用深度可分离卷积替换YOLOv4算法中标准卷积,对YOLOv4网络模型进行改进;

特征图提取模块,用于基于改进后的YOLOv4模型对所述待识别图像进行特征图提取;

目标检测模块,用于基于预先定义的红外检测模型对多尺度的特征图进行检测,得到所述特征图对应的目标检测结果。

其中,所述改进模块包括:

分解模单元,用于将YOLOv4网络模型中的标准卷积分解为深度可分离卷积中的深度卷积和逐点卷积;

替换单元,用于定义a为D

G

则深度可分离卷积的计算量为:

G

所述目标检测模块包括:预定义单元,用于根据模型结构进行参数初始化得到初始红外模型,将可见光目标检测模型中各卷积层的参数传递给初始红外模型对应的卷积层;

从可见光目标检测模型中抽取红外物体检测的预训练模型,并在实际采集的红外数据集中进行微调,得到基于深度学习的红外检测模型。

所述目标检测模块还包括:检测单元,用于将特征图提取模块提取到的多尺寸特征图输入到红外检测模型的CSPDarknet53主干网络中;其中,所述CSPDarknet53是通过在YOLOv3的Darknet53主干网络的基础上添加CSP模块获得;

融合单元,用于将浅层特征映射分为两部分,通过跨层次结构进行合并;通过PANet网络将高层特征的语义信息传播到低层网络并与浅层特征的高分辨率信息融合,将底层信息传播到高层网络中;

预测单元,用于将融合不同层的特征图进行预测,得到不同尺度的融合特征。

最后应说明的是:以上各实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述各实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分或者全部技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的范围,其均应涵盖在本发明的权利要求和说明书的范围当中。

- 一种面向嵌入式平台的红外目标检测方法及系统

- 一种面向点目标的红外焦平面盲元动态检测方法