基于深度强化学习的电动汽车低碳充放电调度方法

文献发布时间:2023-06-19 18:27:32

技术领域

本发明涉及电力调度技术领域,特别涉及一种基于深度强化学习的电动汽车低碳充放点调度方法。

背景技术

据相关统计分析,显示电力系统通过燃烧化石燃料等方式产生了全球15%的碳排放量,减少电力系统碳排放量将为绿色可持续发展产生巨大推力。而为了实现电力系统的碳减排,根本手段是能源替代——通过大规模的可再生能源替代煤炭等化石能源进行发电以有效减少碳排放。

但是,以风光为代表的可再生能源因随机性会降低系统运行性能,故需要与储能系统相配合,通过设置储能系统,能够提高新能源上网率,同时优化系统潮流分布、支持系统调频调峰,可极大地提升系统运行性能;而随着电动汽车渗透率迅速提高,其对电网运行的影响已不可忽视,同时,电动汽车具有单机容量较大、响应速度快、接入系统的时间具有一定规律性等特点,具有进行灵活调度的巨大潜力,可以将电动汽车作为系统可调度储能设备,用以平抑风电、光电等可再生能源的随机性和波动性给系统运行造成的负面影响,从而实现系统运行优化,提高风电、光电的利用率,进而降低系统碳排放量。

不过,如何在满足电动汽车的充电需求的前提下,通过对电动汽车的充放电过程调度来优化系统运行,有效消纳系统内的可再生能源,降低系统运行的碳排放量是亟待解决的问题。

发明内容

基于现有技术亟待解决的问题,本发明提供一种基于深度强化学习的电动汽车低碳充放点调度方法,通过电动汽车、系统储能设备与补偿设备的协调配合,以最小化碳排放为目标,在考虑避免电动汽车(EV)随机接入引起系统过载的约束下,采用深度强化学习算法(TD3)求解模型,得到优化的电动汽车、系统储能设施充放电优化控制策略;能够在满足电动汽车的充电需求的前提下通过控制电动汽车的充放电过程优化系统运行,有效消纳系统内的可再生能源,降低系统运行的碳排放量。

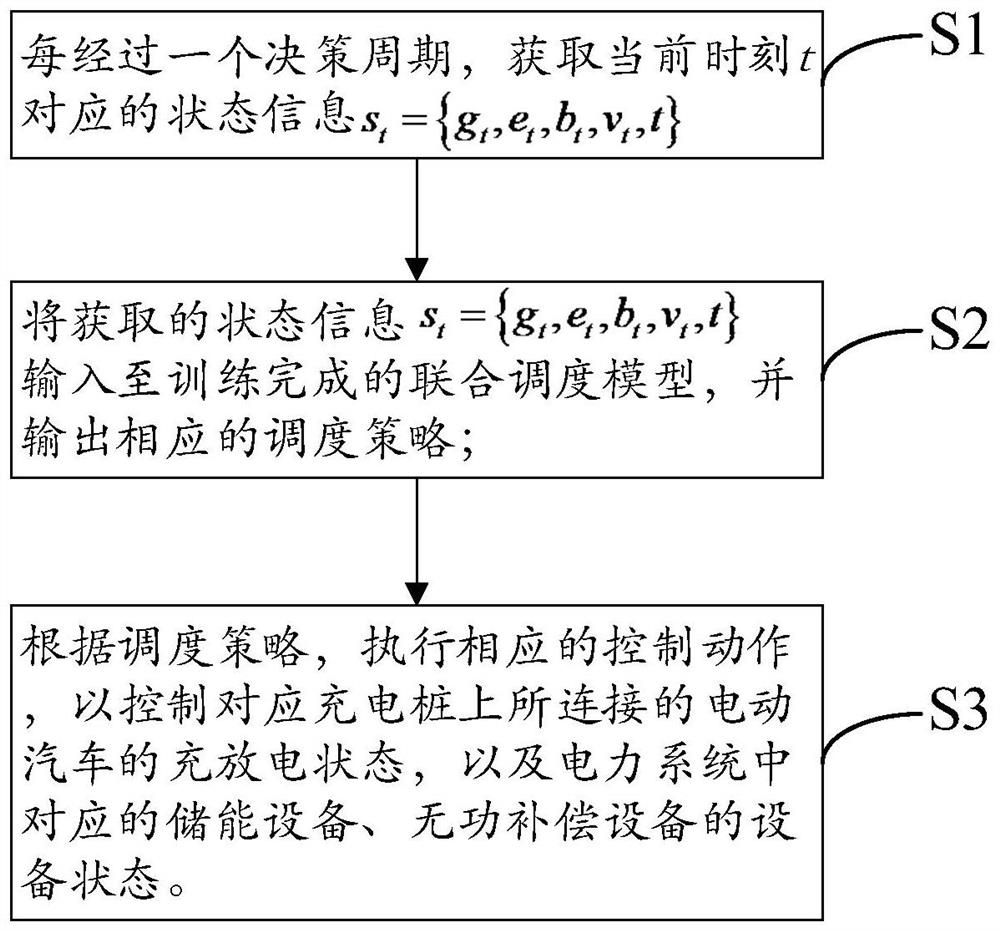

本发明提供的基于深度强化学习的电动汽车低碳充放电调度方法,其包括以下步骤:

S1:每经过一个决策周期,获取当前时刻t对应的状态信息s

S2:将获取的状态信息s

S3:根据所述调度策略,执行相应的控制动作,以控制对应充电桩上所连接的电动汽车的充放电状态,以及电力系统中对应的储能设备、无功补偿设备的设备状态。

根据一种可能的实施方式,以碳排放量最小为目标,其目标函数被配置为:

其中,m

根据一种可能的实施方式,所述状态信息s

根据一种可能的实施方式,所述状态信息s

储能设备在运行过程中发生折旧所分配对应的经济成本分别为:

m

w

其中,m

根据一种可能的实施方式,所述状态信息s

无功补偿设备在运行过程中发生折旧所分配对应的经济成本分别为:

m

w

其中,m

根据一种可能的实施方式,基于TD3算法训练智能体时,还基于TD3算法的特点,将所述目标函数改造为:

式中,β表示智能体在训练过程中探索环境时所采取的动作策略;ρ

根据一种可能的实施方式,基于TD3算法训练智能体过程中,算法交替进行策略评估和策略改进;其中,

在策略评估阶段,需要计算状态-动作价值,即Q

Q

利用神经网络将Q函数参数化后,通过最小化Bellman残差来近似Q函数:

其中,θ

在策略改进阶段,利用神经网络将Q函数参数化后,将最小化目标函数J

根据一种可能的实施方式,基于TD3算法训练智能体过程中,还通过两个初始参数不同的Target Q网络来进行目标价值评估,并选择其中的较小值作为目标价值,因此,需最小化的Bellman残差修正为:

其中,

以及,使用目标策略平滑正则化,以增强策略的稳定性并平滑Q函数;即在计算Bellman残差时,在下一状态s

其中,μ表示Target策略网络;ε为添加的噪音,一般选为高斯噪音,并对其幅值进行剪切以限制在一个较小的范围。

根据一种可能的实施方式,配置智能体输出参数a

z=tanh(a

根据一种可能的实施方式,罚函数h

h

h

其中,a

附图说明:

图1为本发明方法的示意图;

图2为火电机组发电标准耗煤率与机组负荷的关系示意图;

图3为电动汽车采用的压缩高斯策略对应的概率图;

图4为仿真实验中的配电系统的架构示意图;

图5为关于碳排放量和各类成本的仿真结果示意图;

图6为TD3算法、DDPG算法训练智能体的效果对比图;

图7为训练过程中对智能体惩罚次数的统计图;

图8为训练过程中配电网系统发生电压越限次数的统计图。。

具体实施方式

下面结合附图及具体实施例对本发明作进一步的详细描述。但不应将此理解为本发明上述主题的范围仅限于以下的实施例,凡基于本发明内容所实现的技术均属于本发明的范围。

在本发明的一个实施例中,如图1所示,本发明基于深度强化学习的电动汽车低碳充放电调度方法,其包括以下步骤:

S1:每经过一个决策周期,获取当前时刻t对应的状态信息s

S2:将获取的状态信息s

S3:根据所述调度策略,执行相应的控制动作,以控制对应充电桩上所连接的电动汽车的充放电状态,以及电力系统中对应的储能设备、无功补偿设备的设备状态。

在本实施例中,由于马尔科夫决策过程能够用于描述一系列历史无关的状态转移过程,下一状态仅取决于当前状态和当前所执行的动作。对于本发明所研究的联合调度问题,若将每个决策周期内的电源、负载及其它不受调度策略控制的量近似视为常数,则联合调度模型成为一个序贯模型,并能够进一步转化为一个MDP模型,从而能够使用强化学习算法求解。

具体的,一个典型的马尔科夫决策过程可以用一个五元组{S,A,R,P,γ}表示,其中S代表状态空间集合,A代表动作空间集合,R代表回报空间集合,P 代表状态转移概率集合,γ代表回报折扣率;本发明以碳排放量为最小的联合调度问题,可确定MDP对应的五元组为:

(1)S:State是智能体能够感知到的环境信息,该信息将被作为智能体的输入信息以生成一个策略或动作。定义在时刻t的State为:

s

其中,g

(2)A:Action是智能体在感知到状态s

a

其中,α

(3)R:当智能体执行策略(或动作)后,能够从环境获得一定的回报,该回报值将被用以评估所采取的策略(或动作)的好坏。本发明中,Reward被定义为:

r

其中,p

(4)P:Probability代表状态转移概率。当智能体生成并执行一个策略(或动作)后,环境将根据该策略控制其中的各个对象进行交互,并过渡到下一状态。在这个过程中,由于环境自身存在的不确定性,将导致交互过程和过渡到的下一状态产生变化,因此,一般用一个状态转移概率矩阵P表示执行策略后转移到各个状态的概率。在本发明研究的模型中,由于下一时刻接入系统的电动汽车以及风光发电系统的出力是不确定的,因此即便采取相同的策略,下一时刻的状态对于智能体而言依旧是不确定的。该概率矩阵P通过对环境进行蒙特卡洛采样隐式地生成。

(5)γ:折扣因子γ用以描述在未来能够获得的回报的重要性。当经历一个完整的马尔科夫决策过程后,对应的将产生一条马尔科夫链,或等价地形成一条“轨迹”,经历这条“轨迹”将产生一个回报:

需要指出的是,一方面,由于存在状态转移概率,未来的回报是难以准确估计的,因此其重要性略低于当前的回报,而另一方面,当存在稀疏奖励时,一个状态的价值与最终结果密切相关,所以,在较远之后的回报需要乘以一个折扣因子,从而得到:

式中,γ的取值范围为[0,1]。γ的取值越小,智能体越关心当前策略(或动作) 能够获得的回报,表现为短视,但训练过程收敛相对较快;γ的取值越大,智能体越注重策略(或动作)在未来能够获得的回报,表现为远见,但训练过程收敛缓慢,且可能存在饱和的问题。

一般地,γ可取值为0.9,或设轨迹的平均步长为n,则推荐的γ取值为:

在本实施例中,以碳排放量最小为目标,其目标函数被配置为:

其中,m

由于火电机组在运行过程中将消耗燃料并产生一定的碳排放,并受到运行功率的影响。一般地,机组在低功率运行时生产一单位电力将消耗更多的燃料。如图2所示的火电机组的煤耗率与机组负荷的关系,通过该曲线,可以折算出一定负荷下,机组的碳排放量:

c

式中,P

火电机组的运行成本及调频成本为:

m

w

式中,m

具体的,所述状态信息s

将电动汽车的充放电过程分别由以下方程描述:

式中,e

b

所述状态信息s

同时,储能设备在运行过程中发生折旧所分配对应的经济成本分别为:

m

w

其中,m

无功补偿设备在运行过程中发生折旧所分配对应的经济成本分别为:

m

w

其中,m

在本实施例中,基于TD3算法训练智能体时,还基于TD3算法的特点,将所述目标函数改造为:

其中,β表示智能体在训练过程中探索环境时所采取的动作策略;ρ

而且,在TD3算法训练智能体过程中,算法交替进行策略评估和策略改进;其中,

在策略评估阶段,需要计算状态-动作价值,即Q

Q

利用神经网络将Q函数参数化后,通过最小化Bellman残差来近似Q函数:

其中,θ

在策略改进阶段,利用神经网络将Q函数参数化后,将最小化目标函数J

而且,为了减小因Q函数尚未稳定就更新策略引起的震荡和误差,采用策略延迟更新技术,令策略改进阶段发生的频率低于策略评估阶段发生的频率,即智能体每次和环境进行交互时都进行策略评估,但仅在行一定次数的交互后再进行一次策略改进。

在本实施例中,基于TD3算法训练智能体过程中,为了解决训练过程中Q 值网络的过估计问题和平滑Q函数,使用双Q值网络和目标策略平滑正则化技术。具体的,通过两个初始参数不同的Target Q网络来进行目标价值评估,并选择其中的较小值作为目标价值,因此,需最小化的Bellman残差修正为:

其中,

以及,使用目标策略平滑正则化,以增强策略的稳定性并平滑Q函数;即在计算Bellman残差时,在下一状态s

其中,μ表示Target策略网络;ε为添加的噪音,一般选为高斯噪音,并对其幅值进行剪切以限制在一个较小的范围。通过为动作添加噪音,使计算 Bellman残差时该动作的Q值能够收敛到邻域内动作的Q值的期望,从而平滑 Q函数。利用经平滑的Q函数引导策略网络更新,能够有效避免因Q函数梯度过大导致的策略网络参数更新过快,从而增强策略网络的稳定性。

在本实施例中,由于智能体输出的动作向量a

z=tanh(a

通过以上操作,策略网络的输出被映射为高斯分布,实际动作的选择概率等价于该高斯分布经压缩变换后在三个区间上的概率密度函数的积分。如图3 所示,灰色条纹阴影和蓝色条纹阴影区域的面积分别代表了车辆执行放电和充电动作的概率,阴影面积受参数a

在本实施例中,罚函数根据不同对象进行设置,当智能体输出策略与车辆网络的允许的动作空间不符时,需要对该不当行为进行惩罚;对于储能设备,由于其始终接入配电网,故仅需要对可能导致其电池电量发生越限的操作进行惩罚;因此,设置罚函数h

h

h

其中,a

为进一步验证本发明基于深度强化学习的电动汽车低碳充放电调度方法的有效性,进行仿真实验。具体的,选择IEEE 33节点配电系统作为仿真计算的原型,并在此基础上做出部分调整。如图4所示,分别在第6、24节点设置一风力发电机组和光伏发电系统,在第10和16节点各设置一储能设备,在第18和 23节点设置静止无功补偿器;在第11和30节点设置电动汽车充电站。

其中,风力发电机组和光伏发电系统的出力数据来自于Elia.be对AggregateBelgian Wind Farms和Belgium地区在01/06/2021-30/06/2021期间的预测,并乘以适当的比例系数以适应配电系统的容量;基准电量边际排放因子根据《2019 年度减排项目中国区域电网基准线排放因子》取为0.8953t/MWh,碳价格按照欧洲气候交易所21/02/2022-23/02/2022的交易均价取为91.38€/t,并按照国际汇率6.99¥/€进行折算。

实验中仿真步长取为1h,Actor、Critic网络的学习率及Target网络的更新权重分别设置为10-5,3.0×10-5,10-3,折扣因子γ取为0.98,batch size设置为128,BufferSize取为105。

本实验基于Python及Tensorflow 2.0框架进行,所使用的计算机配置Inter Corei5-9300H CPU@2.40GHz及1张NVIDIA GTX 1660Ti GPU。

对联合调度模型进行为期一周的仿真训练,经5000个训练回合后,模型收敛;如图5所示,在训练初期,控制策略变化较为剧烈,系统的碳排放量及各类成本具有较强的波动。在约2000个训练回合后,模型逐渐稳定并开始收敛,系统的碳排放量下降至20t附近,总运行成本(折算为碳排放量,后同)约为 21t,对比图5,较为理想的碳排放量与运行成本分别为15.3t与17.2t,两者相差较大。出现这种现象的原因在于,TD3算法在训练过程中需要引入噪声进行策略探索,本发明所使用的噪声为N(0,0.09),将对智能体在性能稳定后输出的策略造成较大的干扰。这也是模型在约1000个回合时短暂出现在训练后期也未能达到的低总成本和低碳排放量得到原因。尽管如此,从图6依旧能够看出,随着训练回合的增加,模型能够不断地执行为优秀的调度控制策略,证明了模型性能的收敛性和鲁棒性。

图6使用的数据来自于训练过程中的测试回合(即在不添加噪音也不进行学习的情况下进行调度控制测试,设定为每10个训练回合进行一次)。同时,为了验证TD3算法的性能,使用DDPG算法作为对比算法,在相同随机种子的情况下进行仿真实验,所得数据同样绘制于图7中。可以看出TD3算法对应生成的调度控制策略较为稳定,系统的碳排放量及总成本曲线以平稳的方式下降,整体波动小;DDPG算法得到的控制策略稳定性一般,训练期间系统的碳排放量及总成本在较大的范围内波动,另外,DDPG算法也难以收敛到最优调度策略。此外,随着训练回合的增加,基于TD3算法的模型使系统最终的碳排放量降低到约14.8t,总成本降低到约16.2t,相较于图5的保守控制策略,实现了碳排放量(或总成本)的有效降低。另外,图5中,系统调频成本和总运行成本约为常数,表明仅通过无功补偿设备进行调节带来的收益非常有限,这证明了图7中约6%的相对成本节省是通过训练的智能体依据系统运行情况对电动汽车和储能设备进行合理的时间调度规划所实现的,同时也证明了电动汽车参与调度能够有效提升系统运行性能。

图7展示了训练过程中对智能体的不当行为的惩罚值。从图中可以较为明确地看出,通过不断的学习和交互,智能体发出错误决策的次数不断减少,最终接近无错误,证明了智能体能够有效识别车辆和储能电池的SoC,并能够根据SoC避免做出有害于电池寿命及系统运行状态的决策。

图8展示的是训练过程中系统发生电压越限的次数的情况。当电动汽车在高峰期大量涌入时,将会对电力系统造成较大的冲击,可能导致系统发生电压越限。由于本发明的研究目标是在保证经济性的前提下降低系统碳排放量,因此智能体将会尽可能将高峰期涌入的电动汽车分配到各个时间段进行有序充放电以优化系统运行,这能够有效避免因大量负荷集中接入所引起的系统电压越限。如图中所示,在采取保守控制策略的情况下以及约前2500个训练回合中,由于电动汽车的集中性接入以及调度策略的不完善,在为期一周的调度中,系统总是会发生两次电压越限,但经过不断地学习,系统发生电压越限的频次不断减少,证明了本发明所提方法及模型在优化系统运行方面的有效性。

以上所述仅为本发明的较佳实施例而已,并不用以限制本发明,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

- 一种基于深度强化学习的智能电动汽车充放电决策方法

- 一种基于深度强化学习的共享电动汽车调度方法