信息处理装置、信息处理方法和信息处理程序

文献发布时间:2024-01-17 01:27:33

技术领域

本公开涉及一种信息处理装置、信息处理方法和信息处理程序。

背景技术

近年来,其中车辆控制系统(信息处理系统)控制车辆的自动驾驶技术的开发已经被积极地进行。即使在自动驾驶技术普及的情况下,也预期到会发生以下状况:取决于实际的道路基础设施维护状况等,作为系统可能自主执行自动驾驶控制的道路区间的可自动驾驶区间和作为不容许自动驾驶的道路区间的手动驾驶区间相混合。即,不仅可能会发生完全自主地由系统连续地执行自动驾驶行驶的状况,还可能会发生必须将上述的自动驾驶模式切换到由驾驶员执行操舵的手动驾驶模式的情况。

当以这种方式将自动驾驶模式切换到手动驾驶模式时,为了避免事故等的诱发,希望系统侧判定驾驶员到手动驾驶模式的返回响应等级,并且仅当判定可以返回到手动驾驶时才执行切换。因此,例如,在上述系统中,可以设想作为返回响应等级的判定手段之一,使用用于通过解析被认为反映诸如人脑的识别等活动结果的眼球行为来检测驾驶员的觉醒等级并判定到手动驾驶模式的返回响应等级的手段。

引用文献列表

专利文献

专利文献1:WO 2017/195405 A

发明内容

技术问题

顺便要说的是,由于诸如微扫视和震颤等眼球行为是高速运动,因此难以高精度地观测这种眼球行为。因此,可以设想使用不具有帧速率的概念的事件视觉传感器(EVS)来观测眼球行为。然而,难以简单地通过将EVS适用于眼球行为的观测来避免数据量的增加。此外,在精确地观测眼球行为方面存在限制。

因此,本公开提出了一种在抑制数据量增加的同时能够精确地观测眼球行为的信息处理装置、信息处理方法和信息处理程序。

问题的解决方案

根据本公开,提供了一种信息处理装置,包括:对移动体的内部进行成像的事件视觉传感器;和控制所述事件视觉传感器的传感器控制单元,其中所述事件视觉传感器包括:像素阵列单元,所述像素阵列单元包括以矩阵状排列的多个像素;和事件检测单元,所述事件检测单元检测在所述像素中由于入射光引起的亮度变化量超过预定阈值,和当利用所述事件视觉传感器捕捉坐在所述移动体的驾驶位上的驾驶员的眼球行为时,所述传感器控制单元改变所述预定阈值的值。

此外,根据本公开,提供了一种在信息处理装置中执行的信息处理方法。所述信息处理装置包括:对移动体的内部进行成像的事件视觉传感器;和控制所述事件视觉传感器的传感器控制单元,所述事件视觉传感器包括:像素阵列单元,所述像素阵列单元包括以矩阵状排列的多个像素;和事件检测单元,所述事件检测单元检测在所述像素中由于入射光引起的亮度变化量超过预定阈值,所述信息处理方法包括当利用所述事件视觉传感器捕捉坐在所述移动体的驾驶位上的驾驶员的眼球行为时,改变所述预定阈值的值。

此外,根据本公开,提供了一种信息处理程序,用于使计算机执行对移动体的内部进行成像的事件视觉传感器的控制功能,所述事件视觉传感器包括:像素阵列单元,所述像素阵列单元包括以矩阵状排列的多个像素;和事件检测单元,所述事件检测单元检测在所述像素中由于入射光引起的亮度变化量超过预定阈值,所述信息处理程序使所述计算机执行当利用所述事件视觉传感器捕捉坐在所述移动体的驾驶位上的驾驶员的眼球行为时改变所述预定阈值的值的功能。

附图说明

图1是用于说明自动驾驶等级的示例的说明图。

图2是用于说明根据本公开实施方案的行驶的示例的流程图。

图3是用于说明根据本公开实施方案的自动驾驶等级的迁移的示例的说明图。

图4是示出根据本公开实施方案的监控操作的示例的流程图。

图5是用于说明根据本公开实施方案的车辆控制系统100的详细构成的示例的说明图。

图6是示出包括在传感器单元113中的成像装置的安装位置的示例的图。

图7是用于说明包括在传感器单元113中的各种传感器的示例的说明图。

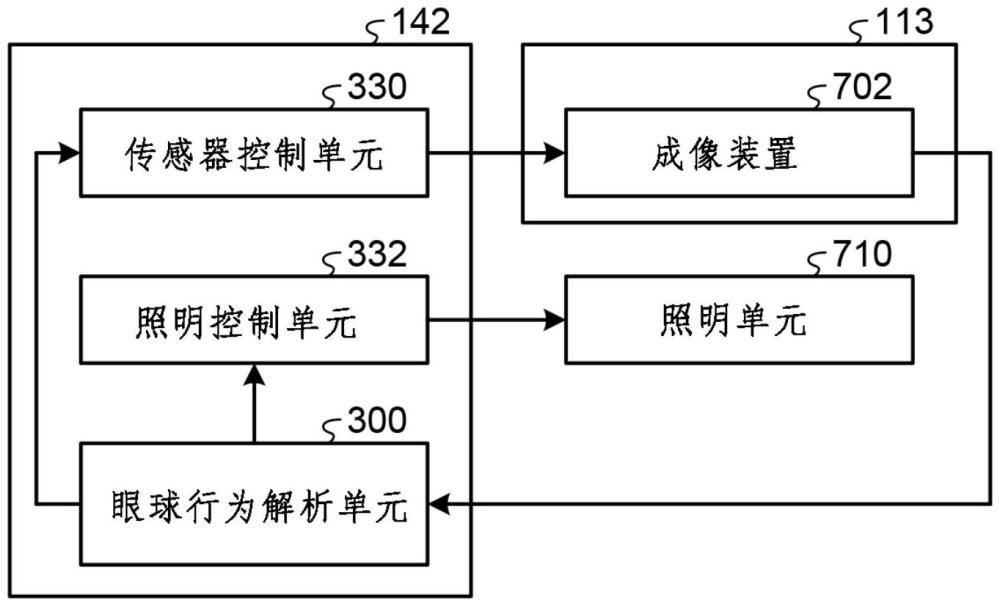

图8是用于说明根据本公开实施方案的执行驾驶员的觉醒等级的判定的单元的示例的说明图。

图9是用于说明根据本公开实施方案的眼球行为解析单元300的操作例的细节的说明图。

图10是示出在本公开的实施方案中使用的EVS 400的构成的示例的框图。

图11是示出位于图10所示的EVS 400中的像素阵列单元500中的像素502的构成的示例的框图。

图12是用于说明根据本公开实施方案的成像装置700和702的安装位置的说明图(之1)。

图13是用于说明根据本公开实施方案的成像装置700和702的安装位置的说明图(之2)。

图14是用于说明根据本公开实施方案的成像装置700和702的安装位置的说明图(之3)。

图15是用于说明根据本公开实施方案的执行驾驶员的眼球行为的观测的单元的示例的说明图。

图16是用于说明根据本公开实施方案的信息处理方法的示例的流程图(之1)。

图17是用于说明根据本公开实施方案的信息处理方法的示例的流程图(之2)。

图18是用于说明由成像装置702观测到的观测数据的示例的说明图。

图19是用于说明车辆控制系统100的用于执行驾驶员的觉醒度的判定处理的部分构成的说明图。

图20是用于说明当提出观看信息的视觉问题时的驾驶员的眼球行为的轨迹的示例的说明图。

图21是用于驾驶员的觉醒等级判定处理的信息处理方法的流程图(之1)。

图22是用于驾驶员的觉醒等级判定处理的信息处理方法的流程图(之2)。

图23是示出实现自动驾驶控制单元112的至少一部分功能的计算机1000的示例的硬件构成图。

具体实施方式

以下参照附图详细说明本公开的优选实施方案。注意,在本说明书和附图中,具有实质上相同的功能构成的构成要素由相同的附图标记和符号表示,从而省略了对该构成要素的重复说明。

注意,在本公开的实施方案中,以本公开适用于汽车的自动驾驶的情况为例进行了说明。然而,本公开的实施方案不限于适用于汽车,并且可以适用于诸如汽车、电动车辆、混合动力电动车辆、摩托车、个人移动装置、飞机、船舶、建筑机械和农业机械(拖拉机)等移动体。此外,在本公开的实施方案中,假设移动体的操舵模式可在自动驾驶模式和用于自动执行一种以上的驾驶任务的自动驾驶模式之间切换。此外,本发明的实施方案不限于适用于移动体,并且可以广泛地应用于监控操作员需要适宜干预的自动控制装置。

注意,按照以下顺序进行说明。

1.自动驾驶等级的示例

2.行驶的示例

3.自动驾驶等级的迁移的示例

4.监控的示例

5.车辆控制系统的详细构成

6.传感器单元113的示意性构成

7.执行驾驶员的觉醒等级的判定的单元的示意性构成

8.眼球行为解析单元300的操作例

9.导致本公开实施方案的创建的背景

9.1使用EVS

9.2EVS

9.3导致本公开实施方案的创建的背景

10.实施方案

10.1 安装位置

10.2 单元的构成

10.3 信息处理方法

10.4 实施例

11.概述

12.硬件构成

13.补充

<<1.自动驾驶等级的示例>>

首先,在说明本公开的实施方案的细节之前,参照图1来说明自动驾驶技术的自动驾驶等级。图1是用于说明自动驾驶等级的示例的说明图。图1示出了由SAE(汽车工程师协会)定义的自动驾驶等级。注意,在以下的说明中,基本上参照了由SAE定义的自动驾驶等级。然而,在图1所示的自动驾驶等级的研究中,没有彻底核查自动驾驶技术广泛普及的情况下的问题和有效性。因此,在以下的说明中,基于这些问题等,存在着不必须由SAE中所定义的解释来说明的一些部分。

在本说明书中,车辆行驶不是大致分为上述的手动驾驶和自动驾驶两种类型,而是根据由系统侧自动执行的任务的内容分阶段地进行分类。例如,如图1所示,假设自动驾驶等级被分类为例如从等级0至等级4的五个阶段(注意,当包括无人自动驾驶是可能的等级时,被分类为六个阶段),自动驾驶等级0是没有车辆控制系统的驾驶辅助的手动驾驶(驾驶员的直接驾驶操舵)。驾驶员执行所有驾驶任务,并且还执行与安全驾驶(例如,避免危险的行动)有关的监控。

接下来,自动驾驶等级1是其中可以执行车辆控制系统的驾驶辅助(自动制动、ACC(自适应巡航控制)、LKAS(车道保持辅助系统)等)的手动驾驶(直接驾驶操舵)。在自动驾驶等级1中,驾驶员执行辅助的单一功能以外的所有驾驶任务,并且还执行与安全驾驶有关的监控。

接下来,自动驾驶等级2也被称为“部分驾驶自动化”。在自动驾驶等级2中,车辆控制系统在特定条件下执行与车辆的前后方向和左右方向这两者上的车辆控制相关的驾驶任务的子任务。例如,在自动驾驶等级2中,车辆控制系统协同地控制转向操作和加减速这二者(例如,ACC和LKAS之间的协同)。然而,即使在自动驾驶等级2中,驾驶任务的执行主体也基本上是驾驶员,并且与安全驾驶相关的监控的主体也是驾驶员。

自动驾驶等级3也被称为“有条件自动驾驶”。在自动驾驶等级3中,车辆控制系统可以在其中用于使车辆控制系统能够针对车辆上搭载的功能采取应对的条件得到满足的受限区域内执行所有驾驶任务。在自动驾驶等级3中,驾驶任务的执行主体是车辆控制系统,并且与安全驾驶相关的监控的主体也基本上是车辆控制系统。然而,在该等级中,车辆控制系统不被要求在所有状况下都采取应对。期望初步应对时的利用者(驾驶员)适宜地响应车辆控制系统的干预请求等。在某些情况下,要求利用者针对车辆控制系统不能自主发现的被称为无声故障(silent failure)的系统故障采取应对。

顺便要说的是,在由SAE定义的自动驾驶等级3中,没有明确定义驾驶员能够实际执行何种次级任务(这里,“次级任务”是指在行驶期间由驾驶员执行的与驾驶有关的操作以外的操作)。具体地,考虑到驾驶员在自动驾驶等级3的行驶期间可以执行诸如操舵以外的作业和行动等次级任务,例如,移动终端的操作、电话会议、视频鉴赏、阅读、游戏、思考和与其他乘客的交谈。另一方面,在SAE的自动驾驶等级3的定义的范围内,期望驾驶员响应于由于系统故障、行驶环境的恶化等引起的来自车辆控制系统侧的请求等而适宜地采取例如执行驾驶操作的应对。因此,在自动驾驶等级3中,为了确保安全行驶,即使在执行上述次级任务的状况下,也期望驾驶员始终保持其中驾驶员能够立即返回到手动驾驶的准备状态。

此外,自动驾驶等级4也被称为“高级驾驶自动化”。在自动驾驶等级4中,车辆控制系统在受限区域内执行所有驾驶任务。在自动驾驶等级4中,驾驶任务的执行主体是车辆控制系统,并且与安全驾驶相关的监控的主体也是车辆控制系统。然而,在自动驾驶等级4中,与上述的自动驾驶等级3不同,不期望驾驶员响应于由于系统故障等引起的来自车辆控制系统侧的请求等而采取例如执行驾驶操作(手动驾驶)的应对。因此,在自动驾驶等级4中,驾驶员能够执行上述的次级任务,并且取决于状况,例如,驾驶员能够在满足条件的区间小睡一下。

如上所述,在自动驾驶等级0至自动驾驶等级2中,驾驶员在其中驾驶员独立地执行全部或部分驾驶任务的手动驾驶模式下行驶。因此,在这三个自动驾驶等级中,驾驶员不被允许从事例如在行驶期间会降低注意力或削弱前方注意力的作为手动驾驶和与之相关行动的以外的行为的次级任务。

另一方面,在自动驾驶等级3中,驾驶员在其中车辆控制系统独立地执行所有驾驶任务的自动驾驶模式下行驶。然而,如上所述,在自动驾驶等级3中,可能会出现驾驶员执行驾驶操作的状况。因此,在自动驾驶等级3中,当允许驾驶员执行次级任务时,要求驾驶员处于驾驶员能够从次级任务返回到手动驾驶的准备状态。

此外,当假设满足允许以自动驾驶等级4的车辆行驶的状况时,驾驶员在其中车辆控制系统执行所有驾驶任务的自动驾驶模式下行驶。然而,由于状况根据实际道路基础设施中的维护情况等而动态变化,因此在行驶行程的途中有时会发现其中自动驾驶等级4不能适用于行驶路线的一部分的区间。在这种情况下,例如,在接近并进入相关区间之前,要求驾驶员将该区间设定并迁移为根据条件识别的自动驾驶等级2以下。然后,在以这种方式设定为自动驾驶等级2以下的区间中,要求驾驶员独立地执行驾驶任务。即,即使在自动驾驶等级4中,由于上述的在行程的途中状况时刻地变化,甚至在预先作为自动驾驶等级4规划的行程的途中,因此实际上可能会发生向自动驾驶等级2以下的迁移。因此,要求驾驶员转移到准备状态,在该准备状态中,在向驾驶员通知自动驾驶等级的迁移之后,驾驶员可以在适宜的预先通知时机从次级任务返回到手动驾驶。

<<2.行驶的示例>>

接下来,基于上述的自动驾驶等级,参照图2说明根据本公开实施方案的行驶的示例。图2是用于说明根据本公开实施方案的行驶的示例的流程图。如图2所示,在根据本公开实施方案的行驶中,车辆控制系统执行例如从步骤S11至步骤S18的步骤。这些步骤的细节将在下面进行说明。

首先,车辆控制系统执行驾驶员认证(步骤S11)。驾驶员认证可以通过驾驶执照、车辆钥匙(包括便携式无线设备)等的持有认证、密码、个人识别号等的知识认证、或者面部、指纹、瞳孔的虹膜、声纹等的生物特征认证来执行。此外,在本实施方案中,可以通过使用持有认证、知识认证和生物特征认证中的全部或者两个以上来执行驾驶员认证。在本实施方案中,通过在开始行驶之前执行这样的驾驶员认证,即使当多个驾驶员驾驶同一车辆时,也可以与各驾驶员相关联地获取各驾驶员特有的信息,例如各驾驶员的眼球行为的履历。注意,在本实施方案中,当多个乘客(搭乘者)搭乘车辆并且多个乘客可以成为驾驶员时,优选对所有驾驶员执行认证。

随后,例如,由驾驶员等操作下面说明的输入单元101(参照图3),从而设定目的地(步骤S12)。注意,这里说明了其中驾驶员上车并设定目的地的示例。然而,本公开的实施方案不限于此。例如,车辆控制系统可以在驾驶员上车之前基于手动输入到智能手机等(假设可与车辆控制系统通信)的目的地信息或日历信息来预设定目的地。可选择地,车辆控制系统可以通过经由结合服务获取预先存储在智能手机等或云服务器等(假设可与车辆控制系统通信)中的时间表信息等来自动预设定目的地。

然后,车辆控制系统基于所设定的目的地执行行驶路线等的预规划设定。此外,车辆控制系统获取并更新例如与所设定的行驶路线的道路环境有关的信息,即,其中车辆行驶的道路的行驶地图信息始终以高密度更新的局部动态地图(LDM)信息等。此时,车辆控制系统沿着行程过程中的行驶,针对每个固定区间重复获取与车辆将要行驶的区间相对应的LDM等。此外,车辆控制系统基于所获取的最新的LDM信息等,针对行驶路线上的各区间适宜地更新和再设定适宜的自动驾驶等级。因此,即使在自动驾驶等级4中开始区间进入,当从时刻更新的信息中检测到在开始行程时尚未发现的对于新的手动驾驶的移交点时,也要求驾驶员识别用于请求移交的通知,并根据变化的部分采取移交应对。

随后,车辆控制系统开始显示行驶路线上的行驶区间。然后,车辆控制系统根据所设定的自动驾驶等级开始行驶(步骤S13)。当开始行驶时,基于车辆(本车)的位置信息和所获取的LDM更新信息来更新行驶区间的显示。注意,在本说明书中,“行驶”还包括当驾驶员不能从自动驾驶返回到手动驾驶时自动执行的安全应对,更具体地包括例如由车辆控制系统判定的MRM等中涉及的车辆停止。

随后,车辆控制系统适宜地执行驾驶员状态的监控(观测)(步骤S14)。在本公开的实施方案中,执行监控以例如获取用于判定驾驶员的返回响应等级的教师数据。在本实施方案中,在需要根据行驶环境随时间的变化进行核查的状况下执行监控,例如,根据针对行驶路线上的各区间设定的自动驾驶等级来切换驾驶模式所需要的驾驶员的先前状态核查以及关于是否已经在适宜的时机执行了返回通知并且驾驶员已经适宜地执行了对通知或警报的返回行动的核查,包括从行程开始之后发生的意外的自动驾驶到手动驾驶的返回请求。

随后,当车辆基于针对行驶路线上的各区间设定的自动驾驶等级到达从自动驾驶模式到手动驾驶模式的切换点时,车辆控制系统判定是否可以切换驾驶模式(步骤S15)。然后,当判定可以切换驾驶模式时(步骤S15:是),车辆控制系统前进到步骤S16中的处理,并且当判定不能切换驾驶模式时(步骤S15:否),车辆控制体系前进到例如步骤S18中的处理。

随后,车辆控制系统切换驾驶模式(步骤S16)。此外,车辆控制系统判定车辆(本车)是否已经到达目的地(步骤S17)。当车辆已经到达目的地时(步骤S17:是),车辆控制系统结束处理,并且当本车没有到达目的地时(步骤S17:否)返回到步骤S13中的处理。此后,车辆控制系统适宜地重复步骤S13至步骤S17中的处理,直到车辆到达目的地。当驾驶模式不能从自动驾驶切换到手动驾驶时,车辆控制系统可以通过MRM等执行紧急停止(步骤S18)。

注意,图2的流程图是用于示意性说明的图,示出了作为简单模型的流程,同时省略了关于移交中涉及的详细过程、移交时的状态核查、自动控制中的应对处理和判定的详细过程的说明以及详细步骤的记载。即,假设步骤S13中的处理包括当驾驶员不能返回时自动执行的一系列应对处理,省略了对该处理的说明。

注意,在本公开的实施方案中,即使在同一道路区间,容许的自动驾驶等级也可以根据车辆性能、路况、天气等随时变化。即使在同一车辆中,容许的运行设计域(ODD)有时也随着检测性能由于装载在本车上的设备的初步污染、传感器的污染等而劣化的情况发生变化。因此,当车辆从出发地行驶到目的地时,容许的自动驾驶等级有时也会发生变化。此外,在其中请求从自动驾驶到手动驾驶的切换应对的自动驾驶等级的迁移的情况下,有时还可以设定用于该应对的移交区间。因此,在本公开的实施方案中,基于随时变化的各种信息来设定和更新ODD。注意,在本说明书中,根据基础设施、行驶环境等容许的每个自动驾驶等级的实际使用范围被称为“运行设计域”(ODD)。

此外,当针对行驶车辆设定的ODD变化时,驾驶员被容许的次级任务的内容也变化。换句话说,由于不容许的次级任务的内容根据ODD而变化,因此被认为是违反交通规则的驾驶员行动的内容的范围也变化。例如,在自动驾驶等级4的情况下,即使驾驶员被容许执行诸如阅读等次级任务,但是当自动驾驶等级4迁移到自动驾驶等级2时,诸如阅读等次级任务也是违规行为。此外,由于在自动驾驶中也存在着自动驾驶等级的突然迁移,因此要求驾驶员处于准备状态,在该准备状态中,驾驶员可以根据状况从次级任务立即返回到手动驾驶。

<<3.自动驾驶等级的迁移的示例>>

随后,参照图3更详细地说明根据本公开实施方案的自动驾驶等级的迁移的示例。图3是用于说明根据本公开实施方案的自动驾驶等级的迁移的示例的说明图。

如图3所示,假设执行从自动驾驶模式(图3中下侧的范围)到手动驾驶模式(图3中上侧的区域)的切换,例如,当行驶路线上的自动驾驶等级3和自动驾驶等级4的区间迁移到自动驾驶等级0和1和自动驾驶等级2的区间时。

顺便要说的是,驾驶员难以有意识地维持其中驾驶员在自动驾驶模式下行驶时可以返回到手动驾驶的准备状态。例如,在自动驾驶模式下行驶时,可以设想驾驶员沉迷于次级任务,如睡眠(小睡)、电视或视频的观看或游戏。例如,驾驶员只将手从方向盘上松开,并且有时注视车辆的前方或周围,有时看书,或者有时打瞌睡,就像手动驾驶时一样。驾驶员的觉醒等级(意识等级)根据次级任务的差异而不同。

此外,当驾驶员在自动驾驶模式下行驶时陷入睡眠时,驾驶员的意识等级或判断等级下降,即,觉醒等级下降。由于驾驶员在觉醒等级下降的状态下不能执行正常的手动驾驶,因此当驾驶员在该状态下将自动驾驶模式切换到手动驾驶模式时,在最坏的情况下驾驶员很可能引起事故。因此,即使在觉醒等级下降的状态下,也要求驾驶员在从自动驾驶模式切换到手动驾驶模式之前立即返回到其中驾驶员可以在正常意识下驾驶车辆的高觉醒状态(内部觉醒恢复状态)。即,为了确保安全行驶,仅当可以观测到驾驶员的内部觉醒状态已经恢复时,才要求执行从自动驾驶模式到手动驾驶模式的切换。

因此,在本公开的实施方案中,为了避免事故等的诱发,仅当驾驶员处于到手动驾驶模式的返回响应等级时,即,当可以观测到指示内部觉醒恢复(驾驶员的内部觉醒状态恢复的状态)的主动响应时(如图3的中央所示),才可以执行这种驾驶模式的切换。在本实施方案中,如图3所示,当不能观测到指示内部觉醒恢复的主动响应时,驾驶模式被切换到诸如MRM(最小风险机动)等紧急疏散模式。注意,在紧急疏散模式中,执行诸如减速、停止、在道路上停车、在路侧带停车或在疏散空间停车等处理。在图3中,由于从自动驾驶等级4到自动驾驶等级3的迁移不涉及驾驶模式的切换,因此不执行上述的指示内部觉醒恢复的主动响应的观测本身。然而,本实施方案不限于图3所示的示例。基于上述的观测或观测结果的迁移也可以在从自动驾驶等级4到自动驾驶等级3的迁移中执行。注意,即使存在主动响应,驾驶员也不总是处于驾驶员把握所有相关状况的状态。因此,安全性可以被认为是执行操舵的移交的必要条件。

具体地,当执行从自动驾驶等级4到自动驾驶等级3的迁移时没有观测到指示内部觉醒恢复的主动响应时,即使根据法律制度驾驶员应该被迫返回手动驾驶,驾驶员也不总是处于其中驾驶员可以适宜地应对来自车辆控制系统的用作自动驾驶等级3的返回请求RTI(请求干预)的状态。更具体地,响应于用作自动驾驶等级3的返回请求RTI,驾驶员不能始终返回到其中大脑觉醒状态被恢复的状态和其中驾驶员可以在没有身体麻木等的情况下手动驾驶的身体状态。如果在这种情况下执行从自动驾驶等级4到自动驾驶等级3的迁移,则可能导致超出车辆控制系统中预先假设的设计概念的状况,并且诱发事故等。因此,在本公开的实施方案中,为了减少上述的可能性,即使在车辆控制系统侧不需要向驾驶员发出返回请求RTI的阶段,为了核查驾驶员的返回响应等级(例如,觉醒等级),也可以适宜地执行预防性虚拟返回请求RTI,以观测指示驾驶员的内部觉醒恢复的主动响应。

注意,指示图3中所示的自动驾驶等级的迁移的各箭头指示容许自动地执行切换的迁移方向。此外,不推荐在各箭头的相反方向上的迁移,因为这种迁移会导致驾驶员对车辆控制系统的状态的错误识别。即,在根据本公开实施方案的车辆控制系统中,期望的是,车辆控制系统被设计为使得当一旦执行自动驾驶等级的迁移以将自动驾驶模式切换到驾驶员干预的手动驾驶模式时,在没有来自驾驶员的主动指示的情况下,车辆控制系统不会再次自动返回到自动驾驶模式。如上所述,在驾驶模式的切换中提供方向性(不可逆性)意味着自动驾驶模式被设计为在没有驾驶员的明确意图的情况下被防止设定。因此,利用车辆控制系统,由于仅当驾驶员具有明确的意图时才能使自动驾驶模式有效化,因此例如,当驾驶模式不是自动驾驶模式时,可以防止驾驶员误解驾驶模式是自动驾驶模式并且容易地开始次级任务。

如上所述,在本公开的实施方案中,为了确保安全行驶,仅当可以观测到驾驶员处于内部恢复状态时,才执行从自动驾驶模式到手动驾驶模式的切换。

<<4.监控的示例>>

因此,参照图4说明在从自动驾驶模式切换到手动驾驶模式时的监控(观测)的示例。图4是用于说明根据本公开实施方案的监控操作的示例的流程图。如图4所示,在本公开的实施方案中,例如,在从自动驾驶模式切换到手动驾驶模式时,车辆控制系统执行步骤S21至步骤S27的步骤。这些步骤的细节将在下面进行说明。

首先,由于驾驶员在自动驾驶模式下行驶,因此假设驾驶员处于驾驶员完全离开驾驶操舵的状态。此外,假设驾驶员正在执行次级任务,如小睡、视频欣赏、沉迷于游戏或使用诸如平板电脑或智能手机等视觉工具的作业。然而,假设使用诸如平板电脑或智能手机等视觉工具的作业是在驾驶位移位的状态下或者在与驾驶位不同的座椅上执行的。

首先,车辆控制系统适宜地间歇性地对驾驶员执行被动监控和/或主动监控(步骤S21)。这里,对主动监控和被动监控进行说明。

首先,主动监控是一种观测方法,其中车辆控制系统向驾驶员输入能动信息,并观测驾驶员对能动信息的意识响应,从而主要对驾驶员进行智能感知、认知、判断和行为能力的判定。输入到驾驶员的能动信息的示例包括视觉、听觉、触觉、嗅觉和(味觉)信息。这些类型的能动信息诱导驾驶员的感知和认知行动。如果该信息是影响风险的信息,则驾驶员根据风险执行判断/行动(响应)。因此,可以通过观测驾驶员的响应来判定驾驶员大脑中的感知、认知、判断和行动状态。具体地,在主动监控中,例如,当车辆控制系统以不影响车辆安全行驶的轻微程度的操舵量作为伪能动信息来执行转向控制以促使驾驶员的反馈时,期望驾驶员将转向返回到适宜的操舵量的行动作为意识响应(如果驾驶员被正常觉醒)。具体地,由于驾驶员执行感知和识别不必要的操舵量、判断返回不必要的操舵量并采取行动的一系列操作,因此引出与上述响应相对应的行动(将转向返回到适宜的操舵量的行动)。因此,通过观测响应,可以判定驾驶员大脑中的感知、认知、判断和行动状态。注意,在手动驾驶模式下的行驶期间,驾驶员始终对道路环境等执行感知、认知、判断和行动的一系列操作,以便执行操舵。因此,可以在车辆控制系统侧未直接向驾驶员输入能动信息的情况下观测驾驶员的意识响应(即,可以认为存在驾驶操舵的响应)。此外,当重复执行上述的能动信息输入时,这些类型的信息在驾驶员的大脑中被智能地过滤,并被视为不必要的(即,“习惯化”)。因此,在本公开的实施方案中,为了避免上述的“习惯化”,优选地将能动信息输入的频率设定为适宜的频率。

接下来,例如,当不能观测到驾驶员对直接的能动信息输入的意识响应(主动监控)时,执行被动监控。存在用于被动监控驾驶员的状态的多种观测方法。观测方法的示例包括对驾驶员的生物信息的观测。更具体地,例如,在被动监控中,当利用者坐在驾驶位上并且处于可驾驶的姿势时,期望对PERCLOS(睁眼率)相关指数、头部姿势行为、眼球行为(扫视(快速眼球运动)、注视、微扫视等)、眨眼、面部表情、面部方向等执行详细的观测评价。此外,在就座以外的姿势中,通过使用可穿戴设备等,可以执行扩展观测,用于观测例如心率、脉搏率、血流、呼吸、脑电图、出汗状态以及从心率和呼吸估计的睡眠深度。此外,在被动监控中,可以观测驾驶员的驾驶位的就座或离开、移动、目的地、姿势等。此外,可以直接观测与驾驶员的谨慎驾驶状态(驾驶员在维持对驾驶的适宜关注的同时执行手动驾驶的状态)相关联的操舵量。此外,当驾驶控制系统侧在自动驾驶模式下的行驶期间发出驾驶模式的切换通知、警报等时,通过被动监控观测到的信息可以用于估计驾驶员返回到手动驾驶所需的时间。此外,当预计驾驶员在预定的时间内不会返回到手动驾驶时,通过被动监控观测到的信息可以用于判定切换到紧急疏散模式的有无。

随后,参照图4继续进行说明。车辆控制系统通知驾驶员到手动驾驶的返回请求RTI(步骤S22)。此时,例如,通过诸如振动等动态触觉或视觉或听觉来通知驾驶员到手动驾驶的返回请求RTI。然后,响应于这种返回请求RTI的通知,如果驾驶员处于正常觉醒状态,则驾驶员返回到驾驶位,并且返回到驾驶员可以在正常意识下驾驶车辆的高觉醒状态。注意,返回请求RTI可以分阶段地执行多次。在这种情况下,返回请求RTI可以在各阶段中通过不同手段来执行,或者可以根据例如驾驶员的状态动态地变化。

随后,车辆控制系统监控驾驶员的就座状态、就座姿势等(步骤S23)。此外,车辆控制系统集中地对正确就座的驾驶员执行主动监控(步骤S24)。为了促使驾驶员返回到驾驶员可以在正常意识下驾驶车辆的高觉醒状态,主动监控的示例包括执行能动信息输入,以向驾驶员发出警告等或者以伪方式向车辆的手动操舵控制输入伪噪声操舵。

随后,车辆控制系统集中地监控驾驶员的面部和诸如扫视等眼球行为(眼球行为集中监控)(步骤S25)。

这里,对眼球行为的监控进行说明。尽管可以通过各种手段观测与驾驶员的状态有关的信息,但是难以直接观测驾驶员大脑中的认知/判断行动。例如,当使用fMRI(功能性磁共振成像)、脑电图(EEG)等时,需要约束受试者(驾驶员)。因此,在本公开的实施方案中,这不适合作为用于观测驾驶员的状态的手段。因此,在本实施方案中,用于观测驾驶员的眼球行为的手段被用作各种生物信息观测手段之一。例如,当驾驶员坐在驾驶位上时,可以在不特别约束驾驶员的情况下执行眼球行为观测。即,眼球行为观测被认为是一种非侵入性和非可穿戴型观测手段。

眼球行为部分地包括生物反射性地出现的行为,其中对事件变化的响应表现为对不包括思考要素的回路的适应性响应。眼球行为的示例包括诸如用于追踪视觉相对移动物的平滑拍摄(滑动性追踪眼睛运动)、由车辆的先进背景接近引起的缓慢拥堵和返回的快速发散运动、以及用于抵消自身的身体和头部的转动并追踪目标方向的滑动性追踪眼睛运动等行为。此外,眼球行为不包括反射响应,而是捕捉视觉目标的特征并追踪该特征以促进理解的行为。即,由于在眼球行为中也同时观察到表现出反映大脑中的神经传递和处理的许多现象,因此认为参照的诸如固定目标的识别等活动结果被反映在大脑的记忆中。因此,通过利用大脑中的认知功能活动被反映在眼球行为中的事实,可以基于眼球行为的解析来高度精确地估计驾驶员的觉醒等级。即,通过执行眼球行为观测,在从自动驾驶模式切换到手动驾驶模式时(具体地,就在切换之前),可以间接地观测驾驶员是否已经返回到驾驶员可以在正常意识下驾驶车辆的高觉醒等级(返回响应等级)。特别地,当驾驶员一旦离开驾驶操舵作业并且在一段时间后返回到驾驶操舵时,认为驾驶员对返回到手动驾驶所需的周围和车辆状态没有充分的记忆。因此,如果驾驶员执行继续的手动驾驶,则驾驶员试图快速地进行用于把握驾驶员本应把握的信息的行动,例如,目视核查道路前方的状况或者目视核查从车辆控制系统的到手动驾驶的返回请求RTI的原因。这种信息把握行动反映在驾驶员的眼球行为中。

此外,如上所述,由于眼球行为指示针对每个人物并且进一步地针对每个人物状态的特有行为,因此当试图通过解析眼球行为来精确地判定驾驶员的觉醒等级时,要求始终把握和学习驾驶员特有的个体眼球行为,并且基于这种学习来判定驾驶员的觉醒等级。此外,在返回到手动驾驶时,驾驶员重点核查的内容以及驾驶员以什么样的优先顺序进行核查受到基于驾驶员过去的风险经历等的记忆的极大影响,并且因此,由于诸如行驶期间的道路状况和行驶速度等各种因素的原因而发生变化。因此,眼球行为不仅指示针对每个人物的特定行为,而且受到基于驾驶员的各种经历的记忆的影响并发生变化。在本实施方案中,优选的是,不使用针对多个驾驶员的统一判定来执行觉醒等级判定,而是基于通过在能动观测区间中的间歇学习获得的学习来执行针对各驾驶员的返回能力判定。这使得可以更适当地执行针对每个驾驶员的判定。

然后,车辆控制系统通过基于上述步骤S25中的监控判定驾驶员的觉醒等级来判定驾驶员的返回响应等级(步骤S26)。然后,车辆控制系统判定驾驶员是否处于驾驶员适应返回到手动驾驶的返回反应等级。由于根据本实施方案的车辆控制系统分阶段地观测驾驶员的返回过程,并且在返回过程的途中的各阶段中观测驾驶员的响应,因此可以执行复杂的判定。然后,当基于驾驶员的内部觉醒返回和手动驾驶行为的能力核查判定可以以预定的准确度返回到手动驾驶时,车辆控制系统执行从自动驾驶模式到手动驾驶模式的切换(步骤S27)。驾驶员的各种类型的眼球行为的观测到的随时间变化的特征被识别,在涉及这些特征的同时执行最终移交,并且通过关于针对每次移交的成功/失败的移交质量来标记这些特征。以下将详细说明上述内容。

注意,图4中的各步骤并不总是必须按照所记载的顺序进行处理,并且可以适宜地改变顺序进行处理或者可以并行地进行部分处理。例如,步骤S24中的主动监控和步骤S25中的眼球行为集中监控可以并行地执行,或者可以通过改变图4中所示的顺序来进来处理。

<<5.车辆控制系统的详细构成>>

接下来,参照图5说明根据本公开实施方案的车辆控制系统100的详细构成。图5是用于说明根据本实施方案的车辆控制系统100的详细构成的示例的说明图。注意,在以下的说明中,当设置有车辆控制系统100的车辆与其他车辆进行区分时,该车辆被称为本车或本车辆。

如图5所示,车辆控制系统100主要包括输入单元101、数据获取单元102、通信单元103、车内设备104、输出控制单元105、输出单元106、驱动系统控制单元107、驱动系统108、车身系统控制单元109、车身系统110、存储单元111、自动驾驶控制单元112和传感器单元113。输入单元101、数据获取单元102、通信单元103、输出控制单元105、驱动系统控制单元107、车身系统控制单元109、存储单元111和自动驾驶控制单元112经由通信网络121彼此连接。通信网络121包括符合诸如CAN(控制器局域网)、LIN(本地互连网络)、LAN(局域网)或FlexRay(注册商标)等任何标准的车载通信网络、总线等。车辆控制系统100的各单元可以在没有通信网络121的情况下直接连接。

注意,在以下的说明中,当车辆控制系统100的各单元经由通信网络121执行通信时,省略了对通信网络121的说明。例如,当输入单元101和自动驾驶控制单元112经由通信网络121彼此通信时,这被简单地记载为输入单元101与自动驾驶控制单元112彼此通信。

在以下的说明中,顺次说明根据本实施方案的车辆控制系统100中包括的各功能单元的细节。

输入单元101由诸如驾驶员等乘客在输入各种数据、指令等时使用的设备来构造。例如,输入单元101包括诸如触摸面板、按钮、麦克风、开关和控制杆等操作设备以及能够通过语音、手势等以手动操作以外的方法执行输入的操作设备。例如,输入单元101可以是使用红外线或其他无线电波的远程控制装置或者诸如适于车辆控制系统100的操作的移动设备或可穿戴设备等外部连接设备。输入单元101可以基于乘客输入的数据、指令等生成输入信号,并将该输入信号供给到车辆控制系统100的各功能单元。

数据获取单元102可以从包括各种传感器的传感器单元113获取用于车辆控制系统100的处理的数据,并将该数据供给到车辆控制系统100的各功能单元。

例如,传感器单元113包括用于检测例如车辆(本车)的状况的各种传感器。具体地,例如,传感器单元113包括陀螺仪传感器、加速度传感器、惯性测量单元(IMU)以及用于检测加速踏板的操作量、制动踏板的操作量、方向盘的操舵角、发动机转速、马达转速、车轮转速等的传感器。

例如,传感器单元113可以包括用于检测关于车辆(本车)外部的信息的各种传感器。具体地,例如,传感器单元113可以包括成像装置,如ToF(飞行时间)相机、立体相机、单眼相机、红外相机或其他相机。例如,传感器单元113可以包括用于检测气候、天气等的环境传感器和用于检测本车周围的物体的周围信息检测传感器。环境传感器的示例包括雨滴传感器、雾传感器、日照传感器和雪传感器。周围信息检测传感器的示例包括超声波传感器、雷达、LiDAR(光检测和测距、激光成像检测和测距)和声纳。

此外,例如,传感器单元113可以包括用于检测车辆(本车)的当前位置的各种传感器。具体地,例如,传感器单元113可以包括从GNSS卫星接收GNSS信号的GNSS(全球导航卫星系统)接收器等。此外,由传感器单元113检测到的当前位置可以通过校正基于同时进行自己位置估计和环境地图创建的SLAM(同时定位和地图创建)的位置信息和由来自LiDAR(光检测和测距)、毫米波雷达等检测到的位置信息的基准点来补充。

例如,传感器单元113可以包括用于检测汽车内部信息的各种传感器。具体地,例如,传感器单元113可以包括对驾驶员成像的成像装置(ToF相机、立体相机、单眼相机、红外相机等)、检测驾驶员的生物信息的生物信息传感器和收集车内声音的麦克风。生物信息传感器设置在例如座椅的座椅表面、方向盘等上,并且可以检测坐在座椅上的乘客或紧握方向盘的驾驶员的生物信息。驾驶员生物信息的示例包括心率、脉搏率、血流、呼吸、脑电波、皮肤温度、皮肤阻力、出汗状态、头部姿势行为和眼球行为(凝视、眨眼、扫视、微扫视、注视、瞟视、盯着、虹膜的瞳孔反应等)。这些生物信息可以通过单独或组合使用驾驶员等的体表上的预定位置之间的电位、使用红外光的血流系统等的接触型可观测信号、使用非接触型微波或毫米波的非接触型可观测信号或FM(调频)波、使用通过利用红外波长的成像装置(监视单元)的眼球的拍摄图像的眼球行为的检测、用于观测操舵响应性的转向或踏板操舵设备的过载扭矩测量信息等来检测。

通信单元103可以与车内设备104和车辆外部的各种设备、服务器、基站等进行通信,发送从车辆控制系统100的各功能单元供给的数据,并将接收到的数据供给到车辆控制系统100的各功能单元。注意,在本公开的实施方案中,由通信单元103支持的通信协议没有特别限制。通信单元103还可以支持多种类型的通信协议。

例如,通信单元103可以通过无线LAN、蓝牙(注册商标)、NFC(近场通信)、WUSB(无线通用串行总线)等与车内设备104进行无线通信。例如,通信单元103可以经由未示出的连接端子(并且如果必要的话,线缆)通过USB、HDMI(高清多媒体接口)(注册商标)、MHL(移动高清链路)等与车内设备104进行有线通信。

此外,例如,通信单元103可以经由基站或接入点与存在于外部网络(例如,互联网、云网络或公司特有网络)上的设备(例如,应用服务器或控制服务器)进行通信。例如,通信单元103可以使用P2P(点对点)技术与本车附近存在的终端(例如,行人或商店的终端、检查员携带的终端或MTC(机器类型通信)终端)进行通信。此外,例如,通信单元103可以执行诸如车对车通信、车对基础设施通信、车对家通信和车对行人通信等V2X通信。例如,通信单元103可以包括信标接收单元,接收从安装在道路上的无线站等发送的无线电波或电磁波,并获取诸如当前位置、拥堵、交通规则、所需时间等信息。注意,可以通过通信单元103与在可以是前导车辆的区间行驶中的前方行驶车辆进行配对,以获取从安装在前方车辆上的数据获取单元获取的信息作为先前行驶间隔信息,并执行用于补充由本车的数据获取单元102获取的数据的补充利用。特别地,通信单元103可以是用于由前导车辆的车队行驶等中的后续车队来确保安全性的手段。

例如,车内设备104可以包括乘客拥有的移动设备或可穿戴设备,携带在本车或附接到本车的信息设备,以及搜索到任何目的地的路线的导航设备。注意,考虑到由于自动驾驶的普及,乘客并不总是固定在就座的固定位置处,车内设备104可以被扩展为视频播放器、游戏设备或可以从车辆设置可拆卸地使用的其他设备。

输出控制单元105可以控制向本车的乘客或车外输出各种信息。例如,输出控制单元105生成包括视觉信息(例如,图像数据)和听觉信息(例如,音频数据)中的至少一个的输出信号,并将该输出信号供给到输出单元106,从而控制来自输出单元106的视觉信息和听觉信息的输出。具体地,例如,输出控制单元105组合由包括在传感器单元113中的不同成像装置捕获的图像数据,以生成鸟瞰图像、全景图像等,并将包括所生成的图像的输出信号供给到输出单元106。注意,当生成鸟瞰图像、全景图像等时,可以通过以容许的使用形式记录和存储复眼的合成处理前的图像来再现更密集的事件。合成处理前的图像的记录和存储取决于记录和存储的可用性信息的存储和传输负荷。例如,输出控制单元105生成包括针对诸如碰撞、接触或进入危险区域等危险的警报声音和警报消息的声音数据,并将包括该生成的声音数据的输出信号供给到输出单元106。

输出单元106可以包括能够将视觉信息或听觉信息输出给本车的乘客或车外的设备。例如,输出单元106包括显示设备、仪表板、音频扬声器、耳机、诸如乘客佩戴的眼镜型显示器等可佩戴设备、投影仪和灯。除了包括普通显示器的设备之外,包括在输出单元106中的显示设备还可以是诸如平视显示器、透过型显示器、或者具有AR(增强现实)显示功能的设备等在驾驶员的视野内显示视觉信息的设备。注意,输出单元106可以包括向驾驶员提供嗅觉刺激(提供预定气味)或触觉刺激(例如,提供冷风、提供振动或提供电气刺激)的各种装置,以便在由于睡眠等原因导致更深层次的离开驾驶员的驾驶操舵作业时促使驾驶员觉醒。此外,输出单元106可以包括给予使身体不适的刺激的装置等,例如,移动驾驶位的靠背以迫使驾驶员处于使驾驶员不适的姿势。

近年来,生活方式中特别重要的信息输出手段的示例包括驾驶员自己带进车里的手机、智能手机和平板电脑设备。这种设备可以被用作HMI(人机接口),即使驾驶员没有将视线移动到车载设备,驾驶员也可以通过该HMI核查由驾驶员使用的应用程序提供的与行驶有关的一系列信息。因此,在本实施方案中,这些类型的设备的输入和输出功能也可以等同于车载设备来看待和处理。

驱动系统控制单元107可以通过生成各种控制信号并将该控制信号供给到驱动系统108来控制驱动系统108。驱动系统控制单元107可以根据需要向驱动系统108以外的各功能单元供给控制信号,并且执行例如驱动系统108的控制状况的通知。

驱动系统108可以包括与本车的驱动系统有关的各种装置。例如,驱动系统108包括诸如内燃机或驱动马达等用于产生车辆的驱动力的驱动力产生装置、用于向车轮传递驱动力的驱动力传递机构、用于调整转向角的转向机构、用于产生制动力的制动装置、ABS(防抱死制动系统)、ESC(电子稳定控制)和电动助力转向装置。

车身系统控制单元109可以通过生成各种控制信号并将该控制信号供给到车身系统110来控制车身系统110。车身系统控制单元109可以根据需要向车身系统110以外的各功能单元供给控制信号,并且执行例如车身系统110的控制状况的通知。

车身系统110可以包括安装在车身上的车身系统的各种装置。例如,车身系统110包括无钥匙进入系统、智能钥匙系统、电动车窗装置、电动座椅、方向盘、空调和各种灯(例如,头灯、尾灯、刹车灯、闪光灯和雾灯)。

存储单元111可以包括诸如ROM(只读存储器)或RAM(随机存取存储器)或HDD(硬盘驱动器)等磁性存储器件、半导体存储器件、光学存储器件或磁光存储器件。存储单元111可以存储由车辆控制系统100的各功能单元使用的各种程序、数据等。例如,存储单元111存储如动态地图等三维高精度地图的地图数据、具有比高精度地图更低精度并且覆盖大区域的全局地图以及包括本车周围信息的局部地图。

自动驾驶控制单元112可以执行诸如自动行驶或驾驶支援等与自动驾驶有关的控制。具体地,例如,自动驾驶控制单元112可以执行为了实现ADAS(高级驾驶员辅助系统)的功能的协调控制,该ADAS的功能包括本车的碰撞规避或冲击减缓、基于车间距离的追随控制、车辆恒速行驶、本车的碰撞警告、本车的车道偏离警告等。例如,自动驾驶控制单元112可以在不依赖于驾驶员的操作的情况下执行用于自动行驶的自动驾驶等的协调控制。具体地,自动驾驶控制单元112包括检测单元131、自己位置估计单元132、状况解析单元133、规划单元134和操作控制单元135。

检测单元131可以检测控制自动驾驶所需的各种信息。检测单元131包括车外信息检测单元141、车内信息检测单元142和车辆状态检测单元143。

车外信息检测单元141可以基于来自车辆控制系统100的各单元的数据或信号,对关于本车外部的信息执行检测处理。例如,车外信息检测单元141对本车周围的物体执行检测处理、识别处理和追踪处理,并对距物体的距离执行检测处理。将被检测的物体的示例包括车辆、人、障碍物、结构物、道路、交通信号灯、交通标志和道路标志。

例如,车外信息检测单元141对本车周围的环境执行检测处理。将被检测的本车周围环境的示例包括天气、温度、湿度、亮度、路面状况等。例如,车外信息检测单元141将指示检测处理的结果的数据供给到自己位置估计单元132、状况解析单元133的地图解析单元151、交通规则识别单元152和状况识别单元153以及操作控制单元135的紧急避险单元171。

注意,如果行驶区间是作为可以重点执行自动驾驶行驶的区间的从基础设施向其供给始终更新的LDM的区间,则由车外信息检测单元141获取的信息可以主要通过基础设施的信息供给来接收。可选择地,在本车进入相关区间之前,可以预先从在相关区间中行驶在前方的车辆或一组车辆接收信息。在本实施方案中,例如,当基础设施不能始终更新最新的LDM时,特别是为了在相关区间之前立即获得道路信息,以便在排队行驶等中执行安全的区间进入,车外信息检测单元141可以经由先前已经进入相关区间的前导车辆来接收道路环境信息。通常根据从与相关区间相对应的基础设施提供的事前信息的存在与否来确定该区间是否是可以进行自动驾驶的区间。在基础设施提供的路线上构成自动驾驶行驶可否的信息并且可以始终更新的新的LDM就是所谓的“信息”,但其行为就像LDM提供了“不可见的轨迹”。注意,在本说明书中,为了方便起见,在车外信息检测单元141被安装在本车并直接从基础设施接收信息的前提下,示出并说明了车外信息探测单元141。然而,车外信息检测单元141不限于此。例如,在本实施方案中,通过接收并利用已经被视为“信息”的前行车辆的信息,车外信息检测单元141可以进一步提高行驶过程中可能会发生的危险等的事前预测性。

车内信息检测单元142可以基于来自车辆控制系统100的各功能单元的数据或信号来执行车内信息的检测处理。例如,车内信息检测单元142执行驾驶员认证处理和识别处理、驾驶员状态检测处理、乘客检测处理、车内环境检测处理等。将被检测的驾驶员的状态的示例包括身体状况、觉醒度、集中度、疲劳度、视线方向、酒精、药物等的影响度以及眼球详细行为。将被检测的车内环境的示例包括温度、湿度、亮度和气味。车内信息检测单元142将指示检测处理的结果的数据供给到状况解析单元133的状况识别单元153、操作控制单元135的紧急避险单元171等。注意,例如,当已经估计或发现驾驶员在向手动驾驶通知返回请求RTI之后的预定期限时间内不能实现手动驾驶,并且已经判定即使执行减速控制以延迟时间也不能及时返回到手动驾驶时,车内信息检测单元142可以向紧急回避单元171等发出指令,并开始减速、疏散和停止程序以退避车辆。

此外,如上所述,由于还假定驾驶员完全脱离驾驶操舵作业下的利用,因此驾驶员很可能会临时打瞌睡或开始其他作业(次级任务)。因此,需要把握驾驶返回所必需的意识的觉醒返回已经进展到什么程度。因此,上述的车内信息检测单元142主要具有两个主要作用。第一个作用是在驾驶过程中对驾驶员状态的被动监控,第二个作用是用于根据驾驶员的意识响应来检测和判定驾驶员是否处于返回反应等级的主动监控,在该返回反应等级中,在通知向手动驾驶的返回请求RTI之后,手动驾驶是可能的。

车辆状态检测单元143可以基于来自车辆控制系统100的各单元的数据或信号来执行车辆(本车)的状态的检测处理。将被检测的本车的状态的示例包括速度、加速度、操舵角和是否存在异常的自我诊断的状态和内容、驾驶操作的状态、电动座椅的位置和倾斜、门锁的状态和其他车载设备的状态。车辆状态检测单元143将指示检测处理的结果的数据供给到状况解析单元133的状况识别单元153、操作控制单元135的紧急避险单元171等。

注意,将被识别的车辆(本车)的状态的示例可以包括判定车辆(本车)的位置、姿势和移动(例如,速度、加速度和移动方向)以及车辆(本车)的运动特性的货物装载量、货物装载中涉及的车身重心的移动、轮胎压力、刹车制动片磨损情况下涉及的制动距离移动、用于防止由货物制动引起的货物移动的容许最大减速制动以及液体装载物中涉及的曲线行驶时的离心缓和极限速度。注意,在本实施方案中,由于车辆特有条件、装载货物特有条件等以及路面的摩擦系数、道路曲线、坡度等,即使在完全相同的道路环境中,控制车辆所需的返回开始时机也是不同的。因此,在本实施方案中,需要收集和学习这些各种条件,并且始终将学习结果反映在用于执行控制的最佳时机的估计上。由于在用于判定实际的车辆控制的这些条件实际上导致事故的情况下的影响等也根据装载在车辆上的运输物的类型而变化,因此期望利用者预见安全,并通过将期望的偏差作为安全系数应用于控制来运用条件。没有必要直接使用通过学习统一获得的结果。

自己位置估计单元132可以基于来自诸如车外信息检测单元141和状况解析单元133的状况识别单元153等车辆控制系统100的各功能单元的数据或信号,对车辆(本车)的位置、姿势等执行估计处理。自己位置估计单元132可以根据需要生成用于估计自己位置的局部地图(在下文中,被称为自己位置估计用地图)。

例如,自己位置估计用地图是使用如SLAM等技术的高精度地图。自己位置估计单元132将指示估计处理的结果的数据供给到状况解析单元133的地图解析单元151、交通规则识别单元152、状况识别单元153等。自己位置估计单元132还可以使存储单元111存储自己位置估计用地图。

状况解析单元133可以对车辆(本车)和周围环境的状况执行解析处理。状况解析单元133包括地图解析单元151、交通规则识别单元152、状况识别单元153和状况预测单元154。

地图解析单元151可以在使用来自诸如自己位置估计单元132和车外信息检测单元141等车辆控制系统100的各功能单元的数据或信号的同时,根据需要对存储在存储单元111中的各种地图执行解析处理,并构建包括自动驾驶处理所需的信息的地图。地图解析单元151将构建的地图供给到交通规则识别单元152、状况识别单元153和状况预测单元154以及规划单元134的路线规划单元161、行动规划单元162、操作规划单元163等。

交通规则识别单元152可以基于来自诸如自己位置估计单元132、车外信息检测单元141和地图解析单元151等车辆控制系统100的各单元的数据或信号来执行对车辆(本车)周围的交通规则的识别处理。通过该识别处理,例如,识别车辆(本车)周围的红绿灯的位置和状况、本车周围的交通规则的内容、本车可以行驶的车道等。交通规则识别单元152将指示识别处理的结果的数据供给到状况预测单元154等。

状况识别单元153可以基于来自诸如自己位置估计单元132、车外信息检测单元141、车内信息检测单元142、车辆状态检测单元143和地图解析单元151等车辆控制系统100的各功能单元的数据或信号,来执行关于车辆(本车)的状况的识别处理。例如,状况识别单元153对车辆(本车)的状况、车辆(本车)周围的状况、车辆(本车)的驾驶员的状况等执行识别处理。状况识别单元153根据需要生成用于识别车辆(本车)周围的状况的局部地图(在下文中,被称为状况识别用地图)。例如,状况识别用地图可以是占用格子地图。状况识别单元153将指示识别处理的结果的数据(根据需要,包括状况识别用地图)供给到自己位置估计单元132、状况预测单元154等。状况识别单元153使存储单元111存储状况识别用地图。

状况预测单元154可以基于来自诸如地图解析单元151、交通规则识别单元152和状况识别单元153等车辆控制系统100的各单元的数据或信号,对关于车辆(本车)的状况执行预测处理。例如,状况预测单元154对车辆(本车)的状况、车辆(本车)周围的状况、驾驶员的状况等执行预测处理。注意,将被预测的车辆(本车)的状况的示例包括车辆(本车)的行为、异常的发生和可行驶距离。将被预测的车辆(本车)周围的状况的示例包括车辆(本车)周围的移动体的行为、红绿灯状态的变化和诸如天气等环境的变化。将被预测的驾驶员的状况的示例包括驾驶员的行为和身体状况。然后,状况预测单元154将指示预测处理的结果的数据与来自交通规则识别单元152和状况识别单元153的数据一起供给到规划单元134的路线规划单元161、行动规划单元162、操作规划单元163等。

路线规划单元161可以基于来自诸如地图解析单元151和状况预测单元154等车辆控制系统100的各功能单元的数据或信号来规划到目的地的路线。例如,路线规划单元161基于全局地图设定从当前位置到指定目的地的路线。路线规划单元161基于LDM等对行驶路线上的各区间设定自动驾驶等级。例如,路线规划单元161可以基于诸如交通堵塞、事故、交通限制或施工等状况、驾驶员的身体状况等来改变路线。路线规划单元161将指示所规划的路线的数据供给到行动规划单元162等。

行动规划单元162可以基于来自诸如地图解析单元151和状况预测单元154等车辆控制系统100的各功能单元的数据或信号,规划车辆(本车)的行动,以便在规划时间内在由路线规划单元161规划的路线上安全行驶。例如,行动规划单元162执行启动、停止、行驶方向(例如,向前移动、向后移动、左转、右转或方向改变)、行驶车道、行驶速度、超车等的规划。行动规划单元162将指示车辆(本车)的规划行动的数据供给到操作规划单元163等。注意,作为避免由另一方引起的事故的目的,与平常时用于控制所需的道路的行驶空间信息并行地,为了避免事故的严重性增加,可以进一步补充管理诸如车辆可以物理地行驶的开放平面空间(空地等)和进入规避危险空间(诸如悬崖或车站出口等行人密集区域)等信息,并且可以作为紧急控制时的疏散空间被反映在控制上。

操作规划单元163可以基于来自诸如地图解析单元151和状况预测单元154等车辆控制系统100的各功能单元的数据或信号,规划车辆(本车)的操作,以实现由行动规划单元162规划的行动。例如,操作规划单元163规划加速、减速、行驶轨迹等。操作规划单元163可以规划驾驶模式的设定、用于执行切换的时机等。操作规划单元163将指示车辆(本车)的规划操作的数据供给到操作控制单元135的加减速控制单元172、方向控制单元173等。

操作控制单元135可以控制车辆(本车)的操作。操作控制单元135包括紧急避险单元171、加减速控制单元172和方向控制单元173。

紧急避险单元171可以基于车外信息检测单元141、车内信息检测单元142和车辆状态检测单元143的检测结果,执行诸如碰撞、接触、进入危险区域、驾驶员的异常、车辆的异常等紧急情况的检测处理。当检测到紧急情况的发生时,紧急避险单元171规划车辆的操作以避免诸如突然停止或突然转弯等紧急情况。紧急避险单元171将指示车辆的规划操作的数据供给到加减速控制单元172、方向控制单元173等。

加减速控制单元172可以执行加减速控制,以实现由操作规划单元163或紧急避险单元171规划的车辆(本车)的操作。例如,加减速控制单元172计算用于实现规划的加速、减速或突然停止的驱动力产生装置或制动装置的控制目标值,并将指示计算出的控制目标值的控制命令供给到驱动系统控制单元107。注意,例如,主要有两种情况可能会发生紧急情况。一种是在自动驾驶模式下,在从行驶路线中的基础设施获取的LDM等最初认为安全的道路上的自动驾驶期间,由于突发原因而发生意外事故或事故诱发因素,并且驾驶员不能及时紧急返回的情况。另一种是由于某些因素而难以从自动驾驶模式切换到手动驾驶模式的情况。

方向控制单元173可以执行用于实现由操作规划单元163或紧急避险单元171规划的车辆(本车)的操作的方向控制。例如,方向控制单元173计算用于实现由操作规划单元163或紧急避险单元171规划的行驶轨迹或急转弯的转向机构的控制目标值,并将指示计算出的控制目标数值的控制命令供给到驱动系统控制单元107。

此外,参照图6说明包括在传感器单元113中的成像装置的安装位置的示例。图6是示出包括在传感器单元113中的成像装置的安装位置的示例的图。例如,图6所示的成像装置可以适用的成像单元7910、7912、7914、7916和7918被设置在车辆7900的前鼻、侧视镜、后保险杠、后备箱门或车内的挡风玻璃上部中的至少一个中。

安装在前鼻中的成像单元7910和安装在车内的挡风玻璃上部的成像单元7918主要获取车辆7900前方的图像。安装在侧视镜中的成像单元7912和7914主要获取车辆7900侧方的图像。安装在后保险杠或后备箱门中的成像单元7916主要获取车辆7900后方的图像。安装在车内挡风玻璃上部的成像单元7918主要用于检测前行车辆、行人、障碍物、红绿灯、交通标志、车道等。此外,在未来的自动驾驶中,当车辆向右或向左转弯时,可以扩展利用到在广域范围的右或左转弯前方道路上的横穿行人或者横穿道路上的接近物范围。

注意,图6示出了各个成像单元7910、7912、7914和7916的成像范围的示例。成像范围“a”表示设置在前鼻中的成像单元7910的成像范围,成像范围“b”和“c”分别表示设置在侧视镜中的成像单元7912和7914的成像范围,并且成像范围“d”表示设置在后保险杠或后备箱门中的成像单元7916的成像范围。例如,叠加由成像单元7910、7912、7914和7916捕获的图像数据,从而获得从上方观看的车辆7900的鸟瞰图像。例如,叠加由成像单元7910、7912、7914和7916捕获的图像数据,从而可以获得从上方观看的车辆7900的鸟瞰图像、以弯曲平面围绕车辆周边部的全方位立体显示图像等。

例如,设置在车辆7900的前方、后方、侧方、角部和车内挡风玻璃上部的车外信息检测单元7920、7922、7924、7926、7928和7930可以是超声波传感器或雷达设备。例如,设置在车辆7900的前鼻、后保险杠、后备箱门和车内挡风玻璃上部的车外信息检测单元7920、7926和7930可以是LiDAR设备。这些车外信息检测单元7920~7930主要用于检测前行车辆、行人、障碍物等。检测结果可以进一步适用于鸟瞰图像显示和全方位立体显示的立体物显示改善。

<<6.传感器单元113的示意性构成>>

接下来,参照图7说明包括在上述传感器单元113中的用于获得关于车辆中的驾驶员的信息的各种传感器的示例。图7是用于说明包括在根据本实施方案的传感器单元113中的各种传感器的示例的说明图。图7是示出包括在传感器单元113中的用于获得关于车辆中的驾驶员的信息的各种传感器的示例的图。如图7所示,传感器单元113包括作为用于检测驾驶员的位置和姿势的检测器的位置和姿势检测单元200,其包括例如ToF相机、立体相机或座椅应变仪。传感器单元113包括面部识别单元202、面部追踪单元204和眼球追踪单元(监视单元)206,作为用于获得驾驶员的生物信息的检测器。在以下的说明中,顺次说明包括在根据本实施方案的传感器单元113中的各种传感器的细节。

面部识别单元202、面部追踪单元204和眼球追踪单元(监视单元)206可以由诸如成像装置等各种传感器构造。例如,面部识别单元202从拍摄的图像中识别和检测驾驶员等的面部,并将检测到的信息输出到面部追踪单元204。面部追踪单元204基于由面部识别单元202检测到的信息来检测驾驶员的面部或头部的移动。此外,眼球追踪单元206检测驾驶员的眼球行为。注意,以下说明根据本公开实施方案的眼球追踪单元206的细节。

此外,传感器单元113可以包括作为用于获得驾驶员的生物信息的其他检测器的生物信息检测单元208。传感器单元113可以包括对驾驶员进行认证的认证单元210。注意,除了通过密码、个人识别号等的知识认证之外,认证单元210的认证方式可以是使用面部、指纹、瞳孔的虹膜、声纹等的生物认证,并且没有特别限制。在上述的说明中,说明了包括在传感器单元113中的主要传感器。然而,传感器单元113可以包括其他各种传感器。

<<7.执行驾驶员的觉醒等级的判定的单元的示意性构成>>

接下来,参照图8说明根据本公开实施方案的执行驾驶员的觉醒等级(返回反应等级)的判定的单元的构成例。图8是用于说明根据本实施方案的执行驾驶员的觉醒等级的判定的单元的示例的说明图。具体地,执行驾驶员的觉醒等级的判定的单元包括图5所示的检测单元131的车内信息检测单元142的一部分、状况解析单元133的状况识别单元153和存储单元111。更具体地,图8示出了包括在车内信息检测单元142中的眼球行为解析单元300和眼球行为学习装置302、包括在状况识别单元153中的判定单元320以及存储在存储单元111中的数据库(DB)310。这些单元相互协作,从而判定驾驶员的觉醒等级。在以下的说明中,顺次说明图8所示的各功能块。

(眼球行为解析单元300)

眼球行为解析单元300经由数据获取单元102获取由传感器单元113的眼球追踪单元206检测到的驾驶员的眼球行为,并解析眼球行为。例如,眼球行为解析单元300检测并解析诸如驾驶员眼球的扫视(眼球转动)、注视或微扫视(眼球微小转动)等眼球行为。由眼球行为解析单元300解析的眼球行为信息被输出到眼球行为学习装置302和后述的判定单元320。

此外,在本实施方案中,眼球行为解析单元300可以根据驾驶模式等动态切换解析模式。例如,眼球行为解析单元300可以在至少两种解析模式(第一解析模式和第二解析模式)之间切换。具体地,眼球行为解析单元300可以在一个解析模式(第一解析模式)中以例如250fps以上的高帧速率(第一帧速率)执行解析,并且可以在另一解析模式(第二解析模式)下以例如60fps的低帧速率(第二帧速率)执行解析。

更具体地,当发生其中驾驶模式从自动驾驶模式切换到手动驾驶模式的事件时,眼球行为解析单元300在切换的准备模式的期间(驾驶模式改变准备模式的期间)中集中地以高帧速率采样和解析眼球行为(第一解析模式)。在该眼球行为解析中,眼球行为解析单元300执行对驾驶员的微扫视或注视微动的观测(采样)和解析。然后,后述的判定单元320基于解析结果来判定驾驶员的觉醒等级(返回反应等级)。此外,优选确定在上述准备模式的期间中的眼球行为解析期间的时间长度,使得在车辆到达根据在基于LDM等的路线上设定的自动驾驶等级的驾驶模式的切换点之前,确保足够的时间来高度精确地判定驾驶员的觉醒等级(即,驾驶员到手动驾驶的返回响应等级)。因此,在本实施方案中,在准备模式的期间中的眼球行为解析期间的开始点(监控点)基于时间表(行程)、LDM、道路状态、行驶速度、车辆类型(拖车或普通乘用车)、驾驶员的就座状态(通过稳态周期监控获取的状态信息)等来确定,即,该期间的时间长度动态地变化。

当驾驶模式是自动驾驶模式时,眼球行为解析单元300以低帧速率对眼球行为进行采样和解析(第二解析模式)。该眼球行为解析被执行为上述的被动监控。例如,还观测和解析PERCLOS、扫视和注视,以判定驾驶员的睡意和疲劳度。当驾驶模式是自动驾驶模式时,眼球行为解析单元300可以根据自动驾驶等级(自动驾驶等级3或自动驾驶等级4)动态切换解析频率。例如,在自动驾驶等级3中,眼球行为解析单元300可以以比自动驾驶等级4中更高的频率执行眼球行为解析。如上所述,在自动驾驶等级3中,为了确保安全行驶,期望驾驶员始终处于驾驶员可以立即返回到手动驾驶的准备状态。因此,在自动驾驶等级3中,优选以高频率执行眼球行为解析,以便检测睡意和疲劳度,并判定驾驶员是否可以立即返回到手动驾驶。

然而,在上述的说明中,区分并记载了诸如自动驾驶等级3和自动驾驶等级4等具体的自动驾驶等级。然而,这是为了方便,并且在实际操作中,自动驾驶等级并不总是被限制为被清楚地区分和控制。即,由于自动驾驶等级和驾驶模式根据随时变化的状况而变化,因此在诸如眼球行为解析单元300等观测驾驶员状态的各种设备的观测中,适宜地执行与状况相对应的观测,以便判定驾驶员是否具有返回到手动驾驶所需的感知、认知、判断和行动能力。

此外,即使当驾驶模式是自动驾驶模式时,为了获取后述的眼球行为学习装置302将要学习的教师数据,例如,在与上述准备模式的期间中的眼球行为解析期间的时间长度相比具有更短的时间长度的期间中,眼球行为解析单元300也可以以高帧速率或低帧速率执行眼球行为解析。例如,当驾驶模式是自动驾驶模式时,当通过被动监控检测到驾驶员的觉醒等级下降时,眼球行为解析单元300可以以高帧速率执行眼球行为解析(第一解析模式)。这种情况下的解析结果是后述的眼球行为学习装置302将要学习的教师数据(被标记为觉醒等级下降时的眼球行为的教师数据)。

另一方面,当驾驶模式是手动驾驶模式时,眼球行为解析单元300以低帧速率解析眼球行为(第二解析模式)。该眼球行为解析被执行为上述的被动监控。例如,还观测和解析PERCLOS、扫视和注视,以判定驾驶员的睡意和疲劳度。即使当驾驶模式是手动驾驶模式时,眼球行为解析单元300也可以执行眼球行为解析,以便在基于驾驶员的驾驶操作被识别为驾驶员正常时执行手动驾驶的状况下,获取后述的眼球行为学习装置302将要学习的教师数据(被标记为觉醒等级正常时的眼球行为的教师数据)。为了获取教师数据,例如,在与上述准备模式的期间的眼球行为解析期间的时间长度相比具有更短的时间长度的期间中,眼球行为解析单元300以高帧速率或低帧速率执行眼球行为解析。即使当驾驶模式是手动驾驶模式时,当通过被动监控检测到驾驶员的觉醒等级下降时,眼球行为解析单元300也可以以高帧速率执行眼球行为解析(第一解析模式)。这种情况下的解析结果也是后述的眼球行为学习装置302将要学习的教师数据(被标记为觉醒等级下降时的眼球行为的教师数据)。

即,在本实施方案中,由于眼球行为解析单元300并不总是以高帧速率执行眼球行为解析,因此可以减少导致诸如成像处理或解析处理等电路操作中涉及的温度上升和由于强发热而引起的噪声的驱动负荷。此外,在本实施方案中,由于眼球行为解析单元300在必要时以高事件检测率执行眼球行为解析,因此可以精确地判定驾驶员的觉醒等级(返回反应等级)。浪费了在不必要的时机对成像单元的连续高速驱动,并且成像元件和信号传输的发热是噪声的因素。在需要本来必要的高速成像观测的时机,存在成像性能的灵敏度劣化的不利影响。

(眼球行为学习装置302)

眼球行为学习装置302作为教师数据学习过去获取的被标记各觉醒等级的驾驶员的眼球行为的解析结果,生成数据库310以供后述的判定单元320进行判定,并将数据库310输出到存储单元111(参见图5)。在本实施方案中,例如,眼球行为学习装置302可以是诸如支持向量返回或深度神经网络等监督学习装置。在这种情况下,解析结果(眼球行为)和被标记为解析结果的觉醒等级(正常时或下降时)分别作为输入信号和教师信号输入到眼球行为学习装置302。眼球行为学习装置302根据预定规则执行关于这些输入信息之间的关系的机器学习。上述多对输入信号和教师信号被输入到眼球行为学习装置302。眼球行为学习装置302对输入执行机器学习,以生成存储指示解析结果(眼球行为)和觉醒等级之间关系的关系信息的数据库(DB)310。注意,所生成的DB 310不限于存储在存储单元111中,并且可以存储在与用于识别驾驶员的识别信息相关联的云上的服务器(未示出)中。当驾驶员更换服务车辆或使用共享汽车、租赁汽车等时,所存储的DB 310也可以在不同的车辆中使用。此外,优选的是,DB 310中的信息始终被更新,而无论信息被存储在哪里。当根据运动特性等获得的返回要求根据车辆的类型而变化时,可以进一步执行与车辆相对应的评价判定标准的正规化。注意,在上述的说明中,根据觉醒等级是正常还是下降来说明数据库(DB)的学习和生成。然而,可以通过进一步细分、分割为返回质量并进一步与其他驾驶员状态迁移信息相关联来执行学习,以提高由眼球行为以外的观测手段获取的可观测信息以及驾驶员的觉醒和返回质量的预测的精度。

(判定单元320)

判定单元320基于由眼球行为解析单元300解析的眼球行为的解析结果来判定驾驶员的觉醒等级(返回反应等级)。例如,当确认驾驶员正在执行用于解决问题的诸如眼球扫视、注视和微扫视等眼球行为时,判定单元320可以判定驾驶员的觉醒等级为高。另一方面,当没有观测到这些眼球行为或者很少时,判定单元320可以判定驾驶员的觉醒等级为低。

具体地,眼球行为表示当人处于正常觉醒状态时和当人处于意识和觉醒下降状态时的不同行为。此外,眼球行为表示分别取决于人的特征行为。因此,在本实施方案中,判定单元320参照由眼球行为学习装置302与各个驾驶员相关联地生成的数据库(DB)310来执行判定。更具体地,在本实施方案中,判定单元320通过将在准备模式的期间中的驾驶员的眼球行为的解析结果与基于过去获取的该驾驶员的眼球行为的解析结果的数据库(DB)310进行比较来判定觉醒等级(返回响应等级)。因此,在本实施方案中,由于判定单元320参照基于学习获得的各个驾驶员特有的眼球行为来判定觉醒等级(返回响应等级),因此可以提高判定的精度。注意,由于存在由于人的视觉特性而引起的因素,并且视觉核查在过去的风险因素的视觉记忆中起作用,因此每个人的特征差异的表现等是不同的。

此外,判定单元320可以将判定结果输出到状况预测单元154(参见图5)或规划单元(移动体驾驶控制单元)134(参见图5)。例如,规划单元134可以基于判定单元320的判定结果来制定用于切换驾驶模式的规划。

<<8.眼球行为解析单元300的操作例>>

接下来,参照图9进一步说明根据本公开实施方案的眼球行为解析单元300的操作例的细节。图9是用于说明根据本公开实施方案的眼球行为解析单元300的操作例的细节的说明图。注意,在图9中,假设左端是出发地点(出发地),右端是目的地点(目的地)。在以下的说明中,从出发地点至目的地点进行说明。

首先,在本实施方案中,如图9所示,无论驾驶模式如何,都以预定频率间歇性地执行被动监控。例如,被动监控包括在低帧速率下眼睛的行为解析。执行眼球行为解析,例如,用于通过观测整个眼睛来执行PERCLOS评价,观测并解析作为详细的眼球行为的扫视、注视等,并判定驾驶员的睡意和疲劳度。

在本实施方案中,在图9的左侧所示的自动驾驶等级0和1的手动驾驶模式下的行驶区间中,不仅可以执行上述的被动监控,而且还可以在基于驾驶员的驾驶操作识别出驾驶员执行正常时手动驾驶的状况下,执行眼球行为解析(例如,微扫视),以便获取眼球行为学习装置302将要学习的教师数据(被标记为觉醒等级正常时的眼球行为的教师数据)。为了获取教师数据,例如,眼球行为解析单元300以高帧速率执行眼球行为解析。

此外,例如,假设在图9的左侧所示的自动驾驶等级2的手动驾驶模式中,通过在处于稳态状态、交通堵塞等的行驶区间中的被动监控来检测驾驶员的觉醒等级的下降。在这种情况下,可以以更高频率执行被动监控,并且可以更高的帧速率执行眼球行为解析(例如,微扫视)。这种情况下的眼球行为的解析结果是眼球行为学习装置302将要学习的教师数据(被标记为觉醒等级下降时的眼球行为的教师数据)。此外,根据对驾驶员觉醒等级下降的检测,作为主动监控,可以向驾驶员发出警报或通知。主动监控可以由驾驶员有意识地响应警报或通知来执行。例如,如上所述,通过使车辆控制系统100以作为能动信息的不必要的操舵量执行转向控制来执行通知。在这种情况下,驾驶员将转向恢复到适宜的操舵量的行动是有意识的响应。此外,如图9中的虚线所示,主动监控不限于在驾驶员的觉醒等级下降时执行,并且可以以预定频率周期性地执行。然而,在手动驾驶模式中,由于驾驶员始终执行用于手动驾驶的道路环境识别判断,因此除了在驾驶员的觉醒等级已经下降的状况下,执行上述主动监控不是必须的。

在手动驾驶模式的区间中,可以周期性地执行眼球行为解析。

在自动驾驶等级4的自动驾驶模式下的行驶区间中,驾驶员很可能已经离开了驾驶位。在该期间中,难以执行周期性的眼球行为解析(难观测期间)。因此,在该期间中,可以以更高的频率执行被动监控。

随后,在从自动驾驶模式切换到手动驾驶模式的驾驶模式的准备模式的区间中,集中地以高帧速率执行眼球行为解析。此外,优选确定眼球行为解析期间的时间长度,使得在车辆到达根据在基于LDM等的路线上设定的自动驾驶等级的驾驶模式的切换点之前,确保足够的时间来高度精确地判定驾驶员的觉醒等级。因此,在本实施方案中,基于时间表(行程)、LDM、道路状态、行驶速度、车辆类型(拖车或普通乘用车)、驾驶员的就座状态(状态信息)等来确定眼球行为解析的期间的开始点(监控点),即,该期间的时间长度动态地变化。此时,当检测到驾驶员的觉醒等级下降时,按照通知、警报、MRM警告、噪声注入(问答形式的问题)等的顺序对驾驶员执行用于调用驾驶员的内部觉醒的操作,同时,集中地执行用于检测驾驶员的有意识响应的主动监控。

即,在本实施方案中,由于眼球行为解析并不总是以高帧速率执行,因此可以减少成像处理、解析处理等的负荷。此外,在本实施方案中,由于在必要时以高帧速率执行眼球行为解析,因此可以精确地判定驾驶员的觉醒等级(返回反应等级)。

在本实施方案中,连续执行对驾驶员的各种观测,学习观测的倾向,并考虑每一时刻的倾向变化来判定诸如觉醒等级等返回反应等级。这是因为,即使在同一个驾驶员中,驾驶员过去的经历和履历也会影响驾驶员的感知、认知、判断、行为等。具体地,例如,观测到的眼球行为根据驾驶员感觉从自动驾驶返回(切换)到手动驾驶的需要会发生很大变化。例如,当用直感的行动降低风险所需的信息较差时,增加对可以在视觉上获取的信息的搜索,并且,如果充分准备了判定所需的信息,则可以在不执行大量信息搜索的情况下将搜索转移到行动。因此,当信息不足时,驾驶员重复以扫视、微扫视、瞟视、震颤等为特征的注视等,以通过利用指向目标的视线来识别个体视觉信息而搜索缺乏的信息。

特别地,在执行从自动驾驶到手动驾驶的返回行动中执行风险判断的阶段内,驾驶员在视觉上搜索记忆中残余的具有高风险且不足以进行判断的信息。例如,一段时间以来一直在观看视频或操作移动终端等而不向前看的驾驶员核查车辆前方以把握状况,并观测影响车辆的行驶方向的车道和障碍物、并行驾驶员和对向车辆的运动,并且执行诸如用于理解状况的注视的出现和返回请求RTI(通知)的消息信息的核查等过程。例如,在行人部分地突出到道路上或混合有儿童跳出来的学校区的城市区域中,用于核查人是否从道路周边部进入道路的视线行为占主导地位。

一种用于人类在执行认知问题的期间临时积累和处理信息的系统被称为作业存储器(作业记忆)。在人类的作业存储器中积累和处理人类行动判断所需的信息。然而,考虑到对可以累积的信息量和可以累积信息的期间存在限制。具体地,累积在作业存储器中的信息随着时间的流逝而衰减,并且例如,作业存储器像动态缓冲存储器一样操作,因为信息的记忆按照从具有最低重要性的信息开始的顺序来面对。随着自动驾驶的普及和可用于提高性能的运行设计区域的扩展,考虑到利用者始终核查安全手动驾驶所需的周围环境信息的需求逐渐减少。因此,行驶所需的前方核查次数减少,或者不执行前方核查。当偏离作业从驾驶操舵作业逐渐增加时,判断所需的行驶道路的事前视觉信息减少。首先,驾驶员在手动驾驶时不断进行道路前方核查,因为存在可能成为风险因素的风险重要性的权重刺激。驾驶员务必连续地执行事前视觉搜索,并避免疏忽驾驶。然而,当偏离作业从驾驶操舵作业增加时,如果作业存储器的衰退记忆中的风险因素较差,结果,由于观测周期性状况变化的必要性也减少,因此对引导视线和重新核查状况的行为的观测也会减少。在本实施方案中,考虑到其中记忆的信息随着时间的流逝从具有最低风险重要性的信息按顺序衰减的人类的作业存储器的这种特性,在适宜的时机提供用于适宜的手动驾驶的信息并将其通知给驾驶员,以执行例如对驾驶员的状态或响应的观测。

为了使驾驶员能够响应于从自动驾驶返回(切换)到手动驾驶的返回请求RTI(通知)而正常地开始实际的手动驾驶,需要用于获取行动判断所需的信息的期间。除了作为获取最新信息的行为的视觉核查之外,视觉信息获取还包括获取用于执行行为控制的反馈的信息的行为。注意,在本实施方案中,例如,如由本申请人提交的上述专利文献1中公开的手段等人机接口可以用于行动判断所需的信息。例如,上述专利文献1公开了将行驶路线分割成各种区间(手动驾驶区间、需要驾驶员干预的区间等),并且对于每个区间以不同的颜色和不同的宽度向驾驶员显示行驶路线。通过设计接近信息的显示时间轴,根据时间的流逝(=本车的行驶),驾驶员可以在视觉上知晓驾驶员何时接近需要应对的区间。即,由于如专利文献1中那样,驾驶员在沿着车辆的行程行驶所涉及的过程中不断更新并提供接近信息,因此即将到来的移交接近信息被取入思考的作业存储器中,作为时间流逝和接近移交点的视觉上风险。因此,驾驶员可以把握作为即将到来的风险的移交接近信息。以这种方式提供包括语义信息的视觉接近信息是用于核查移交给作业存储器之前的状况的刺激。提供更新信息的方式也会影响驾驶员的视觉行为。因此,在本实施方案中,当根据眼球行为解析及其观测评价值来估计驾驶员的状态时,可以通过考虑提供给驾驶员的信息作为影响因素来评价观测行为。信息通过人机接口随时更新和呈现,驾驶员在涉及时间接近感的同时,认识到从自动驾驶返回到手动驾驶的必要性的重要性。因此,返回所需的视觉信息被累积在驾驶员的作业存储器中。在用于驾驶员返回的行动判断中,基于所呈现的信息和由于驾驶员的风险感觉所引起的紧迫性来执行在移交到行动之前获取缺乏信息的行动。因此,由于通过人机接口的呈现信息将行驶中所需的预测信息植入(记忆)在驾驶员的作业存储器中,并且适宜地提供使驾驶员感觉到中途重新核查的必要性的信息,因此可以使驾驶员的无意识保持较浅。结果,加速了驾驶员的判断,从而导致上述专利文献1中公开的驾驶员的返回延迟时间(手动驾驶可返回时间)的减少。

在本公开中,主要关注于眼球行为的解析。然而,当驾驶员的觉醒状态不足时,由于上述所获取的信息的反馈有时未被完全执行,所以除了眼球行为之外,还会出现各种行为等,有时会导致驾驶员过度操舵。因此,在当周期性地核查通过预测例如自动驾驶被切换到手动驾驶的地点的状况而获得的预测信息的同时利用自动驾驶功能的驾驶员与完全忽略这种周期性核查的驾驶员之间,响应于返回请求RTI(通知)的眼球行为是不同的。此外,当驾驶员在驾驶员返回到手动驾驶的时间不足并且对手动驾驶的状况把握不完全的情况下迁移到操舵行动时,操舵行动中的反馈往往不完整,并且有时会出现诸如过度操舵等具有不适当操舵量的过冲操舵。

因此,为了使通过眼球行为的解析对驾驶员的返回反应等级(觉醒等级)和返回延迟时间的估计适宜地起作用,根据本公开实施方案的车辆控制系统100被构造为以下的系统:其中,随着行进向驾驶员呈现的接近信息、添加到所呈现的风险信息的附加信息、向驾驶员的通知、由接近信息、附加信息和通知诱导的实际返回行动和眼球行为、作为返回行动和眼球行为的结果的操舵稳定性等相互影响,并且确定驾驶员的返回行为。注意,在对学习的观测学习的说明中,眼球行为主要被说明为观测学习。然而,通过将由传感器单元113获取的各种观测信息设定为学习目标,除了眼球行为之外,还可以扩展利用驾驶员的觉醒状态的估计。

<<9.导致本公开实施方案的创建的背景>>

<9.1使用EVS>

此外,在说明本公开实施方案的细节之前,说明了发明人创建本公开实施方案的背景。

如上所述,车辆控制系统100需要把握驾驶员的大脑活动状态,以便判定返回反应等级。例如,当驾驶员在返回到手动驾驶之前临时打个盹,并且意识与驾驶操舵完全分离时,参照把握大脑中的(操舵判断所需的)状况所需的记忆进行判断的活动减少。为了把握在驾驶操舵期间用于把握其意识一度与驾驶操舵分离的驾驶员的大脑中的状况的活动状态是否已经返回到意识等级,期望能够直接观测大脑中的活动。然而,为了观测驾驶员大脑中的实际状态,需要诸如功能性磁共振成像(fMRI)设备或脑电图(EEG)设备等大型设备。即使通过设备进行观测,也不可能始终读取准确的大脑中的思想内容。此外,将该设备搭载到上述车辆控制系统100上是不现实的。

另一方面,尽管不能详细把握大脑中的活动,但是参照把握驾驶员大脑中的(操舵判断所需的)的状况所需的记忆进行判断的活动在视觉上被识别,并表现为参照记忆的行动。因此,可以通过观测驾驶员的眼球行为(扫视、微扫视等)来估计活动的一个方面。在人眼的结构中,用于详细的视觉识别的中心视野是窄的,并且因此,当获得诸如周边视野和声音等信息时,人类将中心视野转向相关方向。在人体结构中,由于与全身移动时相比,头部和眼球的惯性较小,因此头部和眼球改变方向所需的时间较短。因此,眼球行为可以是高速运动。因此,为了精确地估计大脑活动,精确地观测高速眼球行为是有效的。例如,在眼球扫视的行为解析中,有必要观测由于眼球的高速转动而引起的视线变化。为了把握这种高速转动,需要以高分辨率动态地检测眼球的虹膜和眼白的边界坐标。

然而,由于眼球行为是高速运动,在普通RGB相机(可见光相机)、红外相机或用于可见光和红外光的RGBIR相机(在下文中,除非特别需要区分相机,否则这些相机被统称为RGB相机)中,由于数据读取和传输的限制,可以持续使用的帧速率存在限制。即使临时强制提高帧速率,帧速率的高操作频率也会产生有害的结果,并导致成像元件的温度上升。结果,成像元件的噪声由于温度上升而增加。在没有噪音的情况下很难细节地把握将要观测的高速眼球行为。

因此,本发明人认为,在上述的车辆控制系统100中,当通过解析眼球行为来判定驾驶员的返回反应等级(觉醒等级)时,使用事件视觉传感器(EVS)来观测驾驶员的眼球行为。

EVS是灵敏地检测亮度变化的图像传感器。由于光电转换的对数转换特性,EVS具有比一般RGB传感器或IR传感器的动态范围更宽的动态范围。因此,可以容易地获得作为帧累积型RGB传感器或IR传感器不擅长的、从暗时到明亮范围的广域中被摄体的亮度边界的变化点的边缘信息。EVS不具有帧速率的概念,并且如果存在频繁的亮度变化,则可以根据亮度变化以高数据速率输出相关地址信息。此外,当出现超过阈值的亮度变化时,EVS稀疏地输出亮度变化的时间戳信息和像素信息(坐标信息),即,不输出针对各固定帧的所有像素信息。因此,数据量小于RGB传感器和IR传感器的数据量,并且可以减少数据传输和演算处理的负担。

<9.2EVS>

因此,参照图10和图11来说明事件视觉传感器(EVS)400。图10是示出在本公开的实施方案中使用的EVS 400的构成的示例的框图。图11是示出位于图10所示的EVS 400中的像素阵列单元500中的像素502的构成的示例的框图。

如图10所示,EVS 400包括通过将多个像素502(参见图11)以矩阵状排列的像素阵列单元500。像素502可以生成与通过光电转换生成的光电流相对应的电压作为像素信号。像素502可以通过将与入射光的亮度变化相对应的光电流变化与预定阈值进行比较来检测事件的存在与否。换句话说,像素502可以基于亮度变化超过预定阈值的事实来检测事件。

此外,如图10所示,EVS 400包括作为像素阵列单元500的周边电路单元的驱动电路411、仲裁器单元(仲裁单元)413、列处理单元414和信号处理单元412。

当检测到事件时,像素502可以向仲裁器单元413输出用于请求输出表示事件发生的事件数据的请求。当从仲裁器单元413接收到表示容许输出事件数据的响应时,像素502将事件数据输出到驱动电路411和信号处理单元412。已经检测到事件的像素502将通过光电转换生成的像素信号输出到列处理单元414。

驱动电路411可以驱动像素阵列单元500的各像素502。例如,驱动电路411检测事件,驱动已经输出事件数据的像素502,并使像素502将相关像素502的像素信号输出到列处理单元414。

仲裁器单元413可以仲裁用于请求输出从各像素502供给的事件数据的请求,并基于仲裁结果(许可/不许可输出事件数据)和用于复位事件检测的复位信号向像素502发送响应。

针对像素阵列单元500的每一列,列处理单元414可以执行将从相关列中的像素502输出的模拟像素信号转换为数字信号的处理。列处理单元414还可以对数字化的像素信号执行CDS(相关双采样)处理。

信号处理单元412可以对从列处理单元414供给的数字化的像素信号和从像素阵列单元500输出的事件数据执行预定的信号处理,并输出信号处理后的事件数据(时间戳信息等)和像素信号。

在像素502中生成的光电流的变化可以被捕捉为入射到像素502上的光的光量变化(亮度变化)。因此,也可以说,该事件是超过预定阈值的像素502的亮度变化。此外,表示事件的发生的事件数据可以至少包括诸如表示其中已经发生作为事件的光量变化的像素502的位置的坐标等位置信息。

此外,参照图11说明像素502。在通过将多个像素502以矩阵状排列而构成的像素阵列单元500中,各像素502包括光接收单元504、像素信号生成单元506和检测单元(事件检测单元)508。

具体地,光接收单元504可以对入射光进行光电转换以生成光电流。然后,光接收单元504可以根据驱动电路411的控制将与光电流相对应的电压的信号供给到像素信号生成单元506和检测单元508中的一个。

像素信号生成单元506可以生成从光接收单元504供给的信号作为像素信号。然后,像素信号生成单元506可以经由与像素阵列单元500的列相对应的垂直信号线VSL(未示出)将生成的模拟像素信号供给到列处理单元414。

检测单元508可以基于来自光接收单元504的光电流的变化量(即,像素502上的入射光的亮度变化量)是否超过预定阈值来检测事件的发生与否。事件的示例可以包括指示光电流的变化量已经超过上限阈值的接通事件和指示变化量下降到下限阈值以下的断开事件。注意,检测单元508可以仅检测接通事件。

当事件发生时,检测单元508可以向仲裁器单元413输出用于请求输出表示事件发生的事件数据的请求。然后,当从仲裁器单元413接收到对请求的响应时,检测单元508可以向驱动电路411和信号处理单元412输出事件数据。注意,在本实施方案中,特别地,当对驾驶员面部的一部分、特别是眼睛的瞳孔检测是专门的并且该部分被用于对该部分的区域的行为解析时,可以提供用于将由仲裁器单元413读取和分配的区域限制为ROI(感兴趣区域)的ROI读取功能。特别地,在瞳孔轮廓检测的情况下,由于目标区域是准圆形区域的椭圆,因此还可以进一步定义具有中心点和半径的搜索仲裁器的目标区域,并且限制读取数据。

<9.3导致本公开实施方案的创建的背景>

然而,在独立地进行关于车辆控制系统100的研究的同时,本发明人认识到,当要使用EVS 400获取诸如驾驶员的眼球行为等观测数据时,可能会发生以下问题。如上所述,EVS 400基于亮度变化超过预定阈值的事实来检测事件。因此,例如,当阈值降低时,EVS400甚至检测到亮度的微小变化作为事件。因此,将被检测的事件会频繁发生,并且检测到的事件的数据量会增加。结果,数据量超过接口的传输带域,并且可能会出现数据不能传输到其他功能块等的问题。在这种情况下,不能发送由EVS 400检测到的所有数据。因此,结果,不能检测到原本期望被检测到的期望事件。另一方面,例如,当阈值增加时,可能会出现EVS 400不能检测到期望事件的问题。

更具体地,当由于扫视行为而发生眼球转动时,由于瞳孔边界线的移动而发生亮度变化,并且当亮度变化超过阈值时,亮度变化由EVS 400检测为事件,并且输出已经发生亮度变化的像素502的坐标信息。在这种情况下,当阈值降低时,可能会出现将被检测的事件频繁发生并且检测到的事件的数据量超过接口的传输带域且不能被传输的问题。此外,由于处理量根据数据量而增加,因此也可能会出现诸如处理的操作温度上升等问题。另一方面,当阈值增加并且将被检测的事件减少时,由EVS 400检测到的事件相对于眼球的转动而稀疏。可能会出现不能精确地观测包括基于瞳孔边界线的移动的根据时间流逝而移动的坐标组的点云的移动重点的问题。

此外,当通过EVS 400不仅捕捉驾驶员的眼球行为而且还捕捉面部的方向、表情等时,因为眼球行为和面部的方向、表情等所需的检测特性有很大不同,而难以实现EVS 400中的眼球行为的观测和其他观测。

因此,鉴于这种情况,本发明人创建了本公开的实施方案。在本公开的实施方案中,当使用EVS 400观测驾驶员的眼球行为时,可以通过调整可以定义EVS 400的事件检测的频率的阈值来优化眼球行为的观测。在本公开的实施方案中,也可以动态调整照明驾驶员的照明装置。因此,根据本公开的实施方案,可以以最佳频率执行事件检测,从而精确地捕捉将要观测的变化,同时抑制用于观测诸如扫视、微扫视和瞟视等眼球行为、眨眼的检测、面部表情的变化等的数据量的增加。虽然检测事件时的阈值的调整在电路设计中是离散设定的,但是在照明装置中,由于阈值可以通过光源设备的快门等任意调整,因此具有高灵活性的优点,例如,可以执行优化调整。

具体地,在本公开的实施方案中,当使用EVS 400观测扫视行为、微扫视行为等时,在需要眼球行为的观测的时机调整EVS 400的事件检测的阈值。以这种方式,可以有效且精确地捕捉扫视行为和微扫视行为,同时抑制数据量的增加并减少演算处理和传输的负荷。

在本公开的实施方案中,当使用EVS 400观测眼球的扫视行为时,在需要眼球行为的观测的时机,使用选择性地透过具有窄带波长的光的滤波器,在驾驶员的面部上照射具有窄带波长的光。因此,由于可以使眼球的虹膜和瞳孔之间的边界阴影明显,所以可以选择性地且有效地精确地观测诸如扫视和微扫视等眼睛的高速行为。

下面说明由本发明人创建的本公开的实施方案的细节。

<<10.实施方案>>

<10.1安装位置>

首先,参照图12至图14说明本公开的实施方案中的EVS 400的安装位置的示例。图12至图14是用于说明根据本实施方案的成像装置700和702的安装位置的说明图。

首先,成像装置700是主要观测车辆600内的驾驶员900的位置并且观测坐在驾驶位602(参照图13)上的驾驶员900的面部和就座坐姿的成像装置。例如,成像装置700可以是RGB相机(可见光相机)或者可以是ToF相机。成像装置700可以是EVS 400。如图12所示,成像装置700优选地设置在车辆600内的驾驶位602的前方上侧。

成像装置702是对车辆600的内部进行成像的成像装置,具体地,其是主要观测驾驶员900的眼球行为(眼球的扫视、注视、微扫视等)的包括EVS 400的成像装置。注意,在本实施方案中,成像装置702不仅观测眼球行为,而且可以观测驾驶员900的面部的状态等,并且可以观测车辆600内部的各种状态。如图12所示,成像装置702优选地设置在车辆600内的驾驶位602的前方下侧的方向盘的下部附近。

更具体地,如图13所示,当从侧面观看驾驶员900时,成像装置700设置在车辆600内的驾驶位602的前方上侧,并且具有宽的视角,从而能够主要捕捉坐在驾驶位602上的驾驶员900的姿势。

成像装置702被设置为与驾驶员900相对,从而能够主要捕捉坐在驾驶位602上的驾驶员900的面部。具体地,如图13所示,成像装置702优选地相对于当驾驶员900观看位于驾驶员900前方无限远处的物体时的视线方向902(水平远方无限远视线)位于下方,从而不干扰驾驶员900的视野。此外,成像装置702优选地被设置为使得由连接驾驶员900的眼球和成像装置702的线段与视线方向902形成的角度θ为10度以上且小于30度,从而可以正面地观测驾驶员900的瞳孔。注意,如果可以使用半反射镜、波长选择镜等在不干扰驾驶员900的前方直视的情况下配置成像装置702,则成像装置702的配置不限于上述。由成像装置702的光轴形成的角度θ不需要是10度以上。

如图14所示,当从车辆600的上侧观看时,成像装置702优选地具有使成像装置702能够至少捕捉坐在驾驶位602上的驾驶员900的面部的视角。

<10.2单元的构成例>

接下来,参照图15说明根据本公开实施方案的执行驾驶员900的眼球行为的观测的单元的构成例。图15是用于说明根据本实施方案的执行驾驶员900的眼球行为的观测的单元的示例的说明图。

具体地,执行驾驶员900的眼球行为的观测的单元主要包括图5所示的车内信息检测单元142的一部分、包括在传感器单元113中包含的EVS 400的成像装置702以及至少照明驾驶员900的面部的照明单元710。车内信息检测单元142的一部分、成像装置702和照明单元710协作,从而执行根据本实施方案的驾驶员900的眼球行为的观测。在以下的说明中,顺次说明图15所示的各功能块。

(成像装置702)

如上所述,成像装置702是观测驾驶员900的眼球行为的成像装置,并且包括EVS400。成像装置702由以下说明的传感器控制单元330控制,并将观测到的数据输出到眼球行为解析单元300。

(照明单元710)

照明单元710设置在车辆600内,并且当捕捉驾驶员900的眼球行为时,可以用具有预定波长的光(例如,近红外光)照射驾驶员900的面部。例如,主要使波长为940nm以上且960nm以下的光透过的滤波器被配置在成像装置的透镜中,由此照明单元710可以通过在需要眼球行为的观测的时机用具有窄带波长的光照射驾驶员900的面部来抑制外光的影响。在本实施方案中,由于由眼球的虹膜和瞳孔形成的边界阴影可以通过外光(阳光)的噪声较少的近红外光而变得明显,因此通过成像装置702可以选择性地且有效地精确地观测驾驶员900的眼球行为(扫视行为)。此外,在照明单元710中,可以通过下面说明的照明控制单元332来调整将要照射的光的强度、照射时间或照射间隔等,从而更容易地捕捉驾驶员900的眼球行为。注意,根据将要使用的光源的类型和成像装置的光接收单元的波长灵敏度分布,可以使用上述设定以外的波长灵敏度。

注意,当成像装置702被用作仅观测眼球行为的成像装置时,滤波器可以适用于成像装置702。因此,成像装置702可以仅捕捉外光的噪声较少的近红外光的反射。

(传感器控制单元330)

传感器控制单元330设置在车内信息检测单元142内,并且控制成像装置702。具体地,当捕捉驾驶员900的眼球行为时,传感器控制单元330改变可以定义包括EVS 400的成像装置702的事件检测的频率的阈值。因此,成像装置702可以以最佳频率执行事件检测,从而精确地捕捉将要观测的变化,同时抑制用于观测诸如扫视、微扫视和瞟视等眼球行为、眨眼检测、面部表情变化等的数据量的增加。此外,当成像装置702不仅具有捕捉驾驶员900的眼球行为的功能,而且还具有捕捉驾驶员900的位置和姿势的功能时,可以通过临时优化用于眼球行为的观测的阈值来精确地观测眼球行为。

更具体地,例如,传感器控制单元330可以将成像装置702的像素阵列单元500内的用于捕捉驾驶员900的面部或眼球的区域设定为感兴趣区域(ROI),并且改变像素502的阈值以仅输出该区域内的像素502的数据。此外,传感器控制单元330可以利用眼球行为解析单元300来解析观测到的数据,并通过接收解析结果的反馈来改变阈值。

(照明控制单元332)

照明控制单元332设置在车内信息检测单元142内,并且控制照明单元710。具体地,当捕捉驾驶员900的眼球行为时,照明控制单元332控制来自照明单元710的光的强度、照射时间或照射间隔。因此,成像装置702可以更容易地捕捉驾驶员900的眼球行为。此外,照明控制单元332可以利用眼球行为解析单元300来解析观测到的数据,并通过接收解析结果的反馈来控制来自照明单元710的光的强度、照射时间或照射间隔。

(眼球行为解析单元300)

眼球行为解析单元300解析由成像装置702观测到的数据。具体地,眼球行为解析单元300可以基于包括检测到事件的成像装置702的像素502的位置坐标点的点分布的形状来区分所述眼球行为的类型(扫视、微扫视等)。更具体地,当检测到具有新月形状的点分布的出现时,眼球行为解析单元300解析出已经出现了微扫视。此外,在本示例性实施方案中,眼球行为解析单元300的解析结果用于判定单元320中的判定(驾驶员的返回响应等级的判定),并且基于判定单元320的判定结果来切换驾驶模式。

<10.3信息处理方法>

接下来,参照图16至图18说明根据本公开实施方案的信息处理方法。图16和图17是用于说明根据本实施方案的信息处理方法的示例的流程图。图18是用于说明由成像装置702观测到的观测数据的示例的说明图。

首先,如图16所示,根据本实施方案的信息处理方法可以包括从步骤S31至步骤S44的步骤。下面将说明根据本实施方案的步骤的细节。

首先,车辆控制系统100评价驾驶员900从离开座椅到返回到驾驶位602中的驾驶姿势的返回移行(步骤S31)。接下来,车辆控制系统100判定驾驶员900是否已经坐在驾驶位602上并且已经返回到驾驶姿势(步骤S32)。当驾驶员900已经坐在驾驶位602上并且已经返回到驾驶姿势时(步骤S32:是),车辆控制系统100前进到步骤S33。当驾驶员没有坐在驾驶位602上或者没有返回到驾驶姿势时(步骤S32:否),车辆控制系统100返回到步骤S31。注意,其中即使驾驶员900坐在驾驶位602上驾驶员900也不处于驾驶姿势的情况可以设想为其中驾驶员900打瞌睡(由于打瞌睡引起的颈部的不稳定抖动等而被检测到)、分心或者面向驾驶位602的前方以外的方向不适宜地就座的情况。在本实施方案中,例如,可以通过从由上述成像装置700和702观测到的观测数据来检测驾驶员900的面部等而指定驾驶员900的位置和姿势。

车辆控制系统100核查驾驶员900的驾驶姿势,并指定驾驶员900的面部和眼睛的区域的位置(步骤S33)。在本实施方案中,例如,驾驶员900的面部和眼球的位置可以通过从由上述成像装置700和702观测到的观测数据来检测驾驶员900的面部、眼球等而指定。

车辆控制系统100根据驾驶员900的面部或眼球的位置,将成像装置702的捕捉面部或眼球的像素阵列单元500内的区域设定为ROI(感兴趣区域)(步骤S34)。因此,在本实施方案中,仅必须输出与在对应于设定的ROI的像素502中检测到的事件有关的数据。因此,可以抑制将要输出的数据量的增加。此外,当成像装置702不仅具有捕捉驾驶员900的眼球行为的功能,而且还具有捕捉驾驶员900的位置和姿势的功能时,可以通过临时优化用于眼球行为的观测的阈值来精确地观测眼球行为。

车辆控制系统100调整可以定义成像装置702的事件检测的频率的阈值(事件检测阈值)(步骤S35)。此时,可以仅调整与在上述步骤S34中设定的ROI相对应的像素502的阈值。在本实施方案中,可以根据期望观测的眼球行为(扫视或微扫视)将阈值设定为预定数值,并且可以根据预先登记的驾驶员900的属性信息(虹膜的颜色、年龄和性别)进一步设定。在本实施方案中,可以根据经由行驶时的时间、天气和行驶期间的道路周围的状态(地形、隧道等)预测的外光的影响来设定阈值。此外,在本实施方案中,可以基于在每次驾驶中机器学习的驾驶员900的眼球行为的观测数据的倾向来设定阈值。

其后,例如,当微扫视出现在驾驶员900的眼球中时,瞳孔的边界移动,并且成像装置702作为事件检测到由于该移动引起的亮度变化。此时,在RGB相机中,由于有时在瞳孔的边界、虹膜图案等中存在个体差异,因此会发生渗出、模糊等,并且难以明显地捕捉微扫视。然而,在本实施方案中,在作为EVS 400的成像装置702中,阈值被设定为适于微扫视的观测的阈值,由此可以根据事件的点分布(点云)来精确地捕捉微扫视。

此外,微扫视是由骨骼肌在眼球周围拉动眼球的运动引起的,如眼眶隐窝中的上直肌和下直肌、外直肌和内直肌以及上斜肌和下斜肌。特别是,瞳孔的左右运动主要由上直肌和下直肌以及外直肌和内直肌引起。这里重要的是捕捉作为基于视觉信息的大脑活动所必需的思考活动的复活的微扫视,其是搜索运动,其中骨骼肌直接从大脑接收命令并且捕捉由骨骼肌引起的眼睛的轻微摆动。在本实施方案中,通过捕捉这种微扫视,可以通过观测与漠不关心时的无特定目的的情况下的眼睛运动明显不同的眼球行为来捕捉大脑中的思考活动,尽管不能直接解读作为思考内容的内容。

随后,车辆控制系统100调整照射单元(光源)(步骤S36)。在本实施方案中,例如,车辆控制系统100调整来自照明单元710的光的强度、照射时间或照射间隔。因此,在本实施方案中,成像装置702可以更容易地捕捉驾驶员900的眼球行为。

随后,车辆控制系统100判定是否已经从观测数据中检测到具有新月形分布的事件数据作为眼球行为(步骤S37)。例如,作为微扫视,如图18所示,眼球高速转动,假设由瞳孔轮廓边界的横切成像面的移动引起的亮度变化作为事件,零星地生成点数据,并且作为新月形的分布被检测到,作为一定期间的点的集合。随着眼球的转动,横切成像面的具有最大移动量的部分是新月形的厚的中央部,并且由于瞳孔的边界移动在转动上较差,所以在切线处几乎不发生事件。因此,在一定的时间间隔发生的事件的总和表现为这样的新月形分布的区域。在微扫视的情况下,各个转动主要是注视内的随机摆动。当已经检测到具有新月形分布的事件数据时(步骤S37:是),车辆控制系统100前进到步骤S38。当没有检测到具有新月形分布的事件数据时(步骤S37:否),车辆控制系统100返回到步骤S35和S36。由眼球的移动产生的点的集合体作为新月形状态而分布,因为该集合体是由瞳孔边界在将要扫描的像面上移动一定时间并收集作业中产生的事件点而获得的集合的结果。当集合体以更精细的时间分辨率被图示化时,该集合体是具有线宽分布的圆弧。然而,为了清楚地说明配置本实施方案的原理,将集合体表示为新月形。瞳孔的实际颜色和实际形状、边界的轮廓清晰差异等具有取决于个人的个体差异,并且取决于各种条件而变化,例如照明条件、可用光源波长和使用中的窄带滤波器的带通宽度。因此,取决于照明和检测条件,检测到的点云的时间序列集合有时不是具有清晰轮廓的新月形。在本说明书中,将包括在清晰区域不相关的情况下由眼球微细行为所产生的检测事件的检测事件记载为新月形分布的检测。即,在本实施方案中,检测到的事件数据的分布的形状可以是例如新月形状,或者可以是其他形状,没有特别限制。

具体地,例如,当人们看到人们不能简单理解的目标时,其在参照他/她自己的记忆的同时,在视觉上捕捉目标,并进一步整理目标、详细部分和记忆,以最终完成对目标的内容的理解。在这种状况下,在许多情况下,人们用眼球进行注视,以捕捉细节。然而,在这种注视中,出现了由于眼球的随机转动引起的摆动(微扫视)。结果,在该微扫视中,当瞳孔的边界在眼球的转动方向上移动时,作为成像装置702捕捉的亮度变化随时间的变化,例如,如图18所示,表现出横切转动方向的新月形分布。图18示意性地示出了由微扫视发现的新月形的暗明(左侧)的点云和新月形的明暗(右侧)的点云。然后,在驾驶员900重复参照和理解记忆的同时,通过执行经由微扫视而具有随机眼球行为的注视,成像装置702观测新月形的点云和瞳孔的边界线在新月形的边界线附近波动的状态。即,在微扫视的情况下,例如,观测到具有与宽度与瞳孔一样大的宽点云的形状不同形状的点云,该点云由正常注视期间的大扫视移动引起。因此,通过观测新月形的点云,可以观测到大脑中的思考活动的出现。

即,在本实施方案中,通过使用EVS 400作为成像装置702,可以利用观测到的点云的形状来区分扫视和微扫视。具体地,扫视是对存在于极大不同位置的对象执行的注视方向上的移动,被观测为在沿着扫视的移动的一定方向上的厚的带状点云。另一方面,在搜索信息细节的注视时的微扫视被观测为以注视方向为中心快速摆动的新月形的点云。因此,可以利用观测到的点云的形状来区分扫视和微扫视。

此外,在本实施方案中,在其中没有检测到具有新月形分布的事件数据的情况下(步骤S37:否)的步骤S35和步骤S36中,可以基于成像装置702对观测数据的解析结果,再次调整用于成像装置702的事件检测的阈值、来自照明单元710的光的强度、照射时间或照射间隔等。在步骤S35和步骤S36中执行事件判定阈值的调整和照明光源的调整,它们以这样的频率发生:在该频率下可以将根据在微扫视中发生的瞳孔转动而移动瞳孔边界的事件的发生作为新月形分布来把握。

车辆控制系统100的成像装置702输出亮度变化像素的坐标点群(点云)(步骤S38)。随后,车辆控制系统100基于在步骤S38中输出的点云来执行对构成眼球行为的点群的详细解析(步骤S39)。然后,车辆控制系统100详细评价眼球行为,即,诸如扫视(眼球转动)、注视或微扫视(眼球微小转动)等眼球行为(步骤S40)。在该步骤中,代替用于注视的方向估计的解析和评价,直接解析基于在通过微扫视的注视期间的随机小间距抖动的出现的有无而作为新月形事件的点云被选择性输出的有限数据本身。因此,由于解析是脑内活动的估计(解析评价),所以不执行高负荷演算处理,例如通过搜索用于检测瞳孔的整个图像来执行的正常多帧图像的连续处理解析。扫视和微扫视的不同之处在于,前者作为从扫视开始点延伸到目标方向的带状点云连续地延伸。

车辆控制系统100判定驾驶员900的眼球行为是否是相当于用于视觉核查的扫视(眼球转动)、注视或在注视期间出现的微扫视(眼球微小转动)的眼球行为(步骤S41)。当已经检测到用于视觉核查的眼球行为时(步骤S41:是),车辆控制系统100前进到步骤S43。当没有检测到用于视觉核查的眼球行为时(步骤S41:否),车辆控制系统100前进到步骤S42。

车辆控制系统100判定是否已经达到预定的判定处理的觉醒返回判定所允许的时间预算(当MRM未被激活时,在自动驾驶中仍然存在超过移交限制点的风险时的容许限制时间)的上限(步骤S42)。当已经达到重试容许的上限时(步骤S42:是),车辆控制系统100前进到步骤S44。当没有达到重试容许的上限时(步骤S42:否),车辆控制系统100返回到步骤S38。然后,车辆控制系统100执行关于驾驶员900是否具有驾驶员900可以返回到手动驾驶的觉醒等级的判定,并记录观测数据作为驾驶员900的认知响应(步骤S43)。此外,车辆控制系统100判定在剩余时间预算内不能确认驾驶员900具有驾驶员900可以返回到手动驾驶的觉醒等级。车辆600执行诸如紧急停止等用于避免进入手动驾驶区间的处理(步骤S44)。

在具有图17所示的子步骤的流程中处理上述步骤S43。步骤S43可以包括从步骤S51至步骤S55的步骤。子步骤的细节将在下面进行说明。

车辆控制系统100判定是否已经执行了关于驾驶员900是否具有驾驶员900可以返回到手动驾驶的觉醒等级的判定(步骤S51)。当已经执行了判定时(步骤S51:是),车辆控制系统100前进到步骤S52。当没有执行判定时(步骤S51:否),车辆控制系统100执行上述步骤S43并返回到步骤S51。

车辆控制系统100判定是否已经判定了驾驶员900具有驾驶员900可以返回到手动驾驶的觉醒等级(步骤S52)。当已经判定驾驶员900具有驾驶员900可以返回到手动驾驶的觉醒等级时(步骤S52:是),车辆控制系统100前进到步骤S53。当已经判定驾驶员900不具有驾驶员900可以返回到手动驾驶的觉醒等级时(步骤S52:否),车辆控制系统100前进到步骤S54。

车辆控制系统100将自动驾驶模式切换到手动驾驶模式(具体地,开始在用于切换的准备阶段中的处理)(步骤S53)。

车辆控制系统100判定是否已经达到判定处理的重试次数的预定上限(步骤S54)。当已经达到重试次数的上限时(步骤S54:是),车辆控制系统100前进到步骤S55。当没有达到上限时(步骤S54:否),车辆控制系统100返回到步骤S51。重试次数不应超过移交待机容许的限制点。

车辆控制系统100判定觉醒等级评价不合格,即,不能确认驾驶员900具有驾驶员900可以返回到手动驾驶的觉醒等级,并结束处理。在这种情况下,不允许返回到手动驾驶,并且汽车执行诸如紧急停止等用于避免进入手动驾驶区间的处理(步骤S55)。注意,这种设定的基本是在觉醒返回不明确的情况下防止返回的处置。作为驾驶员的紧急时的异常状况的应对,不存在使配备在车辆的控制系统中的驾驶员的自动驾驶系统的控制超控功能无效化的应对。当无法获得早期返回确认时,设定可管控的限制点并将随后的无效化设定为基本的目的,作为通过使驾驶员的延迟应对常态化来尝试不合理返回的预防性功能而发挥作用,并防止由于延迟和恐慌返回造成的诱发事故等。

<10.4实施例>

此外,对执行驾驶员900的觉醒等级的判定处理的具体例进行说明。例如,通过向驾驶员900提出下面说明的问题来执行判定处理。

首先,参照图19说明用于执行驾驶员900的觉醒等级的判定处理的具体构成。图19是用于说明车辆控制系统100的用于执行驾驶员900的觉醒等级的判定处理的部分构成的说明图。具体地,图19示出了上述的面部追踪单元204和眼球行为解析单元300、存储在存储单元111中的DB(数据库)800、设置在输出控制单元105中的显示信息生成单元802和显示单元804。

面部追踪单元(驾驶员面部追踪器)204检测驾驶员900的面部和头部的运动信息,并将该运动信息输出到显示信息生成单元802。

显示信息生成单元802在确认驾驶员900坐在驾驶位602上之后生成将要在显示单元804上显示的问题。具体地,例如,显示信息生成单元802生成问题以回答在显示的多个剪影之中的小动物的剪影的数量。可用于生成各种问题的数据被存储在显示信息DB 800中。注意,下面将说明具体问题的示例。尽管在正常使用中向驾驶员提出问题并不始终是必须的过程,但是有些利用者虽然被觉醒,却在没有充分视觉核查周边状况(在从自动驾驶到手动驾驶的移交中是期望的)的情况下漫不经心地开始移交,而忽视了核查周边状况并保持了较差的视觉核查。因此,问题提出是通过促使驾驶员再次执行人工状况把握而经由当时所需的视觉核查目标中出现的微扫视的检测对大脑中的活动估计有效的问题生成。即,该实施例是其中当不能预期到应该自然执行的车辆周围核查的视线核查操作时人为地执行生成问题以进行代替。

当由显示信息生成单元802生成的问题显示在显示单元804上时,驾驶员900将视线移动到该问题,以便获取该问题的回答。例如,如上所述,在显示单元804上显示需要判断的视觉问题,例如回答多个剪影之中的小动物的剪影的数量。为了获取该问题的回答,驾驶员900执行眼球行为以补充必要的信息。例如,驾驶员900执行诸如眼球的扫视(眼球转动)、注视或微扫视(眼球微小转动)等眼球行为。眼球行为解析单元300识别由显示信息生成单元802生成的问题,然后解析观察显示单元804上显示的问题的驾驶员900的眼球行为。注意,在本实施方案中,优选的是,显示单元804与驾驶员900的面部相对,并且相对于当驾驶员900观看位于前方无限远处的物体时的视线方向位于下方。

尽管在眼球的详细行为解析的一部分中存在生物反射性地出现的行为,但是在行为中也同时观察到反映大脑中的神经传递和处理的许多现象。因此,诸如大脑识别等活动结果被反映并在表格中可见。利用大脑中的活动被反映在眼球行为中的事实,可以高度精确地估计驾驶员的觉醒等级。

当人们执行行动所需的状况判定时所获取的外界信息通常是从视觉信息中获得的。当人们感知和识别视觉信息并将视觉信息转化为行动时,人们将视线指向信息,并在信息和他/她自己的记忆(记录的知识)之间进行比较和参照。众所周知,直到人们理解了视线之前的信息,人们会将视线指向信息被看到的部分,并且无意识地表现出视觉信息识别所需的特定眼球行为,如在这种注视期间发生的微扫视、震颤和瞟视。

当人处于正常觉醒状态时和当人们处于意识/觉醒低下状态时,这种眼球行为表现出不同的行为。具体地,当观看某些信息(问题)并试图理解内容时,人们执行大的称为扫视的眼球转动,将眼球(准确地说,中心视野)转向到预定的视觉部分,并在该视觉部分的附近执行注视和涉及作为局部区域的微小眼球转动操作的微扫视的眼球行为。

如上所述,当人们有意识地从视觉信息中获取必要的信息并执行必要的判断时,为了获取信息,出现了特征性的眼球行为。另一方面,当由于例如意识下降而导致视觉信息搜索不充分时,为了确实地获取信息,在注视所必需的眼球行为中发生干扰。这里,参照图20说明当提出观看信息的视觉问题时的驾驶员900的眼球行为的轨迹的示例。图20是用于说明当提出观看信息的视觉问题时的驾驶员900的眼球行为的轨迹的示例的说明图。

首先,图20的(a)示出了一个问题。具体地,该问题是对多个剪影之中的小动物的剪影的数量进行计数的问题。

顺便要说的是,视线的顺序因观看者的不同而不同。视线的顺序是多种多样的,例如,一些受试者首先将视线指向作为问题的疑问句“Q”,一些受试者观看回答“Ans”、观看疑问句“Q”、然后观看数组的整个图面,一些受检者粗略地观看回答的剪影信息、然后观看问题。然而,在大脑中的活动评价中,重要的是评价在评价的每一时刻都是受试者的驾驶员900是否表现出执行搜索和注视的行为,其对于执行在该时刻的回答所必需的信息获取核查是必要的。

以图20的(b)和(c)所示的观测数据为例进行说明。图20的(b)示出了在觉醒等级高的状态下应对问题时的眼球行为。另一方面,在图20的(c)中示出了在应对视觉问题的能力下降的状态下的眼球行为的轨迹示例。在图20的(c)中,尽管眼睛是睁开的,但是不足以应对该问题,因此,眼球行为是在包括眼球扫视的视觉信息搜索中明显表现出的所谓的警惕地环顾四周的倾向的一个示例。这受到属于个体的倾向的影响,例如行为特性的斜视和效果的影响以及伴随当天身体状况的视力变化。因此,希望在考虑个体特性的情况下执行状态判定以进行觉醒判定。希望在识别个体之后考虑个体的特性来执行判定。

例如,为了核查驾驶员900的意识是否在自动驾驶期间继续保持,有必要执行定期监控。为了在不过度打扰驾驶员900的情况下执行监控,系统例如向驾驶员900提出需要某种思考判断的符号,并观测眼球行为。作为观测的结果,当观测到驾驶员900通过视线成功地执行思考核查操作时,推测驾驶员900优先在大脑中执行思考活动以应对问题,并且不会继续沉迷于其他次级任务。该系统可以执行用于检测驾驶员900的视线转向所提出的信息并且响应于检测的进一步视觉识别来判定识别完成的处理。如果驾驶员执行手动驾驶,则由于周围监控义务本来发生在驾驶中,因此要求在正确执行实际的移交操舵之前开始监控义务。因此,尽管并不总是要求用显示信息生成单元802生成目标的视觉信息,但是通过包括用于执行显示的手段,与在不引起驾驶员注意的单调道路上相比,可以更灵活地把握驾驶员的状态。

注意,优选的是,驾驶员900特有的学习数据用于基于眼球行为的觉醒等级判定处理。例如,在包括在车辆控制系统100中的学习装置(未示出)或外部服务器中生成学习数据。例如,学习装置获取由眼球行为解析单元300解析的眼球行为信息,获取由判定单元320基于眼球行为信息判定的驾驶员900的觉醒度信息,并且进一步获取驾驶员900的驾驶操舵信息。然后,学习装置基于所获取的信息,学习驾驶员900的眼球行为与眼球行为时的驾驶员900的觉醒等级之间的正确对应关系,并将所学习的对应关系作为学习数据存储在存储单元中。学习装置可以通过执行与输入影响因素相关联的学习来执行状况适用类型判定,如通过另一个生物传感器(未示出)与驾驶员900的生物信号的相关性以及白天的使用时间段等,并且实现高精度的判定。

判定单元320可以获取眼球行为解析单元300解析的眼球行为信息,并使用眼球行为信息和学习装置生成的学习数据以更高的精度执行觉醒度判定。注意,在本实施方案中,当不存在学习数据或学习数据很少时,判定单元320可以使用一般的眼球行为和觉醒等级之间的对应数据(人的平均数据)来执行觉醒等级判定,而不使用学习数据。

如上所述,眼球行为解析单元300获取眼球的扫视(眼球转动)、注视和微扫视(眼球微小转动)等眼球行为,其作为驾驶员900解决问题的眼球行为。学习装置重复地获取与驾驶员900的觉醒等级相对应的行为特性,并且构建用于执行累积学习和执行从眼球行为的觉醒等级判定的辞典。该辞典用于从重新观测到的眼球行为特性来估计在观测时的利用者的觉醒状态。

接下来,参照图21和图22说明驾驶员900的觉醒等级判定处理的信息处理方法。图21和图22是用于驾驶员900的觉醒等级判定处理的信息处理方法的流程图。在下面的说明中,顺次说明图21所示的步骤中的处理。

首先,车辆控制系统100通过面部追踪单元(驾驶员面部追踪器)204获取驾驶员900的面部的移动。基于所获取的驾驶员900的面部的移动,车辆控制系统100判定驾驶员900是坐在驾驶位602上还是已经返回到驾驶姿势(步骤S61)。当驾驶员900坐在驾驶位602上并且已经返回到驾驶姿势时(步骤S61:是),车辆控制系统100前进到步骤S62。当驾驶员900没有坐在驾驶位602上或者没有返回到驾驶姿势时(步骤S61:否),车辆控制系统100返回到步骤S61。

车辆控制系统100判定是否可以对驾驶员900执行眼球行为解析处理(步骤S62)。例如,当驾驶员900不存在于显示单元804的某一位置时,即使问题被显示在显示单元804上,驾驶员900也不能看到问题。当可以执行眼球行为解析处理时(步骤S62:是),车辆控制系统100前进到步骤S63。当不能执行眼球行为解析处理时(步骤S62:否),车辆控制系统100返回到步骤S62。

车辆控制系统100生成显示信息,即,将要显示给驾驶员900的问题(步骤S63)。随后,车辆控制系统100在显示单元804上显示显示信息,即,在步骤S63中生成的问题(步骤S64)。然后,车辆控制系统100解析由步骤S64中显示的问题诱导的驾驶员900的眼球行为(步骤S65)。随后,车辆控制系统100在步骤S65中基于眼球行为解析执行觉醒等级判定处理(步骤S66)。

在上述步骤S64中,当由显示信息生成单元802生成的问题显示在显示单元804上时,驾驶员900将视线移动到该问题,以便获取该问题的回答。为了获取该问题的回答,驾驶员900表现出用于补充必要的信息的眼球行为。例如,驾驶员900执行诸如眼球的扫视(眼球转动)、注视或微扫视(眼球微小转动)等眼球行为。眼球行为解析单元300解析驾驶员900的眼球行为。此外,由眼球行为解析单元300解析的眼球行为信息被输出到判定单元320。判定单元320基于由眼球行为解析单元300解析的眼球行为信息来判定驾驶员900的觉醒等级。当确认驾驶员900正在执行诸如眼球转动、注视或微扫视(眼球微小转动)等眼球行为以解决该问题时,判定单元320判定驾驶员900的觉醒等级为高。另一方面,当没有观测到这些眼球行为或者这些眼球行为很少时,判定单元320判定驾驶员900的觉醒等级为低。

接下来,参照图22说明上述步骤S65中的处理的细节。

首先,眼球行为解析单元300获取问题显示之后的驾驶员900的眼球行为的观测数据(步骤S71)。例如,眼球行为解析单元300获取眼球追踪单元(驾驶员眼睛追踪器)206检测到的驾驶员900的眼球运动的加速数据。

随后,眼球行为解析单元300从步骤S71获取的观测数据中获取诸如眼球的扫视(眼球转动)、注视或微扫视(眼球微小转动)等眼球行为信息(步骤S72)。如上所述,当在显示单元804上显示问题时,驾驶员900执行眼球行为以获取解决问题所需的信息。例如,驾驶员900执行诸如眼球的扫视(眼球转动)、注视或微扫视(眼球微小转动)等眼球行为。眼球行为解析单元300从观测数据中提取与驾驶员900的眼球行为有关的信息。

随后,眼球行为解析单元300判定是否已经成功地获取了足以判定觉醒等级的观测数据(步骤S73)。具体地,眼球行为解析单元300判定从驾驶员900的观测数据中提取的诸如眼球的扫视(眼球转动)、注视或微扫视(眼球微小转动)等眼球行为信息是否是用于判定该数据是否是与问题解决处理相对应的数据的足够数据。当判定数据足够时(步骤S73:是),车辆控制系统100前进到步骤S74。当判定数据不足时(步骤S73:否),车辆控制系统100返回到步骤S72。

判定单元320基于问题提出之后的驾驶员的眼球行为的观测数据的解析结果来判定驾驶员900的觉醒等级(步骤S74)。具体地,判定单元320解析驾驶员900是否执行诸如眼球的扫视(眼球转动)、注视和微扫视(眼球微小转动)等眼球行为,以解决问题。当判定驾驶员900的眼球行为对应于等效于用于解决问题的扫视(眼球转动)、注视或微扫视(眼球微小转动)的眼球行为时,判定单元320判定驾驶员900的觉醒等级为高。另一方面,当没有观测到这些眼球行为或者很少时,判定单元320判定驾驶员900的觉醒等级为低。注意,在本实施例中,记载了通过0或1的判定来执行判定结果的示例。然而,在实际运用中很难判别100%的可靠觉醒判定和0%的不确定判定。觉醒判别可以与指示固定确定度的参数一起输出,并且可以根据移交过程的适当性逐步地移交功能。

如上所述,上述的信息处理方法在驾驶员900返回到手动驾驶之前向驾驶员900提出视觉问题,并解析在解决该问题时出现的驾驶员900的眼球行为。在上述的信息处理方法中,生成并提出非均匀问题,期望该问题诱发用于解决该问题的诸如扫视(眼球转动)、注视或微扫视(眼球微小转动)等特定的眼球行为作为驾驶员900的眼球行为。当驾驶员900应对该问题时,观测实际出现的眼球行为,解析观测到的眼球行为,并且基于驾驶员900的学习辞典特性来估计观测时的驾驶员900的内部觉醒等级。此外,基于估计结果,判定驾驶员900的状态是否处于值得开始手动驾驶返回的充分的大脑中的内部觉醒状态。具体地,当从这些眼球行为的解析判定驾驶员900已经充分地返回到觉醒时,判定驾驶员900具有手动驾驶是可能的高觉醒度,并且允许手动驾驶的开始。另一方面,当判定这些眼球行为没有充分发生时,判定驾驶员900不具有手动驾驶是可能的高觉醒度,并且不允许手动驾驶的开始。在这种情况下,执行诸如在进入手动驾驶区间之前停止的紧急疏散处理。

由于各种因素的影响,例如驾驶员900在每一时刻的状态、同一问题的重复实施状况、观看回答选择之后核查问题的行动特性、疲劳度、当时的视力和视力疲劳度、外光的干扰以及焦虑,从对于实际问题的视觉信息核查到问题的解决的过程有时极为不同。因此,为了高精度地执行判定,优选使用通过从长期的重复利用每次发生的移交执行时的返回质量(正常返回、延迟返回、返回放弃和系统紧急应对)等的学习处理生成的驾驶员900特有的返回预测辞典数据。此外,如重复说明的,希望使用驾驶员900特有的返回预测辞典数据,基于眼球的行为特性解析结果来执行正常返回预测。根据这些处理,可以开始安全手动驾驶。

尽管上面仅说明了眼球行为的解析,但优选的是,用于关于驾驶员900是否可以开始安全手动驾驶的判定处理的数据和输入到学习装置的数据包括从自己的车辆、道路环境信息和驾驶员生物信号获得的状态和履历信息。

注意,本实施方案被说明为适用于以下的情况:基于能够切换自动驾驶和手动驾驶的移动装置的驾驶员900的眼球行为,判定驾驶员900是否具有驾驶员900可以返回到手动驾驶的觉醒等级。然而,眼球行为的解析是使用可以从外部观测到的观测数据来解析受试者的大脑活动。因此,除了判定从自动驾驶到手动驾驶的移交时的驾驶员900的状态之外,还可以有各种用途。此外,上述眼球行为解析方法是一种观测与针对问题的存储信息的相关结果的方法。因此,通过观测并判定对所提出的问题的反应,各种用途是可能的。如果向受试者提出的问题需要与受试者的记忆进行核对,那么获得问题的回答的过程反映了受试者的状态和心理。因此,例如,当提出报告问题(如饮酒报告或过度劳动报告)时,该问题也可以适用于对被调查者的真/假判定。

此外,上述的问题提出不需要局限于车辆600的运行。例如,问题提出可以扩展到并用于各种各样的事件和职业,例如飞机的运行、火车的运行、起重机的运行、空中交通控制者和远程自动驾驶控制者,以及此外,通过在自我报告时的心理解析进行的真/假评价等。注意,众所周知,当受试者选择解决某些问题所需的视觉信息时,颞叶的颞上沟是活跃的,当受检者注意时,顶间沟是活跃的,并且当受试者移动眼睛时,额视野是活跃的。颞叶内侧上存在的海马体起到回忆记忆的内容的作用。还已知的是,当诸如自主性共济失调等由于所谓的交感神经和副交感神经之间的相互平衡的调节而抑制刺激反射时,眼球行为发生变化。因此,上述的眼球行为解析处理也可以用作诸如驾驶员900等受试者的心理健康的验证和监控处理。具体地,例如,可以通过使用眼球行为解析处理来实现安全运行,用于把握诸如公交车或出租车等商用车辆的驾驶员900的状态并管理健康。

<<11.概述>>

如上所述,根据本公开的实施方案,当使用EVS 400观测驾驶员900的眼球行为时,可以通过调整可以定义EVS 400的事件检测的频率的阈值来优化眼球行为的观测。在本公开的实施方案中,可以调整照明驾驶员900的照明装置。因此,根据本公开的实施方案,可以以最佳频率执行事件检测,从而精确地捕捉将要观测的变化,同时抑制用于观测诸如扫视、微扫视和瞟视等眼球行为、眨眼的检测、面部表情的变化等的数据量的增加。

具体地,在本公开的实施方案中,当使用EVS 400观测扫视行为、微扫视行为等时,在需要眼球行为的观测的时机调整EVS 400的事件检测的阈值。以这种方式,可以有效且精确地捕捉扫视行为和微扫视行为,同时抑制数据量的增加并减少演算处理和传输的负荷。在本公开的实施方案中,当使用EVS 400观测眼球的扫视行为时,在需要眼球行为的观测的时机,使用选择性地透过具有窄带波长的光的滤波器,在驾驶员900的面部上照射具有窄带波长的光。因此,由于可以使眼球的虹膜和瞳孔之间的边界阴影明显,所以可以选择性地且有效地精确地观测扫视行为。

注意,在本公开的实施方案中,以汽车为例进行了说明。然而,本实施方案不限于适用于汽车,并且可以适用于诸如汽车、电动车辆、混合动力电动车辆、摩托车、个人移动装置、飞机、船舶、建筑机械和农业机械(拖拉机)等移动体。由于眼球行为不是受试者的意识行为,而是对视觉信息的反射运动,并且反射运动被有意地校正,因此在行为中出现直到校正的延迟行为。此外,本公开的实施方案还可以适用于各种移动体等的远程操舵运用。

<<12.硬件构成>>

根据上述实施方案的自动驾驶控制单元112的全部或一部分通过例如具有如图23所示的构成的计算机1000来实现。图23是示出实现自动驾驶控制单元112的至少一部分功能的计算机1000的示例的硬件构成图。计算机1000包括CPU 1100、RAM 1200、ROM(只读存储器)1300、HDD(硬盘驱动器)1400、通信接口1500和输入/输出接口1600。计算机1000的各单元通过总线1050连接。

CPU 1100基于存储在ROM 1300或HDD 1400中的程序进行操作,并且控制各单元。例如,CPU 1100在RAM 1200中展开存储在ROM 1300或HDD 1400中的程序,并且执行与各种程序相对应的处理。

ROM 1300存储诸如在计算机1000的启动时由CPU 1100执行的BIOS(基本输入输出系统)等引导程序、依存于计算机1000的硬件的程序等。

HDD 1400是非瞬时地记录将要由CPU 1100执行的程序、将要由该程序使用的数据等的计算机可读记录介质。具体地,HDD 1400是记录作为程序数据1450的示例的根据本公开的信息处理程序的记录介质。

通信接口1500是用于将计算机1000连接到外部网络1550(例如,互联网)的接口。例如,CPU 1100经由通信接口1500从其他设备接收数据,并将CPU 1100生成的数据发送到其他设备。

输入/输出接口1600是用于连接输入/输出设备1650和计算机1000的接口。例如,CPU 1100经由输入/输出接口1600从诸如键盘、鼠标或麦克风等输入/输出设备1650接收数据。CPU 1100经由输入/输出接口1600将数据发送到诸如显示器、扬声器或打印机等输出设备。输入/输出接口1600可以用作读取记录在预定的记录介质(媒体)中的程序等的介质接口。介质例如是诸如DVD(数字多功能盘)或PD(相变可重写盘)等光学记录介质、诸如MO(磁光盘)等磁光记录介质、磁带介质、磁记录介质或半导体存储器。

例如,当计算机1000用作根据本公开实施方案的自动驾驶控制单元112的至少一部分时,计算机1000的CPU 1100通过执行存储在RAM 1200中的程序来实现传感器控制单元330和照明控制单元332的功能。根据本公开的信息处理程序等存储在HDD 1400中。注意,CPU 1100从HDD 1400读取程序数据1450并执行该程序数据。然而,作为另一示例,CPU 1100可以经由外部网络1550从其他设备获取这些程序。

根据本实施方案的传感器控制单元330、照明控制单元332等可以适用于包括以连接到网络(或各设备之间的通信)为前提的多个设备的系统,例如云计算。即,上述的根据本实施方案的信息处理装置例如也可以通过多个设备实现为根据本实施方案的信息处理系统。以上说明了自动驾驶控制单元112的至少一部分的硬件构成的示例。上述的各构成要素可以使用通用部件来构成,或者可以由专用于各构成要素的功能的硬件来构成。可以根据每次将要实施的技术等级适宜地改变这样的构成。

<<13.补充>>

注意,上述的本公开的实施方案可以包括例如由上述的信息处理装置或信息处理系统执行的信息处理方法、用于使信息处理装置起作用的程序、以及记录该程序的非临时性有形介质。该程序可以经由诸如因特网等通信线路(包括无线通信)来分发。

上述的本公开实施方案中的信息处理方法中的各步骤可能并不总是根据所记载的顺序来处理。例如,可以在适宜地改变顺序的情况下处理各步骤。各步骤可以并行地或单独地部分处理,而不是按时间序列处理。此外,各步骤的处理可能并不总是根据所记载的方法来处理,并且可以由例如根据另一方法的另一功能单元来处理。

在说明本公开的实施方案时,基于SAE定义的自动驾驶等级来说明细节。然而,利用自动驾驶等级对自动驾驶的用途进行分类的概念是根据车辆600的设计观点划分的分类。另一方面,当从利用者的观点来看时,根据可利用的自动驾驶等级,在正确地理解和把握允许各等级上运行的运行设计区域中的容许的自动驾驶等级之后,驾驶员900并不总是容易地根据车辆600的自动驾驶等级进行驾驶。即,这可以被称为用于根据机械的功能和指示使用车辆600的以机械为中心的设计。即,在车辆系统可以应对的状况由于各种外部因素和内部因素而随时间动态地变化并且行驶时的自动驾驶等级不是仅从道路区间等在物理上唯一决定的状况下,可以认为驾驶员900被要求服从于车辆控制系统100每次前进的道路状况所容许的等级。另一方面,当从人体工程学的观点来观察驾驶员900和车辆控制系统100之间的关系时,为了实现使用车辆600的目的(即,移动)并获得在移动过程中获得的次要优点,利用者考虑驾驶负担和驾驶中涉及的各种风险之间的平衡来执行行动判断。这里,负担是指为了移动车辆600而进行的操舵作业以及车辆600在移动时承受的一定风险。本来,当从驾驶员900的观点来看时的自动驾驶的优点是从驾驶的约束中释放出来,并且能够进行与驾驶无关的有意义的时间利用,并且可以使得利用者不从属于驾驶。为了享受这样的优点,有必要将支持自动驾驶控制的思想转换为以人为中心的设计思想(通过逆转以机械为中心的设计的以往思想的关系性而获得)。当基于这种思想的观点来重新审视车辆600的车辆控制系统100和作为利用者的驾驶员900之间的关系时,根据驾驶员900的觉醒和身体准备状况(能够根据可以作为车辆600的设计而用作“运行设计区域”的自动驾驶等级来应对),允许实际的各种自动驾驶功能的自动驾驶的利用,可以说是从人体工程学上看的期望的利用形态。

人类在平衡可选择的收益、收益中涉及的损失和风险的同时,进行他/她的行动选择,并进一步学习该行动。通过引入基于以人为中心的设计的控制,驾驶员900执行行动学习,以便能够根据驾驶员900的各道路中容许的上限的自动驾驶操舵环境来适宜地准备返回。此外,已经进行了这种行动学习的驾驶员900被容许离开自动驾驶等级4或更高等级,即,通过可以获得执行NDRA等的收益的高级自动驾驶行驶来离开驾驶操舵作业。另一方面,当不能观测到指示驾驶员900的期望的适宜返回的状态,或者参照驾驶员900过去的返回响应履历或学习数据,基于驾驶员900的观测状态,返回质量较差时,即使在“设计运行区域”内驾驶员900也能够离开驾驶操舵作业的自动驾驶等级4等中的使用可能被禁止,或者在自动驾驶等级3中的使用可能被限制在短时间内,从而极大地限制自动驾驶的使用。

即,基于人类的适应能力来允许自动驾驶的使用,而不是从装载在车辆600上的感测设备和判定处理的性能标准来允许被决定为“运行设计区域”的自动驾驶等级,这样的自动驾驶控制是车辆600的利用者友好的使用形态。即,通过将车辆600的自动驾驶系统的控制思想从所谓的以机械为中心的设计转换为以人为中心的设计,可以利用自动驾驶控制提供利用者友好的使用形态。在本公开的说明中,基于前者的以机械为中心的设计来说明使用驾驶员900的状态观测手段的适用型控制。然而,即使当以机械为中心的设计被以人为中心的设计替换时,类似地,也会发生驾驶员900的从自动驾驶到手动驾驶的切换行动(移交行动)。因此,可以使用上述的驾驶员900的状态观测手段来实施适用型控制。

以上参照附图详细说明了本公开的优选实施方案。然而,本公开的技术范围不限于这样的示例。显而易见的是,那些在本公开的技术领域中具有普通知识的人可以在权利要求中记载的技术思想的范畴内得出各种变更例或修正例。应当理解,这些变更例或修正例自然属于本公开的技术范围。尽管本实施方案是基于事件视觉传感器的单功能传感器来说明的,但是该功能可以通过具有通常的可见光RGB或红外IR型功能的混合型传感器来实现,用于在事件检测的同时捕获灰度图像。本实施方案的有效性不限于专用于事件视觉传感器的传感器。

本说明书中记载的效果仅是说明性或例示性的,而非限制性的。即,连同上述效果一起或代替上述效果,根据本公开的技术可以从本说明书的记载来实现对于本领域技术人员显而易见的其他效果。

注意,本技术还可以采用以下构成。

(1)一种信息处理装置,包括:

对移动体的内部进行成像的事件视觉传感器;和

控制所述事件视觉传感器的传感器控制单元,其中

所述事件视觉传感器包括:

像素阵列单元,所述像素阵列单元包括以矩阵状排列的多个像素;和

事件检测单元,所述事件检测单元检测在所述像素中由于入射光引起的亮度变化量超过预定阈值,和

当利用所述事件视觉传感器捕捉坐在所述移动体的驾驶位上的驾驶员的眼球行为时,所述传感器控制单元改变所述预定阈值的值。

(2)根据(1)所述的信息处理装置,其中,所述眼球行为包括眼球的扫视、注视和微扫视之中的至少一种。

(3)根据(1)或(2)所述的信息处理装置,其中,所述传感器控制单元根据在所述像素阵列单元内的位置来改变与所述像素相对应的所述预定阈值。

(4)根据(3)所述的信息处理装置,其中,所述传感器控制单元根据所述驾驶员的面部或眼球的位置在所述像素阵列单元内设定预定区域,并且改变与所述预定区域内的像素相对应的所述预定阈值。

(5)根据(1)~(4)中任一项所述的信息处理装置,还包括解析由所述事件视觉传感器观测到的数据的眼球行为解析单元。

(6)根据(5)所述的信息处理装置,其中,所述眼球行为解析单元基于由所述事件视觉传感器观测到的点分布的形状来区分所述眼球行为的类型。

(7)根据(6)所述的信息处理装置,其中,当检测到具有新月形状的点分布的出现时,所述眼球行为解析单元解析出已经出现了微扫视。

(8)根据(5)~(7)中任一项所述的信息处理装置,其中,所述传感器控制单元基于所述眼球行为解析单元的解析结果来改变所述预定阈值。

(9)根据(5)~(8)中任一项所述的信息处理装置,还包括

照射单元,当利用所述事件视觉传感器捕捉所述驾驶员的眼球行为时,所述照射单元用具有预定波长的光照射所述驾驶员的面部。

(10)根据(9)所述的信息处理装置,其中,所述照射单元包括使波长为940nm以上且960nm以下的光透过的滤波器。

(11)根据(9)或(10)所述的信息处理装置,还包括控制来自所述照射单元的光的强度、照射时间或照射间隔的照射控制单元。

(12)根据(11)所述的信息处理装置,其中,所述照射控制单元基于所述眼球行为解析单元的解析结果执行控制。

(13)根据(5)~(12)中任一项所述的信息处理装置,还包括

生成问题并在显示单元上进行显示的显示信息生成单元,其中

所述眼球行为解析单元对观察在所述显示单元上显示的问题的驾驶员的眼球行为进行解析。

(14)根据(13)所述的信息处理装置,其中,所述显示单元与所述驾驶员的面部相对,并且相对于当所述驾驶员观看位于前方无限远处的物体时的视线方向位于下方。

(15)根据(14)所述的信息处理装置,其中

所述事件视觉传感器与所述驾驶员的面部相对,并且相对于所述视线方向位于下方,和

由连接所述驾驶员的眼球和所述事件视觉传感器的线段与所述视线方向形成的角度为10度以上且小于30度。

(16)根据(15)所述的信息处理装置,其中,所述事件视觉传感器具有使所述事件视觉传感器能够至少捕捉所述驾驶员的面部的视角。

(17)根据(5)~(16)中任一项所述的信息处理装置,还包括判定单元,所述判定单元基于所述眼球行为的解析结果来判定所述驾驶员到手动驾驶的返回响应等级。

(18)根据(17)所述的信息处理装置,还包括移动体驾驶控制单元,所述移动体驾驶控制单元基于所述返回响应等级的判定结果来切换所述移动体的驾驶模式。

(19)一种在信息处理装置中执行的信息处理方法,所述信息处理装置包括:

对移动体的内部进行成像的事件视觉传感器;和

控制所述事件视觉传感器的传感器控制单元,

所述事件视觉传感器包括:

像素阵列单元,所述像素阵列单元包括以矩阵状排列的多个像素;和

事件检测单元,所述事件检测单元检测在所述像素中由于入射光引起的亮度变化量超过预定阈值,

所述信息处理方法包括当利用所述事件视觉传感器捕捉坐在所述移动体的驾驶位上的驾驶员的眼球行为时,改变所述预定阈值的值。

(20)一种信息处理程序,用于使计算机执行对移动体的内部进行成像的事件视觉传感器的控制功能,

所述事件视觉传感器包括:

像素阵列单元,所述像素阵列单元包括以矩阵状排列的多个像素;和

事件检测单元,所述事件检测单元检测在所述像素中由于入射光引起的亮度变化量超过预定阈值,

所述信息处理程序使所述计算机执行当利用所述事件视觉传感器捕捉坐在所述移动体的驾驶位上的驾驶员的眼球行为时改变所述预定阈值的值的功能。

附图标记列表

100车辆控制系统 101输入单元

102数据获取单元 103通信单元

104车内设备 105输出控制单元

106输出单元 107驱动系统控制单元

108驱动系统 109车身系统控制单元

110车身系统 111存储单元

112自动驾驶控制单元 113传感器单元

121通信网络 131,508检测单元

132自己位置估计单元 133状况解析单元

134规划单元 135操作控制单元

141车外信息检测单元 142车内信息检测单元

143车辆状态检测单元 151地图解析单元

152交通规则识别单元 153状况识别单元

154状况预测单元 161路线规划单元

162行动规划单元 163操作规划单元

171紧急避险单元 172加减速控制单元

173方向控制单元 200位置/姿势检测单元

202面部识别单元 204面部追踪单元

206眼球追踪单元 208生物信息检测单元

210认证单元 300眼球行为解析单元

302眼球行为学习装置 310DB

320判定单元 330传感器控制单元

332照明控制单元 400EVS

411驱动电路 412信号处理单元

413仲裁器单元 414列处理单元

500像素阵列单元 502像素

504光接收单元 506像素信号生成单元

600车辆 602驾驶位

700,702成像装置 710照明单元

800显示信息DB 802显示信息生成单元

804显示单元 900驾驶员

902视线方向

- 信息处理方法、信息处理装置和信息处理程序

- 信息处理方法、信息处理装置以及信息处理程序

- 信息处理装置、信息处理方法和信息处理系统

- 信息处理装置、信息处理方法以及信息处理系统

- 信息处理装置、喷墨记录装置和信息处理方法

- 信息处理服务器、信息处理方法、信息处理程序、记录了信息处理程序的记录介质、便携终端、便携式计算机的信息处理方法、便携终端用程序、以及记录了便携终端用程序的记录介质

- 信息处理系统、信息处理方法、信息处理程序、存储信息处理程序的计算机可读记录介质、数据结构、信息处理服务器和信息处理终端