一种基于FOV模型的视频数据索引构建方法及系统

文献发布时间:2023-06-19 12:13:22

技术领域

本发明涉及数据索引技术领域,特别是涉及一种基于FOV模型的视频数据索引构建方法及系统。

背景技术

城市中的摄像头、手机等各种智能设备每天都会产生大量的视频数据,由于其海量和非结构化的特点使得对视频数据的管理面临着巨大挑战。

发明内容

本发明的目的是提供一种基于FOV模型的视频数据索引构建方法及系统,提高了数据查询效率。

为实现上述目的,本发明提供了如下方案:

一种基于FOV模型的视频数据索引构建方法,包括:

采用视频分割技术,对待构建视频段按照视频帧进行分割,获得视频帧流;

识别所述视频帧流中各视频帧中的影像信息,为各视频帧获得关键词集合;

获得所述视频帧流中各视频帧对应的FOV;所述FOV的属性包括时间、所述关键词集合、视频帧、拍摄位置、拍摄方向和可视距离;

将每相邻两个视频帧作为一组,计算每组两个视频帧对应的FOV的拍摄位置之间的距离和拍摄方向之间的夹角;

根据每组两个视频帧对应的FOV的拍摄位置之间的距离和拍摄方向之间的夹角,从每组两个视频帧对应的FOV中提取关键FOV,构成关键FOV集合;

将覆盖所述待构建视频段的时间划分为K个时间段;

将所述关键FOV集合中的关键FOV按照时间划分到各对应所述时间段,获得K个时间段集合;

将所述时间段集合中所述关键FOV根据所述拍摄位置进行空间聚类,获得各所述时间段集合对应的N组聚类,其中每组聚类中关键FOV的数量不大于设定数目;每组聚类构成一个节点;所述节点包括时间段属性、可视距离属性、关键词属性、空间范围属性、孩子属性和视频帧属性;由所述关键FOV进行空间聚类得到的节点的所述孩子属性为所述节点对应的所有关键FOV构成的集合;

判断N是否大于所述设定数目;

若N大于所述设定数目,则将N个最上层节点根据拍摄位置进行空间聚类,得到N’组聚类,N’组聚类中每组聚类作为对应各节点的上层节点,用N’更新N,返回步骤“判断N是否大于所述设定数目”;

若N小于或等于所述设定数目,则构建当前最上层节点的根节点,所述根节点包括孩子属性;

创建哈希列表,将时间段和时间段对应的根节点插入所述哈希列表,其中时间段作为所述哈希列表的键,所述时间段对应的根节点作为键对应的值。

可选地,所述根据每组两个视频帧对应的FOV的拍摄位置之间的距离和拍摄方向之间的夹角,从每组两个视频帧对应的FOV中提取关键FOV,构成关键FOV集合,具体包括:

判断所述拍摄位置之间的距离是否小于距离阈值,所述拍摄方向之间的夹角是否小于角度阈值;

若所述拍摄位置之间的距离小于所述距离阈值且所述拍摄方向之间的夹角小于角度阈值,则将相邻两个所述视频帧对应的FOV中的一个FOV作为关键FOV;

若所述拍摄位置之间的距离大于所述距离阈值或者所述拍摄方向之间的夹角大于角度阈值,则将相邻两个所述视频帧对应的FOV均作为关键FOV;

由所有关键FOV构成关键FOV集合。

可选地,所述FOV的属性还包括覆盖角度范围。

本发明还公开了一种基于FOV模型的视频数据索引构建系统,包括:

视频分割模块,用于采用视频分割技术,对待构建视频段按照视频帧进行分割,获得视频帧流;

关键词识别模块,用于识别所述视频帧流中各视频帧中的影像信息,为各视频帧获得关键词集合;

FOV获取模块,用于获得所述视频帧流中各视频帧对应的FOV;所述FOV的属性包括时间、所述关键词集合、视频帧、拍摄位置、拍摄方向和可视距离;

距离和夹角计算模块,用于将每相邻两个视频帧作为一组,计算每组两个视频帧对应的FOV的拍摄位置之间的距离和拍摄方向之间的夹角;

关键FOV提取模块,用于根据每组两个视频帧对应的FOV的拍摄位置之间的距离和拍摄方向之间的夹角,从每组两个视频帧对应的FOV中提取关键FOV,构成关键FOV集合;

时间段划分模块,用于将覆盖所述待构建视频段的时间划分为K个时间段;

时间段集合获取模块,用于将所述关键FOV集合中的关键FOV按照时间划分到各对应所述时间段,获得K个时间段集合;

第一空间聚类模块,用于将所述时间段集合中所述关键FOV根据所述拍摄位置进行空间聚类,获得各所述时间段集合对应的N组聚类,其中每组聚类中关键FOV的数量不大于设定数目;每组聚类构成一个节点;所述节点包括时间段属性、可视距离属性、关键词属性、空间范围属性、孩子属性和视频帧属性;由所述关键FOV进行空间聚类得到的节点的所述孩子属性为所述节点对应的所有关键FOV的集合;

判断模块,用于判断N是否大于所述设定数目;

第二空间聚类模块,若N大于所述设定数目,用于将N个最上层节点根据拍摄位置进行空间聚类,得到N’组聚类,N’组聚类中每组聚类作为对应各节点的上层节点,用N’更新N,返回判断模块;

哈希列表构建模块,用于创建哈希列表,将时间段和时间段对应的根节点插入所述哈希列表,其中时间段作为所述哈希列表的键,所述时间段对应的根节点作为键对应的值。

可选地,所述关键FOV提取模块,具体包括:

距离和夹角判断单元,用于判断所述拍摄位置之间的距离是否小于距离阈值,所述拍摄方向之间的夹角是否小于角度阈值;

第一关键FOV提取单元,若所述拍摄位置之间的距离小于所述距离阈值且所述拍摄方向之间的夹角小于角度阈值,用于将相邻两个所述视频帧对应的FOV中的一个FOV作为关键FOV;

第二关键FOV提取单元,若所述拍摄位置之间的距离大于所述距离阈值或者所述拍摄方向之间的夹角大于角度阈值,用于将相邻两个所述视频帧对应的FOV均作为关键FOV;

关键FOV集合构建单元,用于由所有关键FOV构成关键FOV集合。

可选地,所述FOV的属性还包括覆盖角度范围。

根据本发明提供的具体实施例,本发明公开了以下技术效果:

本发明对视频段通过时间分割和空间聚类,创建了时间、拍摄方向、拍摄距离和关键字的多因素索引结构,能够适应多种因素的视频数据查询,提高了查询效率。

附图说明

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

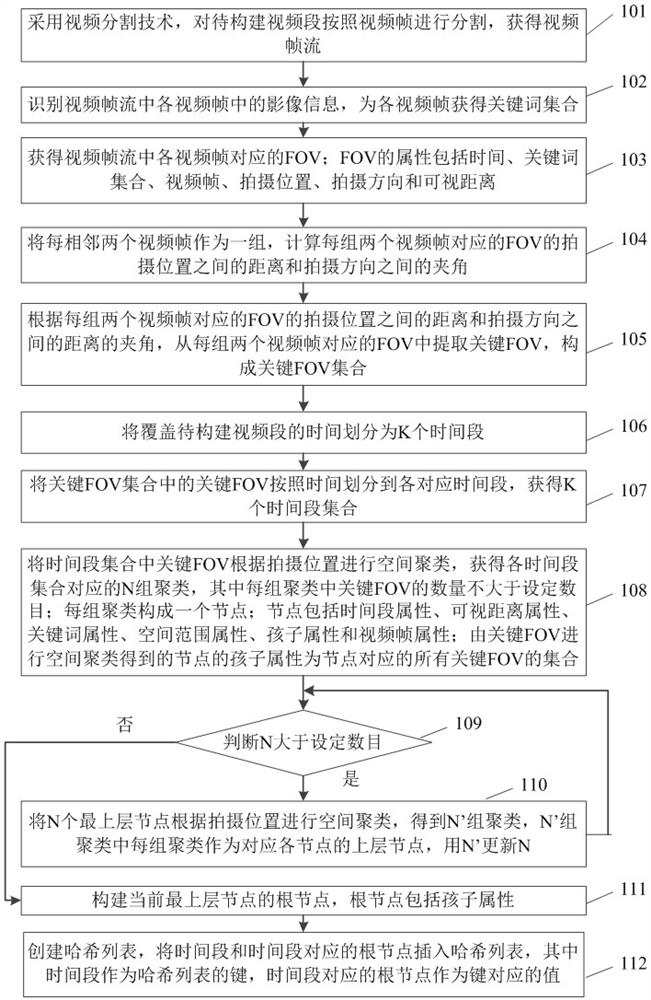

图1为本发明一种基于FOV模型的视频数据索引构建方法流程示意图;

图2为本发明FOV模型的可视化示意图;

图3为本发明索引结构的可视化平面示意图;

图4为本发明一种基于FOV模型的视频数据索引构建方法流程简图;

图5为本发明实施例视频数据集合获取对应FOV集合的方法流程示意图;

图6为本发明实施例视频数据压缩的方法流程示意图;

图7为本发明实施例压缩后视频数据构建索引结构的方法流程示意图;

图8为本发明一种基于FOV模型的视频数据索引构建系统结构示意图。

具体实施方式

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

本发明的目的是提供一种基于FOV模型的视频数据索引构建方法及系统,提高了数据查询效率。

为使本发明的上述目的、特征和优点能够更加明显易懂,下面结合附图和具体实施方式对本发明作进一步详细的说明。

图1为本发明一种基于FOV模型的视频数据索引构建方法流程示意图,如图1所示,一种基于FOV模型的视频数据索引构建方法包括以下步骤:

步骤101:采用视频分割技术,对待构建视频段按照视频帧进行分割,获得视频帧流。

步骤102:识别视频帧流中各视频帧中的影像信息,为各视频帧获得关键词集合。

步骤103:获得视频帧流中各视频帧对应的FOV;FOV的属性包括时间、关键词集合、视频帧、拍摄位置、拍摄方向和可视距离。

FOV的属性还包括覆盖角度范围。

步骤104:将每相邻两个视频帧作为一组,计算每组两个视频帧对应的FOV的拍摄位置之间的距离和拍摄方向之间的夹角。

步骤105:根据每组两个视频帧对应的FOV的拍摄位置之间的距离和拍摄方向之间的夹角,从每组两个视频帧对应的FOV中提取关键FOV,构成关键FOV集合。

步骤106:将覆盖待构建视频段的时间划分为K个时间段。

步骤107:将关键FOV集合中的关键FOV按照时间划分到各对应时间段,获得K个时间段集合。

步骤108:将时间段集合中关键FOV根据拍摄位置进行空间聚类,获得各时间段集合对应的N组聚类,其中每组聚类中关键FOV的数量不大于设定数目;每组聚类构成一个节点;节点包括时间段属性、可视距离属性、关键词属性、空间范围属性、孩子属性和视频帧属性;由关键FOV进行空间聚类得到的节点的孩子属性为节点对应的所有关键FOV的集合。

节点包括叶子节点和非叶子节点。

步骤108中聚类构成的节点为叶子节点。叶子节点的时间段属性为叶子节点对应的所有关键FOV覆盖的时间开始到时间截止的时间段,叶子节点的可视距离属性包括叶子节点对应的所有关键FOV中的最小可视距离和最大可视距离,叶子节点的关键词属性为叶子节点对应的所有关键FOV的关键词集合的并集,叶子节点的空间范围属性为节点对应的所有关键FOV拍摄位置的最小包围矩形,叶子节点的视频帧属性为叶子节点对应的所有关键FOV的视频帧集合。叶子节点的孩子属性为叶子节点对应的所有关键FOV的集合。

步骤109:判断N是否大于设定数目。

若N大于设定数目,则执行步骤110。

步骤110:将N个最上层节点根据拍摄位置进行空间聚类,得到N’组聚类,N’组聚类中每组聚类作为对应各节点的上层节点,用N’更新N(将N’的值赋予N,即N=N’),返回步骤“判断N是否大于设定数目”。

其中,步骤110中当最上层节点为叶子节点时,为将N个叶子节点根据拍摄位置进行空间聚类;当最上层节点为非叶子节点时,为将N个非叶子节点根据拍摄位置进行空间聚类。非叶子节点的孩子属性为该非叶子节点对应的下一层节点的集合。

若N小于或等于设定数目,则执行步骤111。

步骤111:构建当前最上层节点的根节点,根节点包括孩子属性。

步骤112:创建哈希列表,将时间段和时间段对应的根节点插入哈希列表,其中时间段作为哈希列表的键,时间段对应的根节点作为键对应的值。

其中,步骤105具体包括:

判断拍摄位置之间的距离是否小于距离阈值,拍摄方向之间的夹角是否小于角度阈值;

若拍摄位置之间的距离小于距离阈值且拍摄方向之间的夹角小于角度阈值,则将相邻两个视频帧对应的FOV中的一个FOV作为关键FOV;

若拍摄位置之间的距离大于距离阈值或者拍摄方向之间的夹角大于角度阈值,则将相邻两个视频帧对应的FOV均作为关键FOV;

由所有关键FOV构成关键FOV集合。

图4为本发明一种基于FOV模型的视频数据索引构建方法流程简图,如图4所示,本发明一种基于FOV模型的视频数据索引构建方法包括以下步骤:

S1、获取视频数据集合V= {V1, V2, ..., Vn}对应的FOV集合F = {F1, F2, ...,Fn},其中任意元素Fi为一个FOV集合,Fi为集合V中视频段Vi进行视频帧分割并提取FOV得到。

S2、对FOV集合F中每个元素Fi进行压缩处理得到关键FOV集合F’。

S3、采用时间段分割及分层聚类方式为压缩后的FOV集合F’构建方向、距离、关键字、时间感知的索引结构。

其中,步骤S1中获取视频数据集合V = {V1, V2, ..., Vn}对应的FOV集合F ={F1, F2, ..., Fn}的方法包括如下步骤:

S1a、对视频集合V = {V1, V2, ..., Vn}中的每段视频Vi采用视频分割技术将其按视频帧进行分割,得到对应的视频帧流Vi’,i = 1, 2, ..., n;Vi’中包括多个视频帧,对Vi’中的每个视频帧进行如下操作。

S1b、采用基于卷积神经网络的图像识别技术识别视频帧中拍到的各个影像,用各关键词来描述识别出的各影像,输出对应该视频帧的一个关键词集合wordSet。

S1c、计算当前视频帧对应的FOV,判断当前视频帧是否是Vi’中最后一帧,若是则跳转到步骤S1d,否则从Vi’中获取下一个视频帧并跳转到步骤S1b;

当处理完Vi’中所有视频帧后,得到Vi’对应的一个FOV集合Fi,Fi中任意一个元素为一个FOV,其具有时间属性time,时间属性是FOV对应视频帧拍摄的时刻,关键词属性wordSet,关键词属性描述FOV对应视频帧拍摄到的物体影像,视频帧属性frame,视频帧属性是FOV对应的视频帧,拍摄位置属性p、拍摄方向属性dir、覆盖角度范围属性θ及一个可视距离属性r,七元组(p, r, dir, θ, wordSet, time, frame)共同描述一个FOV元素。视频帧与FOV中属性拍摄位置属性p、拍摄方向属性dir、覆盖角度范围属性θ及一个可视距离属性r之间的对应关系如图2所示。

S1d、判断i是否等于n,若等于则结束并输出集合F,否则i+1跳转到步骤S1a。

其中,步骤S2中对FOV集合F中每个元素Fi进行压缩处理得到关键FOV集合F’的方法包括如下步骤:

S2a、对FOV集合F = {F1, F2, ..., Fn}中的每个元素Fi = {f

S2b、对Fi = {f

S2c、计算两个FOV对应拍摄位置之间的距离dist,计算两个FOV对应拍摄方向之间的夹角ρ。

S2d、若dist小于距离阈值ξ,且ρ小于角度阈值ω,则跳转到步骤S2e,否则跳转到步骤S2f,两个阈值ξ和ω都是由用户设定。

S2e、称f

S2f、称两个FOV,f

S2g、判断i是否等于n,若等于则跳转到步骤S2h,否则i+1并跳转到步骤S2a;

S2h、将所有关键FOV构成关键FOV集合F’,F’包含的每个元素都是一个关键FOV,即这个FOV不能被任何其他FOV代替。

其中,步骤S3采用时间段分割及分层聚类方式为压缩后的关键FOV集合F’构建方向、距离、关键字、时间感知的索引结构的方法包括如下步骤:

S3a、计算集合F’覆盖的总时间段AllTime,将时间段AllTime分割为K段,为每个时间段创建一个空集合Sw,w = 1, 2, ..., K,对集合F’中的每个关键FOV进行如下操作。

S3b、找到各关键FOV的拍摄时刻time所属的时间段w,并将各关键FOV存入对应的集合Sw。

S3c、判断当前关键FOV是否为F’中最后一个FOV,若是则执行步骤S3d,否则获取下一个FOV并执行步骤S3b。

S3d、获取第w个时间段对应的集合Sw,w = 1, 2, ..., K;

S3e、将集合Sw中的关键FOV根据拍摄位置p进行空间聚类得到N组聚类,即N组FOV,并控制每组FOV数不大于正整数M,对每组FOV进行如下操作。

S3f、将当前组FOV构建为一个叶子节点Leaf,叶子节点Leaf包括时间段属性Time、可视距离属性R=(minr, maxr)、关键词属性WordSet、空间范围属性Rect、孩子属性Chil和视频帧属性FrameSet。

时间段属性Time=(time_start, time_end)是Leaf对应的所有FOV对应的拍摄时刻组成的一个时间段;可视距离属性R是由Leaf对应FOV的最小可视距离minr和最大可视距离maxr构成的;关键词属性WordSet是对应FOV的所有关键词集合的并集;空间范围属性Rect是对应FOV的所有拍摄位置的最小包围矩形;孩子属性Chil为此叶子节点对应的FOV构成的集合;视频帧属性FrameSet是对应FOV对应的所有视频帧frame构成的一个视频帧集合。

S3g、判断当前组FOV是否为第N组FOV,若是则跳转到步骤S3i,否则跳转到步骤S3h。

S3h、获取下一组FOV,并跳转到步骤S3f。

S3i、至此得到了N个节点,判断N是否大于M,若大于则执行S3j,否则执行S3o。

S3j、将N个节点进一步向上聚类,得到N’组聚类,即得到N’组节点。

S3k、将当前组节点构建为一个上层节点Node,其具有孩子属性Chil,它是此组节点的并集;时间段属性Time=(time_start, time_end),它是此组各个节点对应的时间段求并得到的一个时间段;可视距离属性R=(minr, maxr),它是此组节点对应距离属性求并得到的;关键词属性WordSet,为此组节点的关键字集合的并集;空间范围属性Rect,是此组节点的空间覆盖范围;视频帧属性FrameSet,是此组节点对应视频帧集合的并集。

S3l、判断此组节点是否为第N’组节点,若是跳转到步骤S3m,否则跳转到步骤S3n。

S3m、令N代替N’(用N’对N进行赋值)并跳转到步骤S3i。

S3n、获取下一组节点并跳转到步骤S3k。

S3o、构建一个根节点rootw,其具有孩子属性child,它是N个节点构成的集合。

S3p、判断w是否等于K,若等于则执行步骤S3q,否则w+1并跳转到步骤S3d。

S3q、创建一个哈希列表HsahL,将时间段w及其对应FOV构建的索引结构的根节点rootw插入HsahL中,其中,w = 1, 2, ..., K,HsahL的键为各个时间段,对应键的值为此时间段对应的根节点。

本发明实施例中,视频帧在二维平面中的空间覆盖区域为一个扇形,简称为视域,用FOV(Field-Of-View)表示。如图2所示,视频帧对应FOV由一个七元组(p, r, dir, θ,wordSet, time, frame)共同描述,其中拍摄位置p、拍摄方向dir、覆盖角度范围θ及可视距离r共同确定FOV的地理属性,time是FOV对应视频帧拍摄的时刻,frame是此FOV对应的视频帧,关键词wordSet描述了frame上的物体影像。

图3为本发明的索引结构的可视化平面示意图举例,图3中FOV f

表1 哈希列表HashL

本发明一种基于FOV模型的视频数据索引构建方法包括以下阶段:

第一、FOV集合获取阶段。

FOV集合获取阶段,获取视频数据集合V = {V1, V2, ..., Vn}对应的FOV集合F ={F1, F2, ..., Fn},其中任意元素Fi为一个FOV集合,其为集合V中视频段Vi进行视频帧分割并提取FOV得到,如图5所示,具体包括:

a1、对视频集合V = {V1, V2, ..., Vn}中的每段视频Vi采用视频分割技术将其按视频帧进行分割,得到对应的视频帧流Vi’帧,i = 1, 2, ..., n,对Vi’中的每个视频进行如下操作。

b1、采用基于卷积神经网络的图像识别技术识别视频帧中拍到的各个影像,用各关键词来描述识别出的各影像,输出对应该视频帧的一个关键词集合wordSet。

c1、计算此视频帧对应的FOV并将此FOV存入集合Fi中,判断此视频帧是否是Vi’中最后一帧,若是则跳转到步骤d1,否则从Vi’中获取下一个视频帧并跳转到步骤b1。

d1、将Fi存入集合F中并判断i是否等于n,若等于则结束并输出集合F,否则i+1跳转到步骤a1。

第二、压缩处理阶段。

压缩处理阶段,对FOV集合F中每个元素Fi进行压缩处理得到新FOV集合F’,如图图6所示,具体包括:

a2、对FOV集合F = {F1, F2, ..., Fn}中的每个元素Fi = {f

b2、对Fi = {f

c2、计算两个FOV对应拍摄位置之间的距离dist,计算两个FOV对应拍摄方向之间的夹角ρ。

d2、若dist小于距离阈值ξ,且ρ小于角度阈值ω,则跳转到步骤e2,否则跳转到步骤f2,两个阈值ξ和ω都是由用户指定。

e2、称FOV f

f2、称两个FOV f

g2、判断j是否等于m-1,若等于则跳转到步骤h2,否则j+1并跳转到步骤b2。

h2、判断i是否等于n,若等于则输出集合F’并结束,否则i+1并跳转到步骤a2。

第三、索引构建阶段。

索引构建阶段,采用时间段分割及分层聚类方式为压缩后的FOV集合F’构建方向、距离、关键字、时间感知的索引结构,如图图7所示,具体包括:

a3、计算集合F’覆盖的总时间段AllTime,将该时间段分割为K段,为每个时间段创建一个空集合Sw,w = 1, 2, ..., K,对集合F’中的每个FOV进行如下操作。

b3、找到此FOV的拍摄时刻time所属的时间段w,并将此FOV存入对应的集合Sw。

c3、判断此FOV是否为F’中最后一个FOV,若是则执行步骤d3,否则获取下一个FOV并执行步骤b3。

d3、获取第w个时间段对应的集合Sw,w = 1, 2, ..., K。

e3、将集合Sw中的FOV根据拍摄位置p进行空间聚类得到N组聚类,即N组FOV,并控制每组FOV数不大于正整数M,对每组FOV进行如下操作。

f3、将该组FOV构建为一个叶子节点Leaf,其具有时间段属性Time=(time_start,time_end),它是Leaf对应的所有FOV对应的拍摄时刻组成的一个时间段;可视距离属性R=(minr, maxr),它是由Leaf对应FOV的最小可视距离minr和最大可视距离maxr构成的;关键词属性WordSet,它是对应FOV的所有关键词集合的并集;空间范围属性Rect,它是对应FOV的所有拍摄位置的最小包围矩形;孩子属性Chil,它是此叶子节点对应所有关键FOV构成的集合;视频帧属性FrameSet,它是对应FOV对应的所有视频帧frame构成的一个视频帧集合。

g3、判断该组FOV是否为第N组FOV,若是则跳转到步骤i3,否则跳转到步骤h3。

h3、获取下一组FOV,并跳转到步骤f3。

i3、至此得到了N个节点,判断N是否大于M,若大于则执行j3,否则执行o3。

j3、将N个节点进一步向上聚类,得到N’组聚类,即得到N’组节点,对每组节点。

k3、将此组节点构建为一个上层节点Node,其具有孩子属性Chil,它是此组节点的并集;时间段属性Time=(time_start, time_end),它是此组各个节点对应的时间段求并得到的一个时间段;可视距离属性R=(minr, maxr),它是此组节点对应距离属性求并得到的;关键词属性WordSet,为此组节点的关键字集合的并集;空间范围属性Rect,是此组节点的空间覆盖范围;视频帧属性FrameSet,是此组节点对应视频帧集合的并集。

l3、判断此组节点是否为第N’组节点,若是跳转到步骤m3,否则跳转到步骤n3。

m3、令N代替N’并跳转到步骤i3。

n3、获取下一组节点并跳转到步骤k3。

o3、构建一个根节点rootw,其具有孩子属性child,它是N个节点构成的集合。

p3、判断w是否等于K,若等于则执行步骤q3,否则w+1并跳转到步骤d3。

q3、创建一个哈希列表HsahL,将时间段w及其对应FOV构建的索引结构的根节点rootw插入HsahL中,其中,w = 1, 2, ..., K,HsahL的键为各个时间段,对应键的值为此时间段对应的根节点。

图8为本发明一种基于FOV模型的视频数据索引构建系统结构示意图,如图8所示,一种基于FOV模型的视频数据索引构建系统包括:

视频分割模块201,用于采用视频分割技术,对待构建视频段按照视频帧进行分割,获得视频帧流;

关键词识别模块202,用于识别视频帧流中各视频帧中的影像信息,为各视频帧获得关键词集合;

FOV获取模块203,用于获得视频帧流中各视频帧对应的FOV;FOV的属性包括时间、关键词集合、视频帧、拍摄位置、拍摄方向和可视距离;

距离和夹角计算模块204,用于将每相邻两个视频帧作为一组,计算每组两个视频帧对应的FOV的拍摄位置之间的距离和拍摄方向之间的夹角;

关键FOV提取模块205,用于根据每组两个视频帧对应的FOV的拍摄位置之间的距离和拍摄方向之间的夹角,从每组两个视频帧对应的FOV中提取关键FOV,构成关键FOV集合;

时间段划分模块206,用于将覆盖待构建视频段的时间划分为K个时间段;

时间段集合获取模块207,用于将关键FOV集合中的关键FOV按照时间划分到各对应时间段,获得K个时间段集合;

第一空间聚类模块208,用于将时间段集合中关键FOV根据拍摄位置进行空间聚类,获得各时间段集合对应的N组聚类,其中每组聚类中关键FOV的数量不大于设定数目;每组聚类构成一个叶子节点;叶子节点包括时间段属性、可视距离属性、关键词属性、空间范围属性、孩子属性和视频帧属性;由关键FOV进行空间聚类得到的节点的孩子属性为叶子节点对应的所有关键FOV的集合;

判断模块209,用于判断N是否大于设定数目;

第二空间聚类模块210,若N大于设定数目,用于将N个叶子节点根据拍摄位置进行空间聚类,得到N’组聚类,N’组聚类中每组聚类作为对应各叶子节点的上层节点,用N’更新N,返回判断模块;

根节点构建模块211,若N小于或等于设定数目,用于构建当前最上层节点的根节点,根节点包括孩子属性;

哈希列表构建模块212,用于创建哈希列表,将时间段和时间段对应的根节点插入哈希列表,其中时间段作为哈希列表的键,时间段对应的根节点作为键对应的值。

关键FOV提取模块205,具体包括:

距离和夹角判断单元,用于判断拍摄位置之间的距离是否小于距离阈值,拍摄方向之间的夹角是否小于角度阈值;

第一关键FOV提取单元,若拍摄位置之间的距离小于距离阈值且拍摄方向之间的夹角小于角度阈值,用于将相邻两个视频帧对应的FOV中的一个FOV作为关键FOV;

第二关键FOV提取单元,若拍摄位置之间的距离大于距离阈值或者拍摄方向之间的夹角大于角度阈值,用于将相邻两个视频帧对应的FOV均作为关键FOV;

关键FOV集合构建单元,用于由所有关键FOV构成关键FOV集合。

设定数目为3。

FOV的属性还包括覆盖角度范围。

本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。对于实施例公开的系统而言,由于其与实施例公开的方法相对应,所以描述的比较简单,相关之处参见方法部分说明即可。

本文中应用了具体个例对本发明的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本发明的方法及其核心思想;同时,对于本领域的一般技术人员,依据本发明的思想,在具体实施方式及应用范围上均会有改变之处。综上所述,本说明书内容不应理解为对本发明的限制。

- 一种基于FOV模型的视频数据索引构建方法及系统

- 一种基于FOV模型的视频数据索引构建方法及系统