命名实体的识别方法和装置

文献发布时间:2023-06-19 09:41:38

技术领域

本申请实施例涉及计算机技术领域,尤其涉及一种命名实体的识别方法和装置。

背景技术

命名实体识别(Named Entity Recognition,简称NER),是指识别文本中具有特定意义的实体,主要包括人名、地名、机构名、专有名词等。

现有技术中,采用包括BERT子模型的命名实体识别模型对文本进行命名实体识别,得到的命名实体识别结果的准确度较高。在实现本申请过程中,发明人发现现有技术中至少存在如下问题:由于BERT模型较复杂,若期望采用包括BERT子模型的命名实体识别模型高效的识别文本中的命名实体,则需要基于高性能设备(比如包括视觉处理器(GraphicsProcessing Unit,简称GPU)的设备)。

发明内容

本申请实施例提供一种命名实体的识别方法和装置,用以解决需要基于高性能设备才能高效准确的识别文本中的命名实体的问题。

第一方面,本申请实施例提供一种命名实体的识别方法,包括:接收来自终端设备的针对第一文本的查询请求;通过BERT词向量生成服务,获取所述第一文本对应的第一词向量;所述BERT词向量生成服务是基于BERT模型生成的,BERT模型为从命名实体识别模型中拆分出的BERT子模型,所述BERT模型能够用于获取文本对应的词向量;根据所述第一词向量,采用第一机器学习模型识别所述第一文本中的命名实体,所述第一机器学习模型为从所述命名实体识别模型中拆分出的所述BERT子模型的下游机器学习子模型。

本方案中,服务器基于BERT词向量生成服务获取文本的词向量,接着基于第一机器学习模型和文本对应的词向量获取文本的命名实体识别结果,由于BERT词向量生成服务基于常规性能的设备即可高效的获取文本对应的词向量,且获取词向量的准确度与生成BERT词向量生成服务的BERT模型的准确度相同,因此,本申请的方法可以基于常规性能的设备高效准确的进行命名实体识别,即可以解决若期望高效准确的识别文本中的命名实体,则需要基于高性能设备问题。

在一种可能的实施方式中,在所述通过BERT词向量生成服务,获取所述第一文本对应的第一词向量之前,还包括:获取命名实体识别模型,所述命名实体识别模型中包括所述BERT子模型;从所述命名实体识别模型中拆分出所述BERT子模型作为所述BERT模型;基于所述BERT模型,生成所述BERT词向量生成服务。

本方案中基于从命名实体识别模型中拆分出的BERT子模型生成BERT词向量生成服务,说明生成BERT词向量生成服务的BERT模型为适用于命名实体识别领域的模型,提高了命名实体识别的准确性。

在一种可能的实施方式中,所述命名实体识别模型中还包括所述BERT子模型的下游机器学习子模型;在所述根据所述第一词向量,采用第一机器学习模型识别所述第一文本中的命名实体之前,还包括:从所述命名实体识别模型中拆分出所述下游机器学习子模型作为所述第一机器学习模型。

本方案中的第一机器学习模型为从所述命名实体识别模型中拆分出的所述BERT子模型的下游机器学习子模型,提高了命名实体识别的准确性。

在一种可能的实施方式中,所述获取命名实体识别模型,包括:获取初始命名实体识别模型;获取多个训练样本,每个训练样本包括训练文本和该训练文本的命名实体标注结果;基于所述多个训练样本和所述初始命名实体识别模型,获取所述命名实体识别模型。本方案给出了获取命名实体识别模型的一种具体实现。

在一种可能的实施方式中,所述多个训练样本对应于N个训练样本集,不同的训练样本集包括的训练文本的来源不同,N为大于或等于2的整数;所述基于所述多个训练样本和所述初始命名实体识别模型,获取所述命名实体识别模型;对于每个训练样本集:基于该训练样本集和所述初始命名实体识别模型,训练得到预选命名实体识别模型;基于测试样本集,获取各预选命名实体识别模型的命名实体识别精度;确定所述命名实体识别精度最高的预选命名实体识别模型为所述命名实体识别模型。本方案中命名实体识别模型的获取方法根据不同来源的训练样本集训练多个预选命名实体识别模型,从多个预选命名实体识别模型中选取命名实体识别精度最高的预选命名实体识别模型作为目标命名实体识别模型,可以得到高识别精度的命名实体识别模型。

在一种可能的实施方式中,所述N个训练样本集中存在第一训练样本集,所述第一训练样本集包括的训练文本的来源包括如下中的至少一项:媒体文件集、基于购物平台获取的文本集、微软亚洲研究院MSRA数据集、Boson数据集。本方案提供的训练文本的来源为具体场景下的文本集或数据集,可以提高相应场景下命名实体识别的准确性。

在一种可能的实施方式中,所述查询请求用于查询针对所述第一文本的回复;所述方法还包括:根据所述第一文本的命名实体识别结果,确定所述针对所述第一文本的回复;向所述终端设备发送所述针对所述第一文本的回复。本方案给出了查询请求用于查询针对所述第一文本的回复时的具体实现。

在一种可能的实施方式中,所述查询请求用于查询所述第一文本中包括的命名实体;所述方法还包括:向所述终端设备发送所述第一文本的命名实体识别结果。本方案给出了查询请求用于查询所述第一文本中包括的命名实体时的具体实现。

第二方面,本申请实施例提供一种命名实体识别的装置,包括:收发模块,用于接收来自终端设备的针对第一文本的查询请求;处理模块,用于通过BERT词向量生成服务,获取所述第一文本对应的第一词向量;所述BERT词向量生成服务是基于BERT模型生成的,BERT模型为从命名实体识别模型中拆分出的BERT子模型,所述BERT模型能够用于获取文本对应的词向量;所述处理模块,还用于根据所述第一词向量,采用第一机器学习模型识别所述第一文本中的命名实体;所述第一机器学习模型为从所述命名实体识别模型中拆分出的所述BERT子模型的下游机器学习子模型。

在一种可能的实施方式中,在所述处理模块通过BERT词向量生成服务,获取所述第一文本对应的第一词向量之前,所述处理模块还用于:获取命名实体识别模型,所述命名实体识别模型中包括所述BERT子模型;从所述命名实体识别模型中拆分出所述BERT子模型作为所述BERT模型;基于所述BERT模型,生成所述BERT词向量生成服务。

在一种可能的实施方式中,所述命名实体识别模型中还包括所述BERT子模型的下游机器学习子模型;在所述处理模块根据所述第一词向量,采用第一机器学习模型识别所述第一文本中的命名实体之前,所述处理模块还用于:从所述命名实体识别模型中拆分出所述下游机器学习子模型作为所述第一机器学习模型。

在一种可能的实施方式中,所述处理模块具体用于:获取初始命名实体识别模型;获取多个训练样本,每个训练样本包括训练文本和该训练文本的命名实体标注结果;基于所述多个训练样本和所述初始命名实体识别模型,获取所述命名实体识别模型。

在一种可能的实施方式中,所述多个训练样本对应于N个训练样本集,不同的训练样本集包括的训练文本的来源不同,N为大于或等于2的整数;所述处理模块具体用于:对于每个训练样本集:基于该训练样本集和所述初始命名实体识别模型,训练得到预选命名实体识别模型;基于测试样本集,获取各预选命名实体识别模型的命名实体识别精度;确定所述命名实体识别精度最高的预选命名实体识别模型为所述命名实体识别模型。

在一种可能的实施方式中,所述N个训练样本集中存在第一训练样本集,所述第一训练样本集包括的训练文本的来源包括如下中的至少一项:媒体文件集、基于购物平台获取的文本集、微软亚洲研究院MSRA数据集、Boson数据集。

在一种可能的实施方式中,所述查询请求用于查询针对所述第一文本的回复,所述收发模块还用于接收来自所述终端设备的查询请求,所述查询请求包括所述第一文本;所述处理模块还用于:根据所述第一文本的命名实体识别结果,确定所述针对所述第一文本的回复;所述收发模块还用于向所述终端设备发送所述针对所述第一文本的回复。

在一种可能的实施方式中,所述查询请求用于查询所述第一文本中包括的命名实体;所述收发模块还用于:向所述终端设备发送所述第一文本的命名实体识别结果。

本申请中,服务器基于BERT词向量生成服务获取文本的词向量,接着基于第一机器学习模型和文本对应的词向量获取文本的命名实体识别结果,由于BERT词向量生成服务基于常规性能的设备即可高效的获取文本对应的词向量,且获取词向量的准确度与生成BERT词向量生成服务的BERT模型的准确度相同,因此,本申请的方法可以基于常规性能的设备高效准确的进行命名实体识别,即可以解决若期望高效准确的识别文本中的命名实体,则需要基于高性能设备问题。

附图说明

此处的附图被并入说明书中并构成本说明书的一部分,示出了符合本公开的实施例,并与说明书一起用于解释本公开的原理。

图1为本申请实施例提供的应用场景图;

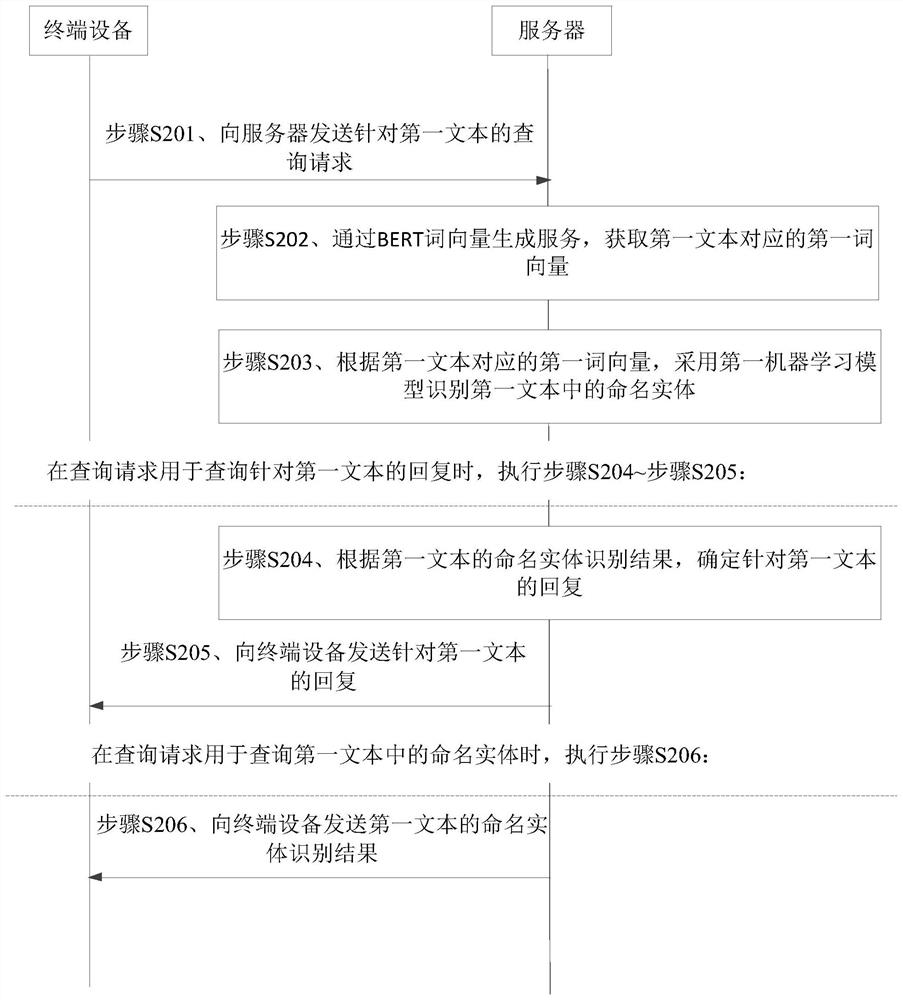

图2为本申请实施例提供的命名实体的识别方法的流程图一;

图3为本申请实施例提供的命名实体的识别方法的流程图二;

图4为本申请实施例提供的命名实体的识别装置的结构示意图;

图5为本申请实施例提供的电子设备的结构示意图。

通过上述附图,已示出本公开明确的实施例,后文中将有更详细的描述。这些附图和文字描述并不是为了通过任何方式限制本公开构思的范围,而是通过参考特定实施例为本领域技术人员说明本公开的概念。

具体实施方式

这里将详细地对示例性实施例进行说明,其示例表示在附图中。下面的描述涉及附图时,除非另有表示,不同附图中的相同数字表示相同或相似的要素。以下示例性实施例中所描述的实施方式并不代表与本公开相一致的所有实施方式。相反,它们仅是与如所附权利要求书中所详述的、本公开的一些方面相一致的装置和方法的例子。

首先对本申请实施例所涉及的名词进行解释:

命名实体:命名实体包括人名、机构名、地名;更广泛的命名实体还包括数字、日期、货币、地址、时间等等。

目前,在很多场景中均需要对文本中的命名实体进行识别。比如参见图1,用户通过终端设备的客服界面输入问题,终端设备向服务器发送该问题,服务器对该问题进行命名实体识别,基于命名实体识别结果能够确定问题的精准语义,从而能够准确的确定该问题的回复,在得到该问题的回复后,向终端设备发送该回复,终端设备显示该回复。

现有技术中,采用包括BERT(Bidirectional Encoder Representation fromTransformers)子模型的命名实体识别模型对文本进行命名实体识别,得到的命名实体识别结果的准确度较高。但是由于BERT模型较复杂,若期望采用包括BERT子模型的命名实体识别模型高效的识别文本中的命名实体,则需要基于高性能设备(比如包括视觉处理器(Graphics Processing Unit,简称GPU)的设备),但是基于高性能设备进行命名实体识别不具有普适性。因此,需要一种基于常规性能设备便能高效准确的进行命名实体识别的方法,若想基于常规性能的设备高效准确的进行命名实体识别,需要降低命名实体识别模型的复杂度,但是若将命名实体识别模型中的BERT子模型换成复杂度低的模型,则无法保证命名实体识别结果的准确性。为了克服该技术难题,发明人发现可基于BERT词向量生成服务获取文本的词向量,根据文本的词向量以及基于文本的词向量能够进行命名实体识别的机器学习模型实现文本中命名实体的识别。由于BERT词向量生成服务可以高效的获取文本对应的词向量,且获取词向量的准确度与生成BERT词向量生成服务的BERT模型的准确度相同,因此,本申请的方法可以基于常规性能的设备高效准确的进行命名实体识别。

下面以具体地实施例对本申请的技术方案以及本申请的技术方案如何解决上述技术问题进行详细说明。下面这几个具体的实施例可以相互结合,对于相同或相似的概念或过程可能在某些实施例中不再赘述。下面将结合附图,对本申请的实施例进行描述。

图2为本申请实施例提供的命名实体的识别方法的流程图一,参见图2,本实施例的方法包括:

步骤S201、终端设备向服务器发送针对第一文本的查询请求。

其中,本实施例中的查询请求包括但不限于如下的形式:

第一种形式中:查询请求用于查询针对第一文本的回复。比如:用户需要咨询A事件,用户在终端设备的用户界面输入咨询A事件相关的问题,也就是第一文本,终端设备基于第一文本,生成查询请求,该查询请求中包括第一文本,终端设备向服务器发送该查询请求。

第二种形式中,本实施例中的查询请求可用于查询第一文本中的命名实体,该查询请求也可称为命名实体识别请求。

步骤S202、服务器通过BERT词向量生成服务,获取第一文本对应的第一词向量。

其中,BERT词向量生成服务(bert-as-service)是基于BERT模型生成的,该BERT模型能够用于获取文本对应的词向量。基于BERT模型生成BERT词向量生成服务的方法可参见目前通用的方法,此处不再赘述。

一种方式中,该BERT模型可以是用于获取文本的词向量的通用BERT模型,通用BERT模型可以是基于多种数据来源的训练样本训练的一个普适性的BERT模型。

另一种方式中,生成BERT词向量生成服务的BERT模型是从目标命名实体识别模型中拆分出来的BERT子模型。

本实施例中的第一文本可对应至少一个词向量,第一文本对应的词向量用于表征第一文本的语义信息。其中,通过BERT词向量生成服务生成的第一文本对应的第一词向量可以精确的表征第一文本的语义信息。

步骤S203、服务器根据第一文本对应的第一词向量,采用第一机器学习模型识别第一文本中的命名实体。

服务器获取到第一文本对应的第一词向量后,将第一文本对应的第一词向量输入至第一机器学习模型中,根据第一机器学习模型的输出得到第一文本的命名实体识别结果。

一种具体的实现中,生成BERT词向量生成服务的BERT模型是通用BERT模型,则第一机器学习模型的获取方法可如下:基于通用的BERT模型得到训练文本对应的词向量,根据训练文本对应的词向量和训练文本的命名实体标注结果,训练第一机器学习模型。

另一种具体的实现中,生成BERT词向量生成服务的BERT模型是从目标命名实体识别模型中拆分出来的BERT子模型,则第一机器学习模型是从目标命名实体识别模型中拆分出来的BERT子模型的下游学习子模型。对于目标命名实体识别模型的获取:可将通用BERT模型作为初始BERT子模型和BERT模型的初始下游学习模型作为初始BERT子模型初始下游学习子模型,初始BERT子模型和初始BERT子模型初始下游学习子模型组成初始命名实体识别模型,基于训练样本和初始命名实体识别模型,训练得到目标命名实体识别模型。此时,该种具体的实现中,文本的命名实体的识别准确度相对于生成BERT词向量生成服务的BERT模型是通用BERT模型的具体实现的文本的命名实体的准确度要高。

其中,第一机器学习模型可包括但不限于如下中的任一项:

(1)双向长短时记忆神经网络(bidirections long short term memorynetwork,简称BiLSTM)和条件随机场(Conditional Random Fields,简称CRF)模型。

(2)双向循环神经网络(bidirections recurrent neural networks,简称BRNN)和CRF模型。

(3)长短时记忆神经网络(Long Short Term Memory Network,简称LSTM)和CRF模型。

(4)循环神经网络(recurrent neural networks,简称RNN)和CRF模型。

(5)CRF模型。

(6)深度神经网络(Deep Neural Networks,以下简称DNN)和CRF模型。

在查询请求用于查询针对第一文本的回复时,还包括步骤S204~步骤S205:

步骤S204、服务器根据第一文本的命名实体识别结果,确定针对第一文本的回复。

服务器根据第一文本的命名实体识别结果分析第一文本的语义,以确定针对第一文本的回复,由于得到第一文本的命名实体识别结果后,可以避免将一个命名实体误判为多个不同的词,因此服务器根据第一文本的命名实体识别结果可以获取到第一文本的精准语义。

步骤S205、服务器向终端设备发送针对第一文本的回复。

在查询请求用于查询第一文本中的命名实体时,执行步骤S206:

步骤S206、服务器向终端设备发送第一文本的命名实体识别结果。

本实施例中,服务器基于BERT词向量生成服务获取文本的词向量,接着基于第一机器学习模型和文本对应的词向量获取文本的命名实体识别结果,由于BERT词向量生成服务基于常规性能的设备即可高效的获取文本对应的词向量,且获取词向量的准确度与生成BERT词向量生成服务的BERT模型的准确度相同,因此,本申请的方法可以基于常规性能的设备高效准确的进行命名实体识别。

下面采用具体的实施例对服务器获取BERT词向量生成服务和第一机器学习模型的一种具体实现进行说明。

图3为本申请实施例提供的命名实体的识别方法的流程图二,参加图3,本实施例的方法包括:

步骤S301、服务器获取目标命名实体识别模型,目标命名实体识别模型中包括BERT子模型和该BERT子模型的下游机器学习子模型。

一种方式中,服务器获取命名实体识别模型包括:服务器接收来自其它设备的目标命名实体识别模型。该种方式中服务器无需训练目标命名实体识别模型,可以降低服务器的功耗。

另一种方式中,服务器获取目标命名实体识别模型包括如下的a1~a3:

b1、服务器获取初始命名实体识别模型。

其中,初始命名实体识别模型包括BERT初始子模型和BERT初始子模型的初始下游机器学习子模型。其中,BERT初始子模型可以是通用模型。

b2、服务器获取多个训练样本,每个训练样本包括训练文本和该训练文本的命名实体标注结果。

训练文本的命名实体标注可以采用BIO标注方式,其中:B-NP表示名词短语的开头,I-NP表示名词短语的剩余部分,O表示不是名词短语。具体来说,标签B-PER表示人名前缀,标签I-PER表示人名剩余部分,标签B-ORG表示机构名前缀,标签I-ORG表示机构名剩余部分,标签B-LOC表示地名前缀,标签I-LOC表示地名剩余部分,标签B-PRICE表示价格前缀,标签I-PRICE表示价格剩余部分,标签B-date_time表示日期前缀,标签I-date_time表示日期剩余部分,标签B-mobilenum表示电话号码的第一位数字,标签I-mobilenum表示电话号码剩余部分,标签B-time表示时间前缀,标签I-time表示时间剩余部分,标签O表示不是名词短语。

比如,文本“Pierre Vinken,61years old,will join IBM’S board as anonexecutive director Nov.29.”的命名实体标注结果为“Pierre_B-PER Vinken_I-PER,_O 61_O years_O old_O,_O will_O join_O IBM_B-ORG’S_O board_O as_O a_Ononexecutive_O director_O Nov._B-date_time 29_I-date_time._O”。

b3、基于多个训练样本和初始命名实体识别模型,获取目标命名实体识别模型。

可选的,多个训练样本分属于N个训练样本集,不同的训练样本集包括的训练文本的来源不同,N为大于或等于2的整数。相应地,服务器基于多个训练样本和初始命名实体识别模型,获取目标命名实体识别模型,包括如下的b31~b33:

b31、对于每个训练样本集:服务器基于该训练样本集和初始命名实体识别模型,训练得到预选命名实体识别模型。

N个训练样本集中存在第一训练样本集,第一训练样本集包括的训练文本的来源包括如下中的至少一项:媒体文本集、基于购物平台获取的文本集、微软亚洲研究院(Microsoft Research Asia,简称MSRA)数据集、Boson数据集。其中,购物平台可以为与命名实体识别场景对应的购物平台,比如,用户通过APP1中的智能客服界面输入第一文本,则第一训练样本中的训练文本的来源可以包括基于APP1对应的购物平台获取的文本集。

示例性地:N个训练样本集包括训练样本集1、训练样本集2、训练样本集3、训练样本集4、训练样本集5、训练样本集6。训练样本集1中训练文本的来源可以是第一媒体文本集和基于购物平台获取的文本集,第一媒体文本集可以包括第一年份的报纸上的文本。训练样本集2中训练文本的来源可以是MSRA数据集。训练样本集3中训练文本的来源可以是MSRA数据集和第一媒体文本集。训练样本集4中训练文本的来源可以是MSRA数据集、第一媒体文本集和基于购物平台获取的文本集。训练样本集5中训练文本的来源可以是MSRA数据集、第一媒体文本集、基于购物平台获取的文本集、第二媒体文本集,第二媒体文本集可以包括基于微博获取的文本。训练样本集6中训练文本的来源可以是MSRA数据集、第一媒体文本集、基于购物平台获取的文本集、第二媒体文本集和Boson数据集。基于训练样本集1和初始命名实体识别模型,训练得到预选命名实体识别模型1,基于训练样本集2和初始命名实体识别模型,训练得到预选命名实体识别模型2,基于训练样本集3和初始命名实体识别模型,训练得到预选命名实体识别模型3,基于训练样本集4和初始命名实体识别模型,训练得到预选命名实体识别模型4,基于训练样本集5和初始命名实体识别模型,训练得到预选命名实体识别模型5,基于训练样本集6和初始命名实体识别模型,训练得到预选命名实体识别模型6。

b32、服务器基于测试样本集,获取各预选命名实体识别模型的命名实体识别精度。

测试样本集中的测试样本包括:测试文本和测试文本的命名实体标注结果。其中,测试样本集中的文本来源可以是MSRA数据集。

将测试样本集中的样本输入预选命名实体识别模型中,根据对测试样本集中的样本的命名实体识别结果和测试样本集中的样本的命名实体标注结果,得到该预选命名实体识别模型对至少一类命名实体的识别精度,将该预选命名实体识别模型对至少一类命名实体的识别精度的平均值作为该预选命名实体识别模型的命名实体识别精度。

上一示例中得到的6个预选命名实体识别模型的命名实体识别精度可如表1中所示:

表1

b33、服务器确定命名实体识别精度最高的预选识别模型为目标命名实体识别模型。

b31~b33中所示的目标命名实体识别模型的获取方法根据不同来源的训练样本集训练多个预选命名实体识别模型,从多个预选命名实体识别模型中选取命名实体识别精度最高的预选命名实体识别模型作为目标命名实体识别模型,可以得到高识别精度的目标命名实体识别模型。

可选的,多个训练样本属于1个训练样本集,相应地,服务器基于多个训练样本和初始命名实体识别模型,训练得到的命名实体识别模型即为目标命名实体识别模型。此时,多个训练样本的来源至少包括:与命名实体识别场景对应的数据集。该可选的方式获取目标命名实体识别模型的效率较高。

步骤S302、服务器从目标命名实体识别模型中拆分出BERT子模型作为BERT模型。

步骤S303、服务器基于该BERT模型,生成BERT词向量生成服务。

步骤S304、服务器从目标命名实体识别模型中拆分出BERT子模型的下游机器学习子模型作为第一机器学习模型。

服务器获取到目标命名实体识别模型后,从目标命名实体识别模型中拆分出的BERT子模型作为BERT模型,从目标命名实体识别模型中拆分出的BERT子模型的下游机器学习子模型作为第一机器学习模型。服务器将从目标命名实体识别模型中拆分出来的BERT子模型作为BERT模型,服务器基于该BERT模型生成图2所示的实施例中的BERT词向量生成服务。

本实施例中给出了服务器生成BERT词向量生成服务和第一机器学习模型的一种具体实现,本实施例的方法可以保证相应场景下对文本中命名实体的识别准确性。

在其它的实现方式中,用于生成BERT词向量生成服务的BERT模型和第一机器学习模型可以是服务器从其它设备接收到的,比如其它设备训练得到目标命名实体识别模型后,拆分目标命名实体识别模型,得到BERT子模型和该BERT子模型的下游机器学习子模型。其它设备向服务器发送该BERT子模型,服务器将该BERT子模型作为BERT模型,并基于该BERT模型生成图2所示的实施例中的BERT词向量生成服务。其它设备向服务器发送该BERT子模型的下游机器学习子模型,服务器将该下游机器学习子模型作为第一机器学习模型。该可选的方式,可以大大降低服务器的功耗。

以上对本申请所涉及的方法进行了说明,下面对本申请所涉及的装置进行说明。

图4为本申请实施例提供的命名实体的识别装置的示意图。如图4所示,该装置可以是服务器,也可以是服务器的部件(例如,集成电路,芯片等等)。该装置包括:收发模块401和处理模块402。

收发模块401,用于接收来自终端设备的针对第一文本的查询请求;处理模块402,用于通过BERT词向量生成服务,获取所述第一文本对应的第一词向量;所述BERT词向量生成服务是基于BERT模型生成的,BERT模型为从命名实体识别模型中拆分出的BERT子模型,所述BERT模型能够用于获取文本对应的词向量;所述处理模块402,还用于根据所述第一词向量,采用第一机器学习模型识别所述第一文本中的命名实体;所述第一机器学习模型为从所述命名实体识别模型中拆分出的所述BERT子模型的下游机器学习子模型。

在一种可能的实施方式中,在所述处理模块402通过BERT词向量生成服务,获取所述第一文本对应的第一词向量之前,所述处理模块402还用于:获取命名实体识别模型,所述命名实体识别模型中包括所述BERT子模型;从所述命名实体识别模型中拆分出所述BERT子模型作为所述BERT模型;基于所述BERT模型,生成所述BERT词向量生成服务。

在一种可能的实施方式中,所述命名实体识别模型中还包括所述BERT子模型的下游机器学习子模型;在所述处理模块402根据所述第一词向量,采用第一机器学习模型识别所述第一文本中的命名实体之前,所述处理模块402还用于:从所述命名实体识别模型中拆分出所述下游机器学习子模型作为所述第一机器学习模型。

可选的,所述处理模块402具体用于:获取初始命名实体识别模型;获取多个训练样本,每个训练样本包括训练文本和该训练文本的命名实体标注结果;基于所述多个训练样本和所述初始命名实体识别模型,获取所述命名实体识别模型。

可选的,所述多个训练样本对应于N个训练样本集,不同的训练样本集包括的训练文本的来源不同,N为大于或等于2的整数;所述处理模块402具体用于:对于每个训练样本集:基于该训练样本集和所述初始命名实体识别模型,训练得到预选命名实体识别模型;基于测试样本集,获取各预选命名实体识别模型的命名实体识别精度;确定所述命名实体识别精度最高的预选命名实体识别模型为所述命名实体识别模型。

可选的,所述N个训练样本集中存在第一训练样本集,所述第一训练样本集包括的训练文本的来源包括如下中的至少一项:媒体文件集、基于购物平台获取的文本集、微软亚洲研究院MSRA数据集、Boson数据集。

可选的,所述查询请求用于查询针对所述第一文本的回复,所述收发模块401还用于接收来自所述终端设备的查询请求,所述查询请求包括所述第一文本;所述处理模块402还用于:根据所述第一文本的命名实体识别结果,确定所述针对所述第一文本的回复;所述收发模块401还用于向所述终端设备发送所述针对所述第一文本的回复。

可选的,所述查询请求用于查询所述第一文本中包括的命名实体;所述收发模块401还用于:向所述终端设备发送所述第一文本的命名实体识别结果。

本实施例的装置,可以用于执行上述方法实施例中服务器对应的技术方案,其实现原理和技术效果类似,此处不再赘述。

图5为本申请实施例提供的一种电子设备的示意图。如图5所示,电子设备500可用于实现上述方法实施例中描述的方法,具体参见上述方法实施例中的说明。其中,电子设备500可为服务器。

所述电子设备500可以包括一个或多个处理器501,所述处理器501也可以称为处理单元,控制执行上述方法实施例中的方法。所述处理器501可以是通用处理器或者专用处理器等。例如可以是基带处理器、或中央处理器。基带处理器可以用于对通信协议以及通信数据进行处理,中央处理器可以用于对通信装置进行控制,执行软件程序,处理软件程序的数据。

可选的,所述电子设备500中可以包括一个或多个存储器502,其上可以存有指令,所述指令可在所述处理器上被运行,使得所述电子设备500执行上述方法实施例中描述的方法。

可选的,所述存储器中也可以是存储有数据。所述处理器501和存储器502可以单独设置,也可以集成在一起。

可选的,所述电子设备500还可以包括收发器503。所述收发器504可以称为收发单元、收发机、收发电路、或者收发器等,用于实现电子设备的收发功能。

本申请中描述的处理器501和收发器503可实现在集成电路(integratedcircuit,IC)、模拟IC、射频集成电路(radio frequency integrated circuit,RFIC)、混合信号IC、专用集成电路(application specific integrated circuit,ASIC)、印刷电路板(printed circuit board,PCB)、电子设备等上。该处理器和收发器也可以用各种1C工艺技术来制造,例如互补金属氧化物半导体(complementary metal oxide semiconductor,CMOS)、N型金属氧化物半导体(nMetal-oxide-semiconductor,NMOS)、P型金属氧化物半导体(positive channel metal oxide semiconductor,PMOS)、双极结型晶体管(BipolarJunction Transistor,BJT)、双极CMOS(BiCMOS)、硅锗(SiGe)、砷化镓(GaAs)等。

应理解,本申请实施例中提及的处理器可以是中央处理单元(CentralProcessing Unit,CPU),还可以是其他通用处理器、数字信号处理器(Digital SignalProcessor,DSP)、专用集成电路(Application Specific Integrated Circuit,ASIC)、现成可编程门阵列(Field Programmable Gate Array,FPGA)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件等。通用处理器可以是微处理器或者该处理器也可以是任何常规的处理器等。

还应理解,本申请实施例中提及的存储器可以是易失性存储器或非易失性存储器,或可包括易失性和非易失性存储器两者。其中,非易失性存储器可以是只读存储器(Read-Only Memory,ROM)、可编程只读存储器(Programmable ROM,PROM)、可擦除可编程只读存储器(Erasable PROM,EPROM)、电可擦除可编程只读存储器(Electrically EPROM,EEPROM)或闪存。易失性存储器可以是随机存取存储器(Random Access Memory,RAM),其用作外部高速缓存。通过示例性但不是限制性说明,许多形式的RAM可用,例如静态随机存取存储器(Static RAM,SRAM)、动态随机存取存储器(Dynamic RAM,DRAM)、同步动态随机存取存储器(Synchronous DRAM,SDRAM)、双倍数据速率同步动态随机存取存储器(Double DataRate SDRAM,DDR SDRAM)、增强型同步动态随机存取存储器(Enhanced SDRAM,ESDRAM)、同步连接动态随机存取存储器(Synchlink DRAM,SLDRAM)和直接内存总线随机存取存储器(Direct Rambus RAM,DR RAM)。

本申请实施例还提供一种非临时性计算机可读存储介质,当该存储介质中的指令由计算机的处理器执行时,使得计算机能够执行上述命名实体的识别方法。

本领域技术人员在考虑说明书及实践这里公开的发明后,将容易想到本公开的其它实施方案。本申请旨在涵盖本公开的任何变型、用途或者适应性变化,这些变型、用途或者适应性变化遵循本公开的一般性原理并包括本公开未公开的本技术领域中的公知常识或惯用技术手段。说明书和实施例仅被视为示例性的,本公开的真正范围和精神由下面的权利要求书指出。

应当理解的是,本公开并不局限于上面已经描述并在附图中示出的精确结构,并且可以在不脱离其范围进行各种修改和改变。本公开的范围仅由所附的权利要求书来限制。

- 一种命名实体识别方法、装置和用于命名实体识别的装置

- 命名实体识别模型获取及命名实体识别方法、装置及介质