基于无锚点孪生网络的目标跟踪方法及装置

文献发布时间:2023-06-19 11:49:09

技术领域

本发明涉及数据处理技术领域,具体涉及一种基于无锚点孪生网络的目标跟踪方法、一种基于无锚点孪生网络的目标跟踪装置、一种计算机设备和一种非临时性计算机可读存储介质。

背景技术

目标跟踪根据视频第一帧中所要跟踪的目标对象,通过跟踪方法在后续每一帧中确定目标空间位置。当前,一些跟踪方法采用无锚点的孪生网络将待确定目标的图像区域与目标模板图像之间计算相似度,根据最大相似度来确定后续帧中的目标图像。该种方式极容易导致目标物尺寸的估计误差。

发明内容

本发明为解决上述技术问题,提供了一种基于无锚点孪生网络的目标跟踪方法及装置,主要目的在于通过无锚点孪生网络对目标进行精准追踪。

本发明采用的技术方案如下:

本发明第一方面实施例提出了一种基于无锚点孪生网络的目标跟踪方法,

在第一帧视频数据中指定目标跟踪框,并将所述目标跟踪框内的图像作为目标图像;

在当前视频帧中裁剪出高宽为上一帧目标跟踪框高宽预设倍数的图像区域作为当前视频帧中的目标搜索图像区域,所述目标搜索图像区域中的图像作为目标搜索图像;

将所述目标图像与目标搜索图像分别输入孪生网络的目标模板分支和目标搜索分支;

根据中心点位置估计模块输出的热图,以所述热图上的最大值所在位置作为中心点位置的初步估计值,将所述预估中心点位置根据分辨率比例映射到目标图像得到中心点位置估计值;

在中心点位置误差估计模块输出的热图上取中心点位置上的误差值,将误差值与所述位置估计值相加得到中心点的位置,以确定当前视频帧中的目标框中心点;

根据目标框尺寸估计模块的输出的热图,在目标框中心点上的值估算目标框尺寸,并根据所述目标框尺寸及所述目标框中心确定目标框,直至完成所有视频数据的目标跟踪。

根据本发明的一个实施例,在在第一帧视频数据中指定目标跟踪框之前,所述方法还包括:

从每段视频中任意选取帧数相差不大于20帧的两帧图像,以其中一帧目标为中心的矩形框为目标图像区域,其作为目标模板的原始图像输入;另一帧中围绕目标中心裁剪出大于预设倍数的目标图像区域的目标搜索图像区域;每一对目标模板图像与目标搜索区域图像构成了一个数据;

在中心点位置热图上,根据距真实中心点坐标的偏移量为热图上各点位置设置软标签,当热图上的点距真实中心点的距离越近,其为中心点的置信度越高;

根据热图的高度和宽度、热图上点位置上预测的置信度值,以及相应的软标签值计算热图上中心点位置估计的损失;

根据中心点位置误差真实值和神经网络估计的位置误差计算热图上中心点位置误差估计的损失;

计算估计值与真值之间的误差,以计算目标框尺寸的损失;

根据热图上中心点位置估计的损失、热图上中心点位置误差估计的损失以及目标框尺寸的损失构建损失函数;

利用所述损失函数根据输入的训练数据进行反向传播,调整网络参数至损失函数收敛。

根据本发明的一个实施例,所述方法还包括:

孪生网络每一支卷积神经网络都是用于提取深度特征的主干网络模块;

其中,中心点估计模块用于估计目标跟踪框的中心位置,点位置误差估计模块用于估计热图上每个点的位置误差,目标框尺寸估计模块用于输出目标框的长宽尺寸,可与中心点计算得到目标跟踪框的空间位置。

本发明第二方面实施例提出了一种基于无锚点孪生网络的目标跟踪装置,

第一确定单元,用于在第一帧视频数据中指定目标跟踪框,并将所述目标跟踪框内的图像作为目标图像;

第二确定单元,用于在当前视频帧中裁剪出高宽为上一帧目标跟踪框高宽预设倍数的图像区域作为当前视频帧中的目标搜索图像区域,所述目标搜索图像区域中的图像作为目标搜索图像;

输入单元,用于将所述目标图像与目标搜索图像分别输入孪生网络的目标模板分支和目标搜索分支;

第一处理单元,用于根据中心点位置估计模块输出的热图,以所述热图上的最大值所在位置作为中心点位置的初步估计值,将所述预估中心点位置根据分辨率比例映射到目标图像得到中心点位置估计值;

第二处理单元,用于在中心点位置误差估计模块输出的热图上取中心点位置上的误差值,将误差值与所述位置估计值相加得到中心点的位置,以确定当前视频帧中的目标框中心点;

第三处理单元,用于根据目标框尺寸估计模块的输出的热图,在目标框中心点上的值估算目标框尺寸,并根据所述目标框尺寸及所述目标框中心确定目标框,直至完成所有视频数据的目标跟踪。

根据本发明的一个实施例,在在第一帧视频数据中指定目标跟踪框之前,所述装置还包括:

第三确定单元,用于从每段视频中任意选取帧数相差不大于20帧的两帧图像,以其中一帧目标为中心的矩形框为目标图像区域,其作为目标模板的原始图像输入;另一帧中围绕目标中心裁剪出大于预设倍数的目标图像区域的目标搜索图像区域;每一对目标模板图像与目标搜索区域图像构成了一个数据;

第四处理单元,用于在中心点位置热图上,根据距真实中心点坐标的偏移量为热图上各点位置设置软标签,当热图上的点距真实中心点的距离越近,其为中心点的置信度越高;

第一计算单元,用于根据热图的高度和宽度、热图上点位置上预测的置信度值,以及相应的软标签值计算热图上中心点位置估计的损失;

第二计算单元,用于根据中心点位置误差真实值和神经网络估计的位置误差计算热图上中心点位置误差估计的损失;

第三计算单元,用于计算估计值与真值之间的误差,以计算目标框尺寸的损失;

第四计算单元,用于根据热图上中心点位置估计的损失、热图上中心点位置误差估计的损失以及目标框尺寸的损失构建损失函数;

调整单元,用于利用所述损失函数根据输入的训练数据进行反向传播,调整网络参数至损失函数收敛。

根据本发明的一个实施例,所述装置还包括:

孪生网络每一支卷积神经网络都是用于提取深度特征的主干网络模块;

其中,中心点估计模块用于估计目标跟踪框的中心位置,点位置误差估计模块用于估计热图上每个点的位置误差,目标框尺寸估计模块用于输出目标框的长宽尺寸,可与中心点计算得到目标跟踪框的空间位置。

本发明的第三方面实施例提出了一种计算机设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时,实现根据第一方面中任一项所述的基于无锚点孪生网络的目标跟踪方法。

本发明的第四方面实施例提出了一种非临时性计算机可读存储介质,该程序被处理器执行时实现根据第一方面中任一项所述的基于无锚点孪生网络的目标跟踪方法。

本发明的有益效果:

相比现有技术中的方法,本发明实施例引入了目标框尺寸粗估计和尺寸估计残差相结合的目标尺寸估计方法,尤其在尺寸估计残差计算方面通过采集目标框中心和中心点附近的相关图作为残差估计的输入,并以形变卷积的方式计算残差热图,这种方式能够更为鲁棒地适应目标物非刚性运动的场合。

附图说明

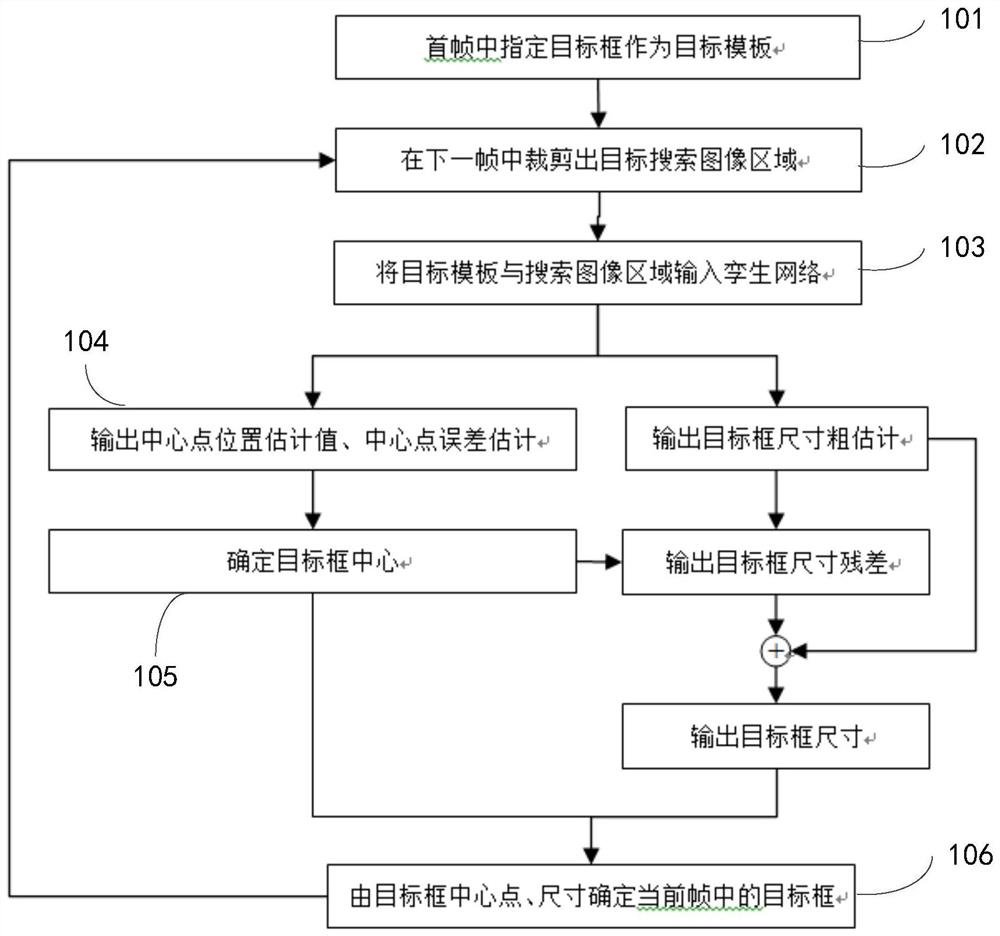

图1示出了本发明实施例提供的一种基于无锚点孪生网络的目标跟踪方法的流程图;

图2示出了本发明实施例提供的一种无锚点孪生网络的示意图;

图3示出了本发明实施例提供的一种训练孪生网络的方法流程图;

图4示出了本发明实施例提供的一种基于无锚点孪生网络的目标跟踪装置的组成框图;

图5示出了本发明实施例提供的另一种基于无锚点孪生网络的目标跟踪装置的组成框图。

具体实施方式

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

本发明实施例一种基于无锚点孪生网络的目标跟踪方法,如图1所示,所述方法包括:

101、在第一帧视频数据中指定目标跟踪框,并将所述目标跟踪框内的图像作为目标图像;目标跟踪框作为目标模板。

在说明本发明实施例的具体实施过程之前,先详细的说明一下本发明实施例所使用的孪生网络,如图2所示,图2示出了本发明实施例提供的一种孪生网络的示意图,孪生卷积神经网络包括中心点估计模块、点位置误差估计模块、目标框尺寸估计模块。其中,孪生网络每一支卷积神经网络都是用于提取深度特征的主干网络模块,中心点估计模块用于估计目标框的中心位置,点位置误差估计模块用于估计热图上每个点的位置误差,目标框尺寸估计模块用于输出目标框的长宽尺寸,其与中心点一起可以计算出目标框的空间位置。

孪生网络有两支卷积神经网络构成的分支,每支卷积神经网络的主干网络都采用了残差神经网络ResNet-50,为了缓解特征图分辨率随着网络深度增加而降低的问题,在ResNet-50的最后两个卷积块中舍去了下采样操作,并采用空洞卷积来扩大感受野,其中第4卷积块中的空洞率设置为2,第5卷积块中的空洞率设置为4,这两支卷积神经网络分别用于目标模板图像和目标搜索图像深度特征的提取。考虑到多层卷积神经网络所提取的特征存在较为明显的差异性,因此需要将不同层输出的特征结果进行融合,具体使用了第3卷积块、第4卷积块和第5卷积块输出的特征。

102、在当前视频帧中裁剪出高宽为上一帧目标跟踪框高宽预设倍数的图像区域作为当前视频帧中的目标搜索图像区域,所述目标搜索图像区域中的图像作为目标搜索图像;

对于每一个卷积块的输出,将目标模板的特征图(目标图像)视作为卷积核,与搜索图像的特征图(目标搜索图像)作卷积计算,获得的互相关图作为后续中心点位置估计、误差估计和中心点至边框边距估计的输入。

在实际应用中,在后续跟踪过程中,在当前帧中围绕上一帧中的目标框为中心裁剪出高和宽为上一帧目标框高和宽2倍的图像区域作为当前帧中的目标搜索图像区域。本发明实施例对预设倍数的设置不进行限定,其可根据不同应用场景进行设置。

103、将所述目标图像与目标搜索图像分别输入孪生网络的目标模板分支和目标搜索分支;

由第3卷积块、第4卷积块和第5卷积块计算所得的3个互相关图在对应通道上取平均值作为最终的互相关图。设置了3个输出分支,分别用于中心点位置估计、中心点位置误差估计和目标框尺寸估计。

104、根据中心点位置估计模块输出的热图,以所述热图上的最大值所在位置作为中心点位置的初步估计值,将所述预估中心点位置根据分辨率比例映射到目标图像得到中心点位置估计值;

中心点位置估计模块在上述所得的互相关图基础上,设置两个卷积层对相关图进行卷积,以此来估计中心点位置热图,其中第一个卷积层的卷积核为3×3尺寸卷积核,输出通道数设置为256,然后通过线性整流层输入到下一层卷积层,该卷积层具有3×3尺寸卷积核,通过该卷积层的卷积得到一个通道的中心点位置热图,热图上每个点的值表示该点为目标框中心位置的置信度。

示例性的,根据中心点位置估计模块输出的一个热图结果,以该张热图上的最大值所在位置作为中心点位置的初步估计值,将该位置根据分辨率比例s映射到原图得到中心点位置估计值。假设热图上最大值所在位置坐标为(i,j),那么映射到原图的位置估计值就为

105、在中心点位置误差估计模块输出的热图上取中心点位置上的误差值,将误差值与所述位置估计值相加得到中心点的位置,以确定当前视频帧中的目标框中心点;

呈由上述实施例,在中心点位置误差估计模块输出的热图上取中心点位置上的误差值,将误差值与位置估计值相加得到中心点的精确位置,由此确定了当前帧中的目标框。假设原图的位置估计值为

106、根据目标框尺寸估计模块的输出的热图,在目标框中心点上的值估算目标框尺寸,并根据所述目标框尺寸及所述目标框中心确定目标框,直至完成所有视频数据的目标跟踪。

目标框尺寸估计模块估计热图上每个点为目标框中心点时目标框的尺寸,其由目标框尺寸粗估计模块和目标框尺寸残差估计模块组成。其中,目标框尺寸粗估计模块对互相关图使用两个卷积层卷积操作,以此得到尺寸粗估计热图。其中第一个卷积层的卷积核为3×3尺寸卷积核,输出通道设置为256个,然后通过线性整流层输入到下一层卷积层,下一层卷积层具有3×3尺寸卷积核,通过该卷积层的卷积得到两个通道的尺寸热图,第一个热图表示每个点为目标框中心点时目标框的宽度,第两个热图表示每个点为目标框中心点时目标框的高度。

目标框尺寸残差估计模块根据互相关图和粗估计的目标框尺寸进一步估计目标框尺寸的残差,以此来补偿目标框估计误差。其接收上述互相关图和目标框尺寸热图作为输入,首先设置了一个卷积层对互相关图做卷积操作,该卷积层的卷积核为3×3尺寸的卷积核,输出通道为27,其中9个通道输出可变形卷积水平方向上的位置偏移误差,9个通道输出可变形卷积垂直方向上的位置偏移误差,剩余9个通道输入sigmoid层得到卷积核上每个权值的估计值。然后这27个通道的偏移量、权值输出一起作为3×3卷积核基础上可变形卷积的输入参数,用于对互相关图进行卷积操作,将这些互相图通过线性整流层输入到后一层卷积层,该卷积层具有1×1尺寸卷积核,通过该卷积层的卷积得到两个通道的目标框尺寸残差热图,分别计算了目标框在宽度和高度值上的残差估计值。

最后,目标框尺寸估计模块的输出为目标框尺寸粗估计模块和目标框尺寸残差估计模块相应输出的热图之和,也即目标框尺寸最终估计值。

呈由上述实施例,根据目标框尺寸估计模块的输出热图在目标框中心点上的值估算目标框尺寸

相比现有技术中的方法,本发明实施例引入了目标框尺寸粗估计和尺寸估计残差相结合的目标尺寸估计方法,尤其在尺寸估计残差计算方面通过采集目标框中心和中心点附近的相关图作为残差估计的输入,并以形变卷积的方式计算残差热图,这种方式能够更为鲁棒地适应目标物非刚性运动的场合。

作为对上述实施例的扩展,如图3所示,图3示出了本发明实施例提供的一种训练孪生网络的方法,具体包括:

201、从每段视频中任意选取帧数相差不大于20帧的两帧图像,以其中一帧目标为中心的矩形框为目标图像区域,其作为目标模板的原始图像输入;另一帧中围绕目标中心裁剪出大于预设倍数的目标图像区域的目标搜索图像区域;每一对目标模板图像与目标搜索区域图像构成了一个训练数据;

为了得到适用于目标跟踪的网络参数,需要利用训练数据来调整网络参数,使得该神经网络能够满足当前的目标跟踪任务要求,为此需要准备训练数据。训练数据选用已手工标注的目标检测图像数据集VID和YouTube-Bou ndingBoxes数据集。从每段视频中任意选取帧数相差不大于20帧的两帧图像,以其中一帧中目标为中心的矩形框为目标图像区域,假设该矩形框宽度为w,高度为h,将其缩放至127×127大小,其为目标模板的原始图像输入。另一帧中围绕目标中心裁剪出宽度为2w,高度为2h的目标搜索图像区域,随后将其缩放至255×255大小。每一对目标模板图像与目标搜索区域图像构成了一个训练数据。

202、在中心点位置热图上,根据距真实中心点坐标的偏移量为热图上各点位置设置软标签,当热图上的点距真实中心点的距离越近,其为中心点的置信度越高;

中心点位置的标签设定方面,在中心点位置热图上,按公式(1)为热图上各点位置设置软标签。

公式(1)中,(i,j)表示当前点坐标距离真实中心点坐标的偏移量,上式表示,当热图上的点距真实中心点的距离越近,其为中心点的置信度越高。当热图上的点距离真实中心点超出3σ的时候,其置信度设置为0。

203、根据热图的高度和宽度、热图上点位置上预测的置信度值,以及相应的软标签值计算热图上中心点位置估计的损失;

为了弥补卷积神经网络下采样操作所造成的定位精度损失问题,设置中心点位置误差估计模块为热图上的点位置估计与原图相应位置之间的误差o。

上式中,(x,y)表示原图上点的坐标,

在目标框尺寸估计问题上,取目标框尺寸真值用于后续损失函数的计算。

为了调整网络参数以适应目标跟踪任务,设置相应的损失函数L为:

L=λ

上式中L

上式中H、W表示热图的高度和宽度,p

204、根据中心点位置误差真实值和神经网络估计的位置误差计算热图上中心点位置误差估计的损失;

关于中心点位置误差估计,L

上式Smooth

205、计算估计值与真值之间的误差,以计算目标框尺寸的损失;

在目标框尺寸估计方面,计算估计值与真值之间的误差,以此来建立关于目标框尺寸的损失函数。

上式中,(α

206、根据热图上中心点位置估计的损失、热图上中心点位置误差估计的损失以及目标框尺寸的损失构建损失函数;

207、利用所述损失函数根据输入的训练数据进行反向传播,调整网络参数至损失函数收敛。

式(3)中,λ

综上所述,本发明实施例将目标跟踪视作是中心点与目标框尺寸的确定问题,避免了使用预置的锚点,减少了热图的输出数量,也就降低了网络的参数数量,加快了跟踪算法的速度。

此外,相比无锚点的目标跟踪方法,本发明实施例引入了目标框尺寸粗估计和尺寸估计残差相结合的目标尺寸估计方法,尤其在尺寸估计残差计算方面通过采集目标框中心和中心点附近的相关图作为残差估计的输入,并以形变卷积的方式计算残差热图,这种方式能够更为鲁棒地适应目标物非刚性运动的场合。

与上述的基于无锚点孪生网络的目标跟踪方法相对应,本发明还提出一种基于无锚点孪生网络的目标跟踪装置。由于本发明的装置实施例与上述的方法实施例相对应,对于装置实施例中未披露的细节可参照上述的方法实施例,本发明中不再进行赘述。

本发明实施例还提供一种基于无锚点孪生网络的目标跟踪装置,其如图4所示,包括:

第一确定单元31,用于在第一帧视频数据中指定目标跟踪框,并将所述目标跟踪框内的图像作为目标图像;

第二确定单元32,用于在当前视频帧中裁剪出高宽为上一帧目标跟踪框高宽预设倍数的图像区域作为当前视频帧中的目标搜索图像区域,所述目标搜索图像区域中的图像作为目标搜索图像;

输入单元33,用于将所述目标图像与目标搜索图像分别输入孪生网络的目标模板分支和目标搜索分支;

第一处理单元34,用于根据中心点位置估计模块输出的热图,以所述热图上的最大值所在位置作为中心点位置的初步估计值,将所述预估中心点位置根据分辨率比例映射到目标图像得到中心点位置估计值;

第二处理单元35,用于在中心点位置误差估计模块输出的热图上取中心点位置上的误差值,将误差值与所述位置估计值相加得到中心点的位置,以确定当前视频帧中的目标框中心点;

第三处理单元36,用于根据目标框尺寸估计模块的输出的热图,在目标框中心点上的值估算目标框尺寸,并根据所述目标框尺寸及所述目标框中心确定目标框,直至完成所有视频数据的目标跟踪。

相比现有技术,本发明实施例引入了目标框尺寸粗估计和尺寸估计残差相结合的目标尺寸估计方法,尤其在尺寸估计残差计算方面通过采集目标框中心和中心点附近的相关图作为残差估计的输入,并以形变卷积的方式计算残差热图,这种方式能够更为鲁棒地适应目标物非刚性运动的场合。

进一步的,如图5所示,所述装置还包括:

第三确定单元37,用于在所述第一确定单元在第一帧视频数据中指定目标跟踪框之前,从每段视频中任意选取帧数相差不大于20帧的两帧图像,以其中一帧目标为中心的矩形框为目标图像区域,其作为目标模板的原始图像输入;另一帧中围绕目标中心裁剪出大于预设倍数的目标图像区域的目标搜索图像区域;每一对目标模板图像与目标搜索区域图像构成了一个数据;

第四处理单元38,用于在中心点位置热图上,根据距真实中心点坐标的偏移量为热图上各点位置设置软标签,当热图上的点距真实中心点的距离越近,其为中心点的置信度越高;

第一计算单元39,用于根据热图的高度和宽度、热图上点位置上预测的置信度值,以及相应的软标签值计算热图上中心点位置估计的损失;

第二计算单元310,用于根据中心点位置误差真实值和神经网络估计的位置误差计算热图上中心点位置误差估计的损失;

第三计算单元311,用于计算估计值与真值之间的误差,以计算目标框尺寸的损失;

第四计算单元312,用于根据热图上中心点位置估计的损失、热图上中心点位置误差估计的损失以及目标框尺寸的损失构建损失函数;

调整单元313,用于利用所述损失函数根据输入的训练数据进行反向传播,调整网络参数至损失函数收敛。

进一步的,所述装置还包括:

孪生网络每一支卷积神经网络都是用于提取深度特征的主干网络模块;

其中,中心点估计模块用于估计目标跟踪框的中心位置,点位置误差估计模块用于估计热图上每个点的位置误差,目标框尺寸估计模块用于输出目标框的长宽尺寸,可与中心点计算得到目标跟踪框的空间位置。

此外,本发明还提出一种计算机设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时,实现上述的辅助谐振换流极变换器的控制方法。

根据本发明实施例的计算机设备,存储在存储器上的计算机程序被处理器运行时,在第一帧视频数据中指定目标跟踪框,并将所述目标跟踪框内的图像作为目标图像;在当前视频帧中裁剪出高宽为上一帧目标跟踪框高宽预设倍数的图像区域作为当前视频帧中的目标搜索图像区域,所述目标搜索图像区域中的图像作为目标搜索图像;将所述目标图像与目标搜索图像分别输入孪生网络的目标模板分支和目标搜索分支;根据中心点位置估计模块输出的热图,以所述热图上的最大值所在位置作为中心点位置的初步估计值,将所述预估中心点位置根据分辨率比例映射到目标图像得到中心点位置估计值;在中心点位置误差估计模块输出的热图上取中心点位置上的误差值,将误差值与所述位置估计值相加得到中心点的位置,以确定当前视频帧中的目标框中心点;根据目标框尺寸估计模块的输出的热图,在目标框中心点上的值估算目标框尺寸,并根据所述目标框尺寸及所述目标框中心确定目标框,直至完成所有视频数据的目标跟踪。引入了目标框尺寸粗估计和尺寸估计残差相结合的目标尺寸估计方法,尤其在尺寸估计残差计算方面通过采集目标框中心和中心点附近的相关图作为残差估计的输入,并以形变卷积的方式计算残差热图,这种方式能够更为鲁棒地适应目标物非刚性运动的场合。

此外,本发明还提出一种非临时性计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时实现上述的辅助谐振换流极变换器的控制方法。

根据本发明实施例的非临时性计算机可读存储介质,存储在其上的计算机程序被处理器执行时,在第一帧视频数据中指定目标跟踪框,并将所述目标跟踪框内的图像作为目标图像;在当前视频帧中裁剪出高宽为上一帧目标跟踪框高宽预设倍数的图像区域作为当前视频帧中的目标搜索图像区域,所述目标搜索图像区域中的图像作为目标搜索图像;将所述目标图像与目标搜索图像分别输入孪生网络的目标模板分支和目标搜索分支;根据中心点位置估计模块输出的热图,以所述热图上的最大值所在位置作为中心点位置的初步估计值,将所述预估中心点位置根据分辨率比例映射到目标图像得到中心点位置估计值;在中心点位置误差估计模块输出的热图上取中心点位置上的误差值,将误差值与所述位置估计值相加得到中心点的位置,以确定当前视频帧中的目标框中心点;根据目标框尺寸估计模块的输出的热图,在目标框中心点上的值估算目标框尺寸,并根据所述目标框尺寸及所述目标框中心确定目标框,直至完成所有视频数据的目标跟踪。引入了目标框尺寸粗估计和尺寸估计残差相结合的目标尺寸估计方法,尤其在尺寸估计残差计算方面通过采集目标框中心和中心点附近的相关图作为残差估计的输入,并以形变卷积的方式计算残差热图,这种方式能够更为鲁棒地适应目标物非刚性运动的场合。

在本说明书的描述中,参考术语“一个实施例”、“一些实施例”、“示例”、“具体示例”、或“一些示例”等的描述意指结合该实施例或示例描述的具体特征、结构、材料或者特点包含于本发明的至少一个实施例或示例中。在本说明书中,对上述术语的示意性表述不必针对相同的实施例或示例。而且,描述的具体特征、结构、材料或者特点可以在任一个或多个实施例或示例中以合适的方式结合。此外,在不相互矛盾的情况下,本领域的技术人员可以将本说明书中描述的不同实施例或示例以及不同实施例或示例的特征进行结合和组合。

尽管已经示出和描述了本发明的实施例,对于本领域的普通技术人员而言,可以理解在不脱离本发明的原理和精神的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由所附权利要求及其等同物限定。

- 基于无锚点孪生网络的目标跟踪方法及装置

- 一种基于孪生网络融合多层特征的无锚点目标跟踪方法