基于伽马通频谱分离的声场景分类方法

文献发布时间:2023-06-19 13:45:04

技术领域

本发明涉及声场景分类技术领域,具体为基于伽马通频谱分离的声场景分类方法。

背景技术

声音是传递信息的重要媒介,也是人类听觉感知系统的重要组成部分。在对复杂环境中的声音事件进行感知方面,人类的固有能力使其不仅能同时捕捉多个声源的信息,如交谈声、敲门声和手机铃声等,且能有选择地屏蔽周围的背景噪音,如空调声、键盘敲击声等。当前,随着智能技术的快速发展,许多智能设备虽能高效地识别语音信息和声纹信息,但对复杂环境中的声音事件进行分类识别时,往往会因为背景噪音的影响,而导致分类识别的准确率不高。

发明内容

为了解决因背景噪音导致生场景分类识别准确率低的问题,本发明提供基于伽马通频谱分离的声场景分类方法,其可以有效地减少背景噪音的影响,提高声音分类识别的准确率。

本发明的技术方案是这样的:基于伽马通频谱分离的声场景分类方法,其包括以下步骤:

S1:采集原始音频样本信息,对其进行预处理;

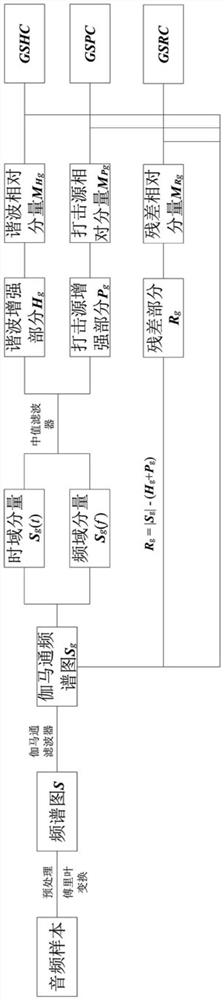

S2:将预处理后的所述原始音频样本信息经过傅里叶变换处理,经过用于提取声学特征的伽马通滤波器处理,得到所述原始音频样本信息对应的伽马通频谱图,记做伽马通频谱图;

其特征在于,其还包括以下步骤:

S3:将所述伽马通频谱图的时域分量和频域分量分别进行中值滤波计算,得到所述伽马通频谱图的谐波增强部分和打击源增强部分;

S4:定义所述所述伽马通频谱图的残差部分,并计算出所述伽马通频谱图的谐波增强部分、打击源增强部分和残差部分的相对分量;

S5:基于所述伽马通频谱图,结合所述谐波增强部分、所述打击源增强部分和所述残差部分的相对分量,计算得到所述伽马通频谱图的谐波分量、打击源分量以及残差分量;

S6:构建声场景分类模型;

S7:将所述伽马通频谱图的所述谐波分量、所述打击源分量、所述残差分量三种声学特征作为训练用数据,输入所述声场景分类模型进行训练,得到训练好的所述声场景分类模型;

S8:将待分类音频样本信息,进行特征分离处理,将得到对应的谐波分量、打击源分量以及残差分量,输入到所述训练好的所述声场景分类模型中,得到分类结果。

其进一步特征在于:

步骤S2中,所述伽马通滤波器组的脉冲响应的经典模型为:

f是是基于赫兹尺度的频率;

步骤S3中,所述伽马通频谱图的谐波增强部分和打击源增强部分的计算方法如下:

将所述伽马通频谱图Sg的时域分量S

y(a)=m{x(a),l}=median{x(a-j,a+j),j=(l-1)/2}

式中,median(.)为中值滤波器,a为信号值,l为滤波器总长度,j为滤波器左右方向的有效长度,x(.)为输入信号;

输出信号为所述伽马通频谱图Sg的谐波增强部分H

式中,l

步骤S4中,所述伽马通频谱图的残差部分R

R

步骤S4所述伽马通频谱图谐波增强部分、打击源增强部分和残差部分的相对分量M

式中

步骤S5中,到所述伽马通频谱图的谐波分量GSHC、打击源分量GSPC以及残差分量GSRC的定义如下:

式中

步骤S6中,基于CNN构建所述声场景分类模型;

所述声场景分类模型包括:通道数递增的连续的Conv层,所述Conve层的最后设置一个全连接层;

每个所述Conv层包括:两个连续的卷积层;每个所述卷积层后面分别依次跟着一个BR层、一个最大池化层;所述BR层基于RELU函数实现;

基于所述声场景分类模型进行分类前,将所述谐波分量、所述打击源分量、所述残差分量三种声学特征输入所述声场景分类模型时,需在声学特征数据的维度的基础上增加一维表示通道数的向量;

训练好的所述声场景分类模型通过softmax函数输出分类预测;

步骤S1中,所述原始音频样本信息包括:音频时长和采样频率,所述预处理包括:预加重、分帧、加窗。

本发明提供的基于伽马通频谱分离的声场景分类方法,其利用伽马通频谱图,并将音频样本信息分离出谐波分量、打击源分量以及残差分量三个部分,基于伽马通频谱图的残差分量,能够有效减少背景噪音中的谐波噪音和打击源噪音,以达到降低背景噪音的效果,进而提升了声场景分类模型的分类准确率,同时提高了声场景分类模型的泛化能力。

附图说明

图1为本发明中伽马通频谱分离原理示意图;

图2为本发明中声场景分类模型的网络结构示意图。

具体实施方式

本发明基于伽马通频谱分离的声场景分类方法,首先对原始音频数据进行频谱分离操作,具体步骤如图1所示。

S1:采集原始音频样本信息,对其进行预处理;

本实施例中,原始音频样本信息包括:音频时长和采样频率,预处理包括:预加重、分帧、加窗。

S2:将预处理后的原始音频样本信息经过傅里叶变换处理得到频谱图S;

对于频谱图S经过用于提取声学特征的伽马通滤波器处理,得到原始音频样本信息对应的伽马通频谱图,记做伽马通频谱图Sg。

本专利中的声学特征提取方法是以频谱图的谐波打击源分离方法为基础,结合伽马通滤波器的特点提出的一种特征提取方法。伽马通语谱图(Gamma-tone spectrogram,Gts)和伽马通频率倒谱系数(Gamma-tone frequency cepstral coefficients,GFCC)是基于等效矩形带宽频率尺度的伽马通滤波器组得到的声学特征。

Gamma-tone滤波器组是耳蜗标准滤波器。它是模拟人耳听觉系统的滤波器组。Gamma-tone(伽马通语)滤波器组脉冲响应的经典模型为:

其中,f是基于赫兹尺度的频率;

将频谱图s通过上述伽马通滤波器组得到伽马通频谱图S

S3:将伽马通频谱图的时域分量和频域分量分别进行中值滤波计算,得到伽马通频谱图的谐波增强部分和打击源增强部分;

伽马通频谱图的谐波增强部分和打击源增强部分的计算方法如下:

将伽马通频谱图Sg的时域分量S

y(a)=m{x(a),l}=median{x(a-j,a+j),j=(l-1)/2}

式中,median(.)为中值滤波器,a为信号值,l为滤波器总长度,j为滤波器左右方向的有效长度,x(.)为输入信号;

输出信号为伽马通频谱图Sg的谐波增强部分H

式中,l

S4:定义伽马通频谱图的残差部分,并计算出伽马通频谱图的谐波增强部分、打击源增强部分和残差部分的相对分量;

伽马通频谱图的残差部分R

R

其中,伽马通频谱图谐波增强部分、打击源增强部分和残差部分的相对分量M

式中

S5:基于伽马通频谱图,结合谐波增强部分、打击源增强部分和残差部分的相对分量,计算得到伽马通频谱图的谐波分量、打击源分量以及残差分量;

到伽马通频谱图的伽马通频谱图谐波分量(Gamma-tone Spectrogram HarmonicComponent,以下简称谐波分量GSHC)、伽马通频谱图打击源分量(Gamma-tone SpectrogramPercussive-source Component,以下简称打击源分量GSPC)以及伽马通频谱图谐波分量(Gamma-tone Spectrogram Residual Component,以下谐波分量GSRC)的定义如下:

式中

S6:构建声场景分类模型;

本发明技术方案中,基于CNN构建声场景分类模型;

声场景分类模型包括:通道数递增的连续的Conv层,Conve层的最后设置一个全连接层;

每个Conv层包括:两个连续的卷积层;每个卷积层后面分别依次跟着一个BR层、一个最大池化层;最后声场景分类模型通过softmax函数输出分类预测。

即:Conv层的结构为:

卷积层+BR层+最大池化层+卷积层+BR层+最大池化层;

本实施例中,CNN网络的主体结构是由三组通道数递增的Conv层和一个全连接层组成,如图2所示,声场景分类模型的网络结构为:

输入层(input)+Conv层+Conv层+Conv层+全连接层+输出层(softmax)。

设置Conv层中的每一个卷积层中卷积核的尺寸为3×3,且卷积核在特征图上均匀扫过的步长设置为1,BR层是由批归一化batch-normalization和激活函数RectifiedLinear Unit(简称RELU)组成,其计算公式为:

全连接层是利用全局平均池化处理,将卷积操作后的特征图层池化为一维数据,并在池化处理后使用dropout处理,舍弃部分网络节点来降低模型出现过拟合的风险。

最后声场景分类模型通过softmax函数输出分类预测,softmax计算公式为

S

S7:将伽马通频谱图的谐波分量、打击源分量、残差分量三种声学特征作为训练用数据,输入声场景分类模型进行训练,得到训练好的声场景分类模型;

其中,基于声场景分类模型进行分类前,将谐波分量、打击源分量、残差分量三种声学特征输入声场景分类模型时,需在声学特征数据的维度的基础上增加一维表示通道数的向量。

如图2所示,为本发明中主体网络的连接示意图,以GSHC特征输入为例,声学特征的特征向量输入网络进行训练之前,需要在原有的2维向量的基础上,增加一维表示通道数的向量,来适应网络中的卷积操作,即,将三种声学特征的特征向量均扩展为分别表示(帧数、特征维数、通道数)的三维向量;如:GSHC特征向量原始为2维向量:(174,128),扩展后为:(174,128,1)。

特征向量输入图2所述的声场景分类模型后,首先经过三组通道数递增的Conv层,其中,第一组Conv层中包含两个通道数为32,卷积核尺寸为3,卷积核滑动步长为1的卷积层以及两组批标准化(Batch-Normalization)处理和激活函数Rectified Linear Unit(简称RELU)处理,卷积核通过均匀扫过特征图来实现卷积操作,以一个卷积核的卷积操作为例,其计算公式为:

其中,求和∑表示卷积层前向传播的过程,I表示输入的特征图,s表示输出的特征图,K表示卷积核,

*表示卷积运算,(i,j)表示特征图上的特征向量,(m,n)表示卷积核的尺寸。

然后采用最大池化处理,并设置池化尺寸为3×3;第二组Conv层的参数设置较第一组Conv层只改变了通道个数和池化尺寸,其两个通道数为64,池化尺寸为3×3;第三组Conv层的参数设置较第二组Conv层只改变了通道个数,其两个通道数为128。从Conv层输出的特征图层进入全连接层,先通过全局平均池化处理将特征图层池化为一维数据,再经过全连接处理得到长度为256的一维特征数据,最后通过Dropout处理来降低模型过拟合的概率。将输出后的特征数据再通过全连接处理得到长度为256的一维特征数据,以及Dropout处理来降低模型过拟合的概率,最后通过归一化指数函数Softmax处理后,输出最终分类预测结果。

S8:使用训练好的声场景分类模型进行分类操作时,将待分类音频样本信息,进行特征分离处理,将得到对应的谐波分量、打击源分量以及残差分量,输入到训练好的声场景分类模型中,得到分类结果。

为了确认本发明技术方案中的基于伽马通频谱分离的声场景分类方法的性能,在Window10系统、显卡GTX1660Ti、CPU为i7-9750H、内存32G的实验环境下,使用keras+TensorFlow作为深度学习框架,采用城市声音事件分类标准数据集UrbanSound8k,其中:fold1-9作为训练集,训练集样本个数为7895;测试集为fold10中wav音频文件,样本个数为838;分别进行以下实验:

(1)数据增强对模型影响的对比实验,

(2)多声学特征和单一声学特征对模型影响的对比试验;

(3)通过环境音频数据集ESC50来检验伽马通频谱分离的声场景分类方法的泛化能力。

利用本专利中的声场景分类模型(图中标记为CNN)和常用的ResNet18模型作为分类模型,以伽马通频谱图(Gamma-tone spectrogram,以下简称Gts)、GSHC、GSPC以及GSRC作为输入数据,在Urbansound8K和ESC-50数据集上进行声场景分类实验,并对比分类准确率的变化情况,具体结果如表1所示:

表1伽马通频谱图分离实验

传统的音频数据分类方法中,主要采用未经处理的频谱图特征作为输入数据,这会导致音频样本中的背景噪音对分类模型产生较大的影响。表1中给出不同声学特征输入的声场景分类准确率对比,可以从表1中的实验数据看出,相较于未经处理的伽马通频谱图特征(Gts),将经过特征分离的GSHC、GSPC和GSRC输入CNN网络时,模型的分类准确率均有所提升,在两个数据集上平均提升了1.7%和1.1%,其中GSRC特征的准确率在两个数据集上均达到最高,分别为89.4%和86.4%。

而在基于ResNet18模型的分类结果数据中,相较于未经处理的伽马通频谱图特征(Gts),将特征分离后的GSHC、GSPC和GSRC输入ResNet18网络时,ResNet18模型的分类准确率也是同样地均有所提升,在两个数据集上平均提升了1.3%和1.8%,其中GSRC特征的准确率在两个数据集上均达到最高,分别为89.9%和87.2%。

综上所述,基于表1的分类准确率数据可以得到,特征分离后得到的特征相比原始特征输入在分类准确率方面有一定的提升,且GSRC特征能有效减少背景噪音的影响从而提高模型的准确率。本发明提供的声场景分类方法,在处理音频数据时,引入了伽马通频谱图分离方式,将待分类音频数据尽心频谱分离,将其分离出:谐波分量、打击源分量以及残差分量,然后输入声场景分类模型中,使得声场景分类模型的准确率以及泛化能力都有一定的提升。

- 基于伽马通频谱分离的声场景分类方法

- 基于网络模型融合的声场景分类方法