基于人工智能的数据处理方法、装置、设备和介质

文献发布时间:2023-06-19 11:44:10

技术领域

本申请涉及人工智能技术领域,尤其涉及一种基于人工智能的数据处理方法、装置、设备和介质。

背景技术

深度Q网络(Deep Q-Network,DQN)模型是深度强化学习(Deep ReinforcementLearning,DRL))中的一个经典算法,其通过将深度学习和强化学习相结合,来优化序列决策问题的长短期综合目标。DQN模型利用神经网络来拟合策略,网络输入状态,输出各个动作对应的Q值(即预期奖励),最大的Q值对应的动作即为DQN认为应该选择的动作。然而,发明人意识到,目前输入DQN模型的状态表示过于简单,例如,直接将文本数据作为状态输入,导致DQN模型输出的Q值不准确,即确定出的策略可靠性较低。

发明内容

本申请实施例提供了一种基于人工智能的数据处理方法、装置、设备和介质,有助于提升确定出的用户处理策略的可靠性。

第一方面,本申请实施例提供了一种基于人工智能的数据处理方法,包括:

获取样本数据;

利用BERT模型获取所述样本数据对应的状态转移信息,并根据所述状态转移信息对所述BERT模型进行训练,以及根据所述BERT模型的输出结果对与所述BERT模型连接的DQN模型进行训练,得到训练后的目标BERT模型和目标DQN模型;

获取目标用户的当前状态信息;

将所述当前状态信息输入所述目标BERT模型进行编码处理,获得所述目标BERT模型输出的分类器标记CLS符号所对应的编码向量;

将所述CLS符号所对应的编码向量输入所述目标DQN模型,获得所述当前状态信息对应的动作信息,所述动作信息用于指示所述当前状态下对所述目标用户所采取的处理策略。

所述样本数据包括状态信息和动作信息;所述利用BERT模型获取所述样本数据对应的状态转移信息,并根据所述状态转移信息对所述BERT模型进行训练,以及根据所述BERT模型的输出结果对与所述BERT模型连接的DQN模型进行训练,得到训练后的目标BERT模型和目标DQN模型,包括:

将所述样本数据包括的状态信息输入BERT模型进行编码处理,获得CLS符号对应的编码向量;

获取所述样本数据包括的动作信息对应的独热编码向量;

将所述CLS符号对应的编码向量与所述动作信息对应的独热编码向量进行向量拼接,获得拼接后的向量;

根据拼接后的向量确定所述样本数据对应的状态转移信息,并根据所述状态转移信息对所述BERT模型的各个模型参数进行调整;

将所述CLS符号对应的编码向量输入DQN模型,对所述DQN模型进行训练,并对所述BERT模型的各个模型参数进行调整,得到训练后的目标BERT模型和目标DQN模型。

可选的,所述根据拼接后的向量确定所述样本数据对应的状态转移信息,并根据所述状态转移信息对所述BERT模型的各个模型参数进行调整,包括:

将拼接后的向量输入全连接层进行预测,获得预测的下一次状态特征;

根据所述预测的下一次状态特征与实际的下一次状态特征,对BERT模型的各个模型参数进行调整。

可选的,所述样本数据包括状态信息,所述状态信息包括多个特征;所述方法还包括:

通过MASK符号代替所述状态信息中的一个或多个特征对应的一维词向量;

获取所述MASK符号在输入所述BERT模型的各个特征中所在位置,并获取所述BERT模型输出的各个编码词向量中所述MASK符号所在位置对应的编码词向量;

根据所述MASK符号所在位置对应的编码词向量预测输入所述BERT模型的所述MASK符号的特征,得到所述MASK符号的预测特征;

根据所述预测特征和所述MASK符号的实际特征,对所述BERT模型的各个模型参数进行调整。

可选的,所述根据所述MASK符号所在位置对应的编码词向量预测输入所述BERT模型的所述MASK符号的特征,包括:

将所述MASK符号所在位置对应的编码词向量输入全连接层进行预测,获得输入所述BERT模型的所述MASK符号的特征。

可选的,所述获取样本数据,包括:

获取多个用户的特征数据,所述特征数据包括连续特征数据;

对所述连续特征数据进行离散化处理,获得离散化特征数据,并将所述离散化特征数据作为样本数据。

可选的,在所述获得所述当前状态信息对应的动作信息之后,所述方法还包括:

根据所述当前状态信息对应的动作信息,确定所述目标用户所属的用户分群;

其中,属于同一用户分群的用户所对应的动作信息相匹配。

第二方面,本申请实施例提供了一种数据处理装置,包括:

获取模块,用于获取样本数据;

训练模块,用于利用BERT模型获取所述样本数据对应的状态转移信息,并根据所述状态转移信息对所述BERT模型进行训练,以及根据所述BERT模型的输出结果对与所述BERT模型连接的DQN模型进行训练,得到训练后的目标BERT模型和目标DQN模型;

所述获取模块,还用于获取目标用户的当前状态信息;

处理模块,用于将所述当前状态信息输入所述目标BERT模型进行编码处理,获得所述目标BERT模型输出的分类器标记CLS符号所对应的编码向量;

所述处理模块,还用于将所述CLS符号所对应的编码向量输入所述目标DQN模型,获得所述当前状态信息对应的动作信息,所述动作信息用于指示所述当前状态下对所述目标用户所采取的处理策略。

第三方面,本申请实施例提供了一种数据处理设备,该数据处理设备可包括处理器和存储器,所述处理器和存储器相互连接。其中,所述存储器用于存储支持数据处理设备执行上述方法或步骤的计算机程序,所述计算机程序包括程序指令,所述处理器被配置用于调用所述程序指令,执行上述第一方面的方法的部分或全部步骤。

第四方面,本申请实施例提供了一种计算机可读存储介质,所述计算机可读存储介质存储有计算机程序,所述计算机程序包括程序指令,所述程序指令当被处理器执行时使所述处理器执行上述第一方面的方法的部分或全部步骤。

在本申请实施例中,BERT模型可以学习到状态转移信息,使得BERT模型的输出向量更准确的表示语句含义信息,最终实现将BERT模型的输出输入DQN模型进行训练时,可以得到更准确的Q值,使得后续在为用户确定策略时,可以通过将BERT模型与DQN模型结合,得到当前状态对应的策略,这就提升了确定出的用户处理策略的可靠性。

附图说明

为了更清楚地说明本申请实施例技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图是本申请的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

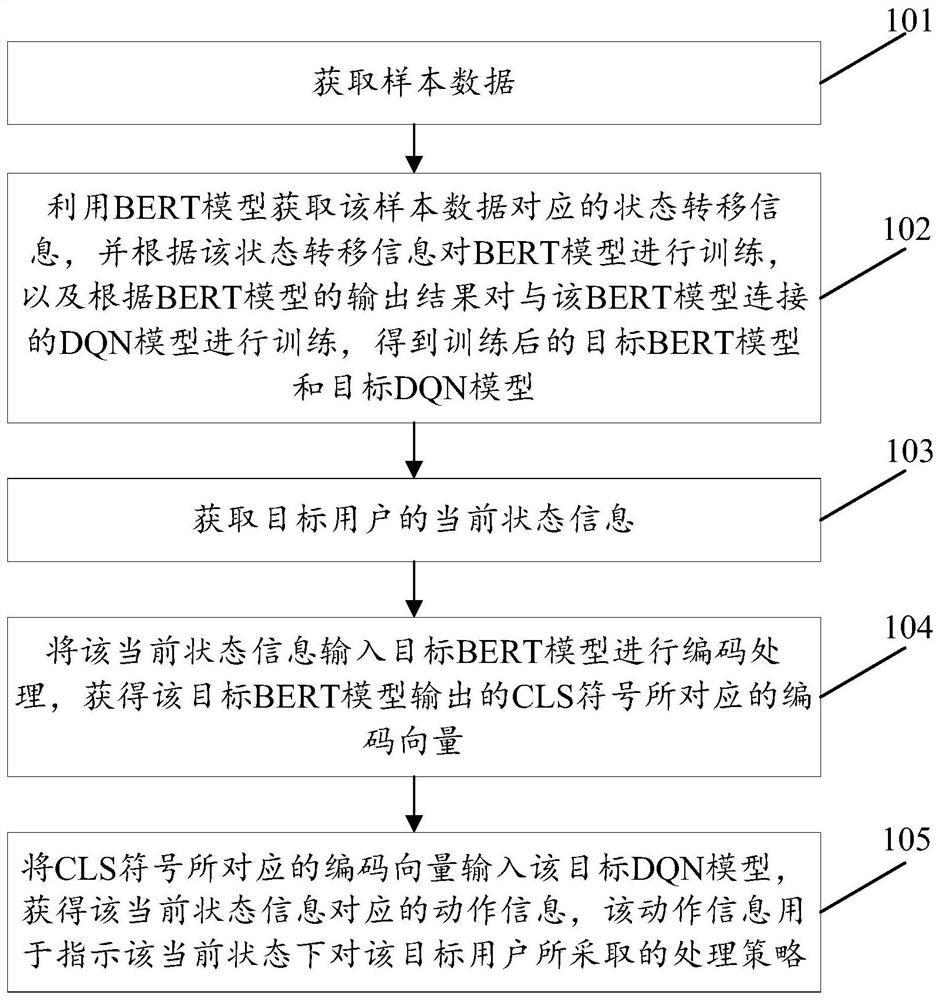

图1是本申请实施例提供的一种基于人工智能的数据处理方法的流程示意图;

图2是本申请实施例提供的另一种基于人工智能的数据处理方法的流程示意图;

图3a是本申请实施例提供的一种BERT+DQN模型的架构示意图;

图3b是本申请实施例提供的另一种BERT+DQN模型的架构示意图;

图4是本申请实施例提供的一种数据处理装置的结构示意图;

图5是本申请实施例提供的一种数据处理设备的结构示意图。

具体实施方式

下面将结合本申请实施例中的附图,对本申请实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例是本申请一部分实施例,而不是全部的实施例。基于本申请中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本申请保护的范围。

本申请的技术方案可应用于人工智能和/或大数据技术领域,如可应用于治疗方案确定、用户分群等场景中,以实现智能地为用户确定出可靠的策略,推动智慧城市的建设。例如,本申请可通过数据平台或其他设备实现。可选的,本申请涉及的数据如样本数据、状态信息和/或动作信息等可存储于区块链节点,或者可存储于数据库,本申请不做限定。

BERT模型是一个先进的神经语言预训练模型,而DQN模型作为DRL中的经典算法,是通过将深度学习和强化学习相结合强化学习,来实现策略的确定。其中,强化学习方法是智能体通过一定的策略(policy),针对状态(state)采取动作(action)后得到奖励(reward),再通过所获得的奖励(reward)来优化策略(policy)的人工智能方法。其中policy是指在特定state下应该采取某个action,以使预期reward最大。本申请通过结合BERT(Bidirectional Encoder Representation from Transformers)模型和DRL模型如DQN模型来确定采取的策略,使得确定出的策略更加准确,可靠性更高。例如,本申请可以获取样本数据,基于样本数据对BERT模型和DRL模型如DQN模型进行训练,进而可将用户信息如用户状态信息输入训练好的BERT模型,将BERT模型的输出信息输入训练好的DRL模型如DQN模型,最终得到该用户状态信息对应的动作信息,获得当前可采取的策略,如治疗方案、锻炼方案和/或分群方案等等。

可以理解,本申请的技术方案可应用于数据处理设备(数据处理装置)中,用于确定处理策略。可选的,该数据处理设备可以是终端,也可以是服务器,还可以为数据平台或其他设备。该终端可包括手机、平板电脑、计算机等等,本申请不做限定。可以理解,在其他实施例中,该终端还可叫做其余名称,比如叫做终端设备、智能终端、用户设备、用户终端等等,此处不一一列举。

本申请实施例提供了一种基于人工智能的数据处理方法、装置、设备和介质等,使得有助于提升确定出的策略的可靠性。以下分别详细说明。

请参见图1,是本申请实施例提供的一种基于人工智能的数据处理方法的流程示意图。该方法可以由上述的数据处理设备执行,如图1所示,该方法可包括以下步骤:

101、获取样本数据。

可选的,该样本数据可以是文本数据、表格数据、图片数据等等,获取的样本数据可包括多个(多组),本申请不做限定。例如,该样本数据可以是糖尿病患者的长期随访数据,通过收集大量糖尿病患者的长期随访数据,作为样本数据。比如以每个患者的每次随访数据为一个(一组)样本数据,一个样本数据可以包括患者的人口统计学信息、检验检查指标、用药史、开药信息等一项或多项特征数据,或者,可以是根据患者的人口统计学信息、检验检查指标、用药史、开药信息等一项或多项特征数据转化得到的。

在一些实施例中,在获取样本数据时,可以是通过获取多个用户的特征数据,该特征数据包括连续特征数据;进而可对该连续特征数据进行离散化处理,获得离散化特征数据,并将该离散化特征数据作为样本数据。也就是说,针对连续特征数据,可以将连续特征数据进行离散化处理后作为样本数据。由此有助于在确保训练可靠性的同时,降低模型训练复杂度。

在一些实施例中,对该连续特征数据进行离散化处理,获得离散化特征数据的方式,可以是将连续特征数据分为n个区间,每个区间对应一个离散值;若用户的连续特征数据属于某一个区间,则将该区间对应的离散值确定为离散化特征数据。也就是说,离散化处理可以是将连续特征数据分为n个区间,每个区间对应一个离散值,进而可根据用户(患者)的连续特征数据所属的区间,确定该连续特征数据对应的离算话特征数据,也即该区间对应的离散值。例如,结合临床知识,将所有的连续患者特征进行离散化处理,分为5个区间,每个区间对应一个离散值。5个区间分别为:极低、较低于正常值、正常值、较高于正常值、极高。

在一些实施例中,该样本数据可以从区块链获取,即样本数据可以预先存储于区块链中。通过从区块链中获取样本数据,可以提升获取的数据的可靠性,进而提升基于该样本数据训练出的模型的准确性,进而提升后续确定出的用户处理策略的可靠性。例如,数据处理设备可以向区块链节点发送携带项目标识的数据请求,使得区块链节点在接收到该请求并对该数据处理设备的身份校验通过之后,可查找该标识对应的样本数据,进而可向该数据处理设备返回查找出的样本数据,数据处理设备可接收区块链节点发送的净效益。可选的,该项目标识可以是疾病标识、区域标识、性别标识、年龄标识等等,本申请不做限定。

在一些实施例中,该样本数据可以从服务器获取,比如通过向服务器发送携带项目标识的数据请求以请求该项目标识对应的样本数据,与上述向区块链节点请求数据的方式类似,此处不赘述。

102、利用BERT模型获取该样本数据对应的状态转移信息,并根据该状态转移信息对BERT模型进行训练,以及根据BERT模型的输出结果对与该BERT模型连接的DQN模型进行训练,得到训练后的目标BERT模型和目标DQN模型。

在获取得到样本数据之后,可以基于样本数据对BERT模型和DRL模型如DQN模型进行训练。例如,可以将样本数据输入BERT模型,并可获取该样本数据对应的状态转移信息,以对BERT模型+DQN模型进行训练。

可选的,该样本数据包括状态信息和动作信息。进一步可选的,该状态转移信息可以是下一次状态特征的相关信息。

在一些实施例中,利用BERT模型获取样本数据对应的状态转移信息,并根据状态转移信息对BERT模型进行训练,以及根据BERT模型的输出结果对与该BERT模型连接的DQN模型进行训练,得到训练后的目标BERT模型和目标DQN模型的方式,可以是将该样本数据包括的状态信息输入BERT模型进行编码处理,获得输出结果如CLS符号对应的编码向量,并可获取该样本数据包括的动作信息对应的独热编码向量;进而可将该CLS符号对应的编码向量与该动作信息对应的独热编码向量进行向量拼接,获得拼接后的向量;然后可根据拼接后的向量确定该样本数据对应的状态转移信息,并根据该状态转移信息对该BERT模型的各个模型参数进行调整。进一步的,还可将该CLS符号对应的编码向量输入DQN模型,对该DQN模型进行训练,通过DQN模型的迭代训练对该BERT模型的各个模型参数进行调整,得到训练后的目标BERT模型和目标DQN模型。

在一些实施例中,根据拼接后的向量确定该样本数据对应的状态转移信息,并根据该状态转移信息对该BERT模型的各个模型参数进行调整的方式,可以是对拼接后的向量进行预测,得到预测的下一次状态信息/特征,比如将拼接后的向量输入全连接层进行预测,获得预测的下一次状态特征;进而可根据该预测的下一次状态特征与实际的下一次状态特征,对BERT模型的各个模型参数进行调整。

在一些实施例中,还可通过MASK符号代替该样本数据中的一个或多个特征对应的词向量如一维词向量;进而可获取该MASK符号在输入BERT模型的各个特征中所在位置,并获取该BERT模型输出的各个编码词向量中该MASK符号所在位置对应的编码词向量。进一步的,可根据该MASK符号所在位置对应的编码词向量预测输入该BERT模型的该MASK符号的特征,得到该MASK符号的预测特征;进而根据该预测特征和该MASK符号的实际特征,对该BERT模型的各个模型参数进行调整。由此可进一步提升对BERT模型训练的可靠性。

也就是说,首先可利用BERT对患者的state进行预训练,输入患者的当前visit的state,预训练包括:MASK(Mask)掉一部分token,然后利用MASK的位置对应的输出预测被MASK的token;利用CLS的输出预测下一个状态会出现的token。然后,可以把BERT模型的CLS的输出连接到DQN模型的输入,利用DQN模型进行强化学习的迭代训练而微调BERT模型,同时拟合最优策略。

在一些实施例中,根据该MASK符号所在位置对应的编码词向量预测输入该BERT模型的该MASK符号的特征的方式,可以是将该MASK符号所在位置对应的编码词向量输入全连接层进行预测,获得输入该BERT模型的该MASK符号的特征。

在一些实施例中,还可以通过其他方式获取状态转移信息,比如基于样本数据从服务器获取,或者通过其他算法确定出,本申请不做限定。

103、获取目标用户的当前状态信息。

可选的,该目标用户可以是指任一个或多个用户,也可以是指特定的一个或多个用户,比如发起决策请求的用户,又如需要进行随访的用户,等等,本申请不做限定。进一步可选的,该当前状态信息可以是指任一状态信息。例如,该当前状态信息可以包括人口统计学信息、检验检查指标、用药史中的一项或多项。

104、将该当前状态信息输入目标BERT模型进行编码处理,获得该目标BERT模型输出的CLS符号所对应的编码向量。

105、将CLS符号所对应的编码向量输入该目标DQN模型,获得该当前状态信息对应的动作信息,该动作信息用于指示该当前状态下对该目标用户所采取的处理策略。

BERT模型是一个先进的神经语言预训练模型,原本用于学习由单词组成的句子的表示。输入为每个单词,输出为句子的表示。本申请可通过将BERT模型用于为患者确定策略的DRL任务上,比如可输入患者某次随访的各个特征(state),输出患者在当次随访的表示。

在训练得到BERT+DQN模型之后,即可通过将用户信息如用户状态信息输入训练好的BERT模型,将BERT模型的输出信息输入训练好的DRL模型如DQN模型,最终得到该用户状态信息对应的动作信息,预测得到当前可采取的策略,如治疗方案、锻炼方案和/或分群方案等等。也就是说,训练结束后,模型使用时,可输入患者的state的各个特征信息,输出最大Q值对应的决策,进行患者分群等等。

在一些实施例中,在确定出目标用户对应的动作信息之后,还可基于该确定出的动作信息/策略为该目标用户推送消息,如营销消息、服务消息、医疗消息等等,本申请不做限定。

本申请提出的BERT+DQN方案结合了深度强化学习技术和神经语言预训练技术,在学习患者状态更好的表示的同时寻找最优的用户处理策略。所学习到的患者状态表示包含了更多的潜在信息以及状态转移信息,同时,由于状态转移还由实际采取的action决定,可能包含了一定的专家决策(action)信息,使得所确定的用户处理策略更加准确、合理、安全。这种结合的框架将DRL的预训练步骤融合进了BERT模型的预训练中,减少了DRL模型的无用探索,适用于各种领域。

在本申请实施例中,BERT模型可以学习到状态转移信息,使得BERT模型的输出向量更准确的表示语句含义信息,最终实现将BERT模型的输出输入DQN模型进行训练时,可以得到更准确的Q值,使得后续在为用户确定策略时,可以通过将BERT模型与DQN模型结合,得到当前状态对应的策略,这就提升了确定出的用户处理策略的可靠性。

请参见图2,是本申请实施例提供的另一种基于人工智能的数据处理方法的流程示意图。该方法可以由上述的数据处理设备执行,并可应用于用户分群场景。如图2所示,该方法可包括以下步骤:

201、获取样本数据。

可选的,该步骤201的描述可参照上述实施例中的相关描述,此处不赘述。

202、将该样本数据包括的状态信息输入BERT模型进行编码处理,获得CLS符号对应的编码向量。

在获取得到样本数据之后,可以将样本数据输入BERT模型进行编码处理,比如将所有样本数据或样本数据中的状态信息输入BERT模型,获得输出结果,包括分类器标记CLS符号所对应的编码向量,该编码向量可以作为输入该BERT模型的所有样本数据的语义表示。

例如,可采用BERT模型对样本数据中各个特征对应的一维词向量进行编码处理,并输出与各个特征对应的编码词向量,编码词向量可以作为该特征的文本语义表示。可以理解,具有相近或相似特征所对应的编码词向量在向量空间上距离也比较接近,比如特征相似度越高,特征对应的编码词向量在向量空间上距离越接近。

其中,为了便于训练该BERT模型,还可以将输入BERT模型的样本数据中的一个或多个特征对应的一维词向量通过MASK符号代替,如下图所示,将某个特征对应的一维词向量通过MASK符号代替。获取该MASK符号在输入BERT模型的各个特征中所在位置,并进一步获取BERT模型输出的各个编码词向量中该MASK符号所在位置对应的编码词向量,根据该MASK符号所在位置对应的编码词向量预测输入该BERT模型的该MASK符号的特征,例如,可以通过将该MASK符号所在位置对应的编码词向量输入全连接层进行预测,获得输入该BERT模型的该MASK符号的特征,根据预测得到的特征和该MASK符号的实际特征,对BERT模型的各个模型参数进行调整。

203、获取该样本数据包括的动作信息对应的独热编码向量,并将该CLS符号对应的编码向量与该动作信息对应的独热编码向量进行向量拼接,获得拼接后的向量。

在获取得到动作对应的独热编码向量之后,可以将CLS符号所对应的编码向量与动作对应的独热编码向量进行向量拼接,获得拼接后的向量,以便于基于拼接向量对BERT模型进行训练。

在本申请中,为了使BERT模型学习到状态转移信息,针对样本数据中的状态,可以获取所采取动作对应的独热编码向量。以状态为糖尿病患者的随访数据作为举例,动作可以是医生所采取的开药方案,则可以进一步将医生所采取的开药方案对应的独热编码向量与CLS符号所对应的编码向量进行拼接。

204、将拼接后的向量输入全连接层进行预测,获得预测的下一次状态特征,根据该预测的下一次状态特征与实际的下一次状态特征,对BERT模型的各个模型参数进行调整。

仍以状态为糖尿病患者的随访数据为例,可以将拼接后的向量输入全连接层进行预测,获得预测得到的下一次随访的状态特征,并根据预测得到的下一次随访得到的状态特征与实际下一次随访的状态特征,对BERT模型的各个模型参数进行调整,以使得预测得到的下一次随访得到的状态特征与实际下一次随访的状态特征匹配度最高或高于阈值,从而实现对BERT模型的训练。

例如,在本申请中,可以将拼接后的向量输入全连接层,并根据全连接层输出的向量预测得到下一次随访的状态特征,根据预测得到的下一次随访得到的状态特征与实际下一次随访的状态特征之间的匹配度,对BERT模型的各个模型参数进行调整,使得预测得到的下一次随访得到的状态特征与实际下一次随访的状态特征之间的匹配度最大。

在这个场景中,state可以为人口统计学信息、检验检查指标、用药史组成的多维向量,action可以为独热编码,reward可以预先设置得到,比如由人为设置。例如,reward=-sign(最后一次随访是否出现并发症)*5+sign(下一次随访糖化血红蛋白是否达标)*1。

通过以上步骤201-204完成对BERT模型的预训练,下面可通过步骤205对DQN模型进行训练,并调整BERT模型。

205、将该CLS符号对应的编码向量输入DQN模型,对该DQN模型进行训练,并对该BERT模型的各个模型参数进行调整,得到训练后的目标BERT模型和目标DQN模型。

进一步的,还可以将CLS符号所对应的编码向量输入DQN模型,并利用DQN模型进行强化学习的迭代训练,从而微调BERT模型,拟合最优策略。

例如,如图3a所示,可利用BERT对患者的state进行预训练,输入患者的当前随访的state,如性别、糖化信息、BMI信息、血压信息、是否用过双胍、年龄信息等等token。其中,可MASK掉一部分token,然后利用MASK的位置对应的输出预测被MASK的token,利用CLS的输出预测下一个状态会出现的token,对BERT进行训练。然后,可以把BERT模型的CLS的输出连接到DQN模型的输入,利用DQN模型进行强化学习的迭代训练而微调BERT模型,同时拟合最优策略。可选的,该DQN可包括一个或多个全连接层。

又如,如图3b所示,可利用BERT对患者的state进行预训练,输入患者的当前随访的state,可MASK掉一部分token,然后利用MASK的位置对应的输出预测被MASK的token,利用CLS的输出预测下一个状态会出现的token,对BERT进行训练。在获取得到BRET输出结果如CLS符号对应的编码向量,以及获取得到动作对应的独热编码向量之后,可以将CLS符号所对应的编码向量与动作对应的独热编码向量进行向量拼接,将拼接后的向量输入全连接层进行预测,获得预测特征token,并根据预测特征与实际特征对BERT模型进行调整。此外,可以把BERT模型的CLS的输出连接到DQN模型的输入,利用DQN模型进行强化学习的迭代训练而微调BERT模型,同时拟合最优策略。

206、获取目标用户的当前状态信息。

207、将该当前状态信息输入该目标BERT模型进行编码处理,获得该目标BERT模型输出的CLS符号所对应的编码向量。

208、将CLS符号所对应的编码向量输入DQN模型,获得该当前状态信息对应的动作信息。其中,该动作信息可用于指示该当前状态下对该目标用户所采取的处理策略。

在对BERT模型和DQN模型训练结束后,使用该BERT模型和DQN模型确定在当前状态特征下应该采取的动作时,可以获取当前状态的各个特征对应的一维词向量,并将该各个特征对应的一维词向量输入BERT模型进行编码处理,获取BERT模型输出的CLS符号所对应的编码向量,该CLS符号所对应的编码向量作为输入该BERT模型的所有特征数据的语义表示。进而可将该CLS符号所对应的编码向量输入DQN模型,从而获得各种动作所对应的Q值,并将最大Q值所对应的动作确定为当前状态下应该采取的动作,例如,以给糖尿病患者进行开药作为举例,以最大Q值所对应的开药方案确定为给患者的开药方案。

209、根据该当前状态信息对应的动作信息,确定该目标用户所属的用户分群。

目前,存在许多需要对用户进行分群的场景,用户分群可以将用户按照一定的条件(属性)组成一个群,分群后可以针对用户群的用户进行多种分析、操作,比如可向同一用户群中的推送消息,或者可对条件最优的用户群的用户特性进行分析,或者可为同一用户群的用户提供相同的解决方案等等。如果仅将深度强化学习应用于患者分群,往往面临着患者状态表示过于简单的问题。分群结果可能不准确。为了给出更准确的分群结果,需要对状态进行更加准确、融入更多信息的表示。同时,由于患者分群结果需要和医生分群的结果保持一致性,尽量不要偏离医生分群的结果太远,以确保可靠性。本申请通过将BERT的预训练模型与强化学习方法结合用于患者分群的框架,BERT模型与深度强化学习方法发挥了各自的优势,将它们结合来进行患者分群可以得到更加准确、更加合理的分群结果,且额外对医生的分群习惯进行预训练。因某些强化学习模型忽略了对状态转移的建模,一定程度上丢失了状态转移信息,利用BERT模型进行预训练,可以纳入状态转移信息进行患者分群,提升准确性。

在本申请实施例中,在训练得到BERT+DQN模型之后,可通过输入目标用户的state的各个特征信息,输出最大Q值对应的决策,进行患者分群。也即,本申请可训练得到进行用户分群的BERT+DQN模型。比如可按照输出的动作信息,进行分群处理。其中,属于同一用户分群的用户所对应的动作信息相匹配。动作信息相匹配可以是指采用的动作/策略相同或相似,比如处于同一区间。例如,以开药对应分群方案,不同的开药即是不同的开药方案,专家开药即为专家的分群方案。

可选的,在完成用户分群比如针对目标群体用户完成分群之后,还可基于分群情况进行消息推送、用户特征分析等等。

例如,在一些实施例中,以糖尿病为例,确定出的动作信息可以为糖尿病的治疗方案。在基于动作信息划分得到用户群之后,数据处理设备还可针对划分得到的用户群为各用户群进行针对性消息推送,发送随访提醒等等,以便于管理和维护,增强用户体验,确保治疗效果。

在这个场景中,state可以为人口统计学信息、检验检查指标、用药史组成的多维向量,action可以为分群方案的独热编码,reward可预先设置得到。

本申请可以通过将BERT模型的输出向量与动作向量对应的独热编码向量进行拼接,从而通过全连接层预测下一次状态的特征,并与实际下一次状态的特征进行匹配,对BERT模型参数进行调整,从而让BERT模型可以学习到状态转移信息,也能让BERT模型的输出向量更准确的表示语句含义信息,最终实现将BERT模型的输出向量输入DQN模型进行训练时,可以得到更准确的Q值。本方案提出的BERT+DQN方法结合了深度强化学习技术和神经语言预训练技术,在学习患者随访更好的表示的同时寻找最优的患者分群决策,所学习到的患者随访表示包含了更多的潜在信息以及状态转移信息。同时,由于状态转移还由实际采取的action决定,该状态表示还包含了一定的专家决策(action)信息,所推荐的患者分群决策更加准确、合理、安全。

这种结合的框架将DRL用于患者分群时的预训练步骤融合进了BERT模型的预训练中,减少了DRL模型的无用探索。可以理解,这种框架不仅可以用于患者分群领域,还能应用于其他领域如离线强化学习领域。

可以理解,上述方法实施例都是对本申请的基于人工智能的数据处理方法的举例说明,对各个实施例的描述都各有侧重,某个实施例中没有详述的部分,可以参见其他实施例的相关描述。

本申请实施例还提供了一种数据处理装置。该装置可包括用于执行前述图1或者图2所述的方法的模块。请参见图4,是本申请实施例提供的一种数据处理装置的结构示意图。本实施例中所描述的数据处理装置,可配置于数据处理设备中,如图4所示,本实施例的数据处理装置400可以包括:获取模块401、训练模块402和处理模块403。其中,

获取模块401,用于获取样本数据;

训练模块402,用于利用BERT模型获取所述样本数据对应的状态转移信息,并根据所述状态转移信息对所述BERT模型进行训练,以及根据所述BERT模型的输出结果对与所述BERT模型连接的DQN模型进行训练,得到训练后的目标BERT模型和目标DQN模型;

获取模块401,还用于获取目标用户的当前状态信息;

处理模块403,用于将所述当前状态信息输入所述目标BERT模型进行编码处理,获得所述目标BERT模型输出的分类器标记CLS符号所对应的编码向量;

处理模块403,还用于将所述CLS符号所对应的编码向量输入所述目标DQN模型,获得所述当前状态信息对应的动作信息,所述动作信息用于指示所述当前状态下对所述目标用户所采取的处理策略。

在一种可能的实施方式中,所述样本数据包括状态信息和动作信息;所述训练模块402利用BERT模型获取所述样本数据对应的状态转移信息,并根据所述状态转移信息对所述BERT模型进行训练,以及根据所述BERT模型的输出结果对与所述BERT模型连接的DQN模型进行训练,得到训练后的目标BERT模型和目标DQN模型,包括:

将所述样本数据包括的状态信息输入BERT模型进行编码处理,获得CLS符号对应的编码向量;

获取所述样本数据包括的动作信息对应的独热编码向量;

将所述CLS符号对应的编码向量与所述动作信息对应的独热编码向量进行向量拼接,获得拼接后的向量;

根据拼接后的向量确定所述样本数据对应的状态转移信息,并根据所述状态转移信息对所述BERT模型的各个模型参数进行调整;

将所述CLS符号对应的编码向量输入DQN模型,对所述DQN模型进行训练,并对所述BERT模型的各个模型参数进行调整,得到训练后的目标BERT模型和目标DQN模型。

在一种可能的实施方式中,所述训练模块402根据拼接后的向量确定所述样本数据对应的状态转移信息,并根据所述状态转移信息对所述BERT模型的各个模型参数进行调整,包括:

将拼接后的向量输入全连接层进行预测,获得预测的下一次状态特征;

根据所述预测的下一次状态特征与实际的下一次状态特征,对BERT模型的各个模型参数进行调整。

在一种可能的实施方式中,所述样本数据包括状态信息,所述状态信息包括多个特征;

训练模块402,还用于通过MASK符号代替所述状态信息中的一个或多个特征对应的一维词向量;获取所述MASK符号在输入所述BERT模型的各个特征中所在位置,并获取所述BERT模型输出的各个编码词向量中所述MASK符号所在位置对应的编码词向量;根据所述MASK符号所在位置对应的编码词向量预测输入所述BERT模型的所述MASK符号的特征,得到所述MASK符号的预测特征;根据所述预测特征和所述MASK符号的实际特征,对所述BERT模型的各个模型参数进行调整。

在一种可能的实施方式中,所述训练模块402根据所述MASK符号所在位置对应的编码词向量预测输入所述BERT模型的所述MASK符号的特征,包括:

将所述MASK符号所在位置对应的编码词向量输入全连接层进行预测,获得输入所述BERT模型的所述MASK符号的特征。

在一种可能的实施方式中,所述获取模块401获取样本数据,包括:

获取多个用户的特征数据,所述特征数据包括连续特征数据;

对所述连续特征数据进行离散化处理,获得离散化特征数据,并将所述离散化特征数据作为样本数据。

在一种可能的实施方式中,处理模块403,还用于根据所述当前状态信息对应的动作信息,确定所述目标用户所属的用户分群;

其中,属于同一用户分群的用户所对应的动作信息相匹配。

可以理解的是,本实施例的数据处理装置的各功能模块可根据上述方法实施例图1或者图2中的方法具体实现,其具体实现过程可以参照上述方法实施例图1或者图2的相关描述,此处不再赘述。

请参见图5,图5是本申请实施例提供的一种数据处理设备的结构示意图。如图5所示,该数据处理设备可包括:处理器501和存储器502。该处理器501和存储器502可相互连接。可选的,该数据处理设备还可包括通信接口503。上述处理器501、存储器502和通信接口503可通过总线或其他方式连接,本申请不做限定。其中,存储器502可用于存储程序指令,处理器501可用于调用所述程序指令执行上述实施例的部分或全部步骤,如执行上述实施例中数据处理设备执行的部分或全部步骤。通信接口503可受所述处理器的控制用于收发消息。例如,存储器502可用于存储计算机程序,所述计算机程序包括程序指令,处理器501用于执行存储器502存储的程序指令。其中,处理器501被配置用于调用所述程序指令,执行以下步骤:

获取样本数据;

利用BERT模型获取所述样本数据对应的状态转移信息,并根据所述状态转移信息对所述BERT模型进行训练,以及根据所述BERT模型的输出结果对与所述BERT模型连接的DQN模型进行训练,得到训练后的目标BERT模型和目标DQN模型;

获取目标用户的当前状态信息;

将所述当前状态信息输入所述目标BERT模型进行编码处理,获得所述目标BERT模型输出的分类器标记CLS符号所对应的编码向量;

将所述CLS符号所对应的编码向量输入所述目标DQN模型,获得所述当前状态信息对应的动作信息,所述动作信息用于指示所述当前状态下对所述目标用户所采取的处理策略。

在一种可能的实施方式中,所述样本数据包括状态信息和动作信息;执行所述利用BERT模型获取所述样本数据对应的状态转移信息,并根据所述状态转移信息对所述BERT模型进行训练,以及根据所述BERT模型的输出结果对与所述BERT模型连接的DQN模型进行训练,得到训练后的目标BERT模型和目标DQN模型,包括:

将所述样本数据包括的状态信息输入BERT模型进行编码处理,获得CLS符号对应的编码向量;

获取所述样本数据包括的动作信息对应的独热编码向量;

将所述CLS符号对应的编码向量与所述动作信息对应的独热编码向量进行向量拼接,获得拼接后的向量;

根据拼接后的向量确定所述样本数据对应的状态转移信息,并根据所述状态转移信息对所述BERT模型的各个模型参数进行调整;

将所述CLS符号对应的编码向量输入DQN模型,对所述DQN模型进行训练,并对所述BERT模型的各个模型参数进行调整,得到训练后的目标BERT模型和目标DQN模型。

在一种可能的实施方式中,执行所述根据拼接后的向量确定所述样本数据对应的状态转移信息,并根据所述状态转移信息对所述BERT模型的各个模型参数进行调整,包括:

将拼接后的向量输入全连接层进行预测,获得预测的下一次状态特征;

根据所述预测的下一次状态特征与实际的下一次状态特征,对BERT模型的各个模型参数进行调整。

在一种可能的实施方式中,所述样本数据包括状态信息,所述状态信息包括多个特征;所述处理器501还用于执行:

通过MASK符号代替所述状态信息中的一个或多个特征对应的一维词向量;

获取所述MASK符号在输入所述BERT模型的各个特征中所在位置,并获取所述BERT模型输出的各个编码词向量中所述MASK符号所在位置对应的编码词向量;

根据所述MASK符号所在位置对应的编码词向量预测输入所述BERT模型的所述MASK符号的特征,得到所述MASK符号的预测特征;

根据所述预测特征和所述MASK符号的实际特征,对所述BERT模型的各个模型参数进行调整。

在一种可能的实施方式中,执行所述根据所述MASK符号所在位置对应的编码词向量预测输入所述BERT模型的所述MASK符号的特征,包括:

将所述MASK符号所在位置对应的编码词向量输入全连接层进行预测,获得输入所述BERT模型的所述MASK符号的特征。

在一种可能的实施方式中,执行所述获取样本数据,包括:

获取多个用户的特征数据,所述特征数据包括连续特征数据;

对所述连续特征数据进行离散化处理,获得离散化特征数据,并将所述离散化特征数据作为样本数据。

在一种可能的实施方式中,所述获得所述当前状态信息对应的动作信息之后,所述处理器501还用于执行:

根据所述当前状态信息对应的动作信息,确定所述目标用户所属的用户分群;

其中,属于同一用户分群的用户所对应的动作信息相匹配。

应当理解,在本申请实施例中,所称处理器501可以是中央处理单元(CentralProcessing Unit,CPU),该处理器501还可以是其他通用处理器、数字信号处理器(DigitalSignal Processor,DSP)、专用集成电路(Application Specific Integrated Circuit,ASIC)、现成可编程门阵列(Field-Programmable Gate Array,FPGA)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件等。通用处理器可以是微处理器或者该处理器也可以是任何常规的处理器等。

该存储器502可以包括只读存储器和随机存取存储器,并向处理器501提供指令和数据。存储器502的一部分还可以包括非易失性随机存取存储器。例如,存储器502还可以存储目标传染病的疫情数据。

该通信接口503可以包括输入设备和/或输出设备,例如该输入设备是可以是控制面板、麦克风、接收器等,输出设备可以是显示屏、发送器等,此处不一一列举。

具体实现中,本申请实施例中所描述的处理器501和存储器502(还可包括通信接口503)可执行本申请实施例提供的图1或者图2所述的方法实施例所描述的实现方式,也可执行本申请实施例所描述的数据处理装置的实现方式,在此不再赘述。

本申请实施例中还提供一种计算机可读存储介质,所述计算机可读存储介质存储有计算机程序,所述计算机程序包括程序指令,所述程序指令被处理器执行时,可执行上述数据处理方法实施例中所执行的部分或全部步骤,如数据处理设备执行的部分或全部步骤。

可选的,本申请涉及的存储介质如计算机可读存储介质可以是非易失性的,也可以是易失性的,本申请不做限定。

本申请实施例还提供一种计算机程序产品,所述计算机程序产品包括计算机程序代码,当所述计算机程序代码在计算机上运行时,使得计算机执行上述数据处理装置方法实施例中所执行的步骤。

在一些实施例中,所述的计算机可读存储介质可主要包括存储程序区和存储数据区,其中,存储程序区可存储操作系统、至少一个功能所需的应用程序等;存储数据区可存储根据区块链节点的使用所创建的数据如样本数据、动作信息、策略等。

其中,本申请所指区块链是分布式数据存储、点对点传输、共识机制、加密算法等计算机技术的新型应用模式。区块链(Blockchain),本质上是一个去中心化的数据库,是一串使用密码学方法相关联产生的数据块,每一个数据块中包含了一批次网络交易的信息,用于验证其信息的有效性(防伪)和生成下一个区块。区块链可以包括区块链底层平台、平台产品服务层以及应用服务层等。

本领域普通技术人员可以理解实现上述实施例方法中的全部或部分流程,是可以通过计算机程序来指令相关的硬件来完成,所述的程序可存储于一计算机可读取存储介质中,该程序在执行时,可包括如上述各方法的实施例的流程。其中,所述的存储介质可为磁碟、光盘、只读存储记忆体(Read-Only Memory,ROM)或随机存储记忆体(Random AccessMemory,RAM)等。

以上所揭露的仅为本申请一种较佳实施例而已,当然不能以此来限定本申请之权利范围,本领域普通技术人员可以理解实现上述实施例的全部或部分流程,并依本申请权利要求所作的等同变化,仍属于发明所涵盖的范围。

- 基于人工智能的数据处理方法、装置、设备及存储介质

- 基于人工智能的数据处理方法、装置、计算机设备及介质