显示系统、电子设备、移动体和显示方法

文献发布时间:2023-06-19 11:52:33

技术领域

本发明涉及显示系统、电子设备、移动体和显示方法等。

背景技术

已知通过在透明屏幕等上显示图像,在用户的视野中重叠显示信息的平视显示器(headup display)。通过组合这样的平视显示器和AR技术,可以在平视显示器上显示虚拟对象,使得虚拟对象跟随前方车辆或道路等实际对象。AR是Augmented Reality(增强现实)的缩写。

在专利文献1所公开的技术中,通过图像处理来校正低频带的姿势变化,通过投射光学单元来校正高频带的姿势变化。通过用投射光学单元校正高频带的姿势变化,在产生车辆的姿势变化的情况下,校正投射图像的位置,使得虚像相对于实像重叠在正确的位置。

在专利文献2所公开的技术中,畸变校正部使用从一定时间前到当前时刻的期间从陀螺仪传感器输出的姿势信号和预测器,预测运算后级的显示偏离校正部校正图像的显示位置时的校正量。然后,畸变校正部重新使显示位置与位于偏离了预测的校正量的位置的显示区域对应,进行图像的畸变校正,显示偏离校正部校正畸变校正后的图像的显示位置。通过由显示偏离校正部校正显示位置,当车辆的姿势改变时,校正投射图像的位置,使得虚像相对于实像被重叠在正确的位置。

专利文献1:日本特开2019-98756号公报

专利文献2:日本特开2019-179214号公报

在使用AR技术的平视显示器中,获取传感器输出,使用传感器输出渲染(rendering)虚拟对象,对渲染图像进行扭曲(warp)处理,并且在平视显示器上显示扭曲处理之后的图像。在这样的显示系统中,由于从用于渲染的传感器输出的采样时刻开始到显示在平视显示器上为止存在时间,所以在该期间产生的车辆等的运动没有反映在虚拟对象的显示位置上。因此,在渲染的虚拟对象和显示时的实际对象之间出现位置偏离,存在希望尽可能地减小由于这样的延迟导致的位置偏离的课题。

发明内容

本公开的一个方式涉及一种平视显示器的显示系统,所述平视显示器在显示区域中显示与实际空间中的实际对象相对应的虚拟对象,所述显示系统包括:渲染图像生成部,其生成包含所述虚拟对象的渲染图像;参数运算部,其根据追踪信息运算出延迟补偿参数,所述延迟补偿参数用于补偿包括所述渲染图像的渲染处理延迟在内的延迟,所述追踪信息是搭载有所述平视显示器的移动体的第1追踪信息、所述平视显示器的观看者的第2追踪信息和所述实际对象的第3追踪信息中的至少一个;以及扭曲处理部,其进行根据所述显示区域的弯曲对所述渲染图像进行坐标变换的扭曲处理,生成在所述显示区域中显示的显示图像,所述扭曲处理部在所述扭曲处理中进行根据所述延迟补偿参数对所述显示区域中的所述虚拟对象的位置进行补偿的延迟补偿处理

另外,本公开的另一方式涉及包括上述显示系统的电子设备。

另外,本公开的又一方式涉及包括上述显示系统的移动体。

另外,本公开的其他另一方式提供一种平视显示器的显示方法,所述平视显示器在显示区域中显示与实际空间中的实际对象相对应的虚拟对象,所述显示方法包括:生成包含所述虚拟对象的渲染图像;根据追踪信息运算出延迟补偿参数,所述延迟补偿参数用于补偿包括所述渲染图像的渲染处理延迟在内的延迟,所述追踪信息是搭载有所述平视显示器的移动体的第1追踪信息、所述平视显示器的观看者的第2追踪信息和所述实际对象的第3追踪信息中的至少一个;以及进行根据所述显示区域的弯曲对所述渲染图像进行坐标变换的扭曲处理,生成在所述显示区域中显示的显示图像,在所述扭曲处理中,进行根据所述延迟补偿参数对所述显示区域中的所述虚拟对象的位置进行补偿的延迟补偿处理。

附图说明

图1是基于HUD的AR显示的例子。

图2是由俯仰位移或垂直位移引起的显示位置偏离的说明图。

图3是说明本实施方式的延迟补偿的图。

图4是现有技术中的显示系统的结构例。

图5是现有技术中的显示系统的处理流程。

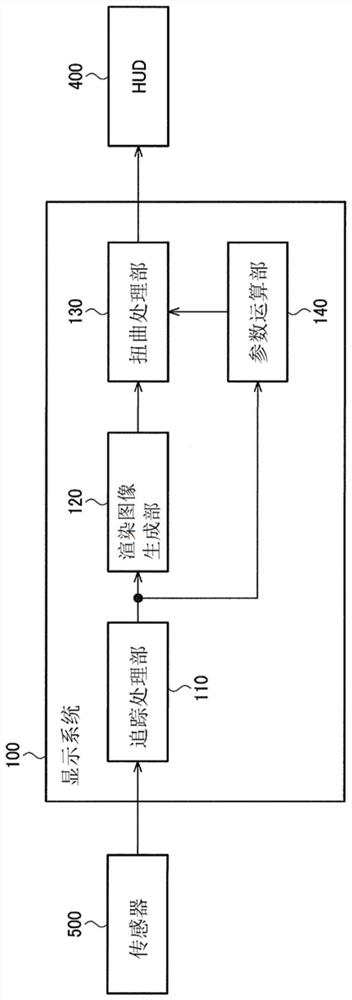

图6是本实施方式中的显示系统的结构例。

图7是追踪处理部的详细处理流程。

图8是显示系统的处理流程。

图9是显示系统的第1详细结构例。

图10是显示系统的第2详细结构例。

图11是第2详细结构例中的显示系统的处理流程。

图12是本实施方式的扭曲处理的说明图。

图13是表示移动体等的追踪信息与基于该追踪信息的延迟补偿的对应的图。

图14是实现补偿方法的延迟补偿参数的例子。

图15是说明根据追踪信息运算出延迟补偿参数的方法的图。

图16是电子设备的结构例。

图17是移动体的例子。

标号说明

10:前方车辆;11、12:实际对象;20、21:虚拟对象;30:汽车;32:移动体;34:屏幕;35:挡风玻璃;36:投射单元;40:显示区域;50:眼睛;52:观看者;100:显示系统;110:追踪处理部;111:视觉惯性测程处理;112:惯性测程处理;113:预测处理;120:渲染图像生成部;130:扭曲处理部;140:参数运算部;145:存储部;150:处理装置;151:接口;160:HUD控制器;161:接口;206:汽车;270:处理装置;300:电子设备;350:存储装置;360:操作装置;370:通信装置;400:平视显示器;410:显示器;500:传感器;510:渲染用传感器;520:延迟补偿用传感器。

具体实施方式

在下文中,将详细说明本公开的优选实施方式。另外,以下说明的本实施方式并不是对权利要求书所记载的内容进行不当限定,在本实施方式中说明的结构未必全部是必须构成要件。

1.显示系统

图1是基于HUD的AR显示的例子。HUD是平视显示器的缩写,AR是增强现实的缩写。以下,主要说明在汽车30上搭载HUD的例子,但本实施方式的HUD也可以搭载在飞机、船舶或两轮车等各种移动体上。

图1表示驾驶员通过HUD观看的AR显示。驾驶员通过挡风玻璃观察前方车辆10、前方车辆10行驶的道路以及它们周围的风景。另外,驾驶员看到HUD投射到挡风玻璃的显示区域40内的虚像,该虚像被驾驶员看作为与实际空间重叠的虚拟对象20。显示区域40表示HUD能够投射虚像的范围,在该显示区域40内显示虚拟对象20。图1中的虚拟对象20是AR的显示对象,被显示成其显示位置追随前方车辆10或道路。即,HUD以从驾驶员看到的前方车辆10或道路与虚拟对象20的相对位置关系不变的方式显示虚拟对象20。

HUD的显示系统使用Lidar等传感器追踪前方车辆10等,根据该追踪结果渲染虚拟对象20,对该渲染图像进行扭曲处理后使HUD进行显示。此时,在从传感器采样的定时到将虚拟对象20显示在HUD上的定时之间,存在追踪处理、渲染处理、扭曲处理或者数据通信等引起的迟延。由这样的处理或通信等产生的迟延称为延迟(latency)。

延迟成为虚拟对象20与前方车辆10等的位置偏离的原因。即,由于显示系统渲染虚拟对象20时的前方车辆10等的位置与虚拟对象20实际显示在HUD上时的前方车辆10等的位置发生偏离,所以虚拟对象20与前方车辆10等偏离地显示。例如,在渲染处理中,即使预测了未来的显示定时的前方车辆10等的位置,也由于从该预测时刻到显示为止存在时间,而预测的前方车辆10等的位置和虚拟对象20实际显示在HUD上时的前方车辆10等的位置可能偏离。

在图2中,作为一例,表示由俯仰位移或垂直位移引起的显示位置偏离的说明图。xyz是固定于汽车30的坐标系。z方向是汽车的行进方向,x方向和y方向与z方向正交且相互正交。当y方向与垂直方向一致时,x方向为水平方向,y方向为垂直方向或上下方向。在成为y方向与铅垂方向不一致的汽车的姿势时,x方向和y方向与水平垂直不一致,但以下为了方便将x方向也称为水平方向,将y方向也称为垂直方向或上下方向。将图中所示的箭头方向作为正方向,在要明示方向的正负的情况下记载为+x方向、-x方向等。

图2的第1段的图示出虚拟对象21和实际对象11之间没有位置偏离的状态。实际对象11是存在于实际空间中并且作为AR显示的追踪目标的对象。例如,图1的前方车辆10等是实际对象。HUD的投射单元36将虚像投射到挡风玻璃35上,该虚像作为虚拟对象21被驾驶员的眼睛50看到。

图2的第2段的图示出了当挡风玻璃35和投射单元36在+y方向上偏移WSM时的虚拟对象21和实际对象11之间的位置偏离。垂直偏移WSM是由于汽车30的俯仰旋转或垂直偏移而产生的。俯仰旋转是以与x方向平行的轴为中心的旋转,垂直偏移是y方向上的平行移动。当HUD的显示系统对虚拟对象21进行渲染时,假设了第1段的图的状态,但由于到在HUD上显示为止存在时间,所以如果在该时间内产生垂直偏移WSM,则该垂直偏移WSM不反映在渲染图像中。因此,由于挡风玻璃35等的垂直偏移WSM,虚拟对象21的显示位置向+y方向偏移,虚拟对象21看起来相对于实际对象11向+y方向偏离。例如,在汽车30由于道路的凹凸而重复进行俯仰运动的情况下,虚拟对象21看起来相对于实际对象11上下摇动而偏离。

图2的第3段的图示出了当驾驶员的眼睛50向+y方向偏移DEM时的虚拟对象21和实际对象11之间的位置偏离。尽管挡风玻璃35不移动,但是眼睛50相对于挡风玻璃35向+y方向偏移,因此虚拟对象21的显示位置向-y方向偏移。因此,虚拟对象21看起来相对于实际对象11向-y方向偏离。

图2的第4段的图示出当实际对象11向-y方向偏移RJM时的虚拟对象21和实际对象11之间的位置偏离。由于挡风玻璃35和眼睛50不移动,所以虚拟对象21的显示位置不偏移,但是由于实际对象11向-y方向偏移,所以虚拟对象21看起来相对于实际对象11向+y方向偏离。

图3是说明本实施方式的延迟补偿的图。图3示出了驾驶员看到的实际对象11和虚拟对象21。在图3的左图中,从驾驶员的角度观察是实际对象11和虚拟对象21的显示位置相互一致的状态。如图3的中图所示,当驾驶员将头向左上移动的情况下,实际对象11向左上移动MV。由于虚拟对象21的显示位置不变,因此实际对象11和虚拟对象21偏离MV。如图3中的右图所示,在本实施例中,通过补偿由于延迟导致的偏移量MV,使实际对象11和虚拟对象21的显示位置一致。通过进行这种延迟补偿,当驾驶员将头部向左上移动时,从左图转移到右图的状态,可以避免中图那样的位置偏离状态。在本实施方式中,通过在尽可能接近显示定时的扭曲处理中进行延迟补偿,来尽可能减小由延迟引起的位置偏离。

为了考虑在HUD的显示系统中存在怎样的延迟,说明现有技术中的典型的显示系统和在该显示系统中发生的延迟。

图4是现有技术中的显示系统90的结构例。显示系统90包括传感器65、处理装置60、HUD控制器70和HUD 80。

传感器65是检测汽车、驾驶员或实际对象的位置、姿势或运动的传感器。

处理装置270包括传感器接口61、追踪处理部62和渲染图像生成部63。传感器接口61是接收传感器65的输出信号的接口电路。追踪处理部62包括CPU,并且基于传感器65的输出信号追踪汽车、驾驶员或实际对象的位置、姿势或运动。渲染图像生成部63包括GPU,并且基于汽车、驾驶员或实际对象的追踪信息渲染虚拟对象,使得虚拟对象跟随实际对象。HUD控制器70包括对渲染图像进行扭曲处理的扭曲处理部71。HUD 80包括显示扭曲处理后的图像的显示器81。显示器81是液晶显示装置等显示装置。当显示在显示器81上的图像被光学系统投射到挡风玻璃上时,渲染图像的虚拟对象被显示。

图5表示显示系统90的处理流程。这里,示出使用IMU和照相机作为传感器65的例子。IMU以与照相机的帧速率相比足够快的采样速率进行感测。tck、tck+1、tck+2表示照相机的曝光定时。即,由照相机获得的图像表示在定时tck等的实际对象的位置。图像信号处理是在照相机的曝光结束后进行的处理,包含读出来自图像传感器的信号和显影处理等。

追踪处理部62通过视觉惯性测程从图像信号处理后的图像追踪实际对象的位置。在这个阶段,检测到照相机的曝光定时tck的实际对象的位置。追踪处理部62根据视觉惯性测程结束后的定时tod的IMU的输出信号和视觉惯性测程的结果,利用惯性测程追踪实际对象的位置。通过该处理,补偿照相机的曝光定时tck到惯性测程的定时tod的延迟,检测出定时tod的实际对象的位置。

渲染图像生成部63在与通过惯性测程检测到的实际对象相对应的位置处渲染虚拟对象,并且将该渲染图像输出到扭曲处理部71。此时,产生从构成渲染图像生成部63的GPU向HUD控制器70的数据通信时间。扭曲处理部71进行对渲染图像的扭曲处理,扭曲处理后的图像被显示在HUD 80上。第1行~最终行是显示器81的水平扫描线,逐行扫描。因此,在1帧的图像显示中,需要对第1行~最终行进行扫描的时间,但在此将进行第1行的显示的定时作为代表而设为显示定时tdp。

显示在HUD 80上的虚拟对象对应于定时tod的实际对象的位置。因此,存在从定时tod到显示定时tdp为止的延迟,实际对象和虚拟对象之间可能由于该期间中的汽车、驾驶员或实际对象的运动而发生偏离。

如上所述,存在如下问题:由于显示使用在显示定时tdp之前检测到的追踪信息渲染的虚拟对象,因从检测到追踪信息的定时到显示定时tdp为止的延迟而产生显示位置偏离。

在上述专利文献1中,使姿势数据的测量时间比图像数据等的通信时间短,投射光学单元使用该姿势数据进行高频带下的校正,由此抑制因通信时间引起的实像和投射图像的位置偏离。但是,由于需要用于控制投射光学单元的数据处理时间以及构成部件的动作时间,所以由该时间产生的位置偏离依然存在。

另外,在上述的专利文献2中,作为紧跟在显示之前进行显示偏离校正的结构,示出了在畸变校正的后级进行显示偏离校正的结构。在该结构中,在畸变校正阶段,根据预测的校正量变更畸变校正的对应关系。在后级校正了位置偏离后,为了再现正确的畸变校正,向与该校正相反的方向偏移畸变校正。因此,在畸变校正中预测的校正量和在后级的显示偏离校正中使用的校正量不同的情况下,显示偏离校正后的畸变图像不能成为正确的畸变校正图像。

图6是本实施方式中的显示系统100的结构例。显示系统100根据传感器500的输出信号,使与实际对象对应的虚拟对象显示在HUD 400上。显示系统100包括追踪处理部110、渲染图像生成部120、扭曲处理部130和参数运算部140。另外,显示系统100不限于图6的结构,例如也可以是追踪处理部110设置在显示系统100的外部,或者也可以是传感器500和HUD 400包含在显示系统100中的结构。稍后将描述显示系统100的硬件结构例。

传感器500是检测移动体、观看者或实际对象的位置、姿势或运动的传感器。传感器500设置于移动体,例如包括Lidar、IMU、照相机、眼睛追踪传感器或头部追踪传感器等。Lidar是Light Detection and Ranging(光检测和测程)的缩写,是用于获取诸如z-map之类的三维信息的传感器。IMU是Inertial Measurement Unit(惯性测量单元)的简称,是检测一个轴或多个轴的运动的传感器。IMU例如由加速度传感器、陀螺仪传感器或它们的组合构成。照相机是拍摄作为二维信息的图像的传感器。眼睛追踪传感器是检测观看者的眼睛的位置、视线方向或这两者的传感器。头部追踪传感器是检测观看者的头部的位置、姿势或这两者的传感器。

移动体是载有HUD 400、观看者以及传感器500在实际空间内移动的物体,例如是汽车、二轮车、飞机或者船舶等。观看者是观看投射到HUD 400的虚像的用户,是移动体的操纵者或搭乘者。实际对象是存在于实际空间中的物体。实际对象只要是在移动体、观看者或实际对象的位置或姿势发生变动时,从观看者看到的HUD显示区域内的实际对象的位置或姿势发生变动的物体即可。

追踪处理部110基于传感器500的输出信号追踪移动体、观看者或实际对象的位置、姿势或运动,并且输出其结果作为追踪信息。例如,追踪处理部110基于来自Lidar的二维测程信息或来自照相机的二维图像来追踪实际对象。另外,追踪处理部110根据来自IMU的加速度或角速度的信息,追踪汽车。另外,追踪处理部110根据来自眼睛追踪传感器的眼睛的位置或视线方向的信息,追踪驾驶员的眼睛。

追踪信息只要是表示移动体、观看者或实际对象的位置、姿势或运动的信息即可,可以是任何形式的信息。例如,追踪信息是表示实际空间中的位置的坐标、表示姿势的角度、表示平行移动的矢量或者表示旋转的角速度等。或者,追踪信息也可以是将上述实际空间中的坐标等换算成图像上的坐标、角度、矢量或角速度等而得的信息。追踪信息包括移动体的第1追踪信息、观看者的第2追踪信息和实际对象的第3追踪信息。但是,追踪信息只要包含第1~第3追踪信息中的至少一个即可,例如也可以省略观看者的第2追踪信息。

渲染图像生成部120基于移动体、观看者或者实际对象的追踪信息渲染虚拟对象,并且输出包括虚拟对象的渲染图像。具体地,渲染图像生成部120求出在HUD 400的显示区域中能够看到实际对象的位置,在与该实际对象的位置相对应的位置处渲染虚拟对象。

参数运算部140根据追踪信息求出延迟补偿参数,根据延迟补偿参数校正扭曲处理中使用的扭曲参数,输出校正后扭曲参数。这里使用的追踪信息是在用于渲染处理的追踪信息之后采样的信息。从使延迟为最小限度的观点出发,希望使用紧跟在参数运算之前或尽量接近参数运算的定时取得的追踪信息。

延迟补偿参数是对渲染图像中的虚拟对象的位置和显示定时的虚拟对象的位置之差进行补偿的参数。延迟补偿参数表示图像数据上的偏移量或旋转角度。更具体地说,延迟补偿参数表示扭曲处理前的没有变形的图像的偏移量或旋转角度。

扭曲参数是扭曲处理中的坐标变换的参数,是使扭曲处理中的输入图像的坐标和输出图像的坐标对应起来的参数。扭曲参数例如是表示输入图像与输出图像之间的坐标变换的矩阵或表。

扭曲处理部130对渲染图像进行扭曲处理,使得渲染图像在投射到弯曲的屏幕上时成为没有变形的图像。具体而言,扭曲处理部130通过使用参数运算部140输出的校正后扭曲参数对渲染图像进行坐标变换,生成显示图像。该坐标变换是消除由屏幕的弯曲引起的图像畸变的坐标变换。显示图像是显示在HUD 400的显示面板上的图像,通过投射单元将显示在该显示面板上的显示图像投射到屏幕上,从而显示为没有畸变的虚像。

HUD 400包括用于将虚像投射到屏幕上的投射单元。投射单元包括:显示面板,其对显示图像进行显示;以及光学系统,其将显示面板上显示的显示图像作为虚像投射到屏幕上。屏幕是移动体的窗玻璃等。或者,HUD 400也可以包含专用的屏幕,向该屏幕投射虚像。

图7表示追踪处理部110的详细处理流程,图8表示显示系统100的处理流程。此外,图7所示的追踪处理是示例,追踪实际对象等的方法不限于此。另外,用于追踪处理的传感器也可以根据采用的方法来选择。

图8所示的传感器的动作如图5中说明的那样。追踪处理部110根据在定时tck照相机拍摄的图像IMG(tck)和在定时tck由IMU采样的移动体的运动信息MTI(tck),进行视觉惯性测程处理111,估计时刻tck的实际对象和移动体的位置以及姿势Pr(tck)。

追踪处理部110根据位置和姿势Pr(tck)和在定时tnow1由IMU采样的移动体的动作信息MTI(tnow1),进行惯性测程处理112,估计定时tnow1的实际对象和移动体的位置和姿势Pc(tck,tnow1)。“tnow1”处于“tck”之后并且在惯性测程处理112开始之前。更优选地,tnow1处于视觉惯性测程处理111结束之后且惯性测程处理112开始之前。

追踪处理部110基于位置和姿势Pc(tck,tnow1)执行预测处理113,预测tnow1之后的定时tfuture的实际对象和移动体的位置和姿势Pp(tck,tnow1,tfuture)。在图8中,示出设tfuture=tdp、预测位置和姿势Pp(tck,tnow1,tdp)的例子。tdp是HUD的显示定时。例如,预测处理113基于按时间顺序获得的位置和姿势Pc的微分值来预测未来位置和姿势Pp。

渲染图像生成部120基于位置和姿势Pp(tck,tnow1,tdp)渲染虚拟对象,并且输出渲染图像。如果将该渲染图像直接显示于HUD 400,则与位置以及姿势Pp所示的实际对象的位置对应地显示虚拟对象。

这里,预测的位置和姿势Pp(tck,tnow1,tdp)是使用tck、tnow1的信息预测出的,不是基于tdp的实际的传感器输出的位置。即,当在tnow1和tdp之间产生的实际的运动与由预测处理113预测的运动不同时,在虚拟对象和实际对象之间可能产生由延迟引起的位置偏离。即,在图8的例子中成为补偿对象的延迟是基于tnow1和tdp之间的处理时间的延迟。另外,成为补偿对象的延迟不限于此。例如,当省略惯性测程和预测处理并且使用Pr(tck)执行渲染处理时,由tck和tdp之间的处理时间的引起的延迟成为补偿对象。

在本实施方式中,如下那样对上述延迟引起的位置偏离进行补偿。追踪处理部110根据在定时tck+1由照相机拍摄的图像IMG(tck+1)和在定时tck+1由IMU采样的移动体的运动信息MTI(tck+1)进行视觉惯性测程处理111,估计定时tck+1的实际对象和移动体的位置和姿势Pr(tck+1)。tck+1是tck的下一个照相机曝光定时。

追踪处理部110根据位置和姿势Pr(tck+1)和在时刻tnow2由IMU采样的移动体的动作信息MTI(tnow2)进行惯性测程处理112,估计时刻tnow2的实际对象和移动体的位置和姿势Pc(tck+1,tnow2)。

追踪处理部110基于位置和姿势Pc(tck+1,tnow2)执行预测处理113,预测tdp的实际对象和移动体的位置和姿势Pp(tck+1,tnow2,tdp)。

参数运算部140根据位置和姿势Pp(tck,tnow1,tdp)以及位置和姿势Pp(tck+1,tnow2,tdp)求出延迟补偿参数。具体地,参数运算部140运算出延迟补偿参数,以消除由于位置和姿势Pp(tck,tnow1,tdp)与位置和姿势Pp(tck+1,tnow2,tdp)之差引起的虚拟对象的位置偏离。参数运算部140使用延迟补偿参数来校正扭曲参数,并输出校正后扭曲参数。

扭曲处理部130使用校正后扭曲参数对渲染图像进行扭曲处理,生成显示图像。扭曲处理部130根据HUD 400的显示面板中的从第1行到最终行的扫描定时,依次进行从第1行到最终行的扭曲处理,将该扭曲处理后的各行的数据按照扫描定时依次输出到HUD 400。在图8中,将第1行的显示定时设为tdp,但tdp也可以是从第1行到显示最终行的帧期间中的任意定时。

根据以上的本实施方式,在扭曲处理中,扭曲处理部130进行基于延迟补偿参数对显示区域中的虚拟对象的位置进行补偿的延迟补偿处理。

通过这种方式,基于延迟补偿参数来对由于tnow1和tdp之间的渲染处理等的延迟而产生的虚拟对象的位置偏离进行补偿。通过在紧接在显示之前执行的扭曲处理中执行延迟补偿,可以使残余的延迟最小化,从而实现虚拟对象对实际对象的跟随性高的AR显示。另外,在本实施方式中,不使用专利文献1那样的光学补偿机构,而是通过图像数据处理进行延迟补偿,因此能够不变更投射单元等的结构地实现延迟补偿。另外,不是如专利文献2那样在畸变校正后进行显示偏离校正,在本实施方式中,由于在扭曲处理中作为一体地进行延迟补偿,所以能够实现准确的畸变校正和延迟补偿。

此外,在本实施方式中,渲染图像生成部120基于第1定时处的追踪信息生成渲染图像。参数运算部140根据处于第1定时之后且图像的显示定时tdp之前的第2定时处的追踪信息和第1定时处的追踪信息,运算出延迟补偿参数。在图8的例子中,tnow1相当于第1定时,tnow2相当于第2定时。

这样,由于第1定时和显示定时之间的延迟被缩短为第2定时和显示定时之间的延迟,所以可削减由延迟引起的位置偏离。使用图8的例子进行说明,在对扭曲参数进行校正的延迟补偿参数中反映了在tnow1之后的tnow2由IMU采样的运动信息。通过利用该延迟补偿参数校正虚拟对象的显示位置,tnow1和tdp之间的延迟被缩短到tnow2和tdp之间的延迟。由于扭曲处理是紧跟在HUD显示之前进行的处理,所以tnow2是接近tdp的定时,能够尽可能减小延迟,减小由延迟引起的虚拟对象的显示位置偏离。

另外,在本实施方式中,参数运算部140根据延迟补偿参数来校正与显示区域的弯曲对应的坐标变换的扭曲参数,从而输出校正后扭曲参数。扭曲处理部130通过使用校正后扭曲参数进行扭曲处理,从而进行延迟补偿处理。

这样,通过使用基于延迟补偿参数的校正后扭曲参数进行扭曲处理,能够在扭曲处理中进行延迟补偿。例如,也可以考虑与扭曲处理分开地进行延迟补偿的图像处理的结构,但处理负荷相应地增加了延迟补偿的图像处理的量,并且由于在延迟补偿后进行扭曲处理,因此会残留扭曲处理的延迟。在本实施方式中,通过使延迟补偿和扭曲处理成为一体,能够抑制处理负荷的增加,并且使延迟为最小限度。

另外,在本实施方式中,追踪信息是表示包含与移动体的行进方向垂直的第1轴位移及第2轴位移中的至少一个的位移的信息。行进方向与z方向对应,第1轴与x方向的轴对应,第2轴与y方向的轴对应。参数运算部140通过校正由上述位移产生的虚拟对象的位置误差而输出校正后扭曲参数。

在延迟补偿中,补偿在短期间内发生的位置或姿势的变化,作为在短期间内发生的位置或姿势的变化,认为移动体或观看者的晃动的影响大。在移动体或观看者晃动的情况下,可认为观看者通过显示区域看到的实际对象发生位移。根据本实施方式,由于校正了因与移动体的行进方向垂直的第1轴位移和第2轴位移而产生的虚拟对象的位置误差,所以可以补偿由于移动体或观看者的晃动而引起的显示位置偏离。

另外,在本实施方式中,与移动体的行进方向垂直的第1轴位移及第2轴位移中的移动体的上下方向的位移是第2轴位移。此时,追踪信息包含表示由移动体的俯仰位移引起的HUD 400或观看者的第2轴位移的信息。参数运算部140通过校正由上述第2轴位移产生的虚拟对象的位置误差而输出校正后扭曲参数。

作为上述的移动体的晃动,设想俯仰位移,移动体的俯仰位移使HUD的屏幕或观看者产生第2轴位移。该HUD的屏幕或观看者的第2轴位移使观看者通过显示区域观看的实际对象产生第2轴方向的偏移位移。根据本实施方式,校正由HUD的屏幕或观看者的第2轴位移产生的虚拟对象的位置误差,所以能够补偿由移动体的俯仰位移引起的显示位置偏离。

另外,在本实施方式中,在扭曲处理中,扭曲处理部130进行根据延迟补偿参数对显示区域中的虚拟对象的旋转和缩放中的至少一个进行补偿的延迟补偿处理。

这样,不仅可以进行偏移位移的延迟补偿,还可以进行旋转或缩放的延迟补偿。缩放是缩小或放大虚拟对象。根据本实施例,补偿了由于延迟而导致的虚拟对象的旋转误差、缩放误差或这两者。因此,可以实现具有更高的跟随性的AR显示。

此外,在本实施方式中,追踪处理部110根据检测移动体的运动的运动传感器的输出信号生成追踪信息。参数运算部140使用基于运动传感器的输出信号的追踪信息来运算出延迟补偿参数。运动传感器例如是上述的IMU,但不限于此,只要是检测移动体的加速度、速度、位置、角速度或姿势的传感器即可。

如上所述,作为延迟补偿的对象,考虑移动体的晃动的影响。根据本实施方式,由于使用基于检测移动体的运动的运动传感器的输出信号的追踪信息来运算出延迟补偿参数,所以补偿了由移动体的晃动引起的虚拟对象的位置偏离。

2.第1详细结构例

以下,说明显示系统100的硬件结构的两个例子,但显示系统100的硬件结构不限于此。

图9是显示系统100的第1详细结构例。显示系统100包括处理装置150和HUD控制器160。处理装置150例如由SoC构成,包括接口151、追踪处理部110、渲染图像生成部120、参数运算部140和存储部145。SoC是System on Chip(片上系统)的简称。HUD控制器160例如由集成电路装置构成,包括扭曲处理部130。另外,对已经说明的构成要素标注相同的附图标号,适当省略对该构成要素的说明。

接口151是用于将传感器500的输出信号输入到处理装置150的接口。接口151例如是接收传感器500的输出信号的接收电路。或者,接口151也可以是被输入传感器500的输出信号的端子。此时,输入到端子的传感器500的输出信号被输入到构成追踪处理部110的处理器,该处理器对传感器500的输出信号进行接收处理。

追踪处理部110根据传感器500的输出信号进行追踪处理。渲染图像生成部120基于从追踪处理部110输出的追踪信息渲染虚拟对象。追踪处理部110和渲染图像生成部120由CPU或GPU等处理器构成。CPU是Central Processing Unit(中央处理单元)的缩写。GPU是Graphical Processing Unit(图形处理单元)的缩写。追踪处理部110和渲染图像生成部120可以由一个处理器实现,也可以分别由单独的处理器实现。存储部145是RAM或非易失性存储器等半导体存储器,存储延迟补偿前的扭曲参数。RAM是Random Access Memory(随机存取存储器)的缩写。如上所述,扭曲参数是矩阵或表。扭曲参数可以是前向映射(forwardmap)参数或逆向映射(inverse map)参数。前向映射参数是将输入图像的各像素和与该各像素对应的移动目的地坐标建立对应的参数,或者是将输入图像的各像素和向与该各像素对应的移动目的地坐标移动的相对移动量建立对应的参数。逆向映射参数是使输出图像的各像素和与该各像素对应的参照源坐标对应起来的参数,或者使输出图像的各像素和相对于与该各像素对应的参照源坐标的相对移动量对应起来的参数。

参数运算部140根据追踪信息求出延迟补偿参数,根据延迟补偿参数校正从存储部145读出的扭曲参数,输出校正后扭曲参数。参数运算部140既可以通过与追踪处理部110以及渲染图像生成部120的处理器相同的处理器来实现,或者也可以通过与其不同的处理器来实现。

扭曲处理部130通过使用校正后扭曲参数对渲染图像进行扭曲处理,生成显示图像。扭曲处理部130由逻辑电路构成,例如由自动配置布线的门阵列或自动布线的标准单元阵列等构成。HUD 400包括显示器410,将显示图像显示在显示器410上。显示器410是液晶显示装置等显示装置。HUD 400包含未图示的投射光学单元。投射光学单元将显示在显示器410上的图像投射到屏幕上,从而在实际空间中叠加显示虚拟对象。

根据本实施方式,显示系统100包括具有渲染图像生成部120和参数运算部140的处理装置150以及具有扭曲处理部130的HUD控制器160。

这样,可使作为SoC的处理装置150进行延迟补偿参数的运算和校正后扭曲参数的运算。由此,不需要在HUD控制器160中追加用于进行延迟补偿的电路,能够不增加HUD控制器160的电路规模地实现延迟补偿。另外,在本实施方式中,处理装置150包括接口151,该接口151被输入作为取得实际对象的二维信息或者三维信息的第1传感器、检测移动体的运动的第2传感器、以及检测观看者的视点或视线方向的第3传感器的至少一个的传感器500的输出信号。在图6中说明的传感器500的例子中,Lidar或照相机对应于第1传感器,IMU对应于第2传感器,眼睛追踪传感器对应于第3传感器。参数运算部140使用基于传感器500的输出信号的追踪信息来运算出延迟补偿参数。

由于延迟而导致的虚拟对象的位置偏离是由于实际对象、移动体或观看者的位置或姿势的变化而产生的。根据本实施方式,传感器500可以检测与实际对象、移动体和观看者中的至少一个有关的位置或姿势的变化。然后,参数运算部140通过使用基于传感器500的输出信号的追踪信息来运算出延迟补偿参数,可以补偿由实际对象、移动体或观看者的位置或姿势的变化引起的虚拟对象的位置偏离。

另外,在本实施方式中,扭曲处理部130将表示扭曲处理的对象帧的帧信息输出给参数运算部140。参数运算部140根据帧信息运算对应于目标帧的延迟的延迟补偿参数。

如在图8中说明的那样,参数运算部140运算与惯性测程的定时tnow1和显示定时tdp之间的延迟对应的延迟补偿参数。在图9的结构中,扭曲处理部130设置于HUD控制器160,参数运算部140设置于处理装置150。因此,参数运算部140如果不能得到扭曲处理部130正在进行哪个帧的扭曲处理的信息,则不能知道显示定时tdp。根据本实施方式,由于扭曲处理部130将表示扭曲处理的对象帧的帧信息输出给参数运算部140,所以参数运算部140能够知道显示定时tdp。

3.第2详细结构例

图10是显示系统100的第2详细结构例。在图10中,处理设备150包括接口151、追踪处理部110和渲染图像生成部120。HUD控制器160包括接口161、扭曲处理部130、参数运算部140和存储部145。另外,对已经说明的构成要素标注相同的标号,适当省略对该构成要素的说明。

传感器500包括:渲染用传感器510,其用于求出渲染用的追踪信息;以及延迟补偿用传感器520,其用于求出延迟补偿参数。渲染传感器510包括例如Lidar、IMU和照相机。延迟补偿用传感器520例如包括IMU和头部追踪传感器。另外,渲染用传感器510和延迟补偿用传感器520所包含的传感器的种类不限于上述情况,只要是检测移动体、观看者或实际对象的位置、姿势或运动的传感器即可。延迟补偿用传感器520和渲染用传感器510是不同的传感器,即使在包含同种传感器的情况下,该同种传感器也分别设置在延迟补偿用传感器520和渲染用传感器510中。

渲染图像生成部120将由追踪处理部110获得的追踪信息与渲染图像一起输出到HUD控制器160。

接口161是用于向HUD控制器160输入从处理装置150发送的渲染图像和追踪信息以及延迟补偿传感器520的输出信号的接口。接口161是接收例如渲染图像、追踪信息和延迟补偿传感器520的输出信号的接收电路。或者,接口161也可以是接收渲染图像和追踪信息的接收电路以及被输入延迟补偿用传感器520的输出信号的端子。在该情况下,输入到端子的延迟补偿用传感器520的输出信号被输入到参数运算部140,参数运算部140对延迟补偿用传感器520的输出信号进行接收处理。

参数运算部140根据从处理装置150与渲染图像一起发送的追踪信息和延迟补偿用传感器520的输出信号,求出延迟补偿参数。参数运算部140根据延迟补偿参数对从存储部145读出的扭曲参数进行校正,输出校正后扭曲参数。

扭曲处理部130通过使用校正后扭曲参数对渲染图像进行扭曲处理,生成显示图像。扭曲处理部130和参数运算部140由逻辑电路构成,例如由自动配置布线的门阵列或自动布线的标准单元阵列等构成。

图11表示第2详细结构例中的显示系统100的处理流程。另外,图11所示的处理流程是一个例子,例如用于渲染或延迟补偿的追踪方法不限于图8。另外,用于追踪的传感器也可以根据所采用的追踪方法来选择。

在图11中,IMU 1和照相机是渲染用传感器510,IMU 2是延迟补偿用传感器520。在时刻tnow2被采样的IMU 2的输出信号被用于延迟补偿。

具体而言,追踪处理部110通过视觉惯性测程处理来估计位置和姿势Pr(tck+1)。渲染图像生成部120将位置和姿势Pp(tck,tnow1,tdp)以及位置和姿势Pr(tck+1)与基于位置和姿势Pp(tck,tnow1,tdp)渲染的渲染图像一起输出到HUD控制器160。

参数运算部140根据通过接口161输入的位置和姿势Pr(tck+1)和在定时tnow2由IMU 2采样的移动体的运动信息MTI'(tnow2),进行惯性测程处理,估计定时tnow2的实际对象和移动体的位置和姿势Pc'(tck+1,tnow2)。

参数运算部140基于位置和姿势Pc'(tck+1,tnow2)执行预测处理,预测tdp的实际对象和移动体的位置和姿势Pp'(tck+1,tnow2,tdp)。

参数运算部140根据位置和姿势Pp(tck,tnow1,tdp)以及位置和姿势Pp'(tck+1,tnow2,tdp)求出延迟补偿参数。具体地,参数运算部140运算出延迟补偿参数,以消除由于位置和姿势Pp(tck,tnow1,tdp)与位置和姿势Pp'(tck+1,tnow2,tdp)之差引起的虚拟对象的位置偏离。参数运算部140使用延迟补偿参数来校正扭曲参数,并输出校正后扭曲参数。

扭曲处理部130使用校正后扭曲参数对渲染图像进行扭曲处理,生成显示图像。

根据本实施方式,显示系统100包括具有渲染图像生成部120的处理装置150以及具有参数运算部140以及扭曲处理部130的HUD控制器160。

这样,能够使HUD控制器160进行延迟补偿参数的运算和校正后扭曲参数的运算。与使处理装置150进行延迟补偿参数的运算和校正后扭曲参数的运算的情况相比,不需要将校正后扭曲参数发送到HUD控制器160的通信时间,可以使用更接近显示定时tdp的定时的传感器输出来进行延迟补偿。

此外,在本实施方式中,处理装置150包括被输入渲染用传感器510的输出信号的第1接口。在图10中,接口151对应于第1接口。渲染图像生成部120根据基于渲染用传感器510的输出信号的追踪信息,生成渲染图像。HUD控制器160包括被输入与渲染用传感器510不同的延迟补偿用传感器520的输出信号和渲染图像的第2接口。在图10中,接口161对应于第2接口。参数运算部140根据延迟补偿用传感器520的输出信号来运算出延迟补偿参数。

这样,由于参数运算部140可以在任意定时取得延迟补偿用传感器520的输出信号,所以可以取得尽可能接近显示定时tdp的定时的延迟补偿用传感器520的输出信号,来运算出延迟补偿参数。

另外,在本实施方式中,渲染图像生成部120基于第1定时处的追踪信息生成渲染图像,将第1定时处的追踪信息与渲染图像一起输出到HUD控制器160。在图11中,第1定时对应于tnow1,第1定时中的追踪信息对应于Pp(tck,tnow1,tdp)。参数运算部140根据与图像的显示定时tdp对应且比第1定时靠后的第2定时处的追踪信息以及第1定时处的追踪信息,运算出延迟补偿参数。在图11中,第2定时对应于tnow2,第2定时中的追踪信息对应于Pp'(tck+1,tnow2,tdp)。

这样,由于第1定时和显示定时之间的延迟被缩短为第2定时和显示定时之间的延迟,所以可削减由延迟引起的位置偏离。使用图11的例子进行说明,校正扭曲参数的延迟补偿参数中反映了在tnow1之后的tnow2由IMU 2采样的运动信息。通过利用该延迟补偿参数校正虚拟对象的显示位置,tnow1和tdp之间的延迟被缩短到tnow2和tdp之间的延迟。

4.扭曲处理

以下,以逆向扭曲为例详细说明扭曲处理。但是,扭曲处理既可以是前向扭曲也可以是逆向扭曲,扭曲处理部130既可以是前向扭曲引擎也可以是逆向扭曲引擎。前向扭曲是将对扭曲引擎输入的输入图像的各像素移动到输出图像中的任意位置的变换。前向扭曲引擎是指具有前向扭曲的功能的扭曲引擎。逆向扭曲是指从输入图像中的任意位置的像素求出逆向引擎的输出图像的各像素的变换。逆向扭曲引擎是具有逆向扭曲的功能的扭曲引擎。

图12是本实施方式的扭曲处理的说明图。输入图像是渲染图像。输出图像是显示在HUD的液晶显示面板等上的显示图像。(xsrc,ysrc)表示输入图像中的水平方向的位置和垂直方向的位置。(xdst,ydst)表示输出图像中的水平方向的位置和垂直方向的位置。

如果用g()表示使用了延迟补偿参数的扭曲参数的校正,则延迟补偿图像中的位置如下式(1)所示。

(xlat,ylat)=g(xsrc,ysrc)……(1)

若将基于与屏幕的弯曲对应的扭曲参数的畸变校正表示为f(),则输出图像中的位置如下式(2)所示。

(xdst,ydst)=f(xlat,ylat)……(2)

根据上式(1)(2),输入图像和输出图像之间的坐标变换如下式(3)所示。

(xdst,ydst)=f·g(xsrc,ysrc)……(3)

由于逆向扭曲使用上式(3)的逆变换,因此成为下式(4)那样。

(xsrc,ysrc)=g

在本实施方式中,参数运算部140求出延迟补偿参数g

图13是表示移动体等的追踪信息与基于该追踪信息的延迟补偿的对应的图。这里,假设获得6轴运动信息作为追踪信息。

偏航位移Δα是以与作为垂直方向的y方向平行的轴为旋转轴的旋转位移。偏航位移Δα使观看者通过屏幕看到的实际对象产生水平偏移。水平偏移是水平方向即x方向的偏移。因此,延迟补偿的方法是水平偏移。

俯仰位移Δβ是以与作为水平方向的x方向平行的轴为旋转轴的旋转位移。俯仰位移Δβ导致观看者通过屏幕看到的实际对象产生垂直偏移。垂直偏移是垂直方向即y方向的偏移。因此,延迟补偿的方法为垂直偏移。

翻滚位移Δγ是以与移动体的前后方向即z方向平行的轴为旋转轴的旋转位移。翻滚位移Δγ使观看者通过屏幕看到的实际对象产生旋转。因此,延迟补偿的方法是旋转。

水平偏移Δx是x方向的偏移,使观看者通过屏幕看到的实际对象产生水平偏移。因此,延迟补偿的方法是水平偏移。

垂直偏移Δy是y方向的偏移,使观看者通过屏幕看到的实际对象产生垂直偏移。因此,延迟补偿的方法为垂直偏移。

前后偏移Δz是z方向的偏移,导致观看者通过屏幕看到的实际对象的缩小或放大。因此,延迟补偿的方法是缩小或放大。

图14表示实现上述补偿方法的延迟补偿参数的例子。图14所示的式的右边的矩阵与图12中说明的g

例如,如果考虑仅发生垂直偏移的情况,则m11=m22=1,m12=m13=0。此时,图14的式成为下式(5)。

(xsrc,ysrc)=(xlat,ylat+m23)……(5)

在图12中,畸变校正的逆变换f

图15是说明根据追踪信息运算出延迟补偿参数的方法的图。

根据偏航、翻滚以及俯仰的旋转中心、观看者的头部、HUD屏幕以及实际对象的几何学位置关系,能够将移动体、观看者或者实际对象产生的位移换算为屏幕上的偏移量或者旋转角度。然后,能够根据该偏移量或旋转角度来决定图14的右边的矩阵。

在图15中,以图14中表示垂直偏移的m23为例,说明根据追踪信息求出延迟补偿参数的方法。这里,说明使用移动体32的俯仰位移Δβ和垂直偏移Δym以及观看者52的垂直偏移Δyp作为追踪信息的例子。

若将俯仰的旋转中心PTC与屏幕34的距离设为DCF,则移动体32的俯仰位移Δβ使屏幕34垂直偏移DCF×Δβ。此外,移动体32的垂直偏移Δym使屏幕34垂直偏移Δym。若对它们进行合计,则屏幕34的垂直偏移量为DCF×Δβ+Δym。假设观看者52的头部和实际对象12不移动,例如,当屏幕34上升+(DCF×Δβ+Δym)时,观看者看到的实际对象12在屏幕34上的位置看起来相对于屏幕34相对下降-(DCF×Δβ+Δym)。因此,此时的延迟补偿参数为m23=-(DCF×Δβ+Δym)。

设观看者52的头部与实际对象12之间的距离为DPT,屏幕34与实际对象12之间的距离为DFT。如果假设屏幕34和实际对象12不移动,则例如当观看者向上移动+Δyp时,从观看者52看到的实际对象12在屏幕34上的位置看起来相对于屏幕34向上移动+(DFT/DPT)×Δyp。如果假设实际对象12足够远,则可以近似为DFT/DPT=1,因此实际对象12的垂直偏移量为Δyp。因此,此时的延迟补偿参数为m23=Δyp。

根据本实施方式,显示系统100包括存储部145,存储部145将使显示图像中的坐标和表示该坐标的移动目的地的移动量对应起来的表存储为扭曲参数。参数运算部140根据延迟补偿参数使表的移动量偏移,将移动量偏移后的表作为补偿后扭曲参数输出。

在图12的例子中,f

变换式例如是多项式,该多项式的系数作为变换式的参数存储在存储部145中。在图12的例子中,表示f

5.电子设备、移动体

图16是包含本实施方式的显示系统100的电子设备300的结构例。电子设备300包括显示系统100、存储装置350、操作装置360、通信装置370、平视显示器400、传感器500。显示系统100包括处理装置150、HUD控制器160。

处理器150将通过渲染虚拟对象而获得的渲染图像输出到HUD控制器160。此外,处理装置150也可以将存储装置350中存储的图像数据或通信装置370接收到的图像数据与虚拟对象合成后的渲染图像输出到HUD控制器160。HUD控制器160在对渲染图像进行扭曲处理的同时进行延迟补偿。另外,HUD控制器160进行显示定时控制等。平视显示器400基于从HUD控制器160传输的图像数据和由HUD控制器160进行的显示定时控制来驱动显示面板,在显示面板上显示图像。显示面板例如是液晶显示面板或EL显示面板等。平视显示器400通过投射光学单元将显示在显示面板上的图像投射到屏幕上。存储装置350例如是存储器、或硬盘驱动器或光盘驱动器等。操作装置360是用于用户操作电子设备300的装置,例如是按钮、或者触摸面板、或者键盘等。通信装置370例如是进行有线通信的装置或进行无线通信的装置。有线通信例如是LAN或USB等。无线通信例如是无线LAN或无线近距离通信等。

作为包含本实施方式的电路装置的电子设备,可以设想车载用的电子设备、工厂设备等的显示终端、搭载于机器人的显示装置或信息处理装置等各种设备。车载用的电子设备例如是仪表面板等。信息处理装置例如是PC等。

图17是包含本实施方式的显示系统100的移动体的例子。移动体包括显示系统100、平视显示器400和传感器500。显示系统100包括处理装置150、HUD控制器160。显示系统100例如设置于ECU(Electronic Control Unit:电子控制单元)内,在ECU中组装有处理装置150和HUD控制器160。此外,HUD控制器160可以组装到平视显示器400中。本实施方式的HUD控制器160例如可以组装在汽车、飞机、摩托车、自行车或船舶等各种移动体中。移动体例如是具备发动机或马达等驱动机构、方向盘或舵等转向机构以及各种电子设备并在地上、天空或海上移动的设备或装置。图17概略地表示作为移动体的具体例的汽车206。汽车206具有车体207和车轮209。上述ECU基于驾驶员的操作,通过控制发动机、制动器或转向等来控制汽车206的行驶。平视显示器400具有透明屏幕,该透明屏幕设置于驾驶席与挡风玻璃之间。或者,平视显示器也可以将挡风玻璃用作透明屏幕,向挡风玻璃上投射图像。平视显示器400也可以执行AR显示,并且用作例如汽车206的仪表面板。

以上说明的本实施方式的显示系统是平视显示器的显示系统,该平视显示器在显示区域中显示与实际空间中的实际对象对应的虚拟对象。显示系统包括渲染图像生成部、参数运算部和扭曲处理部。渲染图像生成部生成包含虚拟对象的渲染图像。参数运算部基于追踪信息运算出延迟补偿参数,该延迟补偿参数用于对包括渲染图像的渲染处理延迟在内的延迟进行补偿,该追踪信息是搭载有平视显示器的移动体的第1追踪信息、平视显示器的观看者的第2追踪信息和实际对象的第3追踪信息中的至少一个。扭曲处理部进行根据显示区域的弯曲对渲染图像进行坐标变换的扭曲处理,生成在显示区域中显示的显示图像。在扭曲处理中,扭曲处理部进行基于延迟补偿参数来补偿虚拟对象在显示区域中的位置的延迟补偿处理。

因此,根据延迟补偿参数来补偿由于包括渲染处理延迟在内的延迟而产生的虚拟对象的位置偏离。通过在紧接在显示之前进行的扭曲处理中执行延迟补偿,可以使残余延迟最小化,从而实现虚拟对象对实际对象的跟随性高的AR显示。

另外,在本实施方式中,渲染图像生成部也可以根据第1定时处的追踪信息生成渲染图像。参数运算部可以根据第1定时之后且显示图像的显示定时之前的第2定时处的追踪信息和第1定时处的追踪信息,运算出延迟补偿参数。

这样,由于第1定时和显示定时之间的延迟被缩短为比第1定时靠后的第2定时和显示定时之间的延迟,所以可削减由延迟引起的位置偏离。

另外,在本实施方式中,参数运算部可以根据延迟补偿参数来校正与显示区域的弯曲对应的坐标变换的扭曲参数,从而输出校正后扭曲参数。扭曲处理部也可以通过使用校正后扭曲参数进行扭曲处理来进行延迟补偿处理。

这样,通过使用基于延迟补偿参数的校正后扭曲参数进行扭曲处理,能够在扭曲处理中进行延迟补偿。另外,在本实施方式中,追踪信息也可以是表示包含与移动体的行进方向垂直的第1轴位移及第2轴位移中的至少一个的位移的信息。参数运算部可以通过校正由位移产生的虚拟对象的位置误差来输出校正后扭曲参数。

在延迟补偿中,补偿在短期间内发生的位置或姿势的变化,作为在短期间内发生的位置或姿势的变化,认为移动体或观看者的晃动的影响大。在移动体或观看者晃动的情况下,可认为观看者通过显示区域看到的实际对象产生偏移位移。根据本实施例,由于校正了因与移动体的行进方向垂直的第1轴位移和第2轴位移而产生的虚拟对象的位置误差,所以可以补偿由于移动体或观看者的晃动而引起的显示位置偏离。

另外,在本实施方式中,在与移动体的行进方向垂直的第1轴位移及第2轴位移中,移动体的上下方向的位移也可以是第2轴位移。在这种情况下,追踪信息可以是表示由移动体的俯仰位移引起的平视显示器或观看者的第2轴位移的信息。参数运算部可以通过校正由第2轴位移产生的虚拟对象的位置误差来输出校正后扭曲参数。

设想俯仰位移作为上述移动体的晃动,移动体的俯仰位移使平视显示器的屏幕或观看者产生第2轴位移。平视显示器的屏幕或观看者的第2轴位移引起观看者通过显示区域观看的实际对象在第2轴方向上的偏移位移。根据本实施例,由于校正了由平视显示器的屏幕或观看者的第2轴位移引起的虚拟对象的位置误差,因此可以补偿由移动体的俯仰位移引起的显示位置偏离。

另外,在本实施方式中,显示系统也可以包括存储部,该存储部将使显示图像中的坐标与表示坐标的移动目的地的移动量对应起来的表作为扭曲参数进行存储。参数运算部可以根据延迟补偿参数来使表的移动量偏移,并将移动量偏移动后的表作为校正后扭曲参数输出。

这样,根据延迟补偿参数使表的移动量偏移,根据该校正后的表进行扭曲处理,从而实现延迟补偿。

另外,在本实施方式中,显示系统也可以包括存储部,该存储部将使显示图像中的坐标变换为移动目的地的坐标的变换式的参数作为扭曲参数进行存储。参数运算部可以根据延迟补偿参数来使移动目的地的坐标偏移,并将移动目的地的坐标偏移后的变换式的参数作为校正后扭曲参数输出。

这样,变换式的移动目的地的坐标基于延迟补偿参数被偏移,通过该校正后的变换式进行扭曲处理,从而实现延迟补偿。

另外,在本实施方式中,在扭曲处理中,扭曲处理部可以进行根据延迟补偿参数对显示区域中的虚拟对象的旋转和缩放中的至少一个进行补偿的延迟补偿处理。

这样,不仅可以进行偏移位移的延迟补偿,还可以进行旋转或缩放的延迟补偿。缩放是缩小或放大虚拟对象。根据本实施例,补偿了由于延迟而导致的虚拟对象的旋转误差、缩放误差或这两者。因此,可以实现具有更高的跟随性的AR显示。

此外,在本实施方式中,显示系统也可以包括追踪处理部,该追踪处理部基于检测移动体的运动的运动传感器的输出信号来生成追踪信息。参数运算部可以使用基于运动传感器的输出信号的追踪信息来运算出延迟补偿参数。

如上所述,作为延迟补偿的对象,考虑移动体的晃动的影响。根据本实施方式,由于使用基于检测移动体的运动的运动传感器的输出信号的追踪信息来运算出延迟补偿参数,所以补偿了由移动体的晃动引起的虚拟对象的位置偏离。

此外,在本实施方式中,显示系统也可以包括具有渲染图像生成部和参数运算部的处理装置以及具有扭曲处理部的平视显示器控制器。

这样,可以使处理装置进行延迟补偿参数的运算和校正后扭曲参数的运算。因此,不需要将用于执行延迟补偿的电路追加到平视显示器控制器,可以在不增加平视显示器控制器的电路规模的情况下实现延迟补偿。

另外,在本实施方式中,处理装置也可以包括接口。接口被输入传感器的输出信号,所述传感器是获取实际对象的二维信息或三维信息的第1传感器、检测移动体的运动的第2传感器以及检测观看者的视点或视线方向的第3传感器中的至少一个。参数运算部也可以使用基于传感器的输出信号的追踪信息来运算出延迟补偿参数。

由于延迟而导致的虚拟对象的位置偏离是由于实际对象、移动体或观看者的位置或姿势的变化而产生的。根据本实施方式,传感器可以检测与实际对象、移动体和观看者中的至少一个有关的位置或姿势的变化。然后,参数运算单元通过使用基于传感器的输出信号的追踪信息来运算出延迟补偿参数,从而可以补偿由于实际对象、移动体或观看者的位置或姿势的变化而产生的虚拟对象的位置偏离。

另外,在本实施方式中,扭曲处理部也可以将表示扭曲处理的对象帧的帧信息输出到参数运算部。参数运算部可以根据帧信息运算与对象帧对应的延迟的延迟补偿参数。

在本实施方式的结构中,设置在处理装置中的参数运算部如果不获得设置在平视显示器控制器中的扭曲处理部正在进行哪个帧的扭曲处理的信息,则不能知道显示定时。根据本实施方式,由于扭曲处理部将表示扭曲处理的对象帧的帧信息输出到参数运算部,所以参数运算部能够知道显示定时。

此外,在本实施方式中,显示系统也可以包括具有渲染图像生成部的处理装置以及具有参数运算部及扭曲处理部的平视显示器控制器。

这样,可以使平视显示器控制器进行延迟补偿参数的运算和校正后扭曲参数的运算。与使处理装置进行延迟补偿参数的运算和校正后扭曲参数的运算的情况相比,不需要将校正后扭曲参数发送到平视显示器控制器的通信时间,能够使用更接近显示定时的定时的传感器输出来进行延迟补偿。

此外,在本实施方式中,处理装置也可以包括被输入渲染用传感器的输出信号的第1接口。渲染图像生成部可以根据基于渲染用传感器的输出信号的追踪信息来生成渲染图像。平视显示器控制器也可以包括被输入与渲染用传感器不同的延迟补偿用传感器的输出信号和渲染图像的第2接口。参数运算部也可以根据延迟补偿用传感器的输出信号来运算出延迟补偿参数。

这样,由于参数运算部可在任意定时取得延迟补偿用传感器的输出信号,所以可取得尽可能接近显示定时的定时的延迟补偿用传感器的输出信号,运算出延迟补偿参数。

另外,在本实施方式中,渲染图像生成部也可以基于第1定时中的追踪信息生成渲染图像,将第1定时处的追踪信息与渲染图像一起输出到平视显示器控制器。参数运算部也可以根据与显示图像的显示定时对应且在第1定时之后的第2定时处的追踪信息和第1定时处的追踪信息,运算出延迟补偿参数。

这样,由于第1定时和显示定时之间的延迟被缩短为比第1定时靠后的第2定时和显示定时之间的延迟,所以可削减由延迟引起的位置偏离。

另外,本实施方式的电子设备包括上述任一项所述的显示系统。

另外,本实施方式的移动体包括上述任一项所述的显示系统。

本实施例的显示方法是在显示区域中显示与实际空间中的实际对象相对应的虚拟对象的平视显示器的显示方法。显示方法包括生成包含虚拟对象的渲染图像。显示方法包括基于追踪信息运算用于对包括渲染图像的渲染处理延迟在内的延迟进行补偿的延迟补偿参数,所述追踪信息是搭载有平视显示器的移动体的第1追踪信息、平视显示器的观看者的第2追踪信息和实际对象的第3追踪信息中的至少一个。显示方法包括进行根据显示区域的弯曲对渲染图像进行坐标变换的扭曲处理,生成在显示区域中显示的显示图像。在该显示方法的扭曲处理中,执行基于延迟补偿参数来补偿虚拟对象在显示区域中的位置的延迟补偿处理。

另外,如上所述对本实施方式进行了详细说明,但本领域技术人员能够容易地理解可进行实质上不脱离本公开的新事项及效果的多种变形。因此,本公开的范围包括所有这样的变形例。例如,在说明书或附图中,至少一次与更广义或同义的不同用语一起记载的用语,在说明书或附图的任何位置都能够置换为该不同的用语。此外,本实施方式和变形例的所有组合也包括在本公开的范围内。另外,传感器、平视显示器、处理装置、平视显示器控制器、显示系统、电子设备及移动体等的结构及动作等也不限于本实施方式中说明的结构及动作,可以进行各种变形实施。

- 显示系统、电子设备、移动体和显示方法

- 显示控制系统、移动体、显示控制方法、显示装置、显示方法以及程序