基于联合隐式图像函数的RGB图像引导深度图超分辨率方法

文献发布时间:2023-06-19 13:26:15

技术领域

本发明涉及一种基于联合隐式图像函数的RGB图像引导的深度图超分辨率(图像恢复)方法,可应用于RGB图像引导的深度图超分辨率任务,具体涉及一种联合隐式图像函数的定义以及一个用于从数据中学习此函数的深度神经网络模型,用于将低分辨率、含有噪声的深度图恢复为高分辨率、无噪声的深度图,属于计算机视觉图像处理技术领域。

背景技术

RGB图像引导的深度图超分辨率任务指的是从一张低分辨率、含有噪声的深度图以及一张对应的高分辨率的RGB图像中恢复高分辨率、无噪声的深度图的任务,在三维重建等任务中有着实际的应用。受限于深度传感器的精度,采集到的深度图通常质量较低,但RGB相机的发展使得高质量的RGB图像可以较容易地获取。现有的深度图超分辨率图像恢复方法通常将这个深度图超分辨率图像恢复任务视为引导滤波(Guided Filtering)问题,通过构建显式的滤波器,将RGB图像中的结构细节转移到深度图中,从而提高深度图的质量,例如文献[1](He,Kaiming et al.“Guided Image Filtering.”IEEE Transactions onPattern Analysis and Machine Intelligence 35,2013:1397-1409.)。但由于RGB图像中信息的复杂性,这种方法可能会将不正确的信息转移到深度图中。另一种常见的方法将这个图像恢复任务视为一个稠密回归问题,通过监督学习的方法训练神经网络,直接对高分辨率的深度图进行回归,例如文献[2](Li,Yijun et al.“Deep Joint Image Filtering.”ECCV,2016.)与[3](Su,Hang et al.“Pixel-Adaptive Convolutional NeuralNetworks.”CVPR,2019:11158-11167.)等。这种方法可以利用CNN的特征提取能力,取得了更好的效果,但可解释性通常较差。

发明内容

为了克服上述技术存在的不足,本发明提供一种基于联合隐式图像函数的RGB图像引导的深度图超分辨率方法及系统,创建应用于深度图超分辨率图像恢复任务的深度神经网络模型,具体采用的联合隐式图像函数表示是一种适用于引导图像超分辨率任务的隐式图像表示形式,用于从对应的RGB图像中提取细节信息,从而更好的完成深度图的超分辨率图像恢复任务。

本发明提出的联合隐式图像函数(Joint Implicit Image Function,JIIF),从隐式神经表示(Implicit Neural Representation)的视角处理RGB图像引导的深度图超分辨率任务。具体而言,我们采用图像插值的形式解决深度图超分辨率问题,并使用一个由多层感知机(Multi-layer Perceptron)实现的深度隐函数(Deep Implicit Function,DIF)学习插值过程中使用的权重与值,最后通过插值公式计算预测的像素值。将本发明方法应用于深度图超分辨率图像恢复任务,恢复得到的图像在具有较好的可解释性的同时,通过利用深度神经网络的特征提取能力,取得了较好的图像恢复效果。

本发明的技术方案是:

一种基于联合隐式图像函数的RGB图像引导深度图超分辨率方法,包括:建立深度神经网络模型;通过两个编码器从RGB图像以及输入的低分辨率深度图中分别提取特征;通过联合隐式图像函数,对于输出的高分辨率深度图中每一个像素,预测插值公式中的权重与值;按照插值公式对每个像素的特征进行插值,再通过解码器输出每个像素深度值的预测。本发明创建的用于深度图超分辨率图像恢复的深度神经网络模型包含RGB图像编码器,深度图编码器,以及JIIF解码器三个部分。

基于联合隐式图像函数的RGB图像引导的深度图超分辨率恢复方法包括如下步骤:

创建用于深度图超分辨率图像恢复的深度神经网络模型,包含RGB图像编码器,深度图编码器,以及JIIF解码器三个部分。本方法首次将隐式神经表示的方法应用于RGB引导的深度图超分辨率任务,提出了适用于此任务的联合隐式图像函数,对多模态的输入(RGB图像,低分辨率深度图)进行建模,并用于对高分辨率下的每一个像素的值进行预测,结合了CNN编码器提取特征的能力以及DIF的空间表达能力,在取得了更准确的预测结果的同时具有较好的解释性。

A.从输入的RGB图像以及低分辨率深度图中提取特征;

A1.通过RGB图像编码器E

A2.通过深度图编码器E

B.通过JIIF解码器输出预测的高分辨率深度图;

B1.对于高分辨率深度图中的每一个像素(目标像素),寻找低分辨率深度图中坐标最近的四个像素(近邻像素)以及提取的深度特征;

B2.在高分辨率RGB图像中找到目标像素对应的坐标处的RGB特征,以及四个近邻像素对应的坐标处的RGB特征;

B3.使用一个统一的联合隐式图像函数,输入上述目标像素以及近邻像素的坐标、深度特征以及RGB特征,输出目标像素与每个近邻像素间的插值权重以及值。

B4.通过插值公式,计算B3中的插值权重以及值在目标像素处的插值结果,作为目标像素处预测的深度值。

在步骤A中,我们通过两个编码器分别提取输入的高分辨率RGB图像与低分辨率深度图的特征,此处提取的特征的分辨率保持不变,即与输入的图像分辨率相同,从而可以视为位于每个像素处的特征。

在步骤B中,我们通过提出的JIIF解码器预测高分辨率深度图。对于高分辨率图像中的每一个目标像素,我们分别对其进行预测。首先,我们在低分辨率深度图中寻找坐标最近的四个近邻像素及其深度特征。传统的插值算法通常通过手工设计的规则计算插值权重,例如双线性插值,没有考虑RGB引导图像的信息。在本方法中,由于高分辨率RGB图像中目标像素与四个近邻像素的RGB特征是已知的,我们可以通过神经网络学习目标像素与任一近邻像素的RGB特征之间的相似性,归一化处理后作为深度特征的插值权重,从而利用了RGB引导图像中的先验知识。进一步的,我们使用一个统一的联合隐式图像函数同时学习插值权重与值。最后,我们使用学习得到的权重与值进行加权求和,输出最终的深度值预测。

与现有技术相比,本发明可以更好的利用RGB引导图像中的信息,并且具有较好的可解释性,在RGB图像引导的深度图像超分辨率恢复任务上取得了优于现有技术的图像恢复效果。

附图说明

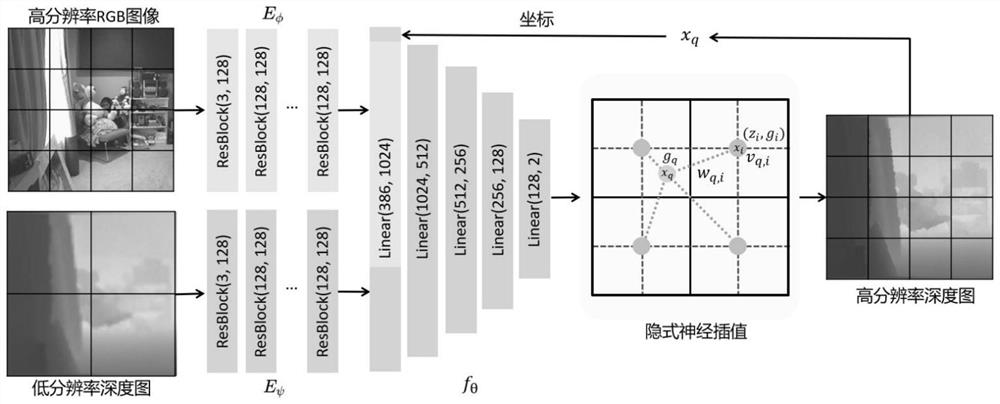

图1是RGB图像引导的深度图超分辨率方法的流程示意图。

图2是本发明建立的用于深度图超分辨率图像恢复的深度神经网网络模型的结构示意图。

具体实施方式

下面将结合本发明实施例中的附图,对本发明中的技术方案进行清楚完整的描述。

本发明提出一种基于联合隐式图像函数引导的深度图超分辨率图像恢复方法,图1所示是本发明提供的RGB图像引导的深度图超分辨率方法的流程;通过提出一种联合隐式图像函数(Joint Implicit Image Function,JIIF),从隐式神经表示(Implicit NeuralRepresentation)的视角处理RGB图像引导的深度图超分辨率恢复任务。具体而言,我们采用图像插值的形式解决超分辨率问题,并且使用一个MLP学习插值过程中使用的权重与值,最后通过插值公式计算预测的像素值。将本发明方法应用于深度图超分辨率图像恢复任务,恢复得到的图像在具有较好的可解释性的同时,通过利用深度神经网络的特征提取能力,取得了较好的图像恢复效果。

本发明是一种基于联合隐式图像函数的RGB图像引导的深度图超分辨率方法,包括:建立深度神经网络模型;本发明创建的用于深度图超分辨率图像恢复的深度神经网络模型包含RGB图像编码器,深度图编码器,以及JIIF解码器三个部分。通过两个编码器从RGB图像以及输入的低分辨率深度图中分别提取特征;通过联合隐式图像函数,对于输出的高分辨率深度图中每一个像素,预测插值公式中的权重与值;按照插值公式对每个像素的特征进行插值,再通过解码器输出每个像素深度值的预测。

图2所示是本发明建立的用于深度图超分辨率图像恢复的深度神经网网络模型的结构示意;首先是编码器部分,包括RGB图像编码器和深度图编码器。对于输入的高分辨率RGB图像G与低分辨率深度图M,我们分别使用两个结构相同的RGB图像编码器E

其中,x

接下来,我们从广义的图像插值公式出发,引出联合隐式图像函数的定义。对于低分辨率的输入图像M,输出的高分辨率图像I中任一像素x

其中,N

不同于现有的传统方法,本方法使用神经网络模型学习w

v

此处f

w

同样,此处f

v

深度隐函数f

我们通过监督学习的方式对上述创建的用于深度图超分辨率图像恢复的深度神经网络模型进行训练,使用的损失函数为预测的高分辨率深度图与真实的高分辨率深度图之间的L1误差:

其中N为总的像素数量,I

利用训练好的用于深度图超分辨率图像恢复的深度神经网络模型,输入待恢复的RGB图像,进行深度图超分辨率图像恢复,即输出恢复好的深度图超分辨率图像。

需要注意的是,公布实施例的目的在于帮助进一步理解本发明,但是本领域的技术人员可以理解:在不脱离本发明及所附权利要求的范围内,各种替换和修改都是可能的。因此,本发明不应局限于实施例所公开的内容,本发明要求保护的范围以权利要求书界定的范围为准。

- 基于联合隐式图像函数的RGB图像引导深度图超分辨率方法

- 一种基于L1-L2罚函数的深度图超分辨率重建方法