一种基于卷积Transformer的遥感图像分类方法及系统

文献发布时间:2023-06-19 18:32:25

技术领域

本发明涉及遥感图像分类领域,具体涉及一种基于卷积Transformer的遥感图像分 类方法及系统。

背景技术

遥感图像具有复杂的整体结构和丰富的纹理特征,基于卷积神经网络(Convolutional Neural Networks,CNN)的遥感图像分类方法虽然能够捕获丰富的局 部信息,但有限的感受野使其无法对全局信息建立长距离依赖关系,从而导致遥感图像 分类的准确率不高。

航空遥感是一门非直接接触且需借助卫星、飞机或无人机作为运载工具进行信息收 集的科学技术,主要应用于地质调查、环境监测、作物预测、资源勘查等领域。随着人 工智能和卫星传感器的发展,遥感技术突破众多挑战,进入了一个能够准确、高效地提 供多种勘测信息的新阶段,使得遥感图像分辨率在空间、光谱、时间等方面都得到了明 显的提升。例如Digital Globe公司的WorldView-2卫星能提供0.5m分辨率的全色和 1.8m分辨率的多光谱影像;中国OHS高光谱卫星上的CMOS传感器,具有256个谱段, 每个谱段范围为400-1000nm,空间分辨率为10m,这为全球带来了更快捷、更精确的卫 星服务。无人机是遥感信息收集的一种主要运载工具,在地质灾害监测、海洋岛礁测绘、 应急救援等领域得到了广泛的应用。与卫星相比,无人机轻小便捷,复杂程度低,开发 成本小,更容易部署,以满足监测、测绘的需要;与飞机相比,无人机不受温度和气候 的影响,在任何天气允许的情况下都可以飞行,提高了时间分辨率,降低了图像模糊率。 近年来有研究提出涉及一种卷积神经网络(Convolutional Neural Networks,CNN)的 方法对无人机图像进行分类。例如Liu提出的将CNN与基于对象的图像分析(OBIA)相结 合,利用多视图数据进行土地覆盖分类的现有技术方案,以及Bazi提出的利用一种双 分支神经网络,为无人机图像分配多个等级标签的现有技术方案等。

针对遥感图像的有效信息采集问题,场景分类是目前使用较广泛的研究领域之一, 其主要目标是获取图像并通过识别图像中正确的语义标签来判断所属场景,从而达到分 类的目的。场景分类有许多重要的应用领域,如土地管理、森林火灾重建、城市规划等。早期的场景分类主要依赖于人工标注来提取图像特征,例如SIFT、GIST、梯度直方图等 方法,这些方法虽然在一些简单的场景分类任务中取得了较好的效果,但随着场景复杂 性及类别数量的增加,其局限性也愈加明显。因此,研究者们提出了传统图像特征建模, 如词袋BOW、LSA、局部聚合描述符向量(VLAD)等方法。

相较于传统图像分类方法,神经网络和自动编码器等深度学习方法在遥感图像分类 等多个应用领域上已取得了显著的成就,特别是CNN在许多应用上超越了其他传统方法。 CNN具有端到端检测的优点,减少了网络训练的参数,从而降低了网络空间的复杂度;多通道输入减少了特征信息重排的过程,缩短了训练时间。在此基础上,循环神经网络(RNN)、生成对抗网络(GANs)、图卷积网络(GCNs)和长短期记忆(LSTM)等方法也相继被 引入,例如申请号为CN202111368092.5的现有发明专利《一种基于自监督学习的遥感 图像分类网络鲁棒性提升方法》利用遥感领域中大量存在的无标签数据,通过孪生网络 挖掘图像自身的信息,有效提升模型的鲁棒性;使用孪生网络对干净样本和对抗样本同 时进行特征提取,即得到特征向量,并通过对比学习迫近干净样本和对抗样本的特征向 量完成模型训练,以及申请号为CN202111193355.3的现有发明专利《基于自补偿卷积 神经网络的遥感场景图像分类方法》采集高光谱图像数据集和相对应的标签向量数据 集;步骤二、建立自补偿卷积神经网络;步骤三、将高光谱图像数据集和相对应的标签 向量数据集输入到建立的自补偿卷积神经网络中,进行迭代优化,得到最优自补偿卷积 神经网络;步骤四、向最优自补偿卷积神经网络中输入待测高光谱图像进行分类结果预 测。前述现有文献的技术方案与本申请不同,未公开本申请中的技术方案及具体技术特 征。Girshick等提出了一种新的目标检测方法,该方法使用深度卷积网络进行分类,与 之前的网络方法相比,提高了方法训练速度和检测准确率。Bi等将航空场景分类视为一 个多实例学习问题,提出了一种参数更少的多实例密集连接卷积网络(MIDC-Net),用来 有效保存不同级别的特征,通过实验证明,该网络方法大大优于许多新方法。Yu等将 GAN与注意力相结合,提出了一种新的注意力生成对抗网络(Attention-GANs),极大地 提高了航空场景分类的性能。XUE等使用三种流行的CNN作为特征处理器,从图像中获 取深度特征并进行融合,实现遥感场景分类。Yu等将两个经过预处理的卷积神经网络与 双流技术进行特征融合以此对高分辨率航拍场景进行分类,其分类准确率显著提高。

近年来,除了CNN以外,一种名为Transformer的新型深度学习方法被提出,并在计算机视觉领域中广受欢迎。Transformer是一种主要依赖自注意力来建立输入特征和 输出特征之间的长距离全局信息依赖的网络,其通过并行化的输出,来获取更有效的结 果。Transformer是目前最先进的序列编码器,在自然语言处理领域得到了广泛的应用 并取得了明显的效果。受此启发,有研究者尝试将Transformer应用于图像上,Bello 等利用自注意力代替部分卷积层以增强CNN的特征提取能力,从而提高了图像分类的性 能。但由于图像的大尺寸导致了自注意力时间复杂度的增加,计算成本较高,Wang等提 出了一种新的端到端的注意循环卷积网络(ARCNet),通过有选择性地关注一些关键区域 或位置,提高分类性能。Dosovitskiy等不再使用传统的结合或替代部分CNN的方法, 而是将图像块的嵌入序列输入到Transformer中,从而直接将Transformer应用于图像 分类任务中。Wu等在CNN上使用了Transformer,首先用CNN提取图像的特征图,然后 将输出的特征图提供给Transformer,最后使用视觉标记增强图像预测。

前述现有技术与本申请在具体实现内容及技术特征上皆存在显著区别,且由于遥感 图像具有复杂的整体结构和丰富的纹理特征,基于CNN的遥感图像分类方法虽然能捕获丰富的局部信息,但对图像的全局信息建模能力较差,从而导致遥感图像分类的准确率 不高。

综上,现有技术存在自注意力时间复杂度的增加、计算成本较高、分类准确率不高及鲁棒性低的技术问题。

发明内容

本发明所要解决的技术问题在于如何解决自注意力时间复杂度的增加、计算成本较 高、分类准确率不高及鲁棒性低的技术问题。

本发明是采用以下技术方案解决上述技术问题的:一种基于卷积Transformer的遥 感图像分类方法包括:

S1、将预设大小的特征图经过第一层卷积后得到预设大小的一层卷积特征图;

S2、将所述一层卷积特征图输入到L-Conv模块中,以不少于2个的所述L-Conv模块处理所述一层卷积特征图,以得到L-Conv处理特征图,其中,所述L-Conv模块包括: 卷积位置编码CPE层和局部特征提取LFE层,所述卷积位置编码CPE层通过深度卷积获 取图像中特征的绝对位置信息,所述局部特征提取LFE层采用深度可分离卷积降维处理 所述一层卷积特征图,进入第二层,第二层的卷积步长为2,对所述L-Conv处理特征图 进行第二层卷积处理,以得到二层卷积处理特征图,以不少于2个的所述L-Conv模块 连续处理所述二层卷积处理特征图,以得到二层卷积特征图;

S3、将所述二层卷积特征图输入Transformer模块,其中,所述Transformer模块包括:轻量级的卷积位置编码CPE层和全局特征提取GFE层,所述轻量级的卷积位置编 码CPE层通过深度卷积来编码特征的位置信息,所述全局特征提取GFE层利用多头自注 意力层对深层图像特征的长距离全局信息建模,以预设数目的所述Transformer模块连 续处理所述所述二层卷积特征图,以得到轻量卷积特征图,平均池化所述轻量卷积特征 图并经预置全连接层处理输出最终预测结果。

本发明首先使用轻量级卷积神经网络代替CNN来提取图像的局部特征,使得在卷积 过程中实现通道和区域的分离,降低了运算量和参数量;其次将得到的局部特征输入到CNN融合多头自注意力机制的混合网络中以增强对图像全局特征的提取能力;最后将获 得的特征输出进行图像分类。本发明中的L-CT(Lightweight Convolutional Transformer,L-CT,轻量级卷积)不仅在浅层能够获取图像特征的局部纹理信息,而 且在深层也能捕获图像特征的全局语义信息,同时兼备CNN和Transformer的优点,使 得网络轻量又高效,提升了算法的鲁棒性。

在更具体的技术方案中,所述卷积位置编码(CPE)层通过使用深度卷积,以下述逻辑对图像特征进行位置编码:

CPE(X

,其中

本发明为了捕获这些特征向量的位置关系,本发明在L-CT中引入了位置编码,位置 编码能够学习图像特征的时间维度信息和顺序关系,在特征提取的过程中可以准确捕获 特征的绝对位置信息。

在更具体的技术方案中,所述步骤S2包括:

S21、给定输入图像

S22、通过特征提取器f

S23、将提取到的所述特征图输入位置编码模块(PEM),以双线性插值处理所述特征 图,据以得到相同空间维度特征图;

S24、拼接所述相同空间维度特征图,从而得到了拼接特征图

本发明为了适配不同分辨率输入的需要,本发明采用流行的卷积位置编码(CPE)来获取图像特征的位置信息。卷积位置编码(CPE)通过使用深度卷积来对图像特征进 行位置编码,可以帮助每个特征确定自己的绝对位置,相比常规的卷积操作,其参数量 和运算成本较低,减少了内存占用量。由于卷积的共享参数和局部性,CPE可以克服置 换不变性,并且对任意输入长度都很友好。

在更具体的技术方案中,所述步骤S24包括:

S241、以下述逻辑处理所述相同空间维度特征图,从而得到了拼接特征图

S242、对所述拼接特征图

在更具体的技术方案中,所述局部特征提取LFE层采用深度可分离卷积来提取图像 特征的局部纹理信息,其中,深度可分离卷积包括:深度卷积和逐点卷积,逐点卷积使用1×1的卷积核对不同通道上的特征图进行线性组合并输出,将经过位置编码后的特 征图进行卷积操作,逐点卷积对不同深度的特征进行线性组合,在对特征图卷积的过程 中分类通道和区域。

本发明将经过位置编码后的特征图进行卷积操作,逐点卷积对不同深度的特征进行 线性组合,使得特征图在卷积过程中实现通道和区域的分离,且深度可分离卷积的参数量和计算量比标准卷积的参数量和计算量更少,通过减少方法的参数量和提高方法的运算速度。

在更具体的技术方案中,在进行所述深度可分离卷积之前,添加了一个1×1的逐点卷积来升维。

在更具体的技术方案中,分别在所述L-Conv模块和所述Transformer模块中的每个 输出上添加残差函数及归一化结构。

本发明在进行深度可分离卷积之前,添加了一个1×1的逐点卷积来升维,使深度卷积能够捕获高维空间中丰富的语义信息;另外,本发明分别在L-Conv模块和Transformer模块中的每个输出上都添加了残差函数和归一化结构,能够防止网络退化 和梯度消失。

在更具体的技术方案中,全局特征提取(GFE)层采用Transformer网络结构,所 述Transformer包括:多头自注意力层和前馈网络层,每个子层前后都添加了正则化层 和残差连接层,在所述前馈网络层使用GELU激活函数进行线性变换。

本发明的每个子层前后都添加了正则化层和残差连接层以避免梯度消失和网络退 化,本发明在前馈网络层使用GELU激活函数进行线性变换,GELU激活函数中引入了随机正则的思想,增强了方法泛化能力,优化了遥感图像的分类效果。

在更具体的技术方案中,所述步骤S3包括:

S31、分别对RSSCN7和AID遥感图像数据集进行交叉迁移学习,以获取预训练的权重系数,以下述逻辑将权重系数W

q

k

v

,其中,x

S32、利用所述特征向量q

,其中,d

S33、使用Softmax函数对所述向量点积a

S34、以下述逻辑利用所述Softmax处理结果

S35、如果将所述特征向量q

S36、以下述逻辑拼接所述多头特征向量q

MultiHead(Q,K,V)=Concat(h

,其中,Q,K,V分别是查询向量、键向量和值向量,W

S37、对所述最终多头自注意力值进行归一化处理及残差处理,以得到所述最终预测结果。

本发明在方法训练过程中引入了迁移学习,使用预先训练好的权值代替网络中随机 初始化的权值,在不影响分类准确率的情况下,加快收敛速度,减少训练时间。对网络中的参数进行微调的方法是迁移学习应用中最常见的一种学习策略,它可以缩短网络方法训练所花费的时间,节约了大量的计算资源和时间、空间成本。

本发明采用的多头自注意力是Transformer的核心思想,被用于计算特征向量之间 的相关程度,使得不同的自注意力机制关注不同层次的空间信息,从而在特征向量之间建立长距离全局依赖关系,提高方法的特征提取能力,提升了遥感图像分类的准确率。

本发明在训练过程中引入了残差结构和迁移学习,以防止网络退化和加快模型收敛 速度。整个多头自注意力模块通过计算得到的结果进行归一化运算,并引入残差模块,以防止网络的退化问题。

在更具体的技术方案中,一种基于卷积Transformer的遥感图像分类系统包括:

一层卷积模块,用以将预设大小的特征图经过第一层卷积后得到预设大小的一层卷 积特征图;

L-Conv模块,用以将所述一层卷积特征图输入到L-Conv模块中,以不少于2个的所述L-Conv模块处理所述一层卷积特征图,以得到L-Conv处理特征图,其中,所述 L-Conv模块包括:卷积位置编码CPE层和局部特征提取LFE层,所述卷积位置编码CPE 层通过深度卷积获取图像中特征的绝对位置信息,所述局部特征提取LFE层采用深度可 分离卷积降维处理所述一层卷积特征图,进入第二层,第二层的卷积步长为2,对所述 L-Conv处理特征图进行第二层卷积处理,以得到二层卷积处理特征图,以不少于2个的 所述L-Conv模块连续处理所述二层卷积处理特征图,以得到二层卷积特征图,所述 L-Conv模块与所述一层卷积模块连接;

Transformer模块,用以将所述二层卷积特征图输入Transformer模块,其中,所述Transformer模块包括:轻量级的卷积位置编码CPE层和全局特征提取GFE层,所述 轻量级的卷积位置编码CPE层通过深度卷积来编码特征的位置信息,所述全局特征提取 GFE层利用多头自注意力层对深层图像特征的长距离全局信息建模,以预设数目的所述Transformer模块连续处理所述所述二层卷积特征图,以得到轻量卷积特征图,平均池 化所述轻量卷积特征图并经预置全连接层处理输出最终预测结果,所述Transformer模 块与所述L-Conv模块连接。

本发明相比现有技术具有以下优点:

本发明首先使用轻量级卷积神经网络代替CNN来提取图像的局部特征,使得在卷积 过程中实现通道和区域的分离,降低了运算量和参数量;其次将得到的局部特征输入到CNN融合多头自注意力机制的混合网络中以增强对图像全局特征的提取能力;最后将获 得的特征输出进行图像分类。本发明中的L-CT(Lightweight Convolutional Transformer,L-CT,轻量级卷积)不仅在浅层能够获取图像特征的局部纹理信息,而 且在深层也能捕获图像特征的全局语义信息,同时兼备CNN和Transformer的优点,使 得网络轻量又高效,提升了算法的鲁棒性。本发明与其他常用的图像分类方法相比,在 减少参数量和计算成本的同时能够高效地提取包括遥感图像在内的各种图像的局部特 征信息和长距离全局依赖信息,能够获得更高的图像分类准确率,从而验证了本方法的 轻量高效性与可行性。

本发明为了捕获这些特征向量的位置关系,本发明在L-CT中引入了位置编码,位置 编码能够学习图像特征的时间维度信息和顺序关系,在特征提取的过程中可以准确捕获 特征的绝对位置信息。

本发明为了适配不同分辨率输入的需要,本发明采用流行的卷积位置编码(CPE)来获取图像特征的位置信息。卷积位置编码(CPE)通过使用深度卷积来对图像特征进 行位置编码,可以帮助每个特征确定自己的绝对位置,相比常规的卷积操作,其参数量 和运算成本较低,减少了内存占用量。由于卷积的共享参数和局部性,CPE可以克服置 换不变性,并且对任意输入长度都很友好。

本发明将经过位置编码后的特征图进行卷积操作,逐点卷积对不同深度的特征进行 线性组合,使得特征图在卷积过程中实现通道和区域的分离,且深度可分离卷积的参数量和计算量比标准卷积的参数量和计算量更少,通过减少方法的参数量和提高方法的运算速度。

本发明在进行深度可分离卷积之前,添加了一个1×1的逐点卷积来升维,使深度卷积能够捕获高维空间中丰富的语义信息;另外,本发明分别在L-Conv模块和Transformer模块中的每个输出上都添加了残差函数和归一化结构,能够防止网络退化 和梯度消失。

本发明的每个子层前后都添加了正则化层和残差连接层以避免梯度消失和网络退 化,本发明在前馈网络层使用GELU激活函数进行线性变换,GELU激活函数中引入了随机正则的思想,增强了方法泛化能力,优化了遥感图像的分类效果。

本发明在方法训练过程中引入了迁移学习,使用预先训练好的权值代替网络中随机 初始化的权值,在不影响分类准确率的情况下,加快收敛速度,减少训练时间。对网络中的参数进行微调的方法是迁移学习应用中最常见的一种学习策略,它可以缩短网络方法训练所花费的时间,节约了大量的计算资源和时间、空间成本。

本发明采用的多头自注意力是Transformer的核心思想,被用于计算特征向量之间 的相关程度,使得不同的自注意力机制关注不同层次的空间信息,从而在特征向量之间建立长距离全局依赖关系,提高方法的特征提取能力,提升了遥感图像分类的准确率。

本发明在训练过程中引入了残差结构和迁移学习,以防止网络退化和加快模型收敛 速度。整个多头自注意力模块通过计算得到的结果进行归一化运算,并引入残差模块,以防止网络的退化问题。本发明解决了现有技术中存在的自注意力时间复杂度的增加、 计算成本较高、分类准确率不高及鲁棒性低的技术问题。

附图说明

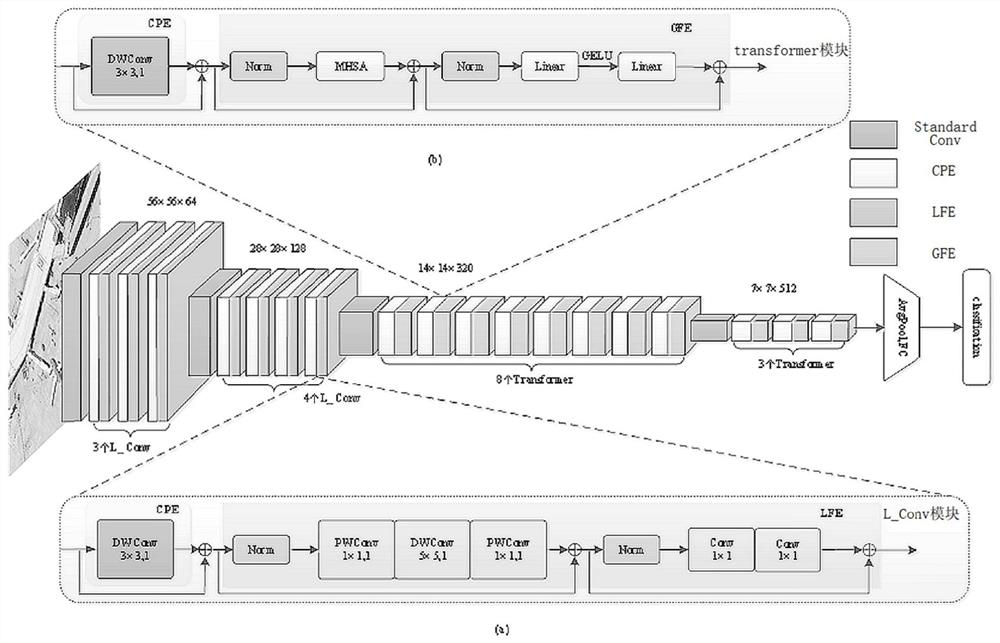

图1为本发明实施例1的L-CT整体网络结构示意图;

图2为本发明实施例2的卷积位置编码的网络结构示意图;

图3为本发明实施例2的深度可分离卷积网络结构示意图;

图4为本发明实施例2的自注意力的网络结构示意图;

图5为本发明实施例2的多头自注意力的网络结构示意图;

图6为本发明实施例3的RSSCN7数据集中的遥感图像示意图;

图7为本发明实施例3的AID数据集中的遥感图像示意图;

图8为本发明实施例3的Loss随Iteration time变化曲线图;

图9为本发明实施例3的Accuracy随Iteration time变化曲线图;

图10为本发明实施例3的不同分类方法在RSSCN7数据集上的参数量和计算量第一对比图;

图11为本发明实施例3的不同分类方法在RSSCN7数据集上的参数量和计算量第二对比图。

具体实施方式

为使本发明实施例的目的、技术方案和优点更加清楚,下面将结合本发明实施例,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例是本发明 一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在 没有作出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

实施例1

如图1所示,基于轻量级卷积Transformer的遥感图像分类方法,在本实施例中,该方法适用的分类对象包括但不限于:遥感图像。本发明的基于轻量级卷积Transformer的遥感图像分类方法中的主干网络结构包括:

轻量级卷积Transformer(Lightweight Convolutional Transformer,L-CT)主要由局 部卷积(Local Convolution,L-Conv)模块和Transformer模块组成。L-CT的整体网络结构 如图1所示。

L-CT主要包含4层,每层都包含一个常规卷积以改变特征图的通道数和像素大小。第一层的卷积核大小为4×4,步长为4,通道数为64,首先将大小为224×224×3的特 征图经过第一层卷积后得到的特征图大小为56×56×64,之后将得到的特征图输入到由 卷积位置编码(Convolution Position Encoding,CPE)层和局部特征提取(Local FeatureExtraction,LFE)层组成的L-Conv模块中,如图1所示。CPE层使用深度卷积以获取图 像中特征的绝对位置信息,LFE层采用深度可分离卷积对特征图进行降维。在连续经过 3个L-Conv模块后进入第二层,第二层的卷积步长为2,经过第二层卷积后得到的特征 图大小为28×28×128,之后按照同样的方式连续经过4个L-Conv模块后进入第三层 和第四层,后两层的卷积步长均为2,将经过卷积操作后的特征图输入到由卷积位置编 码(ConvolutionPosition Encoding,CPE)层和全局特征提取(Global Feature Extraction, GFE)层组成的Transformer模块中,如图1所示。CPE层通过深度卷积来编码特征的 位置信息,GFE层通过在CNN的基础上引入多头自注意力实现对深层图像特征的长距 离全局信息建模。在分别经过8个和3个Transformer模块后,最后进入平均池化和全 连接层输出最终预测结果。此外,在训练过程中引入了残差结构和迁移学习,以防止网 络退化和加快模型收敛速度。L-CT不仅在浅层能够获取图像特征的局部纹理信息,而 且在深层也能捕获图像特征的全局语义信息,同时兼备CNN和Transformer的优点,使 得网络轻量又高效。

实施例2

卷积位置编码(CPE)层:

如图2所示,由于遥感图像具有复杂的整体结构和丰富的纹理特征,其特征向量之间存在着大量的位置信息,为了捕获这些特征向量的位置关系,本发明在L-CT中引入 了位置编码。位置编码能够学习图像特征的时间维度信息和顺序关系,在特征提取的过 程中可以准确捕获特征的绝对位置信息。传统的位置编码包含绝对位置编码、学习位置 向量和相对位置表达等方式,但缺乏一定的灵活性。为了适配不同分辨率输入的需要, 本发明采用流行的卷积位置编码(CPE)来获取图像特征的位置信息。卷积位置编码 (CPE)通过使用深度卷积来对图像特征进行位置编码,可以帮助每个特征确定自己的 绝对位置,相比常规的卷积操作,其参数量和运算成本较低,减少了内存占用量。由于 卷积的共享参数和局部性,CPE可以克服置换不变性,并且对任意输入长度都很友好, 因此所有特征都可以通过查询上下文信息来逐步统一编码自己的位置信息。卷积位置编 码公式如下:

CPE(X

其中

其中,

局部特征提取(LFE)层:

如图3所示,LFE层主要借鉴了mobilenetv2的线性瓶颈结构。线性瓶颈结构采用深度可分离卷积(Depthwise Separable Convolution)来提取图像特征的局部纹理信息,其中,深度可分离卷积包含深度卷积(Depthwise Convolution,DWConv)和逐点卷积(Pointwise Convolution,PWConv),逐点卷积使用1×1的卷积核对不同通道上的特征 图进行线性组合并输出。将经过位置编码后的特征图进行卷积操作,逐点卷积对不同深 度的特征进行线性组合,使得特征图在卷积过程中实现通道和区域的分离,以减少方法 的参数量和提高方法的运算速度。深度可分离卷积的网络结构如图3所示。为了使深度 卷积能够捕获高维空间中丰富的语义信息,本发明在进行深度可分离卷积之前,添加了 一个1×1的逐点卷积来升维;另外,为了防止网络退化和梯度消失,本发明分别在 L-Conv模块和Transformer模块中的每个输出上都添加了残差函数和归一化结构,如图 1所示。

为了证明深度可分离卷积网络具有轻量化的优点,假设深度卷积大小为D

N_DW=D

N_PW=C·N (5)

C_DW=D

C_PW=D

N_DPW=N_DW+N_PW (8)

C_DPW=C_DW+C_PW (9)

其中,N_DPW、C_DPW,N_DW、N_PW,C_DW、C_PW分别表示深度可分离卷积 的参数量、计算量,深度卷积的参数量、计算量,逐点卷积的参数量、计算量。为了验 证深度可分离卷积的参数量和计算量比标准卷积的参数量和计算量更少,假设标准卷积 的卷积核大小为D

N_Std=N·C·D

C_Std=D

其中N_Std、C_Std分别表示标准卷积的参数量和计算量,m、n分别表示深度可分离卷积与标准卷积的参数量和计算量的比值。输出通道数N通常设置较大,所以深度可分 离卷积的参数量和计算量均降低到标准卷积的

全局特征提取(GFE)层:

如图4所示,GFE层主要采用了Transformer网络结构,Transformer包含两个子层,多头自注意力层和前馈网络层,每个子层前后都添加了正则化层和残差连接层以避免梯度消失和网络退化,本发明在前馈网络层使用GELU激活函数进行线性变换,GELU激 活函数中引入了随机正则的思想,增强了方法泛化能力,实验效果更好,如图1所示。 多头自注意力是Transformer的核心思想,主要由多个自注意力连接构成,它被用于计 算特征向量之间的相关程度,使得不同的自注意力机制关注不同层次的空间信息,从而 在特征向量之间建立长距离全局依赖关系,提高方法的特征提取能力。每个自注意力都 通过q、k、v向量计算特征之间的相似度。

在图4中,x

q

k

v

其次利用q

其中d

然后使用Softmax函数对a

最后利用

如图5所示,多头自注意力是在自注意力的基础上引入了多个头得到的,其网络结构如图5所示。如果将上文中得到的q

MultiHead(Q,K,V)=Concat(h

其中,Q,K,V分别是查询向量(Query Vector)、键向量(Key Vector)和值向量(Value Vector),W

迁移学习:

完整地训练一个神经网络通常是很繁杂的过程,加快训练速度并使网络收敛不仅需 要足够多的数据集,而且会消耗大量的计算资源和训练时间,甚至会造成过拟合现象。基于此,在遥感图像应用中,本发明在方法训练过程中引入了迁移学习,使用预先训练 好的权值代替网络中随机初始化的权值,加快收敛速度,减少训练时间。对网络中的参 数进行微调的方法是迁移学习应用中最常见的一种学习策略,它可以缩短网络方法训练 所花费的时间,节约了大量的计算资源和时间、空间成本。

迁移学习在计算机视觉领域中得到了广泛的应用并取得了成功。近些年的研究表明,特征的可迁移性随着目标数据与预训练方法的训练数据的差异性减少而增大,证明 了即使两者有明显的领域差异,效果也比之前要好。在现实场景中应用迁移学习策略时, 需考虑预训练方法能否满足网络框架需求以及不满足时如何进行参数微调等问题,以使 方法达到更好的效果。因此,本发明使用相似任务作为预训练方法,分别对RSSCN7 和AID遥感图像数据集进行交叉迁移学习,在不影响分类准确率的情况下,以缩短训练 时间。

实施例3

实验分析:

实验数据:

如图6及图7所示,在本次实验中分别使用RSSCN7和AID遥感图像数据集作为 实验数据。RSSCN7数据集中共包含了2800张遥感图像,划分为7个典型的场景类别 —草地、森林、农田、停车场、住宅区、工业区和河湖,每个场景类别中包含了400张 遥感图像,每张图像的尺寸大小为400×400。RSSCN7数据集中的遥感图像数据如图6 所示。AID数据集中共包含了10000张遥感图像,划分为30个场景类别—飞机场、沙 滩、商业区、森林、桥梁等,每个场景类别中包含了220至420张遥感图像,每张图像 的尺寸大小为600×600。AID数据集中的遥感图像数据如图7所示。

由于RSSCN7和AID遥感图像数据集中图像场景类别不一致(RSSCN7为7种, AID为30种),因此,在网络参数训练和准确率测试阶段,这两个遥感图像数据集分 别单独用于网络的参数训练和准确率测试。对于每个数据集按照7:3的比例进行划分, 即随机抽取70%的数据作为训练集,30%的数据作为验证集来验证网络分类准确率。

本次实验选取ResNet50、VGG16、ViT等分类方法作为对比实验,以验证本发明提出的基于轻量级卷积Transformer的遥感图像分类方法的可行性和高效性。由于遥感图 像的尺寸大小在输入部分神经网络时会产生一定的限制,影响图像分类准确率,因此在 图像输入网络之前需进行图像预处理。通过图像预处理后,RSSCN7和AID数据集中遥 感图像的分辨率均为224×224。

本发明主要进行了三组实验:1)加载方法训练好的参数,采用选取的RSSCN7和AID遥感图像数据集的验证数据来测试遥感图像分类准确率;2)修改批次大小,测试不 同批次大小对遥感图像分类效果的影响;3)测试遥感图像分类的参数量和训练速度。

实验环境与超参数设置:

本发明实验选用pytorch框架,使用python3.8编程,硬件设备中CPU使用的是AMDRyzen 9 3900X,内存条大小为32GB,GPU型号为GeForce RTX 2080Ti,显存大小为 11GB,系统环境为Ubuntu18.04。训练过程中使用Adam优化器进行方法优化,对模型 中每个参数使用相同的学习率,其中学习率设置为0.0001、迭代次数设置为100、 Batch_size设置为32、图像分辨率设置为224×224。

实验结果分析:

本发明使用RSSCN7和AID遥感图像数据集作为本次实验的数据集。分别将两个 数据集中的每个场景类别通过图像预处理后按照7:3的比例划分为训练集和验证集,先 使用70%的训练集进行方法参数训练,然后将余下的30%的验证集用于测试网络分类 准确率。

不同分类方法在遥感数据集上的实验结果对比:

为了验证本发明方法在遥感图像数据集上的可行性与有效性,本发明选取ResNet50、VGG16、ViT等分类方法作为对比实验。不同的分类方法在RSSCN7和AID 遥感图像数据集上的实验结果如表1所示。由表1可知,本发明方法与其他图像分类方 法相比取得了较明显的效果,在RSSCN7和AID遥感图像数据集上达到了最高的分类 准确率,分别为98.21%和96.90%,与其他分类方法最高分类准确率相比分别提高了 1.31%和0.94%。ViT在RSSCN7和AID遥感图像数据集上取得了相对较低的分类准确 率,这是因为ViT在大数据集上的分类效果较明显,而在小数据集上的分类效果比较差, 准确率较低。由于ResNet50分类方法和VGG16主要是利用卷积层提取丰富的局部信息, 但是对于遥感图像的长距离全局建模能力较差,无法提取完整丰富的图像信息,因而分 类效果不理想。而本发明方法通过将轻量级卷积神经网络提取到的遥感图像局部特征输 入到CNN融合多头自注意力机制的混合网络中,使同时能够有效提取遥感图像的局部 特征和全局特征,实现更高的分类准确率。

表1不同分类方法在遥感图像数据集上的结果对比

3.3.2不同批次大小对遥感图像分类效果的影响

为了进一步验证本发明方法比其他图像分类方法具有更好的鲁棒性,本发明实验增 加了不同分类方法的不同批次大小对遥感图像数据集的分类效果的影响的实验,本次实 验选取的批次大小分别为4,8,16,32,数据集与上述分类准确率测试中的数据集相同。不 同分类方法的不同批次大小对遥感图像数据集的分类效果如表2、3、4、5所示。

由表中的结果可知,当输入样本数量分别为4,8,16,32时,本发明方法与其他图像分 类方法相比均取得了较明显的效果,在RSSCN7和AID遥感图像数据集上达到了最高 的分类准确率,分别为97.38%和96.10%、97.02%和96.63%、97.97%和96.66%、98.21%和96.90%,与其他图像分类方法最高分类准确率相比分别提高了3.69%和3.24%、0.48%和1.07%、1.55%和0.76%、1.31%和0.94%,进一步验证了本发明方法具有很强的鲁棒性。ResNet50方法和VGG16方法可以通过卷积有效地获取局部特征且降低局部冗余, 但有限的感受野使其无法捕获全局依赖关系;ViT方法凭借自注意力可以捕获特征的长 距离依赖,但在大型图像数据集上效果较好,对于中小型图像数据集并不友好。相比较 之下,本发明方法在浅层网络中引入轻量级卷积神经网络有效获取遥感图像的局部特 征,在深层网络中通过在CNN的基础上引入多头自注意力来增强对遥感图像全局特征 的提取,这样既能提取遥感图像的局部特征,又能对全局信息进行长距离建模,故本发 明方法较其他图像分类方法具有更强的鲁棒性和更高的分类准确率。

由表中的数据可知,当输入样本数量的大小为32时,本发明方法在RSSCN7和AID遥感图像数据集上的分类效果最优,分别为98.21%和96.90%。在训练过程中,输入批 次量的大小过小时,会造成训练时间过长,出现梯度震荡,从而不利于模型参数的收敛。

表2批次大小为4时,不同分类方法的分类效果对比

表3批次大小为8时,不同分类方法的分类效果对比

表4批次大小为16时,不同分类方法的分类效果对比

表5批次大小为32时,不同分类方法的分类效果对比

遥感图像分类的参数量与训练速度测试:

如图8及图9所示,在实验中,训练速度是指使用训练集数据进行训练时方法参数拟合的速度,本发明方法在训练过程中,损失值Loss和准确率Accuracy随迭代次数Iteration time的变化曲线分别如图8所示。由图8可以看出,本发明方法在RSSCN7遥 感图像数据集上收敛速度较快,可以看出在迭代次数约为7时,模型开始逐渐收敛,震 荡越来越弱,最终稳定在2.0左右;而在AID遥感图像数据集上收敛速度较慢,可以看 出在迭代次数约为22时,模型开始收敛,最终稳定在6.3左右。

如图10及图11所示,使用遥感数据集进行训练和测试,对ResNet50、VGG16、 ViT和本发明方法在RSSCN7遥感图像数据集上的参数量和计算速度进行结果对比,结 果如图9所示。由图9可知,本发明方法的参数量为22M,计算速度达到了3.6GFLOPs, 与其他分类方法中的最少参数量相比降低了3.56M,与ResNet50相比,两者的计算速 度基本一致,相较于其他分类方法,本发明方法的计算速度有很大提高。本发明方法有 效降低了参数量的同时也提高了计算速度,降低了空间复杂度。

本发明提出了一种基于轻量级卷积Transformer的遥感图像分类方法。该方法首先 使用轻量级卷积神经网络提取局部特征,其次将得到的局部特征输入到CNN融合多头自注意力机制的混合网络中以增强对图像全局特征的提取能力;然后在训练过程中引入迁移学习以加快收敛速度;最后将获得的特征输出进行分类预测。本发明采用RSSCN7 和AID遥感图像数据集进行实验,结果表明基于轻量级卷积Transformer的遥感图像分 类方法的准确率分别达到了98.21%和96.90%,本发明的一种基于轻量级卷积 Transformer的遥感图像分类方法与其他常用的图像分类方法相比,在减少参数量和计算 成本的同时能够高效地提取包括遥感图像在内的各种图像的局部特征信息和长距离全 局依赖信息,获得了更高的图像分类准确率,从而验证了本方法的轻量高效性与可行性。

综上,本发明首先使用轻量级卷积神经网络代替CNN来提取图像的局部特征,使得在卷积过程中实现通道和区域的分离,降低了运算量和参数量;其次将得到的局部特征 输入到CNN融合多头自注意力机制的混合网络中以增强对图像全局特征的提取能力;最 后将获得的特征输出进行图像分类。本发明中的L-CT(Lightweight ConvolutionalTransformer,L-CT,轻量级卷积)不仅在浅层能够获取图像特征的局部纹理信息,而且 在深层也能捕获图像特征的全局语义信息,同时兼备CNN和Transformer的优点,使得 网络轻量又高效,提升了算法的鲁棒性。

本发明为了捕获这些特征向量的位置关系,本发明在L-CT中引入了位置编码,位置 编码能够学习图像特征的时间维度信息和顺序关系,在特征提取的过程中可以准确捕获 特征的绝对位置信息。

本发明为了适配不同分辨率输入的需要,本发明采用流行的卷积位置编码(CPE)来获取图像特征的位置信息。卷积位置编码(CPE)通过使用深度卷积来对图像特征进 行位置编码,可以帮助每个特征确定自己的绝对位置,相比常规的卷积操作,其参数量 和运算成本较低,减少了内存占用量。由于卷积的共享参数和局部性,CPE可以克服置 换不变性,并且对任意输入长度都很友好。

本发明将经过位置编码后的特征图进行卷积操作,逐点卷积对不同深度的特征进行 线性组合,使得特征图在卷积过程中实现通道和区域的分离,且深度可分离卷积的参数量和计算量比标准卷积的参数量和计算量更少,通过减少方法的参数量和提高方法的运算速度。

本发明在进行深度可分离卷积之前,添加了一个1×1的逐点卷积来升维,使深度卷积能够捕获高维空间中丰富的语义信息;另外,本发明分别在L-Conv模块和Transformer模块中的每个输出上都添加了残差函数和归一化结构,能够防止网络退化 和梯度消失。

本发明的每个子层前后都添加了正则化层和残差连接层以避免梯度消失和网络退 化,本发明在前馈网络层使用GELU激活函数进行线性变换,GELU激活函数中引入了随机正则的思想,增强了方法泛化能力,优化了遥感图像的分类效果。

本发明在方法训练过程中引入了迁移学习,使用预先训练好的权值代替网络中随机 初始化的权值,在不影响分类准确率的情况下,加快收敛速度,减少训练时间。对网络中的参数进行微调的方法是迁移学习应用中最常见的一种学习策略,它可以缩短网络方法训练所花费的时间,节约了大量的计算资源和时间、空间成本。

本发明采用的多头自注意力是Transformer的核心思想,被用于计算特征向量之间 的相关程度,使得不同的自注意力机制关注不同层次的空间信息,从而在特征向量之间建立长距离全局依赖关系,提高方法的特征提取能力,提升了遥感图像分类的准确率。

本发明在训练过程中引入了残差结构和迁移学习,以防止网络退化和加快模型收敛 速度。整个多头自注意力模块通过计算得到的结果进行归一化运算,并引入残差模块,以防止网络的退化问题。本发明解决了现有技术中存在的自注意力时间复杂度的增加、 计算成本较高、分类准确率不高及鲁棒性低的技术问题。

以上实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述实施例对 本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换;而这些修改或 者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的精神和范围。

- 基于注意力机制和卷积神经网络高光谱遥感图像分类方法

- 一种基于畸变适应卷积神经网络的图像分类方法

- 基于卷积神经网络和Transformer的河湖遥感图像分割方法及系统

- 基于卷积神经网络和Transformer的河湖遥感图像分割方法及系统