基于深度学习模型驱动数字人肢体动作生成方法及系统

文献发布时间:2023-06-19 19:14:59

技术领域

本发明涉及人工智能技术领域,具体地,涉及一种基于深度学习模型驱动数字人肢体动作生成方法及系统。

背景技术

数字人是指利用计算机数字建模技术,通过图形学、图形渲染模拟人物形象,通过动作、面部捕捉等技术模拟真实人物表情神态特征,并运用深度学习、语音识别、语义理解、语音合成等计算机手段形成的具有多重人类特征(外貌特征、人类表演能力、人类交互能力等)的数字AI机器人。

专利文献CN114972923A公开了一种基于自监督学习的虚拟数字人肢体交互动作生成方法。所述方法包括:根据K3M人体3D骨架提取工具套件对肢体动作片段数据集进行数据处理,得到人体3D骨架帧的时序序列;利用对比训练法和人体3D骨架帧的时序序列对预先构建的自监督模型进行训练,得到3D骨架自监督模型;根据肢体交互动作序列对数据集对3D骨架自监督模型进行训练,得到肢体交互序列自编码模型;利用肢体交互序列自编码模型对虚拟数字人发出的动作指令进行语义特征编码和动作交互解码,得到虚拟数字人响应动作序列。

目前的数字人技术可以根据预先配置好的话术生成语音播报和相应的数字人形象展现。但是,缺少根据播报文本自动生成与之相对应的肢体动作的能力,增加与播报内容相匹配的肢体动作可以极大增强语言的表达能力,目前大多数的解决方案是在数字人播报时采用随机的肢体动作序列或者在配置的播报话术固定位置插入预先约定好的肢体动作标记,此种方案需要人工预先配置,而播报的话术文本和对应的肢体动作没有明确的对应关系,配置人员只能根据自己的感觉进行肢体动作的配置,不同的配置人员可能会有不同的配置效果。并且当面对需要实时播报的话术时则无法预先设置相应的肢体动作标记。

发明内容

针对现有技术中的缺陷,本发明的目的是提供一种基于深度学习模型驱动数字人肢体动作生成方法及系统。

根据本发明提供的一种基于深度学习模型驱动数字人肢体动作生成方法,包括:

步骤S1:获取深度学习信息和音视频数据;

步骤S2:将所述音视频数据分离处理,并根据所述深度学习信息得到肢体动作分类数据和文本数据;

步骤S3:将所述肢体动作分类数据和文本数据一一匹配,并建立文本和肢体动作对应的肢体动作标签相关联的二元组存入数据库中;

步骤S4:数字人播报时,判断是否能在所述数据库中查询到文本对应的肢体动作标签,若是,则用所述肢体动作标签驱动数字人展示对应的肢体动作;若否,则触发步骤S5;

步骤S5:根据语义相似性将所述文本与二元组中对应的肢体动作标签关联,驱动数字人展示对应的肢体动作,并更新所述数据库。

优选地,所述深度学习信息包括深度学习模型;

所述深度学习模型是通过卷积神经网络,建立多层级的卷积神经网络模型并训练所述卷积神经网络模型得到的。所述多层级的卷积神经网络模型具有多个卷积层和池化层;

所述深度学习模型能够进行肢体动作分类。

优选地,步骤S1包括:

步骤S1.1:获取真人播报图片数据,并对含有肢体动作的真人播报图片标注对应的肢体动作数据;

步骤S1.2:构建所述卷积神经网络模型,并初步设置所述模型中各个层级之间预训练的模型参数的权重;

步骤S1.3:根据标注的肢体动作数据训练所述卷积神经网络模型,其中,以所述含有肢体动作的真人播报图片作为所述卷积神经网络模型的输入,以所述肢体动作数据动作为所述卷积神经网络模型的输出;

步骤S1.4:将训练好的卷积神经网络模型在样本数据上进行模型的验证后确定具有良好分类效果的模型参数,从而得到深度学习模型。

优选地,步骤S2包括:

步骤S2.1:获取播报视频并分离出音频,从视频中进行抽帧得到关键帧图片;

步骤S2.2:通过语音识别从音频中识别出文本数据;

步骤S2.3:通过深度学习信息中训练后的深度学习信息模型对抽帧得到的关键帧图片进行肢体动作分类,得到肢体动作分类数据。

优选地,所述步骤S5包括:

步骤S5.1:使用词向量计算未查询到的文本与在数据库中已有关联关系的文本的相似度;

步骤S5.2:将所述未查询到的文本与计算相似度得到的文本对应的肢体动作标签关联,得到更新后的二元组

步骤S5.3:所述肢体动作标签驱动数字人展示相应的肢体动作,同时将更新后的二元组存储到数据库中。

根据本发明提供的一种基于深度学习模型驱动数字人肢体动作生成系统,包括:

模块M1:获取深度学习信息和音视频数据;

模块M2:将所述音视频数据分离处理,并根据所述深度学习信息得到肢体动作分类数据和文本数据;

模块M3:将所述肢体动作分类数据和文本数据一一匹配,并建立文本和肢体动作对应的肢体动作标签相关联的二元组存入数据库中;

模块M4:数字人播报时,判断是否能在所述数据库中查询到文本对应的肢体动作标签,若是,则用所述肢体动作标签驱动数字人展示对应的肢体动作;若否,则触发模块M5;

模块M5:根据语义相似性将所述文本与二元组中对应的肢体动作标签关联,驱动数字人展示对应的肢体动作,并更新所述数据库。

优选地,所述深度学习信息包括深度学习模型;

所述深度学习模型是通过卷积神经网络,建立多层级的卷积神经网络模型并训练所述卷积神经网络模型得到的。所述多层级的卷积神经网络模型具有多个卷积层和池化层;

所述深度学习模型能够进行肢体动作分类。

优选地,模块M1包括:

模块M1.1:获取真人播报图片数据,并对含有肢体动作的真人播报图片标注对应的肢体动作数据;

模块M1.2:构建所述卷积神经网络模型,并初步设置所述模型中各个层级之间预训练的模型参数的权重;

模块M1.3:根据标注的肢体动作数据训练所述卷积神经网络模型,其中,以所述含有肢体动作的真人播报图片作为所述卷积神经网络模型的输入,以所述肢体动作数据动作为所述卷积神经网络模型的输出;

模块M1.4:将训练好的卷积神经网络模型在样本数据上进行模型的验证后确定具有良好分类效果的模型参数,从而得到深度学习模型。

优选地,模块M2包括:

模块M2.1:获取播报视频并分离出音频,从视频中进行抽帧得到关键帧图片;

模块M2.2:通过语音识别从音频中识别出文本数据;

模块M2.3:通过深度学习信息中训练后的深度学习信息模型对抽帧得到的关键帧图片进行肢体动作分类,得到肢体动作分类数据。

优选地,所述模块M5包括:

模块M5.1:使用词向量计算未查询到的文本与在数据库中已有关联关系的文本的相似度;

模块M5.2:将所述未查询到的文本与计算相似度得到的文本对应的肢体动作标签关联,得到更新后的二元组;

模块M5.3:所述肢体动作标签驱动数字人展示相应的肢体动作,同时将更新后的二元组存储到数据库中。

与现有技术相比,本发明具有如下的有益效果:

1、本发明训练了一个可以进行肢体动作分类的深度学习模型,在数字人播报时,通过文本和肢体动作的关联关系,可以自适应的指导数字人肢体动作生成,并可以对识别效果进行自动完善,提高的数字人肢体动作的多样性和感官性。

2、本发明为数字人引入符合播报文本的肢体动作手段,增加了多模态数字人的表达能力,使数字人更拟人化,同时增加了人机交互友好性。

3、本发明根据公开的视频数据自动建立文本和肢体动作标签的对应关系,解决了以往需要大量的人工标注的问题,降低成本的同时提高了质量并增强了最终呈现的效果。

附图说明

通过阅读参照以下附图对非限制性实施例所作的详细描述,本发明的其它特征、目的和优点将会变得更明显:

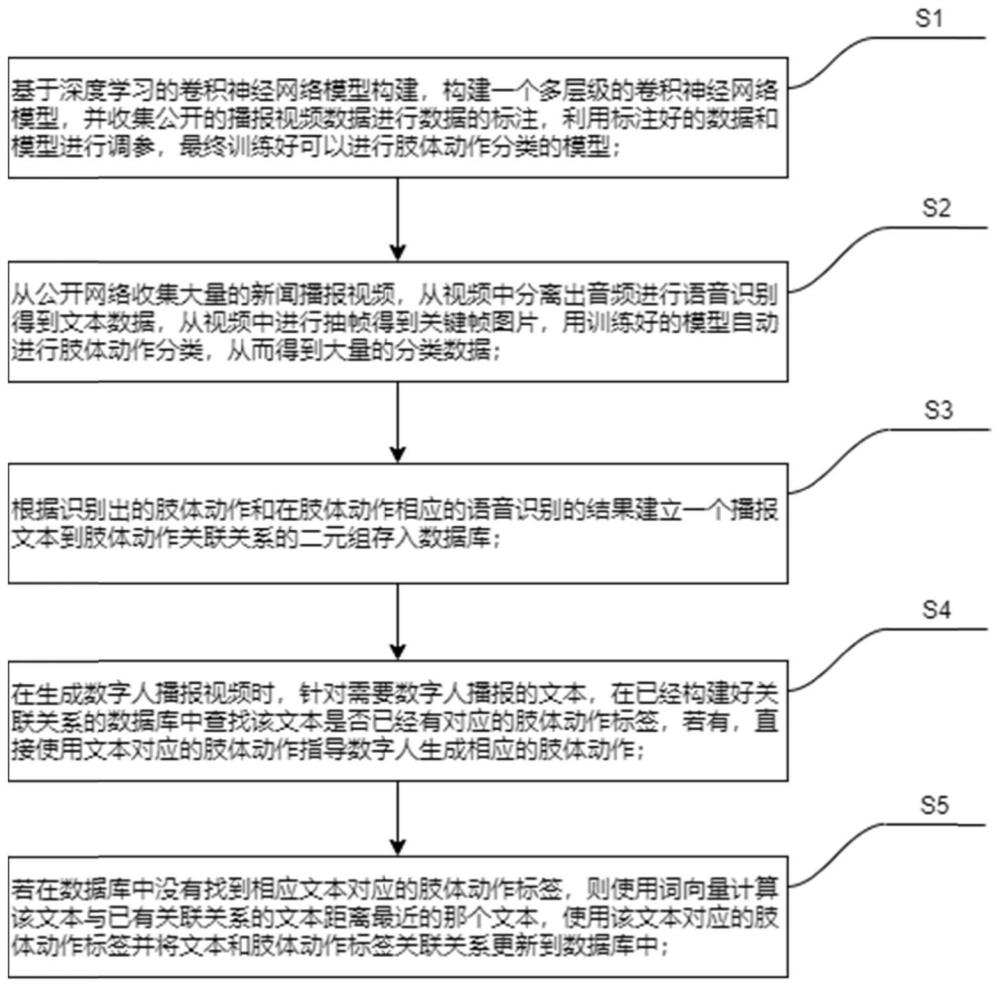

图1为本发明的流程示意图。

具体实施方式

下面结合具体实施例对本发明进行详细说明。以下实施例将有助于本领域的技术人员进一步理解本发明,但不以任何形式限制本发明。应当指出的是,对本领域的普通技术人员来说,在不脱离本发明构思的前提下,还可以做出若干变化和改进。这些都属于本发明的保护范围。

本发明涉及一种多模态数字人肢体动作的自适应生成方法,具体地,通过构建一个多层级的卷积神经网络,使用公开数据进行数据的标注,通过标注好的数据训练多层级的卷积神经网络,从而得到一个可以进行肢体动作分类的深度学习模型,在大量的公开数据上进行肢体动作的分类并关联播报文本,在数字人播报时,通过文本和肢体动作的关联关系并自适应的指导数字人肢体动作生成,并可以对识别效果进行自动完善。

实施例一

根据本发明提供的一种基于深度学习模型驱动数字人肢体动作生成方法,如图1所示,包括:

步骤S1:获取深度学习信息和音视频数据;具体地,构建一个多层级的卷积神经网络模型,并收集公开的播报视频数据进行数据的标注,利用标注好的数据和模型进行调参,最终训练出一个可以进行肢体动作分类的模型。

所述深度学习信息包括深度学习模型;所述深度学习模型是通过卷积神经网络,建立多层级的卷积神经网络模型并训练所述卷积神经网络模型得到的。所述多层级的卷积神经网络模型具有多个卷积层和池化层;所述深度学习模型能够进行肢体动作分类。步骤S1包括:

步骤S1.1:获取真人播报图片数据,并对含有肢体动作的真人播报图片标注对应的肢体动作数据。

步骤S1.2:构建所述卷积神经网络模型,并初步设置所述模型中各个层级之间预训练的模型参数的权重。

步骤S1.3:根据标注的肢体动作数据训练所述卷积神经网络模型,其中,以所述含有肢体动作的真人播报图片作为所述卷积神经网络模型的输入,以所述肢体动作数据动作为所述卷积神经网络模型的输出。

步骤S1.4:将训练好的卷积神经网络模型在样本数据上进行模型的验证后确定具有良好分类效果的模型参数,从而得到深度学习模型。

步骤S2:将所述音视频数据分离处理,并根据所述深度学习信息得到肢体动作分类数据和文本数据。具体地,从公开网络收集大量的新闻播报视频,从视频中分离出音频进行语音识别得到文本数据,从视频中进行抽帧得到关键帧图片,用训练好的模型自动进行肢体动作分类,从而得到大量的分类数据;步骤S2包括:

步骤S2.1:获取播报视频并分离出音频,从视频中进行抽帧得到关键帧图片。

步骤S2.2:通过语音识别从音频中识别出文本数据。

步骤S2.3:通过深度学习信息中训练后的深度学习信息模型对抽帧得到的关键帧图片进行肢体动作分类,得到肢体动作分类数据。

步骤S3:将所述肢体动作分类数据和文本数据一一匹配,并建立文本和肢体动作对应的肢体动作标签相关联的二元组存入数据库中;具体地,利用模型识别出的肢体动作分类关联语音文本得到大量的文本和肢体动作二元组,根据识别出的肢体动作和在肢体动作相应的语音处识别的结果建立一个播报文本到肢体动作关联关系的二元组存入数据库。

步骤S4:数字人播报时,判断是否能在所述数据库中查询到文本对应的肢体动作标签,若是,则用所述肢体动作标签驱动数字人展示对应的肢体动作;若否,则触发步骤S5;具体地,在生成数字人播报视频时,针对需要数字人播报的文本,在已经构建好关联关系的数据库中查找该文本是否已经有对应的肢体动作标签,若有,直接使用文本对应的肢体动作指导数字人生成相应的肢体动作。

步骤S5:根据语义相似性将所述文本与二元组中对应的肢体动作标签关联,驱动数字人展示对应的肢体动作,并更新所述数据库。具体地,假设未查询到文本为W1,计算相似的得到的文本为W2,所述W2文本是在数据库中已有关联关系的文本。进一步地,若在数据库中没有找到相应文本W1对应的肢体动作标签,则使用词向量计算该文本W1与已有关联关系的文本距离最近的那个文本W2,使用该文本W2对应的肢体动作标签并将文本和肢体动作标签关联关系更新到数据库中。所述步骤S5包括:

步骤S5.1:使用词向量计算未查询到的文本与在数据库中已有关联关系的文本的相似度。

步骤S5.2:将所述未查询到的文本与计算相似度得到的文本对应的肢体动作标签关联,得到更新后的二元组。

步骤S5.3:所述肢体动作标签驱动数字人展示相应的肢体动作,同时将更新后的二元组存储到数据库中。

本方法通过采用一个具有多个卷积层和池化层的卷积神经网络,使用公开的数据进行模型的训练,从而得到一个可以识别肢体动作的深度学习模型,并和识别出肢体动作附件的文本进行关联,从而得到一个文本和肢体动作关联关系,在后续数字人播报时使用构件好的关联关系指导数字人生成对应的肢体动作,从而使数字人得到较好的表达效果。

实施例二

本发明还提供了一种基于深度学习模型驱动数字人肢体动作生成系统,本领域技术人员可以通过执行所述基于深度学习模型驱动数字人肢体动作生成方法的步骤流程实现所述基于深度学习模型驱动数字人肢体动作生成系统,即可以将所述基于深度学习模型驱动数字人肢体动作生成方法理解为所述基于深度学习模型驱动数字人肢体动作生成系统的优选实施方式。

根据本发明提供的一种基于深度学习模型驱动数字人肢体动作生成系统,包括:

模块M1:获取深度学习信息和音视频数据;所述深度学习信息包括深度学习模型;所述深度学习模型是通过卷积神经网络,建立多层级的卷积神经网络模型并训练所述卷积神经网络模型得到的。所述多层级的卷积神经网络模型具有多个卷积层和池化层;所述深度学习模型能够进行肢体动作分类。模块M1包括:

模块M1.1:获取真人播报图片数据,并对含有肢体动作的真人播报图片标注对应的肢体动作数据。

模块M1.2:构建所述卷积神经网络模型,并初步设置所述模型中各个层级之间预训练的模型参数的权重。

模块M1.3:根据标注的肢体动作数据训练所述卷积神经网络模型,其中,以所述含有肢体动作的真人播报图片作为所述卷积神经网络模型的输入,以所述肢体动作数据动作为所述卷积神经网络模型的输出。

模块M1.4:将训练好的卷积神经网络模型在样本数据上进行模型的验证后确定具有良好分类效果的模型参数,从而得到深度学习模型。

模块M2:将所述音视频数据分离处理,并根据所述深度学习信息得到肢体动作分类数据和文本数据;模块M2包括:

模块M2.1:获取播报视频并分离出音频,从视频中进行抽帧得到关键帧图片。模块M2.2:通过语音识别从音频中识别出文本数据。模块M2.3:通过深度学习信息中训练后的深度学习信息模型对抽帧得到的关键帧图片进行肢体动作分类,得到肢体动作分类数据。

模块M3:将所述肢体动作分类数据和文本数据一一匹配,并建立文本和肢体动作对应的肢体动作标签相关联的二元组存入数据库中。

模块M4:数字人播报时,判断是否能在所述数据库中查询到文本对应的肢体动作标签,若是,则用所述肢体动作标签驱动数字人展示对应的肢体动作;若否,则触发模块M5。

模块M5:根据语义相似性将所述文本与二元组中对应的肢体动作标签关联,驱动数字人展示对应的肢体动作,并更新所述数据库。所述模块M5包括:模块M5.1:使用词向量计算未查询到的文本与在数据库中已有关联关系的文本的相似度;模块M5.2:将所述未查询到的文本与计算相似度得到的文本对应的肢体动作标签关联,得到更新后的二元组。模块M5.3:所述肢体动作标签驱动数字人展示相应的肢体动作,同时将更新后的二元组存储到数据库中。

本领域技术人员知道,除了以纯计算机可读程序代码方式实现本发明提供的系统、装置及其各个模块以外,完全可以通过将方法步骤进行逻辑编程来使得本发明提供的系统、装置及其各个模块以逻辑门、开关、专用集成电路、可编程逻辑控制器以及嵌入式微控制器等的形式来实现相同程序。所以,本发明提供的系统、装置及其各个模块可以被认为是一种硬件部件,而对其内包括的用于实现各种程序的模块也可以视为硬件部件内的结构;也可以将用于实现各种功能的模块视为既可以是实现方法的软件程序又可以是硬件部件内的结构。

以上对本发明的具体实施例进行了描述。需要理解的是,本发明并不局限于上述特定实施方式,本领域技术人员可以在权利要求的范围内做出各种变化或修改,这并不影响本发明的实质内容。在不冲突的情况下,本申请的实施例和实施例中的特征可以任意相互组合。

- 基于API函数调用的三维数字化仿真模型驱动的系统开发方法

- 基于全景肢体动作的交互方法及系统

- 基于深度学习的3D虚拟数字人交互动作生成方法及系统

- 基于自监督学习的虚拟数字人肢体交互动作生成方法