一种视频处理的方法以及装置

文献发布时间:2023-06-19 11:39:06

技术领域

本发明实施例涉及计算机视觉领域,尤其涉及一种视频处理的方法及装置。

背景技术

计算机视觉是各个应用领域,如制造业、检验、文档分析、医疗诊断,和军事等领域中各种智能/自主系统中不可分割的一部分,它是一门关于如何运用照相机/摄像头和计算机来获取我们所需的,被拍摄对象的数据与信息的学问。形象地说,就是给计算机安装上眼睛(照相机/摄像头)和大脑(算法)用来代替人眼对目标进行识别、跟踪和测量等,从而使计算机能够感知环境。因为感知可以看作是从感官信号中提取信息,所以计算机视觉也可以看作是研究如何使人工系统从图像或多维数据中“感知”的科学。总的来说,计算机视觉就是用各种成象系统代替视觉器官获取输入信息,再由计算机来代替大脑对这些输入信息完成处理和解释。计算机视觉的最终研究目标就是使计算机能像人那样通过视觉观察和理解世界,具有自主适应环境的能力。

目前越来越多的移动终端使用双目摄像头同时拍摄得到双目视频(stereovideo)。为了提高移动终端的移动性和便携性,移动终端的体积通常比较小,导致双目摄像头的体积也不能设置的过大。由于双目摄像头的性能与双目摄像头的体积密切相关,导致安装于移动终端的双目摄像头拍摄的视频质量仍然不够高,尤其在光照条件受限的场景下,通过双目摄像头拍摄的视频具有高噪声、解析力较低、细节缺失、偏色等问题。

发明内容

本申请提供一种视频处理的方法以及装置,可以提升双目摄像头拍摄得到的双目视频的质量。

为解决上述技术问题,本申请实施例提供以下技术方案:

第一方面,本申请提供一种视频处理的方法,包括:获取第一特征序列和第二特征序列,第一特征序列是对第一摄像头采集的视频进行特征提取后获取的,第二特征序列是对第二摄像头采集的视频进行特征提取后获取的,第一摄像头和第二摄像头是帧同步的,第一摄像头和第二摄像头的感知范围是交叉的。第一摄像头可以是RGB摄像头、黑白摄像头、红外摄像头中的任意一种,第二摄像头可以是RGB摄像头、黑白摄像头、红外摄像头中的任意一种。本申请提供的方案可以通过多种特征提取模型对双目摄像头采集的视频进行特征提取。比如,该特征提取模型可以是卷积神经网络(convolutional neuron network,CNN)、深度神经网络(deep neural network,DNN)等等。如果需要对第一摄像头采集的视频进行视频增强,则从第一特征序列中选择多个特征作为参考特征。如果需要对第二摄像头采集的视频进行视频增强,则从第二特征序列中选择多个特征作为参考特征。在一个可能的实施方式中,可以从第一特征序列中选择预设数目的特征作为参考特征。在一个可能的实施方式中,可以将第一特征序列中的每个特征都作为参考特征。从第一特征序列中选择的参考特征数目越多,越有利于提升第一视频的质量,使第一视频携带更多的信息。

对每个参考特征和待融合特征进行融合处理,以获取更新后的每个参考特征,待融合特征包括第一特征序列中除每个参考特征之外的其他至少一个特征,待融合特征还包括第二特征序列中的至少一个特征。在一个可能的实施方式中,待融合特征还可以包括每个参考特征本身。可以通过多种方式对参考特征和待融合特征进行融合处理。比如,如果参考特征和待融合特征的时间戳相同,则可以对参考特征和待融合特征进行加权处理。根据全部参考特征的时间戳的先后顺序,对全部更新后的参考特征进行排序,以获取融合特征序列。每一个参考特征都可以获取至少一个更新后的参考特征,根据参考特征的时间戳从前到后的顺序,可以对全部更新后的参考特征进行排序处理,以获取融合特征序列。该融合特征序列可以用于获取第一视频的增强视频,如果将该特征序列按照预设的高分辨率输出,则可以提升对第一视频进行超分辨率处理后获取的视频的质量。在这种实施方式中,通过从第一特征序列或者第二特征序列中选择多个特征作为参考帧,将第一特征序列或者第二特征序列中的其他特征融合到该参考帧上,可以同时利用双目摄像头采集的视频帧之间的互补信息以及帧间时序信息,对双目摄像头采集的视频进行增强,提升双目摄像头采集的视频的质量。本申请提供的方案可以用于对双目摄像头采集的视频进行去燥、去模糊或者进行超分辨率处理等多种应用场景中。

在第一方面的一种可能实现方式中,对每个参考特征和待融合特征进行融合处理,以获取更新后的每个参考特征,包括:通过多个首尾相连的模型对每个参考特征和待融合特征进行融合处理,多个模型中的最后一个模型的输出用于获取更新后的每个参考特征,其中,多个模型中的任意一个模型,用于执行下述流程:对每个参考特征和目标特征进行融合处理,以获取任意一个模型的输出,其中,任意一个模型是多个模型中的第一个模型时,目标特征是每个待融合特征,任意一个模型是多个模型中除第一个模型之外的其他模型时,目标特征是任意一个模型的前一个模型的输出。在这种实施方式中,通过引入多个目标模型,逐步深入挖掘双目摄像头采集的视频帧之间的互补信息以及帧间时序信息,将双目摄像头采集的视频帧之间的互补信息以及帧间时序信息逐步的迁移到参考特征上。

在第一方面的一种可能实现方式中,如果参考特征和待融合特征的时间戳不相同,则参考特征和待融合特征之间的携带的信息可能会有差异,不适合直接对参考特征和待融合特征直接进行加权处理。实际上,参考特征和待融合特征的时间戳相同时,由于参考特征和待融合特征帧是来自两个不相同的摄像头,导致具有相同时间戳的参考特征和待融合特征携带的信息也可能会有差异。为了解决这一问题,对每个参考特征和目标特征进行融合处理,以获取任意一个模型的输出,包括:对每个参考特征和目标特征进行配准处理,以获取配准后的每个参考特征和配准后的目标特征。根据目标参数对配准后的每个参考特征和配准后的目标特征进行融合处理,以获取任意一个模型的输出,目标参数是根据每个参考特征和目标特征之间的差异确定的。通过这种方式,可以更好的利用待融合特征携带的信息对参考帧进行更新,

在第一方面的一种可能实现方式中,方法还包括:对每个参考特征进行下采样,以获取下采样后的每个参考特征。对待融合特征进行下采样,以获取下采样后的待融合特征。对每个参考特征和待融合特征进行融合处理,以获取更新后的每个参考特征,包括:对下采样后的每个参考特征和下采样后的待融合特征进行融合处理,以获取第一结果。对每个参考特征和待融合特征进行融合处理,以获取第二结果。对第一结果和第二结果进行融合处理,以获取更新后的每个参考特征。通过下采样的方式,从粗到细深入挖掘双目摄像头采集的视频帧之间的互补信息以及帧间时序信息,以提升对双目视频的增强效果。

在第一方面的一种可能实现方式中,根据全部参考特征的时间戳的先后顺序,对全部更新后的参考特征进行排序,以获取融合特征序列,包括:对全部更新后的参考特征进行自注意力计算,以获取每个更新后的参考特征的目标表示。根据全部参考特征的时间戳的先后顺序,对全部更新后的参考特征的目标表示进行排序,以获取融合特征序列。

在第一方面的一种可能实现方式中,多个特征包括第一特征序列中的每个特征,待融合特征包括第一特征序列中除每个参考特征之外的其他全部特征,待融合特征还包括第二特征序列中的全部特征。

在第一方面的一种可能实现方式中,方法还包括:根据融合特征序列对第一摄像头采集的视频进行超分辨处理。

第二方面,本申请提供一种视频处理的装置,包括:特征提取模块,用于获取第一特征序列和第二特征序列,第一特征序列是对第一摄像头采集的视频进行特征提取后获取的,第二特征序列是对第二摄像头采集的视频进行特征提取后获取的,第一摄像头和第二摄像头是帧同步的,第一摄像头和第二摄像头的感知范围是交叉的。特征处理模块,用于:从特征提取模块获取的第一特征序列中选择多个特征作为参考特征。对每个参考特征和待融合特征进行融合处理,以获取更新后的每个参考特征,待融合特征包括第一特征序列中除每个参考特征之外的其他至少一个特征,待融合特征还包括第二特征序列中的至少一个特征。根据全部参考特征的时间戳的先后顺序,对全部更新后的参考特征进行排序,以获取融合特征序列。

在第二方面的一种可能实现方式中,特征处理模块,具体用于:通过多个首尾相连的模型对每个参考特征和待融合特征进行融合处理,多个模型中的最后一个模型的输出用于获取更新后的每个参考特征,其中,多个模型中的任意一个模型,用于执行下述流程:对每个参考特征和目标特征进行融合处理,以获取任意一个模型的输出,其中,任意一个模型是多个模型中的第一个模型时,目标特征是每个待融合特征,任意一个模型是多个模型中除第一个模型之外的其他模型时,目标特征是任意一个模型的前一个模型的输出。

在第二方面的一种可能实现方式中,特征处理模块,具体用于:对每个参考特征和目标特征进行配准处理,以获取配准后的每个参考特征和配准后的目标特征。根据目标参数对配准后的每个参考特征和配准后的目标特征进行融合处理,以获取任意一个模型的输出,目标参数是根据每个参考特征和目标特征之间的差异确定的。

在第二方面的一种可能实现方式中,特征处理模块,还用于:对每个参考特征进行下采样,以获取下采样后的每个参考特征。对待融合特征进行下采样,以获取下采样后的待融合特征。特征处理模块,具体用于:对下采样后的每个参考特征和下采样后的待融合特征进行融合处理,以获取第一结果。对每个参考特征和待融合特征进行融合处理,以获取第二结果。对第一结果和第二结果进行融合处理,以获取更新后的每个参考特征。

在第二方面的一种可能实现方式中,特征处理模块,具体用于:对全部更新后的参考特征进行自注意力计算,以获取每个更新后的参考特征的目标表示。根据全部参考特征的时间戳的先后顺序,对全部更新后的参考特征的目标表示进行排序,以获取融合特征序列。

在第二方面的一种可能实现方式中,多个特征包括第一特征序列中的每个特征,待融合特征包括第一特征序列中除每个参考特征之外的其他全部特征,待融合特征还包括第二特征序列中的全部特征。

在第二方面的一种可能实现方式中,还包括超分辨率处理模块,用于根据融合特征序列对第一摄像头采集的视频进行超分辨处理。

第三方面,本申请提供一种视频处理的装置,包括处理器,处理器和存储器耦合,存储器存储有程序指令,当存储器存储的程序指令被处理器执行时实现权利要求1至7中任一项的方法。

在第三方面的一种可能实现方式中,视频处理的装置是移动终端、智能车、电视、遥感设备、智能监控设备、AR设备或者VR设备。

第四方面,本申请提供一种计算机可读存储介质,包括程序,当其在计算机上运行时,使得计算机执行如第一方面或第一方面任意一种可能的实施方式中的方法。

第五方面,本申请提供一种电路系统,电路系统包括处理电路,处理电路配置为执行如第一方面或第一方面任意一种可能的实施方式中的方法。

第六方面,本申请提供一种计算机程序产品,计算机程序产品包括指令,当指令由电子设备加载并执行,使电子设备执行第一方面或第一方面任意一种可能的实施方式中的方法。

第七方面,本申请提供一种芯片,芯片与存储器耦合,用于执行存储器中存储的程序,以执行如第一方面或第一方面任意一种可能的实施方式中的方法。

对于本申请第二方面至第七方面以及各种可能实现方式的具体实现步骤,以及每种可能实现方式所带来的有益效果,均可以参考第一方面中各种可能的实现方式中的描述,此处不再一一赘述。

附图说明

图1为对双目摄像头采集的视频进行超分辨率处理的方式的示意图;

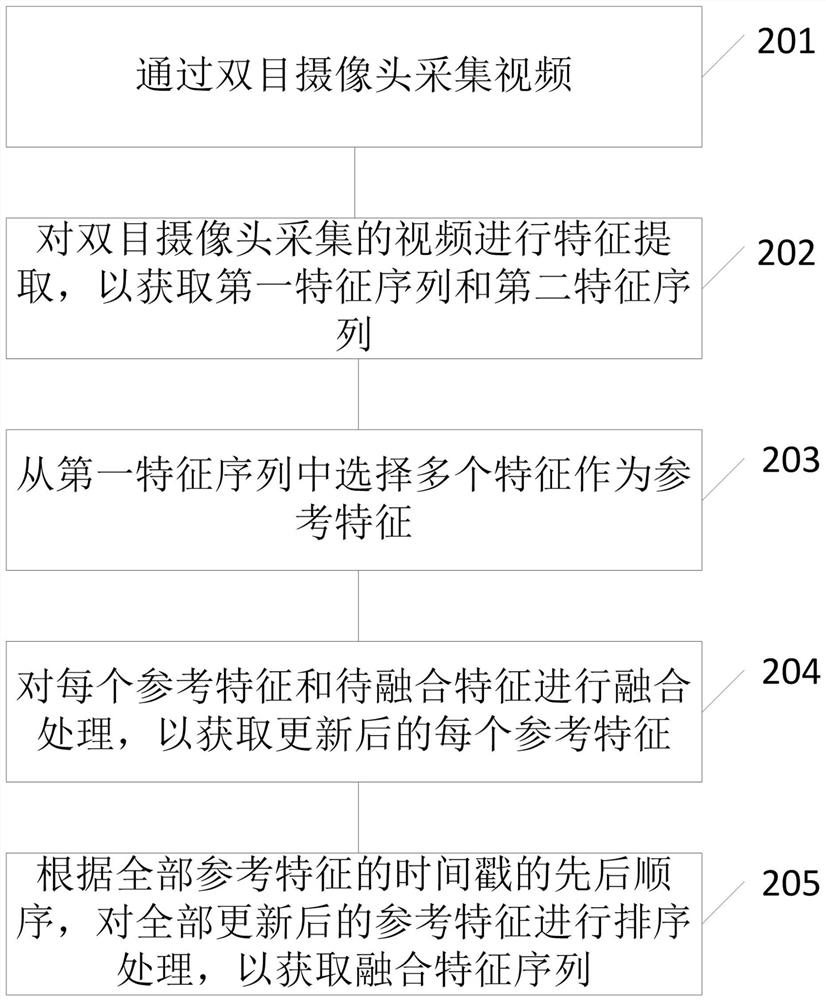

图2为本申请实施例提供的视频处理方法的一种流程示意图;

图3为通过卷积神经网络进行视频特征提取的示意图;

图4为另一种对一个参考特征和一个待融合特征进行融合处理的示意图;

图5为本申请实施例提供的视频处理方法的一种流程示意图;

图6为通过多个首尾相连的目标模型获取更新后的每个参考特征的架构图;

图7为本申请实施例提供的视频处理方法的另一种流程示意图;

图8为本申请实施例提供的视频处理方法的另一种流程示意图;

图9为本申请实施例提供的视频处理方法的另一种流程示意图;

图10为本申请实施例提供的视频处理方法的测试实验效果图;

图11为本申请实施例提供的一种视频处理的装置的结构示意图;

图12为本申请实施例提供的一种电子设备的结构示意图。

具体实施方式

对双目摄像头采集的视频进行超分辨率处理的方法正处于起步阶段。本申请实施例提供了一种视频处理的方法,可以显著提升双目摄像头拍摄的视频的质量,进而可以提升对双目摄像头采集的视频进行超分辨率处理后的视频的精度。

在电子图像/视频应用领域,人们经常期望得到高分辨率(high resolution,HR)图像/视频。然而,受限于成像设备的成本过高或物理条件约束等问题,用户可能仅能获取到低分辨率的图像/视频,因此,为了获得高分辨率的图像/视频,需要一种技术,能够对该低分辨率的视频进行处理以获取到期望的高分辨率图像/视频。

视频超分辨率(super resolution,SR)重建技术就是将低分辨率(lowresolution,LR)的图像/视频(如1080P:1920x1080)通过一定的算法重建提升到HR的图像/视频(如4K:3840x2160)。

如图1中的子图a至子图c展示了几种对双目摄像头采集的视频进行超分辨率处理的方式。如子图a所示,假设双目摄像头采集的视频包括第一视频和第二视频。其中,第一视频中包括时间戳相邻的视频帧:L1帧、L2帧以及L3帧;第二视频包括时间戳相邻的视频帧:R1帧、R2帧以及R3帧。其中,L1帧和R1帧的时间戳相同,L2帧和R2帧的时间戳相同,L3帧和R3帧的时间戳相同。在子图a所示的方式中,逐帧对时间戳相同的视频帧进行融合处理,对融合处理后的视频帧进行超分辨率处理,得到高分辨率的双目视频帧,再将所有高分辨率的双目视频帧进行合并,以获取高分辨率视频。举例说明,对L1帧和R1帧进行融合处理,得到高分辨率的双目视频帧G1,对L2帧和R2帧进行融合处理,得到高分辨率的双目视频帧G2,对L3帧和R3帧进行融合处理,得到高分辨率的双目视频帧G3。对双目视频帧G1,双目视频帧G2,双目视频帧G3进行合并处理,以获取第一视频或第二视频的高分辨率视频。这种实施方式的缺陷在于只能利用具有相同的时间戳的视频帧之间的互补信息提升双目视频的质量。如子图b所示,在另一种实施方式中,分别对来自同一个摄像头的视频帧多帧视频帧进行融合。举例说明,对L1帧和L2帧进行融合处理,得到高分辨率的双目视频帧G1,对L2帧和L3帧进行融合处理,得到高分辨率的双目视频帧G2,对L1帧、L2帧以及L3帧进行融合处理,得到高分辨率的双目视频帧G3。对双目视频帧G1,双目视频帧G2,双目视频帧G3进行合并处理,以获取第一视频或第二视频的高分辨率视频。这种实施方式的缺陷在于只能利用双目视频中的一个视频中的帧间时序信息提升双目视频的质量。如子图c所示,在另一种实施方式中,先按照子图a所示的方式进行处理,获取多个双目视频帧,在对该多个双目视频帧按照子图b所示的方式进行处理,以获取高分辨率的视频。举例说明,对L1帧和R1帧进行融合处理,得到高分辨率的双目视频帧G1,对L2帧和R2帧进行融合处理,得到高分辨率的双目视频帧G2,对L3帧和R3帧进行融合处理,得到高分辨率的双目视频帧G3。再对G1帧和G2帧进行融合处理,得到高分辨率的双目视频帧H1,对G2帧和G3帧进行融合处理,得到高分辨率的双目视频帧H2,对G1帧、G2帧以及G3帧进行融合处理,得到高分辨率的双目视频帧H3。对双目视频帧H1,双目视频帧H2,双目视频帧H3进行合并处理,以获取第一视频或第二视频的高分辨率视频。这种实施方式的缺陷在于只能利用具有相同的时间戳的视频帧之间的互补信息,以及双目视频中的一个视频中的帧间时序信息提升双目视频的质量。

在双目视频超分辨率任务中,主要有两大关键挑战:一是,如何更好的利用双目摄像头采集的视频帧之间的互补信息以及帧间时序信息;二是,如何将两个摄像头采集的不同的视频帧进行融合。上述图1中的子图a至子图c所展示的方式都不能很好的应对这两大关键的挑战。为了解决这两大挑战,本申请实施例提供一种视频处理方法,充分利用双目摄像头采集的视频帧之间的互补信息以及帧间时序信息,可以显著提升双目摄像头拍摄的视频的质量。

下面将结合附图,对本申请中的技术方案进行描述。

本申请实施例提供的一种视频处理的方法能够应用在智能终端、智能制造、智能交通、智能家居、智能医疗、智能安防、自动驾驶、智慧城市等场景中。具体而言,本申请实施例的视频处理方法能够应用在遥感、监控、智能机器人、自动驾驶、智能终端(如手机摄像、VR/AR设备)、沉浸式影院以及需要通过对双目摄像头获取的视频/图像的质量进行增强的场景中。

下面分别对上述几种典型的应用场景进行简单的介绍。

一、对双目视频进行超分辨率处理

本申请提供的方案可以应用于需要对双目视频进行超分辨率处理的场景中。高分辨率图像/视频具有更高的像素密度,更多的细节信息,更细腻的画质,因此视频超分辨率重建技术具有十分广泛和重要的应用价值。例如,在医学影像处理领域,更高分辨率的图像/视频有助于医生更精确地判断病变区域,减少误判漏判,更高效地治疗病患。在安检领域,SR后的高分辨率图像/视频能够帮助安检人员更清晰的看出行李中是否含有疑似违规物品,保障旅客安全;在卫星遥感视频分析领域,SR后的图像/视频能方便专业人员更清晰地看清楚地貌地形,测绘分析;而在消费电子、数字高清电视(high definitiontelevision,HDTV)、虚拟现实(virtual reality,VR),增强现实(augmented reality,AR)、混合现实(mixed reality,MR)、沉浸式影院等领域,SR能够使用户体验到更高清的画质,增强主观视觉体验。以沉浸式影院为例,沉浸式影院通过对摄像头采集的视频进行超分辨率处理,重建为高清立体声视频,为观众提供身临其境的3D体验。本申请提供的方案可以适用于需要进行超分辨率重建的场景,尤其适用于对双目摄像头采集的视频进行超分辨率重建的场景,可以有效提升双目摄像头视频重建的精度。

二、视觉分析任务

具有智能驾驶功能的汽车是通过车载传感器系统感知道路环境,自动规划行车路线并控制车辆到达预定目标的智能汽车。具体的,具有智能驾驶功能的汽车是利用车载传感器系统来感知车辆周围环境,并根据感知所获得的道路信息、车辆位置和障碍物信息,控制车辆的转向和速度,从而使车辆能够安全、可靠地在道路上行驶。其中,车载传感器可以包括双目摄像头、雷达等等。比如,自车可以通过双目摄像头对自车的周围环境进行感知,再比如自车可以通过双目摄像头和雷达对自车的周围环境进行感知。具有智能驾驶功能的汽车往往需要对远距离的对象进行感知,比如对远处的交通信号灯进行感知。车载双目摄像头获取到的远距离的目标对象在图像/视频中所占的像素比例往往很小,这给目标识别带来很大的难度。通过本申请实施例提供的方案,可以提升车载双目摄像头获取的图像/视频的质量,进而可以提升根据该车载双目摄像头获取的图像/视频进行物体检测、物体识别、物体分割等任务的准确率。在其他需要进行视觉分析任务的场景,本申请实施例提供的方案也同样适用,比如在智能监控领域中,需要根据监控设备(该监控设备是双目摄像头或者多目摄像头)获取的图像/视频进行物体识别。其中,进行行人属性识别是一个关键任务,行人属性识别任务需要识别出行人的常见属性,如性别、年龄、头发、衣服、穿搭等。这要求图像/视频特征能够表征的信息更多,比如携带更多的图像的细节信息。通过本申请实施例提供的方案,可以使提取出的图像/视频的特征可以更好的表征图像/视频信息。图像/视频特征能够表征的信息越多,越有利于提升视觉分析任务的准确性。针对于行人属性识别这一任务,则越有利于提升行人属性识别的准确性。

在前述种种场景中,均可以采用本申请实施例提供的视频处理方法,从而提升双目摄像头或者多目摄像头采集的视频的质量。

请参阅图2,图2为本申请实施例提供的视频处理方法的一种流程示意图,方法可以包括:

201、通过双目摄像头采集视频。

其中,双目摄像头是指两个摄像头是帧同步的,并且两个摄像头的感知范围是交叉的。本申请提供的方案可以通过硬件方式实现两个摄像头的帧同步,也可以通过软件方式实现两个摄像头的帧同步,本申请实施例对此并不进行限定。比如,在一种可能的实施方式中,使用硬件触发机制去精确地同步双目摄像头中的每个摄像头,即通过硬件设备触发各个摄像头的帧同步。例如,利用激光分光器产生的每路激光经过光纤连接到一个光电转换器,光电转换器将激光信号转换为电脉冲信号,这些电脉冲信号作为同步信号去触发各个摄像头进行图像/视频的采集。再比如,在一种可能的实施方式中,可以通过软件的方式,一个摄像头获取另一个摄像头的连续N帧中每帧的时间戳,N为大于1的正整数;截取该一个摄像头的连续N帧,并收集该一个摄像头的连续N帧中每帧的时间戳;根据另一个摄像头的连续N帧中每帧的时间戳和该一个摄像头的连续N帧中每帧的时间戳,从另一个摄像头的连续N帧中,确定该一个摄像头的连续N帧中每帧的对齐帧;根据一个摄像头的连续N帧中每帧的时间戳以及一个摄像头的连续N帧中每帧的对齐帧的时间戳,确定平均时延;当平均时延满足同步条件,则确定该一个摄像头与另一个摄像头帧同步。

此外,本申请提供的方案可以适用于多目摄像头,该多目摄像头包括至少两个摄像头。该多目摄像头中的任意两个摄像头之间的限定参照上述双目摄像头进行理解,以下均以双目摄像头为例进行说明,后续对此不再重复赘述。

202、对双目摄像头采集的视频进行特征提取,以获取第一特征序列和第二特征序列。

本申请提供的方案可以通过多种特征提取模型对双目摄像头采集的视频进行特征提取。比如,该特征提取模型可以是卷积神经网络(convolutional neuron network,CNN)、深度神经网络(deep neural network,DNN)等等。下面以CNN为例,对如何对双目摄像头采集的视频进行特征提取进行说明。

如图3所示,CNN100可以包括输入层110,卷积层/池化层120,其中池化层为可选的,以及神经网络层130。

卷积层/池化层120:

卷积层:

如图3所示卷积层/池化层120可以包括如示例121-126层,在一种实现中,121层为卷积层,122层为池化层,123层为卷积层,124层为池化层,125为卷积层,126为池化层;在另一种实现方式中,121、122为卷积层,123为池化层,124、125为卷积层,126为池化层。即卷积层的输出可以作为随后的池化层的输入,也可以作为另一个卷积层的输入以继续进行卷积操作。

以卷积层121为例,卷积层121可以包括很多个卷积算子,卷积算子也称为核,其在图像处理中的作用相当于一个从输入图像矩阵中提取特定信息的过滤器,卷积算子本质上可以是一个权重矩阵,这个权重矩阵通常被预先定义,在对图像(视频可以看做包括多帧图像)进行卷积操作的过程中,权重矩阵通常在输入图像上沿着水平方向一个像素接着一个像素(或两个像素接着两个像素……这取决于步长stride的取值)的进行处理,从而完成从图像中提取特定特征的工作。该权重矩阵的大小应该与图像的大小相关,需要注意的是,权重矩阵的纵深维度(depth dimension)和输入图像的纵深维度是相同的,在进行卷积运算的过程中,权重矩阵会延伸到输入图像的整个深度。因此,和一个单一的权重矩阵进行卷积会产生一个单一纵深维度的卷积化输出,但是大多数情况下不使用单一权重矩阵,而是应用维度相同的多个权重矩阵。每个权重矩阵的输出被堆叠起来形成卷积图像的纵深维度。不同的权重矩阵可以用来提取图像中不同的特征,例如一个权重矩阵用来提取图像边缘信息,另一个权重矩阵用来提取图像的特定颜色,又一个权重矩阵用来对图像中不需要的噪点进行模糊化等等,该多个权重矩阵维度相同,经过该多个维度相同的权重矩阵提取后的特征图维度也相同,再将提取到的多个维度相同的特征图合并形成卷积运算的输出。这些权重矩阵中的权重值在实际应用中需要经过大量的训练得到,通过训练得到的权重值形成的各个权重矩阵可以从输入图像中提取信息,从而帮助卷积神经网络100进行正确的预测。

当卷积神经网络100有多个卷积层的时候,初始的卷积层(例如121)往往提取较多的一般特征,该一般特征也可以称之为低级别的特征;随着卷积神经网络100深度的加深,越往后的卷积层(例如126)提取到的特征越来越复杂,比如高级别的语义之类的特征,语义越高的特征越适用于待解决的问题。

池化层:

由于常常需要减少训练参数的数量,因此卷积层之后常常需要周期性的引入池化层,即如图3中120所示例的121-126各层,可以是一层卷积层后面跟一层池化层,也可以是多层卷积层后面接一层或多层池化层。在图像处理过程中,池化层的唯一目的就是减少图像的空间大小。池化层可以包括平均池化算子和/或最大池化算子,以用于对输入图像进行采样得到较小尺寸的图像。平均池化算子可以在特定范围内对图像中的像素值进行计算产生平均值。最大池化算子可以在特定范围内取该范围内值最大的像素作为最大池化的结果。另外,就像卷积层中用权重矩阵的大小应该与图像大小相关一样,池化层中的运算符也应该与图像的大小相关。通过池化层处理后输出的图像尺寸可以小于输入池化层的图像的尺寸,池化层输出的图像中每个像素点表示输入池化层的图像的对应子区域的平均值或最大值。

神经网络层130:

在经过卷积层/池化层120的处理后,卷积神经网络100还不足以输出所需要的输出信息。因为如前所述,卷积层/池化层120只会提取特征,并减少输入图像带来的参数。然而为了生成最终的输出信息(所需要的类信息或别的相关信息),卷积神经网络100需要利用神经网络层130来生成一个或者一组所需要的类的数量的输出。因此,在神经网络层130中可以包括多层隐含层(如图3所示的131、132至13n)以及输出层140,该多层隐含层中所包含的参数可以根据具体的任务类型的相关训练数据进行预先训练得到,例如该任务类型可以包括图像识别,图像分类,图像超分辨率重建等等。

在神经网络层130中的多层隐含层之后,也就是整个卷积神经网络100的最后层为输出层140,该输出层140具有类似分类交叉熵的损失函数,具体用于计算预测误差,一旦整个卷积神经网络100的前向传播(如图3由110至140的传播为前向传播)完成,反向传播(如图3由140至110的传播为反向传播)就会开始更新前面提到的各层的权重值以及偏差,以减少卷积神经网络100的损失及卷积神经网络100通过输出层输出的结果和理想结果之间的误差。

需要说明的是,如图3所示的卷积神经网络100仅作为一种卷积神经网络的示例,在具体的应用中,卷积神经网络还可以以其他网络模型的形式存在,例如,多个卷积层/池化层并行,将分别提取的特征均输入给全神经网络层130进行处理。

假设双目摄像头采集的视频包括第一视频和第二视频,第一视频由多帧图像组成,针对该多帧图像中的每一帧图像进行特征提取,可以获取每一帧图像对应的图像特征,该多个图像特征组成了第一特征序列,该第一特征序列用于表征第一视频的信息。同理,第二视频由多帧图像组成,针对该多帧图像中的每一帧图像进行特征提取,可以获取每一帧图像对应的图像特征,该多个图像特征组成了第二特征序列,该第二特征序列用于表征第二视频的信息。

在一个可能的实施方式中,可以通过两个特征提取模型同时对双目摄像头采集的视频进行特征提取。为了使两个特征提取模型提取的特征能够更好的融合,该两个特征提取模型可以共享参数。

203、从第一特征序列中选择多个特征作为参考特征。

在一个可能的实施方式中,可以从第一特征序列中选择预设数目的特征作为参考特征。在一个可能的实施方式中,可以将第一特征序列中的每个特征都作为参考特征。从第一特征序列中选择的参考特征数目越多,越有利于提升第一视频的质量,使第一视频携带更多的信息。

204、对每个参考特征和待融合特征进行融合处理,以获取更新后的每个参考特征。

待融合特征包括第一特征序列中除每个参考特征之外的其他至少一个特征,待融合特征还包括第二特征序列中的至少一个特征。举例说明,假设第一特征序列中包括特征1,特征2,特征3,特征4,特征5,第二特征序列中包括特征A,特征B,特征C,特征D,特征E。对于第一特征序列来说,特征1至特征5中的一个或者多个特征都可以作为参考特征。假设特征1和特征2作为参考特征,则特征1作为参考特征时,特征2至特征4,以及特征A至特征D可以作为待融合特征;特征2作为参考特征时,特征1,特征3,特征A,特征B以及特征E可以作为待融合特征。

在一个可能的实施方式中,待融合特征包括第一特征序列中除每个参考特征之外的其他全部特征,待融合特征还包括第二特征序列中的全部特征。结合上面的例子继续说明,假设特征1至特征5中的每个特征都作为参考特征,则特征1作为参考特征时,特征2至特征5,以及特征A至特征E可以作为待融合特征;特征2作为参考特征时,特征1,特征3至特征5,以及特征A至特征E可以作为待融合特征;特征3作为参考特征时,特征1,特征2,特征4,特征5,以及特征A至特征E可以作为待融合特征;特征4作为参考特征时,特征1至特征3,特征5,以及特征A至特征E可以作为待融合特征;特征5作为参考特征时,特征1至特征4,以及特征A至特征E可以作为待融合特征。

本申请可以通过多种方式对参考特征和待融合特征进行融合处理。在一个可能的实施方式中,如果参考特征和待融合特征的时间戳相同,则可以对参考特征和待融合特征进行加权处理。比如结合上面的例子继续说明,特征1和特征A来自不同的摄像头采集的视频,并且特征1和特征A具有相同的时间戳,则可以对特征1和特征A进行加权处理,比如特征1作为参考特征,特征A作为待融合特征时,可以设置特征1的权重更大,特征A的权重更小,对特征1和特征A进行加权处理,以获取更新后的特征1。如果参考特征和待融合特征的时间戳不相同,则参考特征和待融合特征之间的携带的信息可能会有差异,不适合直接对参考特征和待融合特征直接进行加权处理。实际上,参考特征和待融合特征的时间戳相同时,由于参考特征和待融合特征帧是来自两个不相同的摄像头,导致具有相同时间戳的参考特征和待融合特征携带的信息也可能会有差异。这里的两个不相同的摄像头参考双目摄像头的说明进行理解。为了解决这一问题,更好的利用待融合特征携带的信息对参考帧进行更新,还需要对参考特征和待融合特征进行如下处理:在一个可能的实施方式中,对每个参考特征和待融合特征进行配准处理,以获取配准后的每个参考特征。根据配准后的每个参考特征和目标参数获取更新后的每个参考特征,目标参数是根据每个参考特征和待融合特征之间的差异确定的。本申请提供的方案,可以通过多种方式实现对两个特征进行配准,配准指的是两个特征之间的对齐,即两个特征中位于不同位置的相同内容区域的对齐。配准的方式包括基于特征点、基于网格的、基于块匹配的和基于光流法的。此外,预测出两个特征中相同目标对象的运动是实现配准的前提。可以通过运动估计的方式预测两个特征中相同目标对象的运动。运动估计的基本原理是先将参考特征和待融合特征分别分成许多互不重叠的宏块(假设一个宏块内所有像素的位移量都相同),以参考特征为例继续说明,针对每一个参考特征内的每一个宏块,在一个最佳运动矢量的目标范围(search range)内搜索该宏块的最佳运动矢量。而每一个参考特征内的所有宏块的最佳运动矢量就可以认为是每一个帧的最佳运动矢量。下面以一个参考特征内的一个宏块为例,说明对于本方案,如何在一个最佳运动矢量的目标范围内搜索该宏块的最佳运动矢量。待融合特征中的各个宏块和参考特征内的当前的该一个宏块最相似的宏块(即该宏块的匹配宏块),该宏块与其匹配宏块之间的相对运动位移即为该宏块的最佳运动矢量。经过了特征配准后,可以对参考特征和待融合特征进行融合,使参考特征可以有效的利用待融合特征中的信息。此外,为了使配准后的特征能够更好的体现待融合特征中与参考特征最相关的信息,还可以通过目标参数对配准后的特征进行处理。具体的,目标参数可以根据参考特征和待融合特征之间的相乘结果(参考特征中的第i个位置的元素和待融合特征中的第i个位置的元素分别相乘,i为正整数)确定。在一个优选的实施方式中,目标参数可以根据参考特征和待融合特征之间的差值确定。可以根据目标参数对配准后的每个参考特征和配准后的目标特征进行融合处理,以获取更新后的参考特征。为了更好的理解方案,结合上面的例子继续说明,比如特征1作为参考特征,特征B作为待融合特征时,首先对特征1和特征B进行配准处理,以获取配准后的特征1以及配准后的特征B。对配准后的特征1和配准后的特征B进行融合处理后,获取配准后的特征。对特征1和特征B进行减法运算,将减法运算的结果作为目标参数。根据目标参数和配准后的特征进行相乘运算,并将相乘运算的结果作为更新后的特征1。需要说明的是,这个例子只是对优选的实施方式进行举例说明。如图4所示,为另一种对一个参考特征和一个待融合特征进行融合处理的示意图。在这种实施方式中,可以对参考特征和待融合特征进行首尾拼接处理,将拼接后的特征输入至神经网络中,以通过神经网络对参考特征和待融合特征进行配准。之所以对参考特征和待融合特征进行首尾拼接处理,是为了满足神经网络对于输入的要求。可以以配准两个特征为训练目标,对该神经网络进行训练,使训练后的神经网络可以对参考特征和待融合特征进行配准处理,以获取配准后的特征。此外,在这种实施方式中,还可以对参考特征和待融合特征进一步的进行特征提取,以使参考特征和待融合特征可以携带更多的信息,再对参考特征和待融合特征进行减法运算,以获取目标参数。在这种可能的实施方式中,还可以对目标参数进行softmax运算,以将该目标参数通过0至1之间实数进行表示。通过这样的方式,可以在利用目标参数进行后续的运算时,减少计算量。再对目标参数和配准后的特征进行乘法运算,以更好的将待融合特征中对参考特征有重要影响的特征融合到参考特征上。最后在将经过乘法运算的结果(对目标参数和配准后的特征进行乘法运算的结果)和参考特征进行叠加处理,以获取更新后的参考特征。在这种实施方式中,还可以对目标参数和配准后的特征进行乘法运算后的结果和参考特征进行拼接处理,对拼接处理后的特征进行进一步的特征提取,再对特征提取后的结果和参考特征进行叠加处理,以获取更新后的参考特征。

205、根据全部参考特征的时间戳的先后顺序,对全部更新后的参考特征进行排序处理,以获取融合特征序列。

执行了步骤204,每一个参考特征都可以获取至少一个更新后的参考特征,根据参考特征的时间戳从前到后的顺序,可以对全部更新后的参考特征进行排序处理,以获取融合特征序列。该融合特征序列可以用于获取第一视频的增强视频,如果将该特征序列按照预设的高分辨率输出,则可以提升对第一视频进行超分辨率处理后获取的视频的质量。继续举例说明,假设特征1和特征2作为参考特征,特征3,特征A以及特征B作为待融合特征,比如特征1作为参考特征时,特征2,特征3,特征A以及特征B可以作为待融合特征。对每个参考特征和待融合特征进行融合处理,以获取更新后的每个参考特征,则经过步骤204之后,针对特征1,可以获取4个更新后的特征1。比如,根据特征1和特征2获取更新后的特征1.1,根据特征1和特征3获取更新后的特征1.2,根据特征1和特征A获取更新后的特征1.3,根据特征1和特征B获取更新后的特征1.4。同理,针对特征2,也可以获取4个更新后的特征2。比如,根据特征2和特征2获取更新后的特征2.1,根据特征2和特征3获取更新后的特征2.2,根据特征2和特征A获取更新后的特征2.3,根据特征2和特征B获取更新后的特征2.4。由于特征1的时间戳在前,特征2的时间戳在后,则特征1.1至特征1.4应当排在特征2.1至特征2.4之前。在一个可能的实施方式中,还可以对特征1.1至特征1.4进行进一步的排序,由于特征A的时间戳在前,特征2和特征B的时间戳次之,特征3的时间戳最后,则还可以对特征1.1至特征1.4进行进一步的排序,特征1.3在最前面(特征1.3是根据特征1和特征A确定的,在进一步排序时,根据特征A的时间戳进行排序),特征1.1和特征1.4次之(特征1.1和特征1.4之间的顺序可以调换),特征1.2排在最后。

在一个可能的实施方式中,还可以对来自同一个参考特征的更新后的参考特征进行融合处理,再根据全部参考特征的时间戳的先后顺序,对全部更新后的参考特征进行排序处理,以获取融合特征序列。举例说明,在上一段的例子中,可以对该4个更新后的特征1进行融合处理,以获取一个更新后的特征1,则针对每一个参考特征,都只获取了一个更新后的参考特征。再根据全部参考特征的时间戳的先后顺序,对全部更新后的参考特征进行排序处理,以获取融合特征序列。

在一个可能的实施方式中,还可以从第二特征序列中选择多个特征作为参考特征,可以提升对第二视频进行超分辨率处理后获取的视频的质量。

由图2对应的实施例可知,本申请提供的方案通过从第一特征序列或者第二特征序列中选择多个特征作为参考帧,将第一特征序列或者第二特征序列中的其他特征融合到该参考帧上,可以同时利用双目摄像头采集的视频帧之间的互补信息以及帧间时序信息,对双目摄像头采集的视频进行增强,提升双目摄像头采集的视频的质量。

为了进一步提升双目摄像头采集的视频的质量,本申请实施例还可以逐步深入挖掘双目摄像头采集的视频帧之间的互补信息以及帧间时序信息,将双目摄像头采集的视频帧之间的互补信息以及帧间时序信息逐步的迁移到参考特征上,下面结合具体的实施方式进行说明。

请参阅图5,图5为本申请实施例提供的视频处理方法的一种流程示意图,方法可以包括:

501、通过双目摄像头采集视频。

步骤501可以参照图2对应的实施例中的步骤201进行理解,这里不再重复赘述。

502、将时间窗口内的帧序列分别作为两个特征提取模型的输入,以获取第一特征序列和第二特征序列。

可以通过时间窗口遍历双目摄像头采集的视频,将时间窗口内包括的视频帧作为当前的待处理对象,当前的待处理对象作为特征提取模型的输入。其中时间窗口的长度可以根据实际需求进行设定,比如时间窗口可以包括每个摄像头采集的至少两帧视频帧。关于具体如何获取第一特征序列和第二特征序列可以参照图2对应的实施例中的步骤202进行理解,这里不再重复赘述。此外,需要说明的,当前的待处理对象和前一次待处理对象或者后一次待处理对象可能有重复的视频帧,或者当前待处理对象和前一次待处理对象或者后一次待处理对象没有重复的视频帧。

503、将第一特征序列和第二特征序列输入至多个首尾相连的目标模型中,以获取更新后的每个参考特征。

从第一特征序列中选择多个特征作为参考特征。获取参考特征的过程可以参照图2对应的实施例中的步骤203进行理解,这里不再重复赘述。

如图6所示,为通过多个首尾相连的目标模型获取更新后的每个参考特征的架构图。这里以一个参考特征为例进行说明,每个目标模型包括两个输入,所有目标模型的其中一个输入都是参考特征,比如当前处理的参考特征是特征1,则所有目标模型的其中一个输入都是特征1。该多个首尾相连的目标模型中的第一个目标模型的另一个输入是待融合特征,比如当前处理的待融合特征是特征2,则第一个目标模型的另一个输入是特征2,该多个首尾相连的目标模型中除第一个目标模型之外的其他目标模型的另一个输入是前一个目标模型的输出。

每一个目标模型对两个输入进行特征融合处理,以获取该模型的输出,该多个目标模型中的最后一个目标模型的输出是更新后的参考特征。

504、根据全部参考特征的时间戳的先后顺序,对全部更新后的参考特征进行排序处理,以获取融合特征序列。

步骤504可以参照图2对应的实施例中的步骤205进行理解,这里不再重复赘述。

为了更好的理解图5对应的实施方式,下面结合一个具体的例子进行说明:如图7所示,假设通过双目摄像头中的其中一个摄像头(以下称为第一摄像头)采集的视频包括10帧视频帧,分别是视频帧1至视频帧10,通过双目摄像头中的另一个摄像头(以下称为第二摄像头)采集的视频包括10帧视频帧,分别是视频帧A至视频帧J。在图7所展示的例子中,通过时间窗口获取第一组待处理对象,第一组待处理图像包括视频帧1至视频帧5,以及视频帧A至视频帧E。对第一组待处理对象进行特征提取后,可以获取第一特征序列和第二特征序列。第一特征序列中包括5个特征(假设是特征1至特征5),是通过对视频帧1至视频帧5进行特征提取后获取的。第二特征序列中包括5个特征(假设是特征A至特征E),是通过对视频帧A至视频帧E进行特征提取后获取的。假设当前要对第一摄像头采集的视频进行增强处理,则可以将来自第一摄像头中的一个或者多个特征作为参考帧。假设当前要对第二摄像头采集的视频进行增强处理,则可以将来自第二摄像头中一个或者多个特征作为参考特征。下面以对第一摄像头采集的视频进行增强处理为例进行说明。假设设定时间窗口内的每个视频帧对应的每个特征都作为参考特征,设定时间窗口内除了参考特征之外的其他特征都作为待融合特征,则可以有如下过程:分别获取更新后的特征1至特征5,或者同时获取更新后的特征1至特征5。下面以如何获取更新后的特征1为例进行说明,获取更新后的特征2至特征5的过程与获取更新后的特征1的过程是类似的,不再重复赘述。针对特征1作为参考特征,特征2至特征5,以及特征A至特征E都作为待融合特征,则一共可以获取9个更新后的特征1。以根据特征1和特征2获取一个更新后的特征1为例进行说明,根据特征1和其他待融合特征获取更新后的特征1的过程,与根据特征1和特征获取一个更新后的特征1的过程类似,不再重复赘述。根据特征1和特征2获取更新后的特征1时,将特征1和特征2输入至第一个目标模型中,以使第一目标模型对特征1和特征2进行融合处理,关于如何对两个特征进行融合处理,可以参照上文图2对应的实施例中的步骤204介绍的,通过多种方式对参考特征和待融合特征进行融合处理的相关描述进行理解,这里不再重复赘述。第一个目标模型的输出和特征1作为第二个目标模型的输入,第二个目标模型对第一个目标模型的输出和特征1进行融合处理,获取第二个目标的输出,第二个目标模型的输出和特征1作为第三个目标模型的输入,第三个目标模型对第二个目标模型的输出和特征1进行融合处理,依次类推,最后一个目标模型的输出作为一个更新后的特征1。通过这种方式,可以逐步深入挖掘双目摄像头采集的视频帧之间的互补信息以及帧间时序信息,将双目摄像头采集的视频帧之间的互补信息以及帧间时序信息逐步的迁移到参考特征上,对双目摄像头采集的视频进行增强,提升双目摄像头采集的视频的质量。

在一个可能的实施方式中,还可以对全部更新后的参考特征进行自注意力计算,以获取每个更新后的参考特征的目标表示;根据全部参考特征的时间戳的先后顺序,对全部更新后的参考特征的目标表示进行排序,以获取融合特征序列。对全部更新后的参考特征进行自注意力计算,是为了在获取一个更新后的参考特征的过程中,考虑其他更新后的参考特征对该一个更新后的参考特征的影响。举例说明,在上一段列举的例子中,针对特征1作为参考特征,特征2至特征5,以及特征A至特征E都作为待融合特征,则一共可以获取9个更新后的特征1。可以对该9个更新后的参考特征1进行自注意力计算,以更新该9个更新后的特征1,本申请将该经过自注意力计算后的更新后的特征1称为参考特征1的目标表示。在一个可能的实施方式中,还可以对来自同一个参考特征的更新后的参考特征进行融合处理,以针对每一个参考特征获取一个更新后的参考特征,对全部更新后的参考特征进行自注意力计算,以获取获取每个更新后的参考特征的目标表示。比如,对该9个更新后的参考特征1进行融合处理,以获取一个更新后的参考特征,则每个参考特征都只对应一个更新后的参考特征,可以对不同的更新后的参考特征进行自注意力计算,以获取每个更新后的参考特征的目标表示。比如对更新后的参考特征1至更新后的参考特征5进行自注意力计算,以获取更新后的参考特征1至更新后的参考特征5的目标表示。

在一个可能的实施方式中,为了从粗到细深入挖掘双目摄像头采集的视频帧之间的互补信息以及帧间时序信息,还可以对参考特征和待融合特征进行下采样处理,下面结合一个具体的实施方式进行说明。

请参阅图8,图8为本申请实施例提供的视频处理方法的一种流程示意图,方法可以包括:

801、通过双目摄像头采集视频。

802、对双目摄像头采集的视频进行特征提取,以获取第一特征序列和第二特征序列。

803、从第一特征序列中选择多个特征作为参考特征。

步骤801至步骤803可以参照图2对应的实施例中的步骤201至步骤203进行理解,这里不再重复赘述。

804、对每个参考特征进行下采样,以获取下采样后的每个参考特征,对待融合特征进行下采样,以获取下采样后的待融合特征。

对每个参考特征进行下采样,可以降低每个参考特征的分辨率,同理,对待融合特征进行下采样,可以降低待融合特征的分辨率。

在一个可能的实施方式中,可以对每个参考特征进行多次下采样,对待融合特征进行多次下采样。

对参考特征进行下采样后,可以增大目标模型对参考特征的感受野(receptivefield)。感受野可以用来表示目标模型内部的不同位置的神经元对参考特征的感受范围的大小。神经元感受野的值越大,表示其能接触到的参考特征范围就越大,也意味着该神经元可能蕴含更为全局、语义层次更高的特征;而值越小,则表示其包含的特征越趋向于局部和细节。感受野的值可以大致用来判断每一层的抽象层次。同理,对待融合特征进行下采样后,可以增大目标模型对待融合特征的感受野。

805、对下采样后的每个参考特征和下采样后的待融合特征进行融合处理,以获取第一结果,对每个参考特征和待融合特征进行融合处理,以获取第二结果,对第一结果和第二结果进行融合处理,以获取更新后的每个参考特征。

为了更好的理解方案,下面结合图9进行举例说明。如图9所示,以一个参考特征和一个待融合特征为例进行说明。假设参考特征为特征1,待融合特征为特征A,对特征1进行下采样后,得到特征11,对特征A进行下采样后,得到特征A1,需要说明的是,特征11和特征A1的分辨率是相同的。对特征11进行下采样,得到特征12,对特征A1进行下采样后,得到特征A2。本申请对下采样的次数并不进行限定,可以根据实际需求进行设定。通过多个目标模型对特征12和特征A2进行融合处理,得到融合特征1。通过多个目标模型对特征11和特征A1进行融合处理,得到融合特征2。通过多个目标模型对特征1和特征A进行融合处理,得到融合特征3。关于如何通过多个目标模型对两个特征进行融合处理,已经在上文进行了介绍,这里不再重复赘述。再对融合特征1进行上采样,以使融合特征1和融合特征2的分辨率相同,对融合特征1和融合特征2进行融合处理,比如对二者进行加权处理,以获取结果1,再对结果1进行上采样(还可以对结果1进行特征提取后,再进行上采样),使结果1和融合特征3的分辨率相同,对结果1和融合特征3进行融合处理,比如对二者进行加权处理,以获取结果2,改结果2可以看做一个更新后的特征1。

806、根据全部参考特征的时间戳的先后顺序,对全部更新后的参考特征进行排序处理,以获取融合特征序列。

步骤806可以参照图5对应的实施例中的步骤504进行理解,这里不再重复赘述。

由图8对应的实施例可知,对参考特征和待融合特征进行下采样,从粗到细深入挖掘双目摄像头采集的视频帧之间的互补信息以及帧间时序信息,提升双目摄像头获取的视频的质量。

本申请提供的方案可以应用于对双目视频进行超分辨处理的应用场景中,为了更直观地理解本方案所带来的有益效果,以下结合数据对本申请实施例在超分辨率处理的应用场景中带来的有益效果进行说明。

在一种测试实验中,测试数据集包括KITTI2012数据集,KITTI2015数据集以及SceneFlow数据集。其中,KITTI2012数据集包括194个训练视频(该训练视频是通过双目视频)、195个测试视频(该测试视频是通过双目视频);每个视频21帧,分辨率375x1242;KITTI2015数据集包括200个训练视频(该训练视频是通过双目视频)、200个测试视频(该测试视频是通过双目视频);帧数和分辨率与KITTI2012相同;SceneFlow数据集包括约2265个训练视频(该训练视频是通过双目视频)、437个测试视频(该测试视频是通过双目视频);分辨率540x960,不同场景的视频有不同的帧数。在模型的训练过程中,可以对上述数据集中的训练视频进行4倍下采样,得到64*64分辨率的视频,将进行4倍下采样后的训练视频作为模型的训练数据。对上述数据集中的训练视频随机裁切为256x256分辨率的视频,将该256x256分辨率的视频作为训练目标。训练后的模型可以用于对视频进行超分辨率处理,可以通过峰值信噪比(peak signal-to-noise ratio,PSNR)以及结构相似性(structuralsimilarity index,SSIM)来衡量超分辨处理的效果,PSNR和SSIM的取值越高,代表超分辨率处理的效果越好。PSNR是一个表示信号最大可能功率和影响它的表示精度的破坏性噪声功率的比值。峰值信噪比经常用作图像处理等领域中信号重建质量的测量方法,通常简单地通过均方误差进行定义。SSIM是衡量两幅图像相似度的指标,用于评价算法处理的输出图像的质量。结构相似度指数从图像组成的角度将结构信息定义为独立于亮度、对比度的反映场景中物体结构的属性,并将失真建模为亮度、对比度和结构三个不同因素的组合。用均值作为亮度的估计,标准差作为对比度的估计,协方差作为结构相似程度的度量。第一种方式采用了如图1中的子图a所示的方式对模型的输入视频进行的处理;第二种方式采用了如图1中的子图b所示的方式对模型的输入视频进行的处理;第三种方式采用了如图1中的子图c所示的方式对模型的输入视频进行的处理。本申请提供的方案通过从第一特征序列或者第二特征序列中选择多个特征作为参考帧,将第一特征序列或者第二特征序列中的其他特征融合到该参考帧上,可以同时利用双目摄像头采集的视频帧之间的互补信息以及帧间时序信息,显著提升双目摄像头采集的视频的质量,进而提升双目摄像头采集的视频进行超分辨率处理后的视频的质量。

表1

如图10所示,为实验的效果图,从图10中可以直观的看出,相比于图1中的子图a至子图c所示的方式,针对于双目视频的超分辨处理这一任务,本申请提供的方案可以获取更好的超分辨率的效果。

此外,在另一种测试实验中,针对上述图2对应的实施例、图5对应的实施例进行测试。参阅表2和表3,实验结果表明,目标模型的数目越多,越有利于提升双目视频超分的质量。相比于没有对全部更新后的参考特征进行自注意力计算的方案,对全部更新后的参考特征进行自注意力计算,有利于提升双目视频超分的质量。

表2

表3

以上对本申请实施例提供的一种视频处理的方法进行了介绍,通过本申请提供的方案可以提升通过双目摄像头采集的视频的质量。

可以理解的是,为了实现上述功能,下面还提供用于实施上述方案的相关设备。这些相关设备包含了执行各个功能相应的硬件结构和/或软件模块。本领域技术人员应该很容易意识到,结合本文中所公开的实施例描述的各示例的模块及算法步骤,本申请能够以硬件或硬件和计算机软件的结合形式来实现。某个功能究竟以硬件还是计算机软件驱动硬件的方式来执行,取决于技术方案的特定应用和设计约束条件。专业技术人员可以对每个特定的应用来使用不同方法来实现所描述的功能,但是这种实现不应认为超出本申请的范围。

如图11所示,为本申请实施例提供的一种视频处理的装置的结构示意图。该视频处理的装置包括采集模块1101,特征提取模块1102,特征迁移模块1103,迁移特征融合模块1104。

采集模块1101,用于执行图2对应的实施例中的步骤201,图5对应的实施例中的步骤501,图8对应的实施例中的步骤801。由于本方案适用于双目摄像头或者多目摄像头的场景,因此可以包括至少两个采集模块1101。

特征提取模型,用于执行图2对应的实施例中的步骤202,图5对应的实施例中的步骤502,图8对应的实施例中的步骤802。

特征迁移模块1103,用于执行图2对应的实施例中的步骤203,图2对应的实施例中的步骤204,图5对应的实施例中的步骤503,图8对应的实施例中的步骤803,图8对应的实施例中的步骤804,图8对应的实施例中的步骤805。

迁移特征融合模块1104,用于执行图2对应的实施例中的步骤205,图5对应的步骤504。

在一个可能的实施方式中,还可以包括视频重建模块1105,用于根据迁移特征融合模块1104的输出对采集模块1101采集的双目视频进行重建处理,以获取更高分辨率的双目视频。

需要说明的是,上述将视频处理的装置划分为采集模块1101,特征提取模块1102,特征迁移模块1103以及迁移特征融合模块1104只是一种划分方式,不应当理解为对方案的限定。比如,还可以将特征迁移模块1103和特征融合模块1104看做一个模块,特征处理模块。

在一个可能的实施方式中,该视频处理的装置,包括:特征提取模块,用于获取第一特征序列和第二特征序列,第一特征序列是对第一摄像头采集的视频进行特征提取后获取的,第二特征序列是对第二摄像头采集的视频进行特征提取后获取的,第一摄像头和第二摄像头是帧同步的,第一摄像头和第二摄像头的感知范围是交叉的。特征处理模块,用于:从特征提取模块获取的第一特征序列中选择多个特征作为参考特征。对每个参考特征和待融合特征进行融合处理,以获取更新后的每个参考特征,待融合特征包括第一特征序列中除每个参考特征之外的其他至少一个特征,待融合特征还包括第二特征序列中的至少一个特征。根据全部参考特征的时间戳的先后顺序,对全部更新后的参考特征进行排序,以获取融合特征序列。

在一个可能的实施方式中,特征处理模块,具体用于:通过多个首尾相连的模型对每个参考特征和待融合特征进行融合处理,多个模型中的最后一个模型的输出用于获取更新后的每个参考特征,其中,多个模型中的任意一个模型,用于执行下述流程:对每个参考特征和目标特征进行融合处理,以获取任意一个模型的输出,其中,任意一个模型是多个模型中的第一个模型时,目标特征是每个待融合特征,任意一个模型是多个模型中除第一个模型之外的其他模型时,目标特征是任意一个模型的前一个模型的输出。

在一个可能的实施方式中,特征处理模块,具体用于:对每个参考特征和目标特征进行配准处理,以获取配准后的每个参考特征和配准后的目标特征。根据目标参数对配准后的每个参考特征和配准后的目标特征进行融合处理,以获取任意一个模型的输出,目标参数是根据每个参考特征和目标特征之间的差异确定的。

在一个可能的实施方式中,特征处理模块,还用于:对每个参考特征进行下采样,以获取下采样后的每个参考特征。对待融合特征进行下采样,以获取下采样后的待融合特征。特征处理模块,具体用于:对下采样后的每个参考特征和下采样后的待融合特征进行融合处理,以获取第一结果。对每个参考特征和待融合特征进行融合处理,以获取第二结果。对第一结果和第二结果进行融合处理,以获取更新后的每个参考特征。

在一个可能的实施方式中,特征处理模块,具体用于:对全部更新后的参考特征进行自注意力计算,以获取每个更新后的参考特征的目标表示。根据全部参考特征的时间戳的先后顺序,对全部更新后的参考特征的目标表示进行排序,以获取融合特征序列。

在一个可能的实施方式中,多个特征包括第一特征序列中的每个特征,待融合特征包括第一特征序列中除每个参考特征之外的其他全部特征,待融合特征还包括第二特征序列中的全部特征。

在一个可能的实施方式中,还包括超分辨率处理模块,用于根据融合特征序列对第一摄像头采集的视频进行超分辨处理。

此外,上述方法实施例中的每个步骤可能通过多个模块共同完成。比如,在图5对应的实施方式中,针对于步骤504,可以通过特征迁移模块1103和迁移特征融合模块1104共同完成。具体的,特征迁移模块1103可以包括多个目标模型,通过特征迁移模块1103执行与目标模型相关的步骤,通过迁移特征融合模块1104对全部更新后的参考特征进行自注意力计算,以获取每个更新后的参考特征的目标表示。

请参考图12,其示出本申请实施例提供的一种电子设备的结构示意图。该电子设备可以是便携式计算机(如手机)、笔记本电脑、可穿戴电子设备(如智能手表)、遥感设备、智能监控设备、平板电脑、电视、增强现实(augmentedreality,AR)\虚拟现实(virtualreality,VR)设备或车载设备等,以下实施例对该电子设备的具体形式不做特殊限制。

该电子设备可以包括处理器110,存储器,存储器可以包括外部存储器接口120和/或内部存储器121,摄像头193,显示屏194。其中摄像头可以是双目摄像头或者多目摄像头。其中,摄像头193可以包括RGB摄像头,红外摄像头,黑白摄像头等任意一种类型的摄像头。

此外,该电子设备还可以包括通用串行总线(universal serial bus,USB)接口130,充电管理模块140,电源管理模块141,电池142,天线1,天线2,移动通信模块150,无线通信模块160,音频模块170,扬声器170A,受话器170B,麦克风170C,耳机接口170D,传感器模块180,按键190,马达191,指示器192,摄像头193,显示屏194,以及用户标识模块(subscriber identificationmodule,SIM)卡接口195等。

其中,传感器模块180可以包括压力传感器180A,陀螺仪传感器180B,气压传感器180C,磁传感器180D,加速度传感器180E,距离传感器180F,接近光传感器180G,指纹传感器180H,温度传感器180J,触摸传感器180K,环境光传感器180L,骨传导传感器180M等多个传感器。还可以包括图像传感器180N。其中,图像传感器180N可以是包括独立的彩色传感器(图12中未示出)和独立的运动传感器(图12中未示出),也可以是包括彩色传感器的感光单元(可称为彩色传感器像素,图12中未示出)和运动传感器的感光单元(可称为运动传感器像素,图12中未示出)。

可以理解的是,本发明实施例示意的结构并不构成对电子设备的具体限定。在本申请另一些实施例中,电子设备可以包括比图示更多或更少的部件,或者组合某些部件,或者拆分某些部件,或者不同的部件布置。图示的部件可以以硬件,软件或软件和硬件的组合实现。

处理器110可以包括一个或多个处理单元,例如:处理器110可以包括应用处理器(application processor,AP),调制解调处理器,图形处理器(graphics processingunit,GPU),图像信号处理器(image signal processor,ISP),控制器,视频编解码器,数字信号处理器(digital signal processor,DSP),基带处理器,和/或神经网络处理器(neural-networkprocessing unit,NPU)等。其中,不同的处理单元可以是独立的器件,也可以集成在一个或多个处理器中。

其中,控制器可以是电子设备的神经中枢和指挥中心。控制器可以根据指令操作码和时序信号,产生操作控制信号,完成取指令和执行指令的控制。

处理器110中还可以设置存储器,用于存储指令和数据。在一些实施例中,处理器110中的存储器为高速缓冲存储器。该存储器可以保存处理器110刚用过或循环使用的指令或数据。如果处理器110需要再次使用该指令或数据,可从所述存储器中直接调用。避免了重复存取,减少了处理器110的等待时间,因而提高了系统的效率。

在一些实施例中,处理器110可以包括一个或多个接口。接口可以包括集成电路(inter-integrated circuit,I2C)接口,集成电路内置音频(inter-integratedcircuitsound,I2S)接口,脉冲编码调制(pulse code modulation,PCM)接口,通用异步收发传输器(universal asynchronous receiver/transmitter,UART)接口,移动产业处理器接口(mobile industry processor interface,MIPI),通用输入输出(general-purposeinput/output,GPIO)接口,用户标识模块(subscriber identity module,SIM)接口,和/或通用串行总线(universal serialbus,USB)接口等。

I2C接口是一种双向同步串行总线,包括一根串行数据线(serial data line,SDL)和一根串行时钟线(derail clock line,SCL)。在一些实施例中,处理器110可以包含多组I2C总线。处理器110可以通过不同的I2C总线接口分别耦合触摸传感器180K,充电器,闪光灯,摄像头193等。例如:处理器110可以通过I2C接口耦合触摸传感器180K,使处理器110与触摸传感器180K通过I2C总线接口通信,实现电子设备的触摸功能。

I2S接口可以用于音频通信。在一些实施例中,处理器110可以包含多组I2S总线。处理器110可以通过I2S总线与音频模块170耦合,实现处理器110与音频模块170之间的通信。在一些实施例中,音频模块170可以通过I2S接口向无线通信模块160传递音频信号,实现通过蓝牙耳机接听电话的功能。

PCM接口也可以用于音频通信,将模拟信号抽样,量化和编码。在一些实施例中,音频模块170与无线通信模块160可以通过PCM总线接口耦合。在一些实施例中,音频模块170也可以通过PCM接口向无线通信模块160传递音频信号,实现通过蓝牙耳机接听电话的功能。所述I2S接口和所述PCM接口都可以用于音频通信。

UART接口是一种通用串行数据总线,用于异步通信。该总线可以为双向通信总线。它将要传输的数据在串行通信与并行通信之间转换。在一些实施例中,UART接口通常被用于连接处理器110与无线通信模块160。例如:处理器110通过UART接口与无线通信模块160中的蓝牙模块通信,实现蓝牙功能。在一些实施例中,音频模块170可以通过UART接口向无线通信模块160传递音频信号,实现通过蓝牙耳机播放音乐的功能。

MIPI接口可以被用于连接处理器110与显示屏194,摄像头193等外围器件。MIPI接口包括摄像头串行接口(camera serial interface,CSI),显示屏串行接口(displayserial interface,DSI)等。在一些实施例中,处理器110和摄像头193通过CSI接口通信,实现电子设备的拍摄功能。处理器110和显示屏194通过DSI接口通信,实现电子设备的显示功能。

GPIO接口可以通过软件配置。GPIO接口可以被配置为控制信号,也可被配置为数据信号。在一些实施例中,GPIO接口可以用于连接处理器110与摄像头193,显示屏194,无线通信模块160,音频模块170,传感器模块180等。GPIO接口还可以被配置为I2C接口,I2S接口,UART接口,MIPI接口等。

USB接口130是符合USB标准规范的接口,具体可以是Mini USB接口,Micro USB接口,USB Type C接口等。USB接口130可以用于连接充电器为电子设备充电,也可以用于电子设备与外围设备之间传输数据。也可以用于连接耳机,通过耳机播放音频。该接口还可以用于连接其他电子设备,例如AR设备等。

可以理解的是,本发明实施例示意的各模块间的接口连接关系,只是示意性说明,并不构成对电子设备的结构限定。在本申请另一些实施例中,电子设备也可以采用上述实施例中不同的接口连接方式,或多种接口连接方式的组合。

充电管理模块140用于从充电器接收充电输入。其中,充电器可以是无线充电器,也可以是有线充电器。在一些有线充电的实施例中,充电管理模块140可以通过USB接口130接收有线充电器的充电输入。在一些无线充电的实施例中,充电管理模块140可以通过电子设备的无线充电线圈接收无线充电输入。充电管理模块140为电池142充电的同时,还可以通过电源管理模块141为电子设备供电。

电源管理模块141用于连接电池142,充电管理模块140与处理器110。电源管理模块141接收电池142和/或充电管理模块140的输入,为处理器110,内部存储器121,外部存储器,显示屏194,摄像头193,和无线通信模块160等供电。电源管理模块141还可以用于监测电池容量,电池循环次数,电池健康状态(漏电,阻抗)等参数。在其他一些实施例中,电源管理模块141也可以设置于处理器110中。在另一些实施例中,电源管理模块141和充电管理模块140也可以设置于同一个器件中。

电子设备的无线通信功能可以通过天线1,天线2,移动通信模块150,无线通信模块160,调制解调处理器以及基带处理器等实现。

天线1和天线2用于发射和接收电磁波信号。电子设备中的每个天线可用于覆盖单个或多个通信频带。不同的天线还可以复用,以提高天线的利用率。例如:可以将天线1复用为无线局域网的分集天线。在另外一些实施例中,天线可以和调谐开关结合使用。

移动通信模块150可以提供应用在电子设备上的包括2G/3G/4G/5G等无线通信的解决方案。移动通信模块150可以包括至少一个滤波器,开关,功率放大器,低噪声放大器(low noise amplifier,LNA)等。移动通信模块150可以由天线1接收电磁波,并对接收的电磁波进行滤波,放大等处理,传送至调制解调处理器进行解调。移动通信模块150还可以对经调制解调处理器调制后的信号放大,经天线1转为电磁波辐射出去。在一些实施例中,移动通信模块150的至少部分功能模块可以被设置于处理器110中。在一些实施例中,移动通信模块150的至少部分功能模块可以与处理器110的至少部分模块被设置在同一个器件中。

调制解调处理器可以包括调制器和解调器。其中,调制器用于将待发送的低频基带信号调制成中高频信号。解调器用于将接收的电磁波信号解调为低频基带信号。随后解调器将解调得到的低频基带信号传送至基带处理器处理。低频基带信号经基带处理器处理后,被传递给应用处理器。应用处理器通过音频设备(不限于扬声器170A,受话器170B等)输出声音信号,或通过显示屏194显示图像或视频。在一些实施例中,调制解调处理器可以是独立的器件。在另一些实施例中,调制解调处理器可以独立于处理器110,与移动通信模块150或其他功能模块设置在同一个器件中。

无线通信模块160可以提供应用在电子设备上的包括无线局域网(wirelesslocalarea networks,WLAN)(如Wi-Fi网络),蓝牙(blue tooth,BT),全球导航卫星系统(globalnavigation satellite system,GNSS),调频(frequency modulation,FM),NFC,红外技术(infrared,IR)等无线通信的解决方案。无线通信模块160可以是集成至少一个通信处理模块的一个或多个器件。无线通信模块160经由天线2接收电磁波,将电磁波信号调频以及滤波处理,将处理后的信号发送到处理器110。无线通信模块160还可以从处理器110接收待发送的信号,对其进行调频,放大,经天线2转为电磁波辐射出去。

在一些实施例中,电子设备的天线1和移动通信模块150耦合,天线2和无线通信模块160耦合,使得电子设备可以通过无线通信技术与网络以及其他设备通信。所述无线通信技术可以包括全球移动通讯系统(global system for mobile communications,GSM),通用分组无线服务(general packet radio service,GPRS),码分多址接入(codedivisionmultiple access,CDMA),宽带码分多址(wideband code divisionmultipleaccess,WCDMA),时分码分多址(time-division code divisionmultiple access,TD-SCDMA),长期演进(long term evolution,LTE),BT,GNSS,WLAN,NFC,FM,和/或IR技术等。所述GNSS可以包括全球卫星定位系统(globalpositioning system,GPS),全球导航卫星系统(globalnavigation satellite system,GLONASS),北斗卫星导航系统(beidounavigationsatellite system,BDS),准天顶卫星系统(quasi-zenith satellitesystem,QZSS)和/或星基增强系统(satellite based augmentation systems,SBAS)。

电子设备通过GPU,显示屏194,以及应用处理器等实现显示功能。GPU为图像处理的微处理器,连接显示屏194和应用处理器。GPU用于执行数学和几何计算,用于图形渲染。处理器110可包括一个或多个GPU,其执行程序指令以生成或改变显示信息。

显示屏194用于显示图像,视频等。显示屏194包括显示面板。显示面板可以采用液晶显示屏(liquidcrystal display,LCD),有机发光二极管(organic light-emittingdiode,OLED),有源矩阵有机发光二极体或主动矩阵有机发光二极体(active-matrixorganic light emitting diode的,AMOLED),柔性发光二极管(flex light-emittingdiode,FLED),Miniled,MicroLed,Micro-oLed,量子点发光二极管(quantum dotlightemitting diodes,QLED)等。在一些实施例中,电子设备可以包括1个或N个显示屏194,N为大于1的正整数。

电子设备可以通过ISP,摄像头193,视频编解码器,GPU,显示屏194以及应用处理器等实现拍摄功能。

ISP主要用于处理摄像头193反馈的数据。例如,拍照时,打开快门,光线通过镜头被传递到摄像头感光元件上,光信号转换为电信号,摄像头感光元件将所述电信号传递给ISP处理,转化为肉眼可见的图像。ISP还可以对图像的噪点,亮度,肤色进行算法优化。ISP还可以对拍摄场景的曝光,色温等参数优化。在一些实施例中,ISP可以设置在摄像头193中。

摄像头193用于捕获静态图像或视频。物体通过镜头生成光学图像投射到感光元件。感光元件可以是电荷耦合器件(charge coupled device,CCD)或互补金属氧化物半导体(complementary metal-oxide-semiconductor,CMOS)光电晶体管。感光元件把光信号转换成电信号,之后将电信号传递给ISP转换成数字图像信号。ISP将数字图像信号输出到DSP加工处理。DSP将数字图像信号转换成标准的RGB,YUV等格式的图像信号。在一些实施例中,电子设备可以包括多个摄像头193。

数字信号处理器用于处理数字信号,除了可以处理数字图像信号,还可以处理其他数字信号。例如,当电子设备在频点选择时,数字信号处理器用于对频点能量进行傅里叶变换等。

视频编解码器用于对数字视频压缩或解压缩。电子设备可以支持一种或多种视频编解码器。这样,电子设备可以播放或录制多种编码格式的视频,例如:动态图像专家组(movingpicture experts group,MPEG)1,MPEG2,MPEG3,MPEG4等。

NPU为神经网络(neural-network,NN)计算处理器,通过借鉴生物神经网络结构,例如借鉴人脑神经元之间传递模式,对输入信息快速处理,还可以不断的自学习。通过NPU可以实现电子设备的智能认知等应用,例如:图像识别,人脸识别,语音识别,文本理解等。

外部存储器接口120可以用于连接外部存储卡,例如Micro SD卡,实现扩展电子设备的存储能力。外部存储卡通过外部存储器接口120与处理器110通信,实现数据存储功能。例如将音乐,视频等文件保存在外部存储卡中。

内部存储器121可以用于存储计算机可执行程序代码,所述可执行程序代码包括指令。处理器110通过运行存储在内部存储器121的指令,从而执行电子设备的各种功能应用以及数据处理。内部存储器121可以包括存储程序区和存储数据区。其中,存储程序区可存储操作系统,至少一个功能所需的应用程序(比如声音播放功能,图像播放功能等)等。存储数据区可存储电子设备使用过程中所创建的数据(比如音频数据,电话本等)等。此外,内部存储器121可以包括高速随机存取存储器,还可以包括非易失性存储器,例如至少一个磁盘存储器件,闪存器件,通用闪存存储器(universal flash storage,UFS)等。

电子设备可以通过音频模块170,扬声器170A,受话器170B,麦克风170C,耳机接口170D,以及应用处理器等实现音频功能。例如音乐播放,录音等。

音频模块170用于将数字音频信息转换成模拟音频信号输出,也用于将模拟音频输入转换为数字音频信号。音频模块170还可以用于对音频信号编码和解码。在一些实施例中,音频模块170可以设置于处理器110中,或将音频模块170的部分功能模块设置于处理器110中。

扬声器170A,也称“喇叭”,用于将音频电信号转换为声音信号。电子设备可以通过扬声器170A收听音乐,或收听免提通话。

受话器170B,也称“听筒”,用于将音频电信号转换成声音信号。当电子设备接听电话或语音信息时,可以通过将受话器170B靠近人耳接听语音。

麦克风170C,也称“话筒”,“传声器”,用于将声音信号转换为电信号。当拨打电话或发送语音信息时,用户可以通过人嘴靠近麦克风170C发声,将声音信号输入到麦克风170C。电子设备可以设置至少一个麦克风170C。在另一些实施例中,电子设备可以设置两个麦克风170C,除了采集声音信号,还可以实现降噪功能。在另一些实施例中,电子设备还可以设置三个,四个或更多麦克风170C,实现采集声音信号,降噪,还可以识别声音来源,实现定向录音功能等。

耳机接口170D用于连接有线耳机。耳机接口170D可以是USB接口130,也可以是3.5mm的开放移动电子设备平台(open mobile terminal platform,OMTP)标准接口,美国蜂窝电信工业协会(cellulartelecommunications industry association ofthe USA,CTIA)标准接口。

按键190包括开机键,音量键等。按键190可以是机械按键。也可以是触摸式按键。电子设备可以接收按键输入,产生与电子设备的用户设置以及功能控制有关的键信号输入。

马达191可以产生振动提示。马达191可以用于来电振动提示,也可以用于触摸振动反馈。例如,作用于不同应用(例如拍照,音频播放等)的触摸操作,可以对应不同的振动反馈效果。作用于显示屏194不同区域的触摸操作,马达191也可对应不同的振动反馈效果。不同的应用场景(例如:时间提醒,接收信息,闹钟,游戏等)也可以对应不同的振动反馈效果。触摸振动反馈效果还可以支持自定义。

指示器192可以是指示灯,可以用于指示充电状态,电量变化,也可以用于指示消息,未接来电,通知等。

SIM卡接口195用于连接SIM卡。SIM卡可以通过插入SIM卡接口195,或从SIM卡接口195拔出,实现和电子设备的接触和分离。电子设备可以支持1个或N个SIM卡接口,N为大于1的正整数。SIM卡接口195可以支持Nano SIM卡,Micro SIM卡,SIM卡等。同一个SIM卡接口195可以同时插入多张卡。所述多张卡的类型可以相同,也可以不同。SIM卡接口195也可以兼容不同类型的SIM卡。SIM卡接口195也可以兼容外部存储卡。电子设备通过SIM卡和网络交互,实现通话以及数据通信等功能。在一些实施例中,电子设备采用eSIM,即:嵌入式SIM卡。eSIM卡可以嵌在电子设备中,不能和电子设备分离。

本申请实施例提供还提供一种芯片,该芯片包括:处理单元和通信单元,所述处理单元例如可以是处理器,所述通信单元例如可以是输入/输出接口、管脚或电路等。该处理单元可执行存储单元存储的计算机执行指令,以使芯片执行上述图2至图9中所描述的方法。可选地,所述存储单元为所述芯片内的存储单元,如寄存器、缓存等,所述存储单元还可以是所述无线接入设备端内的位于所述芯片外部的存储单元,如只读存储器(read-onlymemory,ROM)或可存储静态信息和指令的其他类型的静态存储设备,随机存取存储器(random access memory,RAM)等。具体地,前述的处理单元或者处理器可以是中央处理器(central processing unit,CPU)、网络处理器(neural-network processing unit,NPU)、图形处理器(graphics processing unit,GPU)、数字信号处理器(digital signalprocessor,DSP)、专用集成电路(application specific integrated circuit,ASIC)或现场可编程逻辑门阵列(field programmable gate array,FPGA)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件等。通用处理器可以是微处理器或者也可以是任何常规的处理器等。

本申请实施例中还提供一种计算机可读存储介质,该计算机可读存储介质中存储有用于训练模型的程序,当其在计算机上运行时,使得计算机执行上述图2至图9中所描述的方法。

本申请实施例中还提供一种包括计算机程序产品,当其在计算机上运行时,使得计算机执行如前述图2至图9所示实施例描述的方法中的步骤。所述计算机程序产品包括一个或多个计算机指令。在计算机上加载和执行所述计算机程序指令时,全部或部分地产生按照本申请实施例所述的流程或功能。所述计算机可以是通用计算机、专用计算机、计算机网络、或者其他可编程装置。所述计算机指令可以存储在计算机可读存储介质中,或者从一个计算机可读存储介质向另一计算机可读存储介质传输,例如,所述计算机指令可以从一个网站站点、计算机、服务器或数据中心通过有线(例如同轴电缆、光纤、数字用户线(DSL))或无线(例如红外、无线、微波等)方式向另一个网站站点、计算机、服务器或数据中心进行传输。所述计算机可读存储介质可以是计算机能够存储的任何可用介质或者是包含一个或多个可用介质集成的服务器、数据中心等数据存储设备。所述可用介质可以是磁性介质,(例如,软盘、硬盘、磁带)、光介质(例如,DVD)、或者半导体介质(例如固态硬盘Solid StateDisk(SSD))等。

本申请实施例中还提供一种电路系统,所述电路系统包括处理电路,所述处理电路配置为执行如前述图2至图9所示实施例描述的方法中的步骤。

通过以上的实施方式的描述,所属领域的技术人员可以清楚地了解到本申请可借助纯软件或软件加必需的通用硬件的方式来实现,当然也可以通过专用硬件包括专用集成电路、专用CLU、专用存储器、专用元器件等来实现。一般情况下,凡由计算机程序完成的功能都可以很容易地用相应的硬件来实现,而且,用来实现同一功能的具体硬件结构也可以是多种多样的,例如模拟电路、数字电路或专用电路等。但是,对本申请而言更多情况下软件程序实现是更佳的实施方式。基于这样的理解,本申请的技术方案本质上或者说对现有技术做出贡献的部分可以以软件产品的形式体现出来,该计算机软件产品存储在可读取的存储介质中,如计算机的软盘、U盘、移动硬盘、ROM、RAM、磁碟或者光盘等,包括若干指令用以使得一台计算机设备(可以是个人计算机,训练设备,或者网络设备等)执行本申请各个实施例所述的方法。此外,该计算机软件产品也可以控件、驱动程序、独立或可下载软件对象等形式体现。

本申请的说明书和权利要求书及上述附图中的术语“第一”,“第二”等是用于区别类似的对象,而不必用于描述特定的顺序或先后次序。应该理解这样使用的数据在适当情况下可以互换,以便这里描述的实施例能够以除了在这里图示或描述的内容以外的顺序实施。本申请中术语“和/或”,仅仅是一种描述关联对象的关联关系,表示可以存在三种关系,例如,A和/或B,可以表示:单独存在A,同时存在A和B,单独存在B这三种情况,另外,本文中字符“/”,一般表示前后关联对象是一种“或”的关系。此外,术语“包括”和“具有”以及他们的任何变形,意图在于覆盖不排他的包含,例如,包含了一系列步骤或模块的过程,方法,系统,产品或设备不必限于清楚地列出的那些步骤或模块,而是可包括没有清楚地列出的或对于这些过程,方法,产品或设备固有的其它步骤或模块。在本申请中出现的对步骤进行的命名或者编号,并不意味着必须按照命名或者编号所指示的时间/逻辑先后顺序执行方法流程中的步骤,已经命名或者编号的流程步骤可以根据要实现的技术目的变更执行次序,只要能达到相同或者相类似的技术效果即可。本申请中所出现的模块的划分,是一种逻辑上的划分,实际应用中实现时可以有另外的划分方式,例如多个模块可以结合成或集成在另一个系统中,或一些特征可以忽略,或不执行,另外,所显示的或讨论的相互之间的耦合或直接耦合或通信连接可以是通过一些端口,模块之间的间接耦合或通信连接可以是电性或其他类似的形式,本申请中均不作限定。并且,作为分离部件说明的模块或子模块可以是也可以不是物理上的分离,可以是也可以不是物理模块,或者可以分布到多个电路模块中,可以根据实际的需要选择其中的部分或全部模块来实现本申请方案的目的。

- 视频处理装置、视频处理装置的IC电路、视频处理方法和视频处理程序

- 视频处理方法、视频处理装置和视频处理设备