文本摘要生成方法、装置、设备及存储介质

文献发布时间:2023-06-19 11:32:36

技术领域

本发明涉及文本处理领域,尤其涉及一种文本摘要生成方法、装置、设备及存储介质。

背景技术

相关技术中,文本摘要可以被分为两类:抽取式文本摘要(ExtractiveSummarization)和生成式文本摘要(Abstractive Summarization)。在抽取式文本摘要中,组成摘要的句子和词汇从原文中直接抽取获得。抽取式文本摘要的模型通常需要对文档中各个句子和词语的重要性进行计算,然后抽取重要性较高的部分组成摘要。进行抽取式摘要的方法主要以规则方法为主,利用无监督学习来进行摘要抽取。但抽取式摘要最终生成的文本往往冗余度较高且概括性不强。

随着神经网络和深度学习的不断发展,能够生成新颖句子且更容易吸收外部知识的生成式摘要模型得到了更多研究者的关注。这类模型通过读入整篇文章,理解其中的内容,再从无到有逐词生成对应的摘要段落。生成式摘要的难度较高,具有能够生成高质量摘要的潜能。生成式摘要的代表模型是“指针-生成器”(Pointer-Generator)模型,该方法通过覆盖机制(coverage mechanism)和指针生成器网络巧妙地缓解了生成式摘要模型常见的重复和无法处理词典外词汇的问题。然而,生成式摘要模型复杂,训练代价大,训练和运行速度较慢,对长文档的处理能力较低,无法满足实际应用场合的需求。

发明内容

有鉴于此,本发明实施例提供了一种文本摘要生成方法、装置、设备及存储介质,旨在改善文本摘要生成的质量。

本发明实施例的技术方案是这样实现的:

本发明实施例提供了一种文本摘要生成方法,包括:

获取需要生成文本摘要的目标文档;

基于混合式文本摘要识别模型对所述目标文档进行识别,得到所述目标文档的文本摘要;

其中,所述混合式文本摘要识别模型为通过强化学习的方法连接第一识别模型和第二识别模型生成的,所述第一识别模型用于输出抽取式文本摘要,所述第二识别模型用于输出生成式文本摘要。

上述方案中,所述方法还包括:

从训练语料中抽取设定数量个第一样本数据;每个第一样本数据包括:用于表征样本文档的每个摘要句子对应的源句子的第一数据向量和用于表征样本文档的每个摘要句子的第二数据向量;

将各第一样本数据的第一数据向量输入所述第一识别模型进行识别,得到各第一样本数据的抽取摘要句向量;

将各第一样本数据的抽取摘要句向量输入所述第二识别模型进行识别,得到各第一样本数据的初步摘要向量;

基于各第一样本数据的初步摘要向量和所述第二数据向量,确定当前混合式文本摘要识别模型对应的奖励值,根据策略梯度更新当前混合式文本摘要识别模型的参数,若所述奖励值未达到设定条件或者更新次数未达到设定次数,返回所述从训练语料中抽取设定数量个第一样本数据,以继续更新当前混合式文本摘要识别模型的参数,直至所述奖励值达到设定条件或者更新次数达到设定次数,得到最终的混合式文本摘要识别模型。

上述方案中,所述方法还包括:

从所述训练语料中抽取设定数量个第二样本数据;每个第二样本数据包括:用于表征样本文档的第三数据向量和用于表征样本文档的每个摘要句子对应的源句子的第四数据向量;

基于各第二样本数据的第三数据向量和第四数据向量训练所述第一识别模型,若所述第一识别模型的训练未满足结束条件,返回所述从训练语料中抽取设定数量个第二样本数据,以继续训练第一识别模型,直至所述第一识别模型的训练满足结束条件,得到最终的第一识别模型。

上述方案中,所述方法还包括:

从所述训练语料中抽取设定数量个第三样本数据;每个第三样本数据包括:用于表征样本文档的每个摘要句子对应的源句子的第五数据向量和用于表征样本文档的每个摘要句子的第六数据向量;

基于各第三样本数据的第五数据向量和第六数据向量训练所述第二识别模型,若所述第二识别模型的训练未满足结束条件,返回所述从训练语料数据中抽取设定数量个第三样本数据,以继续训练第二识别模型,直至所述第二识别模型的训练满足结束条件,得到最终的第二识别模型。

上述方案中,利用所述第二识别模型对各第三样本数据的第五数据向量进行编码时,将当前源句子与其他源句子通过注意力机制进行编码。

上述方案中,所述将各第一样本数据的抽取摘要句向量输入所述第二识别模型进行识别,得到各第一样本数据的初步摘要向量,包括:

所述第二识别模型接收抽取摘要句向量及样本文档中对应的源句子的数据向量,通过注意力机制将抽取摘要句向量与源句子的数据向量基于全局信息进行编码,并对编码后的数据进行解码,得到所述初步摘要向量。

上述方案中,所述方法还包括:

对原始训练语料基于令牌化技术进行编码,生成记录词与编码数据间映射关系的词表;

对所述原始训练语料基于贪心算法对摘要句子对应的源句子进行标识;

基于所述词表对所述原始训练语料中文档的词汇进行训练,得到词汇的词向量。

本发明实施例还提供一种文本摘要生成装置,包括:

获取模块,用于获取需要生成文本摘要的目标文档;

识别模块,用于基于混合式文本摘要识别模型对所述目标文档进行识别,得到所述目标文档的文本摘要;

其中,所述混合式文本摘要识别模型为通过强化学习方法连接第一识别模型和第二识别模型生成的,所述第一识别模型用于输出抽取式文本摘要,所述第二识别模型用于输出生成式文本摘要。

本发明实施例又提供了一种文本摘要生成设备,包括:处理器和用于存储能够在处理器上运行的计算机程序的存储器,其中,所述处理器,用于运行计算机程序时,执行本发明任一实施例所述方法的步骤。

本发明实施例还提供了一种存储介质,所述存储介质上存储有计算机程序,所述计算机程序被处理器执行时,实现本发明任一实施例方法的步骤。

本发明实施例提供的技术方案,基于混合式文本摘要识别模型对目标文档进行识别,得到目标文档的文本摘要;其中,所述混合式文本摘要识别模型为通过强化学习方法连接第一识别模型和第二识别模型生成的,所述第一识别模型用于输出抽取式文本摘要,所述第二识别模型用于输出生成式文本摘要。可以充分利用第一识别模型和第二识别模型的优点,支持处理较长文档,并生成概括性较高的新颖句子,且识别的速度和生成的文本摘要的质量均优于单独使用第一识别模型和第二识别模型。

附图说明

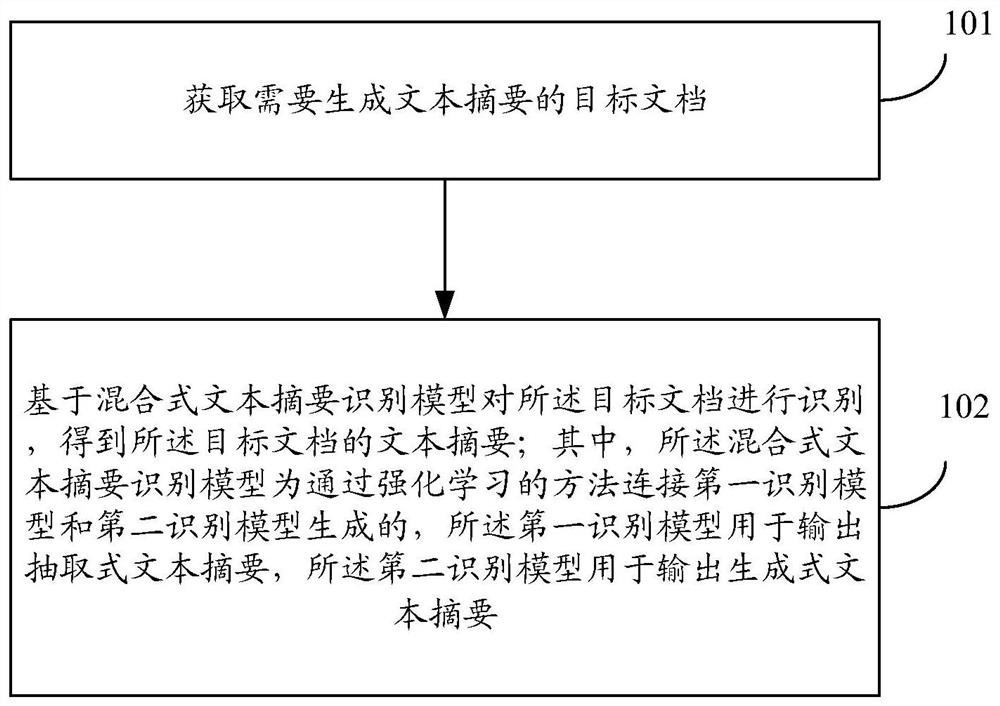

图1为本发明实施例文本摘要生成方法的流程示意图;

图2为本发明实施例训练混合式文本摘要识别模型的流程示意图;

图3为本发明实施例训练第一识别模型的流程示意图;

图4为本发明实施例训练第二识别模型的流程示意图;

图5为本发明应用实施例文本摘要生成方法的流程示意图;

图6为本发明实施例文本摘要生成装置的结构示意图;

图7为本发明实施例文本摘要生成设备的结构示意图。

具体实施方式

下面结合附图及实施例对本发明再作进一步详细的描述。

除非另有定义,本文所使用的所有的技术和科学术语与属于本发明的技术领域的技术人员通常理解的含义相同。本文中在本发明的说明书中所使用的术语只是为了描述具体的实施例的目的,不是旨在于限制本发明。

本发明实施例提供了一种文本摘要生成方法,如图1所示,该方法包括:

步骤101,获取需要生成文本摘要的目标文档;

步骤102,基于混合式文本摘要识别模型对所述目标文档进行识别,得到所述目标文档的文本摘要;其中,所述混合式文本摘要识别模型为通过强化学习的方法连接第一识别模型和第二识别模型生成的,所述第一识别模型用于输出抽取式文本摘要,所述第二识别模型用于输出生成式文本摘要。

这里,强化学习(Reinforcement Learning,RL),又称为再励学习、评价学习或增强学习。通过强化学习的方法连接第一识别模型和第二识别模型,生成混合式文本摘要识别模型,既能够利用第一识别模型和第二识别模型的优点,且通过强化学习进行优化,可以使得混合式文本摘要识别模型中的第一识别模型与第二识别模型的耦合度高。基于该混合式文本摘要识别模型对目标文档进行识别,得到目标文档的文本摘要时,支持处理较长文档,并生成概括性较高的新颖句子,且识别的速度和生成的文本摘要的质量均优于单独使用第一识别模型和第二识别模型。

为了利用该混合式文本摘要识别模型对目标文档进行处理,需要先通过强化学习的方法连接第一识别模型和第二识别模型,生成混合式文本摘要识别模型。

基于此,在一实施例中,所述方法还包括:

从训练语料中抽取设定数量个第一样本数据;每个第一样本数据包括:用于表征样本文档的每个摘要句子对应的源句子的第一数据向量和用于表征样本文档的每个摘要句子的第二数据向量;

将各第一样本数据的第一数据向量输入所述第一识别模型进行识别,得到各第一样本数据的抽取摘要句向量;

将各第一样本数据的抽取摘要句向量输入所述第二识别模型进行识别,得到各第一样本数据的初步摘要向量;

基于各第一样本数据的初步摘要向量和所述第二数据向量确定当前混合式文本摘要识别模型对应的奖励值,根据策略梯度更新当前混合式文本摘要识别模型的参数,若所述奖励值未达到设定条件或者更新次数未达到设定次数,返回所述从训练语料中抽取设定数量个第一样本数据,以继续更新当前混合式文本摘要识别模型的参数,直至所述奖励值达到设定条件或者更新次数达到设定次数,得到最终的混合式文本摘要识别模型。

在一实施例中,如图2所示,训练混合式文本摘要识别模型的方法包括:

步骤201,从训练语料中抽取设定数量个第一样本数据;每个第一样本数据包括:用于表征样本文档的每个摘要句子对应的源句子的第一数据向量和用于表征样本文档的每个摘要句子的第二数据向量;

这里,训练语料为对网络侧获取的原始训练语料进行预处理后的语料数据。

在一实施例中,对原始训练语料进行预处理,包括:

对原始训练语料基于令牌化技术进行编码,生成记录词与编码数据间映射关系的词表;

对所述原始训练语料基于贪心算法对摘要句子对应的源句子进行标识;

基于所述词表对所述原始训练语料中文档的词汇进行训练,得到词汇的词向量。

这里,原理训练语料可以为包括摘要文本的新闻文档,可以通过令牌化技术将原始训练语料中的每条新闻文档以及对应的摘要文本转化为易于表示的统一数据样式。比如,可以采用Penn Treebank风格的令牌化技术来进行编码,得到对应的编码数据集。还可以基于编码规则生成记录词与编码数据间映射关系的词表,并记录每个词出现的频率(又称为词频)。

这里,可以对原始训练语料中各新闻文档的摘要句子,在新闻文档中寻找对应ROUGE

这里,按照词频的大小,基于所述词表对所述原始训练语料中文档的词汇进行训练(如进行word2vec的训练),得到词汇的词向量(word embedding),从而使得每个词汇具有多个维度的向量表示,以表征文档中不会词汇之间的关系。

实际应用时,可以从训练语料中随机无放回抽取BatchSize(批大小)个新闻文档,提取这些文档对应的标签。根据词表和词向量,将新闻文档的每个摘要句子对应的源句子转换为第一设定长度的第一数据向量,将每个摘要句子转换为第二设定长度的第二数据向量,得到多个第一样本数据。

需要说明的是,本发明实施例中,步骤101获取的目标文档可以为对源文档通过令牌化技术处理后的语料数据,或者对源文档进行令牌化技术处理,得到转换后的目标文档,即将源文档转换为符合统一样式的语料数据。

在本发明实施例中,步骤102可以根据上述预处理确定的词表和词向量,将目标文档转换为数据向量,输入至混合式文本摘要识别模型,以对所述目标文档进行识别,得到所述目标文档的文本摘要。

步骤202,将各第一样本数据的第一数据向量输入所述第一识别模型进行识别,得到各第一样本数据的抽取摘要句向量;

这里,第一识别模型为预先训练好的抽取式摘要模型。第一识别模型对第一数据向量进行预测,得到抽取式摘要句对应的向量(即抽取摘要句向量)。

步骤203,将各第一样本数据的抽取摘要句向量输入所述第二识别模型进行识别,得到各第一样本数据的初步摘要向量;

这里,第二识别模型为预先训练好的句子改写模型。第二识别模型对抽取摘要句向量进行改写,生成初步摘要对应的向量(即初步摘要向量)。

步骤204,基于各第一样本数据的初步摘要向量和所述第二数据向量,确定当前混合式文本摘要识别模型对应的奖励值;

这里,当前混合式文本摘要识别模型对应的奖励值为将抽取的设定数量个第一样本数据对应的子奖励值进行累加确定的。对于单个第一样本数据(对应一个新闻文档样本)的子奖励值,可以基于改写后的初步摘要的初步摘要向量与摘要句子的第二数据向量进行ROUGE

这里,可以新闻文档的源句子的第一向量输入批评家网络来拟合对当前状态的评价方程

步骤205,根据策略梯度更新当前混合式文本摘要识别模型的参数;

这里,通过以下策略梯度

实际应用时,混合式文本摘要识别模型可训练的部分包括:抽取器模型的参数θ={θa,ω},分别是解码器和层次化编码器的模型参数。批评家网络通过最小化平方差损失

步骤206,判断是否满足训练结束条件;若否,则返回步骤201;若是,则执行步骤207;

这里,训练结束条件包括:奖励值对应的设定数值和更新对应的设定次数。

若所述奖励值未达到设定条件或者更新次数未达到设定次数,返回步骤201,以继续更新当前混合式文本摘要识别模型的参数。

若所述奖励值达到设定条件或者更新次数达到设定次数,则执行步骤207。

步骤207,保存模型参数,得到最终的混合式文本摘要识别模型。

由于需要预先训练好第一识别模型,基于此,在一实施例中,所述方法还包括:

从所述训练语料中抽取设定数量个第二样本数据;每个第二样本数据包括:用于表征样本文档的第三数据向量和用于表征样本文档的每个摘要句子对应的源句子的第四数据向量;

基于各第二样本数据的第三数据向量和第四数据向量训练所述第一识别模型,若所述第一识别模型的训练未满足结束条件,返回所述从训练语料中抽取设定数量个第二样本数据,以继续训练第一识别模型,直至所述第一识别模型的训练满足结束条件,得到最终的第一识别模型。

在一实施例中,如图3所示,训练第一识别模型的方法包括:

步骤301,从训练语料中抽取设定数量个第二样本数据,每个第二样本数据包括:用于表征样本文档的第三数据向量和用于表征样本文档的每个摘要句子对应的源句子的第四数据向量;

实际应用时,可以从训练语料中随机无放回抽取BatchSize(批大小)个新闻文档,提取这些文档对应的标签。根据词表和词向量,将新闻文档转换为第三数据向量,将新闻文档的每个摘要句子对应的源句子转换为第四数据向量,得到多个第二样本数据。

步骤302,基于各第二样本数据的第三数据向量和第四数据向量训练第一识别模型;

这里,第一识别模型可以为Pointer Network抽取式摘要模型,将抽取的设定数量个第二样本数据的第三数据向量和第四数据向量输入该第一识别模型,对第一识别模型的参数进行训练。

步骤303,判断是否满足训练结束条件;若否,则返回步骤301;若是,则执行步骤304;

这里,训练结束条件包括:损失函数对应的设定损失值和训练的迭代次数。

若损失函数的损失值大于设定损失值或者迭代次数未达到设定次数,返回步骤301,以继续训练所述第一识别模型。

若所述损失函数的损失值小于或等于设定损失值或者迭代次数达到设定次数,则执行步骤304。

步骤304,保存模型参数,得到最终的第一识别模型。

由于需要预先训练好第二识别模型,基于此,在一实施例中,所述方法还包括:

从所述训练语料中抽取设定数量个第三样本数据;每个第三样本数据包括:用于表征样本文档的每个摘要句子对应的源句子的第五数据向量和用于表征样本文档的每个摘要句子的第六数据向量;

基于各第三样本数据的第五数据向量和第六数据向量训练所述第二识别模型,若所述第二识别模型的训练未满足结束条件,返回所述从训练语料数据中抽取设定数量个第三样本数据,以继续训练第二识别模型,直至所述第二识别模型的训练满足结束条件,得到最终的第二识别模型。

在一实施例中,如图4所示,训练第二识别模型的方法包括:

步骤401,从训练语料中抽取设定数量个第三样本数据;每个第三样本数据包括:用于表征样本文档的每个摘要句子对应的源句子的第五数据向量和用于表征样本文档的每个摘要句子的第六数据向量;

实际应用时,可以从训练语料中随机无放回抽取BatchSize(批大小)个新闻文档,提取这些文档对应的标签。根据词表和词向量,将新闻文档的每个摘要句子对应的源句子转换为第五数据向量,将新闻文档的每个摘要句子转换为第六数据向量,得到多个第三样本数据。

步骤402,基于各第三样本数据的第五数据向量和第六数据向量训练第二识别模型;

这里,第二识别模型可以为句子改写模型,将抽取的设定数量个第三样本数据的第五数据向量和第六数据向量输入该第二识别模型,对第二识别模型的参数进行训练。

步骤403,判断是否满足训练结束条件;若否,则返回步骤401;若是,则执行步骤404;

这里,训练结束条件包括:损失函数对应的设定损失值和训练的迭代次数。

若损失函数的损失值大于设定损失值或者迭代次数未达到设定次数,返回步骤401,以继续训练所述第二识别模型。

若所述损失函数的损失值小于或等于设定损失值或者迭代次数达到设定次数,则执行步骤404。

步骤404,保存模型参数,得到最终的第二识别模型。

为了在对句子改写时,能够生成概括性较大的新词汇,在一实施例中,第二识别模型采用融合全局信息的句子改写模型。利用所述第二识别模型对各第三样本数据的第五数据向量进行编码时,将当前源句子与其他源句子通过注意力机制进行编码。

实际应用时,融合全局信息的句子改写模型在编码阶段通过注意力机制对源文档的所有被抽取句子(源句子)进行编码,在对单一句子向量进行编码时,不仅考虑当前句子,还将当前句子与其他句子进行注意力机制的比较与计算,得到融合全局信息的句子编码向量,接着再送入解码器进行句子的解码。通过这种机制,模型能够在改写句子时考虑到全局信息,这些信息指导句子的改写,使模型能够生成更加新颖的句子。

在一实施例中,第二识别模型为融合全局信息的句子改写模型时,所述将各第一样本数据的抽取摘要句向量输入所述第二识别模型进行识别,得到各第一样本数据的初步摘要向量,包括:

所述第二识别模型接收抽取摘要句向量及样本文档中对应的源句子的数据向量,通过注意力机制将抽取摘要句向量与源句子的数据向量基于全局信息进行编码,并对编码后的数据进行解码,得到所述初步摘要向量。

下面结合应用实施例对本发明再作进一步详细的描述。

如图5所示,本应用实施例文本摘要生成方法包括:

步骤501,获取原始训练语料。

这里,可以获取CNN(美国有线电视新闻网)、每日邮报等提供的新闻文档及对应的摘要文本,构成原始训练语料。

步骤502,对原始训练语料基于令牌化技术进行处理,得到令牌化数据。

这里,可以使用Penn Treebank风格的令牌化方式处理原始训练语料中文档文本和摘要文本中的词汇,其目的是将源文档中杂乱不齐的词汇形态转化为易于表示和输入模型的统一样式的令牌化数据。

步骤503,建立词表。

这里,可以从令牌化数据的语料中提取每条新闻以及它们对应的摘要文本,并存储为标准化的json文件。同时记录每个词出现的频率,建立词表。

步骤504,制作文档的抽取标签。

这里,通过贪心算法制作文档的抽取标签。对于每一句目标摘要,在原文中寻找对应ROUGE

步骤505,词向量训练。

这里,根据词频大小建立每个词在词表中的映射,接着进行word2vec的训练,得到原文词汇的词向量表示对应的词向量表示文件。

步骤506,随机无放回抽取Batch数据。

这里,从训练语料中随机无放回抽取BatchSize个新闻文档,提取这些文档对应的抽取标签。通过已建立的词表和词向量表示文件将文档和标签对应的抽取目标转化成长度为MaxLen的数据向量BatchData(即第三数据向量)和标签向量BatchID(即第四数据向量);其中,在填充数据时,若BatchData数据向量长度小于MaxLen,相应位置用0补齐。

步骤507,训练指针网络抽取式摘要模型。

将数据向量BatchData和对应的标签向量BatchID送入Pointer Network抽取式摘要模型中训练模型的参数。

步骤508,判断是否达到最大迭代次数或损失值满足结束条件,若否,则返回步骤506;若是,则执行步骤509。

Pointer Network抽取式摘要模型的训练结束条件为训练的迭代次数达到最大的迭代次数N或者损失值满足预先设定的条件,若符合训练结束条件,则执行步骤509,终止模型训练;否则,跳转至步骤506,重新随机无放回抽取Batch数据,继续训练模型。

步骤509,保存模型训练参数。

这里,保存模型训练参数,得到训练后的第一识别模型。

步骤510,随机无放回抽取Batch数据。

这里,从训练语料中随机无放回抽取BatchSize个新闻文档,提取这些文档对应的抽取标签。根据抽取标签将需要被改写的源句子d

步骤511,训练融合全局信息的句子改写模型。

这里,将源句子数据向量BatchSentences和对应的目标句向量BatchSummaries送入融合全局信息的句子改写模型中训练模型的参数。

实际应用时,融合全局信息的句子改写模型在编码阶段通过注意力机制对源文档的所有被抽取句子进行编码,在对单一句子向量进行编码时,不仅考虑当前句子,还将当前句子与其他句子进行注意力机制的比较与计算,得到融合全局信息的句子编码向量,接着再送入解码器进行句子的解码。通过这种机制,模型能够在改写句子时考虑到全局信息,这些信息指导句子的改写,使模型能够概括性、重要性更强的句子。

步骤512,判断是否达到最大迭代次数或损失值满足结束条件,若否,则返回步骤510;若是,则执行步骤513。

融合全局信息的句子改写模型的训练结束条件为训练的迭代次数达到最大的迭代次数M或者损失值满足预先设定的条件,若符合训练结束条件,则执行步骤513,终止模型训练;否则,跳转至步骤510,重新随机无放回抽取Batch数据,继续训练模型。

步骤513,保存模型训练参数。

这里,保存模型训练参数,得到训练后的第二识别模型。

步骤514,随机无放回抽取Batch数据。

这里,从训练语料中随机无放回抽取BatchSize个新闻文档,提取这些文档对应的抽取标签。根据抽取标签将需要被改写的源句子d

步骤515,使用训练后的指针网络抽取式摘要模型。

这里,将源文档的数据向量BatchData输入训练后的指针网络抽取式摘要模型(即第一识别模型)中进行预测,得到抽取摘要句BatchExtSents。

步骤516,使用训练后的融合全局信息的句子改写模型。

这里,将抽取摘要句BatchExtSents依次全部输入训练后的融合全局信息的句子改写模型(即第二识别模型)中,得到对应的被改写后句子BatchPredSents。

其中,每次输入融合全局信息的句子改写模型的数据包括被改写句及其对应的文档中抽取出的全部句子。模型的编码器通过注意力机制将综合被抽取的全部句子获得与当前改写句相关的全局信息进行编码,解码器综合这些信息,进行解码,得到生成摘要句。

步骤517,计算当前模型的奖励值。

这里,当前混合式文本摘要识别模型对应的奖励值为将随机无放回抽取的BatchSize个新闻文档对应的子奖励值进行累加确定的。对于单个新闻文档的子奖励值,可以基于改写后的初步摘要与摘要文本中摘要句子进行ROUGE

这里,可以新闻文档的源句子的第一向量输入批评家网络来拟合对当前状态的评价方程

步骤518,根据策略梯度更新模型参数。

这里,通过以下策略梯度

实际应用时,混合式文本摘要识别模型可训练的部分包括:抽取器模型的参数θ={θa,ω},分别是解码器和层次化编码器的模型参数。批评家网络通过最小化平方差损失

步骤519,判断是否达到最大迭代次数或奖励值满足结束条件,若否,则返回步骤514;若是,则执行步骤520。

这里,训练结束条件包括:最大迭代次数和奖励值对应的设定值。

若训练的迭代次数达到最大迭代次数或者奖励值满足对应的设定值,则终止模型训练,否则,返回步骤514,以继续训练模型。

步骤520,保存模型训练参数,得到训练后的混合式文本摘要识别模型。

保存模型训练参数,得到训练后的混合式文本摘要识别模型,且该混合式文本摘要识别模型融合了全局信息,指导句子改写时,可以生成更加重要的句子。

步骤521,获取测试数据。

将需要生成文本摘要的目标文档基于令牌化技术进行编码,得到转换后的测试数据。

步骤522,根据训练后的混合式文本摘要识别模型对测试数据进行识别,得到文本摘要识别结果。

将测试数据送入训练好的融合全局信息的混合式文本摘要识别模型中,得到文本摘要识别结果。

本应用实施例使用融合全局信息的混合式文本摘要识别模型,可以充分利用第一识别模型和第二识别模型的优点,既能像抽取式摘要那样快速训练和部署模型,也能像生成式摘要一样生成高质量、具有概括性的文本摘要。此外,通过注意力机制在句子改写阶段融合全局信息,使得改写器能够结合全局信息定位被改写句的重要信息,生成更加具有概括性的文本摘要。

为了实现本发明实施例的方法,本发明实施例还提供一种文本摘要生成装置,如图6所示,该装置包括:获取模块601、识别模块602;其中,

获取模块601,用于获取需要生成文本摘要的目标文档;

识别模块602,用于基于混合式文本摘要识别模型对所述目标文档进行识别,得到所述目标文档的文本摘要;其中,所述混合式文本摘要识别模型为通过强化学习方法连接第一识别模型和第二识别模型生成的,所述第一识别模型用于输出抽取式文本摘要,所述第二识别模型用于输出生成式文本摘要。

在一实施例中,所述装置还包括:第一训练模块603,所述第一训练模块603用于:

从训练语料中抽取设定数量个第一样本数据;每个第一样本数据包括:用于表征样本文档的每个摘要句子对应的源句子的第一数据向量和用于表征样本文档的每个摘要句子的第二数据向量;

将各第一样本数据的第一数据向量输入所述第一识别模型进行识别,得到各第一样本数据的抽取摘要句向量;

将各第一样本数据的抽取摘要句向量输入所述第二识别模型进行识别,得到各第一样本数据的初步摘要向量;

基于各第一样本数据的初步摘要向量和所述第二数据向量,确定当前混合式文本摘要识别模型对应的奖励值,根据策略梯度更新当前混合式文本摘要识别模型的参数,若所述奖励值未达到设定条件或者更新次数未达到设定次数,返回所述从训练语料中抽取设定数量个第一样本数据,以继续更新当前混合式文本摘要识别模型的参数,直至所述奖励值达到设定条件或者更新次数达到设定次数,得到最终的混合式文本摘要识别模型。

在一实施例中,所述装置还包括:第二训练模块604,所述第二训练模块604用于:

从所述训练语料中抽取设定数量个第二样本数据;每个第二样本数据包括:用于表征样本文档的第三数据向量和用于表征样本文档的每个摘要句子对应的源句子的第四数据向量;

基于各第二样本数据的第三数据向量和第四数据向量训练第一识别模型,若所述第一识别模型的训练未满足结束条件,返回所述从训练语料中抽取设定数量个第二样本数据,以继续训练所述第一识别模型,直至所述第一识别模型的训练满足结束条件,得到最终的第一识别模型。

在一实施例中,所述装置还包括:第三训练模块605,所述第三训练模块605用于:

从所述训练语料中抽取设定数量个第三样本数据;每个第三样本数据包括:用于表征样本文档的每个摘要句子对应的源句子的第五数据向量和用于表征样本文档的每个摘要句子的第六数据向量;

基于各第三样本数据的第五数据向量和第六数据向量训练第二识别模型,若所述第二识别模型的训练未满足结束条件,返回所述从训练语料数据中抽取设定数量个第三样本数据,以继续训练所述第二识别模型,直至所述第二识别模型的训练满足结束条件,得到最终的第二识别模型。

在一实施例中,第三训练模块605还用于:利用所述第二识别模型对各第三样本数据的第五数据向量进行编码时,将当前源句子与其他源句子通过注意力机制进行编码。

在一实施例中,第一训练模块603用于将各第一样本数据的抽取摘要句向量输入所述第二识别模型进行识别,得到各第一样本数据的初步摘要向量,包括:

所述第二识别模型接收抽取摘要句向量及样本文档中对应的源句子的数据向量,通过注意力机制将抽取摘要句向量与源句子的数据向量基于全局信息进行编码,并对编码后的数据进行解码,得到所述初步摘要向量。

在一实施例中,所述装置还包括:预处理模块606,所述预处理模块606用于:

对原始训练语料基于令牌化技术进行编码,生成记录词与编码数据间映射关系的词表;

对所述原始训练语料基于贪心算法对摘要句子对应的源句子进行标识;

基于所述词表对所述原始训练语料中文档的词汇进行训练,得到词汇的词向量。

在一实施例中,获取模块601获取的目标文档为对源文档通过令牌化技术处理后的语料数据,或者获取模块601对源文档进行令牌化技术处理,得到转换后的目标文档,即将源文档转换为符合统一样式的语料数据。

在一实施例中,识别模块602用于根据预处理模块606确定的词表和词向量,将目标文档转换为数据向量,输入至混合式文本摘要识别模型,以对所述目标文档进行识别,得到所述目标文档的文本摘要。

实际应用时,获取模块601、识别模块602、第一训练模块603、第二训练模块604、第三训练模块605及预处理模块606,可以由文本摘要生成装置中的处理器来实现。当然,处理器需要运行存储器中的计算机程序来实现它的功能。

需要说明的是:上述实施例提供的文本摘要生成装置在进行文本摘要生成时,仅以上述各程序模块的划分进行举例说明,实际应用中,可以根据需要而将上述处理分配由不同的程序模块完成,即将装置的内部结构划分成不同的程序模块,以完成以上描述的全部或者部分处理。另外,上述实施例提供的文本摘要生成装置与文本摘要生成方法实施例属于同一构思,其具体实现过程详见方法实施例,这里不再赘述。

基于上述程序模块的硬件实现,且为了实现本发明实施例的方法,本发明实施例还提供一种文本摘要生成设备。图7仅仅示出了该文本摘要生成设备的示例性结构而非全部结构,根据需要可以实施图7示出的部分结构或全部结构。

如图7所示,本发明实施例提供的文本摘要生成设备700包括:至少一个处理器701、存储器702、用户接口703和至少一个网络接口704。文本摘要生成设备700中的各个组件通过总线系统705耦合在一起。可以理解,总线系统705用于实现这些组件之间的连接通信。总线系统705除包括数据总线之外,还包括电源总线、控制总线和状态信号总线。但是为了清楚说明起见,在图7中将各种总线都标为总线系统705。

其中,用户接口703可以包括显示器、键盘、鼠标、轨迹球、点击轮、按键、按钮、触感板或者触摸屏等。

本发明实施例中的存储器702用于存储各种类型的数据以支持文本摘要生成设备的操作。这些数据的示例包括:用于在文本摘要生成设备上操作的任何计算机程序。

本发明实施例揭示的文本摘要生成方法可以应用于处理器701中,或者由处理器701实现。处理器701可能是一种集成电路芯片,具有信号的处理能力。在实现过程中,文本摘要生成方法的各步骤可以通过处理器701中的硬件的集成逻辑电路或者软件形式的指令完成。上述的处理器701可以是通用处理器、数字信号处理器(DSP,Digital SignalProcessor),或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件等。处理器701可以实现或者执行本发明实施例中的公开的各方法、步骤及逻辑框图。通用处理器可以是微处理器或者任何常规的处理器等。结合本发明实施例所公开的方法的步骤,可以直接体现为硬件译码处理器执行完成,或者用译码处理器中的硬件及软件模块组合执行完成。软件模块可以位于存储介质中,该存储介质位于存储器702,处理器701读取存储器702中的信息,结合其硬件完成本发明实施例提供的文本摘要生成方法的步骤。

在示例性实施例中,文本摘要生成设备可以被一个或多个应用专用集成电路(ASIC,Application Specific Integrated Circuit)、DSP、可编程逻辑器件(PLD,Programmable Logic Device)、复杂可编程逻辑器件(CPLD,Complex Programmable LogicDevice)、FPGA、通用处理器、控制器、微控制器(MCU,Micro Controller Unit)、微处理器(Microprocessor)、或者其他电子元件实现,用于执行前述方法。

可以理解,存储器702可以是易失性存储器或非易失性存储器,也可包括易失性和非易失性存储器两者。其中,非易失性存储器可以是只读存储器(ROM,Read Only Memory)、可编程只读存储器(PROM,Programmable Read-Only Memory)、可擦除可编程只读存储器(EPROM,Erasable Programmable Read-Only Memory)、电可擦除可编程只读存储器(EEPROM,Electrically Erasable Programmable Read-Only Memory)、磁性随机存取存储器(FRAM,ferromagnetic random access memory)、快闪存储器(Flash Memory)、磁表面存储器、光盘、或只读光盘(CD-ROM,Compact Disc Read-Only Memory);磁表面存储器可以是磁盘存储器或磁带存储器。易失性存储器可以是随机存取存储器(RAM,Random AccessMemory),其用作外部高速缓存。通过示例性但不是限制性说明,许多形式的RAM可用,例如静态随机存取存储器(SRAM,Static Random Access Memory)、同步静态随机存取存储器(SSRAM,Synchronous Static Random Access Memory)、动态随机存取存储器(DRAM,Dynamic Random Access Memory)、同步动态随机存取存储器(SDRAM,SynchronousDynamic Random Access Memory)、双倍数据速率同步动态随机存取存储器(DDRSDRAM,Double Data Rate Synchronous Dynamic Random Access Memory)、增强型同步动态随机存取存储器(ESDRAM,Enhanced Synchronous Dynamic Random Access Memory)、同步连接动态随机存取存储器(SLDRAM,SyncLink Dynamic Random Access Memory)、直接内存总线随机存取存储器(DRRAM,Direct Rambus Random Access Memory)。本发明实施例描述的存储器旨在包括但不限于这些和任意其它适合类型的存储器。

在示例性实施例中,本发明实施例还提供了一种存储介质,即计算机存储介质,具体可以是计算机可读存储介质,例如包括存储计算机程序的存储器702,上述计算机程序可由文本摘要生成设备的处理器701执行,以完成本发明实施例方法所述的步骤。计算机可读存储介质可以是ROM、PROM、EPROM、EEPROM、Flash Memory、磁表面存储器、光盘、或CD-ROM等存储器。

需要说明的是:“第一”、“第二”等是用于区别类似的对象,而不必用于描述特定的顺序或先后次序。

另外,本发明实施例所记载的技术方案之间,在不冲突的情况下,可以任意组合。

以上所述,仅为本发明的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,可轻易想到变化或替换,都应涵盖在本发明的保护范围之内。因此,本发明的保护范围应以权利要求的保护范围为准。

- 提醒生成文本摘要的方法、生成文本摘要的方法及装置

- 基于语义块的文本摘要生成方法、装置、设备及存储介质