使用高速和精确的用户交互跟踪的人类-计算机接口

文献发布时间:2023-06-19 11:26:00

相关申请的交叉引用

本申请要求于2018年9月21日提交的标题为“HUMAN-COMPUTER INTERFACE USINGHIGH-SPEED AND ACCURATE TRACKING OF USER INTERACTIONS”的美国非临时专利申请序列No.16/138,791的优先权和权益,出于所有目的,其公开内容通过引用整体并入本文。

技术领域

本文描述的实施例涉及用于在大脑-计算机接口的实现中使用系统、设备和方法,该大脑-计算机接口将实时眼睛运动和/或头部运动跟踪与大脑活动跟踪集成以呈现和更新被策略性地设计用于高速和精确的人类-计算机交互的用户界面(UI)或用户体验(UX)。本文描述的实施例还涉及硬件不可知的大脑-计算机接口的实现,该大脑-计算机接口使用实时的眼睛跟踪和神经活动的在线分析来传达用户对机器的操纵。

背景技术

人类-计算机接口(HCI)是一种硬件和软件通信系统,其允许大脑活动利用连线的大脑与外部设备之间的直接通信通路来控制计算机或外部设备。HCI主要被设计为一种通过解释大脑信号来直接提供对操作机器和应用的访问的辅助技术。HCI发展的主要目标之一是为严重残疾的人提供交流能力,这些人由于神经系统神经肌肉紊乱(诸如肌萎缩性侧索硬化症、脑干中风或脊髓损伤)而完全瘫痪或“锁定”,与他人进行有效的交流可能极为困难。

大脑计算机接口的一些已知实现包括如由Farwell和Donchin设计的拼写器。在这种拼写器中,字母表中的26个字母以及其它几个符号和命令以6×6矩阵的形式显示在屏幕上,其中行和列随机闪烁。用户将注意力集中在屏幕上并连续地专注于要书写的字符,同时监视大脑的神经反应以寻找特征性(signature)神经大脑信号。一旦检测到特征性大脑信号,就允许系统识别期望的符号。Farwell-Donchin拼写器允许人们以每分钟大约两个字符的速度进行拼写。

发明内容

本文针对硬件不可知的、集成的动眼-神经混合脑机接口(HCI)平台的各种实施例描述了系统、设备和方法,以跟踪眼睛运动和大脑活动,从而传达用户注视(gaze)或注意力的实时定位和期望动作的选择/激活。本公开提出了一种集成的HCI系统,以解决对高速且精确地操作的大脑计算机接口的需求。

附图说明

专利或申请文件包含至少一个彩色执行的附图。专利局将根据要求和必要费用的支付提供带有(一个或多个)彩色附图的本专利或专利申请公开的副本。

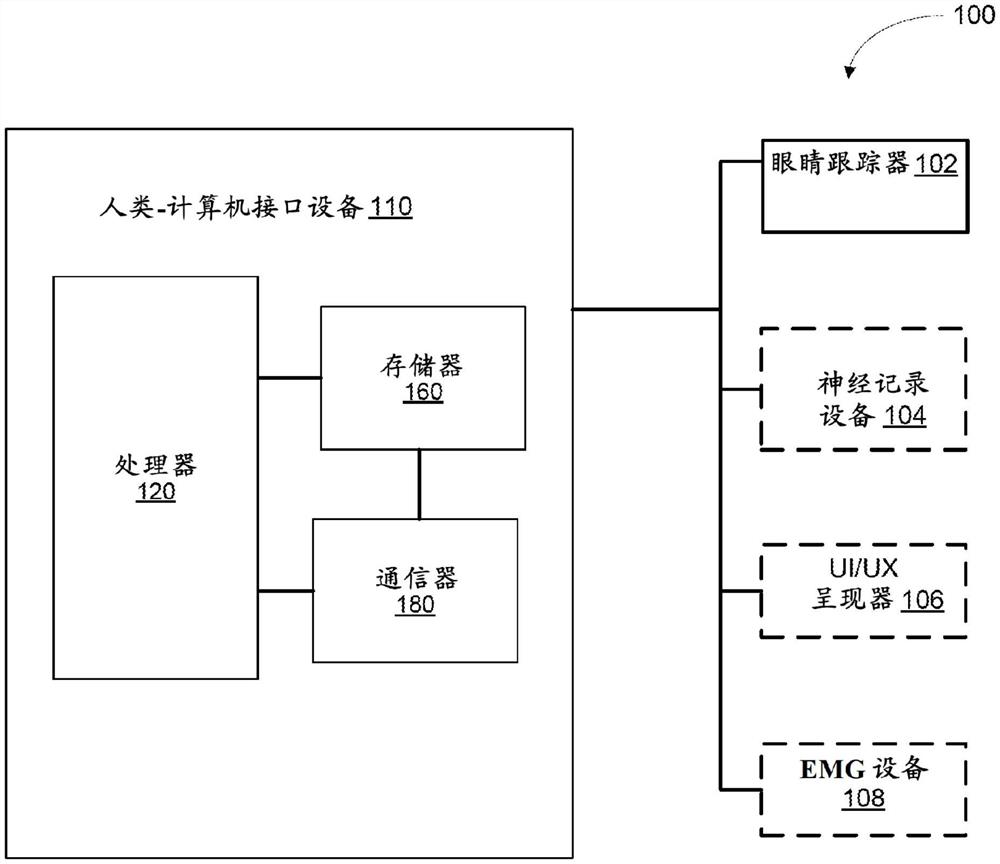

图1是根据实施例的混合人类计算机接口(HCI)系统的示意图。

图2A是根据实施例的经由HCI系统向用户呈现示例性用户界面(UI)/用户体验(UX)的图示。

图2B和2C分别图示了根据实施例的在用户与HCI系统的用户界面交互期间分别使用眼睛跟踪器和神经记录头戴式装置记录的示例性眼睛运动信号和神经信号。

图3是根据实施例的HCI系统的示例性实现中的步骤序列的图示。

图4A和4B是根据实施例的在HCI系统中使用的示例性眼睛跟踪器的前视图和后视图的示意图。

图4C是根据实施例的在HCI系统中使用的包括头戴式显示器的示例性眼睛跟踪器的透视图的示意图。

图4D是根据实施例的在HCI系统中包括的示例性眼睛跟踪器中相对于投影透镜定位的传感器的示意图。

图5A和5B是在示例性HCI系统的眼睛跟踪器中相对于透镜定位以分别捕获中央和倾斜注视期间用户的眼睛运动信号的传感器的示意图。

图5C示出了根据实施例的示例性加权函数,其基于注视位置优先对眼睛运动传感器进行加权,以使用HCI系统改善眼睛跟踪。

图6示出了根据实施例的在UI/UX中呈现的示例性刺激的图像,该示例性刺激用于HCI系统中的眼睛跟踪的隐蔽校准。

图7A图示了根据实施例的在UI/UX中呈现的示例性图像,并且图7B图示了对图7A中的图像的示例性分析的结果,用于HCI系统中的眼睛跟踪的隐蔽校准。

图8A和8B图示了根据实施例的在HCI系统的眼睛跟踪中使用的在针对缩放和偏置的校准之前和之后的示例性注视轨迹。

图9是根据实施例的当在UI/UX中向用户呈现三维刺激以用于HCI系统中的眼睛跟踪的校准时使用视差的示例图示。

图10是根据实施例的使用大脑信号来校准眼睛跟踪的HCI系统的示例性实现的图示。

图11A、11B和11C图示了根据实施例的在HCI系统中的半监督式眼睛运动分类系统的实现中进行的分析。

图12A和12B图示了根据实施例的评估HCI系统中的眼睛跟踪的基准标记系统的示例性实现。

图13是图示根据实施例的在HCI系统中呈现的示例性UI/UX中的可交互对象和由HCI系统生成的界限的示例性图像,以评估用户的注视与对象的交互。

图14A是在图13的示例性UI/UX中描绘的对象的投影的示意图,以分析用户的注视与UI/UX中描绘的对象之间的交互。

图14B是根据实施例的在HCI系统的实现中在分析用户的注视与UI/UX中的对象之间的交互时使用的缩放的示例性处理的示意图。

图15图示了根据实施例的在HCI系统中基于用户生成的信号来识别用户感兴趣的目标刺激的示例性过程的示意性流程图。

图16图示了在根据实施例的HCI系统中用于使用眼睛运动信号来识别用户的目标刺激的示例性过程的示意性流程图。

图17A-17D是分别图示根据四个不同实施例的具有基于耳朵的神经记录设备、肌电图设备和眼睛跟踪器的组合的HCI系统的图像。

图18是根据实施例的在HCI系统中使用眼睛跟踪来分析和导航现实世界环境的示例性过程的示意性流程图。

图19A图示了用户的注意力焦点、用户的眼睛运动以及由视觉显著性图(visualsalience map)表示的图像的显著特性之间的关系。

图19B和19C图示了根据实施例的由HCI系统的用户观看的示例性图像的视觉显著性图和视觉注意力图。

图20是根据实施例的使用HCI系统生成视觉显著性图和视觉注意力图的示例性过程的示意性流程图。

图21是可以由实施例的HCI系统生成的视觉注意力图的示例性。

图22A是根据情绪状态的示例性模型的各种情绪状态的示意图。

图22B是示出与使用根据实施例的HCI系统进行检测相比,通过用户报告的方法检测各种情绪状态的精度的图。

图22C是在实施例的HCI系统中使用多维表示来对情绪的不同状态进行统计建模的示例性过程的示意图。

具体实现

本文公开了用于实现人类-计算机接口的设备、系统和方法。本文描述的实施例涉及用于在利用与策略性地呈现给用户的用户界面/用户体验的用户交互的高速和高效跟踪的人类-计算机接口的实现中使用的系统、设备和方法。本文描述的实施例还涉及硬件不可知的人类-机器或人类-计算机接口的实现,该接口使用神经、眼睛运动和肌电图信号来传达用户对机器和设备的操纵。

本文描述的一些实施例涉及一种装置,该装置包括被配置为向用户呈现交互式环境的显示器;耦合到显示器的眼睛跟踪器,该眼睛跟踪器包括至少一个传感器,该至少一个传感器被配置为记录来自用户的眼睛的眼睛运动信号;以及可操作地耦合到显示器和眼睛跟踪器的接口设备。本文描述的一些实施例涉及一种装置,该装置包括被配置为向用户呈现交互式环境的显示器;耦合到显示器的眼睛跟踪器,该眼睛跟踪器包括至少两个传感器,这至少两个传感器被配置为记录来自用户的眼睛的眼睛运动信号;以及可操作地耦合到显示器和眼睛跟踪器的接口设备。接口设备可以包括存储器和可操作地耦合到存储器的处理器。处理器可以被配置为从眼睛跟踪器中的至少两个传感器接收眼睛运动信号,并且生成和经由交互环境并经由显示器向用户呈现刺激。处理器还可以被配置为基于眼睛运动信号来确定用户的聚焦点;基于用户的聚焦点来确定用户意图的动作;以及执行用户意图的动作。

本文描述的一些实施例涉及一种非暂态处理器可读介质,其存储表示将由处理器执行的指令的代码。指令可以包括使处理器生成可以由用户操纵以执行一组动作的交互式用户环境的代码。指令还可以包括使处理器进行以下操作的代码:定义可以经由交互式用户环境呈现给用户的一组刺激;经由显示器向用户呈现所述一组刺激中的至少一个刺激;从眼睛跟踪器接收由用户生成的眼睛运动信号;并基于与所呈现的刺激相关的信息自动校准眼睛运动信号,以生成一组经校准的眼睛运动信号。指令还可以包括使处理器进行以下操作的代码:基于一组经校准的眼睛运动信号和所呈现的刺激来确定用户的聚焦点;基于聚焦点来确定用户意图的动作;并经由交互式用户环境实现该动作。

本文描述的一些实施例涉及一种方法,该方法包括:向用户并经由显示器呈现交互式用户界面中包括的刺激,并且从眼睛跟踪器接收与用户行为相关联的眼睛运动信号,该眼睛运动信号由定位在眼睛跟踪器上的一个或多个传感器独立记录。在一些情况下,眼睛运动信号可以由定位在眼睛跟踪器上的至少两个传感器记录。该方法还可以包括:接收与所呈现的刺激相关的信息;基于眼睛运动信号来确定用户的聚焦点;基于聚焦点和刺激来确定用户意图的动作;并经由交互式用户界面实现该动作。

如在本说明书中使用的,单数形式“一个”、“一种”和“该”包括复数指示物,除非上下文另外明确指出。因此,例如,术语“一种系统”旨在表示单个系统或系统的组合,“一个算法”或“过程”旨在表示一个或多个算法或过程或指令,或其组合。参考HCI系统的一个实施例描述的任何组件或组件的组合(诸如眼睛跟踪器、神经记录设备、EMG设备或外围头部或身体跟踪设备)可以与本文描述的任何其它实施例一起使用,除非上下文另外明确指出。

示例性人类-计算机接口系统

HCI系统可以被设计为向用户呈现虚拟现实环境或体验。HCI系统可以被用于帮助或增强人们操作计算机或其它数据处理机器和/或软件应用的方式,而无需常规的输入或输出接口(诸如鼠标和键盘)。HCI系统也可以被配置为向用户呈现增强现实环境,以增强与现实世界的交互。HCI还可以被用于增强和提高残疾或行动不便的患者的生活质量。与常规的输入方法相比,HCI还可以提供用于与计算机进行更加直观和自然的交互的接口。此外,还可以将HCI开发为服务于许多其它功能,包括增强、修复以及绘制和研究人类和动物的认知和/或感觉运动系统及其功能。一些示例性HCI应用包括文字处理器、改动的Web浏览器、轮椅或神经假肢的大脑传达控制以及游戏,等等。

为了使HCI技术更好地适合患者、对公众有用并用于控制现实世界中的任务,与当前的实现相比,必须提高信息传送速率以满足自然交互速度,必须降低错误率,并且必须最小化交互接口的复杂性。此外,HCI应用要求用户承担较高的认知负担,因此必须改进UI/UX和信号的底层处理,以从安静的实验室环境转移到现实世界。为了将HCI设备和应用配置为更容易和更直观,在以直观的方式实现高速且高精度地操作的人类-计算机接口或人类-计算机接口时,需要改进的设备和技术,以通过自然的过程启用用户传达的动作选择。

如本文所述,HCI系统包括硬件、指令和软件通信系统,其解释诸如用户的眼睛运动活动或大脑活动或其它运动活动之类的人类活动以控制计算机或外部。在一些实施例中,HCI系统可以基本上类似于2018年8月22日提交的标题为“Brain-computer interfacewith high-speed eye tracking features”的国际专利申请No.PCT/US2018/047598(“'598申请”)中描述的系统,其公开内容通过引用整体并入本文。

在一些实施例中,HCI系统可以包括配置和/或改动,以实现与HCI系统和/或所连接的机器的高速且直观的用户交互。配置或改动可以基本上类似于2017年11月13日提交的标题为“Brain-computer interface with adaptations for accurate and intuitiveuser interactions”的美国专利申请No.62/585,209(“'209申请”)中描述的那些,其公开内容通过引用整体并入本文。

图1是根据实施例的人类-计算机接口系统100的示意图。示例性人类-计算机接口系统100(在本文中也称为“混合HCI系统”或“HCI系统”或“系统”)包括眼睛跟踪器102和人类-计算机接口设备110。HCI系统可选地包括神经记录设备104、用户界面/用户体验(UI/UX)呈现器106以及被配置为记录肌电信号的肌电图(EMG)设备108,如图1中的虚线方框所示。

眼睛跟踪器

HCI系统100中的眼睛跟踪器102可以被配置为捕获、记录、存储和/或传输用户的一只眼睛或两只眼睛的眼睛运动信号,使得眼睛运动可以被用于在任何给定时间指示用户的聚焦点(即,实现上述指点控制特征)。换句话说,眼睛跟踪器102可以被用于通过在二维或三维空间中快速跟随用户的眼睛运动来确定用户在任何给定时间在其视场内看哪里。眼睛跟踪器102可以耦合到HCI设备110,HCI设备110进而可以被配置为处理由眼睛跟踪器102获取的信号。

眼睛跟踪器102可以包括一个或多个照明源,这些照明源被定位和配置为照亮用户的每只眼睛。照明源可以被配置为发射任何合适波长的光并且可以被安装在任何合适的位置以照亮用户的瞳孔并生成第一表面角膜反射(CR)。照明源可以通过紧凑且头戴式的电力系统适当地供电。照明源可以通过有线或无线连接适当地连接以进行数据通信,从而传达控制和数据的传输等。

眼睛跟踪器102可以包括一个或多个安装的传感器或相机(例如,头戴式摄像机)以对用户的一只或两只眼睛成像。例如,在一些实施例中,眼睛跟踪器102可以包括被定位成对每只眼睛成像的一个或多个传感器。在一些实施例中,眼睛跟踪器102可以被配置为用于一只眼睛(例如,优势眼)。可以通过紧凑的头戴式电源为安装的传感器或相机供电。传感器或相机可以直接且独立地耦合到人类-计算机接口设备110,使得HCI设备110可以以逐个传感器的方式独立地接收由每个传感器或相机获取的信号。HCI设备110可以处理由每个传感器获取的信号,如在本文进一步详细描述的。在一些实施例中,相机可以被连接成彼此通信。

在一些实施例中,眼睛跟踪器102可以耦合到UI/UX呈现器,UI/UX呈现器可以被用于向用户呈现交互式界面,如本文所述。在一些实施例中,UI/UX呈现器甚至可以被包括在眼睛跟踪器102中。在这样的实施例中,当眼睛跟踪器102耦合到UI/UX或包括UI/UX时,眼睛跟踪器102可以包括相对于用户的每只眼睛定位的可选透镜(例如,显示透镜),在虚拟现实(VR)环境的情况下,该透镜被用于将经由UI/UX呈现的视觉刺激投影到用户的眼睛。在一些其它实施例中,眼睛跟踪器102可以包括被配置为观看用户周围的现实世界环境的观看窗口,而不是UI/UX形式的模拟交互式用户界面。在这样的实施例中,眼睛跟踪器102可以包括相对于每只眼睛定位以投影用户的即时现实环境的透镜(例如,观看透镜),类似于一副眼镜。在一些实施例中,眼睛跟踪器102可以包括相对于用户的每只眼睛定位的特殊配置的透镜,以投影现实世界环境,同时还投影模拟的或合成的用户界面以覆盖现实世界视图。在这样的实施例中,眼睛跟踪器102可以被用于向用户提供增强现实(AR)环境。

参考眼睛跟踪器102,传感器或相机可以被策略性地定位成捕获关于用户的眼睛运动的信息,使得可以计算用户的注视角度,而不管用户是正在观看真实的、虚拟的还是增强的环境。例如,在一些实施例中,传感器或相机可以被配置为在用户进行眼睛运动时捕获由照明源生成的用户的瞳孔和第一表面角膜反射的实时的相对位置和构造。在这样的实施例中,眼睛跟踪器102可以被配置为使用瞳孔与第一表面CR之间的位置差来确定用户的眼睛相对于用户的头部的朝向和/或位置。

在包括投影透镜(例如,显示透镜或观看透镜)的实施例中,针对捕获来自一只眼睛的眼睛运动信息的一个或多个传感器可以被定位在投影透镜周围,以最佳地捕获眼睛运动信号,同时不干扰视角。在包括被配置为对每只眼睛成像的多于一个传感器或相机的实施例中,传感器可以沿着特定的轴定位,以最佳地捕获沿着特定的轴对向的分量或向量形式的眼睛运动信号。例如,眼睛跟踪器102的一些实施例可以包括被配置为捕获来自每只眼睛的眼睛运动信号的至少两个传感器,这至少两个传感器沿着正交轴成对地被定位在投影透镜周围。作为示例,每只眼睛包括两个传感器的眼睛跟踪器可以沿着水平轴放置。作为另一个示例,包括四个传感器的眼睛跟踪器可以沿着水平轴和垂直轴成对放置,这些轴彼此正交,如本文中进一步详细描述的。

在一些情况下,眼睛跟踪器102可以包括市售的头戴式眼睛跟踪器,诸如例如可以从SenseMotoric Instruments、Tobii Eye Tracking和Pupil-labs以及其它商供应商获得的眼睛跟踪器。

神经记录设备

HCI系统100中的可选的神经记录头戴式装置104可以被配置为捕获、记录和/或传输来自一个或多个大脑区域的指示用户的认知意图的神经控制信号。神经记录设备104可以包括被配置为使用任何合适的方法来记录神经元之间的神经活动的任何合适的记录设备或系统。神经控制信号可以用作指示用户意图执行的动作选择的动作控制特征。在一些实施例中,神经记录设备104可以被配置为捕获神经信号,该神经信号可以被用于指示用户的聚焦点或补充从眼睛跟踪器102获得的信息以指示实现指点控制特征的用户聚焦点。例如,在一些实施例中,神经记录设备104可以被配置为记录和传输表示用户的自愿肌肉运动(例如,眼睛运动、姿势移动、手势)的神经信号,这些神经信号可以被用于实现指点控制特征。在一些实施例中,神经记录设备104可以被配置为记录并传输与运动表象(例如,执行的或想象的运动)对应的神经信号。在一些实施例中,由神经记录设备104获取的信号可以包括与诸如用户的认知、情感或专心状态之类的大脑状态对应的神经信号。神经记录设备104可以耦合到HCI设备110,HCI设备110进而可以处理神经信号以实现指点控制特征或动作控制特征,如本文所述。

在一些实施例中,神经记录设备104可以被配置为通过以电的方式记录由神经元生成的初级离子电流来直接捕获神经信号,该离子电流在神经元集团内和跨神经元集团流动。在一些实施例中,神经记录设备104可以被配置为通过记录与初级电流相关或由初级电流引起的次级电流或神经系统中的其它变化来间接地捕获神经信号。例如,神经活动也可以通过如光学成像(例如,功能磁共振成像,fMRI)之类的其它方法通过记录由于初级电流导致的光学改变来监视。记录大脑的神经活动的其它方法包括脑电图(EEG)、脑皮层电图(ECoG)、功能近红外(FNIR)成像和其它类似的内在信号成像(ISI)方法、脑磁图(MEG)等。

在一些实施例中,神经记录设备104可以被专门改动为记录一个或多个信号,包括多种特征性大脑信号,诸如事件相关电位(ERP)、诱发电位(EP,例如,感觉诱发的电位,如视觉诱发的电位(VEP)、听觉诱发的电位(AEP)、运动诱发的电位)、运动表象、大脑状态相关信号、皮质慢电位以及其它尚未发现的作为各种认知、专心或感觉运动任务的基础的特征性活动电位。在一些实施例中,神经记录设备104可以被专门改动为在频域中记录一个或多个信号。其中的一些示例性包括感觉运动节律、事件相关频谱扰动(ERSP)、特定信号频带(如Theta、Gamma或Mu节律)等。

如本文所述,神经记录设备104可以记录神经活动信号,以通过记录阶段收集关于用户意图的信息,该记录阶段测量大脑活动并将该信息转换成易于转换的电信号,该信号可以转换成命令。在一些实施例中,例如,神经记录头戴式装置104可以被配置为通过脑电图(EEG)来记录电生理活动,脑电图具有高时间分辨率、低设置和维护成本、高便携性,并且对用户是非侵入性的。在这样的实施例中,神经记录设备104可以包括具有从不同的大脑区获取脑电图信号的传感器的电极集合。这些传感器可以测量由神经元中的树突的突触刺激期间的电流流动所引起的电信号,从而中继次级电流的影响。当放置在用户的头皮或头部的一部分上时,神经信号可以通过适当地布置在期望的大脑区上的神经记录设备104中的电极来记录。示例性神经记录设备可以从如Biosemi、Wearable Sensing和G.Tec等商业供应商处获得。例如,在一些实施例中,神经记录设备104、其在收集神经脑活动信号中的操作以及来自神经记录头戴式装置104的信号传送可以基本上类似于'253申请中描述的那些,该申请的公开内容通过引用整体并入本文。

UI/UX呈现器

HCI系统100中包括的可选的UI/UX呈现器106可以被配置为向用户呈现交互式UI/UX。UI/UX呈现器106可以是被配置为向用户提供视听输入的视听显示器。在一些实施例中,UI/UX呈现器106可以使用一个或多个外围致动器来提供附加模态的输入,诸如触觉输入、体感输入等。一些示例性致动器可以包括音频扬声器、触觉刺激提供器等。

在一些实施例中,眼睛跟踪器102和/或神经记录设备104可以包括集成的UI/UX呈现器106。在一些其它实施例中,HCI系统可以包括与眼睛跟踪器102和神经记录设备104分离的独立UI/UX,并且与HCI系统100的其余部分进行数据通信。例如,与UI/UX呈现器106集成的眼睛跟踪器102可以是被配置为体验虚拟现实环境的系统。在一些实施例中,与UI/UX呈现器106集成的眼睛跟踪器102可以被配置为观看增强现实空间。即,与UI/UX呈现器集成的眼睛跟踪器可以用于观看现实世界环境,就像一副眼镜一样,具有通过显示器或投影区域呈现的叠加或覆盖的UI/UX(例如,投影透镜),如上参考眼睛跟踪器102所描述的。

EMG设备

HCI系统100可以可选地包括图1中所示的EMG设备108。EMG设备108可以被配置为适当地定位在用户的身体上,以在使用HCI系统100时记录和传输来自用户的肌电信号。EMG设备108可以耦合到HCI设备110,并且EMG设备108可以被配置为将获取的信号发送到HCI设备110以供处理。例如,EMG设备108可以被配置为通过监视用户在预定面部区域上的面部肌肉活动来记录面部EMG信号。使用EMG设备108记录的面部EMG可以被传输到HCI设备110,并由HCI系统100用于检测和解释用户的各种认知或运动状态,并使UI/UX适应用户的状态。作为另一个示例性,由EMG设备108记录的面部EMG信号可以被用于在使用HCI系统100向用户呈现UI/UX的同时检测用户的情绪反应或情绪状态。可以使用EMG设备108来监视的一些示例性面部肌肉可以包括能指示积极情绪状态的颧肌和能指示消极情绪状态的皱纹肌。

人类-计算机接口设备

人类-计算机接口设备(或HCI设备)110(在本文中也称为“设备”)可以是基于硬件的计算设备和/或多媒体设备,诸如例如计算设备、服务器、台式计算机设备、智能手机、平板电脑、可穿戴设备、膝上型计算机等。HCI设备110包括处理器120、存储器160和通信器180。

处理器120可以是例如基于硬件的集成电路(IC)或被配置为运行和/或执行指令集或代码的任何其它合适的处理设备。例如,处理器120可以是通用处理器、中央处理器(CPU)、加速处理单元(APU)、专用集成电路(ASIC)、现场可编程门阵列(FPGA)、可编程逻辑阵列(PLA)、复杂可编程逻辑设备(CPLD)、可编程逻辑控制器(PLC)等。处理器120通过系统总线(例如,地址总线、数据总线和/或控制总线)可操作地耦合到存储器160。

简要地,处理器120可以被配置为接收和处理由眼睛跟踪器102记录和传输的眼睛运动信号。处理器可以被配置为执行与高速眼睛跟踪相关联的功能,诸如眼睛运动信号的自动校准,如下面进一步详细描述的。处理器120还可以被配置为生成和更新经由UI/UX呈现器106呈现给用户的交互式UI/UX,并接收和处理由神经记录设备104记录和传输的神经信号、由UI/UX呈现器106传输的数据、EMG设备108的肌电信号,以及从耦合到HCI系统100的各种外围传感器和/或致动器接收到的任何其它信号。处理器120可以将接收到的信号和数据单独且分离地或一起作为整体处理。从各种其它组件(如眼睛跟踪器102、神经记录设备104、UI/UX呈现器106和EMG设备108)接收的信号处理可以包括如信号获取、信号预处理、信号校准和/或信号增强等过程。

处理器120还被配置为使用指点控制特征和动作控制特征来实现与UI/UX的用户交互,并且与眼睛跟踪器102、神经记录设备104、UI/UX呈现器106、EMG设备108和各种其它外围传感器和/或致动器以及可以耦合到HCI系统的机器通信。

处理器120可以被配置为生成策略性设计的UI/UX,以满足一个或多个用户的特定需求。可以针对诸如教育、娱乐、游戏、装备控制、用于残疾人的通信接口(例如,拼写器)等各种需求生成策略性地设计的UI/UX。在一些情况下,UI/UX可以用于训练项目,以便用户可以获得使用HCI系统执行特定动作(例如,控制复杂装备)的能力。处理器120可以被配置为学习并适应一个或多个用户。然后可以对特定于用户的训练UI/UX进行适配,以生成用于测试和现实世界实现的UI/UX。在一些实施例中,UI/UX可以被设计为虚拟现实环境或增强现实环境。在一些实施例中,UI/UX可以针对特定用户的特定要求(诸如例如特定用户历史、反应时间、用户偏好等)而定制构建。处理器120可以在生成和更新UI/UX时解决所有这些要求。

在一些实施例中,与处理眼睛运动信号、神经动眼信号、EMG信号和/或来自外围传感器的信号相关联,处理器120还可以访问和处理与有因果关系的刺激或经由UI/UX呈现的诱发了正在处理的信号的刺激相关的数据。利用组合的信息,处理器120可以基于统计模型检测有关信号特征、应用核实的置信度得分(如以下更详细描述的),以预测用户的意图。然后这个预测的意图可以经由例如经由UI/UC呈现器106呈现的UI/UX被传送给用户,并被用于实现UI/UX的改变以及任何所连接的可控制机器或装备的改变。

处理器120可以执行用于信号分析的任何合适方法。例如,处理器120可以从信号中检测一组特征,这些特征可以被用于构建和应用统计模型以解释信号。例如,处理器120可以被配置为对信号进行分类,对信号和诱发信号的刺激进行评分,将信号与UI/UX中可能引起信号的一个或多个目标刺激相关,确定并执行与用户意图的目标刺激相关联的动作。处理器120可以通过实现指点控制特征和动作控制特征来确定并执行用户意图的动作。处理器120被配置为允许用户与所呈现的UI/UX进行交互并且基于用户交互来更新UI/UX,使得用户动作导致所意图的结果性事件。例如,在一些实施例中,在用户可以使用HCI系统100操纵装备的情况下,处理器120呈现UI/UX,接收并处理眼睛运动信号、神经信号、EMG信号和/或来自用户的其它外围信号,将信号解释为用户交互,基于用户交互更新UI/UX,并基于用户与UI/UX的交互来控制装备。

在一些实施例中,处理器120可以包括被配置为在处理器120的运行中执行一个或多个上述功能或其它相关处理的组件或单元(图1中未示出)。例如,处理器可以包括组件或单元,每个组件或单元被配置为从眼睛跟踪器、神经记录设备、EMG设备、UI/UX呈现器等接收信号,处理接收到的信号并分析信号,并解释信号等。处理器还可以包括被配置为生成要经由UI/UX呈现器呈现给用户的UI/UX的组件,以及被配置为基于对从用户接收到的信号的解释来实现UI/UX中的适当改变的组件。处理器120还可以包括被配置为使用合适的工具(例如,机器学习工具)构建统计模型以学习从用户接收的信号(例如,眼睛跟踪器信号、神经记录信号、EMG信号等)与用户的意图之间的关联的组件。这些关联可以被用于训练HCI系统100操作为满足特定的用户需求。在一些实施例中,处理器120中包括的各种组件可以是可被存储在存储器160中并由处理器120执行的代码形式的软件应用或例程或指令。在一些实施例中,HCI设备110和处理器120可以基本上类似于'253申请中描述的HCI设备和处理器,该申请通过引用整体并入本文。

HCI设备110的存储器160可以是例如随机存取存储器(RAM)、存储器缓冲器、硬盘驱动器、只读存储器(ROM)、可擦除可编程只读存储器(EPROM)等。存储器120可以存储例如一个或多个软件模块和/或代码,其可以包括使处理器120执行一个或多个处理、功能等(例如,UI/UX的生成、建立统计模型以将从用户接收的动眼或神经或EMG信号与用户意图相关联、向用户训练HCI系统、使用统计模型预测用户意图、控制与HCI系统耦合的机器或装备,等等)的指令。在一些实现中,存储器160可以是可操作地耦合到处理器120的便携式存储器(例如,闪存驱动器、便携式硬盘等)。在其它情况下,存储器可以与HCI设备110远程地可操作地耦合。例如,远程数据库服务器可以可操作地耦合到HCI设备110。

HCI设备包括被配置为在HCI设备110与眼睛跟踪器102、神经记录设备104、UI/UX呈现器106、EMG设备108和HCI系统100中包括的其它外围传感器或致动器(图1中未示出)之间接收和发送通信的通信器180。通信器213可以是可操作地耦合到处理器120和存储器160的硬件设备和/或由处理器120执行的存储在存储器160中的软件。通信器180可以是例如网络接口卡(NIC),Wi-Fi

虽然在图1的示意图中未示出,但是在一些实施例中,HCI系统100可以包括一个或多个可选的外围传感器以通过其它模态(如声音、触摸、朝向等)收集与用户的行为相关的数据以及外围致动器以呈现丰富的、多模态的用户体验。

虽然在图1的示意图中未示出,但是在一些实施例中,HCI系统100可以连接到包括中央控制系统或服务器系统的其它HCI系统的网络并与之集成。在这样的实施例中,HCI系统100可以使用每个HCI系统向每个用户呈现多用户体验。在这样的实施例中,中央控制系统可以基本上类似于HCI设备110,并且执行所有用户可共用的一些功能,诸如生成和更新多用户UI/UX、接收与所有用户运动相关的输入等。每个集成的HCI系统的每个HCI设备110可以执行适于单个用户的本地化功能,诸如生成和更新单用户UI/UX、接收与单用户运动相关的输入等。

HCI系统的工作

如上所述,HCI系统可以被用于通过交互式UI/UX向用户呈现刺激。由用户生成的信号(诸如眼睛运动、神经或EMG信号)可以被记录、分析和解释,并被用于执行交互式UI/UX的控制。在一些情况下,HCI系统可以耦合到外部装备或装置或现实世界环境的其它方面,并且用户对UI/UX的控制可以被用于传达对外部装备或装置或相关联的现实世界方面的控制。用户对UI/UX的控制可以包括指点控制特征和动作控制特征,以传达用户与(UI/UX)特征的交互。指点控制特征可以类似于如鼠标指针的常规指点设备,它允许用户缩小到一个或多个操纵器或可交互动作项(例如,图标、对象、刺激、标签等)的小集合进行控制。动作控制特征可以类似于传达动作(例如,选择、取消选择等)的设备,例如鼠标单击或键盘上的击键,这允许用户经由UI/UX实现在UI/UX或连接的机器或装备(例如,轮椅)中执行改变的动作。HCI系统中的UI/UX特征可以类似于操作系统,操作系统除了如提供选择菜单、导航控制等其它特征外还可以创建和维护实现指点和动作控制特征的环境。

由动作控制特征执行的动作可以是许多动作之一,并且可以被改动以适合被设计为控制各种设备或机器的各种版本的UI/UX。仅举几个示例性,动作可以是激活或去激活、对UI/UX的连续或半连续改变。例如,滚动、悬停或捏合、缩放、倾斜、旋转、滑动,等等。动作还可以利用离散的开始和停止(如突出显示等)来对UI/UX进行剧烈改变。经由UI/UX的动作控制的其它一些示例性可以包括虚拟键盘控件、菜单导航、放置和取消放置对象或项目的动作、移动物件或项目的动作、展开和/或缩小对象的动作、第一人称观察者或玩家的移动或导航、观察者的视角改变,以及如抓取、拾取或悬停的动作。动作控制的这些方面中的一些在下面公开。

在实现HCI系统的一些实施例中,可以通过处理用户的眼睛运动信号来实现用于识别用户的聚焦点的指点控制特征和方法。在一些实施例中,可以通过对UI/UX的操纵和/或使用神经信号来实现用于识别用户的聚焦点的指点控制特征和方法,所述神经信号它们本身或者在一些情况下作为处理眼睛运动信号的补充或附加、关于用户的聚焦点是信息丰富的。在本文描述的HCI系统的一些实施例中,指点控制特征可以包括通过诸如肌电图之类的各种方法从骨骼肌群或单个肌肉的运动中记录的信号。在其它实施例中,可以同时(例如,HCI系统)或单独地使用大脑信号、肌肉运动的信号、眼睛运动信号和UI/UX的策略操纵的组合来实现指点控制特征。除了上面提到的信号之外,混合式或其它的HCI系统还可以监视和使用来自各种外围传感器的其它信号(例如,头部位置跟踪信号、手势、姿势调整等)。

在一些实施例中,HCI系统可以实现复杂的UI/UX,其实现UI/UX或机器的基于人类行为的控制。如下所述,可以实现对这些特征中的一个或多个的特定改动,以实现与HCI系统的人类交互的高速度和高精度。例如,在一些实施例中,HCI系统可以与在上面通过引用并入的'598申请中描述的系统基本相似。

可以考虑到HCI系统要满足的需求来适配UI/UX。例如,患者用于移动性的HCI系统可以包括以易用性和低认知负荷为目标的UI/UX。作为另一个示例性,儿童用作学习工具的HCI系统可以包括为儿童的直观交互量身定制的UI/UX。类似地,旨在提供游戏体验的HCI系统可以包括为高速和精度等设计的UI/UX。例如,在一些实施例中,HCI系统和/或用户界面/用户体验(UI/UX)可以与在上面通过引用并入的'209申请中描述的那些基本相似。

HCI系统可以被配置为通过复杂的UI/UX与一个或多个用户交互,该UI/UX使用一个或多个底层方法套件进行操作。例如,HCI系统可以配置有底层分析工具和方法,这些底层分析工具和方法与2018年1月18日提交的标题为“Brain-computer interface withadaptations for high-speed,accurate,and intuitive user interactions”的美国专利申请No.62/618,846(“'846申请”)中描述的那些基本相似,其公开内容通过引用整体并入本文。

图2A图示了经由示例性UI/UX 271与示例性HCI系统200的示例性用户交互。系统200可以在结构和/或功能上与上述HCI系统100基本相似。例如,BCI系统200可以包括眼睛跟踪器202、神经记录设备204、HCI设备(未示出)和呈现UI/UX 271的UI/UX呈现器206。如图2A中所示,HCI系统200可以经由眼睛跟踪器202捕获眼睛运动信号,并经由神经记录设备204捕获神经信号,以帮助用户拼写单词和/或句子。UI/UX 271可以以标签或对象的组的形式呈现刺激,也称为标签组闪烁,包括标签279(例如,键盘上常见的字母、数字和符号),如图2A中所示。闪烁的标签之一可以是用户感兴趣的目标标签285,例如图2A的图示中的字母Q。示出了用户进行眼睛运动以注视或沉浸于(foveate to)UI/UX 271中的目标标签285(字母“Q”)上,以选择该字母来拼写单词。图2B和2C示出了与用户的沉浸或将聚焦点指向目标标签相关联的示例性眼睛运动信号和神经信号,以及在观看目标标签时包括特征性形状(例如,事件相关电位)的相关联神经信号(黑色)。图2C还示出了当用户观看不是目标标签的标签时的神经信号(洋红色)以供比较。

图3以处理350的示意性流程图的形式示出了HCI系统300的示例性实现。系统300在结构和/或功能上可以与上述系统100和/或系统200基本相似。在图3所示的示例性实现中,经由UI/UX 371向用户呈现包括对可交互对象379(在本文中也称为标签)的选择的刺激。在示例性图示中,标签379(例如,八边形)之一可以是用户感兴趣的目标标签385。图3所示示例中的事件的序列包括刺激的呈现(例如,包括与一组动作相关联的一组标签的刺激),获取随后的神经活动信号和动眼信号和/或外围信号(如果适用的话),分析获取的信号,解释这些信号以推断或解码用户的意图,并执行UI/UX的改变(例如,通过选择与一个或多个动作相关联的一个或多个标签)。进而,为改变UI/UX而实现的一个或多个动作还可以控制经由UI/UX连接的一个或多个外部机器。

在图3所示的HCI系统的示例性实现中,在步骤351处,向用户呈现输入刺激。输入刺激可以是例如在示例性UI/UX 371中示出的一组标签或符号379。虽然UI/UX 371中的所有标签379都是可见的,但可以将标签379中的一个或多个配置为在视觉外观上短暂改变以指示其可用于选择。外观的改变可以是标签的任何合适特性的改变(例如,填充、透明度、强度、对比度、颜色、形状、尺寸、朝向等)。例如,标签379中的一个或多个可以被配置为闪烁(在本文中也称为“标签闪烁”)以指示潜在的选择。可见标签379的不同分组可以被配置为一起闪烁,从而产生标签闪烁的几种组合,或者标签组闪烁中的几种,每个标签闪烁或标签组闪烁都是刺激。应当注意,虽然示例性刺激被描述为在视觉模态中并且改变以视觉模态呈现,但是任何合适的模态都可以被用于呈现刺激并执行类似的动作选择。例如,听觉音调可以被用作标签。听觉标签的任何合适的听觉特性都可以被暂时改变以指示它们可用于选择。例如,诸如响度、持续时间、音调、啁啾、音色等特性可以被临时改变,以用作UI/UX的听觉空间中的标签闪烁。

在351处在UI/UX 371中呈现的三个标签379可以被配置为在被选择时各自传达不同的动作。可见标签之一可以是目标标签或用户想要选择的标签。通过图3所示的示例性过程,HCI系统(如上述HCI系统100)的目标是确定所呈现的标签379中的哪一个是用户想要选择的目标标签。

UI/UX 371可以被配置为在步骤351处一次或多次将每个可见标签379呈现为刺激(例如,通过标签闪烁),并且在步骤353中,HCI系统(例如,系统100)获取随后的大脑活动信号373和/或眼睛运动信号375以及报告用户行为的任何其它信号(图3中未示出)连同关于刺激呈现377的信息(例如,呈现了哪个标签或标签组、在哪个时间点、在UI/UX 371的什么位置等),如果适用的话。

可用标签379可以通过单独闪烁的标签或标签组的组合来呈现。标签组中的标签闪烁可以减少定位目标标签385所需的闪烁次数。在一些情况下,刺激呈现还可以包括与标签无关的、期望不被用户注意到的重影闪烁的不可见刺激的伪呈现。重影闪烁可以被用于通过UI/UX 371校准刺激呈现。例如,在对指示用户对于特定标签379的聚焦或注意点的信号进行分析期间,可以使用重影闪烁来设置检测阈值。通过使用两只眼睛将注意力集中在目标标签上,可以诱使用户沉浸于感兴趣的目标标签。

在355处,HCI系统分析获取的动眼信号375、神经信号373(以及来自其它传感器的其它外围信号),这些信号可以被单独执行或以集成方法作为整体被执行。在刺激信息377的上下文中执行神经和动眼神经信号(以及EMG、外围信号)的分析。例如,所呈现的刺激的时空特性可以与所获取的动眼、神经和/或EMG信号相关。分析可以包括几种计算方法,诸如信号的预处理、特征检测和特征提取、降维、监督式、无监督式或半监督式分类、构建或应用一个或多个预先构建的统计模型来解释信号、每个分析的置信度分数(例如,分类的置信度分数)的计算、结合并使用刺激信息377的合适方式的计算(例如,一个或多个缩放函数的应用)、每个标签379是目标标签385的可能性的计算、关于目标标签385的身份的确定的解码和/或决定等。图3中的示意图图示了由HCI系统执行的示例性分类过程,以识别在351处呈现的三个标签中的哪一个可以是用户感兴趣的目标标签。

步骤357包括基于在步骤355处执行的分析来确定目标标签385的身份。可以使用任何合适的方法来执行步骤357的决定或确定。例如,使用一种或多种跨阈值算法或其它合适的机器学习工具。

如UI/UX 371A、371B和371C所示的三个可能结果所指示的,步骤357处的决定可以导致在步骤359中对标签379之一的选择。步骤359中的选择进而可以导致执行相关联的动作。例如,如果目标标签385被正确地识别为八边形标签,那么可以执行与八边形相关联的动作3。还可以包括用户验证的一个或多个步骤,以确定目标标签385的识别是否正确。用户可以给出关于目标标签385的识别是对还是错的反馈。这个用户反馈可以被用于确认或校正用于确定将HCI系统训练为与特定用户或特定用例等更好匹配的目标标签的各种分析处理和统计模型385。该反馈可以也可以被用于训练用户。例如,如果例如由于歧义或者因为一个或多个信号太弱而导致用于在357处做出决定的信息不足,那么可以向用户提供指示器以在不同情况下再次重试(例如,更好的聚焦)。

处理眼睛运动信号以进行精确和高速的眼睛跟踪

如本文所述,HCI系统100、200和300可以以高速度和精度处理眼睛运动信号,从而确定用户的聚焦点和用户的预期动作。眼睛运动信号可以由上述眼睛跟踪器捕获。图4A和4B图示了HCI系统400的示例性眼睛跟踪器402的前视图和后视图,眼睛跟踪器402在结构和/或功能上可以分别与系统100和200的先前描述的眼睛跟踪器102和202基本相似。眼睛跟踪器402包括被配置为捕获和记录左眼的运动(例如,由左眼生成的注视角)的左眼相机422和被配置为捕获并记录右眼的运动的右眼相机424。眼睛跟踪器402还包括场景相机,该场景相机被配置为捕获和记录用户所看到的场景或环境(例如,现实世界环境)。

独立传感器

在一些情况下,当HCI系统可以被用于呈现虚拟环境时,眼睛跟踪器可以包括投影透镜,以利用相关联的UI/UX投影虚拟环境。HCI系统500中包括的这种眼睛跟踪器502的示例性在图4C中示出。系统500在结构和/或功能上可以基本上类似于系统100、200、300和400。示例性眼睛跟踪器502包括分别针对左眼和右眼定位的两个投影透镜521和523。眼睛跟踪器502包括分别定位在透镜521和523周围的传感器522和524,以分别捕获左眼和右眼的运动。

传感器定位和注视角计算

为了实现高速且精确的眼睛运动跟踪,HCI系统中包括的眼睛跟踪器(例如,眼睛跟踪器102、202、402和502)可以被改动为每只眼睛包括几个传感器,从而捕获并以预定方式记录眼睛运动信号。例如,如前所述,在一些实施例中,眼睛跟踪器可以包括被定位成捕获由用户的每只眼睛生成的眼睛运动的两个或更多个传感器。眼睛跟踪器可以包括被定位成向每只眼睛投影UI/UX或现实世界的投影透镜,并且被配置为捕获到眼睛运动信号的两个或更多个传感器或相机可以被定位在每只眼睛的投影透镜周围。图4D图示了在HCI系统600中包括的眼睛跟踪器602的透视图,HCI系统600在结构和/或功能上可以与系统100、200、300、400和/或500基本相似。眼睛跟踪器602的图示示出了四个传感器622A、622B、622C和622D的定位,这些传感器针对捕获用户的一只眼睛(例如,左眼)的运动。传感器沿着水平轴和垂直轴这两个轴被定位在那只眼睛的投影透镜621周围。字母指示四个传感器中每个传感器的位置,其中622A为左上(TL)、622B为右上(TR)、622C为左下(BL),而622D为右下(BR)。可以适当地选择两个轴,以提供关于眼睛位置和眼睛运动的最佳指示,例如就注视位置和注视角而言。如图所示,在该示例中,在一些情况下,传感器可以沿着彼此正交的轴被成对地定位,以沿着正交方向(例如,水平和垂直方向)互补地传达注视角。

如之前参考上文中的眼睛跟踪器102所描述的,眼睛跟踪器的传感器可以被配置为独立地捕获和记录眼睛位置和眼睛运动信号,并以特定于传感器的方式将记录的信号传输到HCI设备(例如,上述HCI设备110)。换句话说,由一个传感器捕获和传输的信号可以不受另一个传感器捕获和传输的信号的破坏。

HCI设备可以基于从传感器获得的信号来执行适当的处理和分析。例如,HCI设备可以被配置为从每个传感器获得眼睛运动信号,并独立地计算指示每只眼睛的注视角的注视方向向量。可以相对于一个或多个轴计算注视方向向量(例如,具有相对于水平轴定义的量值和方向的水平注视向量,或具有相对于垂直轴定义的量值和方向的垂直注视向量)以便被用于确定注视位置或用户的聚焦点(例如,沿着水平和/或垂直轴的位置)。当相对于两个或更多个轴对向时,视线向量可以被用于共同表示用户的注视角。例如,HCI设备可以计算水平方向上的注视向量(例如,指向左的向量)和垂直方向上的注视向量(例如,指向上),并且它们可以共同表示朝着左上角的注视角。

HCI设备可以从眼睛跟踪器和/或UI/UX呈现器获得附加信息,诸如眼睛跟踪器的配置、传感器定位、传感器的数量、从用户的眼睛到投影透镜的距离、与眼睛跟踪的光学元件相关的合适信息(例如,投影透镜的图像形成特性)、所呈现的UI/UX等。HCI设备可以使用该附加信息来定位用户相对于UI/UX的聚焦点。

在一些情况下,HCI设备可以组合从沿着一个轴定位的每个传感器获得的原始眼睛运动信号,以获得沿着另一个轴的眼睛运动的精确估计。在一些其它情况下,HCI设备可以基于来自每个传感器的眼睛运动信号来计算,然后组合从沿着一个轴定位的传感器计算出的注视向量以获得对沿着另一个轴的眼睛运动的精确估计。作为示例,在图4D中,HCI设备可以将从左上角位置的传感器622A获得的信号或注视向量与从右上角位置的传感器622B获得的信号或注视向量组合(例如,mean(TL,TR)),并将从左下角位置的传感器622C获得的信号或注视向量与从右下角位置的传感器622D获得的信号或注视向量组合(例如,mean(BL,BR)),以获得垂直轴上注视向量的平均估计(例如,垂直运动=mean(mean(TL,TR),mean(BL,BR)))。作为另一个示例,HCI设备可以组合从右上和右下位置的传感器622B和622D获得的信号或注视向量(例如,mean(TR,BR)),并组合从左上和左下位置的传感器622A和622C获得的信号或注视向量(例如,mean(TL,BL)),以获取水平轴上的注视向量的平均估计(例如,水平运动=mean(mean(TR,BR),mean(TL,BL)))。如前所述,沿着彼此正交的两个轴的注视向量可以共同表示用户在由两个轴定义的二维平面中的注视角或眼睛运动。

在一些情况下,可以使用来自两只眼睛的信息(例如,使用来自双眼注视确定的聚焦深度)和/或通过使用来自UI/UX中呈现的刺激(诸如与计算出的注视角相关联的对象,该对象在UI/UX中具有感知的深度)的附加提示来确定三维空间中用户的注视位置或聚焦点。通过操纵UI/UX中的各种特征,如与UI/UX中的其它对象相比的对象的相对尺寸和位置(例如,较小和较高的对象往往被认为在深度上更远),对象被其它对象遮挡(例如,被感知为更靠近观看者的对象遮挡),以及通过对象的相对移动(例如,距离较远的对象比靠近观看者的对象移动得更慢)等等,对象可以与感知深度相关联。

传感器加权

在一些实现中,HCI设备可以被配置为生成一组加权系数,使得可以利用不同的加权系数对从眼睛跟踪器上的每个传感器获得的信号进行加权。在一些实现中,在两个示例性情况下,可以基于用户的眼睛运动或注视角来确定权重,如图5A和5B中所示。例如,在一些实施例中,当眼睛直接面对传感器或相机时,眼睛运动传感器或相机可以具有增加的精度和减小的可变性。即,当用户进行向左的眼睛运动或注视移动时,眼睛更靠近位于左侧的传感器,并且左传感器可以具有增加的精度和降低的可变性。相反,因为可被传感器捕获的瞳孔表面减少,斜视可能难以检测。基于这些观察,当用户进行指向性的眼睛运动时,HCI设备可以被配置为粗略地评估眼睛运动并更新与耦合到眼睛跟踪器的每个传感器相关联的加权系数,从而使得与传感器的由于眼睛运动方向而有缺点的其余传感器相比,可以更多地依赖可以受益于增加的精度和减小的可变性的传感器。

图5A和5B图示了示例性眼睛跟踪器702的左投影透镜721以及相对于左眼定位在透镜721周围的传感器722A和722B。眼睛跟踪器702可以被包括在HCI系统700(未示出)中,HCI系统700可以在结构和/或功能上类似于之前描述的HCI系统100、200、300、400、500和600。透镜721可以被用于在UI/UX表面内的各个位置投影目标刺激779。在图5A中,目标刺激729在中心,而在图5B中,目标刺激在透镜721的左边缘。如图5A中所示,当用户朝着位于中心的目标刺激729进行向前眼睛运动时(即,用户笔直向前沉浸),传感器722A和722B沿着水平方向(例如,左传感器和右传感器)可以各自传输眼睛运动信号,这导致计算出的注视向量垂直于每个传感器的垂直轴(由箭头指示)。可以确定两个传感器具有相当程度的精度和可变性。因此,HCI设备可以采用相等的加权(或两个传感器之间的加权为50:50)。但是,如图5B中所示,当用户朝着左边缘处的目标刺激729进行倾斜的、向左的眼睛运动时,左传感器722A可以传输眼睛运动信号,从而导致相对于传感器722A的中心轴垂直的注视向量,并且具有增加的精度和降低的可变性。右传感器722B可能遭受降低的精度和/或增加的可变性,并生成具有高倾斜度的计算出的注视向量,如斜箭头所指示的。在这种情况下,可以采用两个传感器之间的偏差加权(例如,80:20加权),以更多地依赖传感器722A而更少地依赖传感器722B,从而更好地估计眼睛运动信号以指示用户的聚焦点。

换句话说,可以使用每个传感器针对每只眼睛计算注视向量,并且可以基于眼睛运动的特性(诸如相对于注视角的那个传感器的垂直角的倾斜度)对与每个传感器相关联的注视向量进行适当加权。当用户实时进行眼睛运动时,可以基于每次眼睛运动来动态地改变与每个传感器相关联的权重。

在一些实施例中,如上所述,眼睛跟踪器可以包括用于每只眼睛的多于两个传感器,沿着正交轴成对地围绕透镜定位,如图4D中的示例所示。例如,眼睛跟踪器可以在每个透镜周围包括四个传感器,以捕获每只眼睛的眼睛运动,这些传感器沿着垂直和水平轴成对定位。HCI设备可以将权重分配给每个传感器,以通过组合由从每个传感器获得的信号得到的经加权的垂直注视向量来计算垂直注视向量的平均估计。分配给每个传感器以计算组合垂直注视向量的权重(例如,w

作为示例,参考图4D,HCI设备可以通过组合从右上和右下位置的传感器622B和622D获得的加权水平向量(例如,mean(TR,BR))以及从左上和左下位置的传感器622A和622C获得的加权水平向量(例如,mean(TL,BL))来生成组合的水平注视向量。可以通过估计向量相对于与计算方向垂直的轴的倾斜度来动态地确定分配给每个传感器的权重,如果倾斜度减小,那么传感器的权重更大。例如,当计算水平向量时,相对于垂直轴计算倾斜度。

因此,来自传感器622B和622D的水平注视向量可以被组合为(mean(w

在一些实现中,HCI系统可以基于模拟的眼睛运动生成运动学模型,使得可以代替和补偿从眼睛跟踪器的一个或多个传感器获得的眼睛运动信号中的缺失数据或人造数据。运动学模型可以使用包括以下的信息生成:眼睛的解剖结构、眼睛跟踪器的配置、与用户相关的信息(诸如头部位置)、投影透镜的UI/UX呈现器与用户的眼睛之间的距离、用户眼睛的间距等。在一些实施例中,运动学模型可以被配置为逐个传感器地在传感器中生成模拟的用户(模仿真实用户)的模拟眼睛运动信号。

在一些实现中,HCI设备可以基于来自其他用户的聚合数据、或在先前项目中从同一用户收集的眼睛运动数据或从模仿用户的眼睛运动的模拟的眼睛运动数据构建用户的眼睛运动的统计模型。然后,HCI设备可以使用该模型来为用户生成预测眼睛运动信号,这可以帮助高速眼睛跟踪。在一些情况下,HCI设备可以在给定时间收集眼睛运动的特性(例如,在时间Ts处正在进行的眼睛运动的动量和方向),并使用这些特性来预测在将来的时间点(例如,时间T+t s,其中T和t可以是时间间隔值)的注视位置或眼睛运动。HCI设备还可以利用运动学模型来获得确定用户的预测注视位置或注视向量时的附加精度,以确定用户想要的动作。

自动校准

在本文描述的HCI系统的一些实现中,分析用户的眼睛运动信号以确定用户的聚焦点和/或确定用户感兴趣的目标刺激的处理可以包括对眼睛跟踪器的精确校准。如下所述,可以在一个或多个递增的且独立的过程中进行眼睛跟踪器的校准。在一些情况下,可以为每个实现或每个用户自动完成校准。

在一些实现中,可以公开地进行校准(即,在清楚地了解用户的情况下)。例如,HCI系统可以生成并使用被明确设计用于眼睛跟踪器校准的刺激(例如,5-9点校准例程),这些刺激包括预定义的校准点(例如,5-9个点),用户可以在该预定的校准点上以监督的方式被指示固定预定的时间段。在一些其它实现中,可以在用户不知情的情况下秘密进行自动校准,因此不会引起干扰。

隐蔽校准可以使用具有捕获用户的注意力和聚焦点的高可能性的刺激,即,最有可能使用户沉浸于特定的一组点的刺激。例如,UI/UX可以被策略性地设计为包括要求用户沉浸于一组点或极有可能这样做的刺激。图6图示了来自UI/UX中呈现的虚拟环境的示例性图像,其中要求用户访问一扇门以前进到下一个场景或环境。门上的点(例如,用于操纵门的点)表示很有可能使用户聚焦的点,因此可以被用于隐蔽校准眼睛跟踪器和/或HCI系统,以更好地捕获用户的眼睛运动信号并更好地利用UI/UX呈现刺激。类似地,对象的中心可以更有可能接收用户聚焦并且可以用作隐蔽校准点。

作为另一个示例性,视觉刺激中包括高视觉的区域可以用作眼睛运动跟踪的隐蔽校准点。显著性(salience)可以是经由UI/UX投影的视觉场景或图像的紧急特性。视觉显著性可以归因于视觉特性不同的对象和/或包括上下文相关信息的可能性高的对象。HCI系统可以被配置为分析UI/UX中包括的图像,以确定在隐蔽校准中使用的高视觉显著性点。图7A和7B图示了确定高视觉显著性的点的一组示例性分析。

可以对图像中的视觉显著性进行建模以预测高显著性的点,诸如例如White等人于2017年1月24日发表在《Nature Communications》杂志上题为“Superior colliculusneurons encode avisual saliency map during free viewing of natural dynamicvideo”的科学出版物中概述的过程。可以生成包括高显著性的对象在内的视觉刺激,以用于校准。还可以使用从远程服务器可获得的现有数据集的示例来生成此类视觉刺激,包括来自各种计算模型的具有标记的显著性级别的视觉场景。在一些情况下,可以通过使用CNN组合显著性模型来生成包括高显著性的对象的视觉刺激。

在一些实现中,HCI系统可以使用显式的校准例程,使得高显著性的对象可以包括包含具有锋利边缘、锋利相交线或平面的区域、具有高对比度或移动的区域的对象,或者传达上下文相关信息的对象。在指导用户将注意力集中在视觉显著性高的点上时,使用明显校准算法,诸如5或9点。在一些实现中,HCI系统可以使用kalman滤波器来处理从传感器获得的眼睛运动信号,并基于统计或运动学模型使用意图的眼睛运动的理论预测来校准眼睛运动信号。在一些实现中,可以递增地使用多于一种校准方法来改善用户的聚焦点的确定。

缩放和范围变化

在HCI系统中,为了充分利用UI/UX呈现器上呈现的UI/UX并精确估计用户的聚焦点,可以对UI/UX进行缩放和范围变化以使其最适合用户的眼睛运动。耦合到HCI系统的眼睛跟踪器的HCI设备可以被配置为运行一组预编程的指令,以隐蔽地且自动地对UI/UX进行缩放和范围变化,以便以无妨碍的方式适应用户的眼睛运动。例如,在一些实现中,HCI设备可以经由UI/UX呈现器生成并呈现视觉刺激,该视觉刺激诱发用户在预定时间段内执行广泛范围的视觉搜索。眼睛跟踪器捕获并记录形成注视位置的轨迹(其描绘用户的聚焦点)的一系列眼睛运动,并将眼睛运动信号传达给HCI设备。图8A图示了跟随着用户在观看UI/UX871时的注视或聚焦点的示例性轨迹。

HCI设备可以被配置为对UI/UX进行缩放和范围变化,以使得轨迹映射在UI/UX呈现器的更好定义的区域或区块上。作为示例,HCI设备可以被配置为确定沿着水平和垂直方向的轨迹的最大值与最小值之间的差。HCI可以获得与UI/UX呈现器的显示分辨率相关的信息(例如,LCD显示器)。基于沿着两个方向的最大值和最小值以及分辨率信息,HCI设备可以通过更新UI/UX以使得轨迹在UI/UX上居中来校正用户可用的UI/UX区域中的任何偏差。HCI设备还可以缩放UI/UX,使得轨迹跨越UI/UX的整个可用表面,以最佳利用显示区域。经由更新后的UI/UX 871在图8B中示出了图8A中的轨迹的按比例缩放和偏差校正的轨迹的示例性图示。

在一些情况下,可以使用线性函数来完成缩放,如图8A和8B中所示。在一些其它情况下,可以使用各种非线性函数(诸如指数函数)来执行缩放。在随着注视角增大或注视角的偏心度增大而偏差呈指数增加的情况下,这样的实现可以特别有用。可以考虑耦合到捕获并传达眼睛运动信号的眼睛跟踪器的传感器的放置和定位来执行缩放和范围变化以及对偏差的校正。

三维中的眼睛跟踪的校准

如前所述,UI/UX呈现器可以向用户呈现三维UI/UX,并且可以经由眼睛跟踪来确定用户在三维空间中的注视位置或聚焦点。在HCI系统的一些实施例中,可以使用适当配置的刺激来校准确定三维空间中的聚焦点的精度。例如,UI/UX中对象相对于用户(例如,用户的眼睛)的定位和移动的特性可以被用于校准用户的眼睛跟踪。用于三维眼睛跟踪的一个示例性特性是视差。视差是在从不同位置观看时对象的位置或方向看起来有所不同的效果。因此,在HCI系统中,可以收集关于用户的位置(例如,用户的眼睛、头部和/或身体位置)的数据,并在观看固定的UI/UX时用于跟踪用户的运动。可替代地,可以向固定的用户呈现移动的UI/UX。

可以根据与用户和所呈现的UI/UX之间的间隔相关的已知信息来计算UI/UX中对象的预期位置。根据预期的位置信息,可以计算预期的注视角和注视位置,以确定用户的预期聚焦点。如本文所述,可以获得并处理来自眼睛跟踪器的眼睛运动信号,以确定用户在UI/UX的三维空间中的实际注视位置或聚焦点。可以将三维空间中的实际聚焦点与预期聚焦点进行比较,以计算误差量度。然后,可以通过对眼睛运动信号和/或从眼睛运动信号计算的注视向量应用适当的校正过程来校正计算的实际聚焦点,以生成经校准的眼睛运动信号和/或实际聚焦点的经校准的确定。

在一些实现中,用户可以生成平滑的追随(pursuit)眼睛运动(不同于扫视眼睛运动)。当用户跟踪并跟随移动的刺激或在用户移动时跟踪静止的刺激时,生成平滑的追随眼睛运动。用户预期相对于UI/UX三维空间中处于不同深度的对象具有不同的相对运动。UI/UX971中的图9中图示了示例性的三维刺激,其中用户被模拟为在相对于至少三个不同深度的对象(前景(树的排)、地面中间(城市景观)和背景(远景))移动的汽车中。当汽车在箭头指示的方向移动时,预期在三个深度中的已知固定点按降序以三个不同的相对速度移动。可以将已知对象或不同深度的点和用户之间的预期相对速度与从眼睛运动信号计算出的实际相对速度进行比较。如上所述,可以基于比较来计算误差量度,并且可以使用校正测度来校准眼睛运动信号和/或聚焦点确定。

使用神经信号校准眼睛跟踪

HCI设备可以被配置为接收和处理经由神经记录设备收集的神经信号,如本文所述。在一些实现中,基于从眼睛跟踪器接收到的眼睛运动信号,神经信号可以被用于校准眼睛运动跟踪。例如,UI/UX可以被配置为在UI/UX呈现器上的特定位置呈现特定的预定刺激。在呈现视觉刺激时,可以使用各种形式的神经信号来确定用户对聚焦点的辅助估计。例如,包括稳态VEP的视觉诱发电位(VEP)可以被用于确定对聚焦点的辅助估计。在一些实现中,可以在记录的神经信号中检测如事件相关电位(ERP)的神经信号(诸如P300信号)并与刺激呈现相确证以确定对聚焦点的辅助估计。在一些实现中,辅助估计可以被用于基于从眼睛跟踪器获得的眼睛运动信号在目标方向上微调聚焦点确定。图10图示了示例性实现,其中数字5预计在UI/UX 1071中生成ERP(例如,P300信号)。根据从眼睛跟踪器获得的眼睛运动信号确定的聚焦点由红色标记指示,该标记相对于数字5偏向定位。HCI设备可以接收和处理来自神经记录设备的神经信号,并检测神经信号中的P300信号(例如,EEG信号)。基于检测到的P300信号,确定对聚焦点的辅助估计在数字5的位置处,该位置由橙色标记指示。HCI设备可以被配置为比较从眼睛运动信号计算出的聚焦点(红色标记)与聚焦点的辅助估计(橙色标记),以计算误差量度和由橙色向量指示的校正偏移。眼睛运动信号可以基于校正偏移向量自动进行校准。

注视运动分类器

在一些实施例中,HCI设备可以被配置为使用眼睛运动分类器来处理眼睛运动信号。可以使用任何合适的分类器来对用户的注视进行分类,包括监督式、非监督式和半监督式的聚类和分类方法。诸如线性分类器、使用逻辑回归的方法、线性判别分析、支持向量机以及其它合适的机器学习工具之类的分类器可以被用于将眼睛运动分类为如扫视运动、非扫视运动、平滑追随运动、微扫视等类别。例如,在一些实现中,眼睛运动分类系统可以使用半监督式学习方法,其中可以使用如K均值聚类的过程来创建针对扫视和非扫视眼睛运动的标记。可以将聚类馈送到支持向量机中。

在一些情况下,扫视和非扫视移动的聚类本质上可以是非圆形、非球形或非卵形的。在这种情况下,K均值聚类可能导致误分类。在这样的情况下,可以使用基于密度的空间聚类方法,诸如带噪声的应用的基于密度的空间聚类(DBSCAN)。在一些实现中,各种聚类的密度可以不相等,并且密度不相等会妨碍使用DBSCAN过程的有效分类。图11A中的示意图图示了具有不同类别的眼睛运动信号的样本且密度不相等的示例性聚类,聚类1的样本密度低于聚类2。如本文所述,具有较低密度的样本的聚类可以被上采样。例如,可以检索眼睛运动信号的预先存在的数据集(例如,包括图11C中所示的眼睛运动信号的分布的数据集)。可以使用预定义的距离度量“d”来选择和评估预先存在的数据集中的一组样本眼睛运动信号。可以基于在眼睛运动信号的分类中被认为重要的一组特征来定义距离度量“d”。然后,可以基于距离度量测得靠近具有较低密度的聚类的一组样本眼睛运动信号可以被用于对缺乏密度的聚类进行上采样,以生成密度相当的聚类,如图11B中所示,接下来,可以有效地使用如DBSCAN的过程对眼睛运动信号进行分类。可以迭代地执行选择样本、定义距离度量、上采样和分类的过程,以重复地实现越来越好的结果。DBSCAN不要求手动指定聚类的数量,因此,这个系统还可以抵抗杂散训练噪声(在2个聚类中,K表示系统将成为离群值,它将质心移到最近的聚类)。DBSCAN聚类可以被用于标记试验,然后将其发送到SVM眼睛运动分类器中以供进一步处理。在可能难以以有效的方式容易地将新的点指派给预定义的聚类的情况下,可以存储经训练的聚类的表示以用于将来的分类需求。例如,可以将经训练的聚类定义为具有中心和外围的n维凸包或点云,并且可以基于到聚类凸包或聚类中心和外围的最短距离来指派聚类中的新点。

基准标记眼球跟踪性能

在HCI系统的一些实现中,HCI设备可以实现内置的基准标记系统来评估眼睛运动跟踪的精度。基准标记工具可以包括专门设计的刺激,该刺激被配置为计算用户的注视位置或聚焦点的估计中的误差。图12A和12B图示了根据实施例的在HCI系统中使用的示例性基准标记工具1285中的示例性界面1271。图12A和12B中的示例性包括由点或对象1280的网格指示的调试网格。可以在二维空间或三维空间中定义对象的网格。网格中的对象1280的特性可以根据需要独立定义。例如,特性可以取决于对象的密度、对象的间距、对象的尺寸和形状等,这些可以根据HCI系统的操作者的要求来定义。基准标记工具1285可以包括用于改变对象和网格的特性的一组控件,并提供用于操作者在使用期间在评估眼睛运动的同时动态地修改特性的一组显示控件。

如图12A(阴影圆)中所示,可以通过使用诸如目标之类的视觉或图形指示器指导用户聚焦于从网格中的对象集中选择的一个对象。记录所选择的对象的预期位置。如本文所述,可以使用从眼睛跟踪器获得的眼睛运动信号来计算用户的注视位置或聚焦点。可以将目标对象的预期位置与用户的注视位置或聚焦点的计算位置进行比较,以确定误差量度。可以对网格中的几个或所有点或对象重复该处理。根据误差量度,可以根据目标对象的空间位置来计算可靠性量度。图12B中图示了可靠性的示例性空间图,示出了眼睛跟踪在UI/UX呈现器左下部有更高可靠性。HCI设备可以使用可靠性的空间图来计算与眼睛跟踪器相关联的误差的边际。空间图可以被用于基于用户尝试聚焦的UI/UX呈现器的部分来建模和/或校准眼睛运动信号。例如,空间图可以揭示随着眼睛偏离UI/UX的中心而可靠性下降,因此可以使用随着偏心率增大或距中心的距离增大而增加的校准偏移来适当地校正眼睛运动信号。

与对象的眼睛跟踪用户交互

在HCI系统的一些实现中,对于HCI系统的有效运行而言,与UI/UX中呈现的刺激或对象的用户交互的精确且高速的计算是必需的。在一些实施例中,呈现给用户的UI/UX可以包括具有定位在三维空间中的对象的三维环境。在这样的实施例中,可以通过称为射线追踪或射线投射的处理来确定用户与三维空间中的特定对象的交互。射线追踪是一种渲染技术,用于通过沿着图像平面中的像素追踪光的路径或来自用户眼睛的视线并模拟其与虚拟对象相遇的效果来生成图像。射线投射是通过遵循光的路径或用户的注视角以通过相机并通过UI/UX中所有对象的预期交点形成射线(作为像素)来实现的。之后,获得来自最近的交点的像素值,并将其进一步设置为投影的基础。射线投射可以与射线追踪不同,射线投射是一种渲染算法,它不会递归地追踪辅助射线,而射线追踪能够做到这一点。

但是,在一些实现中,射线追踪和射线投射都可以是计算密集的和/或费时的。在这样的实现中,如果UI/UX包括具有三维定位的对象的三维空间,那么HCI设备可以使用UI/UX的3D空间中对象的2D投影来实现改进的用户-对象交互过程,如本文所述。改进的用户-对象交互过程可以以比碰撞之前的3D射线追踪更计算高效的方式计算用户的注视交互,对人类受试者注视对象的方式更健壮,并且可以利用操作者对于对象的形状和尺寸的了解。

为了实现改进的用户-对象交互过程,HCI系统可以包括头部跟踪设备以跟踪用户头部的位置。HCI系统还可以获得从用户的眼睛到被跟踪的头部参考点的距离测量。在一些实现中,HCI系统可以定义具有原点的物理坐标系,并获得关于用户的与物理坐标系相关的信息。在实现虚拟或增强环境时,HCI系统可以被配置为通过使用已知的缩放因子将VR或AR环境从虚拟坐标系转换成物理坐标系。在一些实现中,VR/AR环境到物理坐标系上的映射可以包括使用与在将UI/UX投影到用户时使用的渲染变换和投影矩阵相关的信息,并且可以包括与在经由投影透镜进行投影时在投影期间产生的任何失真或视觉效果(诸如透镜失真)相关的信息。

在改进的用户-对象交互过程中,通过计算双目3D注视向量与选定平面的交点来估计用户的单个注视点,该选定平面平行于眼睛的平面并位于用户头部的前方。计算这个选定平面在方便的2D空间上的2D投影。例如,图13图示了三维空间中的一组三维对象。可以选定更靠近房间前部的平面,使得该平面位于用户眼睛的前面,并且与用户眼睛的平面平行。可能在三维空间中处于不同深度的每个对象可以被投影到这个选择的平面上。在一些实现中,选定的2D平面可以在表示用户观看的VR/AR场景的3D投影截头椎体的剪切平面附近。在一些实现中,该平面可以被泛化为现实世界3D设置(即,该平面距用户眼睛中点的距离为d)。

可以评估每个可交互的3D对象,并将其中心投影到2D平面上。在一些情况下,HCI设备将对象的2D投影的界限计算为简单对象(例如,圆形、椭圆形或矩形)。这些界限是灵活的,并且可以基于场景布局和眼睛跟踪器噪声而扩大或缩小。图13中的图示示出了示例性场景中每个对象周围的示例性圆形界限。然后,与3D射线追踪相比,HCI设备以计算高效且精确的方式计算用户的注视是否在特定对象上及其到所有对象的距离。例如,HCI设备计算用户的注视位置或聚焦点与对象的投影图像之间的重叠量度。在一些情况下,HCI基于用户的注视位置与对象的投影的界限之间的重叠量度来确定用户交互。在一些情况下,可以基于根据眼睛运动信号计算出的用户的注视位置与选定的2D平面上对象的投影图像的中心或外围之间的距离度量来确定用户交互。

在一些实现中,通过HCI设备识别每个可交互3D对象上的三维分布点的样本并将识别出的点投影到用户的注视位置可位于的选定2D平面上,可以执行与3D对象的用户交互。识别出的点可以包括有界体积的顶点或对象模型的顶点的抽取集合,例如,如图14A中覆盖在对象上的黑色点所示。然后,每个对象的采样点的2D投影被用于计算该对象投影在二维平面上与用户的视图对应的凸包。

在一些实现中,HCI设备可以应用计算几何技术来确定用户的注视是否在对象上,或者注视距最近对象的凸包的边缘有多远。可以基于预定义的参数(如点数、点间距等)定义计算出的凸包。HCI设备可以生成并显示用于修改定义凸包计算的参数的一组控件,并向HCI系统的操作者提供用于将参数动态地改变为灵活的并针对不同的UI/UX环境定制的控件。例如,可以基于场景布局和眼睛跟踪器噪声来放大或缩小凸包,如图14B中所示的示例所示。

通过使用包括采样点的凸包或简单的2D对象表示,HCI设备可以基于用户与之交互的场景中的活动的可见对象的密度及其界限来扩大或缩小对象的2D投影的界限。该过程或算法使用的确切缩放可以根据经验从可用数据集中得出。

附加地,还可以基于活动场景中的可交互对象之间的平均距离来动态地调整(例如,由操作者实时地调整)用于基于到用户的注视的距离对可交互对象进行评分的任何非线性缩放参数(例如,指数缩放)(本文描述的)。

对可交互对象进行评分以识别意图的目标对象

在一些实现中,HCI系统被配置为呈现一组选项作为刺激,并根据从用户记录的指示用户行为的信号(例如,眼睛运动信号或神经信号)解码用户选择一个可以发起或传达动作的特定刺激的意图。呈现给用户的一组刺激可以是一组可交互对象(也称为标签),其中一个特定对象是用户感兴趣的。这个感兴趣的对象可以被称为目标对象。因此,换句话说,这种HCI系统的一个目标可以是以某种程度的精度和置信度从呈现给用户的可用的、可交互的或可见的一组对象中识别目标对象的身份。目标对象的识别处理可以结合几个信息源,如呈现的特定对象的先验可能性、特定对象可以诱发特征性大脑活动响应的可能性等。如本文描述的HCI系统(例如,HCI系统100、200、300、1200和1300)可以使用任何合适的过程来实现一组可交互对象向用户的呈现,并且可以实现任何合适的过程来识别要由用户选择的预期目标对象,并且这些过程可以基本上类似于通过引用整体并入本文的'846申请中所描述的过程。

图15示出了概述实现HCI系统(类似于本文描述的HCI系统)的处理1550的流程图,该处理向用户呈现一组可交互对象,并允许用户选择可以引起意图的动作的对象。处理1550可以与本文描述的处理350和/或以上引用的'846申请中描述的处理相同或基本相似。处理1550包括步骤1501,该步骤1501向HCI系统的用户呈现包括一个或多个可交互对象的刺激,每个对象在被选择时链接到一个或多个动作。在处理1550的1503处,记录与用户的行为相关的信号。例如,经由神经记录设备和眼睛跟踪器记录神经和/或眼睛运动信号。在1505处,处理和分析所获取的信号。例如,可以分析信号以提取指示用户行为的特征,诸如眼睛运动或认知状态。可以分析眼睛运动信号和/或神经信号以计算用户的注视位置。可以计算注视向量和注视角以确定用户的聚焦点。如本文所述,可以执行计算用户与可交互对象的交互的过程。作为另一个示例,可以分析神经信号以检测用户意图。在1507处,可以使用合适的统计模型或分析工具来分类、标记和/或识别信号中的时期(例如,眼睛运动信号中的扫视时期、神经信号中与特征性事件相关的电位等)。可以为被分析的信号的时期指派分数,以评估和分类被分析的信号。

在1509处,基于被识别、标记和/或分析的信号,对经由UI/UX让用户可用的每个可交互对象进行评分。基于所获取并处理的信号,与可交互对象相关联的分数被配置为与对象是用户感兴趣的目标对象的似然估计对应。可以使用一种或多种合适的评分方案、基于被分析的信号将分数指派给对象或与对象相关联,以形成分数表,该分数表列出对象及其相关联的分数。可以基于HCI系统可用的各种信息流来生成单独的分数表,以对每个可交互对象是感兴趣对象的可能性进行评分。例如,HCI系统可以基于对眼睛运动信号的分析来生成对象的单独的分数表(例如,视觉分数表),以及根据对神经信号的分析生成的单独的分数表(例如,神经分数表),以及基于关于刺激的呈现的可用信息生成单独的分数表(例如,距离分数表)以及基于用户的注视交互生成单独的分数表(例如,交互分数表)等。在一些情况下,可以通过组合任何合适阶段的分析来将一个或多个表折叠。例如,可以一起分析眼睛运动信号和用户交互,以生成组合的视觉分数表,如下面参考图16进一步详细描述的。在1511处,将各种分数表组合以生成主分数表。在1513处,识别并返回分数最高的对象(即,成为目标对象的最高可能性)。在一些情况下,HCI系统可以通过再次呈现识别出的对象来向用户寻求验证。在一些情况下,由HCI系统执行或实现与识别出的目标对象相关联的动作。

图16图示了描绘了在HCI系统的一些实现中使用的示例性过程1650的示意流程图,用于基于眼睛运动信号和用户交互来计算分数以生成示例性视觉分数表。在这个示例性方法中,可以向用户呈现包括五个可交互对象的刺激,这些对象由图16中的示例性UI/UX1671中的五个带编号的菱形示出。作为示例,对象1可以是用户感兴趣的。当用户观看或体验刺激时,HCI系统将神经刺激信号与眼睛运动信号一起获取。分析神经信号中的EEG信号以识别时期,该时期可以与用户做出与选择感兴趣的目标对象相关的决定的选择对应。

在1601处,获得与EEG信号中识别出的时期对应的眼睛跟踪或眼睛运动信号。在1603处,例如使用kalman滤波过程来处理眼睛运动信号。在1605处,使用特征检测过程来进一步分析经处理的眼睛运动信号,该特征检测过程可以被用于进一步分析或者去除人造的或不期望的信息。例如,可以分析经处理的眼睛运动信号以检测指示微扫视眼睛运动或眨眼的部分,以去除这些部分。

在1607处,计算可用的可交互对象的相对和/或绝对位置。例如,如上面参考图13、14A和14B所描述的,UI/UX的三维空间被映射到二维平面或坐标空间上。在1609处,基于眼睛运动信号计算均值注视向量以确定用户的注视角。在一些情况下,可以使用与二维投影平面的位置相关的知识来计算用户在二维坐标空间上的注视位置。在一些情况下,刺激可以被多次呈现,并且可以针对重复的呈现计算注视角或注视位置以获得平均值。

在1611处,计算到每个可交互对象周围的模糊边界的视觉注视角。在一些实现中,模糊边界信息可以包括对获取的眼睛运动信号中的噪声的考虑。在一些实现中,边界可以由相对于每个可交互对象的凸包定义的边界或由表示对象的2D投影的简单对象(例如,圆形或椭圆形)定义的边界部分确定。

在1613处,可以将视敏度模型应用于用户的注视和可交互对象的边界之间的交互的计算。在1615处,使用合适的评分方案(例如,在从-100到100的标度上)对每个可交互对象进行评分,以计算对象是用户感兴趣的目标对象的可能性。在一些实现中,HCI系统可以包括视敏度模型,使用眼睛运动运动学、人眼的解剖学和/或关于用户的眼睛运动的信息来生成预测的注视向量。在一些情况下,评分可以基于生物学得出的视敏度模型的变换。在一些情况下,视敏度模型可以基于指数缩放被建模为例如随着偏心率的增大而结合视敏度的指数减小。HCI系统可以结合其它可用的用户数据(例如,用户的眼距、眼睛跟踪器的品牌和型号等)结合来自视敏度模型的预测视觉角度。

在1617处,生成或更新分数表,以包括用户可用的可交互对象的列表以及每个可交互对象的相关联的分数,该分数指示其是感兴趣的目标对象的可能性。可以使用视敏度模型的结果和扫视眼睛运动信号、用户与可交互对象的交互以及被分析的注视向量的组合来生成视觉分数表,可以通过基于它与计算出的注视向量的接近度将视动分数指派给每个可交互对象来生成视觉分数表。如图15中所示,具有分数v1、v2、v3等的视觉分数表可以被用于更新前面描述的主分数。

虽然示例性处理1650描述了在1601处使用神经信号,但是在一些情况下,可以省略这一步以分析来自记录的整个时间帧的眼睛运动信号。

具有集成的眼睛跟踪器、头部EEG和EMG设备的示例性HCI系统

图17A-17D分别图示了根据四个不同实施例的具有基于耳部的神经记录设备、肌电图设备和眼睛跟踪器的组合的示例性HCI系统。图17A示出了一个HCI系统,除了眼睛跟踪器(未示出)之外,该HCI系统还包括在耳中和/或周围放置的一个或多个EMG设备以及头后部放置的神经记录设备。图17B示出了示例性HCI系统,其包括耳部周围放置的EMG设备和/或头后部放置的神经记录设备。

图17C图示了示例性HCI设备的部分,示出了耳部周围和/或耳中放置的EMG设备。图17D图示了示例性HCI系统,其包括耳部周围放置的EMG设备和在预定位置处放置的神经记录设备,以作为接口从大脑的预定义区域接收神经记录(例如,Cz和Pz位置,以从中枢和顶骨大脑区域获取EEG记录)。

使用HCI系统进行的现实世界交互

如前所述,HCI系统可以被用于促进用户与现实世界的交互,并且在一些情况下可以为用户呈现增强的现实或环境。在一些实现中,即使不呈现供用户交互的UI/UX界面,HCI系统也可以被用于解释用户与现实世界环境的交互。例如,HCI系统可以接收与用户观看或体验的图像或环境相关的信息(例如,经由前置相机或麦克风),而HCI系统可以处理该信息,以便用户以更健壮、高效或提供更多信息的方式与环境交互。

在一些情况下,可以训练HCI系统处理从现实世界环境获得的图像。例如,感兴趣的对象可以用IR反射带或任何合适的标记物标记,该标记物可以被用户使用的HCI系统中包括的眼睛跟踪器或眼镜中的相机轻松识别。获得的信息可以被用于三角测量和获得相对于眼镜的物理坐标。

在示例性实现中,HCI系统可以被训练或用于直接在由相机记录在眼镜中的图像的2D视频空间上工作,并使用诸如计算神经网络和边缘检测算法等之类的计算机视觉技术来识别其中的对象,以从感兴趣的对象中提取样本点,因此我们可以将前面章节中描述的技术应用于这些对象。这种方法的好处是我们不需要预先标记感兴趣的对象。只要使注视数据的2D投影与生成视频图像的视锥体对应,就可以在同一2D空间中操纵注视和对象特性。可以执行如图像处理和图像分割之类的分析以检测或识别现实世界环境的特征(例如,顶点、边缘、对象的中心等)。图18示出了经由HCI系统与路牌的现实世界视图进行用户交互的示例性用户实现。

在图18所示的示例性处理1850中,从视频剪辑获得图像帧,并且执行边缘检测过程以确定帧中包括的对象的边缘。划定遮挡边界并用其识别帧的前景和背景区域。在指派前景和背景区域之后,检测轮廓并基于潜在对象的特征(例如,颜色、实心轮廓等)对潜在对象进行分割和分类。基于分类,对帧中识别出的对象进行编号和呈现(例如,对象1-停车标志)。这样的识别可以帮助用户在环境中导航以及与环境中的对象进行交互。

根据一些实施例,HCI系统可以被用于搜集关于用户与环境的交互的信息。在一些情况下,和用户与预定义或已知环境的交互相关的数据对于诸如产品或服务的广告商或营销商之类的运营商可能具有高价值。

例如,人的眼睛运动可以用作人的注意力的公开测量。对于许多对人类行为感兴趣的组织(诸如例如营销公司(作为营销工具)或游戏公司(以帮助设计环境)、电影制作者等)的应用而言,目标受众的注意力量度可以是宝贵的信息。

注视位置可以被用于搜集关于人的注意力聚焦的信息。但是,注视位置由受试者的大脑中的自底向上(颜色、形状、亮度等)和自顶向下(上下文、执行功能)信号的组合来控制,如图19A的图示中所示。研究表明,只有自顶向下的信号才能与对象或环境的购买或享受的可能性密切相关(因果关系)。例如,如果人因为某产品或服务的标题是“红色”并且具有高视觉显著性而看产品,但它不会影响他们购买该产品或服务的可能性。虽然红色可能已经引起了人们的注意,但是没有更多的信息与用户的购买行为有关,因此与红色标题相关联的用户的高度注意可能与对用户购买产品或服务的可能性感兴趣的营销公司无关。

获得与自顶向下传达的注意力相关(例如,与执行功能相关)的潜在信息的示例性处理可以是从注视位置热量图(自顶向下+自底向上)减去视觉显著性图(仅自底向上),以便仅确定自顶向下的注视控制。这个信息对于人类行为的各个方面具有丰富的信息。例如,与仅包含关于注视或视觉显著性的信息的数据相比,这个信息可以以更高效的方式被用于预测和验证人类执行行为并用作营销信息。作为示例,图19B示出了量化用户的眼睛运动的空间图,越热的颜色指示注视位置的越高的可能性。这可能会错误地指示用户对产品名称有高兴趣。但是,如图19C中所示,通过使用在减去视觉显著性图之后的眼睛运动的空间图,用户的注意力可以主要集中在着色的文本和模型上,而不是产品上。

图20图示了计算与图像帧或视图(例如,现实世界的图像或虚拟现实环境的图像)相关联的视觉显著性图和视觉注意图的示例性处理2050。在2051处,获得帧或场景的视觉图像。在2052处,基于与高视觉显著性相关联的自底向上的特征(例如,亮度、空间频率、颜色、相对于前一帧的移动、对比度等),分解图像以识别具有高显著性的部分。在2054处,基于图像的分解生成视觉显著性图。在2056处,将预测用户注视与图像的部分相交的概率的注视概率图映射到2054处生成的视觉显著性图上。

在2053处,基于从眼睛跟踪器获得的眼睛运动信号来计算用户的实时注视部分。在2055处,计算实际的注视概率图并将其映射到由图像定义的视觉空间上。在2057处,定义一组权重,每个权重与图像的既定部分(例如,像素)相关联,这些权重基于在2055处生成的注视概率图。

在2058处,将在2056处生成的预测注视概率图转换成与图像的每个部分(例如,像素)对应的一组权重,并将从预测的注视概率图得出的权重与从实际的注视概率图得出的权重进行组合,以形成权重的数组。

在2058处,将这组组合权重应用于图像以生成加权的图像(例如,根据注视概率与视觉显著性的差异生成的图像)。在2059处,基于在2058处的加权图像,生成实时视觉注意力估计图(例如,热图),其指示可以与更高执行功能链接的用户兴趣点。图21图示了指示用户注意点的示例性热图。在一些情况下,可以将上述过程的实现用作智能过滤器,以估计或填写关于视觉景象的信息,否则该信息将不可用(例如,当用户在高速运动的同时观看环境时)。

情感状态确定

在一些实现中,如前所述,本文描述的HCI系统可以被用于搜集关于用户的情绪或认知状态的信息。例如,当在经历预定义的UI/UX环境时监视一组用户时,HCI系统可以被用作情绪或情感状态检测系统。图22A图示了映射由唤醒(arousal)和效价(valence)轴限定的表面上的各种情感状态的示意图。

情感状态模型的当前实现可能需要在每个用户和每个项目的基础上进行训练,以便生成明确的情感范围。训练可以包括用户观看或体验约30-60个1分钟视频,这会是耗时的。此外,当前技术涉及在相关联的情感状态上的自我报告,这可能被固有的偏见所污染,可能既费时又不精确。因此,与当前方法相比,使用HCI系统以无监督或半监督的方式自动进行情感状态确定可以是高效且精确的。

HCI系统的示例性实现可以被配置为获得神经信号和/或眼睛运动信号并处理这些信号。一些示例性分析处理可以包括信号的过滤、神经信号(如EEG信号)的提取、时期的提取、与特征性信号的控制对应的特征的提取、沿着有意义的轴执行回归分析等。可以使用从低效价/唤醒到高效价/唤醒的超平面的统计模型来训练HCI系统。可以基于可用数据对模型进行适当缩放(例如,仅从诱发高和低效价/唤醒极值的2x训练文件中缩放最大值和最小值)。示例性超平面在图22C中示出。在图22B的曲线图中示出了基于用户报告的值和基于HCI系统来检测情绪的一组示例性结果。

结论

总之,本文描述了用于可实时地由用户操作或由多个用户联合操作的集成式混合人类-计算机接口系统的实现中使用的系统和方法。所公开的系统的实施例包括眼睛运动跟踪系统、神经活动跟踪系统以及被配置为跟踪用户行为的几个附加系统(诸如EMG跟踪系统、身体位置或头部位置跟踪系统等)。本文描述的实施例被配置为实现指点控制特征和/或动作控制特征。在一些示例性中,实施例被配置为搜集与用户的行为相关的数据以用于分析。在一些实施例中,指点和动作控制特征是通过UI/UX的呈现来实现的,该UI/UX被策略性地设计为启用高速且精确的操作。此外,所公开的系统和方法的一些实施例被配置为使得它们可以是硬件不可知的,以在任何合适的平台上实现实时HCI,从而传达对虚拟的、增强或真实环境的用户操纵。

虽然上面已经描述了各种实施例,但是应当理解的是,它们仅以示例性的方式而非限制的方式呈现。在上述方法指示某些事件以某种次序发生的情况下,可以修改某些事件的次序。此外,某些事件可以在可能的时候在并行处理中并发地执行,以及如上所述顺序执行。

在上述示意图和/或实施例指示以某些朝向或位置布置的某些组件的情况下,可以修改组件的布置。虽然已经具体示出和描述了实施例,但是应该理解的是,可以进行形式和细节上的各种改变。除了相互排斥的组合之外,本文描述的装置和/或方法的任何部分可以以任何组合进行组合。本文描述的实施例可以包括所描述的不同实施例的功能、组件和/或特征的各种组合和/或子组合。

- 使用高速和精确的用户交互跟踪的人类-计算机接口

- 具有对于高速、准确和直观的用户交互的适配的大脑-计算机接口